CONTROLO 1

Conceitos fundamentais de algebra

Propriedades do determinante de uma matriz:

1.

2.

3.

4.

Sejam A e B duas matrizes de dimensão nxn, então |AB| = |A||B|

|A| = |AT|

Se A é não singular então |A-1| = 1/|A|

Multiplicando-se qualquer linha ou coluna por um escalar α então a matriz

resultante terá determinante αA.

5. Qualquer multiplo de uma coluna ou linha pode ser adicionado a outra coluna ou

linha sem alterar o valor do determinante.

6. O determinante de uma matriz triângular é o produto dos elementos da diagonal

principal.

7. O determinante de uma matriz triângular por blocos é igual ao produto do

determinante de cada um dos blocos na diagonal principal.

Propriedades da inversa de uma matriz

1. (AB)-1 = B-1A-1

def

2. (A-1)T = (AT)-1 = A-T

Teste da Gram (independência linear)

Definição da matriz de Gram:

Seja X = [x1 x2 … xk]

A matriz de Gram é dada por: G = XTX

Os vectores x1… xk ∈ ℜn são linearmente independentes se a matriz de Gram

associada tiver determinante não nulo.

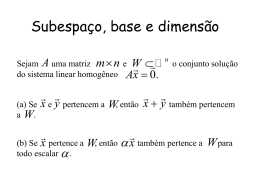

O vector y pertence ao subespaço cuja base é x1… xk se G = [x1… xk y]T[x1… xk y]

tem determinante nulo.

Ortognalidade

Norma Euclidiana: ||x||2 = xTx = x12 + x22 + …+ xn2

Seja c = x – y, então: ||c||2 = ||x||2 + ||y||2 - 2||x|| ||y||cos(α), sendo α o ângulo formado

por x e y.

Por outro lado:

||c|| = ||x – y|| = ||y – x|| = (x – y)T(x – y) = ||x||2 – 2xTy + ||y||2

donde:

cos(α)=

xTy

||x|| ||y||

ou seja x e y são ortogonais de xTy = 0.

Dois subespaços S1 e S2 de ℜn são subespaços ortogonais se qualquer x ∈ S1 é

ortogonal a qualquer y ∈ S2. Se x1… xp é uma base de S1 e y1… yq é uma base de S2

então S1 e S2 são ortogonais se xiTyj = 0, i=1, …, p, j=1,…,q.

Projecções ortogonais

A distância minima entre um vector e um subespaço é um vector ortogonal a esse

subespaço.

Sendo y = yp + ye, em que yp ∈ R e ypTye=0, então yp é a melhor aproximação de y

pertencente ao subespaço R e denomina-se projecção de y em R.

Seja x1… xr uma base de R. A projecção de y em R pode então ser calculada através

de:

yeTxi = 0 ,

i=1,…, r

ou seja:

α)Txi = 0,

i=1,…, r

(y – yp) Txi = (y - Xα

ou seja:

(y - Xα

α)TX = 0 α = (XTX)-1XTy

O vector yp procurado será dado por:

yp = Xα

α = X(XTX)-1XTy = PRy

sendo PR a chamada matriz de projecção ortogonal no subspaço R. Para se projectar

qualquer vector no subespaço R basta multiplicar esse vector por PR.

Propriedades da matriz de projecção ortogonal:

Simétrica: PRT = PR

“idempotent”: PR PR = PR

Complemento ortogonal de um subespaço

Seja x1… xr uma base de um subespaço R. O complemento ortogonal de R é dado

por:

R⊥ = {y ∈ ℜn : yTxi = 0, i = 1, …, r}

Qualquer vector de qualquer base de R⊥ será obviamente ortogonal a qualquer vector

de qualquer base de R.

A dimensão de R⊥ será s = n – r

⊕R⊥

ℜn = R⊕

Espaço nulo de uma matriz

null(A) = { x ∈ ℜn : Ax = 0 }

Sendo protanto x ortogonal a todas as linhas de A, ou seja:

x ∈ null(A) => x ∈ row(A)⊥

Mostra-se tembém que a implicação inversa também é verdadeira donde:

null(A) = row(A)⊥

Valores e vectores próprios

Definição:

Ax = λx

Cálculo dos valores próprios: det(λI – A) = 0

Se λ é um valor próprio de A então αλ é um valor próprio de αΑ.

Α.

Se λ é um valor próprio de A então α + λ é um valor próprio de αΙΙ + Α.

def

Seja T uma matriz não singular e A = TAT-1. Diz-se que A e A são matrizes

similares.

Matrizes similares têm os mesmos valores próprios.

Vectores próprios correspondentes a valores próprios distintos são linearmente

independentes.

O determinante de uma matriz é dado pelo produto dos seus valores próprios.

Uma matriz e a sua transposta têm os mesmos valores próprios.

Os valores próprios de uma matriz triângular são os elementos da sua diagonal

principal.

Os valores próprios de uma matriz triângular por bloco é união dos valores próprios

de cada bloco.

Sejam os valores e vectores próprios de A:

Axi = λi xi,

i = 1, …, n

Ou seja:

AX=XD

em que as colunas de X são os vectores próprios de A e D é uma matriz diagonal em

cuja diagonal temos os respectivos valores próprios de A.

Prova-se que: Ak = XDkX-1

Decomposição em valores singulares

Uma matriz A de dimensão mxn e caracteristica r pode ser decomposta na seguinte

forma:

A = U Σ VT

em que:

[Σ

Σ] = mxn,

[U] = mxm,

[VT] = nxn

UTU = Im

VTV = In

σ1 . . .

0

0 ...

0

...

...

...

...

...

...

0

...

σr 0 . . .

0

0

...

0

Σ=

0 ... 0

Os valores σi são os valores singulares de A. São não negativos e estão ordenados em

ordem decrescente.

Mostra-se que:

i) o quadrado dos valores singulares não nulos de A são os valores próprios não nulos

de AAT ou ATA.

ii) as colunas de U são os vectores próprios de AAT

iii) as colunas de V são os vectores próprios de ATA

Decompondo-se U e V da seguinte forma:

U = [ui . . . ur | ur+1 . . . um] = [ U1 | U2 ]

V = [vi . . . vr | vr+1 . . . vm] = [ V1 | V2 ]

resulta:

A = U1 Σ1 V1T

sendo:

U1 uma base ortonormal do subespaço gerado pela colunas de A

U2 uma base ortonormal do complemento ortogonal do subespaço gerado pela

colunas de A

V1 uma base ortonormal do subespaço gerado pela linhas de A

V2 uma base ortonormal do espaço nulo de A

Equações lineares

Sejam m equações lineares a n incógnitas:

Ax=y

, [A] = mxn

[x] = nx1

[y] = mx1

sendo x o vector das incógnitas.

Seja W = [ A y]

Caracterização da solução pela caracteristica:

Se c(W) ≠ c(A) => y ∉ col(A) => não tem solução

Se c(W) = c(A) => y ∈ col(A) => tem solução

Se c(W) = c(A) = n => tem uma única solução

Se c(W) = c(A) = r < n => tem infinitas soluções soluções com grau de

liberdade n – r.

Se c(A) = m ≤ n existe uma solução (não única se m < n) para cada vector y.

Caracterização pela dimensão da matriz:

Seja m = n:

Se det(A) ≠ 0 a solução é única e dada por x = A-1y

Se det(A) = 0 não existe solução para qualquer y. No entanto se

c(W) = c(A) = r < n então existe uma infinidade de soluções (grau de

liberdade n – r).

Seja m > n:

Se c(A) = n então a solução única minimiza a norma de y – Ax sendo a

projecção de y no subespaço gerado pelas colunas de A e sendo dada

por:

xLS = (ATA)-1ATy

Se c(A) < n existe um numero infinito de soluçõe se o só se

c(W) = c(A) = r < n.

Seja m < n:

Se c(A) = m existe um número infinito de solução. No entanto a

solução de norma minima é dada por:

Xmin-norm = A(ATA)-1ATy

Se c(A) < m podem ou não existir soluções.

Utilização da decomposição em valores singulares para a resolução de equações

lineares

Considere-se o sistema de equações: Ax = y em que a matriz A tem dimensão mxn.

Seja a decomposição em valores singulares:

Σ1 0 V1T

A = [ U1 U2 ]

0 0 V2T

A matriz Σ1 de dimensão rxr contem r valores singulares não nulos de A. As matrizes

U1 e V1 têm r colunas.

Se y = 0 então as soluções correspondem ao espaço nulo de A. A matriz V2 contem

uma base para esse espaço donde as soluções são do tipo:

x = V2α

em que α contêm n –r parâmetros.

Se y ≠ 0 calcula-se o seguinte vector:

z = V1Σ-11 UT1 y

O vector z tem as seguintes propriedades:

1. Se Ax = y tem uma solução única então z é a solução

2. Se Ax = y não tem solução então z dá a solução de mínimos quadrados. Se

a solução de mínimos quadrados não for única dá a solução de norma

mínima. Outras soluções de mínimos quadrados podem se obtidas

adicionando-se do espaço nulo de A:

x = z + V2α

3. Se Ax = y tem um número infinito de soluções, z é a solução de norma

mínima. Outras soluções podem ser obtidas de forma idêntica ao ponto

anterior.

Baixar