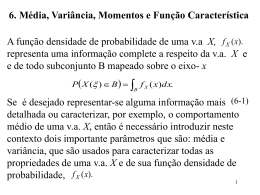

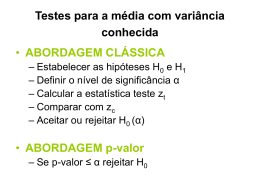

Noções de Inferência Estatística AULA 21 – Parte I Data Mining Sandra de Amo Como inferir a qualidade de um classificador a partir de sua performance sobre uma amostra ? Classificadores são avaliados sobre uma amostra de dados e não sobre o conjunto total de dados. Seja D um conjunto de N amostras de teste; Seja M um modelo de classificação Acurácia Empírica de M = K/N, onde K = número de amostras classificadas corretamente em N tentativas. Se a acurácia empírica é alta podemos dizer que M é um bom classificador ? Exemplo MA foi testado em um conjunto de 30 amostras Acc(MA) = 85% MB foi testado em um conjunto de 5000 amostras Acc(MA) = 75% Podemos concluir que MA é melhor do que MB ? Perguntas importantes: Qual o intervalo de confiança da acurácia obtida por MA ? Qual o intervalo de confiança da acurácia obtida por MB ? Os conjuntos de dados de testes seguem uma mesma distribuição ? Inferência Estatística Inferência Estatística = Processo de obter conclusões confiáveis sobre uma população geral, baseando-se em uma amostragem de dados. Estatísticas: medidas extraídas de uma amostragem de dados através das quais se quer derivar resultados para a população geral. Média e Variância de uma Amostragem Algumas estatísticas importantes: Seja X uma variável aleatória (Por exemplo Altura) Consideremos N observações X1,..., XN extraídas aleatoriamente de uma população com distribuição de probabilidade com média Por exemplo: X1 = 1.55, X2 = 1.59, X3 = 1.65,... Xi é o evento X = altura do indivíduo sorteado. Média da amostragem Variância da amostragem Valor esperado da Média da amostragem Valor esperado da média da amostragem Logo: as médias das amostragens se aproximam da média geral da população, sobretudo para valores grandes de N A estatística “média” é chamada de estimador nãotendencioso da população. Valor esperado da Variância da Amostragem Teorema: Valor esperado da variância da média da amostragem é dado por: onde σX é a variância da população geral SeσX for desconhecido será aproximado pela variância da amostragem sX = desvio padrão da média das amostragens Teorema do Limite Central Seja uma população X com distribuição de probabilidade com média μX e variância σ2X. Considere uma amostragem de tamanho N extraída aleatoriamente da população X. Se x é a média da amostragem , então a distribuição de x se aproxima de uma distribuição normal com média μX e variância (σ2X )/N quando N é grande. Distribuição normal (ou de Gauss). Vários fenômenos aleatórios seguem uma distribuição normal (ou de Gaus) de probabilidade. Muito importante. Tabelas disponíveis. Fácil de avaliar. Intervalo de Confiança Estimativa dos parâmetros de uma população (ex: média, variância): muito importante indicar a confiabilidade da estimativa. Exemplo 1: suponha que queiramos estimar o quanto um grupo de 10000 pessoas do sexo masculino representam a população masculina brasileira em termos de altura. Isto é, o quanto podemos confiar que a altura média destes 10.000 indivíduos representam a altura média da população masculina brasileira, com um grau de confiança de 95% Este é um exemplo do seguinte problema: Conhece-se a média REAL e deseja-se saber o quanto uma amostra considerada aleatoriamente está perto desta média REAL Distribuição Normal 0,95 Area abaixo do gráfico entre -2 e 2 = 0,95 Média real Intervalo de confiança Considera-se a tabela de distribuição normal com média μX e variância (σ2X )/N, onde N = 10.000 Intervalo de confiança (θ1 , θ2 ) com grau de confiança = 0.95 Considera-se as extremidades do intervalo em torno da média da distribuição Θ1 = μX - k Θ2 = μX + k Tal que: P[θ1 < X < θ2 ] = 0.95 Exemplo1 : Continuação Seleciona-se aleatoriamente um grupo de 10000 homens A probabilidade que a média da altura destes 10.000 homens esteja no intervalo [μX - k, μX + k] é 95% onde θ1 = μX - k e Θ2 = μX + k A distribuição normal padrão Z Toda distribuição normal de média μX e variância σ2X pode ser transformada em uma distribuição padrão de média 0 e variância 1. Distribuição normal (μX, σ2X ) distribuição padrão Z (1,0) A partir da distribuição padrão Z (tabelada), encontra-se a distribuição normal específica X : P[X = x] = P[Z = z] onde z = (x – μX)/ σX Exemplo 2 Suponha que não conhecemos a média (real) μX da altura da população masculina brasileira. Queremos estimar esta média a partir de uma amostra de uma amostra X de 10.000 homens considerada aleatoriamente, com uma confiança de 68% De acordo com o Teorema do Limite Central: a média das amostras se aproxima de uma distribuição normal com média μX e variância σ2X/N Média da altura da amostragem (N = 10000) Exemplo 2 (continuação) Procurando na tabela de probabilidade de Z, o intervalo [-a,a] onde P[-a < Z < a] = 0.68 obtemos a = 1 Portanto: o intervalo de confiança para a amostra X considerada é de [ , ] com grau de confiança de 68% Isto é, temos 68% de certeza de que a média REAL da população encontra-se dentro deste intervalo. Como calcular σx Método 1: Considera-se diversas amostras de N = 10.000 homens (por exemplo 100 amostras) Para cada amostra calcula-se sua média. Calcula-se a média de todas as 100 médias σ x = desvio padrão das 100 médias Método 2: Na prática, pode-se aproximar σ x pelo desvio padrão da amostragem sX considerada, onde: Comparação de Classificadores AULA 21 – Parte II Data Mining Sandra de Amo Acurácia Empírica e Acurácia Real Acurácia empírica de um modelo de classificação é obtida sobre um conjunto Teste com N amostras Acurácia empírica = X/N, onde X = número de amostras preditas corretamente Acurácia Real = p = acurácia “hipotética” que seria medida sobre o conjunto de todas as amostras possíveis. Dada uma amostra qualquer, a probabilidade de que o classificador acerte a predição é p. Relação entre Acurácia Empirica e Acurácia Real Medir a acurácia empirica sobre um conjunto T de N amostras = experimento binomial, consistindo em N tentativas. X = variável aleatória X = número de acertos em N tentativas P[X = v] = probabilidade de haver v acertos em N tentativas, sabendo que a probabilidade de acerto em cada tentativa é p. Distribuição de probabilidade binomial Média = Np, Variância = Np(1-p) Distribuição da Acurácia Empírica Acurácia empírica: variável aleatória X/N Distribuição de probabilidade de X/N também é binomial com: Média = p Variância = p(1-p)/N Distribuição binomial pode ser aproximada por uma distribuição normal quando N é grande Logo: distribuição de probabilidade da Acurácia Empírica pode ser considerada uma distribuição NORMAL com Média p e Variância p(p-1)/N Lembrando relação entre distribuição normal e distribuição padrão Z: p(p-1)/N p acc = Média do número de acertos em N tentativas = acurácia empírica Cálculos Seja a = grau de confiança Procura-se na tabela de Z o intervalo [-b,b] para o qual P[-b < Z < b ] = a Usando-se a equação p(p-1)/N p acc Média do número de acertos em N tentativas = acurácia empírica Obtém-se o seguinte intervalo de confiança para p: [θ1, θ2 ] onde θ1 = (2N.acc +b2 – b (b2 + 4N.acc – 4N.acc2) )/ 2(N+b2) θ2 = (2N.acc +b2 + b (b2 + 4N.acc – 4N.acc2) )/ 2(N+b2) Exemplo Suponha um modelo de classificação que tem uma acurácia de 80% quando calculado sobre um conjunto de teste de 100 amostras. Qual o intervalo de confiança de sua acurácia REAL com um grau de confiança de 95% ? Acc = 0.80, N = 100, a = 0.95 Tabela de Z a b Fazendo-se os cálculos temos: θ1 = 71.1% e θ2 = 86,7% θ1 Variação do intervalo de confiança quando o número de amostras aumenta θ2 Comparando a performance de dois modelos M1 = modelo de um classificador C extraido de um conjunto de treinamento T1 Testado sobre D1, com n1 elementos e1 = taxa de erro = 1 – acc1 M2 = modelo de um classificador C extraido de um conjunto de treinamento T2 Testado sobre D2, com n2 elementos e2 = taxa de erro = 1 – acc2 A diferença entre e1 e e2 é estatisticamente significante ? Método d = |e1 – e2| = |acc1 – acc2| d obedece uma distribuição normal com média dt = diferença real |e1 – e2| e Variância estimada variância σd2 σd2 pode ser aproximada por σd2 = e1(1-e1)/n1 + e2(1-e2)/n2 Intervalo de confiança de dt com a% de grau de confiança dt = d±b σd Desvio padrão estimado = sd b = valor encontrado na distribuição Z correspondente a a% Exercício: deduzir esta fórmula a partir da relação entre a distribuição padrão Z e a distribuição normal d (ver slide 15) Exemplo M1 = modelo de um classificador C extraido de um conjunto de treinamento T1 Testado sobre D1, com 30 elementos e1 = taxa de erro = 1 – acc1 = 0.15 M2 = modelo de um classificador C extraido de um conjunto de treinamento T2 Testado sobre D2, com 5000 elementos e2 = taxa de erro = 1 – acc2 = 0.25 d = |e1 – e2| = 0.1 Variância estimada = 0.15(1-0.15)/30 + 0.25(1-0.25)/5000= 0.0043 Desvio padrão estimado = 0.0043 = 0.0655 Exemplo (continuação) Qual o significado do intervalo de confiança [θ1, θ2 ] ? Estamos testando 2 hipóteses: Hipótese Nula: dt = 0 a diferença real entre os erros é nula Hipótese alternativa: dt < > 0 a diferença real entre os erros NÃO é nula (pode ser < 0 ou > 0 ) Exemplo (continuação) Queremos encontrar b na tabela da distribuição padrão Z tal que: P[-b < (d – dt)/sd < b] = a a A interpretação do intervalo [θ1, θ2] é a seguinte: Se dt = 0 está em [θ1, θ2] então a d (que está em [θ1, θ2] ) não tem significância estatistica dt d – dt > 0 θ1 d dt θ2 dt d – dt < 0 Se dt = 0 não está em [θ1, θ2] (está em uma das duas regiões caudais) então d tem significância estatistica. O valor b na tabela Z A tabela Z envolve duas tabelas: Unicaudal Duplamente caudal Para cada valor de a, pode-se encontrar dois valores de b: um para o caso unicaudal e outro para o caso duplamente caudal. Exemplo (continuação) No exemplo : b = 1,96 (duplamente caudal) Como o valor nulo (dt = 0) está no intervalo (0.1 – 0.128; 0.1 + 1.28) então a diferença de performance entre os dois modelos não tem significância estatística. Variando o grau de confiança Quanto deveria ser o grau de confiança para que a diferença de performance d = 0.1 tivesse significância estatística ? 0.1 > b.0,0655 ? b < 0.1/0.655 = 1.527 Procurando o valor de a na tabela duplamente caudal correspondente a b = 1.527: a = 93.6% Logo, a hipótese nula pode ser rejeitada com um grau de confiança 93.6% Comparando a performance de dois classificadores L1 = técnica de classificação L2 = técnica de classificação Os testes de L1 e L2 foram feitos sobre um mesmo banco de dados D utilizando k-cross validation. M1i = modelo de L1 obtido durante a i-ésima iteração M2i = modelo de L2 obtido durante a i-ésima iteração. Os modelos M1i e M2i são testados sobre o mesmo conjunto de teste (correspondente a i-ésima iteração) e1i = taxa de erro de M1i e e2i = taxa de erro de M2i di = e1j – e2j = diferença das taxas de erro na i-ésima iteração Se k é suficientemente grande (o número de vezes que o experimento é realizado é grande) então di segue uma distribuição normal Média δt = média das diferenças das taxas de erro “verdadeiras” Variância σ2 Estimativa do variância σ2 d = média estimada da diferença dos erros δt σ Grau de liberdade (degree of freedom) Exemplo Suponha que a média das diferenças estimadas é 0.05 com desvio padrão de 0.002 Os testes são feitos utilizando 30-cross validation Com um grau de confiança a = 95% a diferença real dos erros (ou da acurácia) é: δt = Intervalo de confiança = [0.05 – 0.00408; 0.05 + 0.00408] = = [0.04592; 005408] Distribuição t com graus de liberdade. k – 1 = 29 Como o valor zero (hipótese nula) não está contido no intervalo de confiança [0.04592; 005408] então podemos concluir que a diferença de performances entre as duas técnicas de classificação é estatisticamente significante.

Baixar