UNIVERSIDADE FEDERAL DE SANTA CATARINA

DEPARTAMENTO DE ENGENHARIA DE PRODUÇÃO E SISTEMAS

PROGRAMA DE PÓS-GRADUAÇÃO EM ENGENHARIA

DE PRODUÇÃO

ALEXANDRE SERRA BARRETO

PREVISÃO DE COMPORTAMENTO E CLASSIFICAÇÃO DE

CONTRIBUINTES TRIBUTÁRIOS: UMA ABORDAGEM POR

MODELOS LINEARES GENERALIZADOS HIERÁRQUICOS

Tese de Doutorado

FLORIANÓPOLIS

2005

ALEXANDRE SERRA BARRETO

PREVISÃO DE COMPORTAMENTO E CLASSIFICAÇÃO DE

CONTRIBUINTES TRIBUTÁRIOS: UMA ABORDAGEM POR

MODELOS LINEARES GENERALIZADOS HIERÁRQUICOS

Tese de Doutorado Apresentada ao

Programa de Pós-Graduação em Engenharia de Produção

da Universidade Federal de Santa Catarina

como requisito parcial para obtenção

do Grau de Doutor em Engenharia de Produção

Orientador: Aran Bey Tcholakian Morales, Dr.

Co-Orientador: Dalton Francisco de Andrade, PhD.

FLORIANÓPOLIS

2005

ALEXANDRE SERRA BARRETO

PREVISÃO DE COMPORTAMENTO E CLASSIFICAÇÃO DE

CONTRIBUINTES TRIBUTÁRIOS: UMA ABORDAGEM POR

MODELOS LINEARES GENERALIZADOS HIERÁRQUICOS

Esta Tese foi julgada e aprovada para a obtenção do grau de Doutor

em Engenharia de Produção no Programa de Pós-Graduação em

Engenharia de Produção da Universidade Federal de Santa Catarina

Florianópolis, 16 de setembro de 2005

______________________________________________

Edson P. Paladini

Coordenador do Programa

BANCA EXAMINADORA

____________________________________

____________________________________

Prof. Aran Bey Tcholakian Morales, Dr.

Prof. Dalton Francisco de Andrade, PhD.

UFSC

UFSC

(Orientador)

(Co-Orientador)

____________________________________

_____________________________________

Profa. Maria Inés Castiñeira, Dra.

Prof. Antonio Cezar Bornia, Dr.

Unisul

UFSC

(Moderadora)

_____________________________________

____________________________________

Prof. José Afonso Mazzon, Dr.

Prof. João Luiz Alkaim, Dr.

USP

Unisul

(Examinador Externo)

(Examinador Externo)

Dedicatória

À minha mãe, Profa. Sylvia Serra Barreto, pelo,

carinho, incentivo, orações e lições concedidas.

Ao meu pai, prof. Fernando Barreto, por proporcionar as

bases para minha formação acadêmica.

Agradecimentos

A Deus e a Jesus Cristo, que me guiaram durante a realização desta pesquisa.

Meu especial agradecimento ao Prof. Aran Bey Tcholakian Morales, pela

orientação científica constante e segura e pela confiança sempre depositada nesta

pesquisa.

Ao Prof. Dalton Francisco de Andrade, minha especial gratidão, pela atenção,

incentivo e valiosa co-orientação do trabalho; e por nossos seminários em métodos

estatísticos realizados no INE/UFSC.

Aos professores membros da banca examinadora desta tese pela contribuição

ao aperfeiçoamento deste trabalho.

Meu muito especial agradecimento ao ex-Secretário da Receita Federal, Dr.

Everardo Maciel; ao Secretário da Receita Federal, Dr. Jorge Antônio Deher Rachid;

e à Comissão de Pós-Graduação da SRF formada pelo Dr. Moacir das Dores, Dr.

Márcio Ferreira Verdi, Dra. Luciana M. Sabino de Freitas Cussi e Dr. Carlos Alberto

Barreto, pela concessão da inestimável oportunidade profissional e de pesquisa.

À Coordenadora-Geral da COSIT/SRF, Dra. Josefa Maria Coelho Marques; ao

Coordenador da DICOR/COTEC/SRF, Dr. Márcio R. Nogueira; ao CoordenadorGeral da COFIS/SRF, Dr. Marcelo Fisch B. Menezes; à Auditora-Fiscal da Receita

Federal Helena Martha Graever de Medeiros e ao Analista do SERPRO Marco

Antônio Lopes, pelo apoio proporcionado a este trabalho.

Ao Prof. Paulo José Ogliari, do INE/UFSC, por sua amizade, disciplinas

ministradas, livros disponibilizados e divertidas conversas sobre estatística.

À Universidade Federal de Santa Catarina, ao Programa de Pós-Graduação em

Engenharia de Produção, ao Programa de Pós-Graduação em Ciências da

Computação e, particularmente, aos professores José Leomar Todesco, Miguel

Angel Verdinelli, Hugo César Hoeschl, Silvia Modesto Nassar, Robert Wayne

Samohyl e Pedro Alberto Barbetta, pelas possibilidades de expansão de

pensamentos, disciplinas ministradas e oportunidades de aprendizado propiciadas

ao longo desta caminhada.

Ao meu amigo Márcio Cruvinel, Engenheiro Eletricista e Auditor-Fiscal da

Receita Federal em Brasília, pela abertura de caminhos às minhas idéias.

Agradeço também a todos os meus colegas da UFSC durante o período de

doutorado, especialmente a Damaris Fanderuff, Juliano Anderson Pacheco, Marcelo

Buscioli Tenório, Renato Corrêa Vieira, Rubson Rocha e Patrícia Bonina Zimath,

pela amizade e agradável convívio durante o período de pós-graduação em

Florianópolis.

Aos meus padrinhos Beatriz e Milton Ribeiro, pelas orações nos momentos

importantes.

Aos meus amigos e irmãos no Rio de Janeiro, Júlio Cezar Ferreira de Mello,

Marcelo Oliveira Brandão e Luiz Phillipe Lameirão Côrtes, pela amizade e

fraternidade de há muitos anos, mesmo à distância, tão importante nos longos

períodos de reflexão e isolamento.

Por fim, agradeço simbolicamente às cidades e ao povo de Florianópolis-SC,

Brasília-DF e Rio de Janeiro-RJ, nas quais esta pesquisa pôde ser proposta,

viabilizada e executada.

Epígrafe

“Já conhecemos as leis que determinam o comportamento

da matéria sob todas as condições, à exceção das mais extremas.

Particularmente conhecemos as leis básicas que perpassam toda a

química e a biologia. Certamente ainda não reduzimos estes temas ao

status de problemas resolvidos; temos, ainda assim, obtido pequeno

sucesso, por enquanto, na previsão do comportamento humano a partir

de equações matemáticas! Assim, mesmo se de fato encontramos um

conjunto completo de leis básicas, ainda estará projetada nos anos

posteriores a intelectualmente lendária tarefa de desenvolver melhores

métodos de aproximação, a fim de que possamos fazer previsões úteis

quanto aos prováveis comportamentos das situações reais complexas.

Uma teoria completa, consistente, unificada é apenas o primeiro passo:

nosso objetivo é a completa compreensão dos eventos à nossa volta e de

nossa própria existência.”

Stephen W. Hawking

Resumo

BARRETO, Alexandre Serra. Previsão de Comportamento e Classificação de

Contribuintes Tributários: Uma Abordagem por Modelos Lineares Generalizados

Hierárquicos. 2005. 262f. Tese (Doutorado em Engenharia de Produção) - Programa

de Pós-Graduação em Engenharia de Produção, UFSC, Florianópolis.

No contexto atual da administração tributária, é requisitado o controle, a curto,

médio e longo prazo, dos níveis de arrecadação de tributos e contribuições

administrados. Para que um determinado nível de arrecadação seja mantido, ou

elevado, é preciso que exista um sistema tributário estabelecido e um processo de

fiscalização permanentemente exercendo certa pressão sobre os contribuintes. A

condução desse processo é uma das atribuições regimentais das agências

tributárias e também, portanto, da Secretaria da Receita Federal, e possui como

uma de suas principais tarefas a seleção de contribuintes para fiscalização. Esta

apresenta como um dos elementos complicadores o inevitável tempo decorrido

entre o cometimento de uma infração por parte de um contribuinte e sua efetiva

detecção pela agência tributária. No que se refere à seleção de contribuintes

pessoas jurídicas, deve-se reconhecer que estes se dedicam a certas atividades

econômicas que contam com características econômico-setoriais próprias, o que

sugere que as medidas tomadas a partir de contribuintes pertencentes a um mesmo

setor de atividades econômicas tendem a ser mais parecidas entre si do que

medidas tomadas a partir de contribuintes participantes de setores econômicos

distintos, hipótese que, em se confirmando, ocasiona a correlação das observações

intra-setores. Assim, esta pesquisa propõe um novo método de classificação e

seleção de contribuintes para fiscalização, fundamentado na previsão de seus

comportamentos tributários por meio de Modelos Lineares Generalizados

Hierárquicos, que efetivamente considera e avalia, de forma sistematizada, a

correlação de medidas existente intra-setores de atividades econômicas. Os dados

de trabalho são os relacionados ao principal método de seleção de contribuintes da

Secretaria da Receita Federal e às auditorias assim deflagradas. A partir da

estimação dos modelos propostos e da utilização de variáveis preditoras individuais

de contribuintes e também de setores econômicos, foram devidamente

quantificadas e explicadas as fontes de variabilidade nas respostas de interesse

tributário aqui enfocadas. Por fim, os modelos foram aplicados à classificação de

contribuintes e avaliados, em termos de capacidade preditiva, pela estimação de

suas medidas de validade interna. Os principais resultados alcançados pela

condução da pesquisa foram: a agregação de conhecimento no que concerne a

dinâmica que rege o comportamento tributário de contribuintes e de setores

econômicos, subsidiando a formulação de políticas fiscais; a consideração, de forma

sistematizada, da correlação de medidas intra-setores econômicos, assim como a

explicação parcial da variabilidade aferida a partir dessa sistematização, em termos

da proposição de métodos para seleção de contribuintes para fiscalização; a

especificação de um novo método de seleção de contribuintes para fiscalização que

confere uma maior agilidade de ação à fiscalização tributária.

Palavras Chave: previsão, classificação, impostos, modelos lineares generalizados

hierárquicos.

Abstract

BARRETO, Alexandre Serra. Previsão de Comportamento e Classificação de

Contribuintes Tributários: Uma Abordagem por Modelos Lineares Generalizados

Hierárquicos. 2005. 262f. Tese (Doutorado em Engenharia de Produção) - Programa

de Pós-Graduação em Engenharia de Produção, UFSC, Florianópolis.

In the tributary context it is required the planning and control of taxes collection.

In order to maintain and eventually increase a reached public collection level it is

necessary an established taxation system and an audit enforcement permanently in

activity. This process is sponsored by tax agencies and has as a crucial task to

select taxpayers for audit proposals, which is challenged by the unavoidable time

gap between the occurrence of a taxpayer’s infraction and its effective detection by

the agency. With respect to corporate taxpayers it is intuitive that taxpayers

belonging to the same economic sector must be more similar than others dedicated

to different economic sectors and this assumption may cause intra-sector correlated

observations. This should be evaluated by the researcher while proposing nonrandomized taxpayer selection methods. Thus the actual research proposes a new

method to classify and select corporate taxpayers based in their tax compliance

behavior predicted by Hierarchical Generalized Linear Models, concerning and

assessing the existence of intra-sector correlated measures. The focused database

belongs to Brazilian tax agency called Secretaria da Receita Federal and is related

to its regular taxpayer selection method and subsequent audits. By estimating the

proposed models and utilizing individual and sectorial explanatory variables, the

variability in taxation measures of interest was quantified and explained. After that

proposed models were applied to classification and evaluated concerning its

prediction capabilities by the estimation of specific internal validation measures. The

more relevant results of this research were to aggregate knowledge about noncompliant tax behavior to taxation research; the consideration, in a systematized

fashion, of the correlation among observations belonging to the same economic

sector, as well as the partial explanation of the variability assessed by means of this

consideration, in respect of proposing taxpayer selection methods; and the

specification of a new method to classify and select taxpayers that privilegies the

agility of tax audit enforcement.

Key-words: forecasting, classification, taxes, hierarchical generalized linear models.

Sumário

Lista de Figuras ..................................................................................................................... xiii

Lista de Quadros ................................................................................................................... xiii

Lista de Tabelas .................................................................................................................... xiii

Lista de Siglas ........................................................................................................................xv

1 INTRODUÇÃO AO TEMA .................................................................................................. 18

1.1 Contextualização do problema .................................................................................... 19

1.1.1 Situação atual da seleção de contribuintes na SRF ............................................. 20

1.1.2 Problema, questões e hipóteses de pesquisa ...................................................... 24

1.2. Objetivos do trabalho.................................................................................................. 26

1.2.1 Objetivo geral........................................................................................................ 26

1.2.2 Objetivos específicos ............................................................................................ 27

1.3 Justificativa .................................................................................................................. 28

1.3.1 Relevância ............................................................................................................ 28

1.3.2 Ineditismo ............................................................................................................. 30

1.3.3 Complexidade ....................................................................................................... 30

1.4 Metodologia de trabalho .............................................................................................. 31

1.4.1 Procedimentos ...................................................................................................... 31

1.4.2 Classificação da pesquisa .................................................................................... 33

1.4.3 Convenções adotadas .......................................................................................... 34

1.4.4 Limitações da pesquisa ........................................................................................ 34

1.5 Delimitações do trabalho ............................................................................................. 35

1.6 Estrutura do trabalho ................................................................................................... 35

1.7 Contextualização da tese na engenharia de produção ............................................... 36

2 EVASÃO E INFRAÇÃO TRIBUTÁRIAS ............................................................................. 38

2.1 Introdução.................................................................................................................... 38

2.2 Conceitos gerais em tributação e implicações à pesquisa .......................................... 39

2.3 Modelo básico de evasão tributária ............................................................................. 41

2.4 Modelos enfocando a seleção de contribuintes para fiscalização............................... 43

2.4.1 Modelos envolvendo contribuintes pessoas físicas .............................................. 43

2.4.2 Modelos envolvendo contribuintes pessoas jurídicas........................................... 49

2.4.3 Modelos envolvendo contribuintes que auferem rendimentos por conta própria . 57

2.5 Modelos teóricos de evasão considerando políticas de incerteza............................... 63

2.6 Modelos teóricos de evasão considerando efeitos sócio-comportamentais................ 70

2.7 Experimentos para avaliação de efeitos sócio-comportamentais em evasão tributária

........................................................................................................................................... 73

2.8 Medidas de evasão tributária da economia ................................................................. 83

2.9 Conclusões gerais do capítulo..................................................................................... 84

3 MODELOS LINEARES GENERALIZADOS HIERÁRQUICOS........................................... 86

3.1 Introdução.................................................................................................................... 86

3.2 Modelos lineares generalizados .................................................................................. 86

3.2.1 Regressão linear: simples e múltipla .................................................................... 90

3.2.2 Estrutura de dados correlacionados ..................................................................... 91

3.3 Modelos lineares hierárquicos ..................................................................................... 97

3.3.1 O modelo hierárquico nulo.................................................................................. 104

3.3.2 Alguns aspectos de locação de variáveis ........................................................... 106

3.4 Modelos lineares generalizados hierárquicos............................................................ 110

3.4.1 Opção entre as estimativas unit-specific e population-average.......................... 116

3.5 Conclusão.................................................................................................................. 118

4 INFERÊNCIA EM MODELOS LINEARES GENERALIZADOS HIERÁRQUICOS ........... 119

4.1 Introdução.................................................................................................................. 119

4.2 Estimação por mínimos quadrados ordinários .......................................................... 119

4.3 Mínimos quadrados generalizados............................................................................ 122

4.4 Estimação por máxima verossimilhança ................................................................... 124

4.4.1 Variável resposta contínua ................................................................................. 125

4.4.2 Variável Resposta Binária................................................................................... 126

4.5 Estimação em MLH ................................................................................................... 127

4.5.1 Notação matricial e conceitos iniciais ................................................................. 127

4.5.2 Estimativas de efeitos fixos por MQG................................................................. 131

4.5.3 Estimativas empíricas de Bayes para coeficientes aleatórios de nível 1............ 132

4.5.4 Estimativas de MV para componentes de variância/covariância........................ 134

4.6 Estimação em MLGH................................................................................................. 137

4.6.1 Conceitos iniciais e notação matricial ................................................................. 137

4.6.2 Obtendo estimativas unit-specific ....................................................................... 138

4.6.3 Obtendo estimativas population-average ........................................................... 142

4.7 Intervalos de confiança em MLGH ............................................................................ 143

4.8 Testes de hipóteses em MLGH ................................................................................. 143

4.8.1 Introdução ........................................................................................................... 143

4.8.2 Testes relacionados a efeitos fixos..................................................................... 144

4.8.3 Testes relacionados a coeficientes aleatórios de nível 1.................................... 145

4.8.4 Testes relacionados a componentes de variância/covariância........................... 146

4.9 Conclusão.................................................................................................................. 148

5 NOVO MÉTODO DE CLASSIFICAÇÃO DE CONTRIBUINTES PARA FISCALIZAÇÃO. 149

5.1 Introdução.................................................................................................................. 149

5.2 Conceituação de infração e definição das variáveis resposta de interesse aos modelos

lineares generalizados hierárquicos ................................................................................ 149

5.3 Processo esquemático do novo método de classificação ......................................... 151

5.4 Conclusões do capítulo ............................................................................................. 153

6 ANÁLISE EXPLORATÓRIA DE DADOS ECONÔMICO-FISCAIS DAS PESSOAS

JURÍDICAS.......................................................................................................................... 154

6.1 Descrição das bases de dados.................................................................................. 154

6.2 Pré-Processamento de dados ................................................................................... 155

6.3 Análise hierárquica exploratória ................................................................................ 160

6.3.1 A estrutura hierárquica em unidades .................................................................. 160

6.3.2 O MLGH1 nulo .................................................................................................... 161

6.3.3 O MLGH2 nulo .................................................................................................... 164

6.4 Conclusão.................................................................................................................. 166

7 ESTIMAÇÃO E APLICAÇÃO DE MODELOS À CLASSIFICAÇÃO DE CONTRIBUINTES

PARA FISCALIZAÇÃO ........................................................................................................ 167

7.1 Extração de amostras de validação........................................................................... 167

7.2 Variáveis candidatas aos modelos ............................................................................ 168

7.3 Processo para seleção de variáveis de níveis 1 e 2.................................................. 171

7.4 Estimativas e métricas de trabalho............................................................................ 172

7.5 O MLGH1................................................................................................................... 174

7.6 O MLGH2................................................................................................................... 178

7.7 Programas utilizados para os processos de estimação ............................................ 182

7.8 Análise de resíduos ................................................................................................... 183

7.9 Interpretação dos modelos estimados....................................................................... 184

7.9.1 MLGH1 ............................................................................................................... 184

7.9.2 MLGH2 ............................................................................................................... 186

7.9.3 Comparação entre o MLGH1 e MLGH2 finais .................................................... 188

7.10 Aplicação à classificação e validação dos modelos estimados ............................... 190

7.10.1 Desempenho das previsões para observações conhecidas............................. 190

7.10.2 Desempenho das previsões para novas observações ..................................... 193

7.11 Comparação entre os desempenhos do método novo e atual ................................ 195

7.12 Aspectos operacionais de utilização do novo método de classificação de

contribuintes para fiscalização......................................................................................... 196

8 CONSIDERAÇÕES FINAIS.............................................................................................. 198

8.1 Principais resultados.................................................................................................. 198

8.2 Conclusões em relação às questões de pesquisa .................................................... 202

8.3 Contribuições alcançadas.......................................................................................... 204

8.4 Limitações e oportunidades para estudos futuros ..................................................... 205

REFERÊNCIAS ................................................................................................................... 206

APÊNDICE A – O trabalho de Feinstein (1991) .................................................................. 214

APÊNDICE B – O trabalho de Murray (1995)...................................................................... 220

APÊNDICE C – O trabalho de Press (1995) ....................................................................... 228

APÊNDICE D – Estimação de MV por Newton-Raphson e Escores................................... 232

APÊNDICE E – Índices Econômico-Fiscais ........................................................................ 234

APÊNDICE F – Estatísticas para os Índices Econômico-Fiscais ........................................ 235

APÊNDICE G – Exemplo de Estatísticas Descritivas e Gráficos para os Índices EconômicoFiscais.................................................................................................................................. 237

APÊNDICE H – Análise em Componentes Principais (Valores de Balanço) ...................... 240

APÊNDICE I – Amostras de Validação ............................................................................... 241

APÊNDICE J – Estimativas para MLGH1 (Variáveis Selecionadas Assinaladas em Negrito)

............................................................................................................................................. 244

APÊNDICE K – Estimativas para MLGH2 (Variáveis Selecionadas Assinaladas em Negrito)

............................................................................................................................................. 251

APÊNDICE L – Comandos do R Project for Statistical Computing para Estimação do

MLGH2_Final....................................................................................................................... 261

xiii

Lista de Figuras

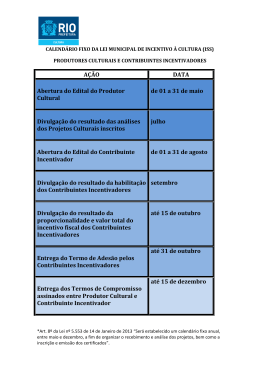

Figura 1: Principal processo de seleção de contribuintes PJ da SRF ................................... 23

Figura 2: Metodologia de pesquisa da tese........................................................................... 32

Figura 3: Relação entre as três inclinações relacionando MA e SES. ................................ 108

Figura 4: Relacionamento entre η ij e φ ij por meio da equação (3.39). ............................. 115

Figura 5: Novo método de classificação (seleção) de contribuintes para fiscalização........ 152

Figura 6: Gráfico de probabilidade Normal para resíduos dos MLGH Finais ...................... 184

Figura 7: Curvas ROC para Amostras de Estimação. ......................................................... 191

Figura 8: Histograma Parcial de I04. ................................................................................... 237

Figura 9: Boxplot de I04....................................................................................................... 238

Figura 10: Stem and Leaf Plot de I04. ................................................................................. 238

Figura 11: Histograma Parcial de I08. ................................................................................. 239

Figura 12: Histograma Parcial de I11. ................................................................................. 239

Lista de Quadros

Quadro 1: Efeitos de fatores políticos e ambientais nas condições de equilíbrio entre

contribuintes e agência tributária........................................................................................... 67

Quadro 2: Estrutura da CNAE-Fiscal................................................................................... 160

Quadro 3: Exemplo de classificação de contribuinte PJ...................................................... 160

Quadro 4: Natureza da Atividade Agregada........................................................................ 168

Quadro 5: Índices Econômico-Fiscais Utilizados na Pesquisa............................................ 234

Lista de Tabelas

Tabela 1: Estimativas para modelo tobit de Joulfaian e Rider (1998) ................................... 58

Tabela 2: Estimativas obtidas para as duas equações propostas por Ali, Cecil e Knoblett

(2001) .................................................................................................................................... 62

Tabela 3: Estimativas unit-specific para o MLGH1.............................................................. 162

Tabela 4: Estimativa population-average para o MLGH1.................................................... 162

Tabela 5: Estimativas MLHG1 (modelo linear binário) ........................................................ 164

Tabela 6: Estimativas unit-specific para o MLGH2.............................................................. 165

Tabela 7: Estimativa population-average para o MLGH2.................................................... 165

Tabela 8: Estimativas MLGH2 (modelo linear binário) ........................................................ 165

Tabela 9: Distribuição percentual das atividades informais................................................. 169

Tabela 10: Variação percentual do PIB (1998 e 1999)........................................................ 170

Tabela 11: Índice de Rentabilidade dos Setores Exportadores em 1999............................ 170

Tabela 12: Estimação do componente variância para modelos nulos ................................ 173

Tabela 13: Estimativas para MLGH1_NAG ......................................................................... 176

Tabela 14: Estimativas para MLGH1_Final ......................................................................... 178

Tabela 15: Estimativas para MLGH2_NAG ......................................................................... 180

Tabela 16: Estimativas para MLGH2_Final ......................................................................... 182

Tabela 17: Estimativas para variáveis presentes em ambos os modelos finais.................. 188

Tabela 18: Pontos de Corte para MLGH1_Final (Amostra Estimação)............................... 192

Tabela 19: Pontos de Corte para MLGH2_Final (Amostra Estimação)............................... 193

Tabela 20: Ponto de Corte para MLGH1_Final (Amostra Validação).................................. 193

Tabela 21: Ponto de Corte para MLGH2_Final (Amostra Validação).................................. 194

Tabela 22: Estimativas para modelo tobit de Feinstein (1991)............................................ 217

Tabela 23: Estimativas primeiro estágio (probit) de Murray(1995)...................................... 223

xiv

Tabela 24: Estimativas terceiro estágio (MQO) de Murray (1995) ...................................... 225

^

Tabela 25: relacionamento entre n e A .............................................................................. 230

Tabela 26: Estatísticas descritivas dos índices econômico-fiscais...................................... 235

Tabela 27: Estatísticas descritivas para I04 ........................................................................ 237

Tabela 28: Autovetores - CP: componente principal ........................................................... 240

Tabela 29: Inércia explicada................................................................................................ 240

Tabela 30: Efeitos do valor de E na fração amostral f, com N=9.757 ................................. 242

Tabela 31: Efeitos do valor de PQ no erro admissível E, com N=9.757.............................. 242

Tabela 32: Determinação de n para as Amostras de Validação ......................................... 243

Tabela 33: Estimativas para nível 1 (Primeira Rodada) ...................................................... 244

Tabela 34: Estimativas para nível 1 (Segunda Rodada) ..................................................... 246

Tabela 35: Estimativas para nível 1 (Terceira Rodada) ...................................................... 248

Tabela 36: Estimativas para nível 2 (Primeira Rodada) ...................................................... 249

Tabela 37: Estimativas para nível 2 (Segunda Rodada) ..................................................... 249

Tabela 38: Estimativas para nível 1 (Primeira Rodada) ...................................................... 251

Tabela 39: Estimativas para nível 1 (Segunda Rodada) ..................................................... 253

Tabela 40: Estimativas para nível 1 (Terceira Rodada) ...................................................... 255

Tabela 41: Estimativas para nível 1 (Quarta Rodada)......................................................... 256

Tabela 42: Estimativas para nível 1 (Quinta Rodada) ......................................................... 258

Tabela 43: Estimativas para nível 2 (Primeira Rodada) ...................................................... 260

xv

Lista de Siglas

ACP - Análise em Componentes Principais

ANCOVA - Análise de Covariância

ANOVA - Análise de Variância

BD1 - Banco de Dados 1

BD2 - Banco de Dados 2

BCCSLL - Base de Cálculo da Contribuição Social sobre o Lucro Líquido

BCCOF - Base de Cálculo da COFINS

BCPISP - Base de Cálculo do PIS/PASEP

CAPES - Coordenação de Aperfeiçoamento de Pessoal de Nível Superior

CCIC - Coeficiente de Correlação Intraclasse

CIAT - Centro Interamericano de Administrações Tributárias

CNAE-Fiscal - Classificação Nacional de Atividades Econômicas - Fiscal das

pessoas jurídicas

COFINS - Contribuição para o Financiamento da Seguridade Social (contribuição

administrada pela SRF)

COPAT - Coordenação de Política e Administração Tributária da SRF

CPI - Comissão Parlamentar de Inquérito

CSLL - Contribuição Social sobre o Lucro Líquido (contribuição administrada pela

SRF)

CTN - Código Tributário Nacional

DCTF - Declaração de Débitos e Créditos Tributários Federais

DIF - Discriminant Index Function do IRS

DIPJ - Declarações de Informações Econômico-Fiscais das Pessoas Jurídicas

DIRF - Declaração do Imposto de Renda Retido na Fonte

DOI - Declaração de Operações Imobiliárias

EM - Algoritmo Esperança-Maximização

ESDC - Estatísticas Suficientes para Dados Completos

EUA - Estados Unidos da América

GLHT - General Linear Hypothesis Test

ICMS - Imposto sobre Circulação de Mercadorias e Serviços (imposto administrado

pelos Estados)

iid - independente e identicamente distribuídas

xvi

IN - Inválido

IND - índice econômico-fiscal genérico

IPI - Imposto sobre Produtos Industrializados (imposto administrado pela SRF)

IR - Imposto de Renda (imposto administrado pela SRF)

IRPJ - Imposto de Renda das Pessoas Jurídicas (imposto administrado pela SRF)

IRPF - Imposto de Renda das Pessoas Físicas (imposto administrado pela SRF)

IRS - Internal Revenue Service dos Estados Unidos da América

IVA - Imposto sobre Valor Agregado

LACSLL - Lucro antes da Contribuição Social sobre o Lucro Líquido

LBRUTO - Lucro Bruto

LOPER - Lucro Operacional

LP - Lucro Presumido apurado pelas pessoas jurídicas

LREAL - Lucro Real apurado pelas pessoas jurídicas

MA - Mathematical Achievement (MA)

MLG - Modelos Lineares Generalizados

MLGH - Modelos Lineares Generalizados Hierárquicos

MLH - Modelos Lineares Hierárquicos

MLMG - Modelos Lineares Mistos Generalizados

MQO - Mínimos Quadrados Ordinários

MQG - Mínimos Quadrados Generalizados

MV - Máxima Verossimilhança

MVR - Máxima Verossimilhança Restrita

NR - Newton-Raphson

PASEP - Contribuição administrada pela SRF

PEC - Programa de Exame Coordenado do IRS

PIB - Produto Interno Bruto

PIS/PASEP - Contribuição para os Programas de Integração Social e de Formação

do Patrimônio do Servidor Público (contribuição administrada pela SRF)

PJ - Pessoas Jurídicas

PQL - algoritmo Penalized Quasi-Likelihood

RBCOF - Receita Bruta da COFINS

RBPISP - Receita Bruta do PIS/PASEP

RECLIQ - Receita Líquida

SECA - Self-Employment Tax dos EUA

xvii

SERPRO - Serviço Federal de Processamento de Dados

SES - Social Economic Status

SII - Servicio de Impuestos Internos do Chile

SRF - Secretaria da Receita Federal

TCMP - Programa de Avaliação do Cumprimento Tributário do IRS

TI - Tecnologia da Informação

UMS - Unidades Monetárias Simbólicas

VA - Variável Aleatória

18

1 INTRODUÇÃO AO TEMA

No contexto atual da administração tributária, é requisitado o controle, a curto,

médio e longo prazo, dos níveis de arrecadação de tributos e contribuições

administrados, haja vista sua relevância para a viabilização orçamentária do Estado.

Tal controle vem, inclusive, elevando sua importância na medida em que o critério de

déficit primário das contas públicas se insere, nos dias de hoje, como fator

determinante na vida de um país em tempos de globalização, pois tem sido

considerado como um dos indicadores de risco sistêmico da economia por parte de

organismos e empreendedores internacionais, o que, via de regra, impele à

formulação de políticas de gastos mais restritivas e a um acurado acompanhamento

dos ingressos públicos. Um planejamento pró-ativo pode ser um dos mediadores

para o alcance do controle dos fluxos de caixa públicos ou privados e, nesse

sentido, os sistemas de tributação, fiscalização e arrecadação devem ser

contemplados pelos gestores dos órgãos tributários da União, Estados ou

Municípios.

Em meio a esse turbulento cenário econômico mundial, são contemporâneos

tanto o fenômeno internet quanto a revolução em Tecnologia da Informação (TI), e o

nível de domínio e disseminação dessas novas tecnologias por parte de uma

sociedade ou organização é hoje fator determinante de suas possibilidades futuras

de sucesso econômico e social. Especificamente em termos de investimentos em TI

governamental, deve-se atentar para o fato de que o Brasil tem sido reconhecido,

inclusive internacionalmente, como uma potência mais do que emergente, atingindo

padrões de atendimento e eficiência semelhantes, e em certos casos até superiores,

aos dos países do primeiro mundo (BARRETO, 2003).

Fazendo parte atuante desse panorama econômico e tecnológico, o principal

órgão tributário brasileiro, a Secretaria da Receita Federal (SRF), responsável pela

administração, fiscalização e arrecadação de 333,58 bilhões de reais em impostos e

contribuições (ano de 2004), enquanto tem trabalhado nos termos de suas missões

institucionais, procura também acompanhar os recentes avanços em TI, e pode-se

dizer que seus esforços não têm sido infrutíferos. Por um lado, sucessivos recordes

de arrecadação têm sido percebidos ano após ano, o que, ao menos em termos de

viabilidade fiscal, não deixa de ser um fato auspicioso. Por outro lado, as políticas de

tecnologia adotadas pela SRF nos últimos anos tornaram-na depositária de vastas

19

informações econômico-fiscais de contribuintes brasileiros e uma referência mundial

no setor (BARRETO, 2003) - fato relevante, em 2005 mais de 99% dos contribuintes

brasileiros enviaram suas declarações de informações fiscais pela internet, sem a

ocorrência de maiores transtornos quanto à transmissão tempestiva e posterior

comprovação do envio dessas informações à SRF.

Essa massa de dados de informações fiscais só favorece o desenvolvimento e a

aplicação de metodologias modernas para a solução de problemas específicos da

SRF, principalmente no suporte e apoio à decisão. Em grande parte dos casos, a

solução pode ser viabilizada pela transformação da informação em estado puro em

conhecimento aplicável, no fluxo dos últimos avanços no uso de tecnologia

avançada para apoio à decisão.

O rápido aumento da capacidade de processamento computacional, associado

com o baixo custo do armazenamento, vem contribuindo para a construção de

repositórios de dados que permitem cruzar dados de diferentes fontes, procurando

identificar informações relevantes e transformando-as em conhecimento útil ao

processo decisório de uma organização. Este conjunto de metodologias e

tecnologias possui dois itens principais: o repositório de dados e os métodos de

análises exploratórias de dados, estes baseados em técnicas estatísticas e de

inteligência artificial.

1.1 Contextualização do problema

Uma das maiores preocupações da SRF tem sido o aperfeiçoamento constante

do processo de formulação e execução das políticas públicas de tributação e de

fiscalização. Para que um nível global de excelência organizacional seja atingido,

todas as subdivisões da SRF têm de ser acionadas e harmonizadas, de forma a que

suas

atribuições

e

missões

regimentais

sejam

exercidas

e

cumpridas

satisfatoriamente em todo o território nacional. Na Capital Federal, as coordenações

centrais formulam e determinam as políticas de logística e recursos humanos, de

administração e estudos tributários, de tributação, de tecnologia, de fiscalização e de

pesquisa e investigação, que por sua vez são jurisdicionadas e operacionalizadas

pelas superintendências das dez regiões fiscais do órgão sediadas, pela ordem, em

Brasília, Belém, Fortaleza, Recife, Salvador, Belo Horizonte, Rio de Janeiro, São

Paulo, Curitiba e Porto Alegre.

20

Um dos órgãos centrais em Brasília é a Coordenação-Geral de Política e

Administração Tributária (COPAT), cujas atribuições regimentais relacionam-se à

formulação de políticas e estudos em administração tributária que subsidiem os

demais sistemas da SRF. Um dos problemas identificados pela COPAT em sua

rotina operacional é a necessidade de auxiliar a programação das atividades de

fiscalização por meio de estudos que abordem o comportamento dos contribuintes

pessoas jurídicas e dos setores de atividades econômicas. Nesse contexto, seu

interesse tem sido a busca de um mecanismo que sistematize e caracterize o

comportamento destes contribuintes em relação às infrações à legislação tributária.

Para seus estudos, a COPAT dispõe das informações obrigatoriamente prestadas

pelos próprios contribuintes nas suas Declarações de Informações EconômicoFiscais das Pessoas Jurídicas (DIPJ), especialmente seus índices econômicofiscais. Com estudos desse escopo, a COPAT almeja subsidiar principalmente a

Coordenação-Geral de Fiscalização com estudos tributários que possam, agilmente,

identificar ou selecionar contribuintes prioritários à fiscalização. Além disso, espera

elevar seu nível de conhecimento em termos do fenômeno comportamental tributário

de contribuintes e setores econômicos.

A agilidade no processo de seleção de contribuintes para fiscalização é

sobremaneira importante, como fica claro a partir do exposto na próxima subseção.

1.1.1 Situação atual da seleção de contribuintes na SRF

Após a entrega das DIPJ por parte dos contribuintes Pessoas Jurídicas (PJ), a

qual se dá regularmente no último dia útil do mês de junho de cada ano, a SRF as

processa e armazena em seus bancos de dados. Posteriormente, essas informações

são adicionadas a diversas outras referentes aos pagamentos de tributos, às demais

declarações instituídas pela SRF e também às informações tributárias prestadas

compulsoriamente, ou por meio de convênio, por fontes externas de informação,

formando uma nova e ampla base de dados. Ou seja, até a efetiva programação de

um lote de fiscalizações, uma longa fase de coleta e pré-processamento dessas

informações tem de ser executada, de forma a que sejam reunidas em um único

banco de dados de cruzamento, o qual permite que os contribuintes apresentando

indícios de infração à legislação tributária de regência dos tributos administrados

pela SRF e incidentes sobre as pessoas jurídicas, quais sejam, Imposto de Renda

das Pessoas Jurídicas (IRPJ), Contribuição Social sobre o Lucro Líquido (CSLL),

21

Contribuição para os Programas de Integração Social e de Formação do Patrimônio

do Servidor Público (PIS/PASEP), Contribuição para o Financiamento da Seguridade

Social (COFINS) e Imposto sobre Produtos Industrializados (IPI), sejam finalmente

selecionados para fiscalização. É importante ressaltar que um indício de infração,

em geral, está associado a alguma inconsistência material em relação às

informações do contribuinte. A duração e a complexidade desse processo podem ser

aferidas na medida em que, conforme a atual programação operacional de seleção

de contribuintes, fundamentada na base de dados de cruzamento de informações,

as declarações entregues pelos contribuintes no exercício 2000, referentes às

atividades praticadas no ano-calendário 1999, tiveram o seu processo de seleção

para fiscalização encerrado ao final de 2003. Não é nenhum demérito para a

organização a ocorrência desse ínterim, pois isso ocorre em outras administrações

tributárias, conforme relatado no capítulo 2, haja vista que uma parte das

informações a serem agregadas ao banco de dados de seleção depende de fontes

externas e, portanto, está sujeita a esperas e eventuais atrasos. Mesmo as

informações internas à SRF, estas, antes de servirem à seleção, também têm de ser

harmonizadas, agregadas e consolidadas, pois são provenientes das diversas

declarações de informações existentes (DIPJ, DCTF, DIRF, DOI etc). Em suma,

após a recepção de todos os dados considerados necessários, essa grande massa

de informações tem de ser pré-processada antes de poder ser utilizada para

consultas e cruzamentos conjuntos.

O processo de seleção descrito no parágrafo anterior assemelha-se bastante à

difundida metáfora de uma malha colhendo os contribuintes de grande interesse

potencial à fiscalização, ou seja, prioritários. Uma vez selecionada uma empresa

(contribuinte PJ), a ação fiscal é finalmente programada e realizada, podendo durar

meses e até anos, a depender da complexidade das infrações efetivamente

encontradas, dos tributos envolvidos e da relevância fiscal da ação. Ao final da

fiscalização, duas ações são possíveis: pode ser lavrado um auto de infração

discriminando os tributos e as respectivas infrações fiscais cometidas, assim como

sua capitulação legal, e o valor em espécie dos tributos e multas a pagar; ou então a

ação fiscal pode ser encerrada sem resultado.

É importante notar que nem todas as pessoas jurídicas que possivelmente

apresentem

indícios

de

infração

fiscal

serão

efetivamente

fiscalizadas,

principalmente devido ao instituto jurídico tributário da decadência e, também, à

22

carência de servidores públicos. A decadência, prevista pelo art. 173 da Lei nº 5.172,

de 25 de Outubro de 1966, Código Tributário Nacional, extingue, após cinco anos

contados a partir do disposto nos incisos e no parágrafo único do referido artigo de

lei, o direito à constituição do crédito tributário na esfera administrativa. Portanto, as

fiscalizações prioritárias, ou seja, motivadas por vultosos indícios de infração à

legislação, vão sendo executadas paulatinamente, até que sejam encerrados os

trabalhos referentes a um determinado ano-calendário e iniciados os trabalhos

relativos ao ano-calendário subseqüente, objetivando evitar a decadência do direito

à constituição de créditos tributários relevantes. Esse procedimento está plenamente

em consonância com o verificado a partir da revisão de literatura do capítulo 2, já

que as agências têm por obrigação agir nos casos envolvendo as infrações mais

graves.

Cumpre ressaltar que todo esse pré-processamento, disponibilização e

manutenção do banco de dados de cruzamento de informações são executados, de

forma terceirizada, pelo Serviço Federal de Processamento de Dados (SERPRO),

empresa pública de prestação de serviços em tecnologia da informação, e,

conseqüentemente, isso representa um gasto de recursos públicos por parte da

SRF, tanto na parte de pré-processamento e desenvolvimento da base de dados de

seleção, quanto na sua efetiva utilização por parte dos servidores do órgão.

Deve-se, ainda, acrescentar que o aqui exposto refere-se ao principal processo

de seleção empregado pela SRF, mas não o único, já que existem ainda outros

recursos e métodos utilizados, como o de pura inadimplência ou de análise

econômico-financeira temporal de declarações, porém, atualmente podem ser

consideradas residuais as fiscalizações assim originadas, já que o órgão tem

investido cada vez mais na vertente do processamento e cruzamento de

informações.

Todo o processo de seleção de contribuintes descrito anteriormente pode ser

sinteticamente ilustrado pela Figura 1.

23

Figura 1: Principal processo de seleção de contribuintes PJ da SRF

Esse processo de seleção por cruzamento de informações é considerado como

uma referência na área de tributação. Sistemas similares ao brasileiro são utilizados

por outros países da América Latina, como Peru e Cuba (VERAMENDI, 2002;

JOVER e AYALA, 2002), e a tendência é sua maior difusão, pois há grande

intercâmbio entre as administrações tributárias dos 36 membros associados do

Centro Interamericano de Administrações Tributárias (CIAT), incluindo-se aí o Brasil.

Pode-se dizer que o processo da Figura 1 é bastante moderno e atual e vem

funcionando a contento, não fosse isso não se verificariam os sucessivos recordes

anuais de arrecadação federal. Contudo, um ponto a se considerar é quanto ao

inevitável tempo transcorrido entre o cometimento de uma infração, a prestação das

informações em DIPJ por parte do contribuinte, o processamento das informações

internas à SRF, o recebimento das informações fiscais externas à SRF, o

processamento conjunto de todos esses dados e a efetiva seleção e fiscalização do

contribuinte infrator. Esse intervalo de tempo não é de ocorrência exclusiva em

relação às auditorias da SRF, haja vista que no capítulo 2 ele é abordado como

tema de estudos tributários (por exemplo, ver seção 2.6). O fato é que quanto maior

esse tempo decorrido, maior o risco de embaraço contábil e cadastral à constituição

e cobrança do crédito tributário na esfera administrativa, já que muitas vezes quando

se vai notificar um contribuinte depois de decorrido um longo tempo do cometimento

de uma determinada infração, este pode ter incorrido em fatos contábeis relevantes falência, cisão, incorporação, fusão, ou ainda não ser localizado em seu domicílio

fiscal. Assim, qualquer esforço no sentido de agilizar a ação do sistema de

24

fiscalização é considerado positivo e relevante no contexto de órgãos tributários

como a SRF.

1.1.2 Problema, questões e hipóteses de pesquisa

Uma das maneiras de atender à solução do mencionado problema operacional

da COPAT é pelo estabelecimento de um método que classifique as pessoas

jurídicas de maneira apropriada, tanto em relação ao processo de análise e

compreensão de fenômenos comportamentais tributários, auxiliando na formulação

de políticas públicas, quanto ao de fiscalização de contribuintes e, portanto, esse

será o tema da pesquisa aqui apresentada.

Uma constatação relevante nesse momento de apresentação do problema é que

as pessoas jurídicas (empresas) subdividem-se em diversos setores de atividades

econômicas que são de naturezas distintas (v.g., indústria, comércio, serviços,

extrativas etc). Isso acarreta que os setores da economia devem ser levados em

consideração no estabelecimento de padrões de comportamento econômico-fiscais

de empresas, pois é intuitivo que empresas de um mesmo setor econômico tendem

a ser mais parecidas entre si do que empresas participantes de distintos setores da

economia, haja vista que aquelas partilham certas características contábeis

individuais e de desempenho econômico-setorial em comum que acabam por

ocasionar a correlação entre suas medidas. Além disso, acredita-se que as próprias

infrações à legislação tributária tendem a ser mais parecidas intra-setores, pois o

fenômeno da concorrência de mercado talvez faça com que sejam rapidamente

disseminadas entre empresas que são diretamente concorrentes.

Portanto o problema de pesquisa consubstancia-se nas seguintes questões

de pesquisa:

1) Como estabelecer um método de classificação de contribuintes pessoas

jurídicas, com base na previsão de seus comportamentos tributários, que as

classifique, ágil e tempestivamente, em função do grau de interesse para fins

de

fiscalização,

levando

em

consideração,

de

forma

sistematizada

(incorporando de forma estruturada todas as atividades econômicas das PJ), a

provável correlação de medidas (informações) existente entre empresas de um

mesmo setor de atividades econômicas?

25

No contexto dessa questão, é importante demarcar que tal método de

classificação, uma vez materializado, vem a corresponder, na prática, a um processo

de seleção de contribuintes para fiscalização, fundamentado na previsão de

comportamento e posterior classificação dos contribuintes em dois grupos distintos,

os de interesse à fiscalização tributária e os demais.

2) O procedimento descrito na primeira questão de pesquisa já foi tentado por

outros órgãos congêneres com sucesso?

3) Como conferir a aludida agilidade à previsão e classificação?

4) Quais as variáveis individuais das PJ (principalmente dentre seus índices

econômico-fiscais)

e

dos

setores

econômicos

que

se

sobressaem

significativamente no contexto da classificação de contribuintes infratores?

5) O método proposto na primeira questão de pesquisa seria vantajoso?

5.1) Qual o desempenho da classificação efetuada frente ao método de

seleção por cruzamento de informações utilizado pela SRF?

5.2) O custo do desenvolvimento e implantação compensa?

Ante ao exposto, uma primeira hipótese de pesquisa é de que qualquer estudo

tributário que envolva a classificação de contribuintes PJ para fins de fiscalização

deve levar em consideração e avaliar a correlação de medidas, posto que existente,

entre contribuintes que se dedicam às mesmas atividades econômicas.

Contudo, uma segunda hipótese relaciona-se ao fato de que essa correlação de

medidas não vem sendo considerada de forma sistematizada (abrangendo, de forma

estruturada, todos os setores de atividades econômicas das PJ) pelos estudos e

trabalhos já realizados envolvendo a seleção de contribuintes para fiscalização.

Conseqüentemente, formula-se, então, uma terceira hipótese relacionada à

possibilidade de consideração sistematizada da correlação de medidas intra-setores

econômicos, e de explicação, ao menos em parte, da variabilidade (entre setores

econômicos) aferida a partir dessa sistematização, durante a condução do processo

de classificação de contribuintes PJ como de relevante interesse fiscal, por meio de

uma modelagem estatística hierárquica formalizada nos termos dos Modelos

Lineares Generalizados Hierárquicos (MLGH), que encerram moderna e recente

metodologia paramétrica especificamente desenvolvida para o tratamento estatístico

26

de estruturas correlacionadas de dados que, em um único modelo, são destacadas

em níveis hierárquicos distintos e que justamente proporcionam a consideração, pelo

modelo, da correlação de medidas existente nos dados.

Por fim, uma quarta e última hipótese relaciona-se à viabilidade de especificação

de modelos hierárquicos contando, no plano (nível) dos contribuintes, tão-somente

com variáveis obrigatoriamente prestadas pelo próprio sujeito passivo (contribuinte)

em sua declaração de informações, sendo, portanto, independentes de dados

individuais de contribuintes prestados por fontes externas de informação e

possibilitando assim uma maior agilidade de ação ao processo de classificação.

Por todo o exposto, este trabalho insere-se nos seguintes contextos

científicos e tecnológicos:

I) Melhorar a eficiência da fiscalização efetuada por parte dos órgãos

tributários, especificamente em relação aos contribuintes pessoas jurídicas.

II) Classificar contribuintes PJ, em termos de interesse potencial à fiscalização,

levando em consideração, de forma sistematizada, a atividade econômica por

eles praticada, o que vem a se constituir em diferencial em relação aos

estudos científicos realizados até o momento.

III) Modernizar e aperfeiçoar os processos de previsão em administração

tributária, por meio da utilização de recente e complexa técnica estatística

paramétrica (MLGH).

Uma vez apresentados o contexto operacional, o problema e as questões de

pesquisa, os objetivos deste trabalho podem ser abordados na próxima seção.

1.2. Objetivos do trabalho

1.2.1 Objetivo geral

O trabalho aqui proposto procura desenvolver e especificar um método de

classificação de contribuintes pessoas jurídicas, com base na previsão de seus

comportamentos tributários, objetivando classificá-las como prioritárias ou não à

fiscalização, por meio de um MLGH que modele a probabilidade de ocorrência de

uma característica de interesse definida, considerando como preditoras, no plano

27

dos contribuintes (nível 1), tão-somente as informações prestadas pelo próprio

sujeito passivo e levando em consideração, no nível 2, a atividade econômica por

ele praticada.

1.2.2 Objetivos específicos

São objetivos específicos deste estudo:

a) identificar o referencial teórico e o estado da arte dos métodos e critérios para

seleção de contribuintes para fiscalização e também da questão mais geral da

modelagem em evasão tributária, por meio de uma revisão de literatura teórica e

empírica. Com isso, procura-se avaliar de que forma o problema de pesquisa tem

sido abordado no mundo científico e levantar os principais resultados já obtidos,

subsidiando a proposta de solução do referido problema;

b) levantar, pré-processar e analisar de forma exploratória os dados relevantes à

pesquisa aqui referenciada;

c) avaliar a magnitude da variabilidade no comportamento tributário empresarial

exclusivamente devida aos setores de atividades econômicas;

d) analisar os diferentes aspectos que possivelmente expliquem a variabilidade das

respostas no nível dos setores de atividades econômicas, de forma a subsidiar o

classificador proposto;

e) pesquisar e selecionar as principais variáveis explicativas da variabilidade

individual das respostas no nível dos contribuintes pessoas jurídicas, de forma a

compor um rol de variáveis candidatas ao MLGH;

f) modelar e estimar um classificador de contribuintes PJ, fundamentado em um

MLGH contando com variável resposta associada à infração tributária;

g) com base no MLGH, executar inferências e demais interpretações em relação ao

comportamento tributário de empresas e de setores econômicos;

h) validar o MLGH e apresentar os principais resultados obtidos a partir das

respectivas previsões.

28

1.3 Justificativa

1.3.1 Relevância

Com respeito ao mencionado cenário operacional da seleção de contribuintes por

cruzamento de informações da Figura 1, cumpre ressaltar que o classificador aqui

proposto não é talhado, a princípio, para substituir integralmente nenhum processo

de seleção ora existente na SRF ou em outras agências. O que se pretende é

estabelecer uma alternativa inovadora de classificação de contribuintes que tenciona

ser uma opção decisória nos momentos que exijam pronta reação por parte dos

órgãos tributários.

Exemplificando, se a utilização prática do novo método de classificação prevê

que determinado contribuinte que acaba de entregar sua declaração de informações

tem grande probabilidade de apresentar indício de infração fiscal e, portanto, o

classifica como prioritário à fiscalização, seria fortemente recomendável a

deflagração de uma subseqüente ação fiscal, haja vista o já mencionado risco de

embaraço à constituição e cobrança do crédito tributário na esfera administrativa.

Assim, por todo o exposto, podem ser relacionados como relevantes os seguintes

resultados obtidos pela consecução da presente pesquisa:

a) O classificador visa a utilizar como preditoras, no plano dos contribuintes PJ, tãosomente as informações prestadas pelos próprios sujeitos passivos em suas

declarações regularmente estabelecidas. Sendo assim, no caso da SRF, a utilização

do método aqui proposto pode se dar tão logo sejam entregues as DIPJ, no último

dia útil de junho de cada ano, portanto com uma possibilidade de grande

antecedência de ação em relação ao atual processamento por cruzamento de

informações, que, conforme já explicitado, é mais demorado em termos de

resultados, uma vez que envolve a reunião e compatibilização, em uma base de

dados única, de volumosas informações prestadas tanto pelos contribuintes, quanto

por um grande número de órgãos e entidades externas à SRF, o que resulta em um

inevitável período de espera para deflagração de ações fiscais. Portanto, o novo

método de classificação, por sua projetada agilidade, possivelmente possibilita a

recuperação de créditos tributários que antes teriam seu lançamento e cobrança

procrastinados indefinidamente em função de impedimentos cadastrais ou contábeis,

ou até inviabilizados em definitivo pelo decurso da decadência.

29

b) O classificador é menos oneroso, em termos de sua utilização, do que o processo

esquematizado pela Figura 1, representando economia de recursos públicos.

Primeiramente, porque não requisita o volumoso processamento e armazenamento

de informações internas e externas sensíveis (sigilosas) para o estabelecimento de

uma

programação

de

ações

fiscais,

mas

tão-somente

das

informações

obrigatoriamente prestadas anualmente pelos próprios contribuintes em suas

declarações regularmente estabelecidas. Ressalte-se que, no caso da SRF,

declarações desta espécie, como as DIPJ, já vêm sendo rotineiramente recebidas e

armazenadas anualmente. Em segundo lugar, porque o próprio relatório final

corporificado por esta pesquisa representa sistematização de conhecimento

passível, em tese, de ser seguida e aplicada de forma autônoma pelos próprios

órgãos tributários. Em síntese, considerando-se o caso concreto da SRF, o método

prescinde de mão de obra ou recursos financeiros adicionais aos já despendidos e,

pelo contrário, sua adoção reduz em muito os recursos técnicos e humanos hoje

terceirizados pelo órgão.

c) O classificador representa maior autonomia dos órgãos tributários em relação às

fontes externas de informação, que, como já exposto, requisitam preciosos tempo e

recursos financeiros para seu processamento e efetiva utilização; particularmente no

caso da SRF, maior autonomia estratégica e operacional é obtida em relação ao

prestador terceirizado de serviços (SERPRO), uma vez que será gerado

conhecimento inédito e alternativo aos serviços hoje terceirizados. É preciso lembrar

que conhecimento representa poder frente às situações de negociação entre as

partes de um contrato.

d) À parte o problema a ser abordado pela presente pesquisa, existem diversos

outros assuntos de responsabilidade regimental das agências e órgãos tributários

que apresentam intrinsecamente a característica da existência de informações

agrupadas entre atividades econômicas, regiões fiscais, unidades administrativas

etc. Portanto, o desenvolvimento do conhecimento e domínio empírico de

metodologias que sejam passíveis de considerar suas conseqüências nas medidas

de interesse pode contribuir para o aperfeiçoamento de processos operacionais

rotineiros nesses órgãos, no caso do Brasil, por exemplo, o estudo da adequação

dos produtos da SRF aos seus clientes - como as declarações de renda

30

informatizadas - ou o controle operacional das atividades tributárias envolvidas nas

importações/exportações nos principais portos e aeroportos brasileiros.

1.3.2 Ineditismo

a) Na fase de análise exploratória de dados, esta pesquisa quantifica, de forma

inédita e sistematizada (incorporando de forma estruturada todos os setores de

atividades econômicas das PJ), a correlação de medidas existente intra-setores

econômicos, no que se refere às infrações tributárias, por meio do cálculo de

coeficientes de correlação intraclasse.

b) Em termos da especificação de métodos para seleção de contribuintes para

fiscalização, o método de classificação proposto nesta pesquisa leva em

consideração, pela primeira vez de forma sistematizada, a correlação de medidas

existente intra-setores econômicos, assim como explica, também de forma inédita,

parte da variabilidade (entre setores econômicos) aferida a partir dessa

sistematização.

c) Esta pesquisa propõe um novo método de classificação de contribuintes que é

pioneiro quanto à utilização de modelos hierárquicos (MLH ou MLGH) em estudos

científicos de escopo tributário.

d) O estabelecimento do classificador auxilia a SRF no conhecimento da dinâmica

que rege a variabilidade no comportamento tributário individual dos contribuintes PJ

brasileiros - principalmente por elucidar e aclarar os indicadores econômico-fiscais

significativamente importantes no contexto das infrações fiscais, haja vista que estes

comporão a matéria-prima para a seleção das variáveis preditoras dos modelos - e

também dos setores de atividades econômicas, um de seus grandes interesses

atuais, produzindo resultados inéditos e relevantes à formulação de políticas

tributárias.

1.3.3 Complexidade

Primeiramente, deve-se reconhecer que a aferição da capacidade contributiva

dos contribuintes pessoas jurídicas (ver capítulo 2) é bastante mais complexa do que

no caso das pessoas físicas, pois aqueles se caracterizam por apresentarem

múltiplas operações contábeis que acabam por gerar incidências tributárias diversas.

Ademais, a própria proposição de métodos específicos para seleção de contribuintes

31

para fiscalização, segundo o verificado no capítulo 2, não vem sendo tema profuso

em trabalhos científicos, haja vista que estes vêm privilegiando estudos econômicoteóricos de difícil transposição para a prática, limitação esta, aliás, relatada por

vários dos autores referenciados no próximo capítulo, uma vez que são

constrangidos a excessivas suposições prévias; ou então aspectos interpretativos

que, embora relevantes, não possuem por escopo o pragmatismo de identificar ou

selecionar contribuintes potencialmente infratores.

Quanto aos estudos relatados no capítulo 2 versando especificamente sobre

métodos para seleção de contribuintes, estes demonstram claramente que o

comportamento do contribuinte está sujeito a uma ampla gama de variáveis, tanto

individuais quanto econômico-setoriais, que, portanto, devem ser cientificamente

integradas de forma sistematizada; fato este que, contudo, não vem ocorrendo,

segundo o manifestado na segunda hipótese de pesquisa, o que demonstra

claramente a não trivialidade do problema de tese.

Além disso, a agilização da ação de fiscalização é aspiração milenar e, no limite,

visa a que a infração fiscal seja de conhecimento e repressão instantânea,

constituindo-se em desafio cuja complexidade e importância ficam patentes a partir

da leitura da subseção 1.1.1 deste capítulo, na qual foi relatado que a fiscalização

brasileira vem agindo com defasagem, em relação ao cometimento de infrações

fiscais, de alguns anos, o que não obstante estar em consonância com o verificado

pela revisão de literatura, situa-se longe do considerado ideal.

Pelo exposto nos parágrafos acima, a complexidade do problema e questões de

pesquisa justificam plenamente um estudo em nível de doutorado.

1.4 Metodologia de trabalho

1.4.1 Procedimentos

Esta pesquisa propõe um método de classificação de contribuintes para fins de

fiscalização tributária que incorpora em si a correlação de medidas existente nos

dados de trabalho. As hipóteses que alicerçam a pesquisa foram relacionadas na

subseção 1.1.2.

A partir destes subsídios, uma fundamentação teórica do tema da evasão

tributária, dos métodos de seleção de contribuintes e de métodos estatísticos Modelos Lineares Generalizados (MLG), Modelos Lineares Hierárquicos (MLH) e

32

Modelos Lineares Generalizados Hierárquicos (MLGH) - a serem aplicados para a

viabilização da solução proposta tem de ser levada a termo para a consecução dos

objetivos de pesquisa. Nesse contexto, o fluxograma da Figura 2 ilustra de forma

sintética a metodologia de pesquisa adotada.

Figura 2: Metodologia de pesquisa da tese.

Em relação à fase de ajuste e validação de modelos na Figura 2, devido às

oportunidades proporcionadas pelas bases de dados de trabalho, conforme

detalhado no capítulo 5, nesta pesquisa são modelados dois MLGH, ambos

prestando-se de forma autônoma e simultânea à classificação de contribuintes, com

o objetivo de prever como resposta esperada a probabilidade de ocorrência de duas

características de interesse distintas, mas identicamente importantes no âmbito

tributário, quais sejam, presença de indício de infração fiscal e presença de efetiva

infração fiscal.

Para a formalização dos modelos e de suas respostas esperadas, os indícios de

infração e infrações propriamente ditas foram considerados em sua forma geral abrangendo os tributos administrados pela SRF e incidentes sobre as PJ, quais

sejam, IRPJ, CSLL, PIS/PASEP, COFINS e IPI - e não especificamente por imposto

ou contribuição, aspecto este devido, integralmente, à característica dos dados

disponibilizados para o trabalho.

33

Quanto às preditoras, ressalte-se que os MLGH levam em consideração tanto

variáveis explicativas do comportamento individual dos contribuintes PJ quanto

variáveis que justificam a variabilidade da resposta entre os setores econômicos.

Os dados disponíveis (população objetivo) para esta pesquisa são: os

relacionados às informações prestadas à SRF pelas pessoas jurídicas brasileiras,

em suas DIPJ referentes ao exercício 2000, ano-calendário 1999, que apuraram o

imposto de renda pelo regime do Lucro Real, excluindo-se as instituições

financeiras; as informações relacionadas às fiscalizações programadas e executadas

pela SRF em relação a esse mesmo ano calendário; e também aspectos econômicosetoriais levantados pelo próprio autor desta pesquisa.

Quanto aos aspectos de amostragem, os dados de trabalho foram previamente

divididos em duas amostras: estimação e validação (ver Apêndice I). O objetivo aqui

é viabilizar o processo tradicional em modelagem estatística, que envolve a

estimação de parâmetros do modelo e sua posterior validação através de uma

amostra adicional de dados.

1.4.2 Classificação da pesquisa

O processo de pesquisa aqui enfocado pode ser classificado sob quatro aspectos

distintos, de acordo com Silva e Menezes (2001, p. 20-21), a saber:

I) Quanto à sua natureza, a presente pesquisa é aplicada, uma vez que "objetiva

gerar conhecimentos para aplicação prática dirigidos à solução de problemas

específicos". No caso desta pesquisa, o problema é o identificado na seção 1.1.2.

II) Quanto à abordagem do problema, a pesquisa é predominantemente quantitativa,

uma vez que se vai utilizar intensivamente de métodos estatísticos para sua

consecução.

III) Do ponto de vista de seus objetivos, esta pesquisa classifica-se como explicativa,

pois almeja "identificar os fatores que determinam e contribuem para a ocorrência

dos fenômenos", sendo que os fenômenos já ocorreram.

IV) Por fim, em relação aos procedimentos técnicos a serem adotados para seu

alcance, a pesquisa classifica-se como bibliográfica, já que perfaz uma intensiva

revisão de literatura sobre o tema de pesquisa e sobre as ferramentas estatísticas a

serem aplicadas na solução proposta; e também como um estudo de caso, já que

34

"envolve o estudo profundo e exaustivo de um ou poucos objetos de maneira que se

permita o seu amplo e detalhado conhecimento".

1.4.3 Convenções adotadas

Quanto às citações diretas de autores apresentadas no texto, adiante-se aqui que

em todos os casos envolvendo referências bibliográficas grafadas em línguas que

não a Portuguesa, a tradução foi executada pelo próprio autor desta pesquisa.

No corpo do trabalho, quando inseridas em um contexto estatístico descritivo, as

expressões singulares "significância", "significante" e "significativa", entendem-se,

respectivamente, por "significância estatística", "estatisticamente significante" e

"estatisticamente significativa". Além disso, as palavras auditado e fiscalizado são

consideradas sinônimas no contexto do texto.

Em termos da apresentação de resultados de trabalhos de autores estrangeiros

no capítulo 2, considerou-se por tradução de tax a palavra "imposto", que

corresponde à tradução literal para a língua Portuguesa. Entretanto, no Brasil a

palavra "tributo" é diferente de "imposto", conforme está conceituado no próximo

capítulo, sendo o primeiro o gênero e o segundo a espécie. Adicionalmente, a

natureza de um tributo independe de sua denominação, e isso por vezes é

controverso no Brasil, inclusive juridicamente. Assim, optou-se por traduzir a

expressão tax evasion por "evasão tributária", de forma a adequá-la ao conceito

mais genérico de tributo no Brasil.

Em relação às várias referências bibliográficas citadas nas seções 3.1 e 4.1,

estas estão ordenadas por grau de contribuição para o desenvolvimento da pesquisa

lá delineada.

1.4.4 Limitações da pesquisa

Em relação à base de dados de trabalho, ressalte-se que não foram

disponibilizadas à pesquisa todas as informações prestadas anualmente pelos

contribuintes em suas DIPJ entregues à SRF, mas somente um subconjunto dessas

informações, como detalhado no capítulo 6, fato que torna esta uma pesquisa ainda

não esgotada no contexto das DIPJ.

Além disso, o método de classificação proposto e aplicado neste trabalho se

limita aos contribuintes PJ que apuraram o Lucro Real no exercício 2000, anocalendário 1999, não sendo válidos, portanto, para outros tipos contribuintes. A

35

opção por limitar a pesquisa a esse tipo de contribuintes deveu-se à relevância fiscal

dos mesmos e também aos dados disponibilizados para o trabalho.

Outro ponto importante é que, conforme já mencionado, os aspectos

relacionados aos indícios e infrações tributárias foram aqui considerados em termos

genéricos, e não especificamente por tributo, o que pode ter reduzido a capacidade