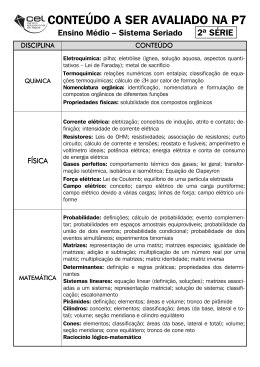

Álgebra Linear

Índice

Lógica e Demonstração

3

1 Demonstração Directa

3

2 Recíproco e Contrapositivo

3

3 Demonstração Indirecta ou por Redução ao Absurdo

4

4 Demonstração por Indução Matemática

5

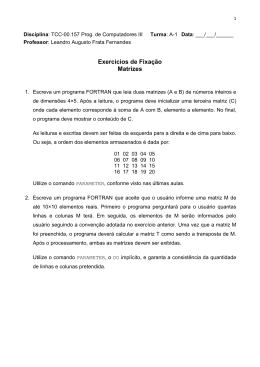

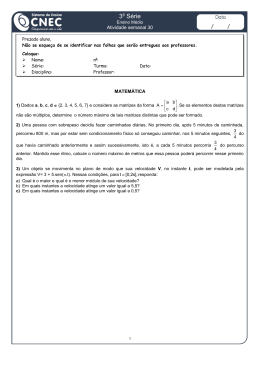

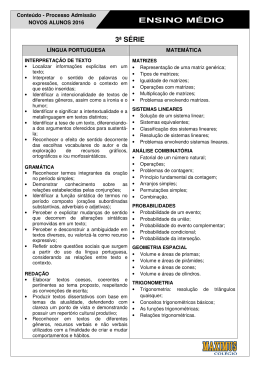

Matrizes e Determinantes

7

5 Nota Histórica

7

6 Teoria das Matrizes

15

6.1 Definições e Generalidades . . . . . . . . . . . . . . . . . . . . . . 15

6.2 Álgebra Matricial . . . . . . . . . . . . . . . . . . . . . . . . . . . 18

6.2.1 Soma de matrizes. . . . . . . . . . . . . . . . . . . . . . . 18

6.2.2 Multiplicação de uma matriz por um escalar. . . . . . . . 20

6.2.3 Multiplicação de matrizes. . . . . . . . . . . . . . . . . . . 22

6.2.4 Multiplicação por blocos. . . . . . . . . . . . . . . . . . . 27

6.3 Transposição de matrizes. Matrizes Simétricas. . . . . . . . . . . 30

6.4 Traço de uma matriz . . . . . . . . . . . . . . . . . . . . . . . . . 33

6.5 Dependência e independência lineares de filas paralelas de uma

matriz. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 35

6.6 Característica de uma matriz. Operações elementares. . . . . . . 41

6.6.1 Operações Elementares . . . . . . . . . . . . . . . . . . . 42

6.6.2 Determinação da Característica de Linha de uma Matriz . 51

6.7 Inversão de Matrizes . . . . . . . . . . . . . . . . . . . . . . . . . 56

6.7.1 Definições e Resultados . . . . . . . . . . . . . . . . . . . 56

6.7.2 Determinação da Inversa de uma Matriz Regular . . . . . 66

6.8 A Característica Revisitada . . . . . . . . . . . . . . . . . . . . . 70

6.9 Resolução de Sistemas de Equações Lineares . . . . . . . . . . . . 74

6.9.1 Enquadramento Teórico . . . . . . . . . . . . . . . . . . . 74

6.9.2 Sistemas de Equações Lineares Indeterminados . . . . . . 87

6.9.3 Algoritmo de Gauss-Jordan . . . . . . . . . . . . . . . . . 97

6.10 Matrizes com propriedades especiais . . . . . . . . . . . . . . . . 98

2

2 Recíproco e Contrapositivo

Lógica e Demonstração

Resumem-se, neste capítulo, os três métodos de demonstração matemática existentes, e cuja aplicação será assídua ao longo de todo o texto.

1

Demonstração Directa

O modo directo de demonstrar a proposição A ⇒ B consiste em determnar

uma sequência de teoremas e/ou axiomas aceites na forma Ai ⇒ Ai+1 , para

i = 1, · · · , n de modo a que A1 ⇒ A e An ⇒ B. A dificuladade está, obviamente,

em encontrar a sequência de axiomas e/ou teoremas que preenchem o vazio entre

A e B. A afirmação A designa-se por hipótese, ou seja, aquilo que é dado e a

afirmação B designa-se por tese, isto é, a conclusão. O método assim descrito

denomina-se raciocínio dedutivo.

Consideremos o seguinte Teorema ilustrativo:

Teorema 1 Seja m um inteiro par e p um inteiro qualquer. Então m × p é um

inteiro par.

Demonstração.

1. m é um inteiro par (Dado, por hipótese).

2. existe um inteiro q tal que m = 2 × q (Definição de um número inteiro

par).

3. m × p = (2q) p (Utilizando o axioma a = b ⇒ ac = bc).

4. m × p = 2 (qp) (Pela propriedade associativa da multiplicação).

5. m × p é um inteiro (Pela definição de um número inteiro par).

2

Recíproco e Contrapositivo

Definição 1 Considere-se a proposição Π da forma A ⇒ B : se a hipótese A

se verifica então a tese, B, também se verifica. O recíproco da proposição Π é

a proposição B ⇒ A.

3

3 Demonstração Indirecta ou por Redução ao Absurdo

O recíproco de uma proposição Π consiste em inverter os papéis da hipótese

e da tese de Π. Há muitas situações em que o recíproco e uma proposição verdadeira não é verdadeiro. Por exemplo, a proposição a = b ⇒ ac = bc, ∀a,b,c∈R é

sempre verdadeira, mas ac = bc ⇒ a = b não é verdadeira para quaisquer

a, b, c ∈ R; basta, evidentemente, que c = 0. Outras situações há, no entanto,

em que uma proposição e o seu recíproco são ambas verdadeiras.

Definição 2 Se a proposição A ⇒ B e o seu recíproco, B ⇒ A, são ambos

verdadeiros diz-se que A se verifica se e só se B se verifica. Alternativamente,

diz-se que A e B são equivalentes e escreve-se A ⇐⇒ B.

Existe uma proposição, formada a partir de qualquer proposição Π, que é

verdadeira sempre que Π é verdadeira: o contrapositivo de Π.

Definição 3 Considere-se uma proposição Π : A =⇒ B. A proposição ∼ B =⇒∼

A designa-se por contrapositivo de Π.

Exemplo 1 Considere-se a seguinte proposição:

(A) n é um número primo diferente de 2.=⇒ (B) n é um inteiro ímpar.

O contrapositivo desta proposição será dado por:

(∼ B) n é um inteiro par.=⇒ (A) n não é um número primo ou n = 2.

3

Demonstração Indirecta ou por Redução ao

Absurdo

Consideremos o seguinte resultado:

Proposição 1 A proposição A =⇒ B é verdadeira se e só se o seu contrapositivo é verdadeiro.

Demonstração. Com recurso a uma tabela de verdade é extremamente

simples provar que (A =⇒ B) ⇐⇒ (∼ B =⇒∼ A):

A

V

F

V

F

B

V

V

F

F

A =⇒ B

V

V

F

V

∼B

V

F

V

F

∼A

V

V

F

F

∼ B =⇒∼ A

V

V

F

V

Note-se as colunas relativas a (A =⇒ B) e (∼ B =⇒∼ A) o que completa a

demonstração.

4

4 Demonstração por Indução Matemática

Assim, uma forma de mostrar a validade de uma proposição A =⇒ B é

mostrar a validade do seu contrapositivo ∼ B =⇒∼ A. Esta linha de raciocínio

designa-se por demonstração indirecta ou demonstração por redução ao absurdo.

Com efeito, se, partindo de ∼ B, provarmos directamente que ∼ A é verdadeira,

o absurdo reside no facto de, originalmente, assumirmos que a afirmação A é

verdadeira.

Conideremos o seguinte Teorema ilustrativo.

Teorema 2 Se p é um número natural e p2 é par, então p é par.

¢

¡

Demonstração. Pretende-se mostrar p2 é par ⇒ (p é par), para qualquer p ∈ N.

Suponhamos então que existe um natural p tal que p é ímpar. Então ∃q∈N :

2

2

p = 2q +1. Assim,

virá (2q + 1)2 = 4q 2 +4q +1,

¡ 2 p ¢= (2q + 1) . Desenvolvendo,

2

2

isto é, p = 4 q + q + 1. Mas então p é um número ímpar, o que é absurdo,

pois a hipótese original era a de que p2 era par. O absurdo vem de se assumir

que p é par, logo p terá de ser ímpar.

4

Demonstração por Indução Matemática

Existe um terceiro método de demonstração que difere significativamente do

método por demonstração directa e do método de transformação por indução:

a demonstração por indução matemática.

As demonstrações por indução têm a limitação de só poderem ser aplicadas a

afirmações envolvendo os números inteiros ou, indexadas aos números inteiros.

Consideremos então uma sequência de afirmações indexadas aos números inteiros, de modo que Π (1) é a primeira afirmação, Π (2) é a segunda afirmação

e Π (n) é a n − ésima afirmação. Suponhamos que é possível demonstrar dois

factos àcerca desta sequência:

(i) A afirmação Π (1) é verdadeira.

(ii) Se, para algum k ∈ N, a afirmação Π (k) é verdadeira então a afirmação

Π (k + 1) também é verdadeira.

Nestas circunstâncias a afirmação Π (n) é verdadeira para qualquer n ∈ N.

Conideremos o seguinte Teorema ilustrativo.

Teorema 3 A soma dos primeiros n números naturais, 1 + 2 + · · · + n, é igual

a 12 n (n + 1).

5

4 Demonstração por Indução Matemática

Demonstração. Procedamos à demonstração por Indução Matemática,

sabendo que a afirmação a demonstrar é dada por:

Π (n) = 1 + 2 + · · · + n =

1

n (n + 1)

2

(i) Consideremos n = 1. Neste caso, a soma dos primeiros naturais será 1,

que é precisamente igual a 12 × 1 × (1 + 1).

(ii) Suponhamos que a afirmação é válida para qualquer k ∈ N. Mostemos

que então deverá ser válida para k + 1. Assumindo que Π (k) é verdadeira,

sabemos que:

Π (k) = 1 + 2 + · · · + k =

1

k (k + 1)

2

Queremos mostrar que:

Π (k + 1) = 1 + 2 + · · · + (k + 1) =

1

(k + 1) (k + 2)

2

Mas,

Π (k + 1) = (1 + 2 + · · · + k) + (k + 1) =

{z

}

|

Π(k)

=

=

=

=

1

k (k + 1) + (k + 1) =

2

¶

µ

1

k + 1 (k + 1) =

2

µ

¶

k+2

(k + 1) =

2

1

(k + 2) (k + 1)

2

Logo, Π (n) é válida para qualquer n ∈ N.

6

5 Nota Histórica

Matrizes e Determinantes

5

Nota Histórica

Historicamente, os primeiros esboços de matrizes e determinantes remontam ao

segundo século a. C. embora existam traços da sua existência em épocas tão

distantes quanto o séc. IV a. C. No entanto, não foi senão nos finais do séc.

XVII da nossa era que as ideias reapareceram e o seu desenvolvimento floresceu.

Não é surpreendente que os primórdios das matrizes e determinantes tenham surgido através do estudo de sistemas de equações lineares. Os Babilónios

estudaram problemas que levaram à resolução simultânea de equações lineares.

Alguns destes problemas sobreviveram até hoje preservados em placas de argila.

Por exemplo, uma placa datada de cerca de 300 a. C. contém o seguinte problema:

Existem dois campos com uma área total de 1800 m2 . Um produz

grão à taxa de 23 de alqueire por m2 enquanto o outro produz grão à

taxa de 12 de alqueire por m2 . Se a colheita total é de 1100 alqueires

qual é a área de cada campo.

Este problema conduz, modernamente, à resolução do sistema de equações

(1) ilustrado em seguida:

½

x + y = 1800

+ 12 y = 1100

2

3x

(1)

Os Chineses, no período entre 200 a. C. e 100 a. C., chegaram mais próximo

da noção de matriz que os Babilónios. Efectivamente, é justo referir que o

texto chinês ”Nove Capítulos da Arte Matemática” escrito durante o período da

dinastia Han (206 a. C.-220 d. C.) ilustra os primeiros exemplos conhecidos de

métodos matriciais, descrevendo principalmente um conjunto de problemas com

regras gerais para a sua solução. Estes problemas têm um carácter aritmético e

conduzem a equações algébricas com coeficientes numéricos. A título ilustrativo

considere-se um desses problemas:

Existem três tipos de milho. Três molhos do primeiro tipo, dois do

segundo e um do terceiro completam 39 medidas. Dois molhos do

primeiro tipo, três do segundo e um do terceiro prefazem 34 medidas. Finalmente, um molho do primeiro tipo, dois do segundo e três

do terceiro prefazem 26 medidas. Quantas medidas de milho estão

contidas num molho de cada tipo?

Modernamente, o sistema de equações lineares (2) permite resolver o problema em aberto.

7

5 Nota Histórica

3x + 2y + z = 39

2x + 3y + z = 34

x + 2y + 3z = 26

(2)

O autor do texto propôs um método de resolução notável: os coeficientes

das três equações a três incógnitas que compõem o sistema são dispostos como

uma tabela num ”quadro de contagem”:

1 2 3

2 3 2

3 1 1

26 34 39

Os métodos modernos dos finais do séc. XX levariam a dispor os coeficientes das equações lineares em linhas, em vez de colunas, mas intrinsecamente

o método é idêntico.

Seguidamente, o autor, escrevendo em 200 a. C. instrui o leitor a multiplicar

a coluna central por 3 e subtrair a coluna da direita, tantas vezes quanto possível;

de modo semelhante, subtrai-se a coluna da direita, tantas vezes quanto possível,

da primeira coluna multiplicada por 3. Destas operações ,resulta o quadro:

0 0 3

4 5 2

8 1 1

39 24 39

Seguidamente, a coluna da esquerda é multiplicada 5 vezes e a coluna central

subtraída tantas vezes quanto possível, resultando no quadro:

0 0 3

0 5 2

36 1 1

99 24 39

Desta tabela é possível determinar, em primeiro lugar, a solução relativamente ao terceiro tipo de milho, seguida do segundo e finalmente do primeiro

tipo. Este método é hoje em dia conhecido como o Método de Eliminação de

Gauss, discutido no âmbito da resolução de sistemas de equações lineares, tema

abordado na secção 6.9, que só virá a ser bem compreendido no início do séc.

XIX.

O matemático italiano Cardan, na sua obra ”Ars Magna”(1545), fornece

uma regra para resolver sistemas de 2 equações lineares, a que dá o nome de

regula de modo. Esta regra é, substantivamente, o que modernamente se designa

por Regra de Cramer para a resolução de sistemas de 2 equações lineares a 2

incógnitas, embora Cardan não tenha dado o passo decisivo e final na definição

8

5 Nota Histórica

da regra. Assim, Cardan não chega até á definição de determinante, mas, numa

perpectiva actual é possível concluir que o seu método leva efectivamente à

definição de determinante.

Muitos dos resultados associados à Teoria Elementar das Matrizes apareceram antes das Matrizes serem objecto de investigação matemática. Por exemplo,

de Witt, na sua obra ”Elementos das Curvas”, publicado como parte dos comentários à edição latina de 1660 da ”Geometria” de Descartes, mostra como

uma transformação dos eixos ordenados reduz a equação de uma cónica à forma

canónica. O processo consiste, modernamente, na diagonalização de uma matriz

simétrica, mas de Witt nunca raciocinou nestes termos.

A ideia de um conceito de determinante surge mais ou menos simultaneamente na Europa e no Japão no último quartel do séc. XVII, embora Seki, no

Japão, tenha publicado em primeiro lugar. Em 1683, Seki escreve o ”Método

para Resolver Problemas Dissimulados”, que contém métodos matriciais descritos em tabelas, de forma em tudo idêntica à descrita nos métodos chineses,

acima abordados. Embora sem conter nenhuma palavra que corresponda ao

conceito ”determinante”, Seki mesmo assim introduz a noção e fornece métodos gerais que permitem o seu cálculo, basados em exemplos. Utilizando os seus

”determinantes”, Seki conseguiu calcular determinantes de ordem 2, 3, 4 e 5

e aplicou-os à resolução, não de sistemas de equações lineares, mas de equaçõe

lineares.

De modo extraordinário, o primeiro aparecimento de um determinante na

Europa, ocorreu no exacto ano de 1683. Nesse ano, Leibniz escreveu a de

l’Hôpital explicando-lhe que o sistema de equações dado por:

... tinha solução porque

10 + 11x + 12y = 0

20 + 21x + 22y = 0

30 + 31x + 32y = 0

10×21×32+11×22×30+12×20×31=10×22×31+11×20×32+12×21×30

Esta igualdade é precisamente a condição que determina que a solvabilidade

de um sistema de equações requer que o determinante da matriz dos coeficientes

seja nulo. note-se que Leibniz não utiliza coeficientes numéricos mas dois símbolos, em que o primeiro indica a equação em que ocorre e o segundo a que letra

pertence. Assim, ”21” denota o que modernamente escreveríamos como a21 .

Leibniz estava convencido que a notação matemática era a chave para o progresso, tendo experimentado com várias notações para o sistema de coefcientes.

Os seus manuscritos não publicados contêm mais de cinquenta formas de representar sistemas de coeficientes, sobre as quais trabalhou por um período de 50

9

5 Nota Histórica

anos, com início em 1678. Apenas duas publicações, em 1700 e 1710, contêm

resultados sobre sistemas de coeficientes, cuja notação é a mesma da utilizada

na carta a de l’Hôpital acima mencionada.

Leibniz utilizou o termo ”resultante” para certas somas combinatórias de

termos de um determinante. Demonstrou vários resultados sobre ”resultantes”,

incluindo o que é actualmente conhecido como a Regra de Cramer. Leibniz também sabia que um determinante podia ser desenvolvido utilizando uma qualquer

coluna do sistema de coeficientes, no que é conhecido actualmente como o Desenvolvimento de Laplace. Assim como o estudo de sistemas de coeficientes

de equações lineares levaram Leibniz na rota dos determinantes, o estudo de

sistemas de coeficientes de formas quadráticas resultou naturalmente num desenvolvimento no sentido de uma Teoria das Matrizes.

Na década de 1730 McLaurin escreveu o seu ”Tratado de Álgebra”, embora

não tenha sido publicado até 1748, dois anos após a sua morte. A obre contém

os primeiros resultados sobre determinantes, demonstrando a Regra de Cramer

para matrizes de ordem 2 e 3 e indicando como se deveria proceder para matrizes

de ordem 4.

Cramer forneceu a regra geral, que hoje aporta o seu nome, para a resolução

de sistemas de n equações a n incógnitas no artigo ”Introdução à Análise de

Curvas Algébricas”, publicado em 1750. O artigo foi motivado pelo desejo de

determinar a equação de uma curva plana que passasse por um certo número de

pontos. A regra propriamente dita surge como apêndice ao artigo, mas não é

fornecida qualquer demonstração. O seu enunciado, segundo o próprio Cramer,

é como se segue:

O valor de cada incógnita é determinado por um conjunto de n quocientes, cujo denominador comum é composto de tantas parcelas

quantas as permutações de n ”coisas”.

Cramer prossegue, explicando precisamente como estas parcelas são calculadas, assim como os respectivos sinais (”+” ou ”-”). São efectivamente produtos de certos coeficientes das equações. Refere ainda que os n numradores das

fracções podem ser determinados substituindo certos coeficientes neste cálculo

por termos constantes do sistema de equações.

O trabalho sobre determinantes começava agora a emergir com certa regularidade. Em 1764, Bézout forneceu métodos para calcular determinantes,

assim como Vandermonde em 1771. Em 1772, Laplace afirmou que os métodos introduzidos por Cramer e Bézout eram impraticáveis. Num artigo onde

estuda as órbitas dos planetas interiores, Laplace discute a solução de sistemas

de equações lineares sem efectivamente os calcular, utilizando determinantes.

Surpreendentemente, Laplace utilizou o termo ”resultante” para referir o que

modernamente se designa por determinante; surpreendente, uma vez que é o

mesmo termo utilizado por Leibniz embora não consta que Laplace tivesse estado a par do trabalho de Leibniz. Laplace propôs ainda o desenvolvimento de

um determinante, método que aporta hoje em dia o seu nome.

10

5 Nota Histórica

Num artigo de 1773, Lagrange estudou identidades para determinantes funcionais de ordem 3. No entanto, este comentário é feito a posteriori, uma vez

que Lagrange não via nenhuma relação entre o seu trabalho e o de Vandermonde

e Laplace. Este artigo de 1773, sobre Mecânica, contém pela primeira vez o que

hoje é a interpretação volumétrica de um determinante. Efectivamente, Lagrange demonstrou que o tetraedro formado pelos pontos O (0, 0, 0), M (x, y, z),

M 0 (x0 , y 0 , z 0 ) e M 00 (x00 , y 00 , z 00 ) tem volume dado por

1

[z (x0 y 00 − y 0 x00 ) + z 0 (yx00 − xy 00 ) + z 00 (xy 0 − yx0 )]

6

que é precisamente igual a

1

6

do determinante da matriz

x x0

y y0

z z0

x00

y 00

z 00

O termo ”determinante” foi inicialmente introduzido por Gauss em ”Disquisitiones Arithmeticae” de 1801, no decurso da discussão sobre formas quadráticas. Gauss utilizou este termo porque o determinante determina as propiedades

de uma forma quadrática. No entanto, o conceito não é o mesmo que o conceito moderno de determinante. Na mesma obra, Gauss dispõe os coeficientes

das suas formas quadráticas em tabelas rectangulares. Gauss descreve a multiplicação de matrizes, mas em termos de uma composição, pelo que ainda não

vislumbrava o conceito de uma Ágebra Matricial. Descreve ainda a inversão de

matrizes no contexto particular de matrizes de coeficientes relativas a formas

quadráticas.

O Método de Eliminação de Gauss, cuja aparição remonta ao texto ”Nove

Capítulos da Arte Matemática” em 200 a. C., foi utilizado por Gauss no seu

trabalho envolvendo o estudo da órbita do asteróide Pallas. Utilizando observações de Pallas feitas entre 1803 e 1809, Gauss obteve um sistema de 6 equações

lineares a 6 incógnitas. Gauss propôs um método sistemático para a resolução

de tais equações, precisamente o Método de Eliminação de Gauss sobre a matriz

dos coeficientes.

Foi Cauchy, em 1812, que usou o termo ”determinante” no seu sentido actual. O trabalho de Cauchy é o mais completo de entre os primeiros trabalhos

sobre determinantes. Reprovou os primeiros resultados e forneceu novos resultados por si descobertos sobre menores complementares e matrizes adjuntas.

No seu artigo de 1812, apresentado numa conferência no Institut de France,

o teorema da multiplicação de determinantes é demonstrado pela primeira vez

embora na mesma conferência, Binet tenha apresentado um artigo contendo

uma demonstração do mesmo teorema mas menos satisfatória que a prova de

Cauchy.

Em 1826 e no contexto das formas quadráticas em n variáveis, Cauchy utilizou o termo ”tableau” para a matriz de coeficientes. Descobriu os seus valores

11

5 Nota Histórica

próprios e forneceu resultados sobre a diagonalização de uma matriz, no processo que envolvia a transformação de uma forma quadrática numa soma de

quadrados. Cauchy introduz ainda a ideia de matrizes semelhantes, mas não

o termo, e mostrou que se duas matrizes são semelhantes então têm a mesma

equação característica. Ainda no contexto das formas quadráticas, mostrou que

qualquer matriz real simétrica é diagonalizável.

Jacques Sturm forneceu uma generalização do problema dos valores próprios

no ocontexto da resolução de sistemas de equações diferenciais ordinárias. Com

efeito, o conceito de valor próprio surgiu 80 anos antes, de novo em trabalhos

sobre sistemas de equações diferenciais realizados por d’Alembert. Na altura,

d’Alembert estudava o movimento de uma corda com massas associadas em

vários pontos do seu comprimento.

Deve ser notado que nem Cauchy nem Jacques Sturm se aperceberam do

alcance e generalidade das ideias que introduziram, considerando-as apenas no

contexto específico das suas áreas de investigação. Jacobi, na década de 1830

e posteriormente Kronecker e Weierstarss nas décadas de 1850 e 1860, respectivamente, também desenvolveram resultados sobre matrizes mas, de novo, no

contexto específico das transformações lineares. Jacobi publicou três tratados

sobre determinantes em 1841. Estes foram importantes na medida em que a

definição de determinante é introduzida de forma algorítmica. Para além disso,

Jacobi não especifica quais os termos dos determinantes, pelo que os resultados

se aplicam tão bem a casos onde os termos são números ou funções. Estes três

artigo de Jacobi tornaram a idieia de determinante largamente conhecida

Cayley, também escrevendo em 1841, publicou a primeira contribuição inglesa para a Teoria dos Determinantes. No seu artigo, utilizou duas linhas

verticais limitando uma matriz, para denotar o seu determinante, notação esta

que permaneceu até aos nossos dias.

Eisenstein, em 1844, denotou substituições lineares por uma letra única e

mostrou como adiconá-las e multiplicá-las como vulgares números, excepto no

que respeita à sua comutatividade. É justo referir que Eisenstein foi o primeiro

a pensar que as substituições lineares poderiam formar uma álgebra, como se

pode induzir de um seu artigo publicado em 1844:

Um algoritmo para o seu cálculo pode ser baseado na aplicação das

regras normais para as operações soma, multiplicação, divisão e exponenciação a equações simbólicas entre sistemas lineares. Obtêm-se

deste modo equações simbólicas correctas, apenas ressalvando que a

ordem dos factores não pode ser alterada.

O primeiro a uilizar o termo ”matriz ” foi Sylvester em 1850. Sylvester

definiu uma matriz como sendo um arranjo rectangular de termos no qual se

podiam definir vários determinantes sobre arranjos de termos contidos no arranjo global. Após ter deixado a América de regresso a Inglaterra em 1851,

Sylvester tornou-se advogado e conheceu Cayley, também advogada e que partilhava com o primeiro o mesmo interesse pela Matemática. Cayley reconheceu

12

5 Nota Histórica

imediatamente o significado do conceito e matriz e, em 1853 publicaria uma

nota, mencionando, pela primeira vez, o conceito de inversa de uma matriz.

Em 1858, Cayley publicou o seu ”Memorando sobre a Teoria das Matrizes”,

o qual constitu um texto notável por conter a primeira definição abstracta de

matriz. Cayley mostra que os arranjos de coeficientes anteriormente estudados

relativos a formas quadráticase transformações lineares são casos especiais de

um conceito mais geral, o conceito de matriz. Cayley propõe uma Álegbra

Matricial onde define a adição, multiplicação, multiplicação por um escalar e

inversão. Adicionalmente, propõe uma construção explícita para a forma da

inversa de uma matriz em termos do seu determinante. Mais ainda, Cayley

mostra que, no caso das matrizes de ordem 2, qualquer matriz satisfaz a sua

equação característica. Refere que verificou o resultado para matrizes de ordem

3, propondo uma demonstração mas:

[...] não me parece necessário empreender numa demonstração formal para o caso geral de matrizes de qualquer ordem [...]

O importante resultado de que uma matriz satisfaz a sua equação característica tem a designação especial de Teorema de Cayley-Hamilton. Qual então o

pael de Hamilton? Efectivamente, Hamilton demonstrou o caso especial para

matrizes de ordem 4, no decurso das suas investigações sobre quaterniões.

Em 1870 surgiu a Forma Canónica de Jordan no ”Tratado sobre Substituições

e Equações Algébricas”, escrito por Jordan. O conceito surge no contexto de

uma forma canónica para substituições lineares sobre o corpo finito de ordem

primo.

Frobenius, em 1878 escreveu um importante texto sobre matrizes, ”Sobre

Substituições Lineares e Formas Bilineares”, embora não pareça ao corrente do

trabalho de Cayley. Neste artigo, Frobenius trata dos coeficientes de formas e

não utiliza o termo ”matriz ”. No entanto, demonstra resultados importantes

sobre matrizes canónicas como representantes de classes de equivalência de matrizes. Cita Kronecker e Weierstrass como tendo considerado casos especiais

dos seus resultados em 1874 e 1868, respectivamente. Frobenius também demonstrou o resultado geral de que uma matriz satisfaz a sua equação característica.

Este artigo de Frobenius de 1878 também encerra a definição de característica

de uma matriz, a qual foi utilizada nas suas investigações em formas canónicas

e na definição de matrizes ortogonais.

A nulidade de uma matriz quadrada foi definida por Sylvester em 1884.

Sylvester definiu a nulidade da matriz A, denotada por n (A), como sendo o

maior i tal que todo o menor complementar de A de ordem n − i + 1 é nulo.

Sylvester estava interessado em invariantes de matrizes, isto é, propriedades que

não são alteradas por certas transformações. Sylvester demonstrou que:

máx {n(A), n(B)} ≤ n(AB) ≤ n(A) + n(B)

Em 1896, Frobenius tomou conhecimento do texto ”Memorando sobre a Teoria das Matrizes” escrito em 1858 por Cayley, adoptando desde então o termo

13

5 Nota Histórica

”matriz ”. Embora Cayley tenha apenas demonstrado o Teorema de CayleyHamilton para matrizes de ordem 2 e 3, Frobenius atribui generosamente o resultado a Cayley, mau grado ter sido aquele o primeiro a demonstrar o teorema

no caso geral.

Uma definição axiomática de determinante foi utilizada por Weierstrass nas

suas lições e, após a sua morte, foi publicada em 1903 na nota ”Sobre a Teoria dos Determinantes”. No mesmo ano, as lições de Kronecker sobre determinantes também foram publicadas, de novo, postumamente. Com estas duas

publicações, a moderna Teoria dos Determinantes tomou vida própria mas levou

um pouco mais de tempo a que a Teoria das Matrizes no seu todo se estabelecesse como uma teoria totalmente aceite. Um importante texto, que deu às

matrizes o devido espaço dentro da Matemática foi a ”Introdução à Álgebra

Superior ” de Bôcher, publicado em 1907. Turnbull e Aitken escreveram textos

influentes nos anos 30 do séc. XX. O texto ”Uma Introdução à Álgebra Linear ”

de 1955 escrito por Mirsky deu à Teoria das Matrizes o impulso necessário para

se manter até hoje como um dos mais importantes temas das licenciaturas em

Matemática.

14

6 Teoria das Matrizes

6

Teoria das Matrizes

6.1

Definições e Generalidades

Definição 4 (Matriz) Sejam K um corpo e m e n números inteiros positivos;

designa-se por matriz sobre K (cujos elementos se designam por escalares) a

todo o quadro de elementos de K dispostos em m linhas e n colunas.

Nota 1 K, em particular, pode ser o conjunto dos números reais, R. Neste

caso, as matrizes dizem-se reais.

Para designar genericamente uma matriz utilizam-se as seguintes notações:

A=

a11

a21

..

.

a12

a22

..

.

···

···

a1,n−1

a2,n−1

..

.

a1n

a2n

..

.

am1

am2

···

am,n−1

amn

aij ∈ K

i = 1, ..., m

= [aij ] ,

j = 1, ..., n

(3)

Nestas notações, o primeiro índice (i) do elemento genérico aij indica a

linha e o segundo (j) a coluna em que se encontra o elemento de K. Por

exemplo, a23 é o elemento da matriz que se encontra na linha 2 e na coluna

3. A matriz denotada acima mostra que, em geral, é costume designar-se uma

matriz por uma letra maiúscula (quando não houver necessidade de especificar

os seus elementos) e os elementos pela correspondente letra minúscula afectada

pelos índices convenientes. Em algumas circunstâncias é por vezes conveniente

representar o elemento (i, j) por (A)ij .

Definição 5 Designa-se por Mm×n (K) o conjunto de todas as matrizes do tipo

m × n (e lê-se ”éme-por-éne”) sobre o corpo K.

As matrizes do conjunto Mm×n (K) podem ser classificadas quanto à forma

em matrizes rectangulares ou matrizes quadradas. Relativamente às matrizes

rectangulares destacam-se alguns tipos como ilustrado na Tab. 1.

Relativamente às matrizes quadradas, estas constituem um importante caso

particular que se caracteriza pelo número de linhas (m) ser igual ao número de

colunas (n). No caso das matrizes quadradas do tipo n × n , a sua dimensão é

definida como ordem, designando-se a matriz como matriz de ordem n. Dentro

desta sub-classe de matrizes destacam-se alguns tipos como ilustrado na Tab.

2.

Definição 6 (Matriz quadrada) Designa-se por matriz quadrada de ordem

n a uma matriz A do tipo n × n. O conjunto das matrizes quadradas de ordem

n sobre um corpo K designa-se por Mn (K).

15

6 Teoria das Matrizes

Matrizes Rectangulares (m 6= n)

Designação

Forma Geral

Matriz Linha

£

¤

ou

a11 a12 · · · a1n

Vector Linha

(m = 1)

a11

a21

Matriz Coluna

..

ou

.

Vector Coluna

am1

(n = 1)

ou

{a11 , a21 , · · · , am1 }

Tabela 1: Principais tipos de Matrizes Rectangulares

Matrizes Quadradas (m = n)

Designação

Forma Geral

a11 a12 · · · a1n

0 a22 · · · a2n

Matriz Triangular Superior

..

..

..

(i > j =⇒ aij = 0)

.

.

.

0

a11

a21

..

.

0 ···

0 ···

a22 · · ·

..

.

ann

0

0

..

.

an1

a11

0

..

.

an2 · · ·

0 ···

a22 · · ·

..

.

ann

0

0

..

.

Matriz Triangular Inferior

(i < j =⇒ aij = 0)

Matriz Diagonal

(aij = 0; i 6= j)

0

0

· · · ann

ou

diag {a11 , a22 , · · · , ann }

É uma matriz diagonal em que

Matriz Escalar

aij = 0, i 6= j; aij = a ∈ K, i = j

diag {a, a, · · · , a}

É a matriz escalar em que

Matriz Identidade

m=n=1

aij = 0, i 6= j; aij = 1 ∈ K, i = j

diag {1, 1, · · · , 1}

Representa-se por In (ou apenas I)

Neste caso identifica-se a matriz

[a] com o próprio escalar a ∈ R

Tabela 2: Principais tipos de Matrizes Quadradas

16

6 Teoria das Matrizes

Uma matriz diagonal pode tanbém ser entendida como uma matriz simultaneamente triangular superior e triangular inferior.

Definição 7 (Elementos homólogos) Dadas as matrizes A = [aij ] e B = [bij ]

do mesmo tipo m × n sobre um corpo K, designam-se por elementos homólogos

aos elementos com os mesmos índices, isto é, àqueles elementos que estão nas

mesmas linha e coluna. Por exemplo, a36 e b36 são elementos homólogos.

Definição 8 (Matrizes iguais) Dadas duas matrizes A = [aij ] e B = [bij ]

do mesmo tipo m × n sobre um corpo K, estas dizem-se iguais se os elementos

homólogos forem iguais. Denota-se simbolicamente essa igualdade por A = B.

Definição 9 (Diagonal) Seja a matriz A = [aij ] ∈ Mm×n (K). Designa-se

por diagonal principal da matriz A aos elementos

ª

©

a11 , a22 , · · · , amin(m,n),min(m,n)

(que se designam por elementos principais da matriz).

Se A = [aij ] ∈ Mn (K) a diagonal principal da matriz A será dada por

{a11 , a22 , · · · , ann } e é possível definir a diagonal secundária dada pelos elementos {a1n , a2,n−1 , · · · , an1 }.

Nota 2 As diagonais de uma matriz tomam uma relevância especial quando se

consideram matrizes quadradas.

Exemplo 2 Considerem-se as seguintes matrizes e identifiquemos as respectivas diagonais:

3

0

1

3 1

• -1 2

0

-1 1 . Diagonal Principal: {3, 2, −3}. Diagonal Se0 -2 -3

1 1

cundária: não tem.

3

0

• -1 2 . Diagonal Principal: {3, 2}. Diagonal Secundária: não tem.

0 -2

3

0

1

0 . Diagonal Principal: {3, 2, −3}. Diagonal Secundária:

• -1 2

0 -2 -3

{1, 2, 0}.

17

6 Teoria das Matrizes

Definição 10 (Matriz nula) Designa-se por matriz nula do tipo Mm×n (K)

à matriz A = [aij ] tal que aij = 0, ∀(i,j)∈{1,...,m}×{1,...,n} . Neste caso, denota-se

A por 0m×n ou simplesmente por 0 se a ordem estiver subentendida e não houver risco de confusão com o escalar 0 (o elemento neutro para a adição do corpo

K).

Definição 11 (Matriz identidade) Designa-se por matriz identidade de ordem n à matriz escalar A = [aij ] ∈ Mn (K), tal que aii = 1 (onde ”1” é

o elemento neutro para a multiplicação no corpo K). Neste caso, denota-se A

por In ou simplesmente por I se a ordem estiver subentendida e não hou- ver

ambiguidade.

6.2

Álgebra Matricial

Discutem-se nesta secção as principais operações com matrizes: adição de matrizes, multiplicação de uma matriz por um escalar e multiplicação de matrizes.

6.2.1

Soma de matrizes.

Definição 12 Sejam A = [aij ] , B = [bij ] ∈ Mm×n (K). Define-se soma A + B

à matriz C = [cij ], tal que cij = aij + bij , ∀(i,j)∈{1,...,m}×{1,...,n} .

Nota 3 Se as matrizes A e B não forem do mesmo tipo, isto é, se não tiverem

as mesmas dimensões e/ou o corpo subjacente não for igual, não é possível

determinar A + B, pelo que a soma de A com B diz-se indefinida.

Proposição 2 O conjunto Mm×n (K) munido da adição definida na Definição

12 constitui um grupo abeliano (ou comutativo):

1. ∀A,B∈Mm×n (K) , ∃C∈Mm×n (K) : C = A + B. Esta é a propriedade mais

simples das estruturas algébricas. Ao verificar esta propriedade diz-se

que o conjunto Mm×n (K) é um grupóide. Alternativamente, diz-se que

Mm×n (K) é fechado para a adição.

2. ∀A,B,C∈Mm×n (K) , A + (B + C) = (A + B) + C. Propriedade associativa

para a adição de matrizes.

3. ∀A,B∈Mm×n (K) , A + B = B + A. Propriedade comutativa para a adição de

matrizes.

4. ∀A∈Mm×n (K) , ∃B∈Mm×n (K) : A + B = A. A matriz B designa-se por elemento neutro para a adição de matrizes e representa-se, como já verificámos, por 0, ou por 0m×n .

18

6 Teoria das Matrizes

5. ∀A∈Mm×n (K) , ∃B∈Mm×n (K) : A + B = 0. A matriz B designa-se por simétrico da matriz A para a adição de matrizes e representa-se por −A.

Diz-se ainda que todos os elementos A ∈ Mm×n (K) são regulares.

Demonstração.

1. Como A, B ∈ Mm×n (K), A + B ∈ Mm×n (K). Adicionalmente

= [aij ] + [bij ]

= [aij + bij ]

(A + B)ij

Como aij , bij ∈ K então K é fechado para a adição, isto é aij + bij ∈ K e

portanto [aij + bij ] ∈ Mm×n (K).

2. Como A, B, C ∈ Mm×n (K) então A + (B + C) e (A + B) + C estão

definidas. Adicionalmente

{A + (B + C)}ij

= [aij ] + [bij + cij ]

= [aij + (bij + cij )]

(porque a adição é associativa em K)

= [(aij + bij ) + cij ]

= [aij + bij ] + [cij ]

= {(A + B) + C}ij

3. Como A, B ∈ Mm×n (K) então A + B e B + A estão definidas. Adicionalmente

(A + B)ij

= [aij ] + [bij ]

= [aij + bij ]

(porque a adição é comutativa em K)

= [bij + aij ]

= [bij ] + [aij ]

= (B + A)ij

4. Seja A ∈ Mm×n (K) e B = 0m×n ∈ Mm×n (K). Então:

(A + B)ij

= [aij ] + [bij ]

= [aij + 0]

(porque 0 é o elemento neutro da adição em K)

= [aij ]

= (A)ij

19

6 Teoria das Matrizes

5. Seja A = [aij ] ∈ Mm×n (K) e B = [bij ] ∈ Mm×n (K) tal que bij =

−aij , i = 1, ..., m; j = 1, ..., n. Então:

(A + B)ij

(porque ∀a∈K , ∃b∈K

Exemplo

·

1

•

3

·

1

•

2

£

3

•

6.2.2

=

=

=

:

=

=

[aij ] + [bij ]

[aij + bij ]

[aij + (−aij )]

a + b = 0 e b = −a)

[0]

(0)ij

3 Considerem-se os seguintes casos:

¸ ·

¸ ·

¸ ·

¸

2

5 6

1+5 2+6

6

8

+

=

=

4

7 8

3+7 4+8

10 12

¸ ·

¸ ·

¸ ·

¸

3

1+3

4

+

=

=

4

2+4

6

¤ £

¤ £

¤

¤ £

4 + 1 2 = 3+1 4+2 = 4 6

Multiplicação de uma matriz por um escalar.

Definição 13 Seja A = [aij ] ∈ Mm×n (K) e λ ∈ K um escalar. Define-se o

produto de λ por A e denota-se por λ·A (ou λA) à matriz B = [bij ] ∈ Mm×n (K)

tal que bij = λaij , ∀(i,j)∈{1,...,m}×{1,...,n} .

Proposição 3 Sejam A, B ∈ Mm×n (K) e λ, µ ∈ K. As seguintes propriedades

são verificadas:

1. λ (A + B) = λA + λB

2. (λ + µ) A = λA + µA

3. λ (µA) = (λµ) A

4. 1 · A = A. O escalar 1 designa-se por unidade ou elemento neutro do

corpo K.

Demonstração.

20

6 Teoria das Matrizes

1.

(λ (A + B))ij

=

=

=

=

=

=

λ [(aij + bij )]

[λ (aij + bij )]

[λaij + λbij ]

[λaij ] + [λbij ]

λ [aij ] + λ [bij ]

(λA)ij + (λB)ij

(λ + µ) (A)ij

=

=

=

=

=

=

(λ + µ) [aij ]

[(λ + µ) aij ]

[λaij + µaij ]

[λaij ] + [µaij ]

λ [aij ] + µ [aij ]

(λA)ij + (µA)ij

2.

3.

(λ (µA))ij

=

=

=

=

=

λ (µ [aij ])

λ [µaij ]

[(λµ) aij ]

(λµ) [aij ]

((λµ) A)ij

4.

(1 (A))ij

=

=

=

=

1· [aij ]

[1·aij ]

[aij ]

(A)ij

Exemplo 4 Considerem-se os seguintes casos:

·

¸ ·

¸ ·

¸

1 2

3×1 3×2

3 6

=

=

• 3×

3 4

3×3 3×4

9 12

21

6 Teoria das Matrizes

•

•

· √

¸ · √ ¸

√2 × 1 =

√2

2×2

2 2

£

¤ £

¤ £

× 3 4 = 12 × 3 12 × 4 = 32

√

2×

1

2

·

1

2

¸

=

2

¤

Proposição 4 O conjunto Mm×n (K) munido da adição definida na Definição

12 e da multiplicação por um escalar definida na Definição 13 é um espaço

vectorial sobre o corpo K de dimensão m · n.

Adiante se estudarão mais aprofundadamente os espaços vectoriais.

6.2.3

Multiplicação de matrizes.

Definição 14 Sejam A ∈ Mm×p (K) e B ∈ Mp×n (K). A matriz produto de A

por B, que seP

denota AB (ou A · B), é dada pela matriz C = [crs ] ∈ Mm×n (K)

p

tal que crs = i=1 ari · bis , ∀(i,j)∈{1,...,m}×{1,...,n} .

Note-se que a matriz A, que multiplica à esquerda, tem tantas colunas quantas as linhas de B. O elemento crs obtém-se multiplicando os elementos da linha

r de A pelos elementos da coluna s de B, pela mesma ordem, e somando os produtos obtidos. Em nenhuma outra circunstância é possível multiplicar duas

matrizes. De um modo geral, dadas duas matrizes A e B de dimensões, respectivamente m × n e p × q, os produtos C = AB e D = BA são possíveis nas

seguintes circunstâncias:

Produto

A × B

(m×n)

B ×

(p×q)

(p×q)

A

(m×n)

Possível se ...

n=p

Resultado

C

(m×q)

q=m

D

(p×n)

Exemplo 5 Considerem-se as seguinte matrizes reais:

−2

A= 3

· 3

3

C=

−5

3

5

5

−5

−4

−3

3

−5 ¸

5

−1

2

0

B = −2 1

−1 −3

£

¤

D = −3 5 −3

Os produtos possíveis são AB, BC, CA, CB, DA e DB. A título exemplificativo, ter-se-á:

22

6 Teoria das Matrizes

2

0

−2 3 −3

AB = 3 5 3 −2 1

3 5 −5

−1 −3

(−2) · 2 + 3 · (−2) + (−3) · (−1) (−2) · 0 + 3 · 1 + (−3) · (−3)

3 · 2 + 5 · (−2) + 3 · (−1)

3 · 0 + 5 · 1 + 3 · (−3)

=

3 · 2 + 5 · (−2) + (−1) · (−1)

3 · 0 + 5 · 1 + (−5) · (−3)

−7 12

= −7 −4

1

20

Exemplo 6 Considerem-se os seguintes casos:

•

•

·

1 2

3 4

¸·

5 6

7 8

¸

·

5 6

7 8

¸·

1 2

3 4

¸

•

·

•

•

£

·

1 −1

1 −1

¸·

¸

1

2

£

3 4

1 −1

1 −1

¸

·

¸

·

¸

1×5+2×7 1×6+2×8

3×5+4×7 3×6+4×8

·

¸

19 22

=

43 50

=

5×1+6×3 5×2+6×4

=

7×1+8×4 7×2+8×4

·

¸

23 34

=

41 46

¤

3 4

¤

·

1

2

·

1×3 1×4

2×3 2×4

·

¸

3 4

=

6 8

=

¸

·

¸

= [3 × 1 + 4 × 2]

= [11] = 11

1 · 1 + (−1) · 1 1 · (−1) + (−1) · (−1)

=

1 · 1 + (−1) · 1 1 · (−1) + (−1) · (−1)

·

¸

0 0

=

0 0

23

¸

6 Teoria das Matrizes

Nota 4 Em geral AB 6= BA. Veja-se o exemplo 6.

Definição 15 (Matrizes comutáveis) Sejam A, B ∈ Mn (K). Se AB = BA,

diz-se que A e B são matrizes comutáveis.

É evidente que só é possível que duas matrizes sejam comutáveis se forem

quadradas. Se não o forem, ou bem que pelo menos um dos produtos não é

possível, ou, se o forem, as matrizes produto têm dimensões diferentes.

Proposição 5 Considerem-se as matrizes A = [aij ] , B = [bij ] ∈ Mm×p (K),

C = [cjk ] , D = [djk ] ∈ Mp×q (K), F = [fkl ] ∈ Mq×n (K) e o escalar λ ∈ K.

Verificam-se as seguintes propriedades:

1. (A + B) D = AD +AB e A (C + D) = AC +AD. Propriedade distributiva

da multiplicação de matrizes em relação à adição de matrizes.

2. λ (AD) = (λA) D = A (λD).

3. (AD) F = A (DF ). Propriedade associativa da multiplicação de matrizes.

4. A0 = 0 e 0A = 0. A matriz nula é o elemento absorvente para a multiplicação de matrizes. As 4 matrizes nulas representadas nestas expressões

são diferentes uma vez que têm dimensões diferentes. Terão de ter as dimensões adequadas para o produto faça sentido. As suas dimensões são,

respectivamente, p × q, m × q, q × m e q × p.

24

6 Teoria das Matrizes

Demonstração.

1. Observemos primeiro que A e B têm dimensão m×p e que D tem dimensão

p × q pelo que (A + B) D e AD + AB têm dimensão m × q.

((A + B) D)ik =

=

=

p

X

j=1

p

X

(A + B)ij djk

(aij + bij ) djk

j=1

p

X

aij djk +

j=1

p

X

bij djk

j=1

= (AD)ik + (BD)ik

2. De modo semelhante se mostra que A (C + D) = AC + AD.

p

X

(λ (AD))ik = λ aij djk

=

=

j=1

p

X

(λaij ) djk

j=1

p

X

(λA)ij djk

j=1

= ((λA) D)ik .

Mas também,

p

p

X

X

λ aij djk =

λaij (λdjk )

j=1

j=1

p

X

=

aij (λD)jk

j=1

= (A (λD))ik .

3. Note-se em primeiro lugar que as matrizes (AD) F e A (DF ) têm ambas

dimensão m × n.

25

6 Teoria das Matrizes

((AD) F )il =

q

X

k=1

=

q

X

k=1

=

(AD)ik fkl

p

X

aij djk fkl

j=1

q X

p

X

aij djk fkl

k=1 j=1

p

X

=

aij

=

j=1

p

X

à q

!

X

djk fkl

k=1

aij (DF )jl

j=1

= (A (DF ))il .

Proposição 6 O conjunto Mn (K) munido da adição definida na Definição 12

e da multiplicação definida na Definição 14 constitui um anel:

1. ∀A,B∈Mn (K) , ∃C∈Mn (K) : C = A + B. O conjunto Mn (K) é fechado para

a adição.

2. ∀A,B,C∈Mn (K) , A + (B + C) = (A + B) + C. Propriedade associativa da

adição de matrizes.

3. ∀A,B∈Mn (K) , A + B = B + A. Propriedade comutativa para a adição de

matrizes.

4. ∀A∈Mn (K) , ∃B∈Mn (K) : A + B = A. A matriz B designa-se por elemento

neutro para a adição de matrizes.

5. ∀A∈Mn (K) , ∃B∈Mn (K) : A + B = 0. Todos os elementos são regulares para

a adição de matrizes.

6. ∀A,B∈Mn (K) , ∃C∈Mn (K) : C = A · B. O conjunto Mn (K) é fechado para a

multiplicaçao.

7. ∀A,B,C∈Mn (K) , A (BC) = (AB) C. Propriedade associativa da multiplicação de matrizes.

26

6 Teoria das Matrizes

8. ∀A∈Mn (K) , ∃B∈Mn (K) : AB = BA = A. A matriz B é o elemento neutro

para a multiplicação de matrizes, e denomina-se por identidade de ordem

n, denotando-se por In ou simplesmente I se não houver dúvida quanto à

ordem.

9. ∀A,B,C∈Mn (K) , A (B + C) = AB + BC. Propriedade distributiva da multiplicação em relação à adição de matrizes.

Nota 5 Note-se que, se A ∈ Mm×n (K) tem-se Im A = A e AIn = A. Isto é,

desde que a matriz identidade tenha a ordem correcta para que o produto possa

ser efectuado, o produto (à esquerda ou à direita) de qualquer

matriz A pela

³ ´

1

identidade é sempre a matriz, como a seguir se demonstra

(Im A)ik =

(AIn )ik =

:

m

X

δ ij ajk = aik = (A)ik

j=1

n

X

aij δ jk = aik = (A)ik

j=1

6.2.4

Multiplicação por blocos.

Definição 16 (Submatriz) Seja A ∈ Mm×n (K). Designa-se submatriz de A

a uma matriz formada pelos elementos de A que pertencem a algumas linhas e

algumas colunas previamente fixadas de A.

Definição 17 (Partição em blocos) Seja A ∈ Mm×n (K). Diz-se que A está

particionada em blocos se cada bloco ocupar as mesmas linhas de A que os blocos

situados à sua esquerda ou direita e ocupar as mesmas colunas de A que os blocos

situados acima ou abaixo.

Por outras palavras, para que uma matriz esteja particionada em blocos é

necessário que as submatrizes que constituem cada bloco sejam formadas por

linhas e colunas consecutivas da matriz A.

A multiplicação por blocos realiza-se da seguinte forma:

(a) Sejam A ∈ Mm×p (K) e B ∈ Mp×n (K) e C = AB.

(b) Considerem-se números inteiros p1 , p2 , · · · , ph tais que sejam verificadas as relações 1 ≤ p1 < p2 < · · · < ph < p.

27

6 Teoria das Matrizes

(c) Escreva-se cij =

p1

X

r=1

(1)

|

air brj +

{z

(1)

cij

p2

X

r=p1 +1

}

|

air brj + · · · +

{z

}

(2)

cij

p

X

air brj . O

r=ph +1

|

{z

(h+1)

cij

}

elemento cij resulta de somar os produtos dos primeiros p1 elementos

(2)

da linha i de A pelos primeiros p1 elementos da coluna j de B; cij

é a soma dos produtos dos p2 − p1 elementos seguintes da linha i de

A pelos p2 − p1 elementos seguintes da coluna j de B e assim por

diante.

Em resumo, dadas duas matrizes A e B, é possível calcular o seu produto

AB por blocos se forem verificadas as seguintes condições:

(a) A ∈ Mm×p (K) e B ∈ Mp×n (K). Esta é a condição que requer que

o número de colunas da matriz que multiplica à esquerda seja igual

ao número de linhas da matriz que multiplica à direita.

(b) O número de colunas de blocos de A tem de ser igual ao número de

linhas de blocos de B.

(c) O número de colunas de cada bloco Aij tem de ser igual ao número

de linhas de cada bloco Bjt , a fim de se poder efectuar o produto

Aij Bjt .

Se, por exemplo, as colunas da matriz A, em número de 6, forem divididas

nos seguintes blocos (1, 2), (3, 4, 5), (6), então as linhas da matriz B terão de

ser divididas da mesma forma. A divisão das linhas da matriz A e colunas da

matriz B é independente uma da outra.

A multiplicação por blocos é por vezes cómoda em particular se alguns dos

blocos forem matrizes nulas ou matrizes identidades.

Exemplo 7 Considerem-se as matrizes

1

0

A=

0

−2

0

1

0

3

0

0

1

−5

0

0

0

−5

−1

−3

1

1

−4

−3

e

B

=

5

5

−2

3

0

3

−1

3

3

3

1

−5

−3

5

−3

5

1

5

0

0

3

−5

1

−5

0

0

5

2

−3

−4

0

0

Os blocos considerados na partição acima transformam a matriz A nu- ma

matriz, que em termos da partição escolhida, pode ser classificada do tipo 2 × 3.

De igual modo, a matriz B, em termos da sua partição é do tipo 3×2. O produto

C = AB considerando os blocos assinalados resulta numa matriz do tipo 2 × 2.

28

6 Teoria das Matrizes

Simbolicamente, as partições consideradas para as matrizes A e B podem ser

representadas como:

·

¸

B11 B12

A11 A12 A13

e B = B21 B22

A=

A21 A22 A23

B31 B32

Consequentemente, a matriz C será particionada, em termos de blocos, como

se simboliza de seguida:

¸

·

C11 C12

C=

C21 C22

Teremos assim:

•

C11

•

C12

•

= A11 B11 + A12 B21 + A13 B31 =

−1 −4 ·

0 £

−2 3

¤

−1

3 + 0 3 −5 + −3 −3

= I3 3

3

0

1

5

0

1

−6 −17

0 0

−2 3

3 + 0 0 + −6 −6

= 3

0 0

14

22

0

1

−8 −14

= −3 −3

14

23

= A11 B12 + A12 B22 + A13 B32 =

0 £

−3 3 5

= I3 5 −5 2 + 0 5 −5

0

1 1 −3

0 0

−3

3

5

−5

2 + 0 0

= 5

0 0

1

1

−3

−3

3

5

−5

2

= 5

1

1

−3

C21

−1

−4 + −3

1

0

0

0 + 0

0

0

¤

−3

5

¸

¸

−4 ·

0 0 0

−3

0 0 0

5

0 0

0 0

0 0

= A21 B11 + A22 B21 + A23 B31 =

·

¸

£

¤ −2 3

£

¤ £

¤ −1 −3

−2 3 −5

3 3 − 5 · 3 −5 + 1 5

=

3 5

0 1

£

¤ £

¤ £

¤

13 −2 + 15 −25 + 14 22

=

£

¤

42 −5

=

29

6 Teoria das Matrizes

•

C22

= A21 B12 + A22 B22 + A23 B32 =

·

¸

£

¤ −3 3 5

£

¤£

¤ 0 0 0

= −2 3 −5 5 −5 2 − 5 · 5 −5 −4 + 1 5

0 0 0

1 1 −3

£

¤ £

¤ £

¤

16 −16 11 + −25 25 20 + 0 0 0

=

£

¤

−9 9 31

=

A matriz C será portanto:

−8 −14 −3 3

5

−3 −3

5 −5 2

C=

14

23

1

1 −3

42 −5 −9 9

31

Definição 18 (Potência de uma matriz) Seja A ∈ Mn (K). Designa-se

por potência de ordem k ∈ N de A, e escreve-se Ak , à matriz C tal que

C = Ak = A × · · · × A.

|

{z

}

k vezes

6.3

Transposição de matrizes. Matrizes Simétricas.

Definição 19 (Matriz transposta) Dada uma matriz A ∈ Mm×n (K), denomina-se matriz transposta de A, e denota-se por AT , a matriz B ∈ Mn×m (K)

tal que bij = aji , ∀(i,j)∈{1,...,m}×{1,...,n} .

Por outras palavras, se uma matriz A é do tipo m × n, a transposta de A,

AT , é do tipo n × m; as linhas de A são as colunas de AT , pela mesma ordem,

e, consequntemente, as colunas de A serão as linhas de AT , pela mesma ordem.

Exemplo 8 Considerem-se os seguintes casos:

•

·

•

·

•

£

1 2

3 4

1

2

¸T

3 4

¸T

=

¤T

=

£

·

1 3

2 4

1 2

=

·

3

4

¸

¤

¸

30

6 Teoria das Matrizes

•

·

3 −5 5

−5 −4 −1

¸T

3 −5

= −5 −4

5 −1

Definição 20 (Matriz simétrica/anti-simétrica) Seja A ∈ Mn (K), maT

triz quadrada³ de

´ ordem n. Diz-se que A é simétrica se A = A e anti-simétrica

T

se A = −A

2

.

Exemplo 9 A matriz

A=

·

a b

b c

¸

é a forma geral de uma matriz simétrica de ordem 2.

A matriz

A=

·

0 b

−b 0

¸

é a forma geral de uma matriz anti-simétrica de ordem 2. Com efeito, por

definição, dever-se-á ter aii = −aii o que implica 2aii = 0 e portanto aii = 0.

Por outras palavras, numa matriz anti-simétrica, os elementos principais são

sempre nulos.

Proposição 7 Sejam A = [aij ] , B = [bij ] ∈ Mm×p (K) , C = [cjk ] ∈ Mp×n (K)

e Dk = [dkl ] ∈ Mn (K) , k = 1, ..., M . Verificam-se as seguintes propriedades:

¡ ¢T

= A.

1. AT

2. (A ± B)T = AT ± B T .

3. (AC)T = C T AT .

´T Q

³Q

M

M

= k=1 DkT .

4.

k=1 Dk

Demonstração.

1.

³¡ ¢T ´

¡ ¢

AT

= AT ji

ij

= (A)ij .

31

6 Teoria das Matrizes

2.

´

³

T

(A ± B)

= (A ± B)ji

ij

= aji ± bji

¡ ¢

¡ ¢

= AT ij ± B T ij .

3.

³

´

T

(AC)

ki

= (AC)ik

p

X

aij cjk

=

j=1

p

X

¡

=

j=1

p

X

=

j=1

¡

AT

CT

¢ ¡

ji

¢

kj

¢

¡

= C T AT ki .

CT

¢

kj

¡ T¢

A ji

4. Por indução em M . O caso M = 2 verifica-se na Propriedade 3. Supon´T

³Q

QM−1 T

M−1

hamos que, por hipótese,

= k=1

Dk . Mostremos que

k=1 Dk

³Q

´T Q

M

T

= M

k=1 Dk

k=1 Dk também se verifica.

Ã

M

Y

k=1

Dk

!T

=

ÃÃM−1

Y

k=1

= (DM )

T

Dk

!

ÃM−1

Y

k=1

= (DM )T

DM

M−1

Y

Dk

!T

!T

(pela Propriedade 3)

DkT (por hipótese)

k=1

=

M

Y

DkT

k=1

Proposição 8 O produto de duas matrizes A, B ∈ Mn (K) simétricas é uma

matriz simétrica sse os seus factores comutam.

32

6 Teoria das Matrizes

Demonstração.

(=⇒)

T

AB = (AB) (porque ABé simétrica)

= B T AT (pela Propriedade 3 da transposição de matrizes)

= BA (porque A e B são comutáveis)

(⇐=)

T

T

(AB) = (BA) (porque A e B comutam)

= AT B T (pela Propriedade 3 da transposição de matrizes.

= AB (porque A e B são simétricas)

6.4

Traço de uma matriz

Definição 21 (Traço de uma Matriz) Seja A = [aij ] ∈ Mm×n (K). O traço

da matriz A é definido como a soma os seus elementos principais, ou, por outras

palavras, dos elementos ao longo da diagonal principal. Denota-se por:

tr (A) = a11 + a22 + · · · + app , onde p = min (m, n) .

Exemplo 10 Considerem-se as seguintes matrizes e determinemos os respectivos traços:

3

0

1

3 1

• −1 2

0

−1 1 . tr (A) = 3 + 2 + (−3) = 2.

0 −2 -3

1 1

3

0

• −1 2 . tr (A) = 3 + 2 = 5.

0 −2

1

3

1

• 0

-1

1 . tr (A) = 1 + (−1) + 1 = 1.

1

−3

1

O operador tr (·) satisfaz as seguintes propriedades:

33

6 Teoria das Matrizes

Proposição 9 Sejam A=[aij ] , B =[bij ] ∈ Mm×n (K) e C =[cpq ] ∈ Mn×m (K).

Verificam-se as seguintes igualdades:

1. tr (A + B) = tr (A) + tr (B).

2. tr (A + B) = tr (B + A).

3. tr (AC) = tr (CA).

Demonstração.

1. Dado que A e B têm as mesmas dimensões a soma A + B encontra-se

definida. Prosseguindo com a argumentação, segue que:

´

³

tr (A + B) = tr (A + B)ij

min(m,n)

X

=

(all + bll )

l=1

min(m,n)

X

=

min(m,n)

all +

l=1

X

bll

l=1

= tr (A) + tr (B)

2. Dado que A e B têm as mesmas dimensões as somas A + B e B + A

encontram-se definidas. Prosseguindo com a argumentação, segue que:

³

´

tr (A + B) = tr (A + B)ij

min(m,n)

=

X

(all + bll )

l=1

min(m,n)

=

X

(bll + all )

l=1

´

³

= tr (B + A)ij

= tr (B + A)

3. Se A ∈ Mm×n (K) e C ∈ Mn×m (K) , tem-se naturalmente AC ∈ Mm (K).

O traco de AC será:

34

6 Teoria das Matrizes

´

³

tr (AC) = tr (AC)iq

n

X

= tr aij cjq

j=1

=

m

X

i=1

n

X

aij cji

j=1

m X

n

X

aij cji

=

i=1 j=1

Por outro lado tem-se CA ∈ Mn (K). O traco de CA será:

´

³

tr (CA) = tr (CA)pj

Ãm

!

X

cpi aij

= tr

i=1

Ãm

!

n

X

X

=

cji aij

=

=

j=1 i=1

m

n X

X

cji aij

j=1 i=1

m X

n

X

aij cji

i=1 j=1

= tr (AC)

6.5

Dependência e independência lineares de filas paralelas de uma matriz.

Definição 22 (Combinação linear £das filas de uma matriz)

Seja a ma¤

triz A ∈ Mm×n (K) e sejam Li = ai1 ai2 · · · ain , i = 1, · · · , m as

linhas da matriz A e Cj = {a1j , a2j , · · · , amj } , j = 1, · · · , n as colunas da matriz A.

m

P

λi Li designa-se combinação linear das linhas de A, onde

1. À expressão

i=1

{λi }i=1,··· ,m são quaisquer escalares do corpo K.

35

6 Teoria das Matrizes

n

P

2. À expressão

µj Cj designa-se combinação linear das colunas de A, onde

j=1

© ª

µj j=1,··· ,n são quaisquer escalares do corpo K.

Definição 23 (Combinação linear nula das filas de uma matriz) Sejam

A ∈ Mm×n (K), {Li }i=1,··· ,m as linhas da matriz A e {Cj }j=1,··· ,n as colunas

da matriz A.

m

P

1. À expressão

λi Li = 0 designa-se combinação linear nula das linhas de

i=1

A, onde {λi }i=1,··· ,m são quaisquer escalares do corpo K.

n

P

µj Cj = 0 designa-se combinação linear nula das colunas

2. À expressão

©j=1ª

de A, onde µj j=1,··· ,n são quaisquer escalares do corpo K.

Definição 24 (Independência linear) Sejam A ∈ Mm×n (K), {Li }i=1,··· ,m

as linhas da matriz A e {Cj }j=1,··· ,n as colunas da matriz A. Diz-se que as

m

n

P

P

0Li (ou

0Cj para

linhas (colunas) de A são linearmente independentes se

i=1

j=1

as colunas) é a única combinação linear nula dessas linhas (colunas).

Por outras palavras, as linhas (ou colunas) de uma matriz dizem-se linearmente independentes se a única combinação linear nula daquelas é a que se

obtém com todos os escalares nulos.

A seguinte constatação é consequência imediata da definição acima:

Nota 6 As linhas (colunas) de uma matriz são linearmente dependentes se é

possível obter uma combinação linear nula daquelas com pelo menos um escalar

diferente de 0.

As definições acima aplicam-se indiferentemente às linhas e colunas de uma

qualquer matriz. Por esse motivo, faremos referência às filas de uma matriz

sempre que não for necessário referir explicitamente as linhas ou colunas da

matriz. Denotaremos por {Fk }k=1,··· ,p as filas da matriz. Note-se, no entanto,

que a referência às filas de uma matriz deverá ser entendida como referência às

linhas ou às colunas e não aos dois conjuntos simultaneamente.

Matematicamente, a condição de independência linear das filas de uma matriz pode ser descrita pelas equações (4).

m

P

λi Li = 0 =⇒λi = 0, i = 1, · · · , m (linhas)

i=1

n

P

(4)

µj Cj = 0 =⇒µj = 0, j = 1, · · · , n (colunas)

j=1

Em geral, os resultados válidos para as linhas também o são para as colunas.

36

6 Teoria das Matrizes

Proposição 10 Sejam A ∈ Mm×n (K) e {Fk }k=1,··· ,p as filas da matriz A.

Verificam-se os seguintes resultados:

1. Se uma das filas de A é constituída integralmente por zeros, as filas são

linearmente dependentes.

2. Algumas das filas de A são linearmente dependentes se e só se todas o

são.

3. As filas de A são linearmente dependentes se e só as filas em que a fila Fk é

0

substituída pela fila Fk = α · Fk , α ∈ K\ {0} são linearmente dependentes.

4. As filas de A são linearmente dependentes se e só as filas em que a fila Fk

0

é substituída pela fila Fk = Fk + Fl , k 6= l são linearmente dependentes.

5. As filas de A são linearmente dependentes se e só se o mesmo sucede

às filas que se obtêm somando a uma delas uma combinação linear das

restantes.

6. As filas de A são linearmente dependentes se e só se algumas delas se

podem escrever como combinação linear das restantes.

Demonstração. Para efeito da demonstração utilizar-se-ão as linhas da

matriz. A prova para as colunas é equivalente.

1. Suponhamos que a linha Lk é inteiramente

nula. A combinação linear

P

nula das linhas da matriz é dada por i6=k λi Li + λk Lk = 0. Sabendo

que Lk = 0 teremos λk Lk = 0 para qualquer λk ∈ K. Em particular, se

escolhermos λk 6= 0, teremos uma combinação linear nula das linhas com

pelo menos um escalar não nulo, precisamente o escalar λk , logo, as linhas

da matriz A são linearmente dependentes

2.(=⇒) Suponhamos, sem perda de generalidade, que as p primeiras linhas

da matriz A são linearmente dependentes. Existirá assim pelo menos

um P

escalar não nulo, digamos λk , com algum k : 1 ≤ k ≤ p tal

p

que i=1 λi Li = 0. Se escolhermos

escalares

nulos para as restantes

P

Pm

linhas da matriz teremos m

λ

L

=

i

i

i=p+1 0Li = 0. Assim,

Pp

Pm i=p+1

teremos i=1 λi Li + i=p+1 λi Li = 0 com o escalar λk não-nulo,

isto é, as linhas da matriz A são linearmente dependentes.

(⇐=) Se as linhas da matriz A são linearmente dependentes, então

∃k∈{1,··· ,m} : λk 6= 0 ∧

X

λi Li + λk Lk = 0

i6=k

Se os restantes escalares forem nulos, teremos

37

6 Teoria das Matrizes

X

λi Li + λk Lk +

i6=k

X

0Li + λk Lk = λk Lk = 0

i6=k

Deste modo, qualquer conjunto de linhas que inclua a linha Lk , que

nestas circunstâncias é integralmente nula, é linearmente dependente.

3.(=⇒) Suponhamos que as linhas de A são linearmente dependentes.

0

Substituamos a linha Lk pela linha Lk = α·Lk , α 6= 0. A combinação

0

linear nula das linhas de A onde a linha Lk é substituída por Lk é

P

P

0

dada por i6=k λi Li + λk Lk = 0 ⇐⇒ i6=k λi Li + (λk · α) · Lk = 0.

Mas as linhas de A são linearmente dependentes pelo que a respectiva

combinação linear nula se obtém com pelo menos um escalar não nulo.

Ou bem que esse escalar é λi , i 6= k, ou bem que será λk · α. Neste

caso, como α 6= 0 teremos λk 6= 0. Em qualquer caso, é possível

0

obter uma combinação linear nula das linhas {Li }i=1,···n ∪ Lk com

i6=k

pelo menos um escalar não nulo.

0

(⇐=) Suponhamos que as linhas {Li }i6=k ∪Lk são linearmente dependentes.

A combinação linear nula das linhas de A é dada por

X

λi Li + λk Lk = 0,

i6=k

a qual é passível de ser reescrita como

X

i6=k

λi Li +

X

λk

λk 0

λi Li +

(α · Lk ) =

L = 0.

α

α k

i6=k

0

Dada a dependência linear de {Li }i6=k ∪ Lk ou bem que teremos

λi 6= 0, i 6= k ou teremos λαk 6= 0. Neste caso, como α 6= 0 teremos

λk 6= 0. Em qualquer caso, é possível obter uma combinação linear

nula das linhas {Li }i=1,··· ,m com pelo menos um escalar não nulo.

4.(=⇒) Suponhamos que as linhas de A são linearmente dependentes.

0

Substituamos a linha Lk pela linha Lk = Lk + Ll , k 6= l. A combi0

nação linear nula das linhas de A onde a linha Lk é substituída por Lk

P

P

0

é dada por i6=k λi Li +λk Lk = Pi6=k λi Li +λk (Lk + Ll )=0. Esta expressão pode ser reescrita como i6=k,l λi Li +λk Lk +(λk + λl ) Ll =0.

Mas as linhas de A são linearmente dependentes pelo que a respectiva combinação linear nula se obtém com pelo menos um escalar

não nulo. Ou bem que esse escalar é λi , i 6= k, l, ou bem que será

λk , ou então será (λk + λl ). Neste caso, ter-se-á obrigatoriamente

38

6 Teoria das Matrizes

λk 6= 0 ∨ λl =

6 0. Em qualquer caso, é possível obter uma combinação

0

linear nula das linhas {Li }i6=k ∪ Lk com pelo menos um escalar não

nulo.

0

(⇐=) Suponhamos que as linhas {Li }i6=k ∪Lk são linearmente dependentes.

A combinação linear nula das linhas de A é dada por

X

λi Li + λk Lk = 0,

i6=k

a qual é passível de ser reescrita como

X

i6=k

λi Li + (λk Lk + λk Ll ) − λk Ll =

|

{z

}

0

λk Lk

X

i6=k,l

0

λi Li + (λl −λk ) Ll + λk Lk =0

0

Dada a dependência linear de {Li }i6=k ∪ Lk ou bem que teremos

λi 6= 0, i 6= k, l ou teremos λk 6= 0 ou ainda (λl − λk ) 6= 0. Neste

caso, ter-se-á obrigatoriamente λk 6= 0 ∨ λl 6= 0. Em qualquer caso,

é possível obter uma combinação linear nula das linhas {Li }i=1,··· ,m

com pelo menos um escalar não nulo.

5.(=⇒) Suponhamos que as linhas de A são linearmente dependentes.

P

0

Substituamos a linha Lk pela linha Lk = Lk + i6=k αi Li . A combi0

Lk

nação linear nula das linhas de A onde a linha L³k é substituída por

´

P

P

P

0

é dada por i6=k λi Li +λk Lk = i6=k λi Li +λk Lk + i6=k αi Li =0.

P

Esta expressão pode ser reescrita como i6=k(λi +λk αi )Li+λk Lk =0.

Mas as linhas de A são linearmente dependentes pelo que a respectiva combinação linear nula se obtém com pelo menos um escalar não nulo. Ou bem que esse escalar é λk ou bem que será

(λi + λk αi ) , i 6= k. Neste caso, ter-se-á obrigatoriamente λk αi 6= 0

(o que implica λk 6= 0)∨λi 6= 0, i 6= k. Em qualquer caso, é possível

0

obter uma combinação linear nula das linhas {Li }i6=k ∪ Lk com pelo

menos um escalar não nulo.

0

(⇐=) Suponhamos que as linhas {Li }i6=k ∪Lk são linearmente dependentes.

A combinação linear nula das linhas de A é dada por

X

λi Li + λk Lk = 0,

i6=k

a qual é passível de ser reescrita como

39

6 Teoria das Matrizes

X

X

X

X

0

λi Li +λk Lk +λk

αi Li −λk

αi Li = (λi − λk ) Li +λk Lk =0

i6=k

i6=k

i6=k

i6=k

0

Dada a dependência linear de {Li }i6=k ∪ Lk ou bem que teremos

λk 6= 0 ou bem que teremos (λi − λk ) 6= 0, i 6= k. Neste caso, ter-se-á

obrigatoriamente (λk 6= 0 ∨ λi 6= 0)i6=k . Em qualquer caso, é possível

obter uma combinação linear nula das linhas {Li }i=1,··· ,m com pelo

menos um escalar não nulo.

6.(=⇒) Suponhamos que as linhas de A são linearmente dependentes. Seja λk

um dos escalares não nulos para os quais se obtém umaP

combinação

linear nula das linhas de A. A combinação

linear

nula

i λi Li = 0

P

pode ser reescrita como Lk = − λ1k i6=k λi Li , uma vez que λk 6= 0.

A expressão mostra que a linha Lk pode ser escrita como combinação

linear das restantes linhas da matriz.

(⇐=) Suponhamos que é possível escrever a linha

P Lk como combinação

linear P

das restantes linhas, isto é, Lk =

i6=k λi Li . Resulta que

Lk − i6=k λi Li = 0, isto é, obteve-se uma combinação linear nula

das linhas da matriz A, em que pelo menos um escalar é não nulo (o

escalar 1 associado à linha Lk ). Tal mostra que as linhas de A são

linearmente dependentes.

Proposição 11 Sejam A ∈ Mm×n (K), B ∈ Mn×p (K) e C = AB. Então cada

linha (respectivamente coluna) de C é combinação linear das linhas (respectivamente colunas) de B (respectivamente A). Mais precisamente:

1. A linha i0 de C é combinação linear das linhas de B que se obtém utilizando os escalares da linha i0 de A.

2. A coluna j0 de C é combinação linear das colunas de A que se obtém

utilizando os escalares da coluna j0 de B.

Demonstração.

1. ci0 k = (AB)i0 k =

LC

i0

Pn

j=1

ai0 j bjk . Logo,

¤

ci0 1 ci0 2 · · · ci0 p

£ Pn

Pn

=

j=1 ai0 j bj1

j=1 ai0 j bj2 · · ·

n

X

£

¤

ai0 j bj1 bj2 · · · bjp

=

=

=

£

j=1

n

X

ai0 j LB

j

j=1

40

Pn

j=1

ai0 j bjp

¤

6 Teoria das Matrizes

2. A prova é em tudo semelhante à anterior mutatis mutantis.

6.6

Característica de uma matriz. Operações elementares.

Definição 25 (Característica) Seja A∈Mm×n (K). Designa-se característica de linha da matriz A ao número máximo de linhas linearmente independentes; denota—se este valor por rl (A). Analogamente a característica de coluna da matriz A, rc (A), é o número máximo de colunas linearmente independentes. A característica da matriz, denotada por rA (ou simplesmente r quando

estiver claro a matriz a que se refere) define-se como o número máximo de linhas

ou colunas linearmente independentes, isto é, rA = mı́n{rl (A) , rc (A)}.

Tem-se claramente rl (A) ≤ m e rc (A) ≤ n e portanto rA ≤ mı́n {m, n},

onde m e n são respectivamente o número de linhas e colunas da matriz em

causa.

Resta desenvolver um processo que permita determinar a característica de

linha (ou coluna) de uma matriz, e portanto da sua característica.

Proposição 12 Sejam A ∈ Mm×n (K), B ∈ Mn×p (K) e C = AB. Então

rl (C) ≤ rl (B) e rc (C) ≤ rc (A).

Demonstração. Recordando a proposição 11 verificámos que,

LC

i =

n

X

j=1

aij LB

j , ∀i=1,··· ,m ,

isto é, cada linha de C é combinação linear das linhas de B. Ora, se o número

máximo de linhas linearmente independentes de B é rl (B) então, cada linha de

C pode ser escrita apenas à custa das rl (B) linhas de B que são efectivamente

linearmente independentes; as restantes linhas de B ou bem que são nulas ou

bem que se podem escrever como combinação das que são linearmente independentes como vimos na Proposição (10). Suponhamos, sem perda de generalidade

que são precisamente as primeiras rl (B) linhas de B que são linearmente independentes. Tal significa que as linhas de C podem ser escritas como combinação

destas linhas de B (agora com outros escalares que não aqueles dados pelas liPrl (B) i B

nhas de A). Isto é, LC

i =

k=1 λk Lk , ∀i=1,··· ,m . Suponhamos, por redução ao

absurdo que C tem rl (B) + 1 linhas lineamente independentes, precisamente as

primeiras. Sabemos então que a combinação linear nula destas rl (B) + 1 linhas

só é passível de ser obtida com todos os escalares nulos.

41

6 Teoria das Matrizes

rl (B)+1

X

0 =

µi LC

i

i=1

rl (B)+1

=

X

rl (B)

µi

i=1

rl (B)+1

=

X

i=1

X

λik LB

k

k=1

rl (B)+1

µi λi1 LB

1 +

X

i=1

rl (B)+1

µi λi2 LB

2 + ··· +

X

i=1

µi λirl (B) LB

rl (B)

Ora, as rl (B) primeiras linhas de B são linearmente independentes pelo que

a combinação nula anterior só se poderá obter com todos os escalares nulos, o

que corresponde a resolver o sistema em ordem a {µi }i=1,··· ,rl (B)+1 :

Prl (B)+1

µi λi1 = 0

Pri=1

l (B)+1

µi λi2 = 0

i=1

···

Prl (B)+1 µ λi

i rl (B) = 0

i=1

O sistema acima tem rl (B) e rl (B)+1 incógnitas. Trata-se de um sistema indeterminado possuindo outras soluções que não a solução {µi = 0}i=1,··· ,rl (B)+1 .

Mas isto é um absurdo pois por hipótese as primeiras rl (B)+1 linhas de C eram

linearmente independentes. O absurdo reside evidentemente no facto de se ter

assumido que o número máximo de linhas linearmente idependentes de C era

superior a rl (B), logo dever-se-á ter rl (C) ≤ rl (B).

A prova relativamente à afirmação rc (C) ≤ rc (A) é em tudo semelhante à

anterior.

6.6.1

Operações Elementares

Os resultados da Proposição (10) permitem concluir que a dependência ou independência lineares das linhas (ou colunas) de uma matriz não é alterada por

um conjunto de operações que no seu conjunto se designam por Operações Elementares Sobre Filas de uma Matriz.

Definição 26 (Operações Elementares) Seja A ∈ Mm×n (K). Define-se

como operação elementar sobre as filas da matriz A, a cada uma das seguintes

operações:

i. Troca entre si de duas linhas (ou colunas) da matriz.

ii. Multiplicação de uma linha (ou coluna) da matriz por um escalar diferente

de 0.

42

6 Teoria das Matrizes

iii. Substituição de uma linha (ou coluna) pela que se obtém somando-lhe

outra, multiplicada por um qualquer escalar (Operação de Jacobi).

As operações elementares acima definidas correspondem à multiplicação (à

esquerda ou à direita) da matriz A por matrizes que resultam da matriz identidade, que deverá ter dimensão apropriada, por aplicação das operações elementares.

Definição 27 (Matriz Elementar) Seja I ∈ Mn (K) a matriz identidade de

ordem n. Designa-se por matriz elementar de ordem n a qualquer matriz E que

resulte de I por aplicação de uma das três operações elementares.

Consideremos genericamente uma matriz A ∈ Mm×n (K). Vejamos, caso

a caso, que matriz, resultante da aplicação de operações elementares sobre a

matriz identidade, deve multiplicar, ou pela qual se deve multiplicar, a matriz

A de forma a que as mesmas operações elementares tenham o mesmo efeito

sobre A. Naturalmente que, a multiplicação à esquerda ou à direita da matriz

A implica uma escolha acertada para a ordem das matrizes elementares a multiplicar. Assim, a multiplicação à esquerda da matriz A implica a utilização

de matrizes elementares de ordem m, enquanto que a multiplicação à direita

implica a utilização de matrizes elementares de ordem n.