Capítulo 13. Regressão Simples 13.1 Introdução a regressão simples: causalidade e os erros de previsão. 13.2 Regressão simples com a variável tempo. 13.3 Minimizando os erros. 13.4 Exemplo: Previsão de vendas 13.5 Coeficiente de determinação - R2. 13.6 Natureza estatística da reta estimada 13.7 Normalidade, independência e a constância da variância dos erros residuais. 13.8 Desvio padrão (erro padrão) dos estimadores dos coeficientes e intervalo de confiança. 13.9 Exemplo de intervalo de confiança para os coeficientes a e b da regressão simples. 13.10 Teste de hipótese representatividade da equação como um todo, a estatística F 13.11 Outro exemplo do teste de hipótese com a estatística F: a dureza de Brinell. 13.12 Teste de hipótese, o exemplo de coeficientes individuais de regressão. 13.13 Não linearidade, e retornando ao exemplo do Boyle 13.14 Conclusões 13.15 Exercícios 13.16 Referências 1 13.1 Introdução a regressão simples: causalidade e os erros de previsão. • A regressão demonstra quantitativamente a força atrás de uma causalidade ou um simples relacionamento que ocorre de Xt para Yt. • Yt é a variável dependente da variável Xt, denominada variável independente. • Quando o valor de Xt se altera por alguma razão, então, em conseqüência, o valor de Yt se alterará. • É também comum chamar Yt a variável explicada e Xt a variável explicatória (ou explicativa). • É importante enfatizar que a questão de causalidade entre variáveis (influência da variável explicatória na variável explicada) deve ser determinada antes de investigar a relação com regressão. 2 Figura 13.1 - A reta estimada de regressão no gráfico de dispersão X-Y. ˆ e Yt Y t t ˆ t aˆ bˆ Xt Y erros residuais positivos et > 0 ˆ t et Yt Y erros residuais negativos et < 0 3 13.2 Regressão simples com a variável tempo. Uma das maneiras mais fáceis de construir uma equação de regressão é através da utilização de uma variável artificial que representa tempo como variável independente Xt. Imaginando por exemplo que Yt represente o preço médio mensal de um quilo de banana (Preçot), durante um ano terá doze preços mensais em seqüência. Para 12 meses, a variável Xt = t corresponderia à seqüência de t = 1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12 ˆ +e Preço aˆ bt A equação de regressão seria a seguinte: t t Para prever o valor do preço de banana no mês 13, deve-se inserir 13 na equação para a variável t e, usando os valores estimados dos coeficientes a e b torna-se fácil calcular a previsão do Preçot. 4 13.3 Minimizando os erros – a soma dos quadrados dos erros (SQE) O método de mínimos quadrados pode ser resumido na seguinte expressão: 2 MIN e t a ,b Em palavras, a expressão significa procurar valores de a e b que minimizem a soma dos erros quadrados. A soma dos erros quadrados é dada embaixo pela expressão Q: T Q t 1 T Yt a bX t 2 t 1 et 2 onde T é o número total de observações em X e Y. O método para minimizar uma expressão como Q envolve o cálculo de derivadas parciais, igualando-as a zero: Q 0 a Q 0 b 5 CONTINUAÇÃO: Minimizando os erros – a soma dos quadrados dos erros (SQE) As equações chamadas de estimadores são as seguintes (sempre notando que um estimador ou variável estimada por regressão e mínimos quadrados é vestido por um chapeuzinho): ˆb T X t Yt X t Yt covX t , Yt r SY XY 2 2 var X SX T X t X t t O estimador de a é dado pela expressão: aˆ ˆ X Y b t t T Yt bˆ Xt 6 13.4 Exemplo: Previsão de vendas MES Tabela 13.1 – Vendas de camisetas e previsões 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 VENDAS MENSAIS 1102 2030 5838 6995 6283 1719 25263 19244 23171 19146 37174 16691 4235 15077 11791 17497 11353 3646 56471 44973 66937 59371 84512 52661 VENDAS ESTIMADAS -4195,17 -1681,17 832,8333 3346,833 5860,833 8374,833 10888,83 13402,83 15916,83 18430,83 20944,83 23458,83 25972,83 28486,83 31000,83 33514,83 36028,83 38542,83 41056,83 43570,83 46084,83 48598,83 51112,83 53626,83 ERRO RESIDUAL -5297,17 -3711,17 -5005,17 -3648,17 -422,167 6655,833 -14374,2 -5841,17 -7254,17 -715,167 -16229,2 6767,833 21737,83 13409,83 19209,83 16017,83 24675,83 34896,83 -15414,2 -1402,17 -20852,2 -10772,2 -33399,2 965,8333 7 Figura 13.2 - A reta de regressão para a demanda de camisetas Os valores de a ( = - 6709) e b ( = 2514) são os melhores estimativos considerando o critério de minimização da soma dos erros quadrados. Qualquer outra reta com outros valores de a e b será associada a uma soma de quadrados dos erros residuais maior. 8 Tabela 13.2– Previsões para a venda de camisetas MES Para calcular previsões fora da amostra observada para os meses 25 e 26, utiliza-se a equação estimada. O valor da previsão para o mês 25 é 56.140 camisetas (= - 6709 + 2514*25), e para mês 26, 58.654 camisetas. VENDAS FUTURAS 25 56140,0 26 58654,0 27 61168,0 28 63682,0 29 66196,0 30 68710,0 31 71224,0 32 73738,0 33 76252,0 34 78766,0 35 81280,0 36 83794,0 9 Yˆ 13.5 Coeficiente de determinação - R2. O coeficiente de determinação, R2, pondera matematicamente a separação de Yt nas suas duas partes distintas: a parte representada pelo valor estimado de Y e a outra parte advinda do erro residual. Quando o erro é relativamente grande, o valor de R2 é próximo ao zero. Yˆt aˆ bˆX t Yt Yˆt et Por outro lado, se os erros fossem realmente pequenos (no gráfico, com os pontos aparecendo mais próximos à reta), então a equação está representando bem os dados e será próximo ao valor um. 10 Continuação: Coeficiente de determinação - R2. O coeficiente de determinação R2 tem um ponto de referência que é a soma dos erros quadrados ao redor da média dos Yt, denominada Soma de Quadrados Total SQT. Essa soma considera simplesmente a diferença entre o valor médio de Yt e o valor observado. SQT Yt Y T 2 t 1 Já vimos esta expressão em outro contexto no capítulo 2, no cálculo da variância e do desvio padrão, 2 (Y Y) Variância = SY2 = i = SQT/(n – 1) n 1 i 1 n 11 Figura 13.3 – A reta de regressão e o erro total e o da regressão 12 6; 11,2 ERRO REGRESSÀO 10 ERRO TOTAL 8 3; 7,1 Y 6 2; 4,4 1; 2,7 2 9; 5,3 7; 5,9 4; 5,8 4 10; 11 8; 9,6 5; 3,5 0; 1 0 0 1 2 3 4 5 6 7 8 9 10 11 X 12 Continuação: Coeficiente de determinação - R2. SQT Yt Y = 1,3E+10 T 2 t 1 T SQE t 1 ˆ Yt Y t 2 = 5,74E+09 SQT - SQE = SQR = 7,27E+09 R2 = SQR / SQT = (SQT – SQE)/SQT = 7,27E+09/1,3E+10 = 0,559 13 13.6 Natureza estatística da reta estimada Veja na Figura 13.4 (próxima transparência) a relação entre as variáveis Xt e Yt e a distribuição normal que está relacionada à aleatoriedade de Yt. A equação colocada na base da figura no plano X-Y é Yt = f(Xt). Para cada valor de Xt há um valor estimado de Yt,. O eixo vertical é o valor da distribuição normal. Geralmente, a relação entre variáveis em regressão é mostrada no plano de X-Y e o eixo vertical Z é ignorado. Para um dado valor de X, existe um valor de Y mais provável, mas em função de Y ser aleatória, outros valores de Y são prováveis. Como fica clara na figura 13.4, variabilidade é característica de Yt e não Xt considerado fixo. Conseqüentemente, o erro da regressão (et) é oriundo exclusivamente da aleatoriedade de Yt. 14 Figura 13.4 - A reta de regressão e a distribuição normal. 15 13.7 Normalidade, independência e a constância da variância dos erros residuais. Foram apresentados no capítulo 6 os testes de BeraJarque e testes visuais como o da linha reta entre valores teóricos e observados e o histograma. Quando foi mencionado em cima que os resíduos devem ser aleatórios, isso também significa a ausência de qualquer relacionamento do resíduo com as variáveis da equação, e qualquer padrão repetitivo que pode ser visualizado graficamente. O gráfico dos resíduos deve aparecer como uma nuvem de dados com média zero e desvio padrão constante. Veja a figura 13.5. 16 Figura 13.5 – Erros residuais bem comportados com média zero e desvio padrão constante. 4 3 Erro residual 2 1 0 -1 -2 -3 -4 17 13.8 Desvio padrão (erro padrão) dos estimadores dos coeficientes e intervalo de confiança. A estimativa dos coeficientes a e b resulta em parte da variável Yt por definição aleatória, possuindo média e desvio padrão. Conseqüentemente, os coeficientes estimados também têm médias e desvio padrão, chamado de erro padrão. O desvio padrão dos coeficientes tem uma relação direta com o desvio padrão dos erros de regressão (et): se ˆ Yt Y t T2 2 2 e t T2 onde T é o tamanho da amostra e T – 2 são os graus de liberdade, assunto que será comentado futuramente. O desvio padrão do estimador do coeficiente a e do coeficiente b é o seguinte: 1 X2 s aˆ s e T X i X 2 s bˆ s e 1 X i X 2 Esses elementos permitem a construção de intervalos de confiança. 18 13.9 Exemplo de intervalo de confiança para os coeficientes a e b da regressão simples. mês/ano Tabela 13.3 – Vendas de camisetas e PIB jun-06 jul-06 ago-06 set-06 out-06 nov-06 dez-06 jan-07 fev-07 mar-07 abr-07 mai-07 jun-07 jul-07 ago-07 set-07 out-07 nov-07 dez-07 jan-08 fev-08 mar-08 abr-08 mai-08 PIB 100 98,08 108,97 107,19 108,08 108,93 112,18 108,64 108,17 107,85 105,66 101,54 100,37 98,08 109,47 107,06 107,59 108,87 110,44 109,92 108,75 109,19 108,25 107,68 VENDAS Yt 1102 2030 5838 6995 6283 1719 25263 19244 23171 19146 37174 16691 4235 15077 11791 17497 11353 3646 56471 44973 66937 59371 84512 52661 19 s abˆ Continuação: 13.9 Exemplo de intervalo de confiança para os coeficientes a e b da regressão simples. Aplicamos mínimos quadrados e os resultados são esses: Coeficientes Interseção a = -220.156 PIB b = 2294 Erro padrão = 126.015 = 1.180 Inferior Superior 95% 95% -481.496 41.183 -152 4.742 Tabela 13.4 – Intervalo de confiança para as estimativas de a e b. Cálculos feitos e adaptados do Excel (2002). P aˆ t 0,025, 22s aˆ a aˆ t 0,025, 22s aˆ 95% P( -220.156 – 2,074*126.015 < a< -220.156 + 2,074*126.015) = 95% P(-481.496 < a < 41.183) = 95% 20 13.10 Teste de hipótese da representatividade da equação como um todo, a estatística F. H0: a equação estimada com Xt não explica adequadamente as variações da variável dependente Yt H1: a equação estimada explica as variações da variável dependente Yt As considerações a seguir são muito parecidas com o conceito de R2 elaborado no início do capítulo, contudo a análise por teste de hipótese tem a vantagem de ter embasamento estatístico mais forte e supera a desvantagem do R2 que não tem ponto de referência bem definida para validar ou não a equação. Tudo depende da montagem da estatística F. 21 Estatística F 22 F(gl2 , gl1 ) gl2 12 gl1 SQR k SQE T k 1 No caso de regressão simples F(1, T – 2) = (SQR/1) / (SQE/(T – 2) ) Já vimos na seção sobre R2 que SQT = SQR + SQE. Os graus de liberdade associados a SQT é T-1, como já foi visto (SQT)/(T-1) é a variância de Yt. Os graus de liberdade associados a SQR é k, o número de variáveis explicativas na equação, nesse caso de regressão simples k = 1. O SQE dos erros residuais tem gl = T-k-1. Quando SQR/gl (uma espécie de média dos quadrados, MQ na tabela ANOVA) é relativamente maior que SQE/gl, a regressão explica bem a relação entre Xt e Yt 22 Tabela 13.5 – ANOVA. Teste de hipótese. Cálculos feitos e adaptados do Excel (2002). Fonte:tabela13.3 ANOVA graus de liberdade (gl) Regressão k=1 Erros T-k-1 = 22 Residuais Total T-1 = 23 SQ SQR = 1.907.658.861 SQE = 11.099.781.778 SQT = 13.007.440.639 MQ valor P F (SQR/gl) / (SQE/gl) SQR/k = 0,065 3,781 1.907.658.861 SQE/T-k-1 = 504.535.535 SQT/T-1 = 565.540.897 Relembrando a apresentação no capítulo 6 sobre testes de hipótese, um valor-p de 0,065 é considerado alto demais para rejeitar a hipótese nula, especialmente nas áreas mais exatas como a engenharia. A hipótese nula terá que ser aceita e a equação descartada pelo pesquisador, confirmando o resultado já visto na luz da análise do intervalo de confiança. 23 13.11 Outro exemplo do teste de hipótese com a estatística F: a dureza de Brinell. (1) Tabela 13.6 – Dureza de Brinell e tempo de secagem. Fonte:Tabela 12.1 OBSER. 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 MÉDIA = Yi - Dureza em Brinell Xi - minutos de secagem 199 205 196 200 218 220 215 223 237 234 235 230 250 248 253 246 226 16 16 16 16 24 24 24 24 32 32 32 32 40 40 40 40 28 24 ANOVA - Estatística F: a dureza de Brinell ANOVA gl Regressão Resíduo Total SQ MQ F Valor P 1 5297,513 5297,513 506,5062 2,16E-12 14 146,425 10,45893 15 5443,938 Cálculos feitos e adaptados do Excel (2002). Valor p é praticamente zero. Rejeitar Ho de não relacionamento entre as variaveis Yt e Xt. 25 13.12 Teste de hipótese, o exemplo de coeficientes individuais de regressão. Um teste de hipótese pode ser montada para cada coeficiente individualmente, no caso de regressão simples para a e b. A hipótese nula segue em geral o valor zero para o coeficiente sob investigação, por exemplo, H0 : b = 0 A hipótese alternativa H1, para onde o pesquisador gostaria de apontar a verdade com suas conjecturas, muitas vezes é simplesmente: H1: b ≠ 0 Dependendo do caso, H1 pode assumir outras formas como b > 0 ou b < 0. É importante na análise de regressão, e Estatística em geral, que as hipóteses nulas e alternativas sejam bem definidas, e em áreas de estudo como as engenharias ou as ciências exatas, que as hipóteses sejam colocadas nos relatórios e artigos explicitamente e em destaque. 26 Continuação: 13.12 Teste de hipótese, o exemplo de coeficientes individuais de regressão. O teste para coeficientes individuais depende do cálculo da estatística t de Gosset. No caso da estimativa para a inclinação da reta, a estatística t é uma relação entre a estimativa e a variabilidade da estimativa em termos do erro padrão s bˆ ˆ b bˆ estatística t sˆ b Estatística t calculada maior que 2 é forte indicação de relacionamento entre Yt e Xt. bˆ sˆ b 2 27 Tabela 13.7 – Teste de hipótese para coeficientes individuais. Cálculos feitos e adaptados do Excel (2002) Coeficientes Erro padrão estatística t valor-P Interseção a = -220.156 126015 -1,747 0,094 PIB b = 2294 1180 1,944 0,064 Voltando para o exemplo da demanda para camisetas e o PIB, calculamos os valores da estatística t na tabela 13.7. Os valores da estatística t são relativamente baixos, e os valores-p são altos por padrões tradicionais. Mais uma vez a análise converge para o resultado já visto acima; a equação não é adequada como representação de vendas de camisetas. 28 13.13 Não linearidade, e retornando ao exemplo do Boyle Nesse exemplo, sabemos que há uma relação de causalidade entre pressão (P) e volume (V). A causalidade pode ser verificada e quantificada com a estimação de regressão usando o procedimento de mínimos quadrados. Adotamos então como primeira tentativa, a estimação da equação V = a + bP. Os resultados preliminares são apresentados na tabela 13.8. 29 RESUMO DOS RESULTADOS Tabela 13.8 – Resultados da regressão de pressão sob volume, adaptados do Excel 2002. Estatística de regressão R-Quadrado 0,87 Erro padrão 4,06 Observações 25 ANOVA gl Regressão Resíduo Total 1 23 24 SQ 2627,43 379,21 3006,64 Interseção PRESSÃO Coeficiente s 51,95 -0,40 Erro padrão 2,13 0,03 MQ 2627,43 16,49 F valor-p 159,36 0,00 Stat t valor-p 24,41 0,00 -12,62 0,00 30 Continuação: 13.13 Não linearidade, e retornando ao exemplo do Boyle Aparentemente, os resultados comprovam uma forte relação inversa O R2 é relativamente alto, mas talvez o pesquisador esperasse um valor até mesmo melhor pela natureza da experiência cientifica O teste de F para a equação inteira oferece um valor-p de 0,00% indicando a rejeição da hipótese nula O valor-p associado aos coeficientes leva a rejeição da hipótese nula de coeficientes zero. Não é mostrado aqui, mas os erros residuais são normais, passando o teste de Bera-Jarque. Contudo, falta uma análise melhor dos erros, a sua independência e a aleatoriedade sugerida na seção 13.7 sobre o teste de hipótese da normalidade dos erros residuais. 31 Figura 13.6 – Erros residuais como a diferença entre volume e a previsão 60 50 40 30 VOLUME Previsto 20 10 0 20 -10 100 120 140 32 Continuação: 13.13 Não linearidade, e retornando ao exemplo do Boyle Na figura 13.6, nos primeiros valores do eixo horizontal de pressão, volume previsto é sempre menor que volume observado e, portanto o resíduo é sempre positivo. Para valores de pressão intermediários a situação se inverte para proporcionar resíduos sempre negativos. Finalmente, para valores de pressão altos, os resíduos voltam a ser positivos. Obviamente, os resíduos não são perfeitamente aleatórios. Conhecendo alguns erros em seqüência oferece condições para prever os próximos valores em função de um padrão reconhecível nos dados. Assim, os dados dos resíduos não são aleatórios, mas sim previsíveis. 33 Continuação: 13.13 Não linearidade, e retornando ao exemplo do Boyle Para resolver o problema da previsibilidade dos erros, podemos questionar em primeiro lugar a linearidade da equação estimada. No capítulo 12 já vimos que a relação entre volume e pressão não é linear e essa condição deve ser levada em conta para regressão simples. Vamos estimar então a equação 1/V = a + bP, explicitando que a pressão causa mais explicitamente a inversa de volume. Veja os resultados em tabela 13.9. 34 Tabela 13.9 – Resultados da regressão de pressão sob a inversa de volume, adaptados do Excel 2002. Estatística de regressão R-Quadrado 0,9999 Erro padrão 0,0002 Observações 25,0000 ANOVA Regressão Resíduo Total Interseção PRESSÃO gl 1,0000 23,0000 24,0000 SQ 0,0081 0,0000 0,0081 Erro Coeficientes padrão 0,0000 0,0001 0,0007 0,0000 MQ 0,0081 0,0000 F 210329 valor-p 0,0000 Stat t valor-p -0,0163 0,9871 459 0,0000 35 Continuação: 13.13 Não linearidade, e retornando ao exemplo do Boyle Comparando os resultados das tabelas 13.8 e 13.9, a utilização da inversa de volume melhora os resultados em quase todas as categorias, principalmente na estatística F, de 159,36 para 210.329. Pelo teste de hipótese nos coeficientes, a interseção a da equação é zero e o coeficiente b é 0,0007. A equação estimada então pode ser escrita como 1/V = 0,0007P. É sempre importante considerar todos os procedimentos para detectar problemas nas estimativas. Na indústria, decisões que valem milhões são tomadas todos os dias na base de cálculos, e muitas vezes de cálculos mau feitos, e as repercussões são catastróficas. 36 Continuação: 13.13 Não linearidade, e retornando ao exemplo do Boyle Com esse intuito, vamos ver a figura dos erros da regressão baseada na inversa de volume, figura 13.7 (próxima transparência). Os pontos são bem mais espalhados aleatoriamente. No entanto, veja que a variabilidade dos dados tende a aumentar com pouca variabilidade no inicio dos dados e mais variabilidade no final. A não constância da variância, e erro padrão, dos resíduos é chamada heterocedasticidade Como foi mostrado nas equações para o erro padrão dos coeficientes e na estatística F, o erro padrão dos resíduos se integram as expressões e se não for constante então a funcionalidade dos cálculos se complica. 37 Figura 13.7 – Erros residuais para o modelo inversa de volume. 0,0005 0,0004 0,0003 Resíduos 0,0002 0,0001 0 -0,0001 0 5 10 15 20 25 30 -0,0002 -0,0003 -0,0004 -0,0005 1/V previsto 38 Continuação: 13.13 Não linearidade, e retornando ao exemplo do Boyle A questão agora é como resolver esse problema de heterocedasticidade. Vamos procurar por alguma transformação das variáveis que elimina a tendência crescente do erro padrão. As possibilidades são numerosas, mas uma das mais óbvias e fáceis de usar é a divisão de Yt e toda a equação por Xt, criando uma nova variável dependente Yt/Xt = 1/VP e uma nova variável independente 1/P. Assim, a nova equação de regressão seria 1/VP = a(1/P) + b. 39 Tabela 13.10 – Resultados da regressão 1/VP = a(1/P) + b, adaptados do Excel 2002. Estatística de regressão R-Quadrado 0,0059 Erro padrão 3,187E-06 Observações 25 ANOVA gl Regressão Resíduo Total Interseção 1/P 1 23 24 SQ MQ F valor-p 1,40E-12 1,4E-12 0,13756 0,71411 2,34E-10 1,02E-11 2,35E-10 Coeficientes Erro padrão b = 0,0007 1,701E-06 a = -3,02E-05 8,168E-05 Stat t valor-P 419 3,7E-46 -0,371 0,714 40 Figura 13.8 – Erros residuais para o modelo 1/VP = a(1/P) + b 0,000006 Resíduos 0,000004 0,000002 0 -0,000002 -0,000004 -0,000006 1/VP previsto 41 13.14 Conclusões Este capítulo é essencialmente teórico no sentido de que a regressão linear simples é raramente utilizada na pratica, restrita a relações entre no máximo duas variáveis. Infelizmente, o mundo real não funciona tão simples assim, pois as relações interessantes sempre dependem de muitas variáveis numa maneira mais complexa com interatividade e não linearidades desempenhado papeis relevantes. 42

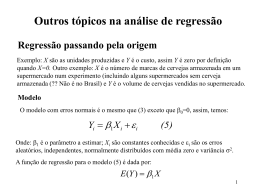

Download