Álgebra Linear: Listas 1-4 Exercícios p/

entregar

Prof.: Martin Weilandt

4 de outubro de 2012

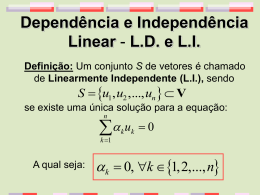

Lista 1

1. Sejam u = (u1 , . . . , un ), v = (v1 , . . . , vn ), w = (w1 , . . . , wn ) ∈ Rn . Verificamos:

(a)

(u + v) + w = ((u1 . . . , un ) + (v1 , . . . , vn )) + (w1 , . . . , wn )

= (u1 + v1 , . . . , un + vn ) + (w1 , . . . , wn )

= (u1 + v1 + w1 , . . . , un + vn + wn )

= (u1 , . . . , un ) + (v1 + w1 , . . . , vn + wn )

= u + (v + w)

(b) v + (−v) = (v1 , . . . , vn ) + (−v1 , . . . , −vn ) = (v1 − v1 , . . . , vn − vn ) = 0

(c)

u + v = (u1 , . . . , un ) + (v1 , . . . , vn ) = (u1 + v1 , . . . , un + vn )

= (v1 + u1 , . . . , vn + un ) = (v1 , . . . , vn ) + (u1 , . . . , un ) = v + u

As outras demonstrações são parecidas (i.e. são baseadas nas propriedades

correspondentes do corpo R).

2. Existência: Tome r := {P1 + t(P2 − P1 ); t ∈ R}. Isso é uma reta (pois é

na forma {P +tu; t ∈ R} para P = P1 ∈ Rn e u = P2 −P1 ∈ Rn \{0})

que contém P1 e P2 (substituir t = 0 e t = 1, respectivamente, na

representação de r acima).

Unicidade: Seja s uma reta contendo P1 , P2 . Por definição duma reta,

sabemos que existem Q ∈ Rn e v ∈ Rn \ {0} tais que s = {Q +

tv; t ∈ R}. Agora P1 , P2 ∈ s implica que existem t1 , t2 ∈ R tais que

P1 = Q + t1 v e P2 = Q + t2 v. Portanto (t1 − t2 )v = P1 − P2 . Como

P1 6= P2 , temos t1 − t2 6= 0 e portanto v é paralelo a P1 − P2 = u.

Como P1 ∈ s, concluimos r = s por um lema da aula.

1

2

3. Basta pegar u = (1, 0, 0), v = (0, 1, 0) e w := u + v = (1, 1, 0). A última

equação mostra que {u, v, w} é linearmente dependente. Para mostrar

(por exemplo) a independência linear de {v, w} com nossos métodos do

Cap. 1 sejam t1 , t2 ∈ R tais que 0 = t1 v + t2 w = (t2 , t1 + t2 , 0). Observamos que o único par (t1 , t2 ) satisfazendo t1 = 0 e t1 + t2 = 0 é dado por

(t1 , t2 ) = (0, 0). Concluimos que {v, w} é linearmente dependente.

Lista 2

1. Uma forma escalonada é:

1

0

0

0

0

−2 −6

1

3

6 −2 −k

0

0

1

0

0

0

0

k

Observamos que a última linha é pivô se e somente se k ∈ R \ {0}. Para

k = 0 observamos que o sistema possui uma variável livre (pois q = n−p =

4 − 3 = 1). Concluimos

(a) Nenhuma solução para k ∈ R \ {0}.

(b) Única solução para nenhum k ∈ R.

(c) Infinitas soluções para k = 0.

2. O efeito da operação li ↔ lj (operação arbitrária do tipo (a), onde i 6= j)

é o mesmo que o efeito das seguintes operações elementas dos tipos (b) e

(c):

1. lj ← lj + li

2. li ← li + (−1)lj

3. lj ← lj + li

4. li ← (−1)li

Argumento formal (não exigido aqui): Se denotamos a matriz original por

A0 e a matriz depois do passo n por An (i.e., a matriz final vai ser A4 )

temos (usando os quatro passos acima):

1. li (A1 ) = li (A0 ) e lj (A1 ) = lj (A0 ) + li (A0 )

2. li (A2 ) = li (A1 ) + (−1)lj (A1 ) e lj (A2 ) = li (A1 )

3. li (A3 ) = li (A2 ) e lj (A3 ) = lj (A2 ) + li (A2 )

4. li (A4 ) = (−1)li e lj (A4 ) = li (A4 )

Então podemos calcular:

lj (A4 ) = lj (A3 ) = lj (A2 )+li (A2 ) = lj (A1 )+li (A1 )−lj (A1 ) = li (A1 ) = li (A0 ).

3

e

li (A4 ) = −li (A3 ) = −li (A2 ) = −li (A1 )+lj (A1 ) = −li (A0 )+lj (A0 )−li (A0 ) = lj (A0 ).

(Um exemplo também podia ser útil para entender o que está acontecendo

aqui.)

3. (1P) Sejam 1 ≤ q ≤ n, 1 ≤ k1 < . . . < kq ≤ n e v1 , . . . , vq ∈ Rn como no

exercício. Sejam α1 , . . . αq ∈ R tais que

0=

q

X

αi v i .

i=1

Escrevendo

(

δij :=

1, i = j

0, senão

(δ de Kronecker), observamos vki j = δij para i, j ∈ {1, . . . , q}. Agora

seja j ∈ {1, . . . , q}. Calculando a kj -ésima componente do vetor acima,

obtemos

q

q

X

X

0=

αi vki j =

αi δij = αj

i=1

1

i=1

q

Concluimos que (v , . . . , v ) é um sistema linearmente independente.

Lista 3

1. (a) Escrevendo os vetores numa matriz e subtraindo 4 vezes a primeira

linha da última, obtemos uma matriz em forma escalonada:

1 −1

α

0 5

−2

0 0 4(α2 − α)

Concluimos que o sistema homogêneo associado possui infinitas soluções se, e somente se, (p < n = 3, i.e.) 0 = α2 − α = α(α − 1) - o

que é equivalente a α ∈ {0, 1}.

(b) Escolhemos α = 1 e temos de achar uma solução não-trivial do sistema

1 −1

1 0

0

5 −2 0

4 −4

4 0

Escalonando totalmente, obtemos

3

1 0

5

2

0 1 −

5

0 0

0

0

0

0

4

A solução do sistema acima é dado por

3

2

{(α1 , α2 , α3 ) ∈ R3 ; α1 = − α3 , α2 = α3 }.

5

5

Escolhendo α3 = 5, obtemos α1 = −3 e α2 = 2 e concluimos

0 = −3u + 2v + 5w.

2. O elemento neutro é dado por (0V , 0W ) pois (v, w) + (0V , 0W ) = (v +

0V , w + 0W ) = (v, w). O elemento inverso é dados por −(v, w) =

(−v, −w). Dos outros axiomas mostramos somente (SM1), as outras demonostrações são parecidos:

α((v1 , v2 ) + (w1 , w2 )) = α(v1 + w1 , v2 + w2 ) = (α(v1 + w1 ), α(v2 + w2 ))

= (αv1 + αw1 , αv2 + αw2 ) = (αv1 , αv2 ) + (αw1 , αw2 )

= α(v1 , v2 ) + α(w1 , w2 )

3. (a) Seja u ∈ hSi. Então existem n ≥ 0, v1 , . . . vn ∈ S e α1 , . . . , αn ∈ R

tais que

n

X

αi vi .

u=

i=1

i

Como U é espaço vetorial e v ∈ U ∀i ∈ {1, . . . , n}, concluimos

u ∈ U.

(A ideia em (a) era considerar o espaço gerado por S como subconjunto de V e mostrar que hSi automaticamente é contido em U . Em

outras palavras os espaço hSi é exatamente o mesmo - se S for considerado como subconjunto de V ou de U . Isso pode parecer meio-óbvio

mas é uma observação central para (b) e merece a demonstração dada

acima. Como esse detalhe não foi tão claro na notação da questão,

(a) é desconsiderado se o aluno só fiz a observação trivial que o espaço

gerado por S em U é contido em U .)

(b) ⊂: Segundo (a) cada subespaço U ⊂ V contendo S contém hSi.

⊃: U := hSi é um subespaço de V contendo S.

Lista 4

1. (a) Escalonamos a seguinte matriz

0

−1

2

1

para identificar os pivôs.

1 1 3

2 1 5

1 3 5

0 1 1

5

A forma totalmente escalonada é

1 0

0 1

0 0

0 0

dada por

1 1

1 3

0 0

0 0

e observamos que os pivôs são dados pelas primeiras duas colunas.

(Qualquer forma escalonada devia dar os mesmos pivôs.) Concluimos

que uma base de hSi é dada por

1

0

−1

, 2

β=

2 1

0

1

2. Usamos a base canônica de R4

0

−1

2

1

e consideramos a matriz

1 1 0 0 0

2 0 1 0 0

1 0 0 1 0

0 0 0 0 1

Escalonamos que observamos que os pivôs são dados pelas primeiras quatro

colunas. Portanto podemos usar β 0 = β ∪ {e1 , e2 }.

3. (a) Observamos

v 1 + . . . + v n − (v 1 + . . . + v n ) = 0.

e (1, . . . , 1, −1) ∈ Rn+1 \ {0}.

(b) Sejam α1 . . . , αn ∈ R tais que

0=

n−1

X

n

X

αi v i + αn (

vi )

i=1

=

i=1

n−1

X

(αi − αn )v i + αn v n

i=1

Como (v 1 , . . . , v n ) é um sistema linearmente independente, concluimos

αi = αn ∀i ≤ n − 1 e αn = 0

e portanto αi = 0 para todo i ∈ {1, . . . , n}.

4. (i)⇒(ii): Como β é base, temos hβi = V .

6

Supomos que exista b ∈ β tal que hβ \ {b}i = hβi = V . Então b ∈

hβ \ {b}i e, portanto, existem n ∈ N, α1 , . . . , αn ∈ R e b1 , . . . , bn ∈

β \ {b} tais que

n

X

b=

αi bi ,

i=1

i.e.

n

X

αi bi + 1b = 0.

i=1

1

n

Mas como b, b , . . . , b são elementos distintos de β (e 1 6= 0), concluimos que β é linearmente dependente. Esta contradição implica

que o b da nossa hipótese não existe e, portanto, hβ \{b}i =

6 hβi ∀b ∈

β.

(ii)⇒(i): hβi = V significa que β é conjunto-gerador de V .

Falta mostrar que β é linearmente independente: Se β fosse linearmente dependente, existiriam n ∈ N, (α1 . . . , αn ) ∈ Rn \ {0} e

b1 , . . . , bn ∈ β tais que

0=

n

X

αi bi .

i=1

Mas (α1 . . . , αn ) ∈ Rn \ {0} implica que existe i0 ∈ {1, . . . , n} tal que

αi0 6= 0 e a equação acima implica

X αi i0

bi .

b =

−

αi0

1≤i≤n

i6=i0

Mas isso implica hβ \ {bi0 }i = hβi - uma contradição a (ii). Concluimos então que β é linearmente independente.

Para mais informações veja http://mtm.ufsc.br/∼martin/al/index.html.

Baixar