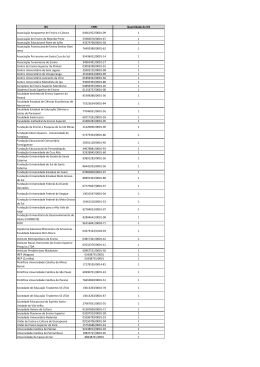

1 Análise de Risco de Crédito para Financiamento de Veículos Utilizando Técnicas de Data Mining Flávio Henrique de Souza Gonçalves Resumo—Na indústria financeira a utilização de ferramentas analíticas que auxiliem na classificação do risco de crédito dos clientes em bons e maus pagadores é indispensável para disponibilização de crédito, uma necessidade vital para os negócios de crédito, principalmente no varejo, trazendo vantagens competitivas para as Instituições Financeira (IF’s) que as utilizam na sua metodologia. As instituições financeiras possuem uma infinidade de dados disponíveis em seus repositórios de dados, que utilizam para transformar em informações úteis para os processos decisórios da organização. Neste trabalho serão analisados dados de propostas de financiamento de aproximadamente 300 mil clientes que tiveram seu créditos aprovados em uma grande IF brasileira no período de 2012 a 2013, utilizando técnicas de data mining (árvore de decisão, regressão logística e redes neurais) do pacote SAS R Enterprise MinerTM 14.1, visando classificar os futuros prospects a financiamento de veículos quanto a sua característica creditícia e viabilizando uma estratégia de análise massificada de financiamentos de veículos. Index Terms—Data mining, CRISP-DM, árvore de decisão, regressão logística, redes neurais, financiamento de veículos. I. I NTRODUÇÃO As IF’s tem como uma das suas principais linhas de crédito do varejo o financiamento de veículos novos e usados. Estas linhas de crédito apresentam um baixo índice de inadimplência diante das demais linhas de crédito, como as linhas de crédito rotativo e empréstimos pessoais sem destinação do recurso. Uma vez observada a concorrência de mercado, as IF’s buscam identificar, dentre os seus clientes prospects, aqueles com o menor risco de crédito, com a intenção de disponibilizar taxas de juros mais atrativas e competitivas. As técnicas de mineração de dados auxiliam na classificação de clientes quanto a sua capacidade creditícia, permitindo identificar clientes com baixo risco de crédito e direcionando a estes melhores condições de financiamento de veículos. A mineração de dados é composta de exploração e a análise, por meio automático ou semiautomático, de grandes quantidades de dados, a fim de descobrir padrões e regras, como em Berry[2]. O objetivo principal do trabalho é analisar o uso de três técnicas (árvore de decisão, regressão logística e redes neurais), contidas no pacote estatístico SAS R Enterprise MinerTM 14.1, para classificação de clientes prospects, em bons ou maus pagadores. A linha de crédito utilizada foi a financiamento de veículos novos ou usados, usando como modelo referência o framework de mineração de dados proposto pelo CRISP-DM (Cross Industry Process Model for Data Mining). II. DESCOBERTA E CONHECIMENTO DOS DADOS Os dados utilizados neste trabalho são dados reais de uma grande IF com grande participação no mercado de finan- ciamento de veículos. Foram capturadas cerca de 300 mil propostas de financiamento de veículos aprovados no período de 2012 e 2013 e observados os clientes que após tomarem o financiamento do veículo vieram a ficar em descumprimento (operações em atraso a mais de 90 dias) durante a vigência do contrato. Foram obtidas cerca de 52 variáveis independentes contínuas e categóricas, com informações da proposta de financiamento de veículos (percentual do financiamento, prazo, idade do veículo, modelo, preços de mercado, etc.), além das informações cadastrais de clientes (idade, sexo, endereço, renda, profissão, dentre outros) e comportamentais (histórico de pagamento, consumo de crédito no SFN, restrições cadastrais). O objetivo da modelagem é estimar a probabilidade do cliente vir a entrar em descumprimento em até 1 ano da vigência do contrato. As variáveis independentes sofreram tratamentos estatísticos antes de serem utilizadas na construção do modelo, seja para tratamentos de valores discrepantes (outliers) ou de valores faltantes (missing). As variáveis foram categorizadas aplicando técnicas estatísticas, mas especificamente foi utilizada odds ratio. Após a categorização foi realizada uma análise descritiva das variáveis conforme Laredo [4]. Posteriormente a construção e tratamento das variáveis dependente e independentes, foi delineado um plano amostral para extração de uma amostra e desenvolvimento dos modelos de classificação. Optou-se por uma amostra pareada devido a proporção dos clientes ruins (3%) em relação a clientes bons (97%) encontrados na população, evitando assim que os modelos utilizados nas técnicas de mineração de dados escolhessem as variáveis que descriminam mais os clientes bons pela sua predominância na população, uma vez que o objetivo é encontrar aquelas variáveis que descriminam os clientes ruins. Após selecionar a amostra pareada de clientes, foi feita a divisão em duas sub amostras para desenvolvimento e treinamento dos modelos. A proporção utilizada para bons e maus pagadores foi de 2/3 e 1/3 respectivamente, conforme sugerido por Laredo[4]. III. IMPLEMENTAÇÃO COMPUTACIONAL E MODELAGEM DOS DADOS Nesta seção é apresentada a implementação computacional das três técnicas abordadas, regressão logística, árvores de decisão e redes neurais, bem como a comparação entre elas no que diz respeito a seus desempenhos e resultados de 2 classificação de clientes entre bons e ruins para financiamento de veículos. A escolha dessas técnicas foi motivada pela facilidade em utilizar variáveis categóricas e contínuas, não pressupor nenhuma distribuição dos seus dados e conseguir ao final da modelagem escorar os clientes conforme sua probabilidade de vir a ficar em descumprimento. A. Regressão Logística A primeira técnica de modelagem a ser utilizada é a regressão logística. Esta trata-se de um técnica estatística que tem como objetivo produzir, a partir de um conjunto de observações, um modelo que permita a predição de valores tomados por uma variável categórica, frequentemente binária, a partir de uma série de variáveis explicativas contínuas e/ou categóricas, conforme Agresti[1] . Uma das vantagens na utilização da regressão logística é que ela não pressupõe normalidade dos erros, é de fácil interpretação e pode ser aplicada em variáveis contínuas e categóricas. Segundo Agresti[1], para uma variável resposta binaria Y e variáveis explicativas X, temos: ⇡(x) = P (Y = 1|X = x) = 1 P (Y = 0|X = x). O modelo de regressão logística pode ser expresso da seguinte maneira: exp (↵ + x) ⇡ (x) = . (1 + exp (↵ + x)) Equivalentemente, os ODDS, chamados logit, tem a relação linear log (⇡ (x)) Logit [⇡ (x)] = = ↵ + x. log (1 ⇡ (x)) Isso equivale a função de ligação logit para o preditor linear. O modelo encontrado foi: Intercept f_var_0036 f_var_0059 f_var_0112 f_var_0114 f_var_0503 f_var_0511 f_var_0523 f_var_0532 f_var_0585 f_var_0825 f_var_0903 f_var_0904 Por motivos de confidencialidade dos dados as variáveis e seus pesos não poderão ser divulgadas publicamente. Na tabela I pode ser observada a ordem de entrada das variáveis nos modelos utilizando o processo de seleção stepwise, note que todas as variáveis do modelo tiveram nível de significância aceitável para o teste de qui-quadrado. Tabela I S ELEÇÃO DAS VARIVAIES UTILIZANDO O MÉTODO stepwise. step 1 2 3 4 5 6 7 8 9 10 11 12 effect entered v_0112 v_0503 v_0904 v_0059 v_0532 v_0036 v_0114 v_0903 v_0825 v_0585 v_0511 v_0523 number df 5 4 4 4 4 4 3 4 2 3 2 3 score in 1 2 3 4 5 6 7 8 9 10 11 12 chi-square pr>chisq 29.084.665 11.255.229 7.684.502 3.100.076 1.969.337 1.454.771 1.250.694 529.309 414.483 412.464 297.420 217.390 <.0001 <.0001 <.0001 <.0001 <.0001 <.0001 <.0001 <.0001 <.0001 <.0001 <.0001 <.0001 Na matriz de confusão apresentado na tabela II , observase que apenas 10% dos clientes classificados como “bons” apresentaram pelo menos um, descumprimento após 12 meses de observação, demonstrando um bom poder de descriminação do modelo. Tabela II M ATRIZ DE CONFUSÃO - REGRESSÃO LOGÍSTICA . False Negative 1044 9% False Negative 483 10% Amostra Desenvolvimento True False True Negative Positive Positive 4655 1159 4770 40% 10% 41% Amostra Validação True False True Negative Positive Positive 1947 546 2010 39% 11% 40% Total 11628 Total 4986 A distribuição dos scores dos clientes após a modelagem pode ser observado na tabela III, que mostra a proporção de clientes classificados como “bons” e “ruins” por faixa de probabilidade, o que permite definir o ponto de corte (cut off ) para determinar a partir de que ponto autoriza a contratação de operações do cliente. Tabela III M ATRIZ DE CONFUSÃO - REGRESSÃO LOGÍSTICA . Posterior Probability Range 0.95-1.00 0.90-0.95 0.85-0.90 0.80-0.85 0.75-0.80 0.70-0.75 0.65-0.70 0.60-0.65 0.55-0.60 0.50-0.55 0.45-0.50 0.40-0.45 0.35-0.40 0.30-0.35 0.25-0.30 0.20-0.25 0.15-0.20 0.10-0.15 0.05-0.10 0.00-0.05 Number of Events 370 1208 870 695 447 331 272 225 184 168 154 114 109 130 104 88 112 94 86 53 Number of Nonevents 15 73 102 118 134 134 144 134 144 161 196 216 239 263 323 379 492 589 899 1059 Mean Posterior Probability 0.962 0.925 0.876 0.825 0.776 0.725 0.675 0.625 0.574 0.525 0.474 0.425 0.375 0.324 0.275 0.224 0.174 0.123 0.073 0.026 % 33.110 110.165 83.591 69.917 49.966 39.990 35.776 30.874 28.208 28.294 30.100 28.380 29.928 33.798 36.722 40.162 51.944 58.738 84.709 95.631 Para determinar o cut off foi observado em que faixa de probabilidade o número observado de clientes ruins (numbers of events) passa a ser maior que o número de clientes bons (numbers of nonevents). Diante disso, foi encontrado o ponto de corte para clientes com probabilidades de vir a descumprir abaixo de 50%, ou seja, aqueles clientes que possuem probabilidade superior a 50% de descumprimento terão sua proposta reprovada automaticamente pelo modelo. B. Árvore de decisão Quinlan[5] é considerado o "pai das Árvores de Decisão", a sua contribuição foi a elaboração de um novo algoritmo chamado ID3, desenvolvido em 1983. O ID3 e suas evoluções 3 (ID4, ID6, C4.5, See 5) são algoritmos muito utilizados para gerar árvore de decisão. Segundo Lemos[3], árvore de decisão são métodos de classificação de dados no contexto de mineração de dados. Podem ser usadas em conjunto com a tecnologia de indução de regras, mas são as únicas a apresentar os resultados hierarquicamente (com priorização). Nelas, o atributo mais importante é apresentado na árvore como o primeiro nó, e os atributos menos relevantes são mostradas nos nós subsequentes. Os resultados encontrados durante a modelagem da árvore e as principais variáveis explicativas do modelo foram por ordem de importância conforme a tabela IV. Tabela IV I MPORTÂNCIA DAS VARIÁVEIS FINAIS DO MODELO - ÁRVORE DE DECISÃO . step 1 2 3 4 5 6 7 8 9 10 11 12 effect entered v_0112 v_0503 v_0904 v_0059 v_0532 v_0036 v_0114 v_0903 v_0825 v_0585 v_0511 v_0523 number df 5 4 4 4 4 4 3 4 2 3 2 3 score in 1 2 3 4 5 6 7 8 9 10 11 12 chi-square pr>chisq 29.084.665 11.255.229 7.684.502 3.100.076 1.969.337 1.454.771 1.250.694 529.309 414.483 412.464 297.420 217.390 <.0001 <.0001 <.0001 <.0001 <.0001 <.0001 <.0001 <.0001 <.0001 <.0001 <.0001 <.0001 Na matriz de confusão apresentado na tabela V, observase que apenas 12% dos clientes classificados como “bons” apresentaram pelo menos um descumprimento após 12 meses de observação, demonstrando um bom poder de descriminação do modelo de classificação da árvore de decisão. Tabela V M ATRIZ DE CONFUSÃO - ÁRVORE DE DECISÃO . False Negative 1388 12% False Negative 610 12% Amostra Desenvolvimento True False True Negative Positive Positive 4774 1040 4426 41% 9% 38% Amostra Validação True False True Negative Positive Positive 2024 469 1883 41% 9% 38% Total 11628 Total 4986 A distribuição dos scores dos clientes após o desenvolvimento da árvore de decisão pode ser observado na tabela VI, que mostra a proporção de clientes classificados como “bons” e “ruins” por faixa de probabilidade, o que permite definir o ponto de corte (cut off ) para determinar a partir de que ponto autoriza a contratação de operações do cliente. O cut off foi definido para clientes com probabilidades de vir a descumprir abaixo de 55%, ou seja, aqueles clientes que possuem probabilidade superior a 55% de descumprimento terão sua proposta reprovada automaticamente pelo modelo. C. Redes Neurais Redes Neurais Artificiais são técnicas computacionais que apresentam um modelo matemático inspirado na estrutura neu- Tabela VI D ISTRIBUIÇÃO DO SCORE DOS CLIENTES - ÁRVORE DE DECISÃO . Posterior Probability Range 0.90-0.95 0.80-0.85 0.75-0.80 0.70-0.75 0.60-0.65 0.55-0.60 0.45-0.50 0.40-0.45 0.35-0.40 0.30-0.35 0.25-0.30 0.15-0.20 0.10-0.15 0.05-0.10 0.00-0.05 Number of Events 1603 1501 193 444 455 230 115 38 554 119 233 180 38 101 10 Number of Nonevents 112 299 57 150 255 167 131 53 866 262 690 850 272 1397 253 Mean Posterior Probability 0.934 0.833 0.772 0.747 0.640 0.579 0.467 0.417 0.390 0.312 0.252 0.174 0.122 0.067 0.038 % 147.489 154.799 21.500 51.084 61.060 34.142 21.156 0.7826 122.119 32.766 79.377 88.579 26.660 128.827 22.618 ral de organismos inteligentes e que adquirem conhecimento através da experiência. A propriedade mais importante das redes neurais é a habilidade de aprender e com isso melhorar seu desempenho. Isso é feito através de um processo iterativo de ajustes aplicado a seus pesos, o treinamento. O aprendizado ocorre quando a rede neural atinge uma solução generalizada para uma classe de problemas. Pode se destacar como as principais características da redes neurais a utilização de variáveis categóricas, os valores numéricos devem ser “discretizados”, possui treinamento supervisionado, possui diversas técnicas não requer conhecimento prévio sobre o domínio, facilidade para generalizar e tratar ruídos, tem como desvantagens ser uma “caixa preta”, ajuste de parâmetros é artesanal e pode tornar-se complexo. Os resultados encontrados no processamento dos dados utilizando a redes neurais demonstram uma boa classificação dos clientes após o treinamento das redes. A arquitetura utilizada para treinamento das redes foi multilayer perception e a técnica de treinamento foi a backpropagation. Na matriz de confusão apresentado pelas redes neurais, observa-se que apenas 9% dos clientes classificados como “bons” apresentaram pelo menos um, descumprimento após 12 meses de observação, demonstrando um bom poder de descriminação conforme tabela VII. Tabela VII M ATRIZ DE CONFUSÃO - REDES NEURAIS . step 1 2 3 4 5 6 7 8 9 10 11 12 effect entered v_0112 v_0503 v_0904 v_0059 v_0532 v_0036 v_0114 v_0903 v_0825 v_0585 v_0511 v_0523 number df 5 4 4 4 4 4 3 4 2 3 2 3 score in 1 2 3 4 5 6 7 8 9 10 11 12 chi-square pr>chisq 29.084.665 11.255.229 7.684.502 3.100.076 1.969.337 1.454.771 1.250.694 529.309 414.483 412.464 297.420 217.390 <.0001 <.0001 <.0001 <.0001 <.0001 <.0001 <.0001 <.0001 <.0001 <.0001 <.0001 <.0001 4 Tabela VIII D ISTRIBUIÇÃO DO SCORE DOS CLIENTES - REDES NEURAIS . Posterior Probability Range 0.95-1.00 0.90-0.95 0.85-0.90 0.80-0.85 0.75-0.80 0.70-0.75 0.65-0.70 0.60-0.65 0.55-0.60 0.50-0.55 0.45-0.50 0.40-0.45 0.35-0.40 0.30-0.35 0.25-0.30 0.20-0.25 0.15-0.20 0.10-0.15 0.05-0.10 0.00-0.05 Number of Events 370 1208 870 695 447 331 272 225 184 168 154 114 109 130 104 88 112 94 86 53 Number of Nonevents 15 73 102 118 134 134 144 134 144 161 196 216 239 263 323 379 492 589 899 1059 Mean Posterior Probability 0.962 0.925 0.876 0.825 0.776 0.725 0.675 0.625 0.574 0.525 0.474 0.425 0.375 0.324 0.275 0.224 0.174 0.123 0.073 0.026 apresentaram um melhor poder explicativo que a árvore de decisão. % Tabela IX R ESULTADOS OBTIDOS PELAS TÉCNICAS DE REDES NEURAIS , REGRESSÃO 33.110 110.165 83.591 69.917 49.966 39.990 35.776 30.874 28.208 28.294 30.100 28.380 29.928 33.798 36.722 40.162 51.944 58.738 84.709 95.631 LOGÍSTICA E ÁRVORE DE DECISÃO A distribuição dos scores dos clientes após o desenvolvimento das redes neurais pode ser observado na tabela VIII, que mostra a proporção de clientes classificados como “bons” e “ruins” por faixa de probabilidade, o que permite definir o ponto de corte (cut off ) para determinar a partir de que ponto autoriza a contratação de operações do cliente. O cut off foi definido para clientes com probabilidades de vir a descumprir abaixo de 45%, ou seja, aqueles clientes que possuem probabilidade superior a 45% de descumprimento terão sua proposta reprovada automaticamente pelo modelo. D. Comparação dos Resultados O primeiro resultado que pode ser observado é a curva ROC dos três modelos. Note que os modelos de redes neurais e regressão logística apresentaram os mesmo resultados tanto na amostra de treinamento quanto na amostra de validação, 0,90 e 0,88, respectivamente, demonstrando um poder de classificação melhor que a árvore de decisão. Outras métricas estatísticas, além da curva ROC, também podem ser utilizadas na escolha do melhor modelo para classificar futuros clientes prospects de financiamento de veículos, como o K-S (kolmogorov-Sminorv) que é a medida de avaliação de performance mais amplamente utilizada no mercado e mede a capacidade do score distinguir bons e maus clientes. Quanto maior a estatística de K-S, maior a separação entre bons e maus. Basicamente esta estatística é construída calculando a máxima diferença entre as distribuições acumuladas de bons e maus pagadores. O Índice de GINI é duas vezes a área entre a diagonal que cruza o gráfico em 45o e a curva ROC, esse coeficiente sumariza a performance do modelo sobre todos os pontos de corte. Na tabela IX podemos observar as principais estatísticas de performance dos modelos que podem ajudar na escolha do melhor para o problema estudado. Observa-se que os modelos desenvolvidos pela redes neurais e regressão logística Estatísticas Kolmogorov-Smirnov Índice de ROC Coeficiente de GINI Neural 0,66 0,90 0,80 Regressão 0,65 0,90 0,78 Árvore 0,60 0,87 0,73 IV. C ONCLUSÃO As técnicas de mineração de dados apresentadas e utilizadas neste trabalho árvore de decisão, regressão logística e redes neurais, no contexto do framework do CRISP-DM, demonstraram ser ferramentas analíticas de grande importância para o processo decisório das IF’s no que diz respeito a concessão de crédito para financiamento de veículos. Diante do apresentado neste artigo, os analistas de crédito das IF’s podem utilizar qualquer uma das três técnicas de mineração de dados para classificar seus clientes entres bons e ruins, pois se mostraram bastante eficientes. Apesar do critério e escolha do melhor modelo apontado pelo do SAS R Enterprise MinerTM 14.1, outros fatores precisam ser levados em consideração além da performance do modelo, principalmente a interpretação do modelo desenvolvido onde as técnicas de regressão logística e árvore de decisão são bem mais simples de interpretar que a redes neurais. Como os indicadores de performance da regressão logística estão muito próximos das redes neurais e possui fácil interpretação dos seus resultados, esse modelo foi o escolhido para classificar os clientes prospect de financiamento de veículos. A difícil missão das IF’s em conceder crédito, pode ser facilitadas pelas ferramentas quantitativas como apresentadas neste artigo, mas não dispensa a expertise de seus analistas de crédito que conseguem captar outras informações fora do contexto da modelagem para conceder novos créditos. Em trabalhos futuros pode ser testado modelos para inferência de rejeitados, visando obter uma maior rentabilidade da carteira e mantendo os níveis de inadimplência nos mesmos patamares atuais. Além de testes de hipóteses para ajudar a decidir quais das técnicas utilizadas seria mais adequado ou que traria um maior retorno dado o risco da carteira de crédito. R EFERÊNCIAS [1] A. Alan. Categorical Data Analysis. John Wiley and Sons, Hoboken, New Jersey, 2002. [2] G. S. L. e Michael J. A. Berry. Data Mining Techniques: For Marketing, Sales, and Customer Relationship Management. John Wiley and Sons, Hoboken, New Jersey, 2011. [3] J. C. N. Eliane Prezepiorski Lemos, Maria Teresinha Arns Steiner. Análise de crédito bancário por meio de redes neurais e árvores de decisão: uma aplicação simples de data mining. Revista de Administração da USP, São Paulo, 2011. [4] S. A. Laredo. Credit Scoring. Edgar Blucher, São Paulo, 2010. [5] J. R. Quinlan. C4.5: Programs for Machine Learning. Morgan Kaufmann Publishers, 2003.

Download