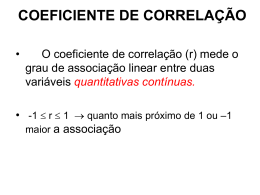

INCT: Informação Genético-Sanitária da Pecuária Brasileira SÉRIE TÉCNICA: GENÉTICA Publicado “on line’ em www.animal.unb.br em 03/11/2010 Glossário de Termos Estatísticos Concepta McManus 1 1,2 , Luiza Seixas 1, Cristiano Barros de Melo 1,3 CNPq / INCT / Informação Genético Sanitária da Pecuária Brasileira, Universidade de Brasília (UnB) / Universidade Federal de Minas Gerais (UFMG), Belo Horizonte, MG. 2 Universidade Federal do Rio Grande do Sul (UFRGS), Porto Alegre, RS. 3 Universidade Brasília (UnB), Brasília, DF. Estatística • Expressão em Latim statisticum collegium, alguém que palestra sobre os assuntos do Estado ou conselho de Estado; • • surgiu a palavra em língua italiana statista; • significa "homem de estado", estadista ou político; Palavra alemã Statistik; o A análise de dados sobre o Estado; o significando a "ciência do Estado" o Palavra foi proposta pela primeira vez no século XVII, em latim, por Schmeitzel na Universidade de Lena e adotada pelo acadêmico alemão Godofredo Achenwall; • Aparece como vocabulário na Enciclopédia Britânica em 1797; • Adquiriu um significado de coleta e classificação de dados, no início do século 19. 1 (1 - alfa) Nível de confiança: É a probabilidade de que o Intervalo de Confiança contenha o verdadeiro valor do parâmetro. α (alfa): É a probabilidade de Rejeitar Ho, quando ela é verdadeira. Neste caso, seria a probabilidade de afirmar que as atitudes em relação à Matemática interferem na formação das atitudes em relação à Estatística, quando na realidade não existe nenhuma relação. Este erro é controlado pelo pesquisador, e é ele que define a margem de erro que está disposto a correr. Existem vários fatores que influenciam na escolha do nível de significância. Em pesquisas, como nas ciências exatas, biológicas, agronômicas, onde as variáveis são mais fáceis de mensurar, onde os instrumentos de medida são confiáveis, onde o controle de fatores intervenientes é razoável, o conhecimento da área é maior, a gravidade das conseqüências do erro menor, entre outros, permitem um maior rigor e, portanto, pode-se ser mais exigente, diminuindo o nível de significância. Contudo, em pesquisas, nas ciências humanas, que lida com pessoas, com construtos polêmicos, instrumentos ainda não testados, as consequências do erro não são tão graves, entre outros, pode-se ser mais flexível. Via de regra, usa-se o nível de 5%. Alfa (alpha): É a probabilidade de se cometer Erro do Tipo I (rejeitar a hipótese nula quando ela é verdadeira) no teste de hipóteses. Algoritmo(algorithm): Um algoritmo é um conjunto definido de operações e passos ou procedimentos que objetivam levar a um particular resultado. Por exemplo, com algumas exceções, os programas computacionais, as fórmulas matemáticas e (de forma ideal) receitas médicas e culinárias são algoritmos. Amostra: Uma amostra é um subconjunto de indivíduos da população alvo. Existem dois tipos de amostras, as probabilísticas, baseadas nas leis de probabilidades, e as amostras não inferência estatística. n - tamanho da amostra probabilísticas, que tentam reproduzir o mais fielmente possível a população alvo. Entretanto, somente as amostras probabilísticas podem, por definição, originar uma generalização estatística, apoiada no cálculo de probabilidades. Amostra (sample): Uma parte finita e não vazia extraída de uma população. Amostra Amodal: é uma amostra que não tem moda. Amostra Bimodal: é uma amostra que tem duas modas. Amostra Imparcial: é uma amostra em que todos os elementos 2 tiveram uma igual oportunidade de fazer parte da mesma. Amostra Multimodal: é uma amostra que tem mais do que duas modas. Amostra Representativa: é aquela que deve conter em proporção todas as características qualitativas e quantitativas da população. Amostra: envolve premissas que dizem respeito às características do evento estudado, dos fatores que exerçam influência sobre este evento e da análise que se pretenda fazer. Portanto, antes de definir o tamanho da amostra, o pesquisador deverá ocupar-se das definições de um planejamento amostral, cujas características serão particulares para cada estudo. Em geral, o planejamento do tamanho da amostra leva em consideração os erros do Tipo I e do Tipo II, de forma que as estimativas de interesse tenham precisão suficiente para serem utilizadas. Portanto, para dimensionar a amostra o pesquisador deve fornecer o nível de significância e o poder do teste desejado Amostragem (sampling): É o método de retirada de amostras de uma população. Amostragem Aleatória (random sample): A amostragem é dita aleatória, probabilística ou ao acaso se todos os elementos da população tiveram probabilidade conhecida e diferente de zero de pertencerem a amostra. Amostragem Aleatória Simples: é aquela em que qualquer elemento da população tem a mesma probabilidade de ser escolhido. Amostragem aleatória simples (simple random sampling): A amostragem é dita aleatória simples se todos os elementos da população possuírem a mesma probabilidade de pertencerem a amostra. Amostragem Estratificada: é aquela em que a população está dividida em estratos ou grupos diferenciados. Amostragem estratificada (stratified sampling): Método de amostragem na qual os elementos são retirados de subpopulações agrupadas por algum critério. Amostragem por conglomerados (cluster sampling): Método de amostragem onde o que é sorteado é o aglomerado e não a unidade individual. Amostragem Sistemática: é aquela em que os elementos são 3 escolhidos a partir de uma regra previamente estabelecida. Amostragem sistemática (systematic sampling): Método de amostragem na qual o primeiro elemento de uma lista da população é selecionado ao acaso e após cada k-ésimo elemento é selecionado. Amostragem: um campo da estatística que estuda técnicas de planejamento de pesquisa para possibilitar inferências sobre um universo a partir do estudo de uma pequena parte de seus componentes, uma amostra. Amplitude (range): É a diferença entre os extremos de um conjunto, isto é, a distância entre o máximo e o mínimo do conjunto. Amplitude de um Conjunto de Dados: é a diferença entre o maior valor e o menor valor desse conjunto. Se os dados estiverem agrupados em classes, a amplitude é a diferença entre o limite superior da última classe e o limite inferior da primeira. Análise de componentes principais (principal component analysis): Transformar um conjunto de variáveis originais, intercorrelacionadas, num novo conjunto de variáveis não correlacionadas, as componentes principais. O objetivo mais imediato da ACP é verificar se existe um pequeno número das primeiras componentes principais que seja responsável por explicar uma proporção elevada da variação total associada ao conjunto original Análise de conglomerados (cluster analysis): O propósito da Análise de Cluster é buscar uma classificação de acordo com as relações naturais que a amostra apresenta, formando grupos de objetos (individuos, empresas, cidades ou outra unidade experimental) por similaridade Análise de sobrevivência (survival analysis): é o estudo de indivíduos (itens observados) onde um evento bem definido (falha) ocorre depois de algum tempo (tempo de falha). Análise discriminante (discriminant analysis): encontrar a melhor função discriminante linear de um conjunto de variáveis que reproduza, tanto quanto possível, um agrupamento a priori de casos considerados Análise multivariada (multivariate analysis): Trata-se de um conjunto de métodos que permite a análise simultânea de medidas múltiplas para cada indivíduo ou objecto em análise, ou seja, qualquer método que permita a análise simultânea de duas ou mais 4 variáveis pode ser considerado como multivariado. Análise Probit (probit analysis): Em teoria de probabilidade e estatística, probit a função é inverso função de distribuição cumulativa (CDF), ou função do quantile associado com o padrão distribuição normal. Tem aplicações dentro gráficos estatísticos exploratórios e especializado modelar da regressão de variáveis binárias da resposta. ANDEVA (Analise de variância): técnica estatística cujo objetivo é testar a igualdade entre três ou mais médias. Ela permite testar se a variabilidade dentro dos grupos é maior que a existente entre os grupos. A técnica supõe independência e normalidade das observações, e igualdade entre as variâncias dos grupos. ANOVA (Analysis of Variance): Teste de hipótese que objetiva comparar mais de duas médias. É isto mesmo, a análise de variância é um teste para comparar médias, que é realizado através das variâncias dentro e entre os conjuntos envolvidos. É uma extensão do teste "t" para duas médias. ANOVA: ver Andeva Assimetria (skeweness): Se um conjunto de dados for dividido em duas partes a partir da mediana e estas duas partes não forem iguais, então ele é dito assimétrico. Outra maneira de verificar se um conjunto é assimétrico é calcular o seu coeficiente de assimetria ou o momento de terceira ordem. Se ele for diferente de zero então o conjunto é dito assimétrico. Atípico (outlier): É um valor de um conjunto de dados que se afasta dos demais. É um valor normalmente muito grande ou muito pequeno quando comparado com o restante do conjunto. Pode ter sido resultado de um erro de medida ou, então, pode ser um indicativo de um comportamento atípico do conjunto sob determinadas condições. Atributo (attribute): É uma denominação alternativa possíveis valores assumidos por uma variável qualitativa. para os Atributos Qualitativos: são atributos que estão relacionados com uma qualidade e apresentam-se com várias modalidades. Atributos Quantitativos: são atributos aos quais é possível atribuir uma medida e apresentam-se com diferentes intensidades ou valores. Autocorrelação (autocorrelation): é uma medida que informa o 5 quanto o valor de uma realização de uma variável aleatória é capaz de influenciar seus vizinhos Bootstrapping: um método de reamostragem onde se utiliza para aproximar distribuição na amostra de um levantamento estatístico. Se usa frequentemente para aproximar o viés ou a variância de um conjunto de dados estatísticos, assim como para construir intervalos de confiança ou realizar contrastes de hipóteses sobre parâmetros de interesse. Na maior parte dos casos não pode obter-se expressões fechadas para as aproximações bootstrap e portanto é necessário obter reamostragens em um ordenador para por em prática o método. A enorme capacidade de cálculo dos computadores atuais facilita consideravelmente a aplicabilidade deste método tão custoso computacionalmente Censo: é um estudo estatístico que resulta da observação de todos os indivíduos da população relativamente a diferentes atributos prédefinidos. Classe Mediana ( ): é a classe, para dados classificados, que contem a Mediana (neste caso considera-se como Mediana o valor da variável estatística que corresponde a n/2, quer n seja par, quer n seja ímpar). Classe Modal: é a classe, para dados classificados, que aparece com maior frequência. Coeficiente angular ou inclinação (da reta de regressão: Y = a + b * X): É a variação de Y por cada variação de X. Coeficiente de confiança: corresponde a 1- α (probabilidade de aceitar a hipótese nula quando esta é verdadeira) e indica a probabilidade de decisão correta baseada na hipótese nula. Coeficiente de correlação de Pearson (Pearson correlation coeficient): é uma medida do grau de relação linear entre duas variáveis quantitativas. Este coeficiente varia entre os valores -1 e 1. O valor 0 (zero) significa que não há relação linear, o valor 1 indica uma relação linear perfeita e o valor -1 também indica uma relação linear perfeita mas inversa, ou seja quando uma das variáveis aumenta a outra diminui. Quanto mais próximo estiver de 1 ou -1, mais forte é a associação linear entre as duas variáveis Coeficiente de correlação de Spearman (Spearman rho correlation coeficient): O coeficiente ρ de Spearman mede a intensidade da relação entre variáveis ordinais. Usa, em vez do valor observado, apenas a ordem das observações. 6 Deste modo, este coeficiente não é sensível a assimetrias na distribuição, nem à presença de outliers, não exigindo portanto que os dados provenham de duas populações normais Coeficiente de Correlação Linear ( r ): medida estatística que permite calcular o valor numérico correspondente ao grau de dependência entre duas variáveis, o qual varia entre -1 e 1. Coeficiente de correlação parcial (partial correlation coeficient): O coeficiente de correlação parcial( rAB.C) permite conhecer o valor da correlação entre duas variables A e B, se a variable C tinha permanecido constante para a série de observações consideradas. O rAB.C é o coeficiente de correlação total entre as variables A e B quando se lhes retirou sua melhor explicação lineal em termo de C. Coeficiente de determinação (coefficient of determination): indica quanto da variância da variável resposta é explicada pela variância das variáveis explicativas. Seu valor está no intervalo de 0 a 1: Quanto maior, mais explicativo é o modelo Coeficiente de determinação (R2): É o quadrado do coeficiente de correlação de Pearson e expresso em porcentagem. É o percentual explicado da variação da variável dependente pela reta de regressão (modelo). O restante é explicado pelo erro, que pode ser devido a ausência de outras variáveis, erros de mensuração das variáveis e ao erro aleatório. Coeficiente de variação (coefficient of variation): É o quociente entre o desvio padrão e a média de um conjunto de dados. É um percentual e portanto adequado para efetuar comparações entre diferentes conjuntos de dados. Coeficiente gama (gamma coeficient). Consistência (consistency): Propriedade que descreve o comportamento de um estimador quando o tamanho da amostra tende ao infinito. Correlação: é a relação ou dependência entre as duas variáveis de uma distribuição bidimensional. Correlação (correlation): Um termo geral utilizado para descrever o fato de que duas ou mais variáveis (conjuntos de dados) estão relacionados. Galton, em 1869, foi provavelmente o primeiro a utilizar o termo com este sentido. O termo é utilizado mais precisamente para denominar relacionamento linear entre dois conjuntos de dados ou variáveis. Correlação amostral (r): Serve para estimar a correlação linear 7 populacional. Correlação canônica (canonical correlation). Correlação Fraca ou Nula: quando o Diagrama de Dispersão não permite o ajustamento de nenhuma reta, o que significa que r = . Diz-se, então, que não existe nenhuma relação entre as variáveis da Distribuição Bidimensional. Correlação Negativa Forte: quando a reta de regressão, obtida a partir do Diagrama de Dispersão, tem declive negativo. A correlação é negativa quando r varia entre -1 e 0 e será tanto mais forte quanto r se aproxima de -1. Correlação Negativa Perfeita ou Linear: quando a reta de regressão, obtida a partir do Diagrama de Dispersão, tem declive negativo com r Correlação populacional (r): É um valor que mede o grau de relação linear entre duas variáveis quantitativas. É igual a covariância dividida pelo desvio padrão de cada uma das variáveis. Correlação Positiva Forte: quando a reta de regressão, obtida a partir do Diagrama de Dispersão, tem declive positivo. A correlação é positiva quando r varia entre 0 e 1 e será tanto mais forte quanto r se aproxima de 1. Correlação Positiva Perfeita ou Linear: quando a reta de regressão, obtida a partir do Diagrama de Dispersão, tem declive positivo com r Covariância populacional C(X,Y): É um valor que mede o grau de dispersão simultânea de duas variáveis quantitativas em relação as suas médias. É a soma dos produtos dos desvios das variáveis em relação a sua média, dividido pelo número de observações: Soma[(Xi – médiaX)*(Yi – médiaY)]/N. É o numerador do coeficiente de correlação. Covariável (covariate or control variable): Uma variável que apresenta um efeito que não se tem interesse direto. A análise da variável de interesse apresentará melhores resultados se a variação da covariável for controlada. 8 Curtose (kurtosis): É uma medida de um conjunto de dados que informa o quanto este conjunto se desvia do modelo (curva) normal. É o grau de achatamento do conjunto. A curva normal teria um coeficiente de curtose igual a três (alguns autores utilizam zero) e é denominada de mesocúrtica. Uma medida acima de três (ou positiva) caracterizaria o conjunto como leptocúrtico (mais afinado que a curva normal). Se o coeficiente de curtose for menor do que três (ou negativo) então o conjunto é denominado de platicúrtico (mais achatado do que a curva normal). Foi proposto por Karl Pearson antes de 1905. É representado por g2 e calculado por: g2= m4/m22, onde m4 é o momento central de quarta ordem e m2 é a variância Dado Estatístico: é o resultado da atributo/variável qualitativa ou quantitativa. observação de um Dados (data): Os números e atributos que são coletados, analisados e interpretados. Dados Classificados: são valores que uma dada variável pode tomar dentro de certo intervalo. Estes dados são classificados ou agrupados em classes. Dados de seção transversal (cross section data): Dados coletados no mesmo ou aproximadamente no mesmo ponto do tempo. Dados de série histórica (data): Dados coletados em períodos de tempo sucessivos. Dados Simples: vão valores associados a uma dada variável e cuja representação é feita através de uma tabela. Definição do Problema: é a primeira fase do estudo estatístico e consiste na definição e formulação correcta do problema a ser estudado. Densidade da classe (class density): É a freqüência da classe dividida pela sua amplitude. Descrição das variáveis: A variável constitui um primeiro nível de operacionalização de uma construção teórica e, para cada uma, se deve dar, em seguida, uma descrição operacional. Para algumas variáveis a descrição é simples, porém, em outros casos, essa definição é mais complexa. Uma variável contínua, pode ser transformada em discreta e depois em categórica ordinal, por exemplo idade (como diferença entre a data atual e data de nascimento, anos completos, faixas de idade). É recomendável tomar o valor bruto e depois categorizá-lo, isso dá mais flexibilidade ao 9 pesquisador. Desvio (deviation): A diferença entre o valor de um conjunto (dado) e a média deste conjunto. Desvio Médio (d): é a média aritmética do valor absoluto da diferença entre cada valor e a média, no caso dos dados não classificados. No caso dos dados classificados, tem que se entrar em conta com a frequência absoluta de cada observação. Desvio Padrão (standard deviation): É a raiz quadrada da soma dos quadrados dos desvios dividida pelo número de elementos, ou dito de outra forma, é raiz quadrada da média aritmética dos quadrados dos desvios. Desvio Padrão (s): é a raiz quadrada positiva da variância. Diagrama de Frequências. Caule-e-Folhas: o mesmo que Separador de Diagrama de Dispersão: é a representação num referencial ortonormado de um conjunto de pares ordenados de valores (x , y), onde cada par ordenado corresponde a uma observação. Diagrama de dispersão (scattergram). Diagrama de Extremos e Quartis: é um diagrama que representa os valores extremos e os quartis de uma variável estatística. Dispersão (dispersion): O quanto um conjunto de dados está espalhado. A dispersão é normalmente avaliada em torno da média, através da variância, do desvio padrão e do desvio médio. Mas também pode ser definida pela amplitude que é a diferença entre o máximo e o mínimo do conjunto ou ainda pela amplitude interquartílica, isto é, a diferença entre o terceiro e o primeiro quartil. Distância de Mahalanobis (Mahalanobis distance): Uma medida que fornece o quanto um ponto (dado) se afasta da média da amostra (ou centróide) no espaço das variáveis independentes utilizadas no ajuste de um modelo de regressão múltipla. Ela fornece uma forma de descobrir pontos que estão mais afastados do que os demais no espaço multidimensional. Distribuição Bidimensional: é a representação de uma variável bidimensional (xi , xj), com 1 £ i £ n e xi e xj duas variáveis unidimensionais. Distribuição de Frequências: o mesmo que Tabela de Frequências. 10 Epsilon (epsilon): Se for desejado corrigir o teste F univariado utiliza-se o "epsilon" de Huynh-Feldt ou de Greenhouse-Geisser. Lembrando que F é a razão entre os quadrados médios entre grupos e dentro dos grupos e que os graus de liberdade entre os grupos é "k - 1", enquanto que o dentro dos grupos é "n - k - 1". Para corrigir o valor de F, uma vez que se tenha percebido a falta de esfericidade, deve-se multiplicar o grau de liberdade entre os grupos pelo valor de epsilon. Para violações mais severas da esfericidade (epsilon < 0,75) o epsilon de Greenhouse-Geisser, mais conservador, deve ser utilizado. Erro de estimação: É a diferença entre o verdadeiro valor do parâmetro e o valor calculado a partir do dados de uma amostra. Este depende diretamente do grau de dispersão (variabilidade) da variável em estudo e inversamente ao tamanho da amostra. Erro do tipo I (alpha error): No teste de hipóteses consiste em rejeitar a hipótese nula quando ela é verdadeira. Erro do tipo II (beta error): No teste de hipóteses consiste em aceitar a hipótese nula quando ela é falsa. Erro quadrado médio (mean square error): É a soma dos quadrados dos desvios entre os valores do estimador (variável) e o parâmetro que ele se propõe a estimar. Erro Tipo-I: rejeitar a hiptótese nula quando esta é verdadeira. A probabilidade de cometer este erro é denotada por α e recebe o nome de nível de significância do teste. Erro Tipo-II: aceitar a hiptótese nula quando esta é falsa. A probabilidade de cometer este erro é denotada por β Esfericidade (sphericity): Propriedade de que a matriz das variâncias/covariâncias de um conjunto de dados multivariados é um múltiplo escalar da matriz identidade. Esfericidade: O teste de esfericidade checa se a matriz de correlação é igual a matriz identidade, ou seja, na diagonal formados por uns e zero fora da diagonal. ESS (Expert Statistical System): Sistema especialista estatístico. Estatística: é o método que ensina a recolher, classificar, apresentar e interpretar um conjunto de dados numéricos. Estatística (Statistics): A arte e a Ciência de coletar, analisar, apresentar e interpretar dados. 11 Estatística (statistics): Um número ou valor. Na teoria da estimação é utilizada também como sinômino de estimador, isto é, uma função dos elementos da amostra. Este termo foi introduzido por Sir Ronald A. Fisher em 1922. Estatística Descritiva: ramo da Estatística que tem por finalidade descrever certas propriedades relativas a um conjunto de dados. Estatística Descritiva (descritive statistics): Parte da Estatística que trata do resumo e da apresentação de conjuntos de dados. Estatística Indutiva: ramo da Estatística que procura inferir propriedades da população a partir de propriedades verificadas numa amostra da mesma. Estatística inferencial ou indutiva (inferential or indutive statistic): O processo de tirar conclusões sobre a natureza ou o modelo de populações a partir de amostras aleatórias retiradas destas populações. Estatística ou estimador: É uma função dos valores da amostra, ou seja uma variável aleatória, pois seu resultado depende dos elementos selecionados naquela amostra. São utilizados para estimar os parâmetros populacionais, para isto é preciso conhecer sua distribuição de probabilidades, que via de regra, pressupõe normalidade ou amostras grandes. Por exemplo: a média amostral, a proporção amostral, a variância amostral, etc. Estatística robusta (statistics): conjunto de técnicas utilizadas para atenuar o efeito de outliers e preservar a forma de uma distribuição tão aderente quanto possível aos dados empíricos Estatística teste (test statistic): É o valor amostral da estatística utilizada para testar um parâmetro no teste de hipóteses. Estatisticamente significante: dizer que um resultado é estatisticamente significante significa que as diferenças encontradas são grandes o suficiente para não serem atribuídas ao acaso. Uma diferença " estatisticamente significante" pode não ser " clinicamente importante"; a importância em termos biológicos não deve ser julgada pelos estatísticos, mas sim pelos profissionais da área em que a pesquisa está sendo feita. Estimação (estimation): Parte da inferência estatística que trata do processo de estimação e das propriedades dos estimadores. Estimador (estimator): A estística (fórmula ou expressão) utilizada para avaliar o valor de um parâmetro. Um estimador é uma variável 12 aleatória. Estimador de máxima verossimilhança (likehood stimator): usado para determinar valores dos livres parâmetros de um modelo estatístico. Não é sempre desejável usar estimadores de máxima verosimilhança, pois eles podem estar sujeitos a sobreajuste: para evitar isso, recomenda-se usar regularização, aonde se adiciona à função objetiva termos que penalizam grandes coeficientes, resultando em estimadores de máxima verosimilhança penalizada. O estimador MV da variância de uma distribuição Gaussiana é enviezado. Estimador de mínimos quadrados (least square stimator): uma técnica de otimização matemática que procura encontrar o melhor ajustamento para um conjunto de dados tentando minimizar a soma dos quadrados das diferenças entre o valor estimado e os dados observados (tais diferenças são chamadas resíduos). Estimativa (estimate): É o valor particular de um estimador, isto é, é o resultado de algum cálculo realizado sobre valores amostrais. Estimativa (ou Estimativa pontual): É o valor que a estatística ou estimador toma em uma amostra determinada. Estimativa por ponto (point estimate): O valor da estatística amostral que corresponde ao parâmetro populacional. Estudo caso-controle: comparação entre um grupo de doentes (casos) e um grupo de pessoas não doentes (controles). O objetivo é verificar se os casos diferem significativamente dos controles, em relação à exposição a um dado fator de risco. Estudo de coorte (cohort study): Um estudo longitudinal com o mesmo conjunto (o coorte) de pessoas ao longo de um determinado tempo. Estudo de coorte: comparação entre um grupo exposto a um fator de risco e outro grupo não exposto. Visa verificar se indivíduos expostos ao fator de risco desenvolvem a doença em questão, em maior ou menor proporção, do que um grupo de indivíduos não expostos. Eta quadrado (eta-square): É uma medida do efeito tamanho que é igual ao quociente entre a soma dos quadrados dos grupos entre pela soma dos quadrados somados para todos os efeitos principais, de interação e de erro (os efeitos das covariáveis não são computados). Esta medida pode ser interpretada como o percentual da variância da variável dependente que são explicadas pelos fatores. Quando existem relações curvilíneas entre a variável dependente e os fatores o Eta Quadrado será maior que o 13 correspondente coeficiente de correlação múltiplo ou R2. Fator (fator): Um fator é uma denominação alternativa, utilizada na análise de variância, para uma variável. Assim se num determinado experimento consiste em determinar o efeito da dosagem de um remédio, a "dosagem do remédio" é um fator. Se neste experimento for levado em conta não apenas a dosagem mas também o tempo em que o remédio será tomado, então "o tempo" será um segundo fator. Cada valor que o fator (variável) assume é denominado nível do fator. Assim se a dosagem testado for de: 100, 110, 115 e 120 mg, este fator terá quatro níveis. Um fator deve ter pelo menos dois níveis. Fenômenos Independentes: são fenómenos respeitantes à mesma variável que não têm qualquer ligação um com o outro. Frequência Absoluta (fi): é o número de vezes que o valor de determinada variável é observado. Frequência Absoluta Acumulada (Fi): é a soma das frequências absolutas anteriores com a frequência absoluta deste valor. Frequência absoluta acumulada de um valor da variável: é o somatório da sua frequência absoluta com todas as anteriores (as dos valores anteriores). Frequência absoluta de um valor da variável: é o número de vezes que esse valor aparece na lista de dados. Freqüência esperada (expected frequency): Número de vezes que um valor da variável deve se repetir se a hipótese nula for verdadeira ou ainda número de vezes que um valor da variável deve se repetir de acordo com um determinado modelo. Freqüência observada (observed frequency): Número de vezes que o valor de uma variável se repete. Frequência Relativa ( fri ): é o quociente entre a frequência absoluta do valor da variável e o número total de observações. Frequência Relativa Acumulada ( Fri ): é a soma das frequências 14 relativas anteriores com a frequência relativa desse valor. Frequência relativa acumulada de um valor da variável: é o somatório da sua frequência relativa com todas as anteriores (as dos valores anteriores). Frequência relativa de um valor da variável: é o quociente entre a sua freqüência absoluta e o número total de dados. Função Cumulativa: função que indica para cada valor real x a frequência absoluta (ou relativa) de observações com intensidade menor ou igual a x. A representação gráfica desta função é em forma de escada. Função de distribuição (cumulative distribuition function): A função de distribuição acumulada ou simplesmente função de distribuição de uma variável aleatória é definida em cada valor "x" real como sendo F(x) = P(X £ x). Gráfico Circular: representado por um círculo que está dividido em sectores cujas amplitudes são proporcionais à frequência que lhe corresponde. Gráfico de Barras: é constituído por barras, horizontais ou verticais, de comprimento proporcional à frequência. Graus de liberdade (degree of freedon): É a quantidade informações (variáveis) livres que serão utilizadas para o cálculo de uma estatística (fórmula). O número de valores independentes que serão utilizados na estimativa de um parâmetro. Em geral, o número de graus de liberdade de uma estimativa é igual ao número de valores utilizados no seu cálculo menos o número de parâmetros estimados no cálculo intermediário para a sua obtenção. Assim para calcular a média de uma amostra de tamanho "n", são necessários as "n" observações fazendo com que esta estatística tenha "n" graus de liberdade. Já a estimativa da variância através de uma amostra de tamanho "n" terá "n - 1" graus de liberdade, pois para a obtenção da variância amostral é necessário antes o cálculo da média amostral. Graus de liberdade: é um conceito ligado ao número de dados disponíveis (livres) para o cálculo da estatística. H1: As atitudes em relação à Matemática interferem na formação das atitudes em relação à Estatística. (rxy ¹ 0) Hipótese alternativa (alternative hipothesis): No teste de hipóteses é a hipótese que ser provar. É geralmente uma desigualdade. Hipótese alternativa (H1): As hipóteses de uma pesquisa devem 15 enunciar-se por propostas tão claras e específicas quanto possível, via de regra, é o que você quer mostrar, por exemplo: “as atitudes em relação a Matemática interferem diretamente na formação das atitudes em relação à Estatística” Hipótese alternativa: hipótese que será considerada como aceitável, caso a hiptótese nula seja rejeitada. Hipótese nula (Ho): A hipótese nula é a negação da hipótese alternativa, por isso, via de regra, você sempre torce para que ela seja rejeitada, como no caso seguinte: “as atitudes em relação a Matemática não interferem na formação das atitudes em relação à Estatística”. Está é a hipótese que esta sendo testada por qualquer teste estatístico. A se tomar uma decisão estatística, existem duas possibilidades de erro: o Erro de tipo I: rejeitar a hipótese nula (Ho), quando ela é verdadeira e, o Erro de tipo II: aceitar a hipótese nula (Ho), quando ela é falsa. Infelizmente, quando a probabilidade de cometer um diminui, a probabilidade de cometer o outro aumenta. Assim, os testes estatísticos foram delineados para controlar o erro de tipo I, chamado de nível de significância. Hipótese nula (null hipothesis): No teste de hipóteses é a hipótese que representa o que já se conhece e é formulada com o objetivo de ser rejeitada. Hipótese nula: hipótese que é colocada a prova em teste de hipótese. Em geral indica uma igualdade a ser contestada. Hipótese: Uma hipótese é um enunciado formal das relações esperadas entre pelo menos uma variável independente e uma variável dependente. Nas pesquisas exploratórias, as hipóteses podem se tornar questões de pesquisa. Estas questões pela sua especificidade, devem dar testemunho do trabalho conceitual efetuado pelo pesquisador e, pela sua clareza, permitir uma resposta interpretável. Histograma: é um gráfico de barras em que a área destas é proporcional à frequência, não havendo espaço entre as mesmas. Só se utiliza em variáveis quantitativas contínuas. Histograma (histogram): Gráfico de colunas justapostas (retângulos) onde a base é a amplitude da classe e a altura é a densidade ou a densidade relativa da classe. É utilizado, normalmente, para representar uma variável contínua. Ho: As atitudes em relação à Matemática não interferem na formação das atitudes em relação à Estatística (rxy = 0) 16 Homocedasticidade ou igualdade de variâncias: Este pressuposto exige que o nível de dispersão da variável dentro dos grupos seja similar. O SPSS automaticamente testa esta hipótese: Ho: s1 = s2 = s3 = s4, através do teste de Levene. Independência (independence): Em teoria de probabilidade, para dizer que dois eventos sejam independentes, significa intuitivamente que a ocorrência de um evento o faz nem mais nem mais menos o provável esse outro ocorre. Inferência Estatística (inferential statistics): A utilização de amostras de uma população com o objetivo de tomar decisões sobre a população. Interação (interaction): Em estatística, interação é um termo em a modelo estatístico adicionado quando o efeito de dois ou mais variáveis não for simplesmente aditivo. Tal termo reflete que o efeito de uma variável depende dos valores de um ou de mais outras variáveis. Intercepto (da reta de regressão: Y = a + b * X): É o valor de Y, quando X = 0. A maioria das vezes não faz sentido interpretar este valor. Intervalo de confiança (confidence interval): A estimativa de um parâmetro populacional através de um intervalo de valores ao invés de um único valor. Intervalo de confiança: É um intervalo centrado na estimava pontual, cuja probabilidade de conter o verdadeiro valor do parâmetro é igual ao nível de confiança.a: É a probabilidade de erro na estimação por intervalo. ISS (Intelligent inteligente. Statistical Software): Software estatístico Kruskall-Wallis (Kruskall-Wallis): Ver teste de Kruskall-Wallis. Lambda de Wilks (Wilks's lambda): É um teste multivariado para verificar diferenças de médias para os casos de múltiplas variáveis dependentes intervalares e múltiplos grupos (mais de dois) formados pelas variáveis independentes. O teste t, o T de Hotelling e o teste F são casos especiais deste teste. Logit (logit): Se U for uma variável definida no intervalo [0; 1], então a transformação que associa a cada valor "u", neste intervalo, um valor "v" no intervalo (-¥; +¥) é denominada de logit (ou logística) e definida por: v = logit(u) = ln[u/(1 - u)]. A transformação inversa é 17 executada por: logit-1(v) = ev/(1 + ev). Matriz de correlação: É uma matriz quadrada, simétrica, cuja diagonal é formada pela unidade, pois trata-se da correlação da variável com ela mesma, e em cada interseção linha (i) coluna (j) a correlação das variáveis Xi e Xj. Matriz de covariância: É uma matriz quadrada, simétrica, cuja diagonal contém a variância da variável e em cada interseção linha (i) coluna (j) a covariância das variáveis Xi e Xj. Máximo(maximum): É o maior valor de um conjunto de dados. Média amostral: (X, se lê X barra), é uma variável aleatória, função dos valores da amostra, é definida como a soma de todos os valores da amostra dividido pelo número de observações da amostra. Serve para estimar a média populacional. Média aritmética: é o valor que se obtém dividindo a soma dos valores pelo número de dados. Mediana: o valor que está no centro da sequência dos dados quando ela está ordenada de forma crescente ou decrescente. Quando o número de valores é impar, é só o valor central, e quando o número de valores é par, somam-se os dois valores centrais e dividem-se por dois (média aritmética). Medida de associação (Measure of association): Um valor que fornece uma idéia da força do relacionamento (e direção) entre duas ou mais variáveis. Medidas de Dispersão: é um conjunto de medidas (Amplitude, Variância e Desvio Padrão) utilizadas no estudo da variabilidade de uma determinada distribuição, permitindo obter uma informação mais completa acerca da "forma" da mesma. Medidas de Localização: é um conjunto de medidas (Média, Mediana, Moda e Quartis) que representam de uma forma global um conjunto de dados. Medidas de Tendência Central: o mesmo que Medidas de Localização. Medidas de tendência central: Moda, Mediana, Média Melhor estimador linear não-viciado (best linear unbiased estimator): Um estimador é dito estimador linear se ele é uma combinação linear das observações amostrais. É dito o melhor estimador linear não-viciado se de todas as combinações lineares da 18 amostra ele apresentar a menor variância. Moda ( m ): observação que ocorre com maior frequência numa amostra. Moda: é o valor mais freqüente da variável. Modelo ARIMA (AutoRegressive Integrated Moving Average): É um modelo utilizado em Séries Temporais e que pode representar o comportamento dinâmico que muitos conjuntos de dados apresentam. Modelo autoregressivo (autoregressive model). Modelo log-linear (log-linear model). Monitoramento: Observações contínuas, sem ter uma ação com base no resultado. Multicolinearidade: Este é um pressuposto importante na análise regressão múltipla, pois se uma variável independente for uma combinação linear de outras variáveis independentes, coloca em risco toda a análise. Não adianta tentar modelar uma variável em função de várias variáveis correlacionadas, essas não incrementam o poder explicativo do modelo. Neste caso, use o modelo de regressão stepwise, backward ou foreward. Nível de confiança (confidence level): É a probabilidade de que um intervalo de confiança contenha o valor do parâmetro que ele se propõe a estimar. Nível de significância (alfa): É definida como a probabilidade de cometer o erro de tipo I, ou seja, rejeitar a hipótese nula (Ho), quando ela é verdadeira. Por exemplo: Nível de significância (alpha level): É a probabilidade de se cometer erro do tipo I no teste de hipóteses, isto é, a probabilidade de se rejeitar a hipótese nula quando ela é verdadeira. Normal: Uma variável quantitativa segue uma distribuição normal, se sua distribuição de frequências tem o formato similar ao de um sino, ou seja a maioria dos valores se concentram em torno da média e, a medida que se afasta do centro as observações são cada vez mais raras. Essa distribuição é simétrica. Muitas variáveis têm essa distribuição, tais como altura das pessoas adultas do sexo masculino, coeficiente de inteligência, etc. Para examinar visualmente, você pode fazer o histograma com a curva ajustada, o SPSS faz isso. O teste que checa a normalidade de uma variável é o teste de Lilliefors, que se encontra no comando EXPLORE do SPSS. A hipótese nula é 19 que a variável segue uma distribuição normal, por isso você espera aceitar Ho, e espera que o p-valor seja maior do que o nível de significância especificado por você. Normalidade: dizer que há normalidade ou que os dados são normalmente distribuídos significa que eles seguem uma distribuição normal, isto é, valores concentrados simetricamente em torno da média e quanto maior a distância da média, menor a freqüência das observações. Número aleatório (random number): Número gerado num computador através de um algoritmo recursivo. Na realidade o correto seria dizer número pseudo aleatório uma vez que as seqüências geradas são reprodutíveis. Número de repetições: é o número de unidades experimentais que recebem o mesmo tratamento. Nuvem de Pontos: o mesmo que Diagrama de Dispersão. Odds ratio: chance de se observar casos expostos ao fator de risco sobre a chance de se observar controles expostos ao fator de risco. Se a exposição ao fator de risco for a mesma para casos e controles o odds ratio vale 1. Também é chamado de razão de chances (odds ratio). Organização dos Dados: consiste em "resumir" os dados através da sua contagem e agrupamento. Parâmetro: É uma medida usada para descrever, de forma resumida, uma característica da população, Por exemplo, a média populacional (m), a proporção populacional (p), a variância populacional (s), o coeficiente de correlação (r), etc. Os parâmetros, via de regra, são valores desconhecidos e desejamos estimar, ou testar, a partir dos dados de uma amostra. Pictogramas: são gráficos onde se utilizam figuras ou símbolos alusivos ao problema em estudo. Planificação do Problema: consiste na determinação de um processo para resolver o problema e, em especial, como obter informações sobra a variável em estudo. 20 Poder do teste (power of a statistical test): Denomina-se poder de um teste estatístico a probabilidade de aceitar a hipótese nula quando ela é verdadeira. A probabilidade de se cometer erro do tipo II, isto é, aceitar a hipótese nula quando ela é falsa é representada por b, então o poder do teste será 1 - b = P(Aceitar H0 /H0 é verdadeira), isto é o poder do teste é definido como a probabilidade de não se cometer erro do tipo II. Poder do teste: corresponde a 1-β Polígono de Frequências: são gráficos com aspecto de linhas quebradas. Constroem-se unindo por segmentos de recta os pontos médios das bases superiores dos rectângulos de um histograma. População: é um conjunto de seres com uma dada característica em comum e com interesse para o estudo. População (population): Conjunto de elementos de interesse com pelo menos uma característica em comum. População: Toda questão de pesquisa define um universo de objetos aos quais os resultados do estudo deverão ser aplicados. A população alvo, também, chamada população estudada, é composta de elementos distintos possuindo um certo número de características comuns (pelo menos uma). Essa característica comum deve delimitar inequivocamente quais os elementos que pertencem à população e quais os que não pertencem. Estes elementos, chamados de unidades populacionais, são as unidades de análise sobre as quais serão recolhidas informações. Precisão absoluta: é a precisão especificada diretamente e na mesma unidade da estimativa que se pretende calcular. Precisão relativa: é a precisão especificada não diretamente como precisão absoluta, mas sim proporcionalmente como porcentagem em relação ao verdadeiro valor. Pressuposto de independência: é chave para a maioria das estatísticas. Isto significa que o resultado de uma observação não interfere no resultado de outra observação. Por exemplo, a nota de um aluno não interfere na nota de um outro aluno. Já esse pressuposto é quebrado para amostras relacionadas como, por exemplo, passar uma prova antes de uma intervenção e a mesma prova (ou outra) depois da intervenção; essas duas medidas são correlacionadas, uma vez que os sujeitos são os mesmos. Neste caso, deve-se utilizar o teste para dados emparelhadas, ou ANOVA com medidas repetidas. Logo, cuidado com os estudos longitudinais, 21 em que se acompanha os mesmos sujeitos em vários momentos. Pressuposto de normalidade: é chave para toda a estatística paramétrica, por essa razão você sempre deve checar a validade do mesmo. Contudo, quando sua amostra for suficientemente grande (n > 30), dependendo do formato da distribuição, o Teorema Central do Limite garante a convergência da média amostral para a normalidade, veja a página 197 do livro de Estatística Básica de Moretin e Bussab. Probit (probit): Se U for uma variável definida no intervalo [0; 1], então a transformação que associa a cada valor "u", neste intervalo, um valor "v" no intervalo (-¥; +¥) é denominada de probit se v = F1 (u), onde F é Função de Distribuição da Normal Padrão. Proporção amostral: ( p se lê p barra), serve para estimar a proporção populacional. Proporção populacional (p): É um valor resultante do cociente entre o número de casos favoráveis e o número de casos possíveis na população. Por exemplo: proporção de eleitores que votarão no candidato XYZ nas próximas eleições. p-valor: É a probabilidade de cometer o erro de tipo I (rejeitar Ho quando ela é verdadeira), com os dados de uma amostra específica. Este valor é dado pelo pacote estatístico, assim o comparamos com o nível de significância escolhido e tomamos a decisão. Se o p-valor for menor que o nível de significância escolhido rejeitamos Ho, caso contrário, aceitamos Ho. P-value: corresponde ao menor nível de significância que pode ser assumido para rejeitar a hipótese nula. Dizemos que há significância estatística quando o p-value é menor que o nível de significância adotado. Por exemplo, quando p=0.0001 pode-se dizer que o resultado é bastante significativo, pois este valor é muito inferior aos níveis de significância usuais. Por outro lado, se p=0.048 pode haver dúvida pois, embora o valor seja inferior, ele está muito próximo ao nível usual de 5%. Quartil (quartil): Valores (são três) que dividem um conjunto de dados em quatro partes iguais. ( Q1 a Q3 ) Qui-quadrado (chi-square): teste qui-quadrado Razão de chances (odds ratio): É a chance a favor dividida pela chance contra, ou seja é o número de casos favoráveis dividido pelo número de casos não favoráveis. 22 Recenseamento: o mesmo que Censo. Recolha de Dados: é a primeira etapa depois de definido o problema em estudo. Reta de Regressão: é a recta traçada sobre uma dada Núvem de Pontos, sendo um modelo matemético que pretende descrever a relação existente entre duas variáveis unidimensionais de uma distribuição bidimensional. Redução de categorias (bracketing, collapsing or grouping): É a operação de combinar categorias ou intervalos de valores de uma variável para produzir um número menor de categorias. Região crítica ou de rejeição (critical region or region of rejection): A área sob a distribuição amostral que é determinada de acordo com o nível de significância do teste. Relações Estatísticas: são relações que se podem estabelecer entre determinadas variáveis de um problema em estudo. Risco relativo: proporção de pessoas expostas ao fator de risco que desenvolveram a doença sobre a proporção de pessoas não expostas que desenvolveram a doença. Vale 1 se as pessoas expostas e não expostas desenvolveram a doença na mesma proporção. Separador de Frequências: é um tipo de tabela que permite ter uma percepção imediata do aspecto global dos dados sem perda da informação contida na colecção dos dados inicial. Somatório ( å ): representa, de forma abreviada, uma soma. Sondagem: é o estudo estatístico que se baseia numa parte da população, isto é, numa amostra que deve ser representativa dessa população. Surveillance: Observações contínuas com um plano de ação com base nos resultados Survey: Observação com um objetivo/meta específica, semelhante a um estudo epidemiológico transversal. T quadrado de Hotteling (Hotelling's t-square): É um teste multivariado para verificar diferenças de médias para casos onde existam múltiplas variáveis dependentes intervalares e dois grupos formados por variáveis independentes categóricas. Para passar do traço de Hotelling ou traço de Lawley-Hotelling para o T quadrado deve-se multiplicar o traço por (n - l), onde "n" é o tamanho da amostra considerando todos os grupos e "l" é o número de 23 subgrupos. Tabela de Frequências: são tabelas onde se apresentam os dados por classes e as frequências respectivas. Tamanho da Amostra: é o número de elementos que constituem uma dada amostra. Teste bicaudal: teste cujo objetivo é testar apenas se as médias (ou proporções) são iguais ou diferentes e não estabelecer qual delas é maior ou menor. Teste bilateral (two-tailed test): Um teste é dito bilateral se a região crítica estiver dividida meio a meio entre valores superiores e inferiores. Teste da soma dos postos de Wilcoxon (Wilcoxon's rank sum test): Um nome alternativo para o teste de Mann-Whitney. Teste de esfericidade de Bartlett (Bartlett's sphericity test): Testa a hipótese nula de que a matriz das covariâncias das variáveis dependentes ortonormalizadas é proporcional a uma matriz identidade. Teste de esfericidade de Mauchly (Mauchly sphericity test): Testa a hipótese nula de que a matriz populacional de correlações é uma matriz identidade. Se o valor da estatística qui-quadrado obtido é significativo então a matriz de correlações a ser analisada é não aleatória. Neste caso é conveniente utilizar o teste de Humphrey e Ilgen. Teste dos sinais de Wilcoxon (Wilcoxon's signed rank test): Um teste não paramétrico ou de distribuição livre para testar a diferença entre duas populações utilizando amostras emparelhadas. O teste toma por base as diferenças absolutas dos pares de observações das duas amostras, ordenados de acordo com o seu valor onde cada posto (diferença) recebe o sinal da diferença original. A estatística teste é a soma dos postos positivos. Teste exato de Fisher (Fisher's exact test): Um teste de independência entre duas variáveis categóricas dicotômicas. Foi introduzido por Sir Ronald A. Fisher em 1935. O teste envolve o uso da distribuição hipergeométrica para calcular a probabilidade de uma determinada combinação de totais parciais (somas de linhas ou colunas) sob a hipótese nula de independência. Teste monocaudal: teste cuja hipótese alternativa é uma desigualdade, ou seja, deseja-se testar se o valor observado é maior 24 ou menor ao valor crítico correspondente à hipótese nula. Teste não paramétrico (nonparametric test): Um teste não paramétrico testa associações, dependência/independência e modelos ao invés de parâmetros. Teste Q de Cochran (Cochran's Q test). Teste qui-quadrado (chi square test). Teste t - de Student (t test or Student t test): Teste paramétrico que utiliza duas amostras independentes. Testa a diferença entre duas médias populacionais quando os desvios padrões populacionais são desconhecidos (o que ocorre na grande maioria dos casos). Teste t: teste estatístico cujo objetivo é testar a igualdade entre duas médias. O teste supõe independência e normalidade das observações. As variâncias dos dois grupos podem ser iguais ou diferentes, havendo alternativas de teste para as duas situações. Neste serviço, consideramos apenas o caso em que as variâncias são iguais. Teste U de Mann-Whitney (Mann-Whitney U test). Teste unilateral (one-tailed test): Um teste é dito unilateral quando a região crítica ou região de rejeição está situada à direita Teste Z: teste estatístico cujo objetivo é testar a igualdade entre uma média conhecida (numa população ) e uma média calculada pelo pesquisador (numa amostra). O teste supõe normalidade das observações. Unidade Amostral: a menor divisão do material que se mede em separado Unidade Estatística ou Indivíduo: é cada um dos elementos da população. Unidade Experimental: a menor divisão do material experimental que poderia receber qualquer tratamento. Validade externa: refere-se à inferência estatística, ou seja, a generalização dos resultados para toda a população de interesse. Validade interna: é a validação dos resultados apenas para a amostra considerada, ou seja, é a validade das inferências para os indivíduos que participaram do estudo. Os cálculos de tamanho de amostra feitos aqui são baseados principalmente nas técnicas estatísticas a serem utilizadas. Entretanto, é importante ressaltar que, o fato do 25 número de observações ser suficiente não garante a utilização da técnica estatística. Em geral, existem algumas suposições que devem ser satisfeitas como por exemplo, a normalidade das observações em testes de comparação de médias. Valor crítico (critical value): Valor da distribuição amostral que separa a região de região da de não rejeição. Variância ( σ2 ): é a medida que permite avaliar o grau de dispersão dos valores da variável em relação à média. Variância (variance): É a média do quadrado das distâncias euclidianos que cada ponto do conjunto está da média aritmética. Variância amostral (s2): Serve para estimar a variância populacional. Variância populacional (s2): É um valor que mede o grau de dispersão dos valores da variável, na população, em relação à média populacional. Definida como a soma dos quadrados dos desvios dos valores da variável em relação a sua média, divido pelo número de observações: Soma[(Xi – média)2]/N Variância relativa (relative variance): É o quociente entre a variância e o quadrado da média. Variáveis Contínuas: são as variáveis que podem tomar qualquer valor de um determinado intervalo. Variáveis Discretas: são as variáveis que podem tomar um número finito ou uma infinidade numerável de valores. Variáveis Qualitativas: o mesmo que Atributos Qualitativos. Variáveis Quantitativas: o mesmo que Atributos Quantitativos. Variável (variable): Uma característica comum a todos os dados. Variável aleatória: É uma variável cujo valor numérico atual é determinado por probabilidades. Por exemplo, X: pontuação na escala de atitudes em relação à Estatística, Y: número de disciplinas reprovadas em Estatística, etc. Observe que o resultado depende do aluno selecionado. A variável aleatória tem uma distribuição de probabilidades associada, o que nos permite calcular a probabilidade de ocorrência de certos valores. Variável contínua: variável cujos possíveis valores formam um intervalo de números reais e que resultam, normalmente, de uma mensuração, como por exemplo peso, altura e pressão arterial. Variável dependente (VD): Mede o fenômeno que se estuda e que se 26 quer explicar. São aquelas cujos efeitos são esperados de acordo com as causas. Elas se situam, habitualmente, no fim do processo causal e são sempre definidas na hipótese ou na questão de pesquisa. No nosso exemplo: desempenho em estatística e atitudes em relação à Estatística. Variável dicotômica: variável em que só existem duas respostas possíveis, como por exemplo sim/não, doente/não doente. Variável discreta: variável quantitativa cujos possíveis valores formam um conjunto finito ou enumerável de números e que geralmente resultam de uma contagem, como por exemplo o número de filhos. Variável independente (VI): São aquelas variáveis candidatas a explicar a(s) variável(eis) dependente(s), cujos efeitos queremos medir. Aqui devemos ter cuidado, pois mesmo encontrando relação entre as variáveis isto, não necessariamente, significa relação causal. Variável qualitativa (ou categórica) nominal: São aquelas cujas respostas podem ser encaixadas em categorias, sendo que cada categoria é independente, sem nenhuma relação com as outras: sexo (masculino, feminino), raça (branco, preto, outro), etc. Variável qualitativa (ou categórica) ordinal: São aquelas cujas categorias mantém uma relação de ordem com as outras, que podem ser regulares ou não (existe uma ordem natural nas categorias): classe social (alta, média, baixa), auto-percepção de desempenho em Matemática (péssimo, ruim, regular, bom , ótimo), etc. A rigor, no tratamento estatístico das variáveis categóricas, não existe diferença se ela for nominal ou ordinal, a única observação é que quando você está lidando com uma variável ordinal, é aconselhável manter a ordem natural das categorias, de menor para maior, na hora da apresentação, seja em tabela ou em gráficos. Variável quantitativa contínua: Resultados de mensurações, podem tomar infinitos valores: pontuação na escala de atitude, nota na prova de matemática, pontuação no vestibular, etc. Variável quantitativa discreta: São aquelas resultantes de contagens, constituem um conjunto finito de valores: número de filhos, número de reprovações em matemática, idade em anos completos, etc. Variável: é uma característica da população. Toda questão de pesquisa define um número de construções teóricas que o pesquisador quer associar. O grau de operacionalização destas construções não faz parte de um consenso. Por essa razão, a seção 27 que trata das definições das variáveis deve permitir ao leitor avaliar a adequação dos instrumentos utilizados, as variáveis escolhidas e as construções teóricas descritas no quadro conceitual. Vício (bias): Conceito referente a uma estatística ou estimador. Um estimador é dito sem vício (não-viciado), não- tendencioso ou imparcial se a média de sua distribuição amostral coincide com o parâmetro a ser estimado. Wavelet (Wavelet): É uma função matemática útil para processamento de sinais e compressão de imagens, embora seu uso com estes propósitos seja recente a teoria não é nova. Os princípios são semelhantes ao da Análise de Fourier. Na WWW wavelets tem sido utilizadas para a compressão de imagens com mais sucesso do que o método familiar JPEG. Referencias: http://www.pucrs.br/famat/statweb/glossarios/gloesta/ge_yz.htm http://www2.esec-miguel-torga.rcts.pt/Projectos/estatistica.pdf http://www.educ.fc.ul.pt/icm/icm2003/icm24/dicionario.htm http://www.unibero.edu.br/glossarios_def.asp http://www.socio-estatistica.com.br/Edestatistica/glossario.htm 28

Download