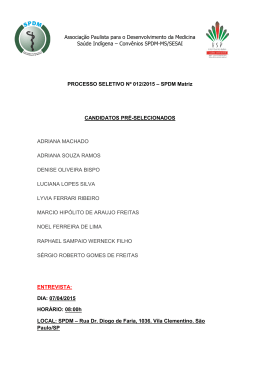

Freitas & Janissek – Análise léxica e Análise de conteúdo – p.1 ANÁLISE LÉXICA E ANÁLISE DE CONTEÚDO: Técnicas complementares, sequenciais e recorrentes para exploração de dados qualitativos Freitas & Janissek – Análise léxica e Análise de conteúdo – p.2 Sphinx ® – sistemas para pesquisas e análises de dados Sphinx Consultoria - Distribuidor EXCLUSIVO do Sphinx Único certificado e autorizado SPHINX na América Latina tel/fax: 0xx51-4773610 e-mail: [email protected] http://www.sphinxbr.com.br Freitas & Janissek – Análise léxica e Análise de conteúdo – p.3 ANÁLISE LÉXICA E ANÁLISE DE CONTEÚDO: Técnicas complementares, sequenciais e recorrentes para exploração de dados qualitativos Henrique Freitas & Raquel Janissek 2000 Distribuição: Sphinx ® Freitas & Janissek – Análise léxica e Análise de conteúdo – p.4 Supervisão gráfica: terceirizada Capa: Fernando K. Andriotti, Maurício G. Testa e André Panisson Edição: Fernando K. Andriotti Impressão: Gráfica La Salle. Dados internacionais de Catalogação na Publicação (CIP) (Câmara Brasileira do Livro, SP, Brasil) FREITAS, Henrique Mello Rodrigues de. Análise léxica e análise de conteúdo: técnicas complementares, sequenciais e recorrentes para exploração de dados qualitativos / Henrique Mello Rodrigues de Freitas e Raquel Janissek. Porto Alegre: Sphinx: Editora Sagra Luzzatto, 2000. 176 p.: il. Bibliografia: 85-241-0637-9 1. Metodologia da Pesquisa. 2. Técnicas de pesquisa. 3. Análise de Dados: pesquisa. I. Janissek, Raquel . II. Título Índice para catálogo sistemático: 1. Pesquisa e métodos – 001.4 2. Ciências sociais – 306.3 3. Análise de dados – 001.642 © Henrique Freitas & Raquel Janissek Todos os direitos estão reservados à Sphinx ® Impresso em Junho 2000. Também disponível via Internet (http://www.sphinxbr.com.br e http://www.adm.ufrgs.br/professores/hfreitas). Freitas & Janissek – Análise léxica e Análise de conteúdo – p.5 Agradecimentos Esta iniciativa teve origem na discussão entre professores da Escola de Administração sobre o que deveria ou não ser feito como análise de dados em um determinado estudo. O resultado, demonstrado neste documento, expressa nossa convicção na resposta que deveria ser aportada. A eles, pela provocação, nosso agradecimento especial! Esta realização só foi possível com o apoio da Sphinx Consultoria-Canoas RS, bem como da Escola de Administração da UFRGS e do Gesid-PPGA/EA/UFRGS. Em especial, nossa equipe de suporte (Fernando Kuhn Andriotti e outros bolsistas). Ao doutorando Jorge Audy (PPGA/EA/UFRGS), agradecemos a leitura e crítica da versão preliminar, bem como o prefácio do ponto de vista de quem necessita recorrer a este tipo de conhecimento aqui elaborado. Agradecemos em especial aos parceiros franceses de concepção e desenvolvimento de sistemas para análises de dados quanti-qualitativos, professores Jean Moscarola (Annecy) e Yves Baulac (Grenoble), pelas discussões intelectuais e pela motivação, sobretudo pela parceria promissora e sua amizade. Nossas famílias certamente são nossas fontes de energia, e merecem nosso agradecimento especial. Henrique Freitas & Raquel Janissek Freitas & Janissek – Análise léxica e Análise de conteúdo – p.6 Sumário Apresentação .............................................................................................................. 8 Prefácio dos Autores ................................................................................................... 9 Dados dos Autores .................................................................................................... 11 Prefácio ..................................................................................................................... 12 1. Explorando dados textuais para identificar oportunidades e antecipar problemas 13 2. Dados qualitativos: problemas e questões inerentes à sua coleta e análise .......... 16 3. Análise quali ou quantitativa de dados textuais? .................................................. 22 3.1. A Análise Léxica .......................................................................................... 32 3.2. A Análise de Conteúdo ................................................................................. 38 4. Aplicações de análise qualitativa em gestão e em sistemas de informação .......... 64 5. Ferramentas para Análises Léxica e de Conteúdo ................................................ 70 6. Aplicação de análise de dados qualitativos: pesquisa sobre internet e negócios . 78 6.1. As questões abertas da pesquisa.................................................................... 80 6.2. Como analisar os dados qualitativos? ........................................................... 84 6.3. Análise léxica dos dados abertos da pesquisa: palavras e expressões .......... 88 6.4. Análise de Conteúdo das questões abertas .................................................. 109 6.5. Aprofundando a análise de dados através da Análise de Correspondência . 134 7. Considerações Finais .......................................................................................... 140 8. Referências bibliográficas .................................................................................. 144 Índice Remissivo .................................................................................................... 149 Índice de Autores .................................................................................................... 155 Apêndice - Sistema Sphinx® para pesquisas e análises de dados ........................... 157 Freitas & Janissek – Análise léxica e Análise de conteúdo – p.7 Apresentação O diferencial proporcionado pelos métodos, bem como a isenção conferida pelo pesquisador que respeita estes métodos, retratam as diferenças das competências e das intenções em uma pesquisa. Todo profissional deve desenvolver habilidades e dominar sistemas, técnicas e métodos inerentes à necessidade por construção de conhecimento a partir de dados disponíveis de uma ou outra forma dentro do seu contexto de atuação. Mostra-se que é viável, com o auxílio de instrumental adequado, explorar dados quanti-qualitativos e produzir informações consistentes que possam trazer respostas ágeis a muitos questionamentos que surgem no dia-a-dia de uma organização e mesmo no trabalho do profissional de pesquisa. Com o uso de dados qualitativos, seja de que natureza for, pode-se ter a chance de identificar oportunidades ou antecipar problemas de forma bem mais pontual, precisa e com um custo operacional bem menor. Existem várias técnicas de coleta e de análise de dados que permitem capturar automática e quase gratuitamente dados qualitativos. Além disso, esse tipo de dado pode ser explorado mais de uma vez, constituindo-se numa fonte diferenciada para a geração de novos, diferentes e curiosos dados, os quais podem ser produzidos diretamente pelo pesquisador. Este livro demonstra algumas técnicas para realizar análise de dados textuais, em especial as análises léxica e de conteúdo, buscando repassar ao leitor condições para uma investigação prática e eficaz. Estas técnicas são apresentadas enfatizando o seu uso em conjunto. O pesquisador ou analista tem, nelas, diferentes recursos que permitem a exploração adequada dos dados, através de procedimentos sistematizados. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.8 Prefácio dos Autores Este livro propõe uma abordagem para a condução de análises de dados qualitativos. Nosso propósito é descrever caminhos para o uso conjunto de diferentes técnicas de análises de dados. Em particular, são apresentadas as idéias de complementaridade, recorrência e sequencialidade do uso das análises léxica e de conteúdo, abordando diferentes aspectos metodológicos para a exploração mais criteriosa da análise de dados qualitativos. Esta iniciativa nasceu de nossa compreensão de que diversos pesquisadores pensam, de forma equivocada, que a escolha deve recair sobre uma ou outra técnica. Ora, a riqueza de análise só pode ser atingida com a variação e a aplicação conjunta de diferentes técnicas! Mostra-se em detalhe a utilização de métodos e técnicas para o desenvolvimento de análises de dados qualitativos, bem como são desenvolvidos exemplos - passo a passo - de como realizar tais análises. Para tal, utiliza-se uma pesquisa essencialmente qualitativa (com entrevistas em profundidade) para demonstrar a forma de implementar as idéias aqui propostas. Ao mesmo tempo, uma revisão da literatura pertinente, nacional e internacional, é apresentada, assim como são evocados exemplos de aplicações deste tipo de análise na área de gestão e sistemas de informação. Além disso, algumas ferramentas que podem ser utilizadas para este tipo de análise são ilustradas, em especial o sistema Sphinx Léxica ®. Nosso intuito é, sobretudo, fornecer aos gerentes, pesquisadores, professores e alunos de diversos níveis de formação, recursos que permitam a exploração adequada de dados qualitativos, Freitas & Janissek – Análise léxica e Análise de conteúdo – p.9 através de procedimentos sistematizados que assegurem a qualidade e mesmo originalidade das descobertas. Enfim, quando as pessoas e as organizações começam a prestar atenção nos telefonemas que recebem, nas sugestões e reclamações da clientela ou de fornecedores, e quando a academia começa a valorizar bem mais as questões subjetivas em harmonia com aquelas em demasia objetivas, temos firme convicção da potencial contribuição deste trabalho. A todos, bom proveito! Henrique Freitas & Raquel Janissek Freitas & Janissek – Análise léxica e Análise de conteúdo – p.10 Dados dos Autores Henrique Freitas é Professor Adjunto da Escola de Administração da UFRGS (desde 1994), onde integra a equipe do GesidPPGA/EA/UFRGS (Grupo de Estudos em Sistemas de Informação e apoio à Decisão do Programa de Pós-Graduação em Administração). É, desde 1993, Pesquisador 2A CNPq, onde já coordenou e realizou diversos projetos. Cursou Economia na UFRGS (1982), Especialização em Análise de sistemas na PUCRS (1983), Mestrado em Administração na UFRGS (1989), Doutorado em gestão na Université de Grenoble 2 – França (1993) e Pósdoutoramento em sistemas de informação na University of Baltimore (MD, EUA, 1997-98). Já orientou 4 teses de doutorado e 17 dissertações de mestrado e orienta, atualmente, 2 doutorandos e 12 mestrandos. Publicou 3 livros e dezenas de artigos nacionais e internacionais, é coordenador nacional da área de Administração da informação da ANPAD e integra o comitê editorial do Journal of AIS. Desde 1989, em parceria com Jean Moscarola e Yves Baulac, coopera na melhoria dos Sistemas Sphinx. e-mail: [email protected] http://www.adm.ufrgs.br/professores/hfreitas Raquel Janissek é Analista de Sistemas. Cursou Informática na UNIJUI (1995) e Mestrado em Administração: Sistemas de Informação – Gesid-PPGA/EA/UFRGS (2000). A partir de setembro de 2000, dando continuidade ao trabalho de cooperação do Prof. Henrique Freitas com a equipe do Prof. Humbert Lesca, inicia seu Doutorado em Sistemas de Informação na Université Pierre Mendes France - Grenoble 2 (França). De 1996 a 1999, foi professora de Análise de Sistemas e Informática na Universidade Regional Integrada (URI), onde coordenou o Estágio Supervisionado do Curso Técnico em Informática e orientou trabalhos de conclusão de cursos. A partir de 2000, integra a equipe de suporte eletrônico dos usuários Sphinx, bem como coopera no desenvolvimento dos produtos e sistemas. e-mail: [email protected] http://www.missoes.com.br/raquel Freitas & Janissek – Análise léxica e Análise de conteúdo – p.11 Prefácio O uso de métodos qualitativos em pesquisa na área de SI tem crescido nos últimos anos. Esta abordagem aprofunda-se no mundo dos significados das ações e relações humanas, um dado pouco perceptível ou captável pelos métodos quantitativos. O grande desafio para os pesquisadores da área está pois relacionado com a análise de dados em uma pesquisa cada vez com base mais qualitativa. Este livro, oferecido pelos professores Henrique e Raquel, é uma significativa contribuição na busca de uma resposta para este desafio, avaliando algumas das principais abordagens de análise de dados e propondo uma sistematização clara e operacional para a exploração de dados qualitativos, em especial na área de SI. Contudo, pela escassez de literatura em língua portuguesa, e mesmo pela qualidade e clareza do material produzido, este é um documento certamente útil para todos pesquisadores das diferentes áreas de Administração, e mesmo das Ciências Sociais. Particularmente, como pesquisador envolvido na realização de uma tese de doutorado, na qual devia explorar dados coletados em diversas entrevistas em profundidade, a literatura e os exemplos aqui resgatados e relatados em detalhe me foram de grande valia. Jorge Audy Doutorando Gesid/PPGA/EA/UFRGS Professor Informática/PUCRS Freitas & Janissek – Análise léxica e Análise de conteúdo – p.12 1. Explorando dados textuais para identificar oportunidades e antecipar problemas A realização de pesquisas acadêmicas ou profissionais tem cada vez mais desafiado os analistas e pesquisadores visto que a objetividade dos dados coletados em uma pesquisa não é mais condição suficiente para a compreensão de um fenômeno (como por exemplo a opinião de um certo público, satisfação do cliente, resistência dos usuários finais de uma tecnologia recentemente adotada). De fato, a subjetividade é que vai permitir explicar ou compreender as verdadeiras razões do comportamento ou preferência de um certo grupo por algum produto, sistema, serviço, etc. A questão inerente é a de como o pesquisador, o analista, ou mesmo o gerente ou executivo poderia realizar tal tipo de análise ou exploração de dados. Ora, qual seria o gerente que não gostaria de – rapidamente – percorrer todos os dados captados através de uma linha 0800, como a do serviço de suporte, a de help desk ou outro, e se dar conta das principais reclamações ou sugestões atuais dos seus clientes? Não seria este tipo de dado, que fica esquecido, engavetado ou nem mesmo pensado como um recurso, uma fonte nobre de dados gerados sem nenhum custo adicional para a organização? Da mesma forma, como poderia este mesmo gerente ousar pensar nisso se ele nem imagina que existam métodos e técnicas para tal? Ele pode muito bem imaginar uma pesquisa onde os clientes dizem se estão ou não satisfeitos com os serviços prestados numa escala de totalmente satisfeitos a totalmente insatisfeitos, mas não se dá conta talvez que poderia saber disso sem mesmo ter que indagar aos clientes. De fato, a técnica quantitativa e supostamente bem dominada aporta um tipo de resposta que é em diversos casos Freitas & Janissek – Análise léxica e Análise de conteúdo – p.13 superficial no sentido que não permite uma qualificação ou um refinamento da opinião. No final, isto pode mesmo ser mais oneroso, pois quando os procedimentos de pesquisa são estabelecidos de maneira formal, há um viés natural na resposta oferecida pelas pessoas ou clientes, e o que se tem de volta são quantidades. Ao passo que, usando dados qualitativos, opiniões mais abertas, espontâneas ou mesmo – e porque não principalmente – aquelas coletadas de forma indireta (como a do setor de pós-venda ou de atendimento ao cliente), pode-se ter a chance de identificar oportunidades ou antecipar problemas de forma bem mais pontual, precisa e com um custo operacional bem menor, ainda por cima a partir da exploração de um dado completamente espontâneo, não induzido de forma alguma. Não são só as técnicas de coleta e de análise quantitativa de dados que foram aperfeiçoadas com o tempo. Hoje em dia, são factíveis e diversas as formas e tecnologias de se capturar automática e praticamente gratuitamente dados qualitativos (subjetivos, textos enfim) que nos denotem as preferências e comportamentos de um certo grupo de pessoas. Os procedimentos, métodos e ferramentas que possibilitam isso são cada vez mais presentes na literatura e no mercado. Há todo um leque de possibilidades que pode ser utilizado (WEITZMAN e MILES, 1995; FREITAS, MOSCAROLA e CUNHA, 1997 e MOSCAROLA, 1990). O que existe, contudo, é uma confusão conceitual ou mesmo prática sobre em que consistem e mesmo de como essas técnicas e ferramentas poderiam ser utilizadas. Em que implica cada uma delas? Como se poderia aplicar e explorar em benefício próprio cada uma delas? Enfim, há mesmo uma ignorância sobre a existência da análise léxica e da análise de conteúdo1, sobre as distintas finalidades de uma e outra. Há ainda uma idéia equivocada de que se deve escolher uma 1 WEBER (1990, p.9) define Análise de Conteúdo como um método de pesquisa que utiliza um conjunto de procedimentos para tornar válidas inferências a partir de um texto. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.14 OU outra para uma dada análise ou exploração de dados, quando na verdade os autores procuram neste livro demonstrar que pesquisadores acadêmicos ou analistas em geral DEVEM ter uma clara visão das vantagens em explorar estes recursos de análise de forma sequencial, recorrente e sobretudo complementar. Na sequência, faz-se uma discussão sobre o valor e importância da coleta e análise de dados qualitativos (seção 2). Logo após, na seção 3, apresentam-se definições conceituais de análise léxica e de análise de conteúdo. A seção 4 evoca exemplos da literatura e de pesquisas realizadas recorrendo a estas técnicas, e a seção 5 levanta e indica ferramentas disponíveis para tal. Em função do foco deste livro, a seção 6 detalha uma pesquisa essencialmente qualitativa, explorando as duas técnicas em questão na análise de dados coletados em entrevistas estruturadas (com guia de entrevista), buscando-se ser didático e ilustrar passo a passo a sua aplicação. Finalmente, na seção 7, faz-se uma reflexão final sobre o uso potencial destas análises no dia-a-dia das organizações, bem como no contexto de pesquisa acadêmica. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.15 2. Dados qualitativos: problemas e questões inerentes à sua coleta e análise Não obstante as colocações recém realizadas, tentando olhar de forma mais precisa um processo de pesquisa qualquer, vai-se notar que dificilmente ele deixa de recorrer a mais de uma técnica de coleta de dados, bem como mais de uma fonte, fazendo inclusive recurso a diferentes técnicas de análise de dados. É pois tempo de método múltiplo de pesquisa, onde o pesquisador ou o analista comercial, financeiro, etc, tem cada vez mais e mais clara a necessidade de estar em contato com diferentes visões das situações reais. E isto utilizando-se de fontes de dados e de técnicas diversas, levando em consideração o rigor das pesquisas. Isto só reforça o valor, utilidade e oportunidade de se abordar de forma mais organizada e mesmo didática as técnicas e ferramentas no que se refere a dados qualitativos. Cada vez mais forte é a tendência de que uma pesquisa quantitativa, mais objetiva, deve ser precedida de uma atividade mais subjetiva, qualitativa, que permita melhor definir o escopo e a forma de focar o estudo. Também tem sido consenso que, mesmo sendo objetiva em sua essência, sempre se pode recorrer a algum tipo de opinião mais espontânea ou aberta, de forma a captar ‘um algo mais’ da parte do respondente. Tudo isto valoriza a questão de como se tratar questões ditas qualitativas. Tais debates foram objetos de recente congresso internacional (LEE, LIEBENAU e DEGROSS, 1997). A estratégia de uso de questões abertas ou fechadas num instrumento é debatida por LEBART e SALEM (1994, p.25-28). Além disso, nas pesquisas, de forma geral, uma etapa pouco valorizada ou um tanto negligenciada é a de preparação de dados: há todo um esforço para que os dados sejam coletados, de forma que não Freitas & Janissek – Análise léxica e Análise de conteúdo – p.16 se dispõe de muito tempo quando os dados poderiam e deveriam ser analisados a fundo, em termos de significado e implicações. Ocorre que, antes de analisar os dados e cruzá-los das mais diferentes formas na busca por relações causais ou possíveis explicações para hipóteses previamente formuladas, é necessário que sejam preparados certos tipos de dados. Exemplos disso podem ser dados objetivos e numéricos como a idade e o salário, na busca por faixas etárias e salariais adequadas para os cruzamentos posteriores a serem realizados (pode-se gerar novos dados escalares a partir dos numéricos). Da mesma forma, é necessário um investimento (mais de tempo de análise do que outro recurso) para que sejam criadas categorias pertinentes e claras a partir de dados tipo texto, ou seja, efetivamente qualitativos. Um exemplo pode ser a criação de um dado novo a partir de uma questão texto que poderia ser “quais as sugestões que você apresentaria para a melhoria dos nossos serviços?” ou então mesmo “quais as principais reclamações que você poderia apresentar?”. Normalmente, pesquisadores e analistas desavisados ou talvez despreparados ou inadvertidos sobrecarregam suas pesquisas com questões abertas, criando uma expectativa em quem responde, a qual se torna ‘falsa expectativa’, visto que tais respostas nunca serão tabuladas e avaliadas como se deveria. Logo, o aprendizado que tal conteúdo permitiria não será jamais produzido. Cuidado especial é necessário no sentido de não se abusar de questões abertas num instrumento de pesquisa, pois seu excesso exige que o respondente se concentre bem mais que o normal: ele poderá pois ficar gradativamente desatento nas suas respostas e mesmo se desinteressar pelas questões posteriores. Cria-se pois uma falsa de idéia de que um dado espontâneo como esse dos exemplos recém evocados deve ser analisado uma só vez, quando ele poderia ser uma fonte bastante grande e diferenciada Freitas & Janissek – Análise léxica e Análise de conteúdo – p.17 para a geração de novos, diferentes e curiosos dados. Esta geração de novos dados a partir de um dado texto pode emergir do próprio texto de cada respondente, como uma lista mais objetiva de sugestões ou de reclamações (no caso dos dois exemplos citados). Mas tal fonte de dados também pode ser objeto de um julgamento a partir de critérios a priori adotados pelo gerente, analista ou pesquisador, como por exemplo gerar um indicador de satisfação a partir da simples leitura das sugestões ou das reclamações emitidas pelo respondente. Ou seja, ao invés de perguntar se o cliente está muito ou pouco satisfeito, o avaliador poderia ler cada uma das respostas emitidas e registradas e iria ele próprio julgar se o respondente está ou não satisfeito. Isto é claro de forma subjetiva, contudo, muitas vezes este dado poderá ser melhor considerado para fins de análise. Ou seja, a um dado aberto e espontâneo, devem corresponder n dados objetivos, gerados seja pela análise e identificação gradativa de um protocolo (como a lista de sugestões que se faz emergir do texto), seja pela avaliação da opinião de cada pessoa em relação a um protocolo ou mesmo escala de medida preparada pelo analista (como por exemplo ‘satisfeito’ ou ‘insatisfeito’). Além disso, um ponto importante diz respeito à definição de quem deveria realizar as análises (e quem finalmente as realiza!): normalmente, solicita-se a um terceiro (aluno, auxiliar, etc) para realizar esta única codificação, quando ela poderia ser rica em aprendizado caso feita pessoalmente pelo analista ou pesquisador. Esta atividade exige a leitura de cada uma das respostas, gerando, neste processo, novas idéias de análise e uma riqueza de compreensão e percepção sem iguais para o analista responsável. Este seria um motivo forte para que se repense cada decisão ou solicitação de codificação a terceiros: a pessoa está implicada no processo? Conhece o métier ou contexto pesquisado? Tem engajamento ou responsabilidade em relação ao objeto pesquisado? Sobretudo, tem Freitas & Janissek – Análise léxica e Análise de conteúdo – p.18 como associar a sua tarefa isolada de codificação a todo resto do processo e atividades desse projeto? Terá a iniciativa de sugerir novas dimensões de análise identificadas no decorrer da própria atividade de codificação? Talvez seja melhor arrumar uma resposta adequada a estas questões ou então de fato decidir que o pesquisador se responsabilizará pela realização da tarefa ou pela supervisão estreita desse processo. Normalmente, uma codificação derivada de uma análise vai gerar um novo dado de múltipla escolha (das diversas categorias criadas, algumas serão marcadas para cada resposta emitida por cada respondente). Este novo dado retratará de forma bem mais objetiva o conteúdo de cada opinião ou resposta. A construção das opções ou categorias desse novo dado gerado deve ser realizada segundo certas regras, de forma a se poder ter confiança na sua coerência, consistência, força enfim. Entretanto, muito da prática empresarial que se tem podido observar (em contato com institutos de pesquisa por ocasião de assessorias de tecnologia ou método) mostra que pessoas não tão bem preparadas realizam tal função. Ocorre que tal novo dado vai ser certamente a base para decisões estratégicas ou operacionais importantes para a organização envolvida. Logo, é de extrema importância a adequada e mesmo rigorosa formulação destas categorias. De fato, cada categoria pode implicar em n ações empresariais, que exigirão alocação de recursos, etc., ou seja, as implicações das corretas definições de categorias podem ser enormes para a organização. Caso as categorias não sejam pertinentes, todas análises, decisões e ações estarão igualmente comprometidas. Não é esta uma atividade para ser realizada com adivinhações ou amadorismos de qualquer sorte. Conceitos, técnicas, métodos e ferramentas são em muito necessários. É então fundamental que se desenvolva um conjunto de diretrizes ou procedimentos que possam ser seguidos: tal é o objetivo deste livro, com o exemplo desenvolvido Freitas & Janissek – Análise léxica e Análise de conteúdo – p.19 na seção 6 e com os conceitos e ferramentas abordados na seção 3 e 5, respectivamente. A preparação e análise de dados provenientes de pesquisas ou captura de dados, sejam eles qualitativos ou quantitativos, passa então pela identificação e categorização adequada dos seus conteúdos, na busca pela produção de conhecimentos e identificação de relações que nos permitam avançar na compreensão dos fenômenos investigados. Esta busca por informações consistentes, relevantes e fidedignas requer tempo e dedicação por parte do analista ou pesquisador, no intuito de gerar resultados que traduzam a realidade ou contexto estudado. Entretanto, não raro estas análises levantam dúvidas quanto à efetividade dos termos e resultados obtidos, especificamente pela não sistematização da sequência de análise dos dados ou por outros motivos, como a inadequação do próprio perfil ou preparação de quem analisa, como recém evocado. Ainda, há toda uma polêmica sobre a legitimidade de se ter somente uma pessoa responsável por uma dada codificação: seria válida tal categorização? Por quê? Seria necessário se ter mais de uma pessoa a codificar? Será que realmente esta segunda pessoa aportaria um ganho de qualidade na codificação realizada? Será que ela estaria engajada o suficiente no mesmo processo de forma a contribuir? Será ainda que este engajamento seria condição importante? Será que tal esforço e mesmo gasto de tempo seria necessário e mesmo compensador? Tendo-se uma segunda pessoa, seria então esperado que se pudesse confrontar as categorias criadas por cada um, consolidá-las num só conjunto (após discussão de cada discordância), e, além disso, comparar uma a uma cada uma das marcações (para cada resposta, cada dos 2 avaliadores ou analistas marcaria as categorias que julga que ali se manifestaram implícita ou explicitamente), dando-se conta do que fecha e do que não fecha em termos de classificação das categorias para cada uma das respostas de Freitas & Janissek – Análise léxica e Análise de conteúdo – p.20 cada respondente. É também nosso objetivo apresentar – na sequência - algumas posições sobre essas colocações. O uso de técnicas de análise de dados qualitativos é pois um tema de crescente interesse e importância no campo da gestão e da informação. Este documento contribui colocando a questão da complementaridade das técnicas de análise léxica e de análise de conteúdo, evocando exemplos da literatura e sobretudo apresentando didaticamente um exemplo no qual aplica estes conceitos e técnicas. Nossa proposta – reforce-se - é de que as duas técnicas sejam utilizadas de forma sequencial (uma após a outra), recorrente (podese ir e vir, deve-se mesmo ir e vir de uma a outra) e complementar (elas não são excludentes, ou seja, não se deve escolher uma ou outra, deve-se adquirir finalmente a visão, a consciência de que os recursos de ambas são excelentes ferramentas na mão do analista e que ele deve fazer bom uso e não isolar uma em detrimento de outra). Freitas & Janissek – Análise léxica e Análise de conteúdo – p.21 3. Análise quali ou quantitativa de dados textuais? A busca por informações consistentes e válidas não deve se deter somente nos dados estruturados, puramente quantitativos, tal qual os imagina-se - na forma de clássicas planilhas, relatórios volumosos, números, percentuais e gráficos: cada vez mais precisa-se recorrer aos dados de natureza qualitativa, como textos, discursos, entrevistas, trechos de livros, reportagens, etc. Dados estes que envolvem elementos que muitas vezes desafiam a astúcia do pesquisador ou do homem de negócios, pois escondem em suas entrelinhas posicionamentos, opiniões, perfis, que exigem uma leitura atenta e ferramentas que possibilitem chegar com maior rapidez (condição de sobrevivência) às informações realmente pertinentes (POZZEBON e FREITAS, 1996; LESCA, FREITAS e CUNHA, 1996; LESCA, FREITAS, POZZEBON, PETRINI e BECKER, 1998). Deve-se poder ir do dado bruto ou puro ao dado elaborado, via interpretação, análise e síntese, e, a partir disso, por uma constatação ou curiosidade, poder rapidamente aprofundar a investigação, eventualmente voltando à fonte e ao dado bruto como recurso mesmo de sustentação de argumento ou simplesmente de ilustração. É importante explorar e sobretudo cruzar de todas as formas possíveis dados quantitativos e qualitativos (Figura 1 - FREITAS, 2000) para a geração de idéias, a verificação de hipóteses, a elaboração de conclusões ou indicação de planos de ação, etc. O uso de técnicas qualitativas x quantitativas, tanto para coleta quanto análise de dados, permitem, quando combinadas, estabelecer conclusões mais significativas a partir dos dados coletados, conclusões estas que balizariam condutas e formas de atuação em diferentes contextos. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.22 A abordagem literária, dita qualitativa, mais associada às técnicas de análise léxica e de conteúdo (abordadas nas seções 3.1 e 3.2), pressupõe a análise de poucas fontes ou dados, num procedimento exploratório ou de elaboração de hipóteses. A abordagem mais científica, dita quantitativa, pressupõe grande quantidade de dados num procedimento de confirmação de hipóteses. Há necessidade de se tratar do quantitativo, enriquecendo-o com informações qualitativas em grande número, de forma a ganhar força de argumento e qualidade nas conclusões e relatórios: o desafio é a busca da associação entre o quantitativo e o qualitativo, onde, por exemplo, o procedimento exploratório ganha força, visto que se poderá multiplicar os dados tratados, reforçando sobremaneira (e mesmo garantindo o ‘bom caminho’) o procedimento confirmatório. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.23 Figura 1 - O desafio de associar qualitativo e quantitativo (FREITAS, 2000) Freitas & Janissek – Análise léxica e Análise de conteúdo – p.24 Segundo KELLE (1995, p.15), "espera-se que as forças de ambas abordagens possam se reforçar mutuamente: a intersubjetividade e a fidedignidade ou confiabilidade providas pela informação padronizada derivada de amplas amostras, por um lado, e o conhecimento íntimo de um simples caso ou passagem de um texto adquirido pela análise interpretativa, por outro lado. A questão essencial nesse tipo de análise seria como transformar o significado da análise textual numa matriz de dados quantitativa, isto de maneira didática e sistemática". A utilidade da combinação destes métodos tem sido assunto discutido fortemente na comunidade acadêmica internacional (MASON, 1997; LEE, LIEBENAU e DEGROSS, 1997), apresentando-nos grande variedade de aspectos a serem levados em conta quando da formulação de questões com vistas à obtenção e análise de dados, sejam eles qualitativos x quantitativos, sejam eles diretos x indiretos, abertos ou fechados. É tempo de seguir em frente com mais estudos qualitativos (MILES e HUBERMAN, 1997), e educar nossos gerentes, começando pelas nossas crianças, que o mundo não é somente quantitativo, e sim qualitativo. Pelo menos, que bom estudo quantitativo não deveria ser precedido por um qualitativo? CRESWELL (1998), e também KIRK e MILLER (1986) oferecemnos alguns conceitos e discussões a respeito de pesquisa qualitativa e principalmente sobre confiabilidade (ou fidedignidade) e validade desse tipo de estudo. Da mesma maneira, a revista MIS Quarterly (v.21, no.3, September 1997) publicou 3 papers baseados em pesquisa qualitativa deste mesmo assunto. MASON (1997, p.9-34) oferece-nos alguns insights sobre essa discussão: o que deveria ser uma pesquisa qualitativa? De que forma relacionar aspectos quali e quanti em uma pesquisa ? Estas pesquisas, seja na obtenção dos dados seja no tratamento destes, deveriam ser sistemática, rigorosa e estrategicamente conduzidas, ainda flexíveis e Freitas & Janissek – Análise léxica e Análise de conteúdo – p.25 contextuais, deveriam envolver críticas auto-construtivas pelo pesquisador, ou provocar reflexões. Também deveriam produzir explicações sociais para charadas ou quebra-cabeças intelectuais permitindo a generalização de alguma forma ou então, permitindo ampla aplicação. Não ser vistas como um corpo unificado de filosofia e prática, cujos métodos podem simplesmente ser combinados sem problemas, nem ser vistas como necessariamente opostas e não complementares. Ainda, deveriam ser conduzidas como uma prática ética levando em consideração o contexto político. De fato, sejam quais forem os fenômenos, entidades ou realidade objetos de investigação, o uso conjunto destes métodos qualitativos e quantitativos permitiriam um maior aprofundamento no conhecimento dos dados, evidenciando-se aspectos do que se deseja investigar e, da mesma forma, possibilitando focar o pensamento sobre o assunto, decidir e executar. O uso conjunto destes dois tipos de análise permite estabelecer conclusões: é importante, pois, diferenciar ambos enfoques, identificando as possibilidades de cada um. Existem ainda outras oposições qualitativo-quantitativo: impressionismo versus sistematização, hipóteses versus verificação, flexibilidade e liberdade versus rigidez (FREITAS, CUNHA e MOSCAROLA, 1997). Enquanto a análise qualitativa se baseia na presença ou ausência de uma dada característica, a análise quantitativa busca identificar a frequência dos temas, palavras, expressões ou símbolos considerados. A noção de importância deve ser clara em cada uma destas análises: o que aparece seguido é o que importa na análise quantitativa, enquanto a qualitativa valoriza a novidade, o interesse, os aspectos que permanecem na esfera do subjetivo. Tem-se assim um dilema de análise: adotar categorias específicas, retratando fielmente a realidade, mas com uma lista de temas cuja frequência será fraca, ou então reagrupar deliberadamente os dados num pequeno número de Freitas & Janissek – Análise léxica e Análise de conteúdo – p.26 categorias, não sem sacrificar informação talvez essencial, a qual ficará perdida no resultado final (FREITAS, CUNHA e MOSCAROLA, 1997). São diversas as fontes e motivações que podem viabilizar a coleta de dados textuais (todo dado cujo conteúdo é texto ou alfanumérico): questões abertas de pesquisas de opinião de mercado e outras; o conteúdo de respostas de entrevistas; mensagens recebidas e enviadas; livros, artigos e textos quaisquer; campos tipo texto nas bases de dados corporativas ou outras; o registro automatizado de telefonemas profissionais ou mesmo pessoais (como os de serviço de atendimento ao cliente); o registro automatizado das operações de consulta de sistemas corporativos como o registro de logs Internet, Intranets e outros sistemas, como por exemplo transações bancárias, suporte técnico, todas operações das caixas de supermercado, etc. Todas estas fontes de dados devem ser exploradas via quantificação e resumo, de forma a permitir a melhor compreensão e interpretação do seu conteúdo, visando daí depreender idéias, ações, enfim, produzir uma informação mais rica para embasar as decisões. Algumas outras aplicações de análise de dados qualitativos são: análise de entrevistas não diretivas, focus group; análise de mídia (TV, imprensa, ...); controle de redação; pesquisas de mercado e de opinião; marketing direto a partir de arquivos internos ou externos; análise de documentos; auditoria na comunicação interna; inteligência Competitiva (patentes, pesq. bibliográfica); gestão de RH (sondagem opinião interna,...), etc. A análise de documentos, sejam eles originários de pesquisas quali ou quantitativas, inclui análise léxica e análise de conteúdo. Ela apresenta um conjunto de características racionais, sendo mais ou menos intuitiva, pessoal e subjetiva. Como outros métodos, apresenta problemas de validade, como autenticidade do texto, validade de interpretação e veracidade dos fatos. Tem ainda, em muitos casos, o Freitas & Janissek – Análise léxica e Análise de conteúdo – p.27 defeito do trabalho não sistematizado, dependendo fortemente do valor e competência do pesquisador. Com o uso conjunto destas técnicas de análise de textos é possível produzir novos dados que podem, por sua vez, ser confrontados especialmente com dados sócio-demográficos, como por exemplo um elenco de reclamações ou sugestões agora vistas por sexo, por faixa etária, por renda, por departamento ou qualquer outro dado mais objetivo ou quantitativo. Antecipar a análise léxica à de conteúdo faria com que a análise de dados se desse de uma maneira plena, ou seja, o uso destas duas técnicas encobrem diversas das possibilidades que dali poderiam surgir ou fazer emergir. Ao final de um esforço de análise de dados, poderia-se dispor de resultados significativos aplicáveis à uma dada realidade. Como isso deve ser feito? De que maneira combinar o uso destas duas formas de análise? Os dois tipos de análise de questões abertas são representados na Figura 2 (FREITAS e MOSCAROLA, 2000). Freitas & Janissek – Análise léxica e Análise de conteúdo – p.28 Figura 2 - A análise de conteúdo e a análise léxica (FREITAS e MOSCAROLA, 2000) Freitas & Janissek – Análise léxica e Análise de conteúdo – p.29 A Análise Léxica (FREITAS e MOSCAROLA, 2000) consiste em se passar da análise do texto para a análise do léxico (o conjunto de todas as palavras encontradas nos depoimentos ou respostas). Já a Análise de Conteúdo (FRANKFORT-NACHMIAS e NACHMIAS, 1996, p.324-330), que consiste em uma leitura aprofundada de cada uma das respostas, onde, codificando-se cada uma, obtém-se uma idéia sobre o todo (FREITAS, 2000). WEBER (1990, p.10) apresenta algumas vantagens da análise de conteúdo, destacando sua aplicabilidade na análise de textos de comunicação de toda natureza, bem como o fato de permitir combinar métodos quanti e qualitativos, e mesmo explorar séries longitudinais de documentos ou fontes múltiplas, e enfim o fato de poder tratar com dados ditos mais espontâneos (e não induzidos ou expressamente perguntados). Com base em textos europeus (GRAWITZ, 1993; GAVARDPERRET e MOSCAROLA, 1995), FREITAS, CUNHA e MOSCAROLA (1997) apresentam noções gerais sobre a análise de dados textuais, com sete diferentes níveis de aplicação e desenvolvimento da análise léxica, ilustrando a aplicação e uso dessas técnicas. Este tipo de análise contribui para a interpretação das questões abertas ou textos, a partir da descrição objetiva, sistemática e quantitativa do seu conteúdo. Diversas referências podem ser consultadas para um maior aprofundamento nas questões da análise de dados qualitativos. WEBER (1990) publicou o livro “Basic Content Analysis”, SILVERMAN (1993) descreve métodos para analisar discursos, textos e interações, no livro “Interpreting Qualitative Data”, MILES e HUBERMAN (1994) publicaram o livro “Qualitative Data Analysis”, o Journal of Applied Management Studies, inglês, publicou dois papers com aplicação de análise de conteúdo e análise léxica: CROUCH e BASCH, “The Structure Of Managerial Thinking”, e OSWICK, KEENOY e GRANT, “Managerial Discourses...”. A MIS Freitas & Janissek – Análise léxica e Análise de conteúdo – p.30 Quarterly também publicou pesquisa qualitativa durante 1997, mostrando disposição da comunidade (e dos editores!) rumo a estudos qualitativos. A literatura francesa também está recebendo novos textos, da parte de BARDIN (1996), e de LEBART e SALEM (1994). Na sequência são apresentadas tais técnicas de análise, buscando enfatizar sua complementaridade. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.31 3.1. A Análise Léxica Toda a análise de textos começa pela organização completa do vocabulário utilizado. Mais do que palavras, fala-se de formas gráficas ou simplesmente de formas breves em razão de uma certa ambigüidade da palavra. A organização consiste em isolar cada forma gráfica supostamente delimitada por dois caracteres separadores que na maioria das vezes são os próprios espaços, mas também podem ser sinais de pontuação. Cada aparição de uma forma de dado é chamada ocorrência, as quais são evidentemente contabilizadas para formar o léxico. O léxico é então, por definição, a lista de todas as formas gráficas utilizadas, cada qual estando munida de um número de ordem ou frequência (LAGARDE, 1995, p.144-145), ou ainda o conjunto das palavras diferentes usadas nesse texto, com a sua frequência de aparição (FREITAS, 2000). Já a Análise Léxica consiste em averiguar ou medir a dimensão das respostas: as pessoas responderam de forma extensa ou concisa? Cria-se uma hipótese de que aqueles que deram respostas extensas têm um interesse maior do que os demais. Uma hipótese discutível que dará, porém, uma indicação (FREITAS, 2000). Nesse tipo de técnica são feitas análises de palavras, e não de respondentes. Por exemplo, caso uma dada palavra apareça n vezes após realizada uma contagem, isso não significa que aquela palavra, ou aquela idéia, possa ser generalizada para grande parte dos respondentes ou representar uma idéia que tenha aparecido em várias opiniões: pode muito bem ocorrer que determinado respondente, ou um pequeno grupo destes, tenham enfaticamente apontado para aquela idéia, repetidamente (por que não?), diferentemente de uma Análise de Conteúdo, onde são identificadas idéias por respondentes, independentemente deste ter citado a palavra 1, 2 ou mais vezes. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.32 Então pode-se dizer que a análise léxica é o estudo científico do vocabulário, com aplicações de métodos estatísticos para a descrição do vocabulário: ela permite identificar com maior detalhe as citações dos participantes, utilizando indicadores que relacionam aspectos relativos às citações e às palavras (BARDIN, 1996). A evolução se dá da visão geral do texto para os dados na sua essência, sejam eles palavras ou expressões (LEBART e SALEM, 1994, p.5869), onde posteriormente serão novamente analisados com vistas ao universo total de informações. Pode-se ainda colocar que, através de processos automáticos que associam a matemática e a estatística, o uso da Análise Léxica permite rapidamente interpretar e fazer uma leitura adequada e dinâmica das questões abertas das enquêtes. Esse procedimento não é mais rigoroso do que a Análise de Conteúdo clássica. Seu tratamento dos dados é objetivo, mas a leitura subjetiva também é realizada: temse, assim, acesso a um processo de leitura mais rápido, automatizado e que, por outro lado, encontra um certo número de justificativas (FREITAS, 2000). A partir do corpo do texto, ou seja, o conteúdo das respostas abertas, evolui-se para analisar palavras e expressões, o léxico. Ao fazer isso, parte-se de um nível que se pode chamar de macroestatístico, iniciando com as entrevistas que foram realizadas e elencando as palavras produzidas nas respostas (GRAWITZ, 1993). Um esquema geral (Figura 3) para Análise Léxica é proposto por FREITAS, MOSCAROLA e JENKINS (1998). Uma Análise Léxica inicia sempre pela contagem das palavras, avançando sistematicamente na direção de identificação da dimensão das respostas. Nos casos de respostas abertas, normalmente são feitas aproximações ou agrupamentos que permitam apresentar critérios mais frequentemente citados, agrupando palavras afins, deletando palavras que não interessam, até resultar num conjunto tal de palavras Freitas & Janissek – Análise léxica e Análise de conteúdo – p.33 que representem na essência as principais descrições citadas nos textos. Tudo depende do quão sutil é feita a análise pelo pesquisador e da qualidade dos dados (amostra). Uma análise rápida em uma pequena amostra normalmente apresentará problemas de dispersão de um mesmo tema, de uma mesma idéia, até mesmo problemas de sinônimos. O tratamento para tal seria o correto agrupamento de palavras em critérios semelhantes. Nestes casos, as frequências permitem consolidar a aplicação de um tema ou locução, possibilitando uma análise de contexto onde as categorias identificadas representem a essência das idéias apresentadas (LEBART e SALEM, 1994, p.135-142). Freitas & Janissek – Análise léxica e Análise de conteúdo – p.34 Corpo do Texto Lematizador Corpo do texto lematizado Dicionário Variáveis De Contexto Navegação Léxica Verbatim Reduzindo e Estruturando o Léxico Variáveis fechadas do léxico Medidas Lexicais: Intensidade banalidade Estrutura Estatística Figura 3 - Esquema para Análise Léxica Fonte: FREITAS, MOSCAROLA e JENKINS (1998) Freitas & Janissek – Análise léxica e Análise de conteúdo – p.35 Como ilustra a Figura 3, a realização de uma análise léxica se dá da seguinte forma: faz-se inicialmente o tratamento deste do conteúdo de um texto ou respostas abertas, através da identificação de número total de ocorrências de cada palavra, número total de palavras, número total de palavras diferentes ou vocábulos e a riqueza de vocabulário para produzir uma resposta (LEBART e SALEM, 1994, p.247). Além disso, classificam-se tais unidades de vocabulário em palavras ricas com algum significado, como verbos, substantivos e adjetivos, além de palavras instrumentais como artigos, preposições, etc. É também possível identificar o tempo aplicado a cada resposta, se isso, é claro, for aplicável naquela situação. A organização da frase, e certos aspectos sintáticos, são suscetíveis de revelar certas características de um discurso ou apontar confirmações de certas hipóteses formuladas, além das comparações entre estas. Para isso, deve-se ir além da Análise Léxica, iniciando a Análise de Conteúdo (BARDIN, 1996, p.82-92). Há recursos e técnicas que podem ser aplicados para ter um corpo do texto lematizado, ou seja, transformar as palavras que ainda constituirão o léxico na sua forma infinitiva ou na sua forma original (fala-se aqui no que diz respeito a verbos, substantivos e adjetivos). Pode-se assim reduzir significativamente o léxico, e, a partir daí, criar novos dados, objetivos (fechados sobre palavras do léxico), bem como gerar novos dados com medidas lexicais (intensidade lexical, banalidade ou trivialidade e ainda originalidade) (SPHINX, 1997). Tal análise, representada na Figura 3, inicia pela aproximação lexical sumária, que consiste em reduzir o texto apresentando as palavras mais frequentes que permitem uma idéia do seu conteúdo. Em seguida é realizada a aproximação lexical controlada, que reduz o texto ao seu léxico e controla, via navegação lexical, a validade e o fundamento das interpretações elaboradas a partir do léxico. Após isso, é realizada a aproximação lexical seletiva, eliminando palavrasFreitas & Janissek – Análise léxica e Análise de conteúdo – p.36 ferramentas e concentrando a atenção no exame de substantivos, verbos e adjetivos via utilização de dicionários e de um lematizador. Em seguida, é realizada a pesquisa das especificidades lexicais, que estabelece uma estatística das palavras do texto, segundo uma variável externa não textual (por exemplo país, região, departamento). A descrição do texto através de variáveis nominais e o cálculo das intensidades lexicais permitem que cada resposta seja descrita pela intensidade segundo a qual se manifestam os diferentes campos estudados. O aprofundamento da análise pode se dar com a análise bi ou multivariada dos dados textuais em função de outros dados, integrando-a desta forma com a análise de dados clássica (FREITAS, CUNHA e MOSCAROLA, 1997). Com a Análise Léxica, é possível apresentar opções (palavras, agrupamentos, expressões) para desvendar caminhos e descobrir opiniões, identificar necessidades, obsessões, seja qual for a intenção da pesquisa ali aplicada. Descobrir as razões de tal objeto de estudo significa passar da indecisão para a riqueza da leitura, e isso pode ser feito com o uso combinado das técnicas apresentadas neste livro. Desta forma, não somente pode-se contar com uma leitura das respostas, o que por si só já nos diz muita coisa, mas também com a identificação das opiniões expressas nas entrelinhas destes mesmos textos. Se em uma leitura espontânea já se pode identificar idéias, o que se poderia dizer de uma leitura e categorização mais atenta no sentido de observar e descobrir conteúdos ali ditos de forma indireta ou até mesmo obscura, permitindo descobrir significados e elementos suscetíveis não identificados a priori. De fato, a aplicação sequencial e recorrente destas técnicas permite assim avançar. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.37 3.2. A Análise de Conteúdo Quando os dados a analisar se apresentam sob a forma de um texto ou de um conjunto de textos ao invés de uma tabela com valores, a análise correspondente assume o nome de Análise de Conteúdo – neste texto AC (LAGARDE, 1995, p.143). A AC é uma técnica de pesquisa para tornar replicáveis e validar inferências de dados de um contexto que envolve procedimentos especializados para processamentos de dados de forma científica. Seu propósito é prover conhecimento, novos insights obtidos a partir destes dados (KRIPPENDORFF, 1980). Uma parte importante do comportamento, opinião ou idéias de pessoas se exprime sob a forma verbal ou escrita. A Análise de Conteúdo destas informações deve normalmente permitir a obtenção destas informações resumidas, organizadas. A AC pode ser usada para analisar em profundidade cada expressão específica de uma pessoa ou grupo envolvido num debate. WEBER (1990, p.9) apresenta alguns propósitos para uso de AC. Permite também observar motivos de satisfação, insatisfação ou opiniões subentendidas, natureza de problemas, etc, estudando as várias formas de comunicação. É um método de observação indireto, já que é a expressão verbal ou escrita do respondente que será observada. Não existiria dentro desse método uma riqueza e uma diversidade de modos de expressão? A AC torna possível analisar as entrelinhas das opiniões das pessoas, não se restringindo unicamente às palavras expressas diretamente, mas também àquelas que estão subentendidas no discurso, fala ou resposta de um respondente (PERRIEN, CHÉRON e ZINS, 1984, p.27). Freitas & Janissek – Análise léxica e Análise de conteúdo – p.38 O objetivo da AC é a inferência2 de conhecimentos relativos às condições de produção com a ajuda de indicadores. A AC é como um trabalho de um arqueólogo: ele trabalha sobre os traços dos documentos que ele pode encontrar ou suscitar, traços estes que são a manifestação de estados, dados, características ou fenômenos. Existe alguma coisa a descobrir sobre eles, e o analista pode manipular esses dados por inferência de conhecimentos sobre o emissor da mensagem ou pelo conhecimento do assunto estudado de forma a obter resultados significativos a partir dos dados (Figura 4). Ele trabalha explorando os dados, como um detetive (BARDIN, 1996, p.43-44). Nesse sentido, a descrição do conteúdo é a primeira etapa a ser cumprida, a qual passa pela já citada Análise Léxica pela possibilidade de leitura rápida do conteúdo das respostas através de resultados tabulados das frequências das mesmas. Parte-se de dados qualitativos - fazendo um agrupamento quantitativo - para análise qualitativa novamente. 2 Inferência: operação lógica, pela qual se aprova uma proposição em verdade de sua ligação com outras proposições já tênues por verdades (BARDIN, 1996, p.43). Este tema é desenvolvido por BARDIN (1996, p.169-177). Freitas & Janissek – Análise léxica e Análise de conteúdo – p.39 Leitura Normal Variáveis Inferidas / Análise de Conteúdo Figura 4 – Análise de Conteúdo BARDIN (1996, p.46) Freitas & Janissek – Análise léxica e Análise de conteúdo – p.40 Fazer o processo dedutivo ou inferencial a partir de índices (palavras) ou indicadores não é raro dentro da prática científica. O médico faz suas deduções sobre a saúde de seu paciente graças aos seus sintomas, o meteorologista faz a previsão do tempo inferindo sobre estados ou posições da natureza. Ocorre o mesmo dentro da Análise de Conteúdo, pela dedução através da leitura e compreensão das mensagens. Os fatos, deduzidos logicamente a partir de indicadores, permitem tirar conclusões, obter novas informações ou completar conhecimentos através do exame detalhado dos dados. Ser objetivo, visto que a análise deve proceder segundo as regras préestabelecidas, obedecendo a diretrizes suficientemente claras e precisas de forma a propiciar que diferentes analistas, trabalhando sobre o mesmo conteúdo, obtenham os mesmos resultados. Ser também sistemático, pois todo o conteúdo deve ser ordenado e integrado nas categorias escolhidas, em função do objetivo perseguido, e elementos de informação associados ou relativos ao objetivo não devem ser deixados de lado. Ser ainda quantitativo, pela possibilidade de evidenciar os elementos significativos, calcular a sua frequência, etc., esta condição não sendo indispensável visto que certas análises de cunho qualitativo buscam mais os temas do que a sua exata medida ou importância. Segundo GRAWITZ (1993, p.534), tais características formam os atributos da Análise de Conteúdo, o que é reforçado por PERRIEN, CHÉRON e ZINS (1984) e FREITAS, MOSCAROLA e JENKINS (1998). Pode-se, ainda, classificar a AC de acordo com o propósito de investigação, que pode ser a descrição de características de comunicação - perguntando o quê, como e de quem alguém disse tal coisa, a inferência dos antecedentes da comunicação - que envolve perguntar porque alguém disse alguma coisa - ou ainda fazer inferências sobre os efeitos da comunicação - perguntando com que Freitas & Janissek – Análise léxica e Análise de conteúdo – p.41 intenção alguém disse tal coisa (HOLSTI, 1969 e JANIS, 1965 apud KRIPPENDORFF, 1980, p.34). De fato, a Análise de Conteúdo é “uma técnica de pesquisa utilizada para tornar replicáveis e validar inferências de dados para seu contexto, segundo seus componentes, relações ou transformações entre estes” (KRIPPENDORFF, 1980, p.35). Para BARDIN (1996, p.47), AC é “um conjunto de técnicas de análise das comunicações que, através de procedimentos sistemáticos e objetivos de descrição do conteúdo das mensagens, visa obter indicadores (quantitativos ou não) que permitam a inferência de conhecimentos relativos às condições de produção e de recepção (variáveis inferidas) destas mensagens”. A seguir, abordam-se alguns tópicos inerentes, como: os tipos de Análise de Conteúdo, as suas etapas, o seu valor como instrumento ou técnica de pesquisa, bem como seu uso e aplicação. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.42 3.2.1. Tipos de Análise de Conteúdo Uma vez que diferentes fontes de dados estão normalmente disponíveis, pode-se usar vários modelos para explorar, processar e analisar dados. GRAWITZ (1993) desenvolve 3 diferentes enfoques (valorizados por FREITAS, MOSCAROLA e JENKINS, 1998): Verificação ou Exploração? Deve-se fazer distinção entre a análise de documentos tendo como objetivo a hipótese de verificação (sabendo-se o que se busca e podendo-se quantificar os resultados - neste caso o objeto é preciso), e aquela análise cujo objetivo seja exploração ou definição de hipóteses, onde a análise é menos rigorosa e sistemática, seguindo papéis e técnicas que não podem ser padronizadas, visto que faz apelo à intuição e à experiência. Análise quantitativa ou análise qualitativa? A análise quantitativa tenta acumular a frequência de temas, palavras ou símbolos, enquanto análise qualitativa é baseada na presença ou ausência de dadas características. Outra dicotomia quali-quanti é impressões versus sistematizações, hipóteses ao invés de verificações, e flexibilidade como oposto à rigidez. O que é importante deve estar claro em cada um dos tipos de análise. O número de vezes que um dado elemento ocorre é o que conta para a análise quantitativa, enquanto a novidade, interesse, tema ou atributo subjetivo é o objeto da análise quali. Sempre se tem um dilema: adotar categorias representativas, ou reagrupar deliberadamente os dados em um pequeno número de categorias, sacrificando informações. BERELSON (1971, apud FRANKFORT-NACHMIAS e NACHMIAS, 1996, p.328) Freitas & Janissek – Análise léxica e Análise de conteúdo – p.43 define que “a Análise de Conteúdo se sustenta ou se destrói pelas suas categorias”. FRANKFORT-NACHMIAS e NACHMIAS apontam, baseados na literatura, uma série de categorias mais frequentemente empregadas, do tipo “o que é dito” (tema, sentido, padrão, valores, métodos, características, origem, tempo, conflito, etc) e “como é dito” (forma ou tipo de comunicação, método ou técnica utilizada, forma de definição). Análise direta ou indireta? A análise quantitativa direta, medida mais comumente utilizada, consiste em contabilizar as respostas tal qual elas aparecem; já a análise quantitativa indireta pode, por vezes, além do que se tem como resultado claro e manifesto, obter por inferência, até mesmo aquilo que o autor deixou subentendido. Este tipo de informação (escolha das palavras, ritmo do discurso, etc) pode ser muito reveladora. Pode-se, então, a partir de uma análise quantitativa, buscar uma interpretação mais sutil, ou o que é latente sob a linguagem explícita utilizada no texto. A interpretação indireta, que vai além do que é dito, não é algo amparado apenas no qualitativo, ela pode perfeitamente se apoiar num conteúdo quantificado (e que possa ser destacado como exemplo). Freitas & Janissek – Análise léxica e Análise de conteúdo – p.44 3.2.2. Etapas da Análise de Conteúdo Toda a análise de conteúdo deve seguir uma série de etapas precisas, que se iniciam pela definição do universo estudado, delimitando e definindo claramente, desta forma, o que estará e o que não estará envolvido. Uma vez estando o universo corretamente definido, inicia-se sua categorização, que significa determinar as dimensões que serão analisadas, dimensões estas que definem a teia da grade de análise. Estas categorias serão determinadas em função da necessidade de informação a testar: elas constituirão o coração da Análise de Conteúdo. A categorização é uma etapa delicada, não sendo evidente determinar a priori suas principais categorias: na verdade, a categorização (processo de redução do texto no qual as muitas palavras e expressões do texto são transformadas em poucas categorias) é o problema central da AC (WEBER, 1990, p.15). Em certos casos, sua origem será empírica: a partir de um estudo de um certo número de casos, as categorias serão formadas a posteriori. Na definição das categorias, é importante utilizar-se dos critérios ou palavras identificadas na Análise Léxica. Tais critérios muito provavelmente serão agrupados ou reagrupados, formando então as categorias. É o que ilustra a Figura 5 (PERRIEN, CHÉRON e ZINS, (1984, p.275-277). Freitas & Janissek – Análise léxica e Análise de conteúdo – p.45 Figura 5 – Análise de Conteúdo em etapas Freitas & Janissek – Análise léxica e Análise de conteúdo – p.46 As categorias são as rubricas significativas em função das quais o conteúdo será classificado e eventualmente quantificado. WEBER (1990, p.56-57) aborda a questão da contagem de categorias. No caso de uma enquête, pode-se prever categorias já em forma de código. A Análise de Conteúdo deve normalmente permitir o aparecimento de variáveis e fatores de influência que se ignorava no início dos trabalhos. As categorias, quando não se tem uma idéia precisa, devem surgir com base no próprio conteúdo. Na enquête de exploração, as categorias constituem elas próprias o quadro, objeto ou contexto de análise, enquanto que, na busca de verificação de uma hipótese, pode-se ter categorias prédefinidas. De fato, um mesmo dado aberto pode servir de base aos dois exercícios ou lógicas ou estratégias de análise recém evocados. Pode-se explorar um dado para saber o que dele pode emergir como categorias (a lista de reclamações dos clientes, por exemplo), assim como se pode utilizar esse mesmo dado para julgar se a clientela está ou não satisfeita (classificação já pronta para se categorizar cada respondente em ‘satisfeito’ ou ‘insatisfeito’). As categorias devem se originar seja do documento objeto da análise, seja de um certo conhecimento geral da área ou atividade na qual ele se insere. Das respostas, caso se trate de uma entrevista; dos objetivos, intenções, crenças do emissor, no caso de um texto; não sem considerar elementos ausentes que podem ser significativos. A escolha das categorias é o procedimento essencial da Análise de Conteúdo; visto que elas fazem a ligação entre os objetivos de pesquisa e seus resultados. O valor da análise fica sujeito ao valor ou legitimidade das categorias de análise. É o objetivo perseguido que deve pautar a escolha ou definição do que deve ser quantificado. Segundo WEBER (1990) e BARDIN (1996), as categorias devem ser exaustivas (percorrer todo o conjunto do texto), exclusivas (os mesmos elementos não podem pertencem a diversas categorias), Freitas & Janissek – Análise léxica e Análise de conteúdo – p.47 objetivas (características claras de modo a permitir seu uso por diferentes analistas em um mesmo texto) e pertinentes (em relação com os objetivos perseguidos e com o conteúdo tratado). A escolha das unidades de análise é a etapa seguinte: o conteúdo de um texto pode ser analisado de diferentes maneiras, conforme as unidades de análise que serão definidas. Vários autores tratam das unidades de análises, apresentando-as com alguns enfoques ou rótulos diferentes. Além de LEBART e SALEM (1994, p.46-50) e de WEBER (1990, p.21-24), destacam-se: Para PERRIEN, CHÉRON e ZINS (1984), as unidades classificam-se em (1) palavras, que são as unidades de análise mais desagregadas, pois muitas vezes expressam situações momentâneas, medidas por estímulos situacionais; (2) em tema, que pode ser definido como a unidade mais manipulável, uma vez que compreende proposições ou afirmações de um sujeito a presença ou ausência de um tema pode ser rica em informações; (3) em personagens, que representam um outro sujeito de interesse, sobre os quais pode-se manipular determinadas características e tomá-las como foco de análise e ainda (4) as características espaciais ou temporais, que implicam em relacionar e medir um certo número de especificidades dos textos, evidenciando o conjunto total das idéias apresentadas. Segundo KRIPPENDORFF (1980, p.57), as unidades de análise classificam-se em (1) unidades amostrais, que são aquelas partes da observação real, registradas independentemente das outras que a acompanham; (2) unidades de registro, que são segmentos específicos do conteúdo, Freitas & Janissek – Análise léxica e Análise de conteúdo – p.48 caracterizados por situarem-se dentro de uma dada categoria e descritas separadamente, podendo então serem registradas como partes analisáveis separadamente das unidades amostrais, e (3) unidades de contexto, que fixam limites de informações contextuais que podem apresentar a descrição de uma unidade de registro. Elas delineiam aquela parte do material necessário para ser examinado para que uma unidade de registro seja caracterizada. A quantificação é a última etapa da Análise de Conteúdo, cujo objetivo é permitir o relacionamento das características dos textos combinadas ao universo estudado. A presença ou ausência de uma unidade igual ao nome das unidades, representa uma quantificação ao nível nominal (PERRIEN, CHÉRON e ZINS, 1984, p.274-277). Freitas & Janissek – Análise léxica e Análise de conteúdo – p.49 3.2.3. O valor da Análise de Conteúdo A Análise de Conteúdo é uma técnica refinada, delicada, e requer muita dedicação, paciência e tempo para satisfazer a curiosidade do investigador. Além disso, são necessárias intuição, imaginação e observação do que é importante, além de criatividade para escolha das categorias já citadas. Ao mesmo tempo, o analista deve ter disciplina, perseverança, e ainda rigidez na decomposição do conteúdo ou na contagem dos resultados das análises. Existem alguns aspectos que GRAWITZ (1993, p.553-558) resgata com relação à AC, os quais são abordados e reforçados por FREITAS, MOSCAROLA e JENKINS (1998): Confiabilidade: A Análise de Conteúdo deve ser objetiva, e os resultados devem ser independentes do instrumento utilizado para medição, sendo conveniente minimizar as diferenças dos pontos de vista entre os analistas. Mas isso é um velho problema das ciências sociais, a confiabilidade não deve ser encarada da mesma forma quando se trata de análises quantitativas de um conteúdo claro e óbvio, como quando se trata de uma análise mais qualitativa, onde se procura identificar intenções ocultas, onde é preciso identificar presença ou ausência de um elemento e não a sua frequência. Segundo KRIPPENDORFF (1980, p.146), a verificação da confiabilidade visa prover uma base para inferências, recomendações, suporte à decisão ou mesmo a aceitação de um fato. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.50 Validade lógica: o instrumento realmente mede o que ele se propõe a medir? Uma análise é válida quando a descrição quantificada que ela oferece a respeito de conteúdo é significativa para o problema original e reproduz fielmente a realidade dos fatos que ele representa. É claro, isso é condição essencial da representatividade da amostra e supõe que certas condições técnicas inerentes a cada estágio sejam observadas satisfatoriamente. A inferência: este ponto merece especial atenção porque algumas das expressões têm mais de uma interpretação, até mesmo interpretações positivas ou negativas, dependendo do contexto. Validade empírica: a predição inerente é justa ou precisa? Uma difícil questão para responder. Em lugar de convicções, prudência e humildade são recomendadas ao traçar as conclusões. Contudo, GRAWITZ (1993) acredita que a experiência e o treinamento do analista assinam a validade de sua análise. O valor da Análise de Conteúdo depende da qualidade da elaboração conceitual feita a priori pelo pesquisador, e da exatidão com a qual ele irá traduzi-la em variáveis, esboço de pesquisa ou categorias. Segundo WEBER (1990, p.15), uma variável baseada na classificação de um conteúdo é válida na medida em que de fato mede o construto que o pesquisador tenciona medir. Os assuntos guiados pelas categorias podem suscitar hipóteses interessantes (FREITAS, MOSCAROLA e JENKINS, 1998). Qualquer esforço nessa direção Freitas & Janissek – Análise léxica e Análise de conteúdo – p.51 deve passar pela confiabilidade e validade dos resultados gerados (KIRK e MILLER, 1986, p.21-24 e p.41-42). Para os resultados de pesquisa serem válidos, os dados nos quais eles serão baseados, bem como os indivíduos envolvidos na sua análise e ainda o processo que vai gerar os resultados devem ser, todos eles, confiáveis. A confiabilidade é necessária, ainda que não seja uma condição suficiente por si só para a validade. A importância da confiabilidade está baseada na sua garantia de que os dados são obtidos independentemente do evento de medição, instrumento ou pessoa (KRIPPENDORFF, 1980). Dados confiáveis, por definição, são dados que permanecem constantes através das variações do processo de medida (KAPLAN e GOLDSEN, apud KRIPPENDORFF, 1980, p.129). A confiabilidade é vista como um problema no contexto de pesquisa qualitativa, em relação à sua estrutura de codificação, que poderia ser vista por ela mesma como confiável se, em qualquer recodificação subsequente, os mesmos códigos fossem repetidos por um diferente codificador com uma margem aceitável de erro. KRIPPENDORFF (1980, p.130-154) aborda em detalhe esta questão da concordância, observando (p.146-147) que adotou em sua equipe a diretriz de reter variáveis cuja concordância nesse sentido fosse de pelo menos 80% entre os dois codificadores (necessariamente independentes, somente discutindo, como último recurso, sobre efetivas dúvidas, e não buscando influenciar um no protocolo do outro), mas que seriam igualmente retidas ou consideradas variáveis cuja concordância fosse entre 67 e 80% (muito embora se deva ser sempre cauteloso ao concluir sobre estes resultados)3. Ele observa ainda que o custo de não ser zeloso nesse sentido é o de se chegar a 3 OLIVEIRA (1999, p.176-178) evoca referencial sobre o grau aceitável de concordância, inclusive identificando na literatura que as chances de concordância entre os classificadores é maior à medida que o número de opções ou categorias é menor. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.52 conclusões equivocadas nas pesquisas. O autor observa (p.147) que se as implicações de uma AC forem consideradas drásticas, deve-se ser rigoroso na consideração de níveis de concordância; porém, em se tratando de estudos exploratórios sem sérias consequências, o nível da concordância "pode ser consideravelmente relaxado, contudo, não tão baixo que não permita levar a sério as descobertas". Para alcançar um bom nível de concordância, deve-se ter cuidado e construir categorias codificadas que sejam mutuamente exclusivas e não ambíguas. Não se deve confundir os requisitos que surgem na pesquisa hipotético-dedutiva com as demandas da pesquisa qualitativa exploratória. Numa abordagem hipotético-dedutiva para análise de textos, categorias (pré-definidas) serviriam para condensar informações relevantes contidas nos dados, as quais seriam representadas através de frequências. Já durante um estudo exploratório, a codificação deve ser construída através do próprio processo de análise de dados. Deve-se entender que cada abordagem requer um enfoque diferente de confiabilidade: um estágio dito exploratório, onde o ambiente (categorias e propriedades) é desenvolvido e hipóteses são geradas, e um estágio de construção de teoria baseada em dados, onde as hipóteses são refinadas com maior detalhe (KELLE, 1995, p.25). SILVERMAN (1993, p.149) discute validade como sendo ‘verdade’, ou seja, ele recorre a HAMMERSLEY, para quem validade é “interpretada como a extensão ou medida pela qual uma apuração, contagem ou codificação representa efetivamente o fenômeno social ao qual se refere”. SILVERMAN (1993, p.156-157) descreve duas formas de validação na pesquisa qualitativa: a “triangulação” (comparar diferentes tipos de dados, quanti e qualitativos, obtidos pelo uso de diferentes métodos, como observação e entrevistas, de forma a ver se um corrobora o outro) e a “validação pelo respondente” (agregando as descobertas de um aos temas sendo estudados pelos Freitas & Janissek – Análise léxica e Análise de conteúdo – p.53 outros, e mesmo avaliando sua reação). Contudo, ele prefere outras técnicas a estas. Ele sugere (p.160-166) que sejam utilizados métodos que permitam generalizar para uma população mais ampla (mas não numa lógica puramente estatística, e sim obtendo informações sobre aspectos relevantes da população de casos e comparando o caso em análise com esses dados, usando método survey numa amostra aleatória de casos, ou ainda realizando diversos estudos etnográficos), métodos de teste de hipóteses (indução analítica na busca de associações, com constante uso de métodos comparativos e a busca por casos de exceção), e mesmo que se use simples procedimentos de contagem (uso de alguma quantificação). Um procedimento confiável deve render os mesmos resultados a partir de um mesmo conjunto de fenômenos, indiferentemente das circunstâncias de aplicação (KRIPPENDORFF, 1980; KIRK e MILLER, 1986). Um codificador ou analista, por exemplo, pode duplicar o que ele tenha tido feito antes e, não encontrando maiores divergências entre as duas, concluir que tais dados são confiáveis. Agora, imagine o mesmo codificador confrontando sua codificação de categorias com codificações feitas por outra pessoa. Neste caso, a ausência de desvios é um indicativo de confiança dos dados, mas maior ainda porque está livre de erros ou inconsistências de um único codificador. Ou ainda, pode ser interessante o fato de estes dados serem testados por duas pessoas e ainda serem confrontados com normas sistematizadas de verificação. Portanto, para testar a confiabilidade dos dados, alguns esforços duplicados são essenciais, seja do codificador por si mesmo, seja a partir da exigência de codificação por mais de um envolvido, em ambas situações confrontando os resultados. Toda comunicação entre codificadores tenderá a melhorar o grau de concordância, contudo esse mesmo grau terá embutido um viés da própria comunicação. Esta confiabilidade da Análise de Conteúdo pode ser Freitas & Janissek – Análise léxica e Análise de conteúdo – p.54 obtida, segundo KRIPPENDORFF (1980, p.130-131), através de 3 maneiras, que são a estabilidade, a reprodutibilidade e a exatidão, as quais exprimem, nessa ordem, o menor e o maior grau de confiabilidade. A Figura 6 apresenta características destes 3 tipos de confiabilidade. Estes aspectos são reforçados e revisados por WEBER (1990, p.17). Freitas & Janissek – Análise léxica e Análise de conteúdo – p.55 TIPO ESFORÇOS DEFINIÇÃO Estabilidade Teste - reteste Reprodutibilidade Teste - teste Exatidão Teste - padrão É o grau ou intensidade no qual o processo é invariável ou imutável com o passar do tempo É o grau ou intensidade no qual o processo pode ser recriado em variadas circunstancias, em diferentes locais, usando diferentes codificadores. É o grau ou intensidade no qual o processo funciona conforme um padrão conhecido. RELAÇÕES 1) Intra-observador / Inconsistências 1) Intra-observador / Inconsistências 2) Inter-observador / Discordâncias 1) Intra-observador / Inconsistências 2) Inter-observador / Discordâncias 3) Divergências sistemáticas, de acordo com as regras ou normas Figura 6 – A confiabilidade na Análise de Conteúdo: tipos, características e técnicas (KRIPPENDORFF, 1980, p.131) Freitas & Janissek – Análise léxica e Análise de conteúdo – p.56 A verificação da estabilidade, dependendo do tipo de análise, por exemplo sendo mais ‘exploratória’, já pode ser uma razoável argumentação para legitimar o valor dos dados ou categorias apresentados, bem como o perfil do analista. No caso de pesquisas de ‘verificação de hipóteses’, é claro, seria fundamental a verificação quanto à reprodutibilidade e à exatidão (KELLE, 1995, p.18-28). SILVERMAN (1993, p.144-148) discute detalhadamente sobre a confiabilidade, contudo é fortemente baseado em KIRK e MILLER. Estes resgatam uma definição de HAMMERSLEY para a confiabilidade: “refere-se ao grau de consistência com o qual as categorias são definidas por diferentes observadores ou pelo mesmo observador em diferentes ocasiões”. A confiabilidade de dados requer, portanto, que no mínimo dois codificadores independentes descrevam um mesmo conjunto de unidades, ou então um mesmo em duas ocasiões com certa distância de tempo. A confiabilidade é expressa como uma função de concordância entre os codificadores (ou as duas codificações do mesmo analista no tempo 1 e no tempo 2) em razão de um mesmo conjunto de dados. Uma vez de posse dos resultados de cada codificador (ou do teste e reteste de um mesmo codificador), existem vários cálculos que podem ser aplicados para verificar o grau de concordância obtido entre os codificadores. Tais cálculos são apresentados por KRIPPENDORFF (1980, p.133-154). Segundo KRIPPENDORFF (1980, p.134), a forma mais convincente de expressar a confiabilidade dos dados pode ser obtida com base no máximo possível de concordância entre os dois avaliadores, isto combinado com uma contagem de desacordos observados em função de desacordos esperados, que ele define num cálculo chamado “chance de concordância”. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.57 EVRARD (1997, p.118-119) revisa diferentes autores a este propósito, bem como KRIPPENDORFF (1980, p.138-154). Destacam-se duas proposições: um é o índice de convergência - o Kappa de Cohen, que compara o percentual de acordo entre os analistas em função do que seria obtido ao acaso, numa formulação matemática que envolve o número total de julgamentos feitos por cada analista, o número de julgamentos sobre os quais os analistas estão de acordo e o número de julgamentos em acordo obtidos ao acaso. Outro é a medida de percentual de acordo (ou a definição de matrizes de contingência entre analistas), onde as categorias de codificação dos analistas são relacionadas em uma tabela de duplas entradas, com as frequências das classificações que foram identificadas pelos dois analistas e a possibilidade de medir o percentual de acordo em relação ao percentual de desacordo. Numa posição contrária ao excesso de "formulismos", nossa idéia é de que - nas pesquisas em SI - estas verificações devem ser passíveis de serem realizadas de forma descomplicada e bastante honesta, isto qualquer que seja o conhecimento do analista. De fato, o que interessa é saber o real grau de concordância entre os dois codificadores em questão (normalmente o pesquisador em si e alguém que serve de referência). Não se deseja sobretudo induzir o pesquisador a realizar manipulações dos resultados observados (ele ficará tentado a tal para provar um – supostamente improvável - alto grau de concordância), nem desviar sua atenção do objeto investigado em si com procedimentos de verificação e cálculos complicados e que exigem tempo nobre e muita paciência, além do envolvimento e doação de um terceiro. O leitor é quem deve julgar o uso adequado e a efetiva cientificidade das verificações da confiabilidade; este texto mostra posição a respeito, mas também o referencial necessário e suficiente para adoção de outra solução. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.58 Assim sendo, note-se primeiro que os procedimentos matemáticos ou de confrontação com outro analista (indicados na literatura já referenciada) são mais pertinentes quando a variável envolvida é do tipo assumida ou definida a priori, ou seja, aquelas cuja classificação ou categorização foi realizada por ambos com base em protocolo comum e bem entendido, oriundo seja de literatura, seja de idéias que eles mutuamente compartilham. Neste caso, pode-se esperar um certo grau de concordância. Isto não é tão verdade para o caso das variáveis ditas inferidas, nas quais o pesquisador vai utilizar seu referencial e todo seu domínio por estar envolvido na pesquisa para criar categorias de forma gradativa à medida que avança de dado em dado. Esperar que o segundo analista, o qual realiza a categorização de confrontação, possa ter um alto grau de concordância, seria partir do pressuposto que ele tem um entendimento da questão e mesmo do seu conteúdo muito próximo do pesquisador principal. Ora, isto é muito difícil. Logo, deve-se esperar, nestes casos, um não tão alto grau de concordância nas confrontações cujo objeto seja este tipo de variável. WEBER (1990, p.18) chama a atenção sobre quão “potencialmente confusa” pode ser a questão de verificação da validade. Mesmo KRIPPENDORFF (1980, p.135) observa que a AC pode conter métricas e escalas complexas e distintas. Nossa proposta é que o pesquisador realize contagens de acordos e desacordos e, a partir disso, possa ter formas simplificadas que permitam dar uma noção do grau de concordância entre os dois avaliadores, entre as quais as seguintes, baseadas seja nas categorias, seja nas observações (pessoas, entrevistas ou fichas): Concordância exata com base no total de itens avaliados – em relação ao total de categorias da questão sendo avaliada multiplicado pelo número de entrevistas ou pessoas ou fichas, quantas categorias foram comuns aos dois avaliadores, independentemente de Freitas & Janissek – Análise léxica e Análise de conteúdo – p.59 terem sido marcadas ou não (marcaram as mesmas e deixaram em branco as mesmas) 4. Concordância parcial com base no total de itens efetivamente marcados pelo pesquisador (ou pelos avaliadores) – em relação ao total de categorias marcadas pelo pesquisador, quantas destas foram também marcadas pelo segundo avaliador, desconsiderando as desigualdades. Ou ainda, também a quantidade de categorias que o pesquisador deixou em branco e também foram deixadas em branco pelo segundo avaliador. A sofisticação (ou ponderação ou mesmo relativização) deste indicador seria também verificada pela quantidade de categorias que o pesquisador marcou e não foram marcadas de forma correspondente pelo segundo avaliador (o que se obtém diretamente, descontando do número total de categorias marcadas pelo pesquisador o número de categorias coincidentes marcadas pelos dois, ou seja, o número de categorias que o segundo avaliador marcou e que coincidem com as categorizações de fato do pesquisador). Além disso, também poderia ser indicada a quantidade de categorias que o segundo avaliador marcou e que não foram marcadas de forma correspondente pelo pesquisador (o que se obtém diretamente, descontando do número total de categorias efetivamente marcadas pelo segundo avaliador o número de categorias coincidentes marcadas pelos dois, este último tendo sido gerado a partir da comparação caso a caso ou categorização entre o pesquisador e o segundo avaliador). Estes dois últimos valores serviriam para mostrar que o principal indicador (a quantidade de categorias de fato igualmente marcadas) tem sua força de argumento amenizada. Este é um indicador simples que mostra honestamente o grau efetivo de concordância. 4 OLIVEIRA (1999, p.357) em sua pesquisa de doutorado, aplicou um cálculo de confiabilidade da codificação de uma questão aberta texto da seguinte forma: o coeficiente de concordância foi calculado dividindo o número total de citações com codificação igual pelo número total de citações e multiplicado por 100. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.60 Concordância exata com base no total de respondentes – forma mais rígida de avaliação da concordância – qual o número de entrevistas ou pessoas ou fichas nas quais a marcação ou categorização realizada pelos dois avaliadores é exatamente coincidente? Concordância parcial com base no total de respondentes – flexibilização do critério de avaliação da concordância – com margem de mais ou menos um, mais ou menos dois, etc, ou seja, qual o número de entrevistas ou pessoas ou fichas nas quais a marcação ou categorização realizada pelos dois avaliadores é quase coincidente (quase todos coincidem, exceto um ou dois, ou mesmo uma quantidade razoável a ser definida pelo pesquisador, de acordo com o número de categorias envolvidas na questão)? No item 6.4 deste livro, são aplicadas estas idéias numa confrontação envolvendo uma variável cujas categorias foram inferidas a partir do conteúdo de cada entrevista, e também numa outra cujas categorias foram definidas a priori pelo pesquisador com base na literatura e na prática gerencial. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.61 3.2.4. Aplicação da Análise de Conteúdo Os recursos oferecidos pelas ciências sociais para nossa reflexão são essencialmente compostos de comunicações orais ou escritas, que incluem textos de entrevistas, falas, discursos e conversas. Qualquer que seja o nível que se deseje atingir e o objeto de nossas pesquisas, os dados a reunir para compreender, explicar opiniões, condutas, ações, enfim, estes dados são quase sempre de origem verbal. A ação, quando nós a apreendemos, apresenta-se em um contexto de palavras: sempre se encontram falas ou discursos e escritos ou textos, ou seja, documentação em palavras. A Análise de Conteúdo pode ser uma boa técnica para ser usada em todos os tipos de pesquisa que possam ser documentadas em textos escritos (documentos oficiais, livros, jornais, documentos pessoais), em gravações de voz ou imagem (rádio, televisão, etc), ou em outras atividades que possam ser decompostas como uma entrevista, por exemplo. É muito importante que pesquisadores sociais estejam aptos a analisar esse tipo de dados de uma forma científica, não se contentando apenas com impressões casuais. A novidade em procedimentos modernos de Análise de Conteúdo está em substituir as impressões por procedimentos padronizados, quantitativos, através da transformação de dados iniciais (provenientes de pesquisas qualitativas) em dados possíveis de serem analisados digamos mais cientificamente. Para isso, utiliza-se da decomposição do texto, que será estudado como uma função das palavras que ele contém ou idéias que ele representa, este último sendo escolhido em função das relações com os objetivos da nossa pesquisa aqui descrita (FREITAS, MOSCAROLA e JENKINS, 1998). Qualquer que seja a comunicação, está-se na presença de um emissor que lança uma mensagem possuindo conteúdo e forma, visando atingir um objetivo, e endereçada a um ou vários receptores. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.62 Quem fala? Para dizer o quê? A quem? Como? Com que resultado? De acordo com BERELSON (in GRAWITZ, 1976, p. 623), a Análise Léxica e a Análise de Conteúdo podem ser aplicadas nos casos que requerem maior precisão ou objetividade. Pode-se aplicar este tipo de técnica de análise de dados de várias formas, envolvendo diferentes fontes de dados. As comparações e evoluções formam o principal campo da Análise de Conteúdo, onde se aplica portanto a utilidade da Análise Léxica para basear toda uma evolução. Quando suficientemente definidas, detalhadas e analisadas em conjunto, permitem-nos passar de uma simples descrição e alcançar o objetivo de toda pesquisa científica: a descoberta de explicações e relações causais (FREITAS, MOSCAROLA e JENKINS, 1998). Freitas & Janissek – Análise léxica e Análise de conteúdo – p.63 4. Aplicações de análise qualitativa em gestão e em sistemas de informação A aplicação e utilidade da análise de dados qualitativos, vistas a partir das técnicas de Análise Léxica e de Análise de Conteúdo recém revisadas, pode ser verificada se valorizarmos diferentes estudos que têm sido desenvolvidos dentro da gestão e mais especificamente na área de sistemas de informação e decisão. A seguir, alguns destes estudos são resgatados. KIRK e MILLER (1986, p.24-29, p.33-40, p. 43-49), WEBER (1990) e MILES e HUBERMAN (1994) descrevem alguns exemplos básicos de aplicação. A exploração automática e sistematizada de informações geradas a partir do próprio uso de sistemas por clientes ou usuários finais tem sido muito valorizada ultimamente: um exemplo é o fato de o navegador Internet ser surpreendido com um ‘bom dia” personalizado já no seu segundo acesso a um dado site Internet, bem como ver oferecida uma lista de produtos adequada a aspectos (ou palavras-chave) identificados quando de sua última conexão. Em FREITAS (1993) e FREITAS e BALLAZ (1993), apresenta-se estudo no qual eram analisados os ‘traçados’ ou dados gerados e armazenados automaticamente a partir da interação do usuário com uma interface disponibilizada remotamente (a experiência do minitel francês foi pioneira nesse sentido): a partir disso, mesmo uma tipologia de usuários seria possível. Era então chamada a atenção para aspectos da mineração de dados, bem como de sua exploração comercial ou mesmo para melhoria do próprio sistema. A análise do conteúdo dos dados gerados por cada um era o foco da questão. Vários estudos estão sendo realizados por nossa equipe (GESID http://www.ppga.ufrgs.br/gesid), enfatizando procedimentos para mineração de dados (GONÇALVES,1999 e BERNARDES, 1999). Freitas & Janissek – Análise léxica e Análise de conteúdo – p.64 Uma outra aplicação bem interessante é a de um projeto nosso, no qual dados simples são estruturados e colocados em um só espaço para aplicação de técnicas de datamining: trata-se aqui dos anais dos congressos da ICIS (International Conference on Information Systems) e da AIS (Association for Information Systems), hoje na sua maioria disponíveis via Internet ou CD-ROM, bem como da ANPAD (Associação Brasileira dos Programas de Pós-Graduação em Administração). Estruturou-se uma base de dados (com campos como “conferência”, “sessão”, “autores”, “título”, “resumo”, etc), e então se tem condições de explorar e de comparar dados, com a identificação de especificidades e de principais temas. Pode-se ter uma idéia de quão “mundiais” são estes encontros, identificando ainda temas, pessoas e universidades para intercâmbio, como numa pesquisa de literatura. Em FREITAS (2000), com base em dados dos anais da AIS 97, ICIS 96 e 97, da ECIS (European Conference) 1996 e 97, e do Enanpad Adminfo 1995-97, foram indicados elementos interessantes e curiosos sobre a área acadêmica de administração da informação. De fato, isso constitui uma base de dados para análises em projetos futuros, contendo a parte de referência essencial dos anais dos congressos: aplicando a técnica de análise de dados qualitativos, é possível oferecer uma idéia geral sobre o que está sendo agora feito na comunidade mundial, as tendências de temas e métodos, bem como é possível focar o esforço de revisão de literatura de projetos ou estudantes de nossas equipes. Pode-se ainda imaginar outras aplicações, como a de MOSCAROLA (1996), a qual diz respeito à busca (datamining) na Internet de um debate eleitoral nos EUA: “Dole versus Clinton” imediatamente após sua realização. Este é um campo de aplicação interessante, o da análise dos discursos, seja dos documentos estratégicos ou de políticas de uma organização, seja este do debate político eleitoral. A exploração desses dados apontou que os Freitas & Janissek – Análise léxica e Análise de conteúdo – p.65 candidatos não estabeleceram um debate: pode-se saber quem disse o que, o que foi original em cada um, como cada um abordou certos temas como educação ou economia, etc. Pode-se saber que, no caso, as intervenções de Clinton eram de em média 19 palavras contra 14 de Dole, ou ainda identificar as expressões que se repetiam no discurso de cada um (Clinton: worked hard, better of than we were four years ago; e Dole: economic package, people watching). Quantas pessoas assistiram a este debate e puderam ter rapidamente esta mesma percepção? Em parceria PPGA/UFRGS, IEL/FIERGS e SEBRAE/RS, foi realizada a pesquisa “indicadores da qualidade e produtividade”, envolvendo 120 empresas gaúchas, cujo relatório executivo permitiu traçar um primeiro diagnóstico com dados seriamente coletados e analisados acerca da situação da indústria gaúcha quanto aos programas de qualidade. Um terço dos 300 dados coletados com cada um dos 240 entrevistados (diretores de RH e de Qualidade ou Industrial) eram qualitativos: muitas curiosidades e inconsistências entre discurso e ação de fato foram apontados na época (RUAS, PIRES, FREITAS, ANTUNES, e CUNHA Jr, 1994). Um estudo de 2 anos foi realizado num hospital-universitário, usando a técnica de Focus Group para coletar dados em diferentes grupos de profissionais envolvidos no processo organizacional e educacional (gestores, médicos, professores, enfermeiros, etc). Os dados analisados ajudaram na definição de um prontuário essencial do paciente, com importantes modificações na gestão da informação corporativa e operacional. Este estudo foi apresentado na Argentina, Austrália, Brazil, Canadá, e EUA. Importantes ganhos foram realizados no Hospital (STUMPF e FREITAS, 1996). Foi realizada uma survey cross-cultural exploratória para se buscar identificar perfis de tomadores de decisão, envolvendo uma centena de gerentes de Brasil, França e EUA (285 ao todo): 72 Freitas & Janissek – Análise léxica e Análise de conteúdo – p.66 diferentes dados foram coletados (FREITAS, MOSCAROLA e MACADAR, 1996; MACADAR, COSTA, FREITAS, BECKER e MOSCAROLA, 1997). O processo de pesquisa, para definição dos instrumentos (FREITAS, BECKER, ZANELA, MACADAR, MOSCAROLA e JENKINS, 1998; MACADAR, 1998), bem como para realização e análise foi muito meticuloso (FREITAS, JENKINS, MOSCAROLA, BECKER, ZANELA e MACADAR, 1998; COSTA, FREITAS e BECKER, 1998). Este projeto exigiu muitas horas na codificação e validação de protocolos de análise, definição de dicionários para poder analisar cada uma das questões abertas. Além dos perfis ricos em detalhes sobre os decisores nos 3 países (http://www.adm.ufrgs.br/professores/hfreitas/decision), todo processo de definição e análise, bem como todo instrumental foi descrito (FREITAS, MOSCAROLA, JENKINS, BECKER, ZANELA e MACADAR, 1998; ZANELA, 1999). Neste caso, três analistas debateram suas discordâncias na criação de categorias de análise e mesmo quanto à composição de cada categoria, definindo dicionários específicos para análises automatizadas de textos-opiniões. Em outra survey realizada, coletou-se dados para melhor subsidiar o processo de Planejamento de SI de uma organização. Nosso objetivo aqui é unicamente ilustrar a aplicação do uso de análise de dados qualitativos via análise de conteúdo ou análise léxica. A partir de entrevistas com 300 gerentes em uma organização estatal americana de gestão dos transportes, foram levantados dados para identificar os principais fatores críticos de sucesso, as barreiras à adoção de novas tecnologias ou soluções, e outros aspectos. As respostas foram livres, depois digitadas, e uma análise de conteúdo foi realizada: a partir da leitura de cada resposta, o analista e equipe criaram um novo código, gerando novas variáveis (fechadas desta vez, e não mais abertas como as originais). Estes novos códigos, a partir de Freitas & Janissek – Análise léxica e Análise de conteúdo – p.67 dados abertos, foram cruciais nas decisões tomadas na sequência do projeto (JENKINS, FREITAS, ARSHAM e equipe, 1998). OLIVEIRA (1999) divulgou tese na qual definiu uma série de indicadores para tomada de decisão na etapa de concepção de um processo construtivo: os dados foram levantados a partir de técnicas como focus group, survey e estudo de caso. Foram consultados grupos de pessoas diferentes, a saber: usuários de edificações, projetistas e construtores. Este trabalho detalha o método de análise e de validação da informação de forma exemplar. Diversos estudos aplicados com análise de dados qualitativos, como a “comunicação interna num banco comparada com as expectativas dos clientes”, foram realizados por MOSCAROLA (1990, 1993, 1994, 1995). Neste estudo, o autor analisou o conjunto dos documentos que o banco comunicava aos seus clientes, bem como foram entrevistados clientes do banco, evocando sua relação com o mesmo. O banco falava do produto, enquanto que o cliente falava de seus problemas; o banco falava do quanto ele é bom e o cliente falava sobre as dificuldades nas quais se encontrava. Os dados obtidos comprovavam evidências que muitas vezes são contundentes, mas nem sempre percebidas, e que podem determinar o sucesso de um empreendimento. DOMENJOZ, GAVARD-PERRET e MOSCAROLA (1995), no artigo “Price and communication: how do they interrelate? an analysis of car advertisements published in English”, analisaram o conteúdo de 52 publicidades de carro usando um protocolo de observação; combinando observações descritivas e subjetivas da mídia, codificando a parte visual numa grade. A análise léxica foi aplicada para determinar como o preço se expressa e como a faixa de preço determina tipos específicos de mensagem ou temas em relação à mídia e aos mercados. Atualmente, diversos outros estudos estão sendo realizados em nossa equipe (http://www.ppga.ufrgs.br/gesid) ou de certa forma com Freitas & Janissek – Análise léxica e Análise de conteúdo – p.68 nosso acompanhamento: estudos sobre gestão do conhecimento (BOFF, 1997), sobre escolhas em orçamento público (DORNELAS, 1999), sobre variáveis importantes na tomada de decisão gerencial (LUCIANO, 1999). Um estudo ao qual nos dedicamos particularmente é sobre a influência da implementação de sites Web em negócios empresariais (JANISSEK, 1999 e 2000). Neste estudo, dados relativos ao uso da Internet em organizações foram levantados a partir de entrevistas estruturadas abertas: o conteúdo foi analisado e foi possível criar categorias sobre as principais opiniões emitidas pelos respondentes (este estudo é apresentado em detalhe na Seção 6, ilustrando uma aplicação prática envolvendo de forma complementar as análises léxica e de conteúdo). Freitas & Janissek – Análise léxica e Análise de conteúdo – p.69 5. Ferramentas para Análises Léxica e de Conteúdo O progresso da tecnologia da informação e dos sistemas hoje disponíveis facilitam a aplicação das técnicas de Análise Léxica e de Análise de Conteúdo, entre outros procedimentos científicos de exploração de dados qualitativos. Pode-se ‘surfar’ ou ‘navegar’ pelos textos e rapidamente obter algumas noções básicas ali contidas. Uma grande variedade de investigação e mesmo de novas e diferentes leituras se torna possível. Contudo, isto não deve mascarar a dificuldade final de interpretação inerente a este processo. Dedicação e paciência, aliados à curiosidade, são as características importantes que o pesquisador ou analista deve desenvolver nesse campo (FREITAS, 2000). A evolução da análise de dados tipo texto oferece hoje soluções combinando: a estatística léxica e os métodos de análise de dados, a análise sintática, e a navegação léxica ou ‘surfing’ e a leitura assistida por computador. As tecnologias disponíveis são bem mais poderosas que antes. BARDIN (1996, p.181) descreve algumas consequências do uso de ferramentas computacionais na realização de análise de dados textuais: o aumento da rapidez (processo); a possibilidade de maior rigor na organização da pesquisa (com a consequente menor ambigüidade); a flexibilidade é reforçada, podendo-se reutilizar os dados para verificação de novas hipóteses; a facilidade de padronização, reprodução e troca de documentos; a possibilidade de manipular e explorar dados complexos; enfim, o estímulo à criatividade e reflexão pela liberação do pesquisador de tarefas repetitivas e maçantes. No entanto, a análise de dados tipo texto não muda o significado essencial dos dados. Mesmo se a análise reduz o ‘ruído’ contido nos dados, a redução de uma longa leitura e a rápida ou Freitas & Janissek – Análise léxica e Análise de conteúdo – p.70 apressada chegada a conclusões conduz todos analistas a uma leitura dita interpretativa. A interpretação é frequentemente perigosa, parecendo ser “rápida e falsamente objetiva”: MOSCAROLA (1994, 1995) aconselha que se tenha cuidado na investigação e nas conclusões. Quanto à aplicação de ferramentas computacionais, BARDIN (1996, p.180) destaca a importância de seu uso quando a unidade de análise é a palavra e o indicador é de frequência (ocorrência das palavras); quando a análise é complexa e comporta um grande número de análises a tratar simultaneamente; quando se deseja realizar uma análise de co-ocorrências (repetição de uma mesma palavra no mesmo depoimento); quando a pesquisa implica em diversas análises sucessivas; enfim, quando a análise demandará ao seu final operações estatísticas e numéricas mais complexas. KELLE (1995, p.18-28) apresenta idéias que devem ser também consideradas sobre a confiabilidade das ferramentas utilizadas. De fato, o uso dos computadores, mecanizando questões manuais em análises, sejam elas qualitativas ou quantitativas, vem auxiliando as análises de dados e tornando seu processo mais sistemático, ágil, rigoroso e transparente. Não obstante esse aperfeiçoamento no processo de análise, os computadores também podem auxiliar métodos de obtenção de validade em pesquisas qualitativas, de duas maneiras: de um lado podem assistir ao gerenciamento de grandes quantidades de dados (análises de dados quanti) e em segundo lugar, facilitar a recuperação e obtenção de todas as informações relevantes sobre certos tópicos analisados. Isso incrementa a veracidade de resultados qualitativos consideravelmente visto que estas facilidades podem assegurar que as hipóteses desenvolvidas sejam reais. A aplicação de critérios desenvolvidos no contexto da pesquisa experimental, como a replicabilidade (KRIPPENDORFF, 1980), Freitas & Janissek – Análise léxica e Análise de conteúdo – p.71 poderia claramente ir contra as intenções de indagações qualitativas (KELLE, 1995, p.22). Apesar disso, os conceitos de validade tradicionais merecem uma atenção especial: o conceito de validade não é prover uma perfeita concordância entre os resultados dos pesquisadores e a realidade, mas identificar possíveis fontes de erro. O ponto de vista entre o uso de computadores e a validade refere-se a uma abordagem que permite examinar dois dos maiores problemas para pesquisas qualitativas: (1) resultados amostrais, que se relacionam ao fato da amostra ser ou não ser representativa. Descobrir novos fenômenos através de uma análise cuidadosa em estudos de caso ou estudos de campo podem prover novos e proveitosos insights, mas é importante lembrar que estes não são generalizáveis. Outro problema é em relação à (2) consistência e confiabilidade da aplicação do plano de codificação. Muitos pesquisadores qualitativos usam exclusivamente ferramentas para auxiliar suas análises de dados qualitativos. Recentes investigações têm demonstrado que a implementação de métodos auxiliados por computadores por pesquisadores que não tem usado métodos de codificação pode causar dificuldades em desenvolver um plano de codificação comum ou aplicá-lo como um plano consistente. Em ambos problemas os computadores podem ser ferramentas úteis para identificar fontes de erros. Várias são as técnicas e métodos que podem ser utilizadas em conjunto para o levantamento, tratamento e análise de dados: amostragem, questionário, estatísticas de dados e análises de dados, síntese e comunicação (MOSCAROLA, 1990). Mas de que forma um dos muitos softwares que hoje permitem tal feito poderia ser utilizado para analisar dados qualitativos? Primeiramente, tem-se que ter bem claro que um software NÃO irá analisar dados. Ele irá auxiliar ou facilitar a análise feita por uma pessoa, mas jamais substituí-la. A formatação de dados, a tabulação destes, sua apresentação e até Freitas & Janissek – Análise léxica e Análise de conteúdo – p.72 mesmo seu tratamento são tarefas possíveis de serem executadas por programas de computadores, desde um simples editor de textos até o mais sofisticado software de datamining, e estes sim são o que podese chamar de procedimentos para auxílio à análise de dados. Na última década, vários destes sistemas foram desenvolvidos, o que de certa forma permitiu que cada vez mais o uso de computadores pudesse reduzir muito o tempo de análise, permitindo que o analista se concentrasse na análise de fato, e não passasse incansáveis horas tabulando dados, organizando dados, formatando dados, enfim, procedimentos esses que poderiam ser feitos de forma sistemática e explícita, assegurando totalidade e refinamento, além de permitir flexibilidade e revisão nos procedimentos de análise. Com a difusão da literatura nessa área, várias obras têm sido criadas, divulgadas e utilizadas por pesquisadores. Não somente o desenvolvimento desse tipo de software tem aumentado rapidamente, como também o uso destes em estudos qualitativos tem sido realizado em diferente áreas, englobando por exemplo: edição, revisão ou mesmo correção de anotações de pesquisa, codificação para posterior facilitação de pesquisa, busca e recuperação, relacionamento ou ligação entre dados de pesquisa, armazenamento (de forma organizada), análise de conteúdo, construção de teorias, mapeamento gráfico (diagramas), etc (WEITZMAN e MILES, 1995, p.4-5). Estes mesmos autores citam vários sistemas que podem ser utilizados para auxílio à análise de dados: (1) tratamento ou recuperação de textos (localização de documentos com base em palavras), (2) gerenciamento de textos (recuperar documentos e ajudar na sua seleção de forma organizada e sistemática), (3) programas para codificação e recuperação (recuperar documentos a partir de palavras-chave ou códigos), (4) programas construtores de teoria baseados em códigos (com recuperação de documentos e com funções de concepção de estruturas conceituais, anotações, e ainda formulação e teste de Freitas & Janissek – Análise léxica e Análise de conteúdo – p.73 hipóteses), e (5) programas de concepção de redes de relações, os quais ajudam a formular e representar esquemas conceituais através de uma rede de ‘nós’ e ‘ligações’, podendo assistir todo o tipo de análise qualitativa de dados. Os autores apresentam 24 softwares, suas características, suas utilidades, enfatizando a prática da escolha dos mesmos a partir de questões que dizem respeito ao uso que deles será feito. Vários desses programas possuem algumas características semelhantes, porém com configurações distintas. A escolha pelo melhor software depende do nível de envolvimento do usuário com o computador, tempo dedicado a isso, tipo de projeto, expectativas sobre o projeto e ainda o tipo de análise que deseja fazer. Uma lista de sistemas é avaliada pelos autores (p.25), destacando-se produtos como Atlas/ti, QCA e Nud-ist. Além disso, pode-se citar PREIN, KELLE e BIRD (apud KELLE, 1995, p.190-210), os quais avaliam estes e outros sistemas de forma sistematizada e consistente. Algumas das características a serem avaliadas quando da escolha de um sistema a utilizar para o tratamento de dados são (WEITZMAN e MILES, 1995, p.9-15): que tipo de usuário eu sou? Estou escolhendo o software para trabalhar um projeto em particular ou para trabalhar com vários projetos nos próximos anos? Sobre que tipo de projeto e base de dados eu estarei trabalhando? Que tipos de análise estou planejando realizar? Quais as restrições financeiras do projeto envolvido? Qual a importância de manter os dados reservados ou com acesso restrito? Diversos aspectos devem também ser observados, como os que se seguem: o tipo de base de dados (única x múltipla), se serão casos únicos ou múltiplos, se os registros serão fixos ou sujeitos a revisão (dinâmicos), se os dados serão estruturados ou abertos, se as entradas serão uniformes ou diversas, qual o tamanho da base de dados, que tipo de análises se pretende fazer, se será exploratória ou confirmatória, qual o esquema de codificação (bem Freitas & Janissek – Análise léxica e Análise de conteúdo – p.74 definido desde o início ou evolutivo), se a codificação será simples ou múltipla, será interativa ou de uma só passada (única), qual o grau de análise (sumária ou detalhada), qual o interesse no contexto dos dados, quais as intenções de exposição ou demonstração dos resultados (e quais necessidades de elaboração), enfim, se deseja-se uma apresentação qualitativa ou quantitativa (com números). Além da flexibilidade e da interface amigável, sempre desejáveis em um sistema, as ferramentas devem incorporar um conjunto particular de funções para realizar análise qualitativa (Figura 7): a flexibilidade diz respeito à possibilidade do programa trabalhar de diversas maneiras com seus dados, permitindo a adaptabilidade ou incremento de funções que permitam um melhor desempenho das funções requeridas para tratamento dos dados, como inclusão de macros, criação de novas rotinas, customização, adaptação, entre outros. Outra característica quase que obrigatória nos tempos atuais é a interface amigável com o usuário: quão difícil é aprender o manejo do software? Uma vez que você aprenda a trabalhar com ele, quão fácil é seu uso? O tempo e esforço requeridos para aprender e usar o programa são justificados em termos do que você está conseguindo? Quão bom é o suporte - manual, documentação, tutoriais, atendimento, helps, suporte técnico? Qualquer decisão de escolha deverá levar em conta tais questionamentos, envolvendo principalmente o pesquisador e seu trabalho como focos principais. Conhecer as necessidades e estar apto para reconhecer coisas que você irá ou não encontrar nestes softwares são fatores fundamentais nesse tipo de escolha (WEITZMAN e MILES, 1995, p.22). Da mesma forma, LEE e FIELDING (apud KELLE, 1995, p.29-40) discutem sobre aspectos inerentes à escolha de sistemas computadorizados para tal fim. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.75 Caixa de título Nome do sistema, sistema operacional que requer, autor, endereço, email, www, preço, requisitos de hardware, etc. Apreciação sumária, como instalar e operar, com o que se assemelha, o que se pode fazer com ele, suas principais forças e características. Como o sistema organiza os seus dados. Avaliação global Estrutura de base de dados Entrada de dados Trabalhando com os dados Localização e busca Apresentação dos dados Construção de teorias Edição gráfica Interface amigável Outras oportunidades Atualização Comentários comparativos Referências sumárias Como você insere seus dados no sistema e os prepara para análise. Como você codifica, seleciona e explora seus dados, como faz anotações, como os dados se relacionam. Como se busca e localiza itens nos dados (trechos, palavras) que necessita para análise. Como o sistema oferece os resultados, e com que recursos e métodos (tela, impressora, arquivos, etc). Como o sistema ajuda a pensar de forma sistematizada sobre os dados, desenvolver proposições ou hipóteses, testá-las, bem como gerar uma explanação coerente do que se está descobrindo. As habilidades do sistema para trabalhar com os dados e resultados de forma esquemática, interrelacionando dados e resultados. A facilidade de aprender o sistema, o suporte que o sistema oferece ao aprendizado, e a sua facilidade de uso uma vez aprendido. Qualquer aspecto de interesse e que não se encaixe em outro lugar, incluindo automação, facilitação, customização, etc. Informações recentes do autor do sistema sobre melhorias potenciais a serem implementadas, etc. Comparações com outros sistemas que podem fazer operações similares. Pontos específicos inerentes a este sistema (manual, artigos essenciais sobre seu uso,etc.). Figura 7 - Características desejáveis em um sistema de auxílio à análise de dados qualitativos. Adaptado de WEITZMAN e MILES (1995, p. 23-24) Freitas & Janissek – Análise léxica e Análise de conteúdo – p.76 WEBER (1990, p.80-82) descreve experiências embrionárias de informatização da análise de conteúdo, como também BARDIN (1996, p.178-205). KELLE (1995) publicou uma obra com 22 colaboradores, na qual debate as questões inerentes à pesquisa qualitativa e seu instrumental, em especial o suporte computacional para análise de dados qualitativos. Algumas das principais ferramentas existentes para auxiliar a realização da Análise Léxica e da Análise de Conteúdo são as que de fato permitem, além do tratamento normal dos dados, recém descrito, aprofundar-se em vários tipos de procedimentos que gerem ou apresentem os dados de tal forma que seja possível a inferência de informações sobre os mesmos. Entre tais procedimentos, tem-se (1) as técnicas estatísticas como matrizes simétricas, diagonalização, entre outros; (2) análises de correlações e cálculos de coeficientes, regressão múltipla de dados, correlações lineares, etc; (3) análise discriminante, (4) análise de variância, entre outras que permitem o tratamento dos dados (LAGARDE, 1995; MOSCAROLA, 1990; PEREIRA, 1999). Moscarola e Lagarde são professores franceses na origem do sistema Sphinx (http://www.sphinxbr.com.br), em constante aperfeiçoamento por equipe franco-brasileira (hoje formada por Jean Moscarola, Yves Baulac e Henrique Freitas), e utilizado para as ilustrações da Seção 6 a seguir. No exemplo desenvolvido passo a passo, é examinada uma pesquisa com questões abertas e suas devidas análises: após uma ilustração prática inicial, desenvolvem-se alguns conceitos sobre análise léxica (com base na quantificação de palavras e expressões usadas nas respostas), a qual age como facilitador para, na sequência, realizar uma análise de conteúdo (com base em códigos e interpretações a partir das respostas). Freitas & Janissek – Análise léxica e Análise de conteúdo – p.77 6. Aplicação de análise de dados qualitativos: pesquisa sobre internet e negócios Está claro que a análise de um texto passa pelo estudo do vocabulário utilizado (LEBART e SALEM, 1994, p.247). Para ilustrar a análise de dados textuais conforme os preceitos descritos até o momento, evoluindo da Análise Léxica e tomando-a por base para a Análise de Conteúdo, é apresentada a seguir a sequência de análise de um caso. Tratam-se de dados de uma pesquisa realizada em 1999, no contexto de investigação de uma dissertação sobre a influência da Internet em negócios empresarias (JANISSEK,1999 e 2000). O levantamento de dados se deu em duas organizações (o HSA, Hospital de Caridade de Santo Ângelo, e a Mattiazzi Construções, empresa do ramo de Construção Civil de Santa Rosa, com atuação em todo o estado do RS), com 6 pessoas entrevistadas em cada uma, isto dentro de uma primeira etapa do estudo. O objetivo desta etapa era identificar categorias que definissem os elementos estudados (previamente definidos como por exemplo análise de mercado, clientes, fornecedores, custos, etc) para, numa segunda etapa, conseguir identificar quais das categorias emergentes, dentro do contexto de cada elemento, seriam de maior importância e permitiriam verificar os impactos desta tecnologia. A ferramenta de apoio utilizada para o registro das entrevistas, a gestão e preparação dos dados coletados, bem como para as análises, foi o sistema Sphinx 5. As respostas obtidas através de entrevistas, as quais foram compostas por perguntas abertas (uma para cada elemento investigado), permitiram formar o corpo de texto a ser analisado. Este 5 Sphinx ® (http://www.sphinxbr.com.br) é um sistema de concepção de pesquisas e de análise de dados quanti-qualitativos, com múltiplas possibilidades de cruzamentos e testes estatísticos, permitindo a análise léxica ou a análise de conteúdo das questões abertas tipo texto. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.78 texto gerado pelas entrevistas pode ser analisado pelo seu próprio conteúdo, permitindo daí fazer emergir categorias, ou então pode ser analisado de acordo com categorias particulares já definidas (baseadas na literatura ou curiosidade de investigação), para ver se é específico de uma categoria particular de entrevistados (LAGARDE, 1995). Para ilustrar a maneira segundo a qual julgamos adequado realizar uma análise em dados deste tipo, apresenta-se a seguir uma evolução de etapas de análise, começando pela Análise Léxica e partir dela para a efetivação – em melhores condições e conhecimento de causa - da Análise de Conteúdo. Nosso intuito aqui é apresentar e valorizar as idéias de sequencialidade, recorrência e complementaridade entre as duas análises (léxica e de conteúdo). Na sequência, são descritas as questões abertas da pesquisa objeto da aplicação (6.1), bem como é discutido um plano de análise de dados (6.2). As palavras e expressões são investigadas pela Análise Léxica (6.3) e as categorias são inferidas ou induzidas em dois procedimentos de Análise de Conteúdo (6.4), o que é encerrado com um aprofundamento e Análise de Correspondência (6.5). Freitas & Janissek – Análise léxica e Análise de conteúdo – p.79 6.1. As questões abertas da pesquisa A etapa de pesquisa aqui abordada continha 10 perguntas essencialmente abertas, obtendo-se 120 pequenos textos provenientes de 12 entrevistados: estes depoimentos indicam a percepção dos respondentes com relação aos 10 elementos questionados. A Figura 8 apresenta os elementos estudados, bem como algumas das colocações feitas aos respondentes na condução das entrevistas. As questões foram todas colocadas em função da Internet e da possibilidade desta interferir no desenvolvimento ou rotinas dos elementos estudados, de certa forma inerentes a questões organizacionais, de comunicação e de marketing. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.80 Elemento Estudado Exemplo de colocação na entrevista para coleta da resposta ou dado aberto 1.Análise de Mercado Fale sobre sua percepção acerca de como é feita a Análise de Mercado em sua empresa e de que forma a Internet poderia auxiliar neste processo. 2.Atuação Uma vez identificadas necessidades e características do mercado onde vocês atuam, de que forma sua empresa posiciona-se para atuar? 3.Aquisição e Distribuição de De que forma é feita a Aquisição e Distribuição de Conhecimentos em Conhecimentos sua empresa e de que forma a Internet poderia auxiliar? 4.Atualização Quais os procedimentos adotados na empresa para Atualização das pessoas, tanto a nível pessoal quanto corporativo? De que forma a Internet poderia auxiliar? 5.Clientes De que forma são feitos os contatos com Clientes, tanto a nível de prestação de serviços quanto disponibilização de informações? Como a Internet poderia ser utilizada nesse sentido? 6.Fornecedores De que forma sua empresa hoje contacta com Fornecedores? Você acredita que esses contatos poderiam ser facilitados com o uso da Internet? 7.Custos Uma vez que sua empresa esteja utilizando Internet, você acredita em redução ou aumento Custos para a realização de atividades? 8.Decisão Como são embasadas as Decisões tomadas dentro da sua empresa? E de que forma você acredita que a Internet interfere ou poderia auxiliar nisso? 9.Imagem Corporativa Quais os procedimentos adotados pela empresa em relação ao estabelecimento de sua Imagem Corporativa? A Internet interfere neste processo? Como? 10.Vantagem Competitiva Você acredita que sua empresa pode obter ou manter Vantagem Competitiva estando posicionada na Internet? Figura 8 - Elementos e exemplo de questões ou colocações durante as entrevistas Freitas & Janissek – Análise léxica e Análise de conteúdo – p.81 Das 10 perguntas abertas evocadas, optou-se por desenvolver a ilustração das análises objeto deste livro com o processamento dos textos das respostas da questão nº 1, a qual diz respeito à Análise de Mercado. Serão examinadas, portanto, as respostas à seguinte questão (Figura 9): Elemento Estudado Exemplo de colocação na entrevista para coleta da resposta ou dado aberto 1.Análise de Mercado Fale sobre sua percepção acerca de como é feita a Análise de Mercado em sua empresa e de que forma a Internet poderia auxiliar neste processo. Figura 9 - O elemento tomado para exemplo das análises léxica e de conteúdo Freitas & Janissek – Análise léxica e Análise de conteúdo – p.82 Eis algumas das respostas obtidas a partir desta questão aberta (Figura 10): Respostas da Questão sobre Análise de Mercado Entrevistado 1 - quanto à concorrência hoje se faz uma análise de concorrência, mas principalmente em nível de preços, em nível de preços serviços, preços de diárias, preços de taxas, que eles estão cobrando, e essa pesquisa é feita assim ó: alguns hospitais parceiros da gente que tem uma relação mais tranquila, e que normalmente são fora de Santo Ângelo, a gente liga e pergunta os preços, pede tabela de preços, e daí a gente manda a nossa, para comparar e ver se está coerente ou não, e essa troca de informações se dá desse jeito. Para hospitais concorrentes nossos, vamos chamar assim, os de Santo Ângelo, a gente adota estratégias diferentes para verificar preços, eu peço para alguém que não tem nada a ver ligar, perguntar algum preço como se fosse se internar, ou fazer algum exame, enfim. Então é nesse sentido que a gente acompanha e monitora os preços da concorrência. Quanto a novos serviços, novos produtos, a maioria das vezes para gente conseguir novos serviços, na sua maioria eles são terceirizados, tipo tomografia, ecografia, ressonancia, essas coisas. Estamos seguidamente buscando esses novos serviços, inclusive agora a oncologia que é um serviço super importante, mas mais em nível de se conseguir profissionais para isso. A identificação dessas coisas novas se dá através de tudo um pouco, através de visitas a outros hospitais maiores, através de conversas com pessoas conhecidas, é nesse sentido que a gente procura identificar o que se está precisando, o que o público precisa, assim a gente busca novas tecnologias, novos serviços, até mesmo em nível de atendimento, mudanças de sistemáticas de atendimento a cliente, por ex. nós tínhamos um tempo atrás por exemplo uma internação só. Daí visitamos outros hospitais e vimos que faziam separado, uma para SUS e outra para convênios. Achamos legal e implantamos. A Internet nesse sentido ainda não tem sido muito usada. Há uma perspectiva inclusive pelo avanço da Internet, de cada vez mais a gente buscar informações pela Internet, principalmente agora com o programa de qualidade que a gente está implementando, nós estamos usando bastante a Internet para acessar site de outros hospitais para ver o que está sendo feito para a gente usar aqui ou até mesmo pular etapas. Entrevistado 2 - acho que o hospital não faz isso. Estamos tentando implantar isso agora com a nova administração, mas acho que não existe nada oficial assim para isso, ainda não. Ele está tentando assim trazer novos serviços para cá, estão tentando ampliar um pouquinho mais, mas o problema do hospital é que nós paramos muitos anos. Então agora assim, de 4 anos para cá que as coisas estão começando a engrenar de novo. Mas é um processo longo. ... Entrevistado 12 - eu acho assim ó, sempre é positivo olhar o que o teu concorrente está fazendo, porque sempre tu vai poder trazer algo para dentro da tua empresa ou ver o que ele está fazendo, ou ver como você está em relação aos outros. Aqui na empresa a gente trabalha sempre com os olhos e ouvidos abertos ao que está sendo feito pelos outros. A Internet, especificamente, eu não uso muito, mesmo porque eu não tenho aqui na minha máquina. Quando eu preciso eu subo ali no Jonas e vejo alguma coisa junto com ele. Eu realmente espero ter logo o acesso a Internet aqui comigo logo porque daí a gente pode olhar para fora (para o mercado) não somente da forma tradicional, mas através da Internet também, que eu acho bem positivo. Eu não uso a Internet por não ter o hábito, por não ter tempo durante o expediente para fazer isso e também porque o que eu faço, essa parte financeira, está pouco ligado com a Internet. Figura 10 - Exemplos de respostas sobre “Análise de Mercado” Freitas & Janissek – Análise léxica e Análise de conteúdo – p.83 6.2. Como analisar os dados qualitativos? É nossa convicção que é fundamental compreender que diferentes análises podem ser realizadas a partir de uma mesma base de dados qualitativos, em especial que um mesmo dado aberto pode servir de base para diversas codificações ou análises, bem como também é fundamental que se perceba que as técnicas podem e devem ser usadas de forma complementar, possibilitando uma mais rica e convicta codificação. É, pois, necessário que se tente definir um plano de análise ou um esquema que permita ver claramente quais as etapas de análise a realizar e de que forma fazer uso combinado de técnicas e ferramentas. BARDIN (1996, p.125-133) discute sobre a organização das atividades de análise de dados, envolvendo pré-análise, exploração do material e análise (tratamento dos resultados, inferências e interpretação). A Figura 11 ilustra um esquema que pode servir de referência para tal procedimento, com as devidas adaptações exigidas a cada caso. Na aplicação aqui ilustrada, em particular, os dados fornecidos pelos respondentes sobre a questão Análise de Mercado servem de massa bruta para diferentes enfoques de análise de dados. Inicialmente, convém ter uma rápida compreensão do conteúdo global das respostas, o que pode ser realizado através da Análise Léxica, a qual permite identificar o conjunto de todas as palavras ou expressões encontradas nos depoimentos ou respostas, cada qual com sua frequência de incidência. O resultado desta avaliação (topo ou palavras e expressões mais comumente citadas) servirá então de base para a Análise de Conteúdo, que consiste em uma leitura aprofundada de cada uma das respostas e consequente criação de um código que será registrado em um novo dado. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.84 Figura 11 - Modelo para Análise de Dados Qualitativos COM =categorias assumidas a priori AC = categorias inferidas da pesquisa Freitas & Janissek – Análise léxica e Análise de conteúdo – p.85 Segundo BARDIN (1996), a Análise Léxica pode ser definida como a classificação e contabilização pormenorizada das frequências de um vocabulário. Desta forma, as palavras ou expressões podem ser agrupadas de acordo com o seu significado para subsidiar o pesquisador ou analista nesta fase de categorização. A partir disso, diferentes codificações podem ser realizadas: inferidas (que emergem do próprio texto) ou assumidas ou induzidas (que contém de alguma forma um referencial). Estas duas abordagens são detalhadas na sequência: uma delas permite extrair ou inferir dos dados textuais as principais idéias ali citadas, transformando-as em Categorias inferidas AC 6, as quais representam, no seu conjunto, o total das informações contidas, gerando neste caso o que convencionamos chamar de Tabela AC (ou Tabela de categorias inferidas AC); outra permite que, dado um conjunto pré-definido de categorias com base na literatura ou mesmo em uma suposição ou elaboração conceitual (no caso da etapa de pesquisa aqui ilustrada o protocolo assumido a priori, dito OCM 7), os textos sejam percorridos um a um e analisados sob o enfoque destas categorias pressupostas, permitindo ao final montar uma Tabela induzida ou, neste caso, Tabela induzida OCM, com a frequência em que tais categorias apareceram no texto. 6 Tabelas de categorias AC foram assim designadas neste artigo por se referirem ao conjunto de categorias geradas (inferidas) a partir da Análise de Conteúdo. 7 Protocolo OCM e Tabela OCM referem-se ao conjunto de categorias das dimensões estudadas na etapa da pesquisa utilizada para ilustração (JANISSEK, 2000), que – após profunda revisão da literatura - são Organização, Comunicação e Marketing. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.86 Como será evocado mais adiante (e já abordado conceitualmente na seção 3), há que se atentar ainda para a questão da validade e confiança das categorizações realizadas. Ao final, as categorias inferidas e induzidas (neste caso, AC e OCM) permitirão, juntamente com outros dados estudados, preencher uma grade de análise e realizar cruzamentos de dados, os quais se pressupõe possam vir a facilitar a compreensão de um certo fenômeno ou situação seja pelo pesquisador, seja pelo analista ou gerente. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.87 6.3. Análise léxica dos dados abertos da pesquisa: palavras e expressões Uma das técnicas de análise de textos (seção 3.1), a Análise Léxica, permite apresentar o conjunto das palavras que compõem o corpo dos textos ou respostas de cada entrevistado, permitindo diversos tipos de contabilização e de navegação pelas respostas, o que será descrito a seguir. Um primeiro método de análise léxica consiste em averiguar ou medir a dimensão das respostas: as pessoas responderam de forma extensa ou concisa? Cria-se uma hipótese de que aqueles que deram respostas extensas têm um interesse maior do que os demais. Uma hipótese discutível que dará, porém, uma indicação (embora nem sempre a maior presença de uma palavra indica que esta tenha sido amplamente referenciada). A Figura 12 apresenta a quantidade de palavras por depoimento: os 12 entrevistados falaram 1970 palavras nos seus depoimentos sobre Análise de Mercado, mas somente 597 diferentes. Um dos depoimentos foi de somente 21 palavras, enquanto o mais extenso foi de 385, o depoimento-médio sendo de 164 palavras, com um desvio-padrão de 134 palavras. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.88 AM_tamanho texto No. cit. menos de 50.0 3 de 50.0 a 100.0 2 de 100.0 a 150.0 2 de 150.0 a 200.0 1 de 200.0 a 300.0 1 300.0 e acima 3 TOTAL OBS. 12 Mínimo= 21, Máximo= 385 Soma= 1970 Média= 164.17 Desvio-padrão= 134.92 Freq. 25.0% 16.7% 16.7% 8.3% 8.3% 25.0% 100% Figura 12 - A quantidade de palavras por depoimento Freitas & Janissek – Análise léxica e Análise de conteúdo – p.89 Na Figura 12, pode-se rapidamente notar que 7 dos 12 respondentes usaram menos de 150 palavras em seus depoimentos, 2 entre 150 e 300 e mesmo 3 com mais de 300 palavras. Cruzando esse dado com os gestores (8) e técnicos (4), verifica-se que 3 dos 4 técnicos usaram menos de 150 palavras para se expressar, ao passo que 4 dos 8 gestores usaram mais de 150 palavras para falar sobre Análise de Mercado: teriam os técnicos tendência a se expressarem menos ou seriam eles mais objetivos? Eis uma questão que poderia ser aprofundada, por exemplo. Na Figura 13, pode-se verificar que no total das 12 respostas, explorando-se todas as palavras, obtém-se alguns indicadores possibilitados pela análise léxica. Neste caso, foi usada a organização (HSA e Mattiazzi) como critério de cruzamento (poderia ser a distinção gestor – técnico, ou sexo, idade...). Nota-se que o pessoal do HSA (1074 no total, em média 179 palavras) falou um pouco mais que o pessoal da Mattiazzi (896 no total, em média 149), contudo o índice de repetição do pessoal do HSA é mais elevado. Outros indicadores são oferecidos, mas seu uso teria de ser num grau de detalhe que nem sempre é explorado, depende da natureza da investigação e do interesse do analista. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.90 Frequência da categoria Quantidade total de palavras Comprimento médio Quantidade de palavras diferentes Quantidade de hapax Repetição média Frequência máxima Palavra mais frequente Peso das 148 palavras comuns Quantidade de palavras exclusivas Peso das palavras exclusivas Percentual do corpo Percentual de leitura HSA Mattiazzi 6 1074 179.00 391 191 2.75 51 que 68.2% 243 31.8% 54.5% 86.4% 6 896 149.33 354 164 2.53 35 de 70.1% 206 29.9% 45.5% 82.7% Figura 13 - Análise Mercado: Balanço por contexto Freitas & Janissek – Análise léxica e Análise de conteúdo – p.91 6.3.1. Análise de palavras A análise de palavras consiste em reduzir rapidamente o corpo do texto a um conjunto de palavras que representem a sua essência. O software utilizado deve permitir a análise do conjunto de todas as palavras que compõem o corpo dos textos respondidos (neste caso, cada conjunto de 12 respostas a cada dos 10 elementos, aqui sendo utilizado apenas o elemento Análise de Mercado), permitindo assim diversos tipos de contabilização e de navegação pelas respostas. A Figura 14 apresenta o resultado da lista de palavras (coluna da esquerda), com suas respectivas frequências. São fornecidos outros cálculos de potencial interesse, como a banalidade (trivialidade ou o quão comum é a resposta em relação às outras) e a riqueza (o grau de originalidade das palavras daquela resposta). Freitas & Janissek – Análise léxica e Análise de conteúdo – p.92 Figura 14 - Interface para Análise Léxica do Sphinx ® Freitas & Janissek – Análise léxica e Análise de conteúdo – p.93 Embora o resumo contextual nos dê uma idéia dos tamanhos relativos das respostas e de sua riqueza de linguagem utilizada, ele ainda pode nos dar idéia do próprio conteúdo. Para tal, precisa-se retornar à lista de palavras e identificar aquelas idéias ou palavras chaves. O léxico ou conjunto de palavras pode ser reduzido manualmente ou automaticamente para torná-lo mais manejável: normalmente a redução é primeiro automática, para então ser finalizada manualmente (se necessário). A redução léxica automática é feita através de critérios de escolha estabelecidos, como por exemplo ignorar palavras com menos de 3 letras, ignorar determinadas palavras comuns, ignorar números, etc. (MOSCAROLA, 1996). Após identificar a frequência de cada das palavras do léxico (Figura 14), a partir de uma lista ordenada por frequência de todas as palavras existentes nas 12 respostas, optou-se por reduzi-las a um conjunto de dados "reais", ou de significado, ignorando, por exemplo, palavras com menos de 4 letras, e reagrupando palavras semelhantes, como por exemplo concorrência, concorrentes e concorrente. Na verdade, fez-se a chamada aproximação léxica, ou seja, retirou-se da lista ou “léxico” todas as palavras chamadas “instrumentais” (aquelas que não comunicam diretamente uma idéia ou conteúdo no sentido da análise realizada, como as preposições, os artigos, etc.) e chegou-se então a uma lista de palavras de conteúdo. Esse procedimento (sem agrupar palavras similares ainda) reduziu automaticamente o léxico, em nosso caso, partindo-se de 1970 palavras para 1135, onde 835 palavras foram suprimidas, contudo as palavras de origem (ou diferentes) que eram 597 passaram para 499, não tendo sido reduzidas tanto quanto se poderia esperar. Uma maior redução só poderia agora se dar por agrupamentos de palavras similares. Essa tarefa pode ser feita automaticamente, mas com procedimento de confirmação de grupos de palavras, tudo isso com base em raiz de tamanho n (por exemplo raiz mínima de tamanho 6 ou Freitas & Janissek – Análise léxica e Análise de conteúdo – p.94 7, pois raiz de tamanho 5 ou menor tende a agrupar palavras que normalmente não pertenceriam ao mesmo grupo). Agrupamento por raiz de tamanho 7 nos retornou 40 grupos (exemplo: hospitais, hospital e hospitalar), já um de tamanho 4 resgatou 88 grupos, mas tendo tendência a não serem confirmados, como por exemplo com “comparar, complexa e comprar”. Considerando por raiz 7, passou-se a ter 40 grupos automáticos, ficando então com 446 palavras compondo o léxico. Além disso, pode-se enfim partir para a ordenação de todo o léxico (lista de 446 palavras) por ordem alfabética, e então buscar marcar e reagrupar aquelas que julgamos similares. Após realizada uma cuidadosa redução através dos chamados agrupamentos, parte-se para analisar o contexto de uma determinada palavra. Já aqui se inicia, mesmo que imperceptivelmente, uma análise de conteúdo, pois se baseia fortemente na palavra para chegar até o contexto em que esta foi dita. Este procedimento é de fato interessante porque nos permite a percepção de idéias, sequências ou contexto no qual uma palavra (ou expressão, como veremos adiante) foi citada. Para exemplificar o que foi dito acima, toma-se como exemplo a palavra concorrência, que aparece (é citada) 9 vezes: mas em que contexto? Faz-se a chamada navegação léxica, que consiste em ir diretamente às respostas onde foi citada a palavra em questão (Figura 15). Pode-se exportar estas respostas para um documento em editor de texto se assim o desejar, possibilitando desta forma a edição e formatação do conteúdo em relatórios, documentos, análises, enfim. Este arquivo é chamado verbatim, que significa citação. A navegação léxica permite a restituição das respostas, organizando-as de acordo com seu conteúdo, possibilitando conhecer em que contexto e com que sentido foi empregada à palavra em questão. Pode-se ir além, marcando as palavras que dizem respeito à concorrência e analisando o contexto em que mesma foi expressa. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.95 Figura 15 - O ambiente de uma palavra Freitas & Janissek – Análise léxica e Análise de conteúdo – p.96 Outro procedimento que pode ser feito é cruzar palavras com categorias de respondentes, como cargo, empresa, sexo, etc. Isso pode permitir uma leitura mais objetiva no sentido de identificar a origem de cada termo analisado. A Figura 16 apresenta um exemplo com palavras consideradas chave cruzadas com a categoria Cargo (se gestores ou técnicos), e na qual pode-se identificar por exemplo que os gestores falam mais de ‘mercado’ e de ‘serviços’. BARDIN (1996, p.87) aborda em detalhe a análise das palavras mais frequentes. A unidade representada aqui é baseada nos 12 entrevistados e não na quantidade de ocorrências de cada palavrachave. A ocorrência de palavras por si só deixaria entender que ‘Internet’ é citada 15 vezes por 5 entre 8 gestores e também 7 vezes por 3 entre 4 técnicos, ou então que ‘mercado’ é citada 11 vezes pelos gestores (4 de 8) contra 2 vezes pelos técnicos (1 de 4), assim como ‘serviços’ é uma idéia evocada 9 vezes por 4 de 8 gestores enquanto só 1 é citada por um técnico de 4, e ainda ‘pesquisa’ é citada por 3 gestores de 8 e por 2 técnicos de 4 (porém 10 vezes), e enfim ‘preço’ é enfatizado 9 vezes pelos gestores e nenhuma vez pelos técnicos. Análise de Mercado / Cargo Internet Novos Informações Mercado Pesquisa Serviços Concorrência Produto Gestores (8) 5 3 3 4 3 4 2 2 Técnicos (4) 3 3 2 1 2 1 2 2 TOTAL 8 6 5 5 5 5 4 4 Figura 16 – Exemplo de cruzamento de palavras-chave com cargo Freitas & Janissek – Análise léxica e Análise de conteúdo – p.97 Como demonstrado, várias são as leituras que podem ser feitas a partir de uma mesma lista do léxico. No caso aqui analisado, os cruzamentos principais estão sendo feitos pelo pesquisador entre o elemento (no caso Análise de Mercado) com cargo dos respondentes, sexo e organização. Ao final da análise de cada elemento (são 10), gerou-se uma lista de 40 a 50 palavras que mais aparecem no texto (Figura 17), a qual servirá, juntamente com a lista das expressões abordadas a seguir, para apoiar ou direcionar a Análise de Conteúdo da pesquisa em questão. De novo, na ilustração (Figura 17) aparece a indicação de quantas pessoas fizeram uso de cada palavra, e não o seu número ou quantidade de ocorrências. Acessar Acontecendo Alterações Análise Atendimento Atualizar Avanço Benchmarking Cidade Cliente Comunidade Concorrência 1 2 1 2 1 1 1 1 1 3 1 4 Conseguir Curiosidade Descobrir Diferentes Empreendimento Empresa Englobando Entidades Equipamentos Especialidades Experiência Estratégias 1 1 1 2 1 6 1 1 2 1 1 1 Fornecedores Identificação Indicativos Informações Internet Lançamentos Mercado Monitorar Mudanças Necessidade Negócios Novos 3 1 1 5 8 1 5 1 1 1 1 6 Observações Parceiros Pesquisa Pessoas Preços Produtos Qualidade Relação Serviços Tecnologia Tendência Verificar 1 2 5 5 2 4 1 5 5 3 1 1 Figura 17 - Lista das palavras e quantos entrevistados as utilizaram nas suas respostas (ordem alfabética) Freitas & Janissek – Análise léxica e Análise de conteúdo – p.98 6.3.2. Análise de expressões Ainda que a visão recém mostrada das simples palavras do texto nos permita perceber de forma geral seu conteúdo, a interpretação das respostas pode ser dificultada quando compreendidas fora de seu contexto (MOSCAROLA,1996). Por essa razão, é importante se fazer uma Análise de Expressões, pois permite complementar a Análise de Palavras recém descrita, identificando não somente o contexto das palavras, mas a correspondência entre palavras que apareçam juntas repetidamente dentro do corpo de um texto. Verificar as expressões ou segmentos que se repetem várias vezes no texto permite portanto uma melhor percepção da forma como tais componentes do léxico são apresentados (LEBART e SALEM, 1994, p.58-69). Tais expressões são determinadas em função do comprimento mínimo-máximo, frequência mínima dos segmentos procurados, número de palavras dentro do segmento ou a(s) palavra(s) que deve(m) imperativamente pertencer ao segmento (SPHINX, 1997; MOSCAROLA,1996). BARDIN (1996, p.194) aborda em detalhe a análise das expressões ou segmentos mais frequentes. No exemplo descrito, optou-se por encontrar expressões entre 3 e 10 palavras (e mesmo entre 2 e 10 palavras), que fossem repetidas no mínimo 2 vezes dentro do corpo do texto analisado (Figura 18): Freitas & Janissek – Análise léxica e Análise de conteúdo – p.99 Figura 18 - Opções de busca das expressões repetidas e expressões identificadas Freitas & Janissek – Análise léxica e Análise de conteúdo – p.100 As expressões identificadas foram transformadas numa lista de expressões, como a lista de palavras anteriormente ilustrada. A Figura 19 mostra os segmentos ou trechos repetidos que foram localizados nos textos das respostas da questão aberta Análise de Mercado, em ordem de ocorrências dentro do texto em análise. Além disso, é possível navegar nas observações ou efetuar uma recodificação com base nos elementos repetidos, ou seja, da mesma forma que na análise de palavras, foram reagrupadas algumas expressões que possuíam o mesmo significado (como por ex. usando Internet, utiliza Internet), agrupa-se também segmentos que tenham o mesmo significado. Com base nesse agrupamento, é gerada uma lista com as principais expressões, indicada na Figura 20. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.101 Figura 19 - Lista geral de expressões Freitas & Janissek – Análise léxica e Análise de conteúdo – p.102 Figura 20 - Lista agrupada ou reduzida de expressões Freitas & Janissek – Análise léxica e Análise de conteúdo – p.103 Esta mesma lista de expressões pode ser vista sob várias perspectivas, como por exemplo em função do cargo ou perfil dos respondentes, aqui no caso enquadrados em gestores e técnicos. Outras visualizações seriam também possíveis nesse caso, como por organização ou por sexo, como já observado. Na Figura 21 a seguir, é apresentada uma divisão das expressões por cargo. Na Figura 22, apresentamos outra possibilidade também já demonstrada na análise de palavras, a navegação léxica (no caso navegação de expressões), que é a localização dentro do texto das citações analisadas e que consiste em ir diretamente às respostas onde foi citada a expressão em questão. Esta navegação permite conhecer em que contexto e com que sentido foi empregada a expressão em questão, ou seja, se a lista de expressões apresentar um termo chave, podemos rapidamente com a ajuda de uma ferramenta (ou duplo clique no mouse) descobrir palavras anteriores e posteriores em que tal expressão foi citada. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.104 Figura 21 - Lista de expressões por cargo Freitas & Janissek – Análise léxica e Análise de conteúdo – p.105 Figura 22 - O ambiente de uma expressão Freitas & Janissek – Análise léxica e Análise de conteúdo – p.106 Estes são apenas alguns exemplos do tipo de navegação possível de ser feita a partir de um conjunto de textos. Tais navegações permitem explorar de várias maneiras um mesmo dado bruto de origem, permitindo dessa forma a construção de inferências que subsidiarão futuras análises ou verificações de hipóteses: os respondentes, nas expressões repetidas, evocam ‘pesquisa de mercado’, falam de forma a manifestar dúvidas (‘acho’, ‘não sei’, ‘não uso’), e abordam algo sobre ‘nível de preços’, por exemplo. A lista completa das expressões, de tamanho 3 a 10, repetidas no mínimo 2 vezes, e reagrupadas em função de sua similaridade, está disposta a seguir: - abrir os olhos - acho que o hospital - da forma tradicional - está sendo feito para - feita uma pesquisa - nesse sentido a gente - nível de preços - o hospital faz - o que está acontecendo - o que está sendo feito - para dentro das empresas - para o mercado - passa pelo mundo - pela Internet a gente - pesquisa de mercado - troca de informações Tomando agora como base esta lista de expressões, e complementando-a com a lista de palavras anteriormente definida, pode-se então partir (sequencialidade) para a tentativa de criar categorias que traduzam as principais idéias dos textos dos respondentes em relação à Análise de Mercado. Ou seja, tem-se aqui um exemplo prático de como uma Análise Léxica pode facilitar nosso Freitas & Janissek – Análise léxica e Análise de conteúdo – p.107 entendimento ao pontuar palavras e expressões que apareçam mais no texto. Para a criação de categorias a partir destas listas definidas, deve-se partir para a efetiva Análise de Conteúdo, detalhada a seguir. Este procedimento deveria ser feito para cada dos 10 elementos (dos quais um é a Análise de Mercado aqui ilustrada). Freitas & Janissek – Análise léxica e Análise de conteúdo – p.108 6.4. Análise de Conteúdo das questões abertas Para a análise dos dados qualitativos, o primeiro desafio a ser enfrentado é a adequada codificação das informações. Segundo HOLSTI (apud MILES e HUBERMAN, 1994), “a codificação é um processo pelo qual os dados brutos são sistematicamente transformados e agrupados em unidades que permitem uma descrição exata das características relevantes do conteúdo.” A partir das principais palavras e expressões identificadas na Análise Léxica, pode ser efetuada uma Análise de Conteúdo. A realização de tais análises será feita sob as perspectivas apresentadas no início desta seção 6: criação de categorias de fato inferidas (que chamaremos aqui de categorias AC, ou seja Análise de Conteúdo com base na leitura que faz emergir categorias) e identificação da existência (ou não) de categorias assumidas ou induzidas (que chamaremos aqui de categorias OCM, ou seja Análise de Conteúdo com base num protocolo prévio baseado na literatura, cuja estrutura é a Organização, a Comunicação e o Marketing) dentro dos textos analisados, demonstrando desta forma a diversidade de exploração de uma mesma base de dados. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.109 6.4.1. Criando ou inferindo categorias AC A primeira parte para a criação das Categorias AC consiste na leitura de cada um dos 12 textos de respostas. Tal procedimento requer que a análise léxica esteja concluída, de forma que os textos dos respondentes sejam confrontados com as listas de palavras e expressões obtidas anteriormente. Vai-se lendo o texto correspondente a cada um dos entrevistados e, a seguir, na mesma tela do sistema em uso, pode-se interpretar gradativamente o conteúdo de forma a codificar as respostas dadas. À medida que se lê o conteúdo da resposta em análise, pode-se criar as categorias de respostas – ou Categorias AC. Este é um contexto no qual pode-se ler e anotar o conteúdo do que é lido, com a possibilidade de enriquecer os temas que se está interpretando. É como se fosse uma tentativa de “fechar” a questão, ou seja, dispor da questão aberta e espontânea, mas também criar uma nova, fechada ou com categorias de respostas correspondentes. Este procedimento requer atenção, paciência e muita seriedade por parte do pesquisador. Não são poucas as vezes que será necessário recorrer à Análise de Palavras ou Expressões, procedendo com a navegação lexical, identificando contextos em que tais citações foram ditas, por exemplo, ou até mesmo leitura e releitura de forma a ter certeza da validade das categorias que estão sendo criadas. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.110 É importante ressaltar que tal procedimento é possível pela existência prévia das listas de palavras e expressões que compõem o léxico, ou seja, a complementaridade de tais procedimentos com a navegação nos textos, enfim, a busca da melhor definição de categorias somente é permitida pela sequencialidade e mesmo recorrência das análises. Para a criação de cada categoria em cada grupo de palavras, deve-se observar algumas regras básicas (BARDIN, 1996, p.134-168; KELLE, 1995, p.24), fundamentais na sua elaboração. As categorias devem ser: Homogêneas: não misturar “alhos-com-bugalhos”; cada categoria diz respeito a uma idéia central exclusiva. Exaustivas: esgotar a totalidade do texto. Praticamente todas as palavras foram classificadas, muito embora alguns termos não tenham sido passíveis de classificação. Exclusivas: um mesmo elemento do conteúdo não pode ser classificado em duas categorias diferentes. Desta forma, cada palavra pertence à somente uma categoria. Objetivas: codificadores diferentes devem chegar a resultados iguais. Cada membro da equipe realizou uma análise individual. As discordâncias foram debatidas até se chegar a uma percepção comum, procurando-se diminuir a subjetividade na análise. Adequadas ou pertinentes: as regras devem ser adaptadas ao conteúdo e ao objetivo. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.111 De fato, este método de codificação representa um trabalho maçante e demorado, contudo gratificante em nossa opinião. É um método subjetivo, como a leitura pode sê-lo; é um método clássico de análise de conteúdo. Mas ao seu final, a codificação resultante é expressiva da realidade inerente àquela amostra. E a análise que se faz é com convicção e prazer de visualizar o resultado de tal esforço. Para testar a confiabilidade das categorias, alguns esforços duplicados são essenciais. Tal procedimento, para ter sua validade, deve passar pelas técnicas de confiabilidade definidas por KRIPPENDORFF (1980) e já descritas na seção 3.2, ou seja, a confiabilidade do procedimento de classificação do texto segundo algum critério, pode ser verificada (1) ao repetir o procedimento mais de uma vez pelo mesmo pesquisador (teste-reteste), (2) quando a classificação é realizada por uma outra pessoa, considerando as regras elaboradas pelo pesquisador, (3) ou pelo critério da exatidão, onde os resultados são confrontados com padrões previamente estabelecidos. O presente caso ampara-se, quando da geração das categorias, na estabilidade: o pesquisador realizou 3 categorizações dos dados, com intervalos de tempos percebidos entre estas. Foram, portanto, realizadas leitura (1 x) e releitura (2 x) por parte do pesquisador. Esta verificação foi ainda acompanhada e apoiada por um segundo analista (com titulação na área fim – administração e análise de dados). Cada classificação ou categorização foi feita separadamente, isto é, não se buscou, forçosamente, utilizar as mesmas categorias para cada elemento, muito embora cada um dos 10 elementos (no caso exemplificado somente 1 elemento: Análise de Mercado) tenham tido categorias em comum com os demais, dada a própria natureza das palavras descritas pelos respondentes. Após a varredura de todos os textos das respostas, chegou-se enfim à lista completa das categorias AC para aquele elemento, conforme demonstra a Figura 23. A definição de cada uma das categorias foi feita gradativamente pelo Freitas & Janissek – Análise léxica e Análise de conteúdo – p.112 pesquisador, após leitura de cada das 12 respostas ao elemento considerado. De fato, o reteste permitiu também um aperfeiçoamento da designação de cada categoria (de cada elemento), ou mesmo o acréscimo ou exclusão de algum item. CATEGORIAS AC - ANÁLISE MERCADO Identificar novidades Obter informações Monitorar mercado Observar tendências Analisar concorrentes Atualizar informações Realizar benchmarking Descobrir oportunidades de negócios Identificar estratégias Analisar clientes e fornecedores Figura 23 – Categorias Análise de Mercado Freitas & Janissek – Análise léxica e Análise de conteúdo – p.113 Após a criação das categorias, o próximo passo é a marcação das categorias em relação à cada respondente, ou seja, uma vez que categorias tenham sido identificadas, ou mesmo extraídas a partir de um dado conjunto de respostas (neste caso, 12 respostas), é necessário proceder toda uma releitura do que foi dito por cada respondente, confrontando-as com a lista de categorias criadas para aquele elemento e marcando a categoria que de fato apareça naquela resposta. A Figura 24 apresenta o início de uma codificação que evolui naturalmente à medida que se avança na leitura de cada resposta, e consequentemente a criação de novos códigos ou categorias de respostas a marcar, ou seja, em vários momentos da codificação o pesquisador vê-se compelido a alterar, criar ou até mesmo excluir categorias. Da mesma forma, se julgar necessário, o pesquisador pode alterar o texto das categorias, adequando o que for necessário. Isso normalmente é feito recorrendo-se novamente às listas de palavras, expressões e até mesmo aos textos, de forma que a marcação seja, de fato, a mais isenta possível de qualquer tipo de vício de leitura ou trabalho. Pode-se, ainda, voltar rapidamente para as primeiras observações, de forma a revisar as categorizações inicialmente marcadas, tendo assim consolidada a sua marcação. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.114 Figura 24 – Codificação para cada entrevistado Freitas & Janissek – Análise léxica e Análise de conteúdo – p.115 Estas categorias, na verdade, fazem emergir dos textos as principais idéias que pontuam cada um dos elementos estudados. Ao ler os textos, portanto, pode-se perceber a necessidade de ajustes de forma que a lista final das categorias possa realmente ser representativa, ou seja, indicar efetivamente as idéias principais. Claro, tais alterações são feitas, prioritariamente, pelo próprio pesquisador, sem contudo deixar de levar em consideração as opiniões e colocações de um segundo codificador (aquele que dá ao pesquisador elementos para argumentar sobre a maior ou menor confiabilidade da classificação de cada um dos dados e por consequência dos resultados). Este procedimento ampara-se na técnica da reprodutibilidade de KRIPPENDORFF (1980), onde, a partir do conjunto de categorias obtido, além do pesquisador, outro analista deve realizar a leitura de cada texto e sua classificação nas categorias propostas. Por se tratar de categorias inferidas (que emergiram do conjunto dos textos), foram criados protocolos mínimos de marcação das Categorias AC para a codificação por outro analista. Isto se deve à necessidade de melhor contextualizar o estudo e explicitar ao segundo codificador o que de fato deveria ser feito. O perfil do segundo analista é muito semelhante ao do pesquisador, em termos de formação e de atuação profissional. Este codificador recebeu, além do protocolo, uma quantidade de formulários (Figura 25) com as categorias desmarcadas, sendo um formulário para cada um dos 10 elementos, cada elemento com 12 opiniões ou respostas e cada resposta com um conjunto de categorias desmarcadas. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.116 O confronto final entre tais resultados permitiu a definição final da lista de Categorias AC. Esta última etapa passou pelos procedimentos de verificação de concordância entre os codificadores em razão de um mesmo conjunto de dados (KRIPPENDORFF, 1980, p.133-154). Figura 25 - Formulário com as categorias desmarcadas para o segundo codificador Freitas & Janissek – Análise léxica e Análise de conteúdo – p.117 Uma vez de posse dos resultados de cada codificador, foram utilizadas para verificação da reprodutibilidade as seguintes propostas, melhor detalhadas no item 3.2 deste livro, aqui exemplificadas (contadas em termos de comparação) a partir do caso estudado (Figura 26): Critério de avaliação Concordância exata com base no total de itens avaliados Concordância parcial com base no total de itens marcados pelo pesquisador (ou pelos avaliadores) 70 / 120 marcadas 50 / 120 não marcadas 26 / 120 marcadas 94 / 120 não marcadas 23 / 70 = 23 das 70 que o pesquisador marcou foram também marcadas pelo segundo avaliador. Avaliador Pesquisador Segundo Avaliador Diferença / comentário 23 / 120 marcadas iguais 47 / 120 não marcadas iguais 70 / 120 total iguais, sejam marcadas ou não marcadas O segundo avaliador marcou 3 categorias que não foram marcadas pelo pesquisador. O pesquisador marcou 47 que o segundo avaliador não marcou. Concordância exata com base no total de respondentes Concordância parcial com base no total de respondentes Total de respostas analisadas pelo Pesquisador e pelo Segundo Avaliador : 12 Coincidente (com + ou - 1 ) = 2 / 12 Exatamente coincidente = 1 / 12 Coincidente (com + ou - 2 ) = 3 / 12 Coincidente (com + ou - 3 ) = 4 / 12 47 / 50 = 47 de 50 que o pesquisador deixou em branco foram também deixadas em branco pelo segundo avaliador. Figura 26 – Verificação da confiabilidade AC segundo os 4 critérios adaptados por FREITAS e JANISSEK com base na literatura Freitas & Janissek – Análise léxica e Análise de conteúdo – p.118 Na Figura 26, pode-se verificar rapidamente que o pesquisador marcou 70 categorias da lista das 120 que formam o todo do elemento Análise de Mercado (10 categorias x 12 respostas), um nº bem maior que o total das categorias marcadas pelo Segundo Avaliador (26 de 120 totais). Podemos supor aqui que o Pesquisador, sendo conhecedor de causa e melhor situado em seu estudo, pôde identificar nas respostas, mesmo que nas suas entre-linhas, o que dali ele supôs serem as categorias previamente por ele criadas. O próprio fato de ter sido ele, o pesquisador, quem desenvolveu todo o estudo, revisou literatura, criou as perguntas abertas, fez a entrevista, degravou, e também fez emergir do conteúdo destas entrevistas as categorias aqui analisadas, faz que este tenha um bom domínio e maiores condições de análise e categorização, sem citar aqui a importância do conhecimento adquirido em experiências, neste estudo bastante importante. O pesquisador teve, enfim, mais firmeza para marcar. Surge aqui uma questão: a da real necessidade de esforços duplos, uma vez que um segundo avaliador, apesar de possuir em mãos um protocolo que o permita situar-se dentro do procedimento, jamais terá suficiente conhecimento de causa ou aquele sentimento de envolvimento para conduzir uma categorização e mesmo ter a clara noção e dedicação necessárias para a confiabilidade necessária. Seriam então estes esforços realizados simplesmente para justificar uma suposta verificação de resultados obtidos? Não seria o pesquisador figura suficiente para realizar e validar tais procedimentos? Vejamos mais alguns dados: Com base no indicador de concordância exata dos itens avaliados, exemplificado na Figura 26, podemos ali observar outros dados interessantes, como o nº de 23 categorias marcadas por ambos. Veja, das 26 categorias marcadas pelo segundo avaliador, 23 destas Freitas & Janissek – Análise léxica e Análise de conteúdo – p.119 são concomitantes com as marcadas pelo pesquisador. Seria isso uma simples coincidência? E ainda, que das 50 categorias não marcadas pelo pesquisador, 47 também não tenham sido marcadas pelo segundo avaliador ? Desse total, de categorias marcadas e não marcadas, 70 sejam comuns ? Eis algumas questões que poderiam ser aprofundadas, por exemplo. Ou isto seria um forte indicador de concordância? Julgamos que sim, especialmente constatando 58% de concordância entre os dois (70/120). Com base no indicador de concordância parcial dos itens avaliados, balizado pelo total das categorias marcadas pelo pesquisador, aqui no exemplo 70 categorias, podemos perceber que destas 70, 23 foram também marcadas pelo segundo avaliador, e que 47 das 50 que o pesquisador deixou em branco foram também deixadas em branco pelo segundo avaliador. Claro, o universo das categorias agora analisado restringe-se ao total das categorias marcadas pelo pesquisador. Este indicador vai além, mostrando também que o segundo pesquisador não concorda (será que realmente não concorda, ou sua marcação foi limitada pelo seu conhecimento?) com 47 das 70 categorias foram escolhidas pelo pesquisador. Mas somente 3 das categorias marcadas pelo segundo avaliador não coincidem com as do pesquisador. Seria este outro dado interessante? Em nosso julgamento, sim. Partindo agora para analisar não mais as categorias em si, mas a exata coincidência das categorias marcadas por resposta por cada um dos dois avaliadores, apresentamos, ainda com base nos dados da Figura 26, algumas outras verificações que podem ser percebidas, e que dizem respeito à concordância exata ou parcial com base no total de respondentes. Das 12 respostas analisadas, somente 1 das marcações realizadas pelo pesquisador e também pelo segundo avaliador coincide totalmente. Sendo flexível no critério, ou seja, permitindo coincidir fichas onde nem todas as categorias estejam Freitas & Janissek – Análise léxica e Análise de conteúdo – p.120 marcadas iguais, pode-se identificar um certo grau de concordância exata, ou seja, a codificação exatamente coincidente de 4 fichas em 12 é um argumento de validade dos dados. Contudo, muito subjetivo, considerando que se trata de categorias inferidas. De toda forma, os dados apresentados permitem aprofundar análises para dali fazer emergir algum dado interessante, objetivo buscado por todo pesquisador. Todo procedimento acima demonstrado para um elemento (Análise de Mercado) foi feito para cada um dos 10 elementos citados no início destas análises, gerando então 10 novos dados objetivos, cada qual com uma categorização e com sua respectiva validação ou confrontação. Cada confrontação significa que foi oferecida ao segundo avaliador uma listagem com a resposta de cada entrevistado para cada elemento, cada resposta sucedida de categorias validadas pelo pesquisador em teste-reteste, mas com casas de marcar em branco, as quais o segundo avaliador, no seu entendimento, marcava se fosse o caso daquela observação. A lista completa das categorias geradas pelo pesquisador para o elemento Análise de Mercado foi considerada. Na Figura 24 anterior, a resposta é do respondente nº 4, com a respectiva categorização. Este procedimento recém ilustrado é repetido para cada respondente (no total de 12) em cada um dos 10 elementos estudados. No final, é gerada uma tabela com o número de citações e o resultado das frequências de cada categoria de cada elemento, conforme ilustra a Figura 27 a seguir (onde o número de citações indica a quantidade de entrevistados enquadrados na categoria e a frequência é em relação aos 12 entrevistados). Freitas & Janissek – Análise léxica e Análise de conteúdo – p.121 No. cit. Freq. Identificar novidades Obter informações Monitorar mercado Observar tendências Analisar concorrentes Atualizar informações Realizar benchmarking Descobrir oportunidades de negócios Identificar estratégias Analisar clientes e fornecedores Elemento Análise Mercado 11 10 9 9 8 8 4 4 4 3 91% 83% 75% 75% 66% 66% 33% 33% 33% 25% TOTAL OBSERVADORES. 12 Figura 27 – A classificação final das categorias do elemento Análise de Mercado, segundo pesquisador. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.122 Após este tratamento todo, pode-se partir para o efetivo entendimento dos resultados. A Figura 28 apresenta as categorias que emergiram dos textos (inferidas na leitura e categorização da variável aberta texto sobre a Análise de Mercado), na frequência com que apareceram entre os 12 entrevistados: 11 11 10 9 9 8 8 4 4 4 3 0 Identificar novidades Obter infos Monitorar mercado Observar Analisar tendências concorrência Atualizar infos Realizar benchmark. Descobrir Identificar Analisar oportun. estratégias clientes e negócios fornec. Figura 28 – Representação gráfica das categorias mais citadas para Análise de Mercado entre os 12 entrevistados Freitas & Janissek – Análise léxica e Análise de conteúdo – p.123 Finalizadas todas as etapas da categorização, poder-se-ia então tentar tirar conclusões, cruzando-as contra outros elementos, como já evocado (cargo, sexo, organização). No caso da pesquisa em questão, além disso, esta categorização servirá de base para, considerando cada um dos 10 elementos, criar um instrumento fechado, o qual – após uma série de implantações envolvendo sites web para melhoria da organização, da sua comunicação e do seu marketing - será aplicado novamente para cada um dos 12 respondentes, solicitando que os mesmos indiquem a importância ou incidência de cada um. Contudo, tal procedimento não é objeto deste texto. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.124 6.4.2. Análise de Conteúdo induzida ou com base em protocolo assumido a priori Outro importante procedimento realizado ainda no contexto deste estudo foi a Análise de Conteúdo das Categorias OCM. As categorias OCM dizem respeito a um protocolo anteriormente criado, representativo das dimensões estudadas por JANISSEK (1999 e 2000), quais sejam a (O)rganização, sua (C)omunicação e seu (M)arketing: um protocolo pois baseado na literatura e especulações a priori do pesquisador. Esse segundo procedimento realizado, conforme introduzido no início desta seção, vem mostrar que uma mesma base de dados pode servir para várias elaborações ou para diferentes análises. Não somente é possível extrair categorias inferidas (AC) dos textos obtidos através das entrevistas, como também pode-se identificar a presença ou não de categorias que representem outras dimensões estudadas – neste caso, as Categorias OCM. Ou seja, nas categorias OCM a leitura dos textos e sua subsequente marcação é feita na tentativa de verificar a existência de categorias assumidas a priori (induzidas), enquanto que as categorias AC são marcadas pela inferência de suas representações. WEBER (1990, p.37) aborda esta questão de inferência e indução. Ao contrário então do procedimento de criação de categorias (AC) já descrito na seção 6.4.1 - onde primeiramente se fizeram emergir dos textos categorias representativas e, em seguida, tais categorias foram cruzadas novamente com os textos, na tentativa de marcar aquelas ali citadas, o esforço agora é somente na direção de identificar a existência ou não das categorias pré-definidas (a partir da literatura ou de especulações mesmo do pesquisador) nos textos, sem Freitas & Janissek – Análise léxica e Análise de conteúdo – p.125 a necessidade de se fazer emergir nada destes. O protocolo OCM criado é composto por 9 categorias, assim identificadas (Figura 29): Organização-Serviços Organização-Gestão Organização-Informação Comunicação-Interna Comunicação-Externa Comunicação-Informal Comunicação-Formal Marketing-Comércio-Eletrônico Marketing-Publicidade O C M Figura 29 – Os componentes do protocolo OCM para análise induzida das entrevistas em todos elementos Freitas & Janissek – Análise léxica e Análise de conteúdo – p.126 A Figura 30 ilustra o procedimento de marcação das categorias OCM, com base no texto do respondente de número 5. O perfil deste segundo analista também é o do pesquisador, em termos de formação e de atuação profissional. Este codificador recebeu, além do protocolo, uma quantidade de formulários (Figura 25) com as categorias desmarcadas, sendo 1 formulário para cada um dos 10 elementos, cada elemento com 12 opiniões ou respostas e cada resposta com 1 conjunto de categorias desmarcadas. Tais categorias são as indicadas na Figura 29. Para cada elemento (neste caso, a Análise de Mercado), cada resposta de cada entrevistado foi analisada pelo pesquisador e também por um segundo avaliador (neste caso, um outro que não aquele que codificou a parte inferida, mas ainda com mesmo perfil). Freitas & Janissek – Análise léxica e Análise de conteúdo – p.127 Figura 30 – A categorização induzida Freitas & Janissek – Análise léxica e Análise de conteúdo – p.128 O resultado desta categorização apontou que, ao falar sobre Análise de Mercado, os entrevistados valorizam a questão da informação da organização (10 de 12), a comunicação externa (9 de 12), a comunicação informal (8 de 12), depois aparecendo outros aspectos (com 5 de 12), como a organizacional (gestão e serviços) e a comunicação formal. Eles não mencionaram algo mais fortemente inerente a marketing (comércio eletrônico e publicidade). Na sequência, tem-se a Figura 31, a qual mostra os dados de confrontação das avaliações do pesquisador e do segundo avaliador, de forma a dar maior poder de argumentação ao pesquisador. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.129 Critério de avaliação Avaliador Pesquisador Segundo Avaliador Diferença / comentário Concordância exata com base no total de itens avaliados Concordância parcial com base no total de itens marcados pelo pesquisador (ou pelos avaliadores) 48 / 108 marcadas 60 / 108 não marcadas 34 / 108 marcadas 74 / 108 não marcadas 29 / 48 = 29 das 48 que o pesquisador marcou foram também marcadas pelo segundo avaliador. 29 / 108 marcadas iguais O pesquisador marcou 19 que o segundo 55 / 108 não avaliador não marcou. marcadas iguais O segundo avaliador 84 / 108 total marcou 5 categorias que iguais, sejam não foram marcadas pelo marcadas ou não pesquisador. marcadas 55 / 60 = 55 de 60 que o pesquisador deixou em branco foram também deixadas em branco pelo segundo avaliador Concordância exata com base no total de respondentes Concordância parcial com base no total de respondentes Total de respostas analisadas pelo Pesquisador e pelo Segundo Avaliador : 12 Coincidente (com + ou - 1) = 5 / 12 Exatamente Coincidentes = 2/12 Coincidente (com + ou - 2 ) = 7 / 12 Coincidente (com + ou - 3 ) = 11 / 12 Figura 31 – Verificação da confiabilidade OCM segundo os 4 critérios adaptados por FREITAS e JANISSEK com base na literatura Freitas & Janissek – Análise léxica e Análise de conteúdo – p.130 Da mesma forma que a Figura 26, a Figura 31 nos apresenta alguns dados bastante interessantes, dados estes que agora estão sendo analisados não mais sobre uma base de categorias inferidas, e sim com base em categorias induzidas a priori, determinadas em função da literatura de referência. Nesta tabela, onde os dados são categorizados em função da Categorização OCM, 9 categorias compõem cada ficha apresentada aos dois avaliadores (o pesquisador sendo a primeira pessoa e o segundo avalista, enquanto replicabilidade das marcações), no total de 12 fichas - 12 respostas, gerando portanto um total de 108 categorias. Deste total, o pesquisador marcou 48, um nº aproximado ao total das categorias marcadas pelo Segundo Avaliador (34 de 108 totais). Deste total, 29 categorias foram coincidentemente marcadas pelos dois avaliadores, e 55 deixaram de ser marcadas, também por ambos. Isso nos gera um total de 84 categorias igualmente analisadas pelos dois avaliadores. Ora, isso representa um total de 77,8% de concordância sobre a mesma base avaliada (84/108), que, segundo KRIPPENDORFF (1980), indica um bom grau de acordo entre os dois pesquisadores. Também facilmente perceptível é o grau de acordo entre os avaliadores com base em seus universos determinados, exemplificado na FIGURA 31 pelo grau de concordância parcial que nos mostra que o segundo avaliador indicou 29 das 48 já indicadas pelo pesquisador, e mesmo 55 das 60 também deixadas em branco pelo pesquisador, apresentando um grau de concordância, com base no universo do pesquisador, de 84 categorias similares. Voltando a observação sobre as discordâncias entre os dois avaliadores, verifica-se que o pesquisador marcou 19 categorias que o segundo avaliador não marcou, e que este marcou apenas 5 categorias que não foram marcadas pelo pesquisador. Pode-se perceber aqui, rapidamente, um alto grau de categorias em acordo entre os avaliadores. Seria tal grau Freitas & Janissek – Análise léxica e Análise de conteúdo – p.131 de acordo um indicativo de que, pelo fato das categorias serem induzidas, ocorreria uma maior facilidade de assimilação ou aceitação, mesmo por parte do segundo avaliador, somente balizado por um protocolo que serviu para situá-lo no estudo? Sim, acreditamos que tal suposição seja verdadeira. Outros dados servem ainda para mostrar tal acordo, como por exemplo o grau de concordância exata com base no total de respondentes. Este grau nos indica (Figura 31) que 2 das 12 fichas analisadas tiveram exatamente o mesmo julgamento. Sendo novamente aqui flexível no critério, ou seja, permitindo coincidir fichas onde nem todas as categorias estejam marcadas iguais, pode-se identificar agora um alto grau de concordância exata, diferentemente do que ocorreu na categorização AC. No caso da flexibilização das fichas das OCM aqui analisadas, obtemos quase que a totalidade de acordo, chegando a 11 das 12 analisadas quando fixado em 3 o número de categorias flexíveis na análise. Ora, 11 dentre 12 fichas exatamente coincidentes é um alto argumento de validade e confiabilidade dos dados. Além disso, considerando que se tratam de categorias induzidas, tal dado representa a veracidade dos conteúdos aqui avaliados. Fazendo agora um comparativo entre a análise de categorias inferidas AC, anteriormente descrito, e a análise de categorias induzidas OCM, podemos perceber que a indução de categorias facilita a confiabilidade de uma situação ou elemento analisado. Traçando um paralelo entre as duas análises, percebemos claramente tal situação, dado que o percentual (ou número) de coincidências é notoriamente superior quando se trata de categorias induzidas OCM. É nossa suposição que sim se deve ter maior de concordância na induzida do que na inferida, visto que o protocolo assumido a priori é mais facilmente aceitável ou assimilável pelo segundo avaliador, mesmo quando este não esteja completamente engajado na pesquisa. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.132 Ambas as análises aqui apresentadas permitem concluir que a duplicação de esforços pode ser importante quando do processo de investigação, pela possibilidade de aprofundar análises dos dados obtidos. Entretanto, tais esforços não podem nem devem balizar uma investigação, no sentido de amarrar o pesquisador ao processo da replicabilidade em si. Tal procedimento serviria para permitir que o pesquisador legitimasse suas conclusões ou pudesse perceber daí informações não imaginadas, elevando ao máximo a exploração dos dados. Reforça-se nossa convicção da importância cada vez maior de que o pesquisador busque aprofundar suas análises, mesmo que inicialmente isso possa parecer utópico. Essa aparente utopia da relevância da análise ou mesmo confrontação de resultados num processo de investigação permite desenvolver a capacidade de pensar, observar, relacionar, justificar, sintetizar, correlacionar e inferir, e consequentemente o processo de agir dentro de um dado contexto analisado. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.133 6.5. Aprofundando a análise de dados através da Análise de Correspondência De fato, o aprofundamento das análises dos dados aqui usados como ilustração serão feitos oportunamente em outra publicação, em especial por JANISSEK8. A Análise de Correspondência pode ser utilizada para explorar associações entre variáveis categóricas quaisquer, possibilitando a representação conjunta destas e suas relações. Dentre o conjunto de técnicas relacionadas com mapas perceptuais que permitem operar variáveis, a Análise de Correspondência merece destaque pela sua facilidade de aplicação e de interpretação, bem como pela sua versatilidade no tratamento de variáveis categóricas. Tais tipos de análises permitem que o analista visualize as proximidades, similaridades ou dissimilaridades entre os elementos estudados. Diversos autores descrevem este tipo de teste envolvendo dados qualitativos: MOSCAROLA (1990, p.277-282), LEBART e SALEM (1994, p.79-110), LAGARDE (1995, p.89-100 e 143-149), PEREIRA (1999,p.133-151) e CUNHA Jr. (1997). BARDIN (1996, p.57) aborda os cruzamentos de variáveis objetivas (como a nossa classificação da amostra em gestores e técnicos) com as palavras mais frequentes. Este mesmo autor (p.190) fala da aplicação da Análise de Correspondência. A representação gráfica da Análise de Correspondência é especialmente rica em informação, permitindo que o analista depreenda, rápida e facilmente, as relações entre variáveis. O principal objetivo da Análise de Correspondência é a sintetização da massa de dados. Utilizando os procedimentos adequados de análise multidimensional de dados o pesquisador poderá poupar muitos recursos despendidos no processamento e análise dos mesmos. Estas técnicas de redução de 8 http://www.adm.ufrgs.br/professores/hfreitas/e-business Freitas & Janissek – Análise léxica e Análise de conteúdo – p.134 dados viabilizam a exploração das variáveis disponíveis para análise. As variáveis apropriadas para a utilização deste tipo de análise são as do tipo categóricas (qualitativas), ou mesmo variáveis quantitativas que passaram por um processo de categorização. As distâncias do gráfico gerado indicam as correspondências existentes entre as categorias (LAGARDE, 1995; FREITAS e MOSCAROLA, 2000; FREITAS, 2000). O intuito seria cruzar dados para se tentar extrair daí informações que aparentemente não são explícitas numa tabela ou teste. As Figuras 32 e 33 apresentam uma visão de uma tabela que cruza as empresas ou organizações de origem (representadas por E1 e E2) e os cargos dos entrevistados (como G para gestor e T para técnico) com as categorias definidas por inferência para a Análise de Mercado: uma em forma de tabela propriamente dita e outra em forma de mapa perceptual da Análise de Correspondência. Trata-se de cruzar então variáveis objetivas (a empresa e o cargo) com uma variável que se origina de um dado completamente subjetivo, mas cuja objetividade foi buscada primeiro pelo pesquisador, depois confrontada com outro, na busca de confiabilidade. A partir daí, o que se pode construir como análise e aprendizagem é que poderá ditar o interesse de todo esse esforço de análise. Entretanto, este é apenas um exemplo do que se pode fazer com a combinação de tais técnicas de análise. Nosso intuito é apenas demonstrar que se pode buscar aprofundar a compreensão e a capacidade de análise a partir de duas visões diferentes do mesmo conjunto de dados. Basta tentar analisar a tabela e, ao mesmo tempo, tentar avaliar o que indicam as proximidades geográficas na Figura 33, indo e vindo de figura a figura (32 e 33), de forma a verificar curiosidades ou testar inferências a partir disso. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.135 AC_Análise Mercado C1 C2 C3 C4 C5 C6 C7 C8 C9 C10 TOTAL E1_G (3) 3 0 3 1 2 3 3 3 2 0 20 E2_G (5) 4 2 2 2 2 3 3 3 2 2 25 E1_T (3) 3 1 2 1 0 3 2 2 3 1 18 E2_T (1) 1 1 1 0 0 1 1 1 1 0 7 TOTAL 11 4 8 4 4 10 9 9 8 3 70 Empresa e Cargo Figura 32 – Tabulação cruzada entre Empresa_Cargo (gestor ou técnico) e Categorização da Análise de Mercado (AC) Legenda: E1 = empresa 1, E2 = empresa 2, G = gestor, T = técnico C1= Categoria Identificar novidades C2= Categoria Realizar benchmarking C3= Categoria Analisar concorrentes C4= Categoria Descobrir oportun negócios C5= Categoria Identificar estratégias C6= Categoria Obter informações C7= Categoria Monitorar mercado C8= Categoria Observar tendências C9= Categoria Atualizar informações C10= Categoria Analisar clientes e fornec Freitas & Janissek – Análise léxica e Análise de conteúdo – p.136 Eixo 2 (37.6%) E2_Técnico (1) Atualizar informações Analisar concorrentes E1_Técnicos (3) Obter informações E1_Gestores (3) Monitorar mercado Eixo 1 (48.1%) Observar tendências Identificar novidades Realizar benchmarking E2_Gestores (5) Descobrir oportun negócios Identificar estratégias Analisar clientes e fornec Figura 33 – Análise de Correspondência entre Empresa_Cargo (gestor ou técnico) e Categorização da Análise de Mercado (AC) Legenda: E1 = empresa 1, E2 = empresa 2, G = gestor, T = técnico Freitas & Janissek – Análise léxica e Análise de conteúdo – p.137 Com base na tabela e gráfico acima, podemos analisar informações que nos são apresentadas através da análise de correspondência entre as categorias do elemento Análise de Mercado, cruzados com variáveis de cargo dos entrevistados de cada empresa, as quais denotam curiosidades como, por exemplo, o fato de que os técnicos das duas empresas pensam mais ou menos as mesmas coisas (E1_Técnicos e E2_Técnicos), ao mesmo tempo que não dão importância à Identificação de Estratégias e Descobrir Oportunidades de Negócios. Seria este um indicativo de que Técnicos não se preocupam com dados mais administrativos da sua organização? Outro dado importante é que os Gestores da empresa 1 não falam da possibilidade de analisar clientes e fornecedores nem descobrir oportunidades de negócios através do uso da internet, enquanto que os gestores da empresa 2 dão bastante importância para isso. Seria pelo fato da empresa 2 estar mais aculturada ao uso da internet do que a empresa 1? Seria este um dado importante a ser investigado? Outras informações, tais como obter informações através da internet, monitorar mercado, observar tendências e identificar novidades recebem grande importância tanto por gestores quanto técnicos, de ambas as organizações. Estes são apenas alguns exemplos do que se pode avançar em relação à analise de uma base de dados, com o auxílio de uma ferramenta adequada que nos gere tais tabelas e/ou gráficos automaticamente, dando margem à uma análise mais fina e detalhada de dados inicialmente brutos e com pouco significado. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.138 *** A proposta aqui foi apresentar algumas soluções de análises de dados qualitativos, tais como análise léxica e análise de conteúdo (e ainda outras como a aqui descrita análise de correspondência) que, uma vez aplicadas complementar, recorrente e sequencialmente, permitem no seu conjunto obter informações e chegar a um conjunto de cenários que nos possibilitem avançar, inferir, induzir e identificar tendências, influências, impactos ou o simples uso das tecnologias, situações ou contextos analisados. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.139 7. Considerações Finais A realidade de boa parte de nossos pesquisadores e analistas é que eles acumulam dados em suas atividades, sem contudo explorá-los adequadamente. Normalmente, não dominam métodos, técnicas e ferramental para tal. O diferencial proporcionado pelos métodos, bem como a isenção conferida pelo pesquisador que respeita com rigor estes métodos, retratam as diferenças das competências e das intenções. Todo profissional, pesquisador, professor, executivo, gerente ou analista deve desenvolver habilidades e dominar sistemas, técnicas e métodos inerentes à cada vez maior necessidade por construção de conhecimento a partir de dados dispersos em redes locais e mesmo mundiais, assim como nas múltiplas facetas e atividades de toda organização. Considerando isto, procurou-se demonstrar técnicas para realizar análise de dados textuais, em especial as Análises Léxica e de Conteúdo, suas mazelas e as precauções inerentes, buscando repassar ao leitor condições para uma investigação prática e eficaz. Mostra-se que é viável, com o auxílio de instrumental adequado, levantar dados quanti-qualitativos e explorar informações consistentes que possam trazer respostas ágeis a muitos questionamentos que surgem no dia-adia de uma organização e mesmo no trabalho do profissional de pesquisa. As idéias aqui apresentadas mostram que as Análises Léxica e de Conteúdo não devem ser excludentes entre si, muito pelo contrário, ao utilizá-las em conjunto o pesquisador ou analista tem, nelas, diferentes análises que, juntas, podem permitir que dados sejam adequadamente explorados. Não se trata aqui de escolher entre as técnicas e sim de se dar conta de que uma e outra oferecem a possibilidade de avançar sobre os dados investigados, e aprender a Freitas & Janissek – Análise léxica e Análise de conteúdo – p.140 utilizá-las de forma sequencial, recorrendo uma a outra quando da necessidade de um entendimento maior ou definição de resultados e percebendo o valor que pode ter a compreensão e a prática da sua complementaridade. Fez-se uma discussão sobre o valor e importância da coleta e análise de dados qualitativos, apresentando conceitos de análise léxica e de análise de conteúdo, bem como exemplos da literatura e de pesquisas e sistemas realizados recorrendo a estas técnicas. Uma pesquisa essencialmente qualitativa, explorando as duas técnicas em questão na análise de dados coletados em entrevistas estruturadas (com guia de entrevista), foi descrita buscando-se ilustrar uma aplicação. A objetividade dos dados coletados em uma pesquisa não é mais suficiente para a compreensão de um fenômeno, é a subjetividade que pode permitir compreender as razões de dado comportamento ou preferência. O uso de dados qualitativos, opiniões mais espontâneas ou indiretas, permite identificar oportunidades ou antecipar problemas. Além disso, esse tipo de dado pode ser explorado mais de uma vez, constituindo-se numa fonte diferenciada para a geração de novos, diferentes e curiosos dados, os quais podem ser produzidos diretamente pelo pesquisador. As análises, bem como a sistematização de seus procedimentos, dependem muito do valor e competência do pesquisador, de forma que este possa levar a cabo sua investigação e extrair o máximo de suposições e ou conclusões a partir de um conjunto de dados ou realidade estudada: é fundamental o domínio por parte do analista (ou equipe) do tema, objeto ou foco de estudo. A análise de dados textuais é bastante intuitiva, pessoal e subjetiva, mas contém certa racionalidade, permitindo a aplicação de técnicas e o uso de sistemas na sua facilitação. Apresenta, como outros, problemas de validade, assim como a autenticidade do texto, a validade de Freitas & Janissek – Análise léxica e Análise de conteúdo – p.141 interpretação e a veracidade das afirmações de fato. Soluções para perceber e analisar a confiabilidade dos dados foram discutidas, através de 3 maneiras, que são a estabilidade, a reprodutibilidade e a exatidão. Nossa idéia é de que - nas pesquisas em SI - estas verificações sejam realizadas de forma simples, para o que revisamos e mesmo propusemos alguns indicadores com base no total de itens avaliados e com base no total de respondentes. Ao exemplificar as soluções aqui propostas através de uma pesquisa realizada sobre sites web e negócios empresariais, foi possível apresentar a sequência lógica de uma análise de dados qualitativos, descrevendo todos os passos para o plano de análise de dados e operacionalizando a idéia de que as técnicas apresentadas sejam de fato utilizadas de forma sequencial, recorrente e complementar. As palavras e expressões originadas pela pesquisa foram investigadas pela Análise Léxica e as categorias do presente estudo foram inferidas ou induzidas através dos procedimentos de Análise de Conteúdo. Durante esta análise, foi possível aplicar os 4 indicadores adaptados pelos autores a partir de literatura, visando verificar a confiabilidade dos dados, numa confrontação envolvendo uma variável cujas categorias foram inferidas a partir do conteúdo de cada entrevista, e também numa outra, cujas categorias foram definidas a priori pelo pesquisador com base na literatura e na prática gerencial. Todos estes passos foram exemplificados no intuito de mostrar o valor das idéias aqui apresentadas, baseadas no fato de que as verificações são passíveis de serem realizadas de forma descomplicada e bastante honesta, sem induzir o pesquisador a realizar manipulação de seus dados nem desviar sua atenção sobre o objeto investigado. Tal exemplificação foi finalizada com a Análise de Correspondência, utilizada para observar associações entre variáveis categóricas quaisquer, possibilitando a representação conjunta destas e Freitas & Janissek – Análise léxica e Análise de conteúdo – p.142 suas relações, num exercício de exploração dos dados da pesquisa objeto de aplicação. Nossa proposta – reforce-se - é de que as duas técnicas sejam utilizadas de forma sequencial (uma após a outra), recorrente (pode-se ir e vir, deve-se mesmo ir e vir de uma a outra) e complementar (elas não são excludentes), ou seja, não se deve escolher uma ou outra, deve-se adquirir finalmente a visão de que os recursos de ambas são excelentes ferramentas na mão do analista e que ele deve fazer bom uso e não isolar uma em detrimento de outra. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.143 8. Referências bibliográficas BARDIN, L. L’analyse de contenu. Paris: PUF, 8. Ed.,1996. BERNARDES, R. Um estudo sobre a demanda de informações em sites Web: o caso de uma unidade de pesquisa de uma empresa de P&D para o agronegócio brasileiro. Porto Alegre: Projeto de Dissertação de Mestrado. PPGA/EA/UFRGS, [email protected], Dezembro 1999, 38 p. BICKMAN, L. & ROG, D.J. Handbook of Applied Social Research Methods. Sage Publications, 1998. BOFF, L. H. O uso da informação em ambientes de trabalho de conhecimento. Porto Alegre: Projeto de Tese. PPGA/EA/UFRGS. [email protected], Maio 1997. CRESWELL, J. W. Qualitative Inquiry and Research Design. Sage Publications, 1998. CUNHA JR. M. V. M. Análise Multidimensional de Dados Categóricos: A Aplicação das Análises de correspondência Simples e Múltipla em Marketing e Sua Integração com Técnicas de Análises de Dados Quantitativos. Porto Alegre: Caderno De Estudos - PPGA/EA/UFRGS, 1997. DOMENJOZ, P., GAVARD-PERRET, M. L., e MOSCAROLA, J. Price and communication: How do they interrelate? An analysis of car advertisements published in English. France: Actes du congrès de la AFM (Association Française du Marketing), 1995. DORNELAS, J. S. Inovações ligadas ao processo de gestão participativa e ao uso de sistemas de apoio à decisão em grupo, na direção de novas formas de estruturas organizacionais. Foz do Iguaçu: 23º ANPAD, [email protected], Setembro, 1999. EVRARD, Y. Études et recherches en marketing. Paris: Nathan, 1997. FRANKFORT-NACHMIAS, C. & NACHMIAS,D. Research Methods in The Social Sciences. New York: St. Martin's Press, 1996. FREITAS, H. & MOSCAROLA, J. Content analyzing qualitative data on Information Systems. Baltimore, MD, EUA: Association for Freitas & Janissek – Análise léxica e Análise de conteúdo – p.144 Information Systems Americas Conference 1998, Technology research in progress, August 14-16, 1998. FREITAS, H., BECKER J.L., ZANELA, A. C., MACADAR M. A. , MOSCAROLA, J. e JENKINS, M. The design process of a crosscultural exploratory quantitative-qualitative survey research project to study the decision-making process. Baltimore, MD, EUA: Association for Information Systems Americas Conference 1998, Technology research in progress, August 14-16, 1998. FREITAS, H., CUNHA Jr. M.V.M. e MOSCAROLA, J. Aplicação de sistema de software para auxílio na análise de conteúdo. São Paulo: RAUSP, v. 32, nº 3, Jul/Set. 1997, p. 97-109. FREITAS, H., MOSCAROLA, J., e JENKINS, M. Content and lexical analysis: a qualitative practical application. Baltimore, MD, EUA: ISRC, Merrick School of Business, University of Baltimore (MD, EUA), WP ISRC No. 070498, April 1998. 35 p. FREITAS, H., MOSCAROLA, J., JENKINS, M., BECKER J.L., ZANELA, A. C. e MACADAR, M. A. Decision-making process, national culture, and decisional background, cross-cultural exploratory quantitativequalitative survey research project: Brazil, France and USA, some preliminary results - a report to the AIS 98. Baltimore, MD, EUA: Association for Information Systems Americas Conference 1998, Organizational research in progress. Baltimore, MD, EUA, August 1416, 1998, 3 p. FREITAS, H.; MOSCAROLA, J. Análise de dados quantitativos e qualitativos: casos aplicados usando o Sphinx®. Porto Alegre, Sphinx: 2000, 176 p. FREITAS, H. As tendências em Sistemas de Informação com base em recentes congressos. Porto Alegre: ReAd (http://www.adm.ufrgs.br/read), No.13, Jan. 2000, 20 p. FREITAS, H., CUNHA Jr., M. V. M. e MOSCAROLA, J. Pelo resgate de alguns princípios da análise de conteúdo: aplicação prática qualitativa em marketing. Angra dos Reis - RJ: Anais do 20ºENANPAD, ANPAD, Marketing, 23 - 25 de Setembro 1996, p. 467 - 487. GRAWITZ, M. Méthodologie des Sciences Sociales. Paris: Dalloz, 1976 (chap. II, p. 586-627), and 1993 (9 ed., chap. 2, section 2, p. 532-565). 870 p. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.145 GAVARD-PERRET, M.L. & MOSCAROLA, J. De l'énoncé à l'énonciation: relecture de l'analyse lexicale en marketing. Annecy, France: GEREG and CERIAM, Université de Savoie, Cahier GEREG, 1995, 34 p. GONÇALVES, L.P.F. Aplicação das técnicas de mineração de dados na administração: o caso de Três supermercados. Porto Alegre: Projeto de Dissertação de Mestrado. PPGA/EA/UFRGS. [email protected], Dezembro 1999. 36 p. JANISSEK, R. O impacto da implementação de sites Web em Negócios empresariais. Porto Alegre: Projeto de Dissertação de Mestrado. PPGA/EA/UFRGS. [email protected], Junho 1999. JANISSEK, R. A influência da Internet em Negócios empresariais: identificação e caracterização de elementos para análise de sites. Porto Alegre: Dissertação de Mestrado. PPGA/EA/UFRGS. [email protected], Maio 2000. JENKINS, M.; FREITAS, H.; ARSHAM, H. e equipe técnica. Preliminary report on the Assessment of the Status of the Current and Planned IT Environment, Maryland Department of Transportation (MDOT), presented to the Information technology Team. Baltimore, MD, EUA: relatório de atividade de pesquisa com 300 managers de 10 departamentos diferentes, participação como coordenador técnico de análise de dados. Baltimore, MD, EUA: ISRC, Merrick School of Business, University of Baltimore, January 22, 1998, 35 p. KELLE, U. Computer-Aided Qualitative Data Analysis: theory, methods and practice. Sage Publications, 1995. KIRK, J. & MILLER, M. Reliability and validity in qualitative research. Sage publications, 1986. KRIPPENDORFF, K. Content analysis: an introduction to its methodology. The Sage CommText Series, 1980, 191p. LAGARDE, J. Initiation à l'analyse des données. Paris: Dunod, 1995. 162 p. LEBART, L. & SALEM, A. Statistique Textuelle. Paris: Dunod, 1994. 342 p. LEE, A. S. LIEBENAU, J. ; DEGROSS, J. I. Information Systems and Qualitative Research. Philadelphia, USA: Proceedings ICIS, Chapman & Hall, 1997. LESCA, H. Information et Adaptation de l'entreprise. Paris: Masson, 1989. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.146 LUCIANO, E. M. Mapeamento dos indicadores essenciais para diagnóstico e suporte ao processo decisório. Porto Alegre: PPGA/EA/UFRGS, [email protected], Abril 1999. MASON, J. Qualitative researching. Sage, 1997, 180 p. MATTAR, F.N. Pesquisa de Marketing: edição compacta. São Paulo: Atlas, 1996. MILES, M. B. & HUBERMAN, A. M. Qualitative data analysis. Sage Publications, 1994, 338 p. MOSCAROLA, J. Balladur, Chirac, Jospin, les mots d’une campagne: quelques exemples d’analyse lexicone avec le Sphinx. Annecy, France: IUP, cahier du GEREG, Université de Savoie, 1995, 8 p. MOSCAROLA, J. La communication politique vue par l’analyse lexicale. Annecy, France: IUP, Université de Savoie, Cahier du GEREG, n° 32, 1994. MOSCAROLA, J. Discourse analysis with sphinx lexica. Annecy, France: 1996. MOSCAROLA, J. Analyse de contenu et analyse de données: solutions logiciels pour une intégration quali/quanti. Paris: Actes JADT, 1993. MOSCAROLA, J. Les actes de langage: protocoles d'enquêtes et analyse des données textuelles. Paris: Colloque Consensus Ex-Machina, La Sorbonne, April 1994. MOSCAROLA, J. Enquêtes et Analyse de donnés avec le Sphinx. Paris: Libraire Vuibert, 1990. OLIVEIRA, M. Indicadores para tomada de decisão na etapa de concepção do processo construtivo: a percepção dos principais intervenientes. Porto Alegre: Tese de Doutorado, PPGA/EA/UFRGS, 1999. PEREIRA, J. C. R. Análise de Dados Qualitativos. São Paulo: Edusp. 1999. 156 p. PERRIEN, J. CHÉRON, E.; ZINS, M. Recherche em Marketing: méthodes et décisions. Quebec, Canadá: Gaëtan Morin Éditeur, 1984. SILVERMAN, D. Interpreting Qualitative Data. Sage Publications, 1995. 224 p. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.147 SPHINX LÉXICA for Windows, Guia do usuário. Sphinx Consultoria, Brazil ([email protected] website: http://www.sphinxbr.com.br), 1997. WEBER, R.P. Basic content analysis. Sage University paper, 1990. 96 p. WEITZMAN, E. A. e MILES, M. B. Computer programs for qualitative data analysis. Sage Publications, 1995. 372 p. ZANELA, A. I. C. A influência da cultura nacional e da experiência decisória sobre a percepção do processo decisório individual: um estudo comparativo entre Brasil, França e Estados Unidos. Porto Alegre: Dissertação de Mestrado. PPGA/EA/UFRGS, 1999. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.148 Índice Remissivo A abertas agrupamentos ambigüidade amostra aproximação autenticidade avaliação 14 16 17 27 28 30 33 34 36 67 68 69 78 80 81 83 110 120 34 37 39 95 96 102 17 19 20 27 32 37 41 54 70 17 19 20 27 34 37 41 51 54 72 113 135 36 34 37 95 28 143 18 61 77 85 119 131 B banalidade 36 93 C categorias categóricas categorização citações classificação codificação código cohen coleta comparações complementaridade concordância concorrência confiabilidade confrontação contagem corpo correlações correspondência criatividade critério cruzamentos customização 17 19 20 21 27 34 41 43-48 50-54 57 58 59 60 61 67 69 79 80 86-98 109-143 135 136 144 145 20 37 45 59 60 61 87 88 113 115 120 122 124 125 130 132 133 136 137 33 97 105 111 122 123 21 47 51 58 59 87 112 113 117 135 18 19 20 52 53 54 55 58 67 72 73 74 75 85 110 113 115 117 122 47 52 68 74 78 86 115 58 7 14 15 16 22 27 82 83 142 36 58 61 63 77 119 9 15 21 26 31 69 80 85 100 112 142 52 53 55 57 58 59 60 61 72 118 119 120 121 122 131 132 133 134 84 95 96 97 98 99 25 50 52 53 55 56 57 59 71 72 113 117 119 120 131 133 136 143 59 61 122 130 134 143 32 34 47 50 54 57 59 26 33 36 80 89 92 93 100 78 134 80 100 135 136 139 140 144 145 50 70 18 34 45 61 91 113 119 122 131 133 17 88 91 98 99 135 75 77 D dados datamining decisão decomposição dedicação definição desacordos designação 5 7-10 12-18 20-23 25-28 30 33-39 41-44 52-55 57 62-80 85-89 95 110 113 117 118 120-122 126 130-134 65 73 11 19 50 64 67 68 69 76 82 145 146 149 50 62 20 50 70 120 18 32 43 44 45 47 52 56 57 58 66 67 112 114 118 142 57 58 59 114 Freitas & Janissek – Análise léxica e Análise de conteúdo – p.149 desigualdades desmarcadas desvio diagnóstico dicionários didática diferenciada dimensão dimensões direção diretrizes discordâncias dispersão distinção divergências documentos 60 117 128 54 58 89 144 66 148 37 67 16 25 7 18 142 32 34 89 19 45 126 34 52 126 145 20 41 21 56 67 112 132 34 43 91 54 56 27 28 30 39 43 62 66 68 70 74 96 E elaboração elementos emergir emissor empresa engajada enquêtes entendimento entrelinhas entrevista entrevistados equipe erro escala escolha especializados especificidades espontânea essenciais estatística estratégias estrutura estudo etapa exatidão excludentes expectativa expectativas experiência explicações exploração exportar expressões extrair 22 23 51 75 87 112 126 146 22 41 47 48 65 79 81 82 93 102 109 113 117 122 125 127 128 135 147 18 28 47 80 110 117 120 122 126 127 39 47 63 79 82 83 84 98 99 136 137 139 145 20 27 134 33 47 148 149 59 109 122 124 142 22 37 39 15 47 61 62 82 83 120 142 143 66 68 80 81 89 98 99 111 123 124 130 136 139 5 11 52 65 68 69 78 112 143 147 52 54 72 13 18 9 19 44 47 48 50 52 74 76 95 38 37 48 65 14 16 18 30 37 111 142 55 77 113 148 33 37 54 70 71 73 78 16 47 84 99 114 123 137 139 15 52 69 77 110 142 5 16 25 33 37 45 53 64 66 67 68 69 79 117 120 126 133 143 145 149 17 39 45 48 49 68 79 81 87 118 149 51 55 56 57 113 143 21 141 144 17 68 74 43 51 64 99 149 17 26 63 8 9 10 12 13 14 15 43 47 64 66 70 85 110 134 136 144 96 26 33 37 45 51 66 78 80 85 87 89 99 100 102 105 108 109 110 111 112 115 143 87 126 136 142 Freitas & Janissek – Análise léxica e Análise de conteúdo – p.150 F facilidade fenômeno ferramentas fichas fidedignidade flexibilidade foco formulação formulismos fornecedores frequência 70 77 133 135 13 54 88 142 9 14 15 16 20 21 22 37 70 71 72 75 78 85 141 144 60 61 122 132 133 20 25 26 43 70 73 75 15 48 64 143 19 25 58 74 58 10 79 82 99 114 123 139 26 27 32 41 43 50 71 85 87 92 95 100 123 124 G generalização geração geradas gerentes gestão gradativa gratificante gratuitamente grau grupo 26 7 18 22 113 142 53 64 102 122 10 25 67 68 9 11 21 28 64 67 68 69 79 127 130 145 18 59 113 7 14 55 56 57 58 59 61 75 91 93 122 132 133 11 13 14 32 38 96 112 145 H habilidades hipóteses honesta 7 77 141 17 22 23 26 36 43 51 53 54 57 70 72 74 77 108 58 144 I identificação implementação implicações inconsistências indicadores induzidas inferência influência informação insights instrumental instrumento intensidade interação internet interpretação investigação isenção isenta 18 20 34 36 37 65 84 99 110 139 147 69 72 147 17 20 53 54 56 66 33 39 41 42 66 68 91 143 148 149 80 87 88 110 126 132 133 134 143 39 41 42 44 51 78 126 136 47 69 79 147 149 9 11 21 25 27 41 44 45 64 65 67 68 70 127 130 135 145 146 25 38 72 7 67 78 141 16 17 42 50 51 52 125 36 37 56 30 64 27 64 65 66 69 79 81 82 83 84 98 99 102 108 139 147 22 27 28 30 44 51 70 71 85 100 135 143 8 22 26 41 70 71 79 80 91 134 141 142 7 141 115 Freitas & Janissek – Análise léxica e Análise de conteúdo – p.151 J julgamento justificativas 18 58 121 133 33 L legitimidade leitura lematizado levantamento léxica léxico limites lineares linguagem lista literatura locais localização logs 20 47 52 5 18 19 22 30 33 37 39 41 68 70 71 85 92 98 110 111 113 114 115 117 124 126 36 72 79 8 9 15 21 23 28 30 31 32 33 34 36 37 39 45 63-97 105 109 110 140-143 148 149 30 32 33 36 37 95 96 99 100 112 49 78 44 95 18 27 32 47 64 74 93 95 96 99 102 105 108 109 114-118 120 122 9 12 14 15 21 31 44 59 61 65 73 80 87 110 119 120 126 127 131 132 142 143 56 141 74 77 105 27 M material média medição medida mensagem mercado métodos métricas mineração modelos modificações múltipla multivariada 12 49 85 66 91 92 50 52 18 41 44 51 52 54 58 59 111 115 39 63 69 14 27 79 82-85-93 98 99 102 108 109 113 114 120-124 128 130 136 137 139 7 9 12 13 14 20 25 26 28 30 33 44 54 65 70 71 72 77 141 59 64 65 147 43 86 67 19 75 78 145 37 O objetividade objetivo ocorrências opções operações opinião oportunidades oposições orçamento ordenação ordenada organização originalidade 13 63 136 142 20 21 28 33 39 41 43 47 49 52 63 67 79 112 122 135 36 71 98 99 102 19 37 27 71 77 13 14 16 18 19 27 28 38 113 7 13 14 77 114 123 139 142 26 69 96 95 7 13 19 20 32 36 66 67 68 70 85 91 99 105 110 125 127 130 139 141 10 36 93 Freitas & Janissek – Análise léxica e Análise de conteúdo – p.152 P padronização palavras participantes percepção pesquisa pesquisador população possibilidade precauções pressupostas propostas protocolo proximidades público 70 26 30 32 33 34 36 37 39 41 43 44 45 48 62 64 66 71 74 77 78 80 85 87 89 91 92 93 95 96 97 98 99 100 102 105 109 110 111 112 113 115 135 143 33 19 66 81 82 83 96 100 112 149 7 9 12 13-17 19 25 26 31 37 38 42 47 51 52 53 54 59 62 63 65- 67 70-73 78-81 84 86-89 98 99 108 125 134 141-148 7 8 11 12 13 16 18 19 20 22 26 28 34 51 58 59 60 61 70 76 87 88 99 111-144 54 14 26 28 39 41 58 70 75 81 105 111 134 139 142 141 59 87 9 21 59 117 119 143 18 52 59 69 87 110 117 120 126 127 128 133 134 135 136 13 69 84 Q qualidade qualitativa quantificação quantitativa quantitativas questão 10 12 20 23 34 51 66 84 99 9 12 15 16 22 23 25 26 27 31 39 43 50 52 53 54 64 74 75 78 142 147 27 49 54 78 14 16 22 23 25 26 27 30 43 44 75 22 28 50 71 136 13 15 16 17 21 25 47 51 52 58 59 60 61 64 83 84 85 88 91 96 97 99 102 105 111 120 125 126 130 142 R reagrupadas recodificação recomendações recorrência recursos redução referencial refinamento registro regras regressão relação relacionamento relativos relatórios releitura relevância repetição replicabilidade representatividade reprodutibilidade requisitos respostas restrições 102 108 52 102 50 9 80 112 8 10 15 20 21 36 62 77 135 144 45 71 82 95 96 136 59 87 14 73 27 49 75 79 19 41 56 112 113 78 18 19 48 50 52 58 60 68 69 72 81 82 84 93 99 109 115 123 139 49 73 33 39 41 42 69 95 22 23 66 96 111 113 115 134 71 91 92 72 132 134 43 51 72 117 126 55 56 57 117 119 143 53 77 7 17-19 21 27 30 32-34 36-39 44 47 68 78 80 83 84 85 86 89 91 93 95-102 105 111 114 115 117 119 120 122 128 131 132 141 75 Freitas & Janissek – Análise léxica e Análise de conteúdo – p.153 resultados reteste revisão rigor riqueza rotinas rubricas 20 28 39 41 43 47 50 52 53 54 55 57 58 72 75 77 85 112 113 117-120 124 134 142 56 57 113 114 122 9 65 73 75 16 70 141 9 19 36 37 38 93 95 75 81 47 S satisfação segmentos sequências serviços significado significativa simétricas similaridade simplificadas sinais sinônimos sistemas sistemática sites subjetividade substantivos suporte 13 18 38 49 100 102 96 13 17 82 84 98 99 127 130 17 25 36 71 87 95 102 139 12 51 78 77 95 96 108 132 135 59 32 34 5 7 9 11 27 64 70 73 74 76 77 141 142 143 145 146 25 26 30 43 73 74 69 79 125 143 145 147 13 112 142 36 37 5 13 27 50 76 77 78 148 T técnicas tendências teste transformações tratamento triangulação trivialidade 7-9 13-16 20-23 28-31 36-38 42 43 51 54 56 64-78 85 89 113 135 136 141-147 65 114 123 137 139 140 146 54 56 57 74 113 122 135 136 42 26 33 34 36 72 73 74 75 78 85 124 135 54 36 93 U unidade universo 48 49 71 98 145 33 45 49 121 132 V validação validade valor variância variáveis verbatim versatilidade visualizações vocabulário 54 67 68 122 25 28 37 51 52 53 59 71 72 88 111 113 122 133 143 15 16 28 42 47 50 51 57 142 144 78 37 42 47 51 52 59 68 69 135 136 139 144 97 135 105 32 33 36 79 87 Freitas & Janissek – Análise léxica e Análise de conteúdo – p.154 Índice de Autores ARSHAM – p. 68 BARDIN – p. 30 32 35 39 42 47 70 71 78 86 89 101 105 117 144 BECKER – p. 21 67 BERNARDES – p. 65 BERELSON – p. 44 63 BIRD – p. 74 BOFF – p. 69 CHÉRON – p. 38 41 45 48 49 CRESWELL – p. 24 CUNHA JR – p. 13 21 25 26 29 36 66 144 DEGROSS – p. 15 24 DOMENJOZ – p. 68 DORNELAS – p. 69 EVRARD – p. 58 FRANKFORT-NACHMIAS – p. 29 44 FREITAS – p. 10 13 21 25 26 27 29 31 32 36 41 43 50 51 62 63 64 65 66 67 68 70 78 GAVARD-PERRET – p. 29 68 GOLDSEN – p. 52 GONÇALVES – p. 65 GRANT – p. 30 GRAWITZ – p. 29 32 41 43 50 51 63 HAMMERSLEY – p. 53 57 HUBERMAN – p. 24 29 64 115 HOLSTI – p. 42 115 JANIS – p. 42 JANISSEK – p. 10 69 79 134 144 JENKINS – p. 32 41 43 50 52 62 63 67 68 KAPLAN – p. 52 KEENOY – p. 30 KELLE – p. 24 53 57 71 72 74 76 78 117 KIRK – p. 24 52 54 57 64 Freitas & Janissek – Análise léxica e Análise de conteúdo – p.155 KRIPPENDORFF – p. 38 42 49 50 52 54 55 57 58 59 72 118 122 123 141 LAGARDE – p. 31 38 78 80 144 145 LEBART – p. 15 30 32 33 35 48 79 105 144 LEE – p. 15 24 76 LESCA – p. 21 LIEBENAU – p. 15 24 LUCIANO – p. 69 MACADAR – p. 67 MASON – p. 24 MILES – p. 13 24 29 64 73 74 76 115 MILLER – p. 24 52 54 57 64 MOSCAROLA – p. 5 13 25 26 27 29 32 36 41 43 50 52 62 63 65 67 68 69 71 73 78 97 105 144 NACHMIAS – p. 29 44 OLIVEIRA – p. 68 OSWICK – p. 30 PEREIRA – p. 78 144 PERRIEN – p. 38 41 45 48 49 PETRINI – p. 21 PIRES – p. 66 POZZEBON – p. 21 PREIN – p. 74 RUAS – p. 66 SALEM – p. 15 30 32 33 35 48 79 105 144 SILVERMAN – p. 29 53 54 57 STUMPF – p. 67 WEBER – p. 29 38 45 47 48 51 55 59 64 78 134 WEITZMAN – p. 13 73 74 76 ZANELA – p. 67 ZINS – P. 38 41 45 48 49 Freitas & Janissek – Análise léxica e Análise de conteúdo – p.156 Apêndice - Sistema Sphinx® para pesquisas e análises de dados Freitas & Janissek – Análise léxica e Análise de conteúdo – p.157 ----- ADOTE ESTA 'IDÉIA!' ----no site http://www.adm.ufrgs.br/professores/hfreitas você encontra aulas, textos, revista do HF ... E ainda: Links para teses e dissertações, e-business, UFRGS, PPGA, EA, GESID, EAD, projetos e pesquisas em desenvolvimento, congressos, disciplinas, e muito, muito mais! Apoio a projetos de pesquisa: Freitas & Janissek – Análise léxica e Análise de conteúdo – p.158 Outros livros do autor: FREITAS, H e MOSCAROLA, J. Análise de dados quantitativos & qualitativos: casos aplicados usando o Sphinx®. Porto Alegre/RS: Sphinx, 2000, 176 p. FREITAS, H., BECKER, J. L., KLADIS, C. M. e HOPPEN, N. Informação e decisão: sistemas de apoio e seu impacto. Porto Alegre/RS: Ed. Ortiz, 1997, 214 p. FREITAS, H. A informação como ferramenta gerencial: um telessistema de informação em marketing para o apoio à decisão. Porto Alegre - RS: Ed. ORTIZ, 1993. 360 p. FREITAS, H. Um micro = um centro de informações. Rio de Janeiro - RJ: LTC, 1991. 146 p. Informações pelo e-mail: [email protected] Freitas & Janissek – Análise léxica e Análise de conteúdo – p.159 Sphinx Consultoria Ltda Distribuidor EXCLUSIVO dos sistemas Sphinx® Único certificado e autorizado SPHINX® na América Latina Rua Peru 211 - 92420.300 Canoas RS – Brasil Fone/Fax: 0xx51 - 477.3610 e-mail: [email protected] http://www.sphinxbr.com.br Freitas & Janissek – Análise léxica e Análise de conteúdo – p.160 http://www.sphinxbr.com.br O Site da Sphinx Brasil Acesse o site da Sphinx Brasil. Você encontrará: DICAS sobre a utilização do Sphinx ® e seus módulos. DOWNLOAD de manuais, funções, demo, autodemo, dlls, drivers, etc. SUPORTE e-mail. Arquivo Sphinx® DEMO, que permite instalar uma versão limitada do sistema para criar exemplos com até 5 questões e 20 questionários, ou abrir e analisar os casos cujos dados estão disponíveis para download no site. Arquivo AUTODEMO do Sphinx®, que é uma apresentação eletrônica, que percorre automaticamente as funcionalidades do Sphinx® (questionário, digitação e análise de dados). Descrição dos SISTEMAS Sphinx®, para verificar aquele que melhor se adapta às suas necessidades. DIVERSOS ARTIGOS sobre pesquisas e análises de dados usando os sistemas Sphinx ® em diferentes áreas (turismo, comércio, política, saúde, engenharias, qualidade, etc). CASOS variados, exemplos e dados que podem ser abertos e analisados na versão de demo, para que se tenha melhor noção sobre o potencial uso e aplicação dos sistemas Sphinx ®. FLASH-MAILS periódicos, com dicas, promoções, etc. DEPOIMENTOS de clientes usuários Sphinx® . Aproveite! Conecte-se com o que existe de melhor em soluções para análise de dados Freitas & Janissek – Análise léxica e Análise de conteúdo – p.161 UTILIZE OS SISTEMAS SPHINX E FAÇA SEUS DADOS FALAREM ! O SPHINX PRIMO guia você na realização de suas enquêtes! Em três etapas (definir o questionário, digitar as respostas, tratar e analisar os resultados), o Sphinx Primo acompanha você ao longo de todo o seu trabalho. De forma simples e muito profissional, ele fará você ganhar tempo, oferecendo-lhe toda a flexibilidade possível. Este sistema convém tanto aos estudos qualitativos como aos estudos quantitativos e não requer nenhum conhecimento prévio de estatística. Caso deseje aprofundar as suas análises ou analisar outras fontes de dados (bases de dados, textos...), você pode aumentar suas capacidades, fazendo-o evoluir até o Sphinx Plus² e o Sphinx Léxica. O tratamento de suas enquêtes e de seus dados com o SPHINX PLUS2. O Sphinx Plus2 é uma ferramenta de concepção e de tratamento de enquêtes, de análise estatística e de gestão de dados. Graças à sua riqueza funcional e à sua grande flexibilidade, é a ferramenta ideal para aqueles que querem aprofundar a compreensão dos dados de uma enquête ou explorar operacionalmente todo o tipo de arquivo. Permite, além de todas as funcionalidades do Primo, definir planos de tabulação, explorar e quantificar os dados textuais, calcular, tratamentos estatísticos, análises multivariadas, etc. Para aprofundar a análise de seus dados, utilize o Sphinx Léxica. Com o SPHINX LÉXICA, alie o rigor científico à sofisticação da linguagem. O Sphinx Léxica propõe a você soluções avançadas para realizar seus estudos qualitativos. Ele integra as funções de concepção e edição de enquêtes, de análise e gestão de dados do Sphinx Primo e do Sphinx Plus 2, enriquecendo suas funções de navegação lexical e oferecendo novas possibilidades de leitura, de análise e de quantificação dos dados textuais. Você pode aplicar indiferentemente todos os recursos do Sphinx Léxica às suas enquêtes, ao estudo de suas bases de dados heterogêneas, à análise de textos de qualquer natureza (entrevistas, discursos, artigos, livros, etc). É a solução mais completa para a análise de dados textuais (análise sintática, segmentos repetidos, tabelas lexicais e de especificidades, coocorrências, frases características). Com o Sphinx Léxica, o tratamento de todos os seus dados, tanto quantitativos como qualitativos, torna-se fácil, o que levará você a aprofundar seus resultados e conclusões. Descobrindo as novidades do Sphinx Léxica, você enriquecerá seus métodos de pesquisa e terá vontade de empreender novas investigações. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.162 Os módulos do Sphinx® Soluções para concepção de enquêtes e análise de dados Módulo Descrição SCANNER Oferece opções avançadas para formatação e impressão do questionário, bem como para leitura automatizada por scanner, com reconhecimento automático de respostas objetivas (fechadas). DATA ENTRY Estágio de entrada de dados. Facilita e distribui o trabalho de digitação em outros postos de trabalho, com boa relação custo/benefício. MULTIMÍDIA Permite criar questionários auto-aplicáveis, com imagens e sons que respondem ao texto, aos toques ou à voz. Indicado para captação de respostas em postos multimídia (exposições, recepções,...) ODBC Reconhecimento e transformação automática de bases de dados de formato ODBC para o formato do Sphinx, agilizando o aproveitamento dos dados. PRINT Permite a formatação e a impressão de formulários de enquêtes criadas no Sphinx. BASIC Permite programar opções para modificações e cálculos de variáveis, com possibilidade de rápida recodificação de nãorespostas, adição de números ou textos, criação de indicadores, etc. ERGO-3D Sistema interativo de representação visual em 3 dimensões, através do olho de uma câmera a partir da qual se pode modificar a posição e a orientação, fazendo ‘girar os dados’. MULTILÍNGUA Permite optar pelos resultados e comentários nos idiomas Português, Francês ou Inglês. Os manuais dos módulos Sphinx podem ser obtidos em http://www.sphinxbr.com.br/arquivos/ Freitas & Janissek – Análise léxica e Análise de conteúdo – p.163 O Sphinxfor you é o nosso programa de fidelização de nossos usuários e clientes, lançado para sua maior satisfação. Estaremos sempre lhe oferecendo serviços diferenciados de diversas naturezas, como: Site web Livros 3 Sistemas Manuais Eventos e Workshop Dicas on-line Artigos Help Suporte Técnico Treinamentos in company Flash-mail Casos e dados Módulos Promoções Treinamentos por turma Fique de olho, o Sphinxfor you vai fazer a diferença e lhe mostrar que vale a pena ser fiel à Sphinx e seus sistemas e serviços, valorizando nosso esforço de pesquisa e trabalho, sobretudo considerando que de fato somos os únicos certificados pela França para prestar serviços e os distribuidores exclusivos do sistema no Brasil. Sphinx Consultoria Ltda Rua Peru, 211 - 92.420-300 - Canoas RS Brasil - Fone/Fax: 0xx51 - 477 3610 e-mail: [email protected] - Visite nosso site: http://www.sphinxbr.com.br Distribuidor EXCLUSIVO do Sphinx Único certificado e autorizado SPHINX na América Latina Freitas & Janissek – Análise léxica e Análise de conteúdo – p.164 SUPORTE TÉCNICO SPHINX O suporte técnico SPHINX é um serviço contratado anualmente e fornecido via e-mail ([email protected]) ou ainda por telefone/fax (0xx51-477-3610). No primeiro ano de licença, o suporte será gratuito, desde que o contato telefônico seja realizado pelo cliente. Os e-mails serão respondidos no mais breve espaço de tempo possível (24 horas em média). Existem outras maneiras de obter assistência enquanto você trabalha com o Sphinx: 1. Clicando sobre a figura da esfinge, no diálogo principal do sistema 2. A partir do menu ?, na opção de Índice do HELP, onde encontrará as principais explicações sobre o sistema SPHINX®; ou a opção Ajuda sobre, para procurar por tópicos, palavras ou frases específicas; e ainda a opção Aceleradores/Atalhos, que mostra as combinações de teclas que podem ser utilizadas no sistema. 3. O HELP pode ser ativado diretamente em Iniciar – Programas – Sphinx ou pelo ícone no Grupo de Programas. 4. No site do Sphinx (http://www.sphinxbr.com.br), onde você pode se conectar para acessar informações adicionais sobre as funcionalidades dos sistemas Sphinx, como dicas, artigos e casos variados, além da possibilidade de download de recursos técnicos, como demo dos sistemas, manuais, etc. Sphinx Consultoria Ltda Rua Peru, 211 - 92.420-300 - Canoas – RS - Fone/Fax: 0xx51 - 477 3610 e-mail: [email protected] - Visite nosso site: http://www.sphinxbr.com.br Único certificado e autorizado SPHINX na América Latina Distribuidor EXCLUSIVO do Sphinx Freitas & Janissek – Análise léxica e Análise de conteúdo – p.165 ARTIGOS, DEMO SPHINX® E DADOS DE CASOS Nos sites listados abaixo, é possível obter artigos que vão lhe conduzir para a criação de enquêtes, definição de questões, aplicação de pesquisas, entrada de dados, tratamentos e análises de dados quanti e qualitativos. Além disso, são também disponibilizados sistemas demo, autodemo e dados para que você seja introduzido no mundo de tabulações e análises de dados. http://www.sphinxbr.com.br http://www.adm.ufrgs.br/professores/hfreitas Sphinx® - sistemas de concepção de pesquisas e de análise estatística de dados quantitativos e qualitativos Alie rigor e flexibilidade na criação de pesquisas e análise de dados. Invista na qualidade de seus resultados e na rapidez de intervenção. O Sphinx® é uma ferramenta profissional para todos os tipos de pesquisa e análise. Confira! Visite nosso site http://www.sphinxbr.com.br Freitas & Janissek – Análise léxica e Análise de conteúdo – p.166 Lista de Funções SPHINX® 1. Questionário - elaboração Definição Até 1.000 (mil) questões abertas ou fechadas. Quatro tipos de questões fechadas: respostas únicas, múltiplas, ordenadas, ou escalares. Três tipos de questões abertas : numéricas, tipo texto (ou textuais), ou código (número ilimitado de modalidades associadas a listas de códigos, por exemplo códigos postais, datas, imagens). Exibição do questionário sob forma de lista. Diálogo de definição de uma questão: título da questão e nome das variáveis, lista das modalidades, número de respostas. Definição de atributos (entrada obrigatória, indicação de 'outros, quais?' numa questão aberta, ...). Modificações no questionário: supressões, inserções, deslocamento de questões. Criação de questões vizinhas pela duplicação ou pela utilização das funções Copiar/Colar. Criação de novas questões durante ou depois da entrada das respostas. Definição de desvios/pulos («Ir para questão... se...»). Possibilidade de agrupar questões do mesmo tipo. Ajuda na concepção Bibliotecas de questões classificadas por tema e pelo tipo de questões: consulta da biblioteca e inserção de questões da biblioteca no questionário. Criação de novas bibliotecas ou enriquecimento da biblioteca atual segundo o desejo do usuário. Edição e paginação Paginação automática, com casas de marcar ou preencher e impressão com opções de apresentação (cabeçalhos, comentários, tipo de letra e tamanho). Exportação para um arquivo ASCII (texto) ou para um arquivo MS Word (formatação). 2. Respostas - digitação Digitação ou entrada dos dados Modo direto (uma tela por questão): digitação com mouse. Modo rápido (um questionário por tela): via teclado, adaptada à entrada em série. Gravação automática. Saltos ou pulos ativados pelos envios. Abertura automática de uma casa de entrada para as questões « outro, especifique... » e utilização de abreviações para a digitação das questões texto. Entrada ou digitação das questões tipo código via um arquivo de códigos. Controle permanente das entradas (recusa de códigos errados, de valores fora dos limites, digitação obrigatória). Possibilidade de digitação multi-postos com reagrupamento posterior dos arquivos de respostas. Número máximo de observações: 32.000. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.167 Consultas, modificações No modo direto: possibilidade de adicionar à tela a resposta de uma outra questão. No modo rápido: exibição opcional das categorias codificadas ou em claro. Consulta do arquivo de respostas no modo planilha. Pesquisa e correção das respostas correspondendo a um perfil escolhido. Compatibilidade e exportações Compatibilidade com as versões brasileiras anteriores do Sphinx for Windows®. Exportação do questionário ou dos dados, de todas as respostas ou somente de certas questões num arquivo texto (.txt), com separadores modificáveis pelo usuário. Para as questões fechadas, categorias em claro ou codificadas. Edição de listas para mala-direta. Comunicação com outros programas, como o SPSS. Importações Importação das respostas para todo o questionário ou para certas questões a partir de um arquivo de formato texto (separadores modificáveis pelo usuário). Opções de importação: criação de novas observações ou modificação das existentes. Importação de uma base de dados no formato ASCII. Visualização e controle do arquivo. Identificação dos nomes e dos tipos de variáveis. Importação de dados de scanners. Importação de dados do SPSS. Importação de um texto. Definição de separações. Criação opcional dos indicadores de níveis e dos números de unidades. Gestão das anotações e criação de variáveis de contexto. Amostragem Ajuste de amostra por extração ou por substituição de respostas. Extração de uma amostra aleatória ou de um estrato. Simulação de uma amostra: determinação do tamanho, da precisão e do risco de erro. 3. Dados - processamento Tabulação Tabulação automática com resultados das tabulações simples, das tabulações cruzadas (entre 2 questões), das tabelas múltiplas ou recapitulativas. Opções: tabelas, histogramas, setores. Opções de apresentação: percentuais, freqüências, médias, qui-quadrado, não-respostas. Resultados na tela, num arquivo ou na impressora. Plano de tabulação Definição de vários tratamentos entre o conjunto de possibilidades oferecidas. Execução repetida em vários estratos. Listas estruturadas Lista das respostas a uma ou várias questões classificadas segundo a categoria de uma outra questão. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.168 Seleção dos elementos da lista, do critério de classificação e de eventuais condições restritivas. Opções de apresentação da lista. Estratos Definição de estratos pela combinação de seleções de respostas segundo operadores multicritérios de seleção: e, ou, exceto, >, <. Tratamentos efetuados sobre o estrato corrente ou (normalmente) sobre a amostra total. Consulta e análise do detalhe dos estratos definidos por uma variável. Questões tipo texto - recodificação Apresentação simultânea da questão e das categorias disponíveis para codificar seu conteúdo. Acréscimo de novas categorias em processo de recodificação. Apresentação de uma variável ilustrativa em relação à questão em processo de codificação. Gravação em uma nova variável ou retomada de uma codificação em andamento. Variáveis numéricas - criar classes Exibição de parâmetros: mínimo, máximo, soma, média, mediana, desvio-padrão, variância, quartis, decis. Lista dos valores da variável com menção do valor máximo e da média. Possibilidade de identificar as observações correspondentes aos valores da lista. Diagrama ou histograma interativo: acréscimos, supressões e modificações dos limites, (re)definindo novas classes. Opção diagrama e histograma: freqüências proporcionais à altura ou à superfície. Análise da tabela das freqüências (re)classificadas. Criação de uma nova variável fechada sobre as classes do histograma. Interpretar códigos Lista dos códigos e de suas freqüências. Possibilidade de identificar as observações correspondentes aos códigos (Número e Característica para uma outra variável). Definição manual de reagrupamentos ou reagrupamento automático sobre uma parte do código (códigos analíticos). Interpretação do código pelo título da questão ou categoria, conforme o arquivo de descrição dos códigos. Criação de uma nova variável, depois reagrupamento ou interpretação dos códigos. Descrever imagens Exibição simultânea da imagem e das modalidades disponíveis para codificar seu conteúdo. Acréscimo de novas modalidades em processo de leitura das questões. Apresentação de uma variável em relação à questão em processo de codificação. Gravação em uma nova variável ou retomada de uma codificação em andamento. Criação e supressão de variáveis Lista resumida das variáveis (nome, tipo, título da questão). Supressão de questões ou variáveis com atualização do arquivo de respostas. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.169 Criação de uma variável Número cujo conteúdo é o nº da observação ou questionário. Possibilidade de: esconder variáveis que não aparecerão mais nas listas; modificar o nome da variável ou transformar em escalares as questões tipo fechada única. Transformar uma variável Transformação de variável fechada por reagrupamento ou por exclusão de categorias. Uma variável de respostas fechadas ordenadas em n variáveis fechadas escalares. Uma variável fechada com n categorias em n variáveis tipo « sim/não ». Uma variável fechada com respostas múltiplas ou ordenadas numa variável numérica contendo o número ou quantidade de respostas. Uma variável numérica numa variável fechada escalar. Uma variável qualquer numa variável numérica, tipo código ou tipo texto. 4. Resultados - análise Navegação automática entre as telas Tabulação (consulta pelo desfile dos resultados) e Análise (ações em uma tabela). Troca de estrato com atualização automática da tabela em processo de análise. Comentário especial pela tradução (ou transformação) da significância dos testes estatísticos em mensagens. Tabelas recapitulativas Síntese das variáveis fechadas (categoria mais citada, menos citada, não-respostas). Síntese das variáveis numéricas (não-respostas, valor mínimo, valor máximo, soma, média, desvio-padrão). Síntese das variáveis tipo escalar (não-respostas, itens da escala, média, desvio-padrão). Síntese das variáveis tipo texto (não-respostas, número total de palavras, número médio de palavras, número de palavras diferentes, hapax (trecho que aparece uma única vez no texto), freqüência máxima, palavra mais freqüente). Tabelas de freqüências Supressão, reagrupamento, classificação, troca de linhas ou de colunas, modificação de títulos e comentários. Apresentação: gráfico de setores ou histogramas. (barras), opções por percentuais ou freqüências, escolha das dimensões dos gráficos. Caracterização das freqüências da cada célula ou casa de uma tabela ou de cada ponto de um mapa obtido pelo simples clique ou duplo clique sobre a célula escolhida. Tabelas (tabulações) simples Opções: % observações % citações, % acumulados, intervalos de confiança, comparação de freqüências, teste do qui-quadrado (Qui 2) em relação à eqüi-repartição ou à uma repartição de referência. Opção diagrama (altura proporcional) ou histograma (superfície proporcional). Classificação ou criação de novas classes das variáveis numéricas: modificável a partir do ambiente de análise. Conservação da última classificação. Tabelas (tabulações) cruzadas Apresentação das observações em freqüências ou em percentuais (linhas, colunas ou total). Qui-quadrado (Qui 2) por linha ou coluna, comparação entre 2 linhas, 2 colunas. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.170 Qui-quadrado sobre o conjunto da tabela, com apresentação em destaque das casas significativas. Diagrama de barras lado a lado ou em barras empilhadas (ou superpostas). Definição da altura dos elementos. Análise de correspondência (AC), com apresentação do mapa fatorial e dos parâmetros. Tabelas de características Tabela sintética, caracterizando as amostras definidas pelas categorias de uma variável em relação às categorias ou valores de outras variáveis. Caracterização absoluta: categorias mais citadas (variáveis fechadas), média e desviopadrão (variáveis numéricas). Caracterização relativa: categorias significativamente sobre-representadas (ou subrepresentadas) na amostra, ou valores médios significativamente superiores (ou inferiores) à média da amostra. Tabelas múltiplas Tabulações simples combinadas: criação de uma tabela cruzada pela justaposição da tabulação simples de diversas questões de categorias idênticas. Tabulações cruzadas justapostas: cruzamento de uma questão com várias outras. Justaposição de tabelas cruzadas. Tabulações simples subdivididas (ou ventiladas): cruzamento de uma questão com algumas das categorias pertencendo a outras questões. Todas as funções de análise das tabulações cruzadas se aplicam às tabelas múltiplas. Tabelas de dados externos Possibilidade de tratar os dados de uma tabela externa ao Sphinx. Entrada pelo teclado ou leitura de um arquivo ASCII. Análise como tabela de contingência (AC). Correlação Cálculo do coeficiente de correlação e dos parâmetros da reta de regressão linear. Apresentação da nuvem de pontos e da reta de regressão. Possibilidade de apresentar as características dos pontos e de colori-los em função de uma outra variável. Tipologia interativa pela localização de centros de classes e agregação dos pontos até o centro mais próximo. Análise interativa das freqüências de uma tabela ou do ponto de um mapa Identificação das observações pelo simples clique e detalhe por duplo clique sobre a célula de uma tabela ou sobre um ponto de um mapa. Retorno automático ao modo de digitação das respostas para eventuais correções. Ilustração e características das freqüências de uma célula segundo uma outra variável (valor, repartição, especificidade). Teste de especifidade da célula em relação à amostra total. Retomar uma análise A lista dos tratamentos efetuados é guardada na memória, todo tratamento efetuado durante uma sessão de trabalho pode ser retomado sem ser redefinido. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.171 5. Análise lexical (conteúdo, textos) Consulta e navegação lexical Apresentação do corpo do texto, observação por observação. Apresentação do léxico integral e navegação no interior deste corpo do texto. Apresentação do léxico pela ordem de freqüência (por ocorrências ou respostas), por ordem alfabética, por ordem de aparição ou de acordo com o tamanho das palavras. Redução do léxico de acordo com o tamanho das palavras ou pela eliminação das palavras-ferramentas (as quais são armazenadas em dicionários). As palavras do léxico podem ser marcadas usando-se o mouse, o teclado, um dicionário ou conforme a freqüência. Pesquisa disponível para uma palavra inteira, começo de palavra ou parte de palavra. Opções de pesquisa das observações em relação à palavra ativa sozinha, à presença simultânea de todas as palavras marcadas, a duas palavras marcadas consecutivas, ou pesquisa sem palavra marcada. Consulta seletiva do léxico ou das respostas, conforme as palavras marcadas. Cálculo dos parâmetros: tamanho do corpo, riqueza do léxico, tamanho e banalidade da resposta. Caracterização de uma palavra pelo seu ambiente (co-ocorrências, léxicos relativos). Caracterização de uma palavra pela análise das observações que a contêm: repartição das observações conforme qualquer outra variável, e comparação com a repartição sobre o conjunto da amostra. Cálculo da especificidade. Possibilidade de modificação dos dados em processo de consulta: modificação do texto da observação corrente, ou troca automática da palavra clicada em todo o texto. Utilização do léxico e dos dicionários Supressão das palavras marcadas ou não-marcadas. Definição de equivalência e reagrupamento dos termos equivalentes nos dicionários. Criação, enriquecimento e modificação dos dicionários, a partir das palavras marcadas do léxico ou utilizando o teclado. Possibilidade de truncar as palavras do dicionário. Saída Verbatim Possibilidade de definir um estrato lexical correspondendo somente às respostas contendo as palavras marcadas do léxico. Cópia da resposta corrente em um arquivo-texto. Cópia impressa ou em um arquivo-texto de todas as palavras do léxico ou de todas as respostas. Saída (salvar ou imprimir) das seleções correspondendo às respostas do estrato corrente contendo as palavras marcadas. Opções de apresentação em linhas ou colunas. Criação de variáveis lexicais Nova variável fechada sobre as palavras marcadas do léxico (codificação automática em função dos termos contidos na resposta): criação de uma variável dicotômica ou de uma variável com respostas fechadas múltipas, cujas categorias são as palavras marcadas no léxico. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.172 Tamanho da resposta: variável numérica contendo o número de palavras da resposta (possibilidade de restrição às palavras marcadas somente). Uma única variável para o conjunto de palavras marcadas. Intensidade lexical: variável numérica contendo a relação entre o número de palavras marcadas e o número total de palavras de uma resposta. Uma única variável para o conjunto de palavras marcadas. Possibilidade de criar uma variável por palavra marcada para as variáveis Tamanho da resposta, Intensidade lexical. Banalidade da resposta: variável numérica indicando a freqüência média de aparição das palavras contidas na resposta (possibilidade de restrição às palavras marcadas somente). Variável texto modificado: nova variável texto contendo somente as palavras selecionadas no léxico. Possibilidade de criar uma nova variável texto, modificada, na qual as palavras marcadas consecutivas são associadas. Fracionar as respostas para os separadores escolhidos. Essa função cria uma nova base, na qual as observações iniciais são fracionadas em função dos separadores que elas contêm. Essa função permite fazer variar o nível de análise (documento, parágrafo, ...). Segmentos repetidos Pesquisa de todas as seqüências de palavras sucessivas presentes no corpo. Parametragem da pesquisa: comprimento dos segmentos, freqüência, conteúdo. Possibilidade de ignorar as palavras-ferramentas. Criação de uma variável associando os segmentos. Processamento das palavras compostas e expressões Criação e utilização de listas de expressões a partir das palavras do léxico ou de um dicionário, pesquisa das expressões da lista no corpo do texto. Produção de índice Cálculo, para cada palavra, do léxico dos números de observações contendo essas palavras, possibilidade de fabricar índices. Ambiente de uma palavra Concordância: apresentação do trecho do texto (frase, grupo, ...) contendo a palavra selecionada. Apresentação da lista de fragmentos em questão. Opções de apresentação da lista das concordâncias: centrada ou não sobre a palavra selecionada, com ou sem as palavras suprimidas eventualmente do léxico. Léxicos relativos: apresentação pela ordem das ocorrências decrescentes dos léxicos, à esquerda e à direita da palavra da qual estamos procurando o ambiente (palavra pivô). Definição dos léxicos: 4 léxicos (pivô-2, pivô-1, pivô+1, pivô+2), 2 léxicos (pivô-2 a -1, pivô 1 a 2), 1 léxico (pivô -2 a 2). Cálculos: número de ocorrências em um lugar (a), número total de ocorrências (b), percentual (a/b). Possibilidade de parametrizar os separadores para a pesquisa das concordâncias e léxicos relativos (separador de frase, grupo ou outro separador). Saída das listas e léxicos relativos à impressora, em um fichário ou no bloco de notas. Opções de apresentação em linha ou em coluna. Definição e seleção das frases mais características. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.173 Lematização O Sphinx utiliza um instrumento de análise sintática e um dicionário de francês de 61.400 entradas, 521.400 formas lexicais e 25.600 locuções, produzido pela Langage Naturel SA. (sistema externo ao Sphinx, disponível somente em francês e em inglês, não disponibilizado em português). Criação de uma nova variável texto a partir do corpo do texto lematizado. Criação de um corpo lematizado, no qual cada palavra aparece sob a sua forma canônica (masculino singular para os substantivos e os adjetivos, infinitivo para os verbos), provida de uma marca definindo sua classe gramatical. Tabela lexical Cruzamento das palavras selecionadas no corpo do texto com uma ou várias variáveis fechadas. Cálculo do número de vezes em que as palavras em linha estão presentes numa resposta correspondendo às categorias em coluna. Cálculo dos percentuais em linha, coluna, testes do qui-quadrado, testes de especificidade. Possibilidade de imprimir ou copiar a tabela. 6. Aprofundar a estatística Análise de médias Cruzamento de uma questão fechada com uma ou mais variáveis numéricas ou escalares (até 50 modalidades possíveis). Para cada categoria correspondendo às categorias da questão fechada, cálculo da soma, da média e do desvio-padrão das variáveis numéricas. Para cada variável numérica, teste de comparação entre a média de cada categoria ou modalidade e a média para todos os indivíduos. Teste t. Para cada variável numérica, análise da variância aplicada à divisão em categorias. Advertência na tela das células para as quais o Teste t ou Fischer são significativos. Definição dos níveis de significância. Apresentação da tabela de médias, desvios-padrão, freqüências. Supressão de colunas ou linhas, reagrupamento de modalidades ou categorias. Permutação da tabela conforme a ordem crescente ou decrescente da coluna. Gráfico de dispersão, gráfico perfil, etc. Análise dos componentes principais (ACP) dos dados da tabela. Matriz ou diagrama dos coeficientes de correlação. Mapa dos planos fatoriais (combinação dos 5 primeiros componentes). Apresentação seletiva das categorias, dos critérios e do círculo de correlação. Classificação automática Classificação em relação a variáveis quantitativas e qualitativas ou quantitativas e booleanas. Método de centros móveis (nuvens dinâmicas; K-means). Escolha do número de classes com uma divisão inicial aleatória. Ajustamento de uma classificação inicial criada por uma variável escolhida. Criação de uma nova variável identificando cada indivíduo pertencente a uma das classes. Cálculo dos indicadores caracterizando a classificação obtida (homogeneidade, poder discriminante). Freitas & Janissek – Análise léxica e Análise de conteúdo – p.174 Análise fatorial das correspondências múltiplas (AFC) Análise multi-variada de questões fechadas. Tabela de freqüências, extração dos 5 primeiros eixos, tabela de contribuições, percentual de variância explicada. Mapas fatoriais, escores fatoriais e tipologia. Análise dos componentes principais (ACP) Análise multi-variada de variáveis numéricas e escalares. Matriz ou gráfico dos coeficientes de correlação, extração dos 5 primeiros componentes, tabela das contribuições, percentual de variância explicada. Mapas fatoriais, escores fatoriais e tipologia interativa. Mapas fatoriais Escolha do plano de projeção pela permutação dos eixos horizontais ou verticais. Ajuste do limite de projeção dos pontos em função do seu ângulo com o plano, e indicação do número de pontos não-projetados. Exibição dos indivíduos ou das categorias/critérios (opções dos nº do indivíduo, tamanho dos pontos, detalhamento das respostas relativas a uma observação, cores, etc.) Apresentação dos indivíduos ou categorias proporcionalmente às freqüências. Grade de contagem dos indivíduos por zona. Copiar/Colar num editor de textos (imagem vetorizada) o mapa corrente e as matrizes de correlação, tabela de BURT e contribuições. Tipologia Definição interativa das classes de indivíduos em função da sua posição no mapa atual. Agregação dos indivíduos por proximidade aos pontos móveis. Adicionar/suprimir novos centros de classes. Estabelecimento de cores dos indivíduos-pontos em função da sua proximidade e sua vinculação à uma classe. Criação de variáveis Escores fatoriais (variável contendo a coordenada do ponto para o eixo ou o componente escolhido) e variável tipológica (variável fechada indicando a vinculação de cada ponto a um dos grupos definidos no mapa atual). Correlação e regressão múltipla Até 20 variáveis explicativas, matriz e diagrama de correlação. Perfil gráfico dos coeficientes de correlação das variáveis explicativas com a variável explicada, opções de classificação, gráfico simultâneo do valor médio das variáveis explicativas e do coeficiente de correlação com a variável explicada. Regressão múltipla passo a passo. Acréscimo ou supressão de variáveis explicativas. Criação de uma nova variável igual ao valor calculado da variável a explicar. Criação de uma nova variável igual ao resíduo. Combinar variáveis Variável contador: variável numérica, soma respostas (categorias ou intervalos) indicadas, ponderadas por um coeficiente; Escolha das questões e categorias (operadores =, _, <, >), entrada do valor para cálculo. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.175 Variável perfil: variável fechada cujas categorias correspondem a combinações lógicas multi-variáveis; Definição das combinações qualificando cada modalidade do perfil (operadores =, _, >, >, e, ou, exceto). Variável fusão: variável fechada tendo por categorias as categorias de duas variáveis (fusão simples) ou todas para os casos obtidos pelo cruzamento destas variáveis (fusão cruzada); Escolha das variáveis a fusionar (reunir) e da opção (fusão simples ou fusão cruzada). Variável Multi_Sim/Não criação de uma variável fechada múltipla a partir de n variáveis de respostas tipo sim/não. Variável Verbose: variável aberta tipo texto reunindo as respostas com várias questões de diferentes tipos. Identificador: variável de tipo código, identificando uma observação pelo seu número ou suas iniciais (ou cifras) das respostas a diferentes variáveis. Estrato: variável fechada cujas modalidades são escolhidas dentre os estratos definidos. Duração: variável numérica, diferença em dias (ou horas) de duas datas (tempo). Calcular uma nova variável Definição de uma nova variável definida como função algébrica ou lógica de várias outras (Constantes, operadores aritméticos, funções potência, log., exp., cos., etc.) Digitação direta da expressão (ou indicador) como uma fórmula matemática. Definição calculadora da expressão pela seleção das variáveis e ação sobre os botões Possibilidade de substituir as não-respostas pela média das variáveis. 7. Relatório - elaboração Todos os testes estatísticos são interpretados e são objeto de uma mensagem formal. Possibilidade de modificar os títulos e os comentários provenientes do Sphinx. Impressão de todas as análises (tabelas, gráficos, comentários). Alta precisão na impressão a laser ou a jato de tinta (modo vetorial). Opções de paginação (orientação das folhas, paginação das tabelas e gráficos, modo especial para retroprojeção). Opção Copiar/Colar (títulos, comentários, tabelas ou gráficos, textos). Criação de documentos no Word contendo textos, imagens ou tabelas. possibilidade de ativar os estilos e níveis de plano do Word. Comunicação direta com o editor de textos: a opção Incluir no relatório (menu Arquivo) permite inserir diretamente em um documento a análise atual. Exportação num arquivo texto dos valores de uma tabela (para criar gráficos em um sistema especializado, como o Excel® ou o PowerPoint®). Possibilidade de ativar as ações de gestão de arquivos, edição de listas de mala direta, consulta de fichas graças às funções Definir um estrato, Exportar e Consultar. 8. Funções de ajuda (help) e ferramentas em linha (on line) Help on line: acesso pelo contexto ou pelo índice. Envios ao interior da ajuda. Ajuda personalizada, criada e modificável pelo usuário. Acesso direto à calculadora, ao bloco de notas e ao gerenciador de arquivos. Definição do tipo de caractere, cores e opções de apresentação. Freitas & Janissek – Análise léxica e Análise de conteúdo – p.176 Sphinx: fácil, pedagógico e inovador Receba maiores informações sobre os sistemas e serviços Sphinx®. Basta retornar este formulário preenchido. Retornar para Sphinx Consultoria Ltda. Rua Peru 211 – Canoas RS – cep 92420-300 Fone/fax 0xx51 3477 3610 e-mail: [email protected] Nome: Empresa: Endereço: Cidade/UF: Fone/fax: E-mail: Sim, eu tenho interesse em receber maiores informações sobre: Os módulos* [ ] Sphinx Scanner [ ] Sphinx Data Entry [ ] Sphinx Multimídia [ ] Sphinx ODBC [ ] Sphinx Print [ ] Sphinx Basic [ ] Sphinx Ergo-3d [ ] Sphinx Multilíngua *somente para quem já possui um dos sistemas Sphinx Os sistemas [ ] Sphinx Léxica [ ] Sphinx Plus2 [ ] Sphinx Primo [ ] Eurêka! Os serviços Sphinx® [ ] Treinamento in company [ ] Treinamento por turma [ ] Suporte Acesse nosso site: http://www.sphinxbr.com.br Distribuidor EXCLUSIVO do Sphinx Único certificado e autorizado SPHINX na América Latina Freitas & Janissek – Análise léxica e Análise de conteúdo – p.177 Freitas & Janissek – Análise léxica e Análise de conteúdo – p.178