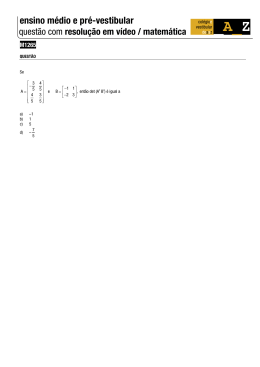

Diagonalizando uma matriz dois por dois simétrica É muito comum no curso de bacharelado em física termos que diagonalizar matrizes de ordem dois ou três. Em mecânica quântica, principalmente, há uma imensidão de exercícios que requerem a diagonalização de hamiltonianas dois por dois. O problema de spin 1/2 em um campo magnético externo, por exemplo, é sempre abordado nos cursos de mecânica quântica. Mesmo em mecânica clássica há problemas que envolvem a diagonalização de pequenas matrizes quadradas, nem sempre simétricas. O problema de dois osciladores harmônicos acoplados, por exemplo, envolve a diagonalização de uma matriz de ordem dois. Nesta postagem vou diagonalizar uma matriz dois por dois simétrica, com elementos reais, dada a importância desse caso no curso de graduação e mesmo de pósgraduação. Farei uma exposição específica para este problema particular, de ordem dois, mas, quando discutir o determinante que dá os autovalores, farei uma digressão bem completa sobre a fórmula para calcular, no caso de dimensão finita qualquer, o determinante do produto de duas matrizes. Vamos considerar a diagonalização de uma matriz simétrica 2 × 2, com elementos reais. Seja essa matriz dada por a c M = , (1) c b com a, b e c números reais. Para que a diagonalização não seja trivial, vamos supor que c 6= 0. Sem perder a generalidade, vamos supor também que c > 0, pois, no caso tivéssemos c negativo, bastaria diagonalizar a matriz −M, ao invés de M. A Eq. (1) mostra que a matriz é simétrica, pois sua transposta é idêntica a ela mesma, isto é, Mt = M. (2) Devemos encontrar uma matriz N, com inversa, N −1 , tal que N −1 M N = D, (3) onde D é uma matriz diagonal, D = λ1 0 0 λ2 , (4) e λ1 e λ2 são os chamados “autovalores de M ”. Podemos reescrever a Eq. (1) assim: 1 0 0 c M = a + , (5) 0 1 c d onde, por conveniência notacional, definimos d ≡ b − a. 1 (6) Substituindo a Eq. (5) na Eq. (3), dá 1 0 0 N −1 a + 0 1 c c d 0 c c d N = D, isto é, aN −1 1 0 0 1 N +N −1 N = D, ou seja, N −1 0 c c d = D−a N 1 0 0 1 λ1 − a 0 = 0 λ2 − a , (7) pois N −1 1 0 0 1 = N −1 N = N 1 0 0 1 . (8) Da Eq. (7) vemos que a matriz H ≡ 0 c c d (9) é diagonalizável pela mesma matriz N que diagonaliza a matriz original, M, da Eq. (1). Note, na Eq. (7), que os autovalores da matriz H são λ1 − a e λ2 − a. Vamos, portanto, diagonalizar a matriz H, da Eq. (9). Mas, antes, vamos ver o que significa diagonalizar uma matriz. Da Eq. (3), podemos escrever MN = N D, (10) onde multiplicamos, pela esquerda, ambos os membros da Eq. (3) por N e usamos a definição da inversa da matriz N, isto é, N N −1 = N −1 N = I, (11) onde I ≡ 1 0 0 1 . (12) Vamos escrever uma forma explícita para a matriz N : N1,1 N1,2 N ≡ , (13) N2,1 N2,2 onde devemos encontrar os elementos Ni,j , para i, j = 1, 2. Multiplicando a Eq. (13) pela Eq. (4), obtemos N1,1 N1,2 λ1 0 ND = N2,1 N2,2 0 λ2 λ1 N1,1 λ2 N1,2 = . (14) λ1 N2,1 λ2 N2,2 2 Substituindo as Eqs. (13) e (14) na Eq. (10) e usando a Eq. (1) para a matriz M, encontramos a equação matricial: a c N1,1 N1,2 λ1 N1,1 λ2 N1,2 = . (15) c b N2,1 N2,2 λ1 N2,1 λ2 N2,2 Mas, a c c b N1,1 N2,1 N1,2 N2,2 = aN1,1 + cN2,1 cN1,1 + bN2,1 aN1,2 + cN2,2 cN1,2 + bN2,2 Com a Eq. (16), a Eq. (15) agora escreve-se aN1,1 + cN2,1 aN1,2 + cN2,2 λ1 N1,1 = cN1,1 + bN2,1 cN1,2 + bN2,2 λ1 N2,1 λ2 N1,2 λ2 N2,2 . (16) . (17) Como a Eq. (17) é, sem dúvida, uma igualdade matricial, cada elemento da matriz escrita no membro esquerdo deve ser igual ao seu correspondente no membro direito da equação. Em particular, a primeira coluna da matriz do primeiro membro da Eq. (17) deve ser igual à primeira coluna do segundo membro e, portanto, aN1,1 + cN2,1 λ1 N1,1 = . (18) cN1,1 + bN2,1 λ1 N2,1 Mas a Eq. (18) pode ser reescrita assim: a c N1,1 N1,1 = λ1 . c b N2,1 N2,1 (19) Você pode verificar também que igualando a segunda coluna da matriz da esquerda da Eq. (17), com a segunda coluna da matriz da direita dessa equação, resulta em a c N1,2 N1,2 = λ2 . (20) c b N2,2 N2,2 As Eqs. (19) e (20) são as chamadas equações de autovalores e autovetores. Os números λ1 e λ2 já foram identificados como os autovalores da matriz M logo abaixo da Eq. (4). As duas colunas da matriz N, que aparecem, respectivamente, nas Eqs. (19) e (20), são os chamadas “autovetores da matriz M ”, caso não sejam nulas, isto é, um autovetor não pode ser nulo, por definição. A Eq. (3) define o que é a diagonalização de uma matriz. As Eqs. (19) e (20) são, como vimos acima, equivalentes à Eq. (3). É por causa dessa equivalência que, para diagonalizar uma matriz, podemos proceder encontrando seus autovalores e autovetores. Aqui, embora estejamos tratando o caso de uma matriz simétrica 2 × 2, você pode verificar que a equivalência entre a definição da Eq. (3) e o correspondente conjunto de equações de autovalores e autovetores vale também para o caso de matrizes não simétricas e de maior dimensão, desde que sejam 3 matrizes quadradas e que seja possível diagonalizá-las. No caso de matrizes simétricas, sempre é possível diagonalizá-las, embora eu não demonstrarei isso aqui. Voltando para a diagonalização da matriz H, da Eq. (9), precisamos encontrar todos os números λ e autovetores U, tais que HU = λU. (21) Definamos, portanto, ≡ U α β . (22) Usando as Eqs. (9) e (22), podemos reescrever a Eq. (21) como 0 c α α = λ , c d β β isto é, −λ c c d−λ α β = 0 0 , (23) ou, equivalentemente, usando as Eqs. (12) e (21) HU − λU = 0, HU − λIU = 0, ou seja, ou ainda, (H − λI) U = 0. (24) −1 Se a inversa da matriz (H − λI) existir, podemos denotá-la por (H − λI) . Então, a Eq. (24) pode ser multiplicada por essa matriz inversa, pela esquerda, e obtemos (H − λI) −1 (H − λI) U = 0, isto é, IU = 0, ou seja, U = 0. (25) Então, se existir a inversa da matriz (H − λI) , não encontraremos os autovetores da matriz H. Qual a condição para que uma matriz não possa ser invertida? 4 Para encontrar essa condição, vamos considerar a matriz N, da Eq. (13). Para encontrar sua inversa, precisamos encontrar uma outra matriz, denotada N −1 , tal que a Eq. (11) seja válida. Tomemos, para começar, o determinante da Eq. (11): det N N −1 = det N −1 N = det (I) = 1. (26) É muito fácil ver que o determinante da identidade é igual à unidade, para qualquer dimensão do espaço de matrizes quadradas. Mas qual o valor do determinante de um produto de duas matrizes quadradas? Para responder a esta questão, vamos considerar o produto de duas matrizes, A e B. Um elemento qualquer desse produto é dado por (AB)i,j = P X Ai,k Bk,j , (27) k=1 onde P é um número inteiro representando o número de elementos de uma linha ou coluna das matrizes P × P, também chamado de “ordem da matriz”. O determinante de uma matriz A pode ser definido como det (A) ≡ P! X sig σqP q=1 P Y Ai,σqP (i) , (28) i=1 onde σqP é a função que dá a q-ésima permutação de P números inteiros, de 1 até P, e sig σqP é o sinal da permutação σqP . Há P ! dessas permutações. Por exemplo, vamos considerar matrizes 3 × 3. Nesse caso, há 3! = 3 · 2 · 1 = 6 permutações. Podemos representar essas permutações por (1, 2, 3) , (1, 3, 2) , (2, 3, 1) , (2, 1, 3) , (3, 1, 2) e (3, 2, 1) . Não há mais permutações de 1 a 3 além dessas seis. A primeira, definimos como sendo σ13 , a segunda, como σ23 , e assim sucessivamente até que a sexta é definida como σ63 . Poderíamos trocar a ordem dos índices inferiores dessas funções a nosso bel-prazer, sem alterar o resultado da definição da Eq. (28); depois da explicação que segue, você pode pensar e ver que isso é verdade. Então, essas seis funções atuam nos números 1, 2 e 3 dando: σ13 (1) , σ13 (2) , σ13 (3) = (1, 2, 3) , (29) σ23 (1) , σ23 (2) , σ23 (3) = (1, 3, 2) , (30) σ33 (1) , σ33 (2) , σ33 (3) = (2, 3, 1) , (31) σ43 (1) , σ43 (2) , σ43 (3) = (2, 1, 3) , (32) σ53 (1) , σ53 (2) , σ53 (3) = (3, 1, 2) (33) 5 e σ63 (1) , σ63 (2) , σ63 (3) = (3, 2, 1) . (34) O sinal de uma determinada permutação, digamos σ53 , por exemplo, é calculado tomando −1 elevado ao número de inversões da terna dada, neste particular exemplo, por σ53 (1) , σ53 (2) , σ53 (3) = (3, 1, 2) , conforme mostra a Eq. (33). O número de inversões em uma permutação σqP , de P números, é dada pelo número de pares (i, j) , no conjunto desses P números, tais que i < j e, ao mesmo tempo, σqP (i) > σqP (j) . Neste exemplo, há duas inversões na permutação σ53 : (1, 2) e (1, 3) , pois σ53 (1) = 3 > 1 = σ53 (2) e σ53 (1) = 3 > 2 = σ53 (3) . Então, essa permutação σ53 tem sinal positivo, isto é, sig σ53 = 1, pois tem um número par de inversões. Você pode facilmente verificar que, por exemplo, sig σ63 = −1, pois o número de inversões na permutação σ63 é ímpar, correspondendo aos pares (1, 2) , (1, 3) e (2, 3) , de acordo com a Eq. (34). Vamos, então, usar a Eq. (28) para ver o que dá o determinante de uma matriz 3 × 3 : det (A) = 6 X sig σq3 q=1 = 6 X 3 Y Ai,σq3 (i) i=1 sig σq3 A1,σq3 (1) A2,σq3 (1) A3,σq3 (1) , (35) q=1 Q onde expandimos o produtório. Uma pequena digressão sobre o símbolo é oportuna neste ponto. Produtórios são análogos a somatórios, exceto que, ao invés de somar termos, produtórios multiplicam fatores. Por exemplo, o produtório que dá 6! = 6 · 5 · 4 · 3 · 2 · 1 é escrito como 6 Y l = 1 · 2 · 3 · 4 · 5 · 6. (36) l=1 Veja, que, como no caso de somatórios, a ordem nos produtórios pode ser invertida sem que haja alteração no resultado final: 1 Y l = 6·5·4·3·2·1=1·2·3·4·5·6= 6 Y m, (37) m=1 l=6 onde usamos a Eq. (36) na última igualdade. Também, em analogia com somatórios, o índice aparecendo em um produtório é irrelevante, como explicitado na Eq. (37). O índice em um produtório é também dito “mudo”, como no caso de índices aparecendo em somatórios. Retornemos à Eq. (35). Podemos agora expandir o somatório e obter det (A) = sig σ13 A1,σ13 (1) A2,σ13 (1) A3,σ13 (1) + sig σ23 A1,σ23 (1) A2,σ23 (1) A3,σ23 (1) + sig σ33 A1,σ33 (1) A2,σ33 (1) A3,σ33 (1) + sig σ43 A1,σ43 (1) A2,σ43 (1) A3,σ43 (1) + sig σ53 A1,σ53 (1) A2,σ53 (1) A3,σ53 (1) + sig σ63 A1,σ63 (1) A2,σ63 (1) A3,σ63 (1) , 6 que, com as Eqs. desde (29) até (34), também permite que esse determinante seja escrito como det (A) = A1,1 A2,2 A3,3 − A1,1 A2,3 A3,2 + A1,2 A2,3 A3,1 − A1,2 A2,1 A3,3 + A1,3 A2,1 A3,2 − A1,3 A2,2 A3,1 , (38) onde já calculamos os sinais das permutações, contando quantas inversões há em cada uma. Lembrando as regras e a notação para determinantes 3 × 3 do segundo grau, podemos ver que a Eq. (38) também pode ser escrita assim: = A1,1 (A2,2 A3,3 − A2,3 A3,2 ) − A1,2 (A2,1 A3,3 − A2,3 A3,1 ) det (A) + A1,3 (A2,1 A3,2 − A2,2 A3,1 ) A A2,2 A2,3 − A1,2 2,1 = A1,1 A3,1 A3,2 A3,3 A A2,3 + A1,3 2,1 A3,1 A3,3 A2,2 , A3,2 ou seja, det (A) = A1,1 A2,1 A3,1 A1,2 A2,2 A3,2 A1,3 A2,3 A3,3 , (39) como é ensinado no segundo grau. Uma vez que nos certificamos de que a definição para determinantes da Eq. (28) é, nos casos particulares que conhecemos, o que já sabemos, podemos proceder com o cálculo do determinante do produto de duas matrizes. Usando a Eq. (28), mas trocando os elementos da matriz A por aqueles do produto AB, dados pela Eq. (27), obtemos det (AB) = P! X sig σqP P Y q=1 = P! X (AB)i,σqP (i) i=1 sig σqP P Y P X i=1 ki =1 q=1 ! Ai,ki Bki ,σqP (i) , (40) onde precisamos introduzir o subíndice i ao índice k para não confundir os produtos de somatórios que aparecem quando expandimos o produtório. Vamos expandir o produtório da Eq. (40). Então, det (AB) = P! X sig σqP q=1 P X k1 =1 ··· P X A1,k1 . . . AP,kP Bk1 ,σqP (1) . . . BkP ,σqP (P ) . Mas, a ordem de somatórios não importa e, portanto, podemos reescrever a Eq. (41) como " P! # P P X X X P det (AB) = ··· A1,k1 . . . AP,kP sig σq Bk1 ,σqP (1) . . . BkP ,σqP (P ) . k1 =1 (41) kP =1 q=1 kP =1 7 (42) Considere uma sequência de números (k1 , . . . , kP ) e a quantidade entre colchetes da Eq. (42). Suponha que dois desses números sejam iguais. Nesse caso, devemos mostrar que a quantidade entre colchetes é nula. Primeiro, considere o caso em que P = 2. Então, 2! X sig σq2 Bk1 ,σq2 (1) Bk2 ,σq2 (2) = Bk1 ,1 Bk2 ,2 − Bk1 ,2 Bk2 ,1 , (43) q=1 onde definimos σ12 (1) , σ12 (2) ≡ (1, 2) e σ22 (1) , σ22 (2) ≡ (2, 1) . No caso em que k1 = k2 , vemos que a Eq. (43) dá zero. Considere agora o caso em que P =3: 3! X sig σq3 Bk1 ,σq3 (1) Bk2 ,σq3 (2) Bk3 ,σq3 (3) = Bk1 ,1 Bk2 ,2 Bk3 ,3 − Bk1 ,1 Bk2 ,3 Bk3 ,2 + Bk1 ,2 Bk2 ,3 Bk3 ,1 − Bk1 ,2 Bk2 ,1 Bk3 ,3 + Bk1 ,3 Bk2 ,1 Bk3 ,2 − Bk1 ,3 Bk2 ,2 Bk3 ,1 , q=1 onde usamos as Eqs. de (29) a (34) para definir σq3 . É fácil verificar que se dois dos números k1 , k2 e k3 forem iguais, a Eq. (44) dá zero. Verifique! Para qualquer P, a soma entre colchetes da Eq. (42) dá zero. Para ver isso, considere um dos termos da soma entre colchetes, que é dado por, digamos, sig σqP Bk1 ,σqP (1) . . . Bkm ,σqP (m) . . . Bks ,σqP (s) . . . BkP ,σqP (P ) , (45) onde km = ks e 1 < m < s < P. Entre os termos da soma entre colchetes da Eq. (42) há, para cada termo como o (45), um outro, proveniente de outra permutação, σqP0 , dada por σqP0 (i) = σqP (i) , (46) para i = 1, . . . , m − 1, m + 1, . . . , s − 1, s + 1, . . . , P. Necessariamente, então, para esses dois termos, σqP0 (m) σqP (s) (47) = σqP (m) , (48) = e σqP0 (s) já que não pode haver duas permutações iguais na soma sobre as permutações. Então, para cada termo como o (45), há um outro como sig σqP0 Bk1 ,σqP (1) . . . Bkm−1 ,σqP (m−1) Bkm ,σqP (s) Bkm+1 ,σqP (m+1) . . . ×Bks−1 ,σqP (s−1) Bks ,σqP (m) Bks+1 ,σqP (s+1) . . . BkP ,σqP (P ) , (49) onde usamos as Eqs. (46), (47) e (48). Como, por hipótese, km = ks , os termos (45) e (49) só diferem pelo seu sinal: um tem o fator sig σqP , enquanto 8 (44) o outro tem um fator sig σqP0 . Esses sinais são opostos. Para ver isso, note que σqP (m) > σqP (s) ou σqP (s) > σqP (m) , pois não podem ser iguais, uma vez que m < s, por hipótese. Para que a permutação σqP seja convertida na permutação σqP0 , temos que proceder a um número ímpar de trocas entre dois números adjacentes na sequência dada por σqP (1) , . . . σqP (P ) . Por exemplo, para que a sequência dada por (1, 3, 8, 2, 6, 7, 4, 5) seja convertida na sequência (1, 3, 8, 4, 6, 7, 2, 5) , precisamos trocar 2 com 6, depois, 2 com 7 e, depois, 2 com 4, obtendo (1, 3, 8, 6, 7, 4, 2, 5) . A seguir, temos que trocar 4 com 7 e, depois, 4 com 6, em um total de 5 trocas. Cada vez que trocamos dois números adjacentes, a nova permutação deve trocar de sinal com relação à anterior, já que um número na sequência é sempre maior, ou menor, do que outro. Para trocar um dos números com qualquer outro, devemos trocar um deles com cada um dos n números entre os dois, trocá-los entre si, quando estiverem adjacentes, e, depois, trocar o outro número com os mesmos n números que estavam, no início, entre eles. Temos, assim, que efetuar 2n + 1 trocas entre números adjacentes, isto é, temos sempre um número ímpar de trocas. Cada troca adjacente muda o sinal da permutação e, portanto, a troca entre dois números quaisquer sempre muda o sinal da permutação, com relação à permutação de partida. Uma vez que demonstramos que a presença de índices ki repetidos em termos que não se cancelam na Eq. (42) não ocorre, então, de todos os termos possíveis, somente aqueles que têm todos os índices ki não nulos podem permanecer sem se cancelar. Assim, os somatórios da Eq. (42) contribuem com termos não nulos somente para permutações da sequência de índices ki , de 1 até P. Logo, a Eq. (42) pode ser reescrita como " P! # P! X X P det (AB) = A1,σrP (1) . . . AP,σrP (P ) sig σq BσrP (1),σqP (1) . . . BσrP (P ),σqP (P ) . r=1 (50) q=1 Vamos olhar para a soma entre colchetes. Em cada termo da soma, podemos reordenar os fatores todos de forma a obter os primeiros índices dos fatores Bi,j na ordem crescente de 1 até P. Essa é justamente a permutação inversa de σrP . Vamos denotar essa permutação inversa como σ̄rP . Então, a soma entre colchetes pode ser escrita como P! X sig σqP BσrP (1),σqP (1) . . . BσrP (P ),σqP (P ) = q=1 P! X sig σqP B1,σ̄P (σP (1)) . . . BP,σ̄P (σP (P )) r q r q q=1 = P! X sig σqP B1,(σ̄P ◦σP )(1) . . . BP,(σ̄P ◦σP )(P ) , r q r q q=1 onde σ̄rP ◦σqP é a composição das duas permutações. É evidente que a composição de duas permutações é também uma permutação. Então, seja σuP ≡ σ̄rP ◦ σqP . (52) Precisamos relacionar o sinal de σuP com os sinais de σ̄rP e σqP . Note que qualquer permutação pode ser feita através de uma sequência de trocas entre dois 9 (51) números. Mas, como vimos, cada uma dessas trocas, ou transposições, muda o sinal da permutação com relação à permutação anterior à transposição. Assim, na Eq. (34), por exemplo, partimos de (1, 2, 3) e chegamos a (3, 2, 1) . Podemos fazer vários caminhos diferentes para chegar à permutação final. Por exemplo, podemos fazer a transposição a seguir: (1, 2, 3) → (3, 2, 1) e pronto, uma só transposição, entre 1 e 3, dando, portanto, um sinal negativo para a permutação final. Veja que o sinal coincide com aquele obtido através do número de inversões, que neste caso é 3. Poderíamos ter feito outro caminho, por exemplo: (1, 2, 3) → (2, 1, 3) , (2, 1, 3) → (2, 3, 1) depois e (2, 3, 1) → (3, 2, 1) , ou seja, três transposições adjacentes, isto é, cada uma dessas transposições é uma troca entre dois números adjacentes na sequência: a troca entre 1 e 2, depois a troca entre 1 e 3 e, finalmente, a troca entre 2 e 3. De novo, o número de transposições é ímpar, dando um sinal negativo, idêntico ao sinal da permutação final. Não importa o caminho que fizermos, −1 elevado ao número de transposições para chegar ao destino final dá igual ao sinal da permutação. Para provar isso no caso geral, note primeiro que sempre é possível, através de transposições, chegar ao resultado da permutação desejada, partindo da sequência de 1 até P. E, como já vimos acima, uma transposição qualquer é composta de um número ímpar de transposições adjacentes. Então, escolha um caminho qualquer para o destino desejado. Esse caminho pode, portanto, ser decomposto por uma sequência de permutações adjacentes. O que precisamos mostrar, portanto, é que, para qualquer caminho, o número de inversões da permutação final, mais o número de transposições adjacentes do caminho, tem que ser um número par. Se demonstrarmos isso, para qualquer caminho, ou o número de transposições adjacentes é ímpar, assim como o número de inversões da correspondente permutação final, ou é par, quando também o é o número de inversões da permutação considerada. Para ver isso, seja L o número de transposições adjacentes que leva a sequência de 1 a P à permutação final desejada, suposta N consistir de N inversões e, portanto, com sinal (−1) . Agora, inverta cada uma das transposições adjacentes. Cada uma dessas transposições multiplica por −1 o sinal da permutação parcial resultante. Após a reversão de todas as L transposições adjacentes, o resultado é o de partida: a sequência original de 1 a P. O sinal dessa permutação é +1, pois é a permutação identidade. Logo, como o número de inversões na permutação em análise era N e, portanto, seu 10 N sinal era (−1) , após as L transposições adjacentes inversas, esse sinal ficou L multiplicado por (−1) , com o resultado que L N (−1) (−1) = 1, ou seja, L + N deve ser par, para qualquer caminho que leve a sequência de 1 a P à permutação desejada. Então, se N for par, L também o será e, se N for ímpar, L será ímpar também, para qualquer caminho. Assim, −1 elevado ao número de transposições adjacentes, de qualquer caminho, sempre dará o sinal da permutação desejada. Retornemos, então, para a Eq. (52). Tome um caminho de transposições adjacentes para a permutação σqP e suponha que esse caminho tenha L1 trans L posições adjacentes e, portanto, sig σqP = (−1) 1 . Suponha que um caminho de transposições adjacentes para a permutação σ̄rP tenha L2 transposições ad L jacentes e, portanto, sig σ̄rP = (−1) 2 . É evidente que, seguindo esses dois caminhos em sequência, reproduziremos a permutação composta da Eq. (52). O sinal dessa nova permutação, portanto, será dado por L +L (53) sig σ̄rP ◦ σqP = (−1) 1 2 = sig σ̄rP sig σqP . Multiplicando a Eq. (53) por sig σ̄rP , encontramos sig σqP = sig σ̄rP sig σ̄rP ◦ σqP . (54) Vamos, agora, substituir a Eq. (54) de volta na Eq. (51) para obter P! X sig σqP BσrP (1),σqP (1) . . . BσrP (P ),σqP (P ) q=1 = P! X sig σ̄rP sig σ̄rP ◦ σqP B1,(σ̄P ◦σP )(1) . . . BP,(σ̄P ◦σP )(P ) r q r q q=1 = sig σ̄rP P! X sig σ̄rP ◦ σqP B1,(σ̄P ◦σP )(1) . . . BP,(σ̄P ◦σP )(P ) , r q r q (55) q=1 já que a soma é sobre q e não sobre r. Veja agora que o número de permutações de P números é igual a P !. Como a composição de permutações da Eq. (52) é também uma permutação, conforme varrermos q sobre todas as permutações, a composição σ̄rP ◦ σqP também varrerá o conjunto de todas as P ! permutações possíveis. Para ver isso, faça a hipótese de que q1 6= q2 . Então, segue necessariamente, que σqP1 6= σqP2 . Isso nós sabemos ser verdade, como podemos verificar com exemplos e pela própria definição de permutação. Assim, vamos supor que, apesar disso, quando tomamos as composições de cada uma dessas duas permutações com σ̄rP , encontramos σ̄rP ◦ σqP1 = σ̄rP ◦ σqP2 . 11 (56) Então, aplicando cada um dos membros da Eq. (56) à sequência de números de 1 até P, devemos obter a mesma permutação desses números. Aplicando, portanto, a esse resultado, a inversa de σ̄rP , devemos obter uma única permutação. Esta única permutação, de acordo com a Eq. (56) deve ser igual à aplicação de σqP1 à sequência de 1 a P e também deve ser igual à aplicação de σqP2 à sequência de 1 a P. Mas este resultado implica que q1 deve ser igual a q2 , contradizendo a hipótese que sabemos ser verdade. Logo, a outra hipótese, isto é, a Eq. (56), deve ser falsa. Assim, varrendo a composição σ̄rP ◦ σqP sobre q, estamos varrendo todo o conjunto de permutações de 1 a P. Com esse resultado, podemos escrever a Eq. (55) assim: P! X sig σqP BσrP (1),σqP (1) . . . BσrP (P ),σqP (P ) = sig σ̄rP = σ̄rP P! X q=1 sig σuP B1,σuP (1) . . . BP,σuP (P ) u=1 sig det (B) , (55b) onde usamos a Eq. (28) para o determinante de uma matriz qualquer. Substituindo a Eq. (55b) na Eq. (50), obtemos det (AB) = P! X A1,σrP (1) . . . AP,σrP (P ) sig σ̄rP det (B) r=1 = det (B) P! X sig σ̄rP A1,σrP (1) . . . AP,σrP (P ) . (57) r=1 Depois de todas as demonstrações que fizemos acima, agora é fácil ver que o sinal de uma permutação é igual ao de sua inversa, pois ambas podem ser representadas pelo mesmo número de transposições adjacentes. Isso é claro porque, se escolhermos um caminho de L transposições adjacentes que dá σrP , devemos aplicar o mesmo número de transposições adjacentes ao resultado final para invertê-la, sendo cada uma dessas transposições a inversa de cada uma das que foram aplicadas à sequência de 1 a P para obtermos σrP . Com este resultado, a Eq. (57) fica, finalmente, det (AB) P! X sig σrP A1,σrP (1) . . . AP,σrP (P ) = det (B) = det (B) det (A) = det (A) det (B) , r=1 (58) onde, novamente, usamos a Eq. (28) para a definição do determinante de A. Logo após a Eq. (25), precisávamos saber qual a condição para que uma matriz não tenha inversa. Agora podemos responder isso de forma fácil. Considere a Eq. (11). Suponha que uma matriz N tenha determinante nulo, mas que sua inversa, N −1 , exista. Então, da Eq. (26), temos que det N −1 N = 1. (59) 12 Usando a Eq. (58) na Eq. (59), vemos que det N −1 det (N ) = 1, (60) que é impossível se det (N ) for nulo. Como, dada uma matriz, sempre podemos calcular seu determinante, a matriz N −1 não existe, pois, caso existisse, teríamos que ter a Eq. (60) válida para det (N ) = 0, o que é uma contradição, pois a Eq. (60) implicaria 0 = 1. Logo, a condição para uma matriz não ser inversível é que tenha determinante nulo. Vamos impor essa condição à matriz H − λI para encontrar seus autovalores e autovetores: det (H − λI) = 0. Substituindo a Eq. (9) na Eq. (61), vem −λ c det = c d−λ (61) 0, (62) isto é, −λ (d − λ) − c2 = 0, ou seja, λ2 − dλ − c2 = 0, (63) cuja solução é dada por λ± = d 1p 2 ± d + 4c2 . 2 2 (64) Para futura referência, note que d 1p 2 d 1p 2 λ+ λ− = + d + 4c2 − d + 4c2 2 2 2 2 2 1 2 d − d + 4c2 = −c2 . (65) = 4 4 Para achar os autovetores correspondentes aos autovalores da Eq. (64), utilizamos as Eqs. (9), (22) e (24): −λ± c α± = 0, (66) c d − λ± β± isto é, λ± α± = cβ± (67) e cα± = − (d − λ± ) β± . 13 (68) Com as soluções da Eq. (64), podemos mostrar que a Eq. (68) é equivalente à Eq. (67) e, portanto, não fornece informação diferente daquela fornecida pela Eq. (67). Para vermos isso, basta substituir a Eq. (64) na Eq. (68): d 1p 2 cα± = − d − ∓ d + 4c2 β± , (69) 2 2 isto é, cα± = − d 1p 2 2 ∓ d + 4c β± , 2 2 ou seja, cλ± α± = = d 1p 2 d + 4c2 β± ∓ −λ± 2 2 d 1p 2 d 1p 2 − ± d + 4c2 ∓ d + 4c2 β± , 2 2 2 2 ou ainda, d2 1 2 − d + 4c2 β± . 4 4 cλ± α± = − Portanto, cλ± α± c2 β± , = que dá λ± α± = cβ± . (70) Como a Eq. (70) é idêntica à Eq. (67), vemos que a Eq. (68) é linearmente dependente da Eq. (67) e, portanto, não fornece nova informação. A Eq. (67) é indeterminada, pois dá apenas uma relação entre α± e β± . É uma convenção normalizar os autovetores e, assim, devemos ter 2 2 α± + β± = 1. (71) λ± α± . c (72) Da Eq. (67), temos que β± = Substituindo a Eq. (72) na Eq. (71) dá λ2± 2 1 + 2 α± c 14 = 1, isto é, 2 α± = c2 . c2 + λ2± (73) Então, extraindo a raiz quadrada da Eq. (73), escolhemos, como solução, c α± = q (74) 2 c + λ2± (pois poderíamos, ao invés, escolher a solução com sinal negativo). Substituindo a Eq. (74) na Eq. (72), obtemos β± λ± = q . (75) c2 + λ2± Então, temos os dois autovetores: 1 α+ c U+ = =q β+ λ+ c2 + λ2+ (76) e U− = α− β− 1 =q c2 + λ2− c λ− , (77) correspondentes aos autovalores λ+ e λ− da Eq. (64), respectivamente, obtidos usando as Eqs. (74) e (75) na Eq. (22). Note agora que, como λ+ não é nulo, nem negativo, pois, por hipótese, c > 0 e, portanto, c 6= 0 (cf. Eq. (64)), podemos escrever c q c2 = + λ2− cλ cλ+ q + =q . 2 2 2 2 2 λ+ c + λ− c λ+ + (λ+ λ− ) (78) Substituindo a Eq. (65) na Eq. (78), obtemos c q cλ+ cλ+ q = q , 2 c λ2+ + c2 c2 λ2+ + (−c2 ) = c2 + λ2− ou seja, c q c2 + λ2− = λ+ q . (79) c2 + λ2+ Observe também que λ q − c2 + λ2− = λ λ c2 q− + = −q 2 λ+ c2 + λ2− c2 λ2+ + (λ+ λ− ) = −q c2 c2 λ2+ + 15 2 (−c2 ) = −q c λ2+ + c2 , isto é, λ− q c2 + λ2− = −q c . (80) c2 + λ2+ Podemos agora substituir as Eqs. (79) e (80) na Eq. (77) para obter 1 α− λ+ U− = =q . (81) β− −c c2 + λ2+ Logo, comparando as Eqs. (76) e (81), vemos que α+ = −β− (82) β+ = (83) e α− . Além disso, vemos claramente que os autovetores das Eqs. (76) e (81) são ortonormais, pois, além de normalizados à unidade, satisfazem: t U+ U− = t U− U+ = 0. (84) Como os autovetores U± são ortonormais, a matriz N, que diagonaliza tanto H, como M, é ortogonal, isto é, sua inversa é sua transposta. De acordo com as prescrições das Eqs. (19) e (20), bem como a discussão que segue essas equações, as colunas da matriz N são dadas pelos autovetores das Eqs. (76) e (81): 1 c λ+ N = q . (85) λ+ −c c2 + λ2+ Transpondo a Eq. (85), obtemos a matriz N −1 : 1 c λ+ N −1 = q = N, λ+ −c c2 + λ2+ (86) que, neste caso, é igual a si própria e, portanto, simétrica. Você pode verificar, instantaneamente, que a Eq. (11) está satisfeita pelas matrizes das Eqs. (85) e (86). Para ver que essas matrizes diagonalizam a matriz M, façamos: 1 a c c λ+ q MN = λ+ −c c b c2 + λ2+ 1 ac + cλ+ aλ+ − c2 = q , (87) c2 + bλ+ cλ+ − bc c2 + λ2+ 16 onde usamos as Eqs. (1) e (85). Multiplicando a Eq. (87) pela Eq. (86), pela esquerda, dá 1 c λ+ ac + cλ+ aλ+ − c2 N −1 M N = c2 + bλ+ cλ+ − bc c2 + λ2+ λ+ −c ac2 +2c2 λ +bλ2 caλ −c3 +cλ2 −λ bc + = + c2 +λ2+ λ+ ac+cλ2+ −c3 −cbλ+ c2 +λ2+ + + + c2 +λ2+ aλ2+ −2λ+ c2 +bc2 c2 +λ2+ . (88) Considere agora os numeradores dos elementos da matriz da Eq. (88). Temos, para o primeiro elemento da diagonal principal, o numerador: ac2 + 2c2 λ+ + bλ2+ = ac2 + 2c2 λ+ + (d + a) λ2+ = a c2 + λ2+ + 2c2 + dλ+ λ+ , (89) onde usamos a Eq. (6). Então, a Eq. (89) fica ac2 + 2c2 λ+ + bλ2+ = a c2 + λ2+ + 2c2 + λ2+ − c2 λ+ = (a + λ+ ) c2 + λ2+ , (90) utilizando a Eq. (63) com λ = λ+ . Também temos, para os numeradores dos elementos fora da diagonal principal, caλ+ − c3 + cλ2+ − λ+ bc = caλ+ − c3 + cλ2+ − λ+ (d + a) c = −c3 + cλ2+ − λ+ dc, (91) usando a Eq. (6). Fazendo λ = λ+ na Eq. (63), isolando dλ+ e substituindo na Eq. (91), encontramos caλ+ − c3 + cλ2+ − λ+ bc = −c3 + cλ2+ − λ2+ − c2 c = 0. (91) Finalmente, o segundo elemento da diagonal principal tem o numerador dado por aλ2+ − λ+ c2 − c2 λ+ + bc2 = aλ2+ − λ+ c2 − c2 λ+ + (d + a) c2 = a λ2+ + c2 + (d − 2λ+ ) c2 , (92) usando a Eq. (6). Substituindo a Eq. (65) na Eq. (92), obtemos aλ2+ − λ+ c2 − c2 λ+ + bc2 = a λ2+ + c2 − (d − 2λ+ ) λ+ λ− = a λ2+ + c2 − dλ+ − 2λ2+ λ− . (93) Tomando λ = λ+ na Eq. (63) e usando o resultado na Eq. (93), ficamos com aλ2+ − λ+ c2 − c2 λ+ + bc2 = a λ2+ + c2 − λ2+ − c2 − 2λ2+ λ− = (a + λ− ) λ2+ + c2 . (94) 17 Substituindo, finalmente, as Eqs. (90), (91) e (94) de volta na Eq. (88), obtemos λ+ + a 0 N −1 M N = , (95) 0 λ− + a mostrando que a mesma matriz N que diagonaliza a matriz H, da Eq. (9), também diagonaliza a matriz M, da Eq. (1), só que com autovalores dados por λ1 = λ+ + a (96) λ2 = λ− + a, (97) e como previmos na Eq. (7) e explicitamos logo abaixo da Eq. (9). Agora podemos sumarizar a resposta para o problema de diagonalizar a matriz M da Eq. (1). Os autovetores são dados pelas Eqs. (76) e (81) que, com as Eqs. (6), (96) e (97), podem ser escritos em termos dos elementos da matriz M: 1 c (98) U1 = q λ1 − a 2 c2 + (λ1 − a) e U2 = 1 q 2 c2 + (λ1 − a) λ1 − a −c , (99) onde os respectivos autovalores, λ1 e λ2 , são dados pelas Eqs. (6), (64), (96) e (97): q a+b 1 2 + λ1 = (b − a) + 4c2 (100) 2 2 e λ2 = a+b 1 − 2 2 q 2 (b − a) + 4c2 . 18 (101)

Download