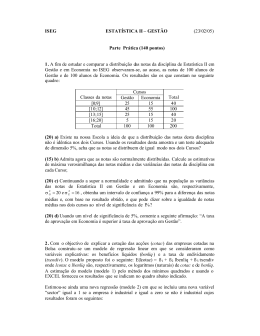

TESTE PARA VERIFICAR A IGUALDADE DE PARÂMETROS E A IDENTIDADE DE MODELOS DE REGRESSÃO NÃO-LINEAR. I. DADOS NO DELINEAMENTO INTEIRAMENTE CASUALIZADO Adair José REGAZZI1 Carlos Henrique Osório SILVA1 RESUMO: Considerou-se o ajustamento de g equações de regressão não-linear e o teste da razão de verossimilhança, com aproximação dada pela estatística qui-quadrado, para se testar a identidade dos modelos e comparar, por meio de simulação de dados, as aproximações dadas pelas estatísticas χ2 e F. Para um número total de observações suficientemente grande (N ≥ 120) as duas aproximações são praticamente equivalentes. Para amostras menores, a aproximação dada pela estatística F deve ser a preferida, uma vez que a taxa de erro tipo I foi sempre menor, independentemente do valor de N. PALAVRAS-CHAVE: Curvas de crescimento; verossimilhança; teste de hipótese. 1 Introdução Em análise de regressão, com muita freqüência deseja-se saber se um conjunto de g equações ajustadas são idênticas, ou seja, se o fenômeno em estudo pode ser representado por uma única equação. Vários autores apresentaram métodos para testar hipóteses relativas à identidade de modelos lineares, como por exemplo, Graybill (1976), Steel e Torrie (1980), Neter et al. (1996), Regazzi (1993, 1999), entre outros. Modelos de regressão linear têm aplicações nas mais diversas áreas do conhecimento. Muitas vezes, um modelo linear é utilizado apenas pela facilidade em descrever o relacionamento aproximado. Entretanto, o verdadeiro relacionamento entre uma variável dependente e uma ou mais variáveis independentes pode ser descrito por um modelo não-linear, determinado com base em conhecimentos teóricos do problema tratado. Portanto, existem muitas situações em que modelos lineares podem não ser apropriados. Um exemplo típico na área de Ciências Biológicas é a modelagem de crescimento, em que pode ser necessário ajustar funções não-lineares para melhor explicar o processo de crescimento. Nesse caso, são referências úteis: Draper e Smith (1981), Ratkowsky (1983), Gallant (1987), Bates e Watts (1988), Cordeiro e Paula (1989), Myers (1990), Souza (1998), Khattree e Naik (1999), dentre outros. Bates e Watts (1988), para comparar modelos de regressão não-linear, apresentaram um teste assintótico baseado na razão de verossimilhança como no caso de modelos 1 Departamento de Informática, Universidade Federal de Viçosa - UFV, CEP 36570-000, Viçosa, MG, Brasil. E-mail: adairreg@ ufv.br / [email protected]. Rev. Mat. Estat., São Paulo, v.22, n.3, p.33-45, 2004 33 lineares, com aproximação dada pela estatística F, conforme sumarizado na Tabela 1. A estatística do teste é então: ( S p − S f ) / ve F0 = ~ F ( v e ; v f ). Sf / vf Cabe ressaltar que para modelos de regressão não-linear esta análise é apenas aproximada, porque a razão entre os quadrados médios não tem uma distribuição F exata (Souza, 1998). O teste a um nível de significância α, da hipótese H0 de que o modelo reduzido é adequado, consiste em rejeitar H0 se F0 ≥ Fα ( v e ; v f ). Tabela 1 - Esquema da análise para execução do teste proposto por Bates e Watts (1988) sobre a igualdade de parâmetros em modelos de regressão não-linear1 Causas de variação GL SQ QM 2 Parâmetros extras ve = Pf – Pp Se = Sp – Sf se =Se /ve Modelo completo vf = N – Pf Sf sf2=Sf /vf Modelo reduzido vp = N – Pp Sp F0 2 se / sf2 1 S= Soma de quadrados residuais, v = Número de graus de liberdade, P= Número de parâmetros e N = Número total de observações. Subscritos: f = modelo completo, p = modelo reduzido, e = extra. Regazzi (2003), utilizando o teste da razão de verossimilhança conforme Rao (1973), apresentou em detalhes a aplicação desse teste em modelos de regressão nãolinear, com aproximação dada pela estatística qui-quadrado (χ2). Cabe ressaltar que Regazzi (2003) admitiu apenas um valor observado de Y para cada um de X. Considerando agora o caso de dados com repetições, o objetivo do presente trabalho é apresentar o teste da razão de verossimilhança para testar a identidade de modelos de regressão não-linear, com aproximação dada pela estatística χ2 e comparar as estatísticas F (Bates e Watts, 1988) e χ2 (Rao, 1973) por simulação de dados. 2 Metodologia e resultados 2.1 Dados provenientes de um delineamento inteiramente casualizado 2.1.1 Preliminares Considere inicialmente um experimento com I tratamentos, sendo I níveis de um fator quantitativo, cada um com ri (i=1, ... , I) repetições, no delineamento com um fator inteiramente casualizado. Do ponto de vista da estatística experimental, e considerando-se um modelo de regressão não-linear com p parâmetros, o esquema da análise da variância para testar a falta de ajustamento do modelo é como apresentado na Tabela 2. 34 Rev. Mat. Estat., São Paulo, v.22, n.3, p.33-45, 2004 Tabela 2 - Esquema da análise da variância GL1 Causas de variação Parâmetros da regressão p Falta de ajustamento I-p Parâmetros do delineamento (I) Resíduo (Erro puro) n-I Total não corrigido n 1 n= n i =1 QM QMFA QMR ri É fato que, no delineamento com um fator inteiramente casualizado, SQParâmetros da regressão + SQFalta de ajustamento = SQParâmetros do delineamento. Se a matriz do modelo linear aproximante (via matriz Jacobiana) tiver uma coluna de “uns”, então, SQRegressão = SQParâmetros da regressão – C, onde C= ( n i =1 yi ) 2 n . Neste caso, SQRegressão + SQFalta de ajustamento = SQTratamentos, pois SQtratamentos = SQParâmetros do delineamento – C. Assim teríamos, p-1, I-p e I-1 graus de liberdade associados às causas de variação devido à regressão, falta de ajustamento e tratamentos, respectivamente. No esquema da Tabela 2, o resíduo da regressão que tem n-p graus de liberdade foi decomposto em falta de ajustamento mais o erro puro. O teste F aproximado (assintótico) para a falta de ajustamento do modelo é dado por: QMFA F= ~ F ( I − p; n − I ). QMR É sempre desejável que o teste para falta de ajustamento do modelo dê um resultado não-significativo. Nos casos em que a falta de ajustamento é significativa, pode-se concluir que o modelo utilizado não é apropriado. Assim, deve-se modificar a função esperança a fim de obter-se uma função mais apropriada. Considerando-se a análise de variância com um enfoque em Estatística Experimental, em modelos de regressão linear, o teste F para falta de ajustamento e para regressão, tem como denominador o quadrado médio do resíduo ou erro puro (QMR, Tabela 2). Quando a falta de ajustamento é não-significativa, pode-se optar em combinar a falta de ajustamento e o erro puro, obtendo-se o quadrado médio do resíduo da regressão (QMRR) a ser utilizado como denominador no teste F para regressão. Para modelos lineares, os testes de Wald e da razão de verossimilhança são equivalentes teórica e numericamente. Para modelos de regressão não-linear, teoricamente os testes de Wald e da razão de verossimilhança são assintoticamente equivalentes, desde que certas condições, comumente denominadas “de regularidade”, sejam atendidas. Mas em pequenas amostras, os resultados assintóticos aproximam de modo distinto cada procedimento (Souza, 1998). Rev. Mat. Estat., São Paulo, v.22, n.3, p.33-45, 2004 35 2.1.2 Modelo estatístico Considerou-se, inicialmente o ajustamento dos dados de observação relativos a g grupos (g diferentes condições experimentais ou g variedades etc.). Para cada um deles, foi ajustado o modelo Michaelis-Menten com erro aditivo dado por: a i xij + ε ij , com j=1, ... , ni , i=1, ... , g (1) yij = bi + xij em que • yij é o valor observado na j-ésima unidade experimental do i-ésimo grupo; • xij é o valor da variável independente associado a yij • εij é o erro aleatório não observável do modelo. O parâmetro ai para cada grupo i, é o valor máximo esperado para a resposta (assíntota), ou seja, ai é o limite da esperança de yij quando xij tende a infinito; bi é o parâmetro para o i-ésimo grupo, tal que, quando xij = bi, yij é a metade do valor máximo esperado. A metodologia que será apresentada pressupõe que ε ij ~ NID (0, σ 2 ) . Temos ainda que g i =1 ni = N é o número total de observações. Como foram admitidos g grupos e se pressupõe homocedasticidade, sua verificação poderá ser feita mediante um teste de homogeneidade de variâncias apropriado, como por exemplo, o teste de Bartlett, citado por Li (1964). Essa homogeneidade de variâncias é sobre os resíduos da regressão para os g grupos. Conforme se verifica em PimentelGomes (1990), quando se tem uma relação de variâncias (max. QMRR / min. QMRR) menor que sete, é quase sempre possível combinar as variâncias residuais, obtendo-se uma estimativa comum. Quando esse quociente for além de sete, convirá considerar separadamente subgrupos de modelos, em que se tenha, dentro de cada subgrupo, uma razoável homogeneidade de variâncias. As hipóteses que serão consideradas são as seguintes: • H o(1) : b1 = ... = bg (= b) vs. H a(1) : nem todos bi são iguais. • H o( 2) : a1 = ... = a g (= a) vs. H a( 2 ) : nem todos ai são iguais. • H o(3) :b1 = ... = bg (= b) e a1 = ... = a g ( = a) vs. H a( 3) : pelo menos uma igualdade é uma desigualdade. Para i = 1, ... , g, sejam as variáveis “dummy” Di tais que: Di = 36 1 se a observação y ij pertence ao grupo i , 0 em caso contrário . Rev. Mat. Estat., São Paulo, v.22, n.3, p.33-45, 2004 Então, o modelo da equação (1) pode ser escrito como: yij = g Du u =1 a u xij bu + xij + ε ij , j = 1, ... , ni , i = 1, ... , g O problema é comparar as equações ajustadas para os vários grupos. Para testar as hipóteses formuladas, a metodologia apresentada se baseia no teste da razão de verossimilhança, com aproximação dada pela estatística χ 2 . No presente trabalho as estimativas de máxima verossimilhança dos parâmetros foram obtidas utilizando-se o procedimento PROC NLIN do SAS∗ (1990). Maiores detalhes podem ser vistos em Regazzi (2003). Considere o problema geral de testar a hipótese de nulidade: H o : θ ∈ ω versus H a : θ ∈ ω c , onde ω é um subconjunto do espaço paramétrico Ω e ω c é o complemento de ω , com Ω = ω ∪ ω c . A estatística do teste da razão de verossimilhança para este problema é L= sendo σˆ Ω2 2 σˆ Ω N 2 σˆ ω2 , a estimativa de máxima verossimilhança de σ2 com nenhuma restrição no espaço paramétrico e σˆ ω a estimativa de máxima verossimilhança de σ2 com as restrições lineares colocadas em H0. Para grandes amostras de tamanho N, conforme Rao (1973), tem-se que d σˆ Ω2 2 − 2 ln L = − N ln → χv . 2 N →∞ σˆ ω 2 Designaremos de completo o modelo ajustado sob nenhuma restrição em Ω e de reduzido o modelo ajustado sob as restrições definidas em H0. Para o teste de H0 a estatística do teste da razão de verossimilhança é: ( 2 χ Calculado = − N ln σˆ Ω2 σˆ ω2 ) = − N ln A regra de decisão consiste em rejeitar H 0 χ 2 Calculado SQRRΩ SQRRω . a um nível de significância α se ≥ χ α (v) , em que v = pΩ − pω é o número de graus de liberdade, sendo 2 pΩ e pω o número de parâmetros estimados nos modelos completo e reduzido, respectivamente, e SQRR é a soma de quadrados do resíduo da regressão. Investigamos o ∗ SAS versão 8.2 licenciado para a UFV, 2003. Rev. Mat. Estat., São Paulo, v.22, n.3, p.33-45, 2004 37 ajuste de modelos para dados com repetições, portanto a SQRR envolve o erro puro mais a falta de ajustamento. (1) ( 2) (3) Para o teste de H 0 , H 0 e H 0 as estatísticas do teste da razão de verossimilhança são: ( ) − N ln σˆ Ω2 σˆ ω2i = − N ln SQRRΩ / N SQRRΩ = − N ln SQRRωi / N SQRRω i com, respectivamente, ( g − 1), ( g − 1) e 2( g − 1) graus de liberdade para i = 1, 2, 3. A seguir ilustraremos a metodologia com o auxílio do procedimento PROC NLIN do pacote estatístico SAS. Dadas as estimativas iniciais θ0 e a forma da função µ (θ , x) , o PROC NLIN ajusta o modelo y = µ (θ , x) + ε para os dados ( y i , xi ), i = 1, ... , N e fornece as estimativas de mínimos quadrados de θ, por métodos iterativos, tais como NewtonRaphson, Gauss-Newton, Steepest Descent etc. Uma introdução aos métodos iterativos aplicada a mínimos quadrados em modelos não-lineares é apresentada em Johnson e Frasier (1985). 2.2 Ilustração do método Para ilustrar a metodologia apresentada neste estudo, utilizaram-se os dados da Tabela 3, em que g = 2. Inicialmente, aplicou-se um teste de homogeneidade de variâncias (Tabela 4) e resultou que a hipótese de homogeneidade não foi rejeitada (P > 0,05). Com base na Tabela 2, aplicou-se o teste para falta de ajustamento do modelo para cada grupo obtendo-se os seguintes resultados: Grupo 1: F= QMFA 124,4750 = = 1,07 , com 4 e 6 graus de liberdade (P=0,4472). QMR 116,2500 Grupo 2: QMFA 115,65 = = 1,46 , com 4 e 5 graus de liberdade (P=0,3391). QMR 79,40 Em ambos os grupos considerou-se o resultado não-significativo (P>0,05) indicando que o modelo não-linear adotado pode ser considerado adequado e obteve-se o resíduo da regressão conforme a Tabela 4. Dado que g = 2, introduziram-se mais duas variáveis independentes D1 e D2, para identificar os grupos 1 e 2, respectivamente. O modelo completo adotado para analisar estes dados foi F= yij = D1 a1 xij b1 + xij + D2 a 2 xij b2 + xij + ε ij em que i = 1, 2; j = 1, ... , ni com n1 = 12 e n2 = 11, portanto N = 23. 38 Rev. Mat. Estat., São Paulo, v.22, n.3, p.33-45, 2004 Tabela 3 - Velocidade da reação versus concentração de substrato de um experimento com Puromycin1 Velocidade (contagem/min2) Grupo 1 Grupo 2 76 67 47 51 97 84 107 86 123 98 139 115 159 131 152 124 191 144 201 158 207 160 200 - Concentração de substrato (ppm) 0,02 0,06 0,11 0,22 0,56 1,10 1 Fonte: Bates e Watts (1988). Grupo1: Enzima tratada com Puromycin; Grupo 2: Enzima não tratada. Tabela 4 - Resumo da análise da variância da regressão e do teste de homogeneidade de variâncias Causas de Variação Parâmetros da regr. Resíduo da regressão H 0 : σ 12 = σ 22 Grupo 1 GL 2 10 SQ 270213,6 1195,4 Grupo 2 GL 2 9 SQ 147348,4 859,6 2 2 χ Obs . = 0,113 n.s . χ Tab . ( 5%;1 ) = 3,841 n.s. Não-significativo (P>0,05), pelo teste de Bartlett O objetivo deste exemplo é ajustar o modelo Michaelis-Menten e determinar se uma única equação para os dois grupos pode ser considerada adequada e, caso contrário, se certos valores dos parâmetros no modelo podem ser considerados como iguais nos dois grupos. Adiante no texto, fornecemos uma alternativa simples de codificação em SAS para calcular as estimativas de máxima verossimilhança dos parâmetros sob Ω (nenhuma restrição no espaço paramétrico), ω1 (espaço paramétrico restrito por: b1 = b2 = b ), ω 2 (espaço paramétrico restrito por: a1 = a 2 = a ) e ω 3 (espaço paramétrico restrito por b1 = b2 = b e a1 = a 2 = a ). Em cada caso, o PROC NLIN requer os valores iniciais das estimativas dos parâmetros com a opção PARMS. Executando-se o procedimento NLIN com nenhuma restrição e com várias restrições especificadas por ω 1 , ω 2 e ω 3 , obtém-se as estimativas σˆ Ω2 , σˆ ω21 , σˆ ω2 2 e σˆ ω23 necessárias para se executar o teste estatístico das várias hipóteses descritas anteriormente. Rev. Mat. Estat., São Paulo, v.22, n.3, p.33-45, 2004 39 2.3 Programa SAS title ' Função Michaelis-Menten y = ax/(b+x) '; data batesex1; input grupo trat rep x y d1 d2; cards; 1 1 1 0.02 76 1 0 1 1 2 0.02 47 1 0 1 2 1 0.06 97 1 0 1 2 2 0.06 107 1 0 1 3 1 0.11 123 1 0 1 3 2 0.11 139 1 0 1 4 1 0.22 159 1 0 1 4 2 0.22 152 1 0 1 5 1 0.56 191 1 0 1 5 2 0.56 201 1 0 1 6 1 1.10 207 1 0 1 6 2 1.10 200 1 0 2 1 1 0.02 67 0 1 2 1 2 0.02 51 0 1 2 2 1 0.06 84 0 1 2 2 2 0.06 86 0 1 2 3 1 0.11 98 0 1 2 3 2 0.11 115 0 1 2 4 1 0.22 131 0 1 2 4 2 0.22 124 0 1 2 5 1 0.56 144 0 1 2 5 2 0.56 158 0 1 2 6 1 1.10 160 0 1 ; /* programa para o modelo completo omega (Ω) */ /* Estimativas iniciais foram tomadas para cada grupo separadamente */ proc nlin data=batesex1 maxiter=100; parms a1=205 b1=0.08 a2=165 b2=0.06; model y=d1*((a1*x)/(b1+x)) + d2*((a2*x)/(b2+x)) ; run; /* programa para o modelo com restrição ω1:b1=b2=b */ /* Estimativa inicial de b foi tomada como a média de b1 e b2 */ proc nlin data=batesex1 maxiter=100; parms a1=205 b=0.07 a2=165; model y=d1*((a1*x)/(b+x)) + d2*((a2*x)/(b+x)) ; run; /* programa para o modelo com restrição ω2:a1=a2=a */ /* Estimativa inicial de a foi tomada como a média de a1 e a2 */ proc nlin data=batesex1 maxiter=100; 40 Rev. Mat. Estat., São Paulo, v.22, n.3, p.33-45, 2004 parms a=185 b1=0.08 b2=0.06; model y=d1*((a*x)/(b1+x)) + d2*((a*x)/(b2+x)) ; run; /* programa para o modelo com restrição ω3:a1=a2=a e b1=b2=b */ /* Estimativa inicial de a e b foi tomada como médias de ai e bi, respectivamente */ proc nlin data=batesex1 maxiter=100; parms a=185 b=0.07; model y=d1*((a*x)/(b+x)) + d2*((a*x)/(b+x)) ; run; quit; Na Tabela 5 estão apresentadas as estimativas dos parâmetros do modelo com nenhuma restrição no espaço paramétrico (Ω) e com as restrições especificadas por ω1 , ω 2 e ω 3 . Tabela 5 - Estimativas dos parâmetros do modelo completo (Ω) e modelos reduzidos ( ω1 , ω 2 e ω 3 ) e respectivas somas de quadrados do resíduo da regressão (SQRR) e número de graus de liberdade do resíduo da regressão(GLRR) Parâmetros a1 b1 a2 b2 a b SQRR GLRR Estimativas dos parâmetros dos modelos Ω ω1 ω2 ω3 212,7 0,0641 160,3 0,0477 2055,1 19 208,6 166,6 0,0580 2240,9 20 0,0480 0,0887 194,1 4815,4 20 190,8 0,0604 7276,5 21 Na Tabela 6 estão apresentados os resultados do teste para as três hipóteses formuladas. Como o teste de H 0( 3) foi significativo, pode-se concluir que as duas equações diferem, estatisticamente. Assim, a equação comum, cujas estimativas estão apresentadas na Tabela 5 (modelo ω 3 ), não pode ser usada para os dois grupos. Entretanto, a hipótese de que o valor do parâmetro b é igual no modelo dos dois grupos não foi rejeitada (P > 0,05). Assim, o modelo escolhido é aquele com três parâmetros (a1, a2 e b). Um teste para falta de ajustamento para o modelo escolhido está apresentado na Tabela 7. Note que, SQFalta de ajustamento = SQResíduo da regressão – SQErro puro. Uma vez que o teste para falta de ajustamento foi não-significativo(P>0,05), pode-se concluir que o modelo é adequado para descrever os dados. As equações ajustadas são: Rev. Mat. Estat., São Paulo, v.22, n.3, p.33-45, 2004 41 yˆ = d1 208,6 x 166,6 x + d2 0,0580 + x 0,0580 + x Tabela 6 - Hipóteses avaliadas, valores da estatística do teste qui- quadrado, número de graus de liberdade e nível descritivo do teste (Valor-P) H 0( 1 ) : b1 = b2 = b H (2) 0 Graus de liberdade (v) 2 P( χ v2 > χ Calc .) 1,991 1 0,1582 19,584 1 9,6272x10-6 29,079 2 4,8481x10-7 2 χ Calc . Hipóteses : a1 = a 2 = a H 0( 3 ) : a1 = a 2 = a e b1 = b2 = b Tabela 7 - Análise com o teste para falta de ajustamento para o modelo escolhido Causas de Variação Falta de ajustamento Resíduo (Erro puro) Resíduo da regressão G.L. 9 11 20 SQ 1146,40 1094,50 2240,90 QM 127,38 99,50 Grupo 1 (d1=1 e d2=0) ŷ = 208,6 x 0 ,0580 + x Grupo 2 (d1=0 e d2=1) ŷ = 166,6 x 0 ,0580 + x F 1,28 Valor-P 0,3441 O resultado do teste da razão de verossimilhança, com aproximação dada pela estatística F (Bates e Watts, 1988), para as três hipóteses sobre igualdade de parâmetros foram: F ( H 0(1) ) = 1,72 com 1 e 19 graus de liberdade (P = 0,2053), F ( H 0( 2 ) ) = 25,52 com 1 e 19 graus de liberdade (P = 70,8x10-6) e F ( H 0( 3) ) = 24,14 com 2 e 19 graus de liberdade (P = 60,708x10-7). Assim, comparando-se os resultados obtidos com base na estatística χ2 apresentada neste trabalho e a estatística F apresentada por Bates e Watts (1988), com base nos valores-P (Tabela 8), as conclusões são as mesmas. Entretanto, os níveis descritivos dos testes com base na estatística F foram sempre superiores aos obtidos com a estatística χ2. Tabela 8 - Níveis descritivos para os testes do exemplo Hipóteses 2 P( χ v2 > χ Calculado ) H 0( 1 ) H 0( 2 ) 9,6272x10 H 0( 3 ) 4,8481x10-7 a 42 0,1582 P( F > FCalculado ) a 0,2053 -6 70,8x10-6 60,708x10-7 Bates e Watts (1988) Rev. Mat. Estat., São Paulo, v.22, n.3, p.33-45, 2004 3 Simulações Com o objetivo de comparar as duas aproximações, isto é, as estatísticas F e χ2 por simulação de dados, estabeleceu-se trabalhar com a seguinte hipótese de identidade de modelos: H 0 :b1 = b2 (= b) e a1 = a 2 (= a ) vs. H a : pelo menos uma igualdade é uma desigualdade. M conjuntos de dados foram simulados sob H0 para o modelo a xi yi = +εi . b + xi Os valores y i foram simulados adotando-se como parâmetros do modelo os valores a = 185 e b = 0,07 . Os seguintes valores e critérios foram estabelecidos: M = 1.000 conjunto de dados para cada valor r ; g = 2 (somente dois grupos) ; r = 2, 5, 10 e 50 (4 simulações com dados balanceados) e os seis valores x conforme especificados no exemplo descrito na Tabela 3. Para ε i , o erro aleatório com as pressuposições ε i ~ NID (0, σ 2 ) adotou-se σ 2 = 152 = 225. Portanto obteve-se N igual a 24, 60, 120 e 600 respectivamente, para r = 2, 5, 10 e 50. O valor M =1.000 foi estabelecido por tentativas. Testou-se inicialmente M = 100, 200 e 500 e verificou-se uma estabilização razoável dos resultados para M = 1.000 ou superior. Obteve-se, para cada cenário de simulação e para cada uma das estatísticas, a porcentagem de decisão incorreta (erro tipo I) α = c / M , em que c é o número de vezes que a estatística (F ou χ2) levou à rejeição da hipótese de identidade dos modelos, ao nível de significância nominal de 5%. Ajustou-se o modelo (1), completo e reduzido, para cada conjunto de dados simulados, interativamente com o procedimento PROC NLIN do SAS (1990). Um resumo dos resultados do estudo por simulação de dados estão apresentados na Tabela 9. Tabela 9 - Valores da porcentagem de decisão incorreta (erro tipo I), ao nível de significância nominal de 5%, para os M=1.000 conjuntos de dados simulados, em cada uma das quatro simulações Estatísticas Simulações* F r = 2 n = 12 N = 24 6,1 r = 5 n = 30 N = 60 5,6 r = 10 n = 60 N = 120 5,2 r = 50 n = 300 N = 600 5,2 χ2 10,0 6,7 5,9 5,5 * r é o número de repetições para cada um dos seis valores de x em cada um dos dois grupos, n é o número de observações de cada grupo e N é o número total de observações. Em todos os casos avaliados, a aproximação χ2 foi a que proporcionou maiores porcentagens de erros tipo I. Para N=24 a taxa de erro tipo I com a aproximação χ2 foi exatamente duas vezes o nível de significância nominal, enquanto na aproximação F essa taxa foi de apenas 1,1% superior ao nível nominal 5%. De acordo com os resultados Rev. Mat. Estat., São Paulo, v.22, n.3, p.33-45, 2004 43 apresentados, pode-se concluir que para um número total de observações suficientemente grande (N ≥ 120) as duas aproximações são praticamente equivalentes. Para amostras menores, a aproximação dada pela estatística F deve ser a preferida, uma vez que a taxa de erro tipo I foi sempre menor, independentemente do valor de N. Conclusões (i) A hipótese de identidade de modelos de regressão não-linear pode ser testada pelo teste da razão de verossimilhança utilizando-se as aproximações F ou qui-quadrado; (ii) Para um número total de observações suficientemente grande, as duas aproximações são praticamente equivalentes; (iii) Para amostras menores, a aproximação dada pela estatística F deve ser a preferida, uma vez que a taxa de erro tipo I é sempre menor, independentemente do número total de observações N. Agradecimentos Os autores são gratos à Joy Smith – SAS consultant, Department of Statistics, North Carolina State University, pela valiosa colaboração com os programas utilizados nas simulações. REGAZZI, A. J.; SILVA, C. H. O. Test for parameters equality in nonlinear regression models. I. Data in the randomized complete design. Rev. Mat. Est., São Paulo, v.22, n.3, p.33-45, 2004. ABSTRACT: We considerer the adjustment of g nonlinear regression equations and the likelihood ratio test with χ2 approximation in order to test model identity, and we also compare the approximations given by F and χ2 test statistics in a simulation study. For sufficiently large data sets (N ≥ 120) we found the two approximations to perform roughly the same. For smaller sample sizes the F statistic approximation should be preferred since it yielded smaller type I error rates for N values investigated. KEYWORDS: Growth curve; likelihood; hypothesis test. Referências BATES, D. M.; WATTS, D. G. Nonlinear regression analysis and its applications. New York: John Wiley, 1988. 365p. CORDEIRO, G. M.; PAULA, G. A. Modelos de regressão para análise de dados univariados. Rio de Janeiro: Instituto de Matemática Pura e Aplicada do CNPq, 1989. 353p. DRAPER, N. R.; SMITH, H. Applied regression analysis. 2nd. ed. New York: John Wiley, 1981. 709p. GALLANT, A. R. Nonlinear statistical models. New York: John Wiley, 1987. 611p. GRAYBILL, F.A. Theory and application of the linear model. Belmont: Duxbury Press, 1976. 704p. JOHNSON, M. L.; FRASIER, S. G. Nonlinear least-square analysis. Methods Enzymol., San Diego, v.117, p.301-342, 1985. 44 Rev. Mat. Estat., São Paulo, v.22, n.3, p.33-45, 2004 KHATTREE, R.; NAIK, D. N. Applied multivariate statistical with SAS software. 2nd. ed. Cary: SAS Institute, 1999. 338p. LI, J. C. R. Statistical inference. Ann Arbor: Edwards Brothers, 1964. v.1, 658p. MYERS, R. H. Classical and modern regression with applications. 2nd. ed. Boston: PWSKent, 1990. 488p. NETER, J. et al. Applied linear statistical models. 4th. ed. Chicago: Richard D. Irwin, 1996. 1408 p. PIMENTEL GOMES, F. Curso de estatística experimental. 13. ed. Piracicaba: Nobel, 1990. 468p. RAO, C. R. Linear statistical inference and its applications. New York: John Wiley, 1973. 522p. RATKOWSKY, D. A. Nonlinear regression modeling: a unified practical approach. New York : Marcel Dekker, 1983. 276p. REGAZZI, A. J. Teste para verificar a identidade de modelos de regressão e a igualdade de alguns parâmetros num modelo polinomial ortogonal. Rev. Ceres, Viçosa, v.40, n.228, p.176-195, 1993. REGAZZI, A. J. Teste para verificar a identidade de modelos de regressão e a igualdade de parâmetros no caso de dados de delineamentos experimentais. Rev. Ceres, Viçosa, v.46, n.266, p.383-409, 1999. REGAZZI, A. J. Teste para verificar a igualdade de parâmetros e a identidade de modelos de regressão não-linear. Rev. Ceres, Viçosa, v.50, n.287, p.9-26, 2003. SAS INSTITUTE. SAS/STAT User’s guide. Version 6. 4th. ed. Cary, 1990. v.2, 796p. SEARLE, S. R. Linear models. New York: John Wiley, 1971. 532p. STEEL, R. G. D.; TORRIE, J. H. Principles and procedures of statistics. New York: McGraw-Hill Book, 1980. 633p. SOUZA, G. S. Introdução aos modelos de regressão linear e não-linear. Brasília: Serviço de Produção de Informação, 1998. 505p. Recebido em 09.02.2004. Aprovado após revisão em 19.12.2004. Rev. Mat. Estat., São Paulo, v.22, n.3, p.33-45, 2004 45

Baixar