SAPO (Science Authomatic Press Observer): Construindo um barômetro da ciência e tecnologia na mídia Carlos Vogt§, Marcelo Knobel§, Yurij Castelfranchi§#, Rafael Evangelista§, Vilson Gartner* I wish to God these calculations had been executed by steam… Charles Babbage, 1821 A comunicação e a difusão do saber, e também a discussão pública das teorias […] percebidas não como foram valores. sempre Pelo contrário: elas se tornaram valores. Paolo Rossi, 2000 O princípio basilar da ciência acadêmica é que os resultados da pesquisa devem ser públicos. […] A instituição fundamental da ciência, então, è o sistema de comunicação John Ziman, 1987 § Labjor – Laboratório de Estudos Avançados em Jornalismo, Universidade Estadual de Campinas (SP) # SISSA – International School for Advanced Studies, Trieste, Itália. * SOLIS – Cooperativa de Soluções Livres, Lajeado (RS) 1 Prólogo: não há ciência sem comunicação Sua vida era envolta em lenda. Diziam que já estava há uma década tentando descobrir o segredo de uma vasilha de porcelana, provavelmente chinesa. Tinha gasto tudo que possuía. Acabada a lenha, havia destruído a cerca da casa e depois os móveis, para alimentar o forno onde pesquisava a cozimento da cerâmica. Assim, Bernard de Palissy (cerca 1510-1590) acabou na miséria, obcecado por aquele sonho. Cúmulo do azar, morreu na Bastilha, vítima das perseguições contra os huguenotes, sem descobrir o segredo daquela porcelana. Antes, porém, teve tempo de se tornar um dos maiores ceramistas de sua época, e um celebre filósofo natural. Estudou minerais e fósseis, hidrologia e agronomia, fisiologia das plantas e anatomia. Se orgulhava de não saber escrever em hebraico nem em latim: às “línguas retóricas” dos doutos, declarava preferir sua própria “língua rústica”, o francês, porque, dizia, a ciência era destinada “a todos os homens de França”. Em seu ateliê, em Paris, Palissy deu, por dez anos, conferências sobre artes e ciências. O público de curiosos e intelectuais pagava entrada para assistir: uma coroa. Mas dizem que o filósofo apostava o preço do bilhete: reembolsaria a todos caso as teorias que expunha se revelassem erradas. Grande divulgador e brilhante filósofo natural, Palissy, meio século antes de Galileu, escreveu livros de ciência em língua vulgar. E inventou, ante litteram, as conferências públicas de ciência. A história de Palissy (e, mais tarde, a de Galileu) não representa um caso à parte. É apenas um exemplo, dentre tantos, da relação indissociável entre ciência e comunicação (Eisenstein, 1998). Seja por meio de epistolários ou conferências públicas, de livros ou revistas, de museus, coleções, tábuas anatômicas, seja, hoje em dia, por meio softwares, listas de discussão e open archives, congressos, workshops, newtorks de pesquisa: a ciência, em cada uma de suas fases, sempre foi fortemente ligada a formas variadas de difusão, arquivamento, discussão da informação e do conhecimento. É fácil concordar com o historiador da ciência Paolo Rossi, que diz que a ciência nasce quando a comunicação do conhecimento – que era considerada intrinsecamente negativa no âmbito dos saberes herméticos e alquímicos – se transforma num valor: A comunicação e a difusão do saber, e também a discussão pública das teorias (que, para nós, são práticas comuns) não foram sempre percebidas como valores. Pelo contrário: elas se tornaram valores. À comunicação como valor sempre se contrapôs – desde as origens do pensamento europeu – uma imagem diferente do saber: como iniciação, como um patrimônio que somente poucos podem alcançar (Rossi, 2000, p.18). 2 Aliás, podemos dizer, com John Ziman, que não há ciência sem comunicação: o princípio basilar da ciência acadêmica é que os resultados da pesquisa devem ser públicos. Qualquer coisa que os cientistas pensem ou digam como indivíduos, suas descobertas não podem ser consideradas como pertencentes ao conhecimento científico se não forem relatadas e gravadas de forma permanente. A instituição fundamental da ciência é, então, o sistema de comunicação (Ziman, 1987; p. 80) Se isso sempre foi verdade, hoje é mais ainda. E não só. Se nunca houve ciência sem comunicação, hoje muitos estudiosos começam a dizer que tampouco há ciência sem sua divulgação e comunicação ao público. A comunicação pública da ciência desempenha um papel central nas sociedades contemporâneas, não somente no sentido, enfatizado e bem estudado, da importância do conhecimento científico para a formação dos cidadãos e para a gestão das democracias, mas também por uma necessidade, menos estudada e talvez menos confessável, da própria ciência. Uma necessidade interna, fisiológica, imprescindível, intrínseca ao novo panorama em que ciência e tecnologia se desenvolvem hoje. Se carreira, patrocínio, proteção aos cientistas sempre foram ligadas, pelo menos em parte, às suas capacidades de comunicar, é verdade que antigamente, pelo menos até as primeiras décadas do século XX, grande parte das decisões relevantes para a ciência eram tomadas, de forma substancial, no interior das comunidades científicas. As interações com o resto da sociedade, embora importantes para garantir recursos ou para interagir com o mundo da indústria, eram laterais, posteriores em certa medida à atividade científica: os cientistas, embora às vezes com pouco recursos, podiam viver na “torre de marfim” (Greco, 2002). Hoje, alguma decisões relevantes para a vida profissional e para o trabalho dos cientistas, bem como parte dos posicionamentos sobre como se faz pesquisa ou como se avalia sua qualidade, são tomadas com a participação de diferentes sujeitos, nem todos cientistas ou especialistas: são políticos, burocratas, empresários, militares, religiosos, movimentos sociais, consumidores e associações de pacientes que pedem, e frequentemente obtêm, o direito e a legitimidade para participar de decisões relevantes para o desenvolvimento da ciência. Esse processo, bastante complexo e ainda pouco estudado, parece ter começado após as guerras mundiais e se aprofundou a partir da década de 1990. Os cientistas, às vezes com relutância, estão cada vez mais precisando aprender como sair de seus laboratórios e de suas universidade para se comunicarem com grupos sociais variados: 3 A comunicação dirigida ao público não especialista (ou aos públicos) se tornou então relevante para a própria ciência. […] [A comunicação pública] antes era uma atividade opcional, hoje está se tornando uma necessidade para ciência. Se o cientista “acadêmico”, até o início do sec. XX, poderia, se assim desejasse, comunicar a ciência para os não especialistas, hoje o cientista “pós-acadêmico” deve fazé-lo. (Greco, 2002). A interação entre a ciência e os variados tipos de público é hoje, então, uma exigência social, e não somente um filantrópico desejo de democratizar o conhecimento, nem somente debe-se ao efeito da importância da tecnologia em nossas vidas. A sociedade precisa de informações científicas e a ciência precisa se comunicar com a sociedade como um todo (Greco, 2002; Castelfranchi, 2002; Greco, 2004). A separação entre a comunicação entre pares científicos e aquela voltada ao público leigo tornou-se menos drástica. Eis então que estudá-las representa um instrumento de grande valor para o estudo da ciência e da tecnologia na sociedade. Hoje, os fluxos comunicativos entre a tecnociência e as demais instituições envolvem um continuum de interações entre os cientistas e variados grupos sociais. Tanto a atividade epistemológica dos cientistas hoje, quanto a formulação de políticas públicas para C&T, são profundamente interligadas à comunicação e às representações sociais (Vogt et al., 2005; Vogt & Polino, 2003). Por essas razões, os temas complexos da cultura científica, como também da participação social em C&T, da percepção e representação da C&T, da presença da ciência na mídia, não só estão no centro do interesse de sociólogos, historiadores e estudiosos de opinião pública, como também, cada vez mais, passam a ter relevância para comunidades diversas de cientistas, políticos e policy makers, empresários, educadores, comunicadores e movimentos sociais. 1. Introdução: ciência e mídia Não é um acaso, então, que a bibliografia sobre percepção pública da C&T 1 e sobre ciência e tecnologia na mídia - tanto a latino-americana quanto a européia e norte-americana2 - seja bastante rica e extensa. Os diferentes instrumentos de análise de textos já desenvolvidos no âmbito dos estudos da linguagem, da semiótica, da opinião pública, da sociologia e até da antropologia, já foram aplicados à análise da mídia impressa, radiofônica e televisiva (Bauer & Gaskell, 2002). Particularmente, a análise de conteúdo (Bardin, 1997; Neuendorf, 2002) e a análise de discurso 1 Veja, por ex., Vogt & Polino, 2003 2 Por ex., Nelkin, 1987; Gregory & Miller,1998, Guimarães, 2001 4 (Flick, 1998; Orlandi, 1999) são utilizadas freqüentemente para investigar a comunicação pública, seu impacto, conteúdo, práticas discursivas, mensagens explícitas e implícitas. Para utilizar tais instrumentos, o requisito mais fundamental é, sem dúvida, dispor de um bom corpus (coerente, confiável, bem selecionado e organizado) de textos a serem analisados. Não só. Também fora do contexto acadêmico são inúmeras as situações em que se precisa de corpus de textos midiáticos selecionados, estruturados em base de dados e mensuráveis do ponto de vista quantitativo. Empresas com base científico-tecnológica ou instituições públicas ligadas à P&D, saúde e meio ambiente, estão sempre interessadas em medir sua visibilidade na mídia. Institutos públicos e privados podem precisar analisar o impacto e a repercussão de seus releases para imprensa, ou de seus posicionamentos públicos. Editores e administradores de jornais podem precisar de instrumentos quantitativos para comparar suas políticas editoriais com a de outros jornais. O peso relativo dado a diferentes tipologias de notícias e de conteúdos, o andamento ao longo do ano do tipo e qualidade das matérias publicadas, podem ser dados importantes. Os próprios jornalistas profissionais podem ter interesse em uma análise qualitativa e quantitativa que compare a cobertura que realizaram com a de colegas sobre assuntos ou eventos similares. Por isso, ao longo dos últimos três anos, fizemos o esforço de desenvolver um sistema de coleta, seleção, organização e mensuração da presença e do impacto da Ciência, Tecnologia & Inovação (CT&I) na mídia3. Trata-se de um banco de dados integrado com indicadores quantitativos, medidos automaticamente, da presença e do impacto das questões ligadas a CT&I em alguns dos jornais brasileiros de maior tiragem. Achamos que tal tecnologia pode representar um instrumento valioso, tanto para pesquisas acadêmicas quanto como ponto de partida para o desenvolvimento de produtos e aplicações tecnológicas destinadas a entidades públicas e empresas. O SAPO pode oferecer à comunidade de pesquisadores, de variadas áreas, informações diárias sobre a cobertura da mídia em CT&I, permitindo enxergar não só quanto este tema freqüenta o leitor, mas também como o leitor o freqüenta nas páginas dos jornais (Vogt et. al., 2005). 2. Um SAPO na mídia Nosso objetivo foi desenvolver um sistema que integrasse informações sobre Ciência, Tecnologia e Inovação divulgadas na mídia nacional e que permitisse uma avaliação da cobertura 3 O trabalho recebeu apoio da Fundação de Amparo à Pesquisa do Estado de São Paulo (Fapesp), sendo financiado no ambito do projeto “Ciência & Tecnologia, Comunicação e Sociedade: Questões de CT&I na Mídia Nacional”, Processo FAPESP N. 02/08321-6. 5 jornalística tanto em termos quantitativos (indicadores de freqüência, impacto, aprofundamento etc.) quanto qualitativos (fornecer um corpus arquivado e organizado de textos que permitam análise de conteúdo, de discurso e similares). Além disso, a proposta foi fornecer para comunidades de pesquisadores nacionais e internacionais um instrumento que pudesse, uma vez refinado e aperfeiçoado, estabelecer critérios comuns, oferecendo metodologias e indicadores-padrão para estudos de ciência na mídia, permitindo assim comparações nacionais e internacionais, estudos transversais e longitudinais em vários periódicos etc. O sistema se constitui de (veja Fig. 1): 1. Um conjunto de algoritmos especificamente preparados para a extração e cópia do texto integral (disponibilizado em sua versão eletrônica) de alguns dos jornais brasileiros de maior tiragem e difusão. O sistema está ativado, por enquanto, para acompanhamento automático de alguns dos maiores diários brasileiros: O Globo (RJ), Jornal do Brasil (RJ), Folha de S. Paulo (SP), e O Estado de S. Paulo (SP). Porém, uma interface para inserção manual de dados permite, caso seja necessário, incluir matérias oriundas de outros veículos. 2. Um sistema de classificação e filtragem de matérias, capaz de selecionar de forma automática aqueles textos que tratem de temas relacionados às ciências; políticas científico-tecnológicas e para inovação; biomedicina e meio ambiente. Veremos a seguir qual é a eficiência desse sistema de seleção e quais critérios guiam a escolha das matérias a selecionar. 3. Um banco de dados estruturado e um buscador inteligente que, organizam e gerenciam, a partir de vários metadados (veículo, caderno, data, fonte, autor, gênero jornalístico etc.), matérias selecionadas como sendo “de ciência”. Nesse banco é possível fazer diversas consultas como: •Notícias por assunto (grande área, área, palavras-chaves) •Notícias por autor •Notícias por fonte (agências, assessorias de comunicação institucionais etc.) •Notícias por período de tempo (dia, semana, mês, ano, com possibilidade de se realizarem estudos de evolução temporal de notícias sobre um determinado tema) De acordo com exigências uso específicas, tanto de pesquisa quanto de empresas, novas buscas podem ser facilmente modificadas e adaptadas. 4. Um conjunto de equações capazes de gerar indicadores sobre a frequência, relevância e outras características do material coletado e armazenado. 6 Ao usuário do sistema, então, é possível verificar quais temas científicos são objeto de maior interesse para a imprensa brasileira, como esses assuntos são tratados e em que seção do jornal aparecem mais freqüentemente. Ao pesquisador cadastrado é possível também utilizar os textos completos para análise de conteúdo ou de discurso. Decidimos dar prioridade aos textos publicados na mídia diária impressa (disponibilizados online), porque é a mais analisada em estudos clássicos. Exemplificando, isso significa coletar para o sistema todo o conteúdo de uma edição diária de jornais como a Folha de S.Paulo, disponível no endereço http://www.uol.com.br/fsp e, ao mesmo tempo, deixar de fora o conteúdo da FolhaonLine, disponível no endereço http://www.folha.uol.com.br/. Embora os dois conteúdos guardem íntima relação – parte do conteúdo do jornal impresso é uma reformulação do publicado na agência de notícias do jornal – nos limitarmos ao jornal impresso (mesmo em sua versão na Internet) significa nos utilizarmos de uma amostra menor e de controle e comparação mais fácil com pesquisas tradicionais. Ao mesmo tempo, a coleta desse material – muitas vezes restrito a assinantes – é tecnicamente mais difícil se comparada ao conteúdo das agências, muitas vezes já disponível e padronizado em formatos como o RSS. 2.1 Estrutura e funcionamento do sistema O projeto apresentou, desde o princípio, características e necessidades voltadas para o ambiente da internet. Dessa forma, a solução tecnológica adotada também foi baseada em ferramentas voltadas para essa plataforma. A linguagem de programação utilizada foi o PHP juntamente com o Framework MIOLO, base de dados Postgres, servidor de páginas Apache e sistema operacional GNU/Linux4. Dentre os desafios iniciais, estava o fato de conseguir desenvolver um software que aliasse facilidade de uso e versatilidade para acompanhar as mudanças constantes nas formatações de conteúdos online. Assim, seria imprescindível criar um sistema amplamente configurável que permitisse ainda a fácil inclusão de novos veículos no futuro. É através da interface web que são definidas as configurações dos veículos, localização (endereço web) dos textos, informações sobre os identificadores dos conteúdos nas matérias, filtros, entre outros. Tomando por base análises preliminares feitas nos sites dos veículos abrangidos no projeto, foram definidas as questões relativas ao armazenamento dos dados. Em seguida, o passo seguinte foi a 4 Toda a implementação tecnológica do projeto foi realizada com o apoio da cooperativa SOLIS (Cooperativa de Soluções Livres), baseada em Lajeado (RS). 7 criação de protótipos que fizessem a captura dessas informações e validassem ou apontassem mudanças necessárias na base de dados modelada originalmente. Finalizada essa etapa, partiu-se para a criação do sistema propriamente dito, com todas as suas telas, regras de negócios, além de vários algoritmos (pequenos programas) responsáveis pela coleta e seleção de dados. Estes também continham um desafio interessante, a necessidade de se fazer a autenticação automática em alguns sites para se ter acesso ao seu conteúdo. Os algoritmos, por sua vez, são agendados e executados automaticamente pelo sistema operacional. Juntamente com o processo de coleta dos dados nos sites, o sistema executa o processo de filtragem e, mediante filtros e pesos atribuídos previamente, é feita a extração de dados e seleção automática ou o descarte das matérias. Todo esse processo acontece sem a necessidade de intervenção humana, a qual somente será necessária para revisão e descarte definitivo do material coletado, além de melhorias nos filtros para o sistema. Por fim, a interface web permite ainda acesso às matérias, visualização de gráficos, acompanhamento diário dos processos executados pelos algoritmos e pesquisa nos conteúdos, que pode, inclusive, ser armazenada para utilização posterior. De modo resumido, o sistema opera da seguinte maneira: os sites dos jornais brasileiros são percorridos diariamente, as matérias são coletadas a partir de marcadores - observados pela leitura do código publicado - e armazenadas em uma base de dados. A base de notícias é assim atualizada diariamente de forma automática. Um sistema de filtros, dinamicamente definidos e que podem ser atualizados ou adaptados para exigências específicas, permite a seleção automática das notícias relevantes. Esse filtro opera a partir de pontuações previamente atribuídas a uma série de palavras-chaves. Esse pontos são somados e cada matéria recebe um score. Uma vez selecionadas as matérias de forma automática, elas são arquivadas no banco de dados de maneira organizada, sendo a elas acrescentado um conjunto de metadados. Fig. 1: Estrutura esquemática do sistema de coleta e classificação das matérias no banco de dados 8 2.2. Mecanismo de seleção e classificação O esquema de funcionamento dos filtros é extremamente simples. Seu uso, adequado à fase atual de implementação do projeto, terá que ser refinado e revisado, por meio da utilização de técnicas de Inteligência Artificial (redes neuronais, redes bayesianas, campos de proximidade semântica etc.). Porém, mesmo em sua forma simplificada, os filtros permitem identificar, com um bom nível de confiabilidade, as matérias relativas às ciências naturais e, com o auxílio de codificadores5, podem também ser valiosos na análise de matérias sobre ciências humanas e sociais. Antes de descrever em detalhes o funcionamento dos filtros e do sistema de seleção, é importante esclarecer como definimos um protocolo qualitativo para seleção do material: como estabelecer de forma clara o que é “ciência” e o que não é “ciência” nos jornais? Uma matéria sobre o novo modelo de Ipod é “inovação tecnológica”? Uma matéria acerca de como adubar melhor um pomar é ciências biológicas? E uma entrevista com uma nutricionista? E uma coluna sobre cosméticos? 2.3 Protocolo: o que definimos como “ciência e tecnologia nos jornais”? Muitas das pesquisas clássicas6, consideram como “ciência e tecnologia na mídia” somente as matérias que são “eivadas de conteúdo referente à C&T”7. Vários estudos caminham nesse sentido, selecionando apenas às matérias que dedicam-se à explicação de termos e conceitos científicos ou que são apenas a descrição de novas descobertas. Esse tipo de texto quase sempre é facilmente identificável e encontra-se encurralado em páginas ou cadernos com a explicita denominação, que remetem à ciência, tecnologia, saúde ou meio ambiente. Com essa abordagem limitada, identificar a “ciência” nos jornais é bastante simples e, ao mesmo tempo, pouco útil. Porque não cabem nessa seleção, por exemplo, cartas de leitores que, não divulgando nem explicando nada sobre transgênicos, expressam suas opiniões, valores, crenças a respeito de um tema importante em que a ciência entra na vida política e social do país. Também não cabem grandes discussões, que aparecem em páginas opinativas do jornal, em colunas econômicas ou nos artigos políticos, sobre 5 Na análise de conteúdo, se chama codificação o processo de classificação das unidades de texto a serem analisados (em nosso caso, as matérias coletadas pelo sistema), baseado nas categorias que foram previamente estabelecidas (por ex.: data, título, diário, gênero jornalístico, fonte, área temática etc.). São chamados de codificadores os sujeitos treinados para efetuar tal classificação das matérias em categorias. Em boa parte do texto a seguir o sistema de codificação de que trataremos é extremamente simples, devendo os codificadores simplesmente classificarem as unidades de texto como sendo de “CT&I” (selecionadas) ou “Não de CT&I” (não selecionadas). 6 Bucchi & Mazzolini, 2003; Dutt & Garg, 2000; Einsiedel, 1992. 7 Vogt & Marques de Melo, 2001 9 decisões estratégicas no setor de inovação tecnológica ou política energética, por exemplo. Não cabem artigos e matérias que aparecem em cadernos tão diferentes como o de esportes, cidades ou cultura, onde a ciência não vem “divulgada” ou noticiada factualmente e, sim, debatida ou, como é mais comum, apropriada, utilizada como metáfora, imaginada, veículo de discussões sobre temáticas tão disparatadas como sexualidade e eleições, novelas das oito ou campeonatos mundiais. Nossa opção foi estudar a ciência enquanto cultura: um grande ecossistema de símbolos, idéias, histórias, fatos, noções, que circulam e agitam a sociedade e tem, portanto, um fortíssimo reflexo midiático. A ciência “divulgada” é só a ponta do iceberg da ciência presente na mídia. Para medir e entender o peso real da cultura científica nas sociedade contemporâneas, é importante então analisar a presença da ciência em sua totalidade e interpretar o jornalismo científico em seu sentido mais amplo. Eis então que nosso protocolo para seleção das matérias “de ciência” foi mais complexo que o usual. Treinamos os codificadores8, e preparamos o mecanismo de seleção da máquina, de forma que escolhessem matérias de “ciência, tecnologia e meio ambiente” com as seguintes caraterísticas: - Não são selecionadas matérias sobre todos os produtos tecnológicos (novos modelos de celular, computador etc.) mas, ao contrário, somente matérias relativas a avanços em tecnologias de ponta ligados a pesquisa (como nanotecnologia, biologia molecular etc.). Obviamente, inclui-se também temas de tecnologia aerospacial, matérias sobre astronautas etc. - São selecionadas as grandes discussões sobre políticas e impacto da CT&I (por ex.: poluição electromagnética, transgênicos, TV digital etc.) - Ciências da vida inclui medicina. E, com esta, também políticas de saúde, empresas farmacêuticas, investimento em pesquisa e saúde, matérias sobre gripe aviária, Aids, políticas dos remédios, patentes, novas vacinas etc. - Ciências não implica somente matérias onde algum conteúdo científico é explicado e divulgado, mas também editoriais, colunas, artigos, cartas onde temas fortemente ligados à ciência e tecnologia são debatidos, comentados etc. Por exemplo, aborto, clonagem, poluição, política nuclear (e tratados internacionais sobre proliferação nuclear) etc. - Consideramos como matérias sobre meio ambiente – e, portanto, estão incluídas - não somente a divulgação de pesquisa sobre ecologia ou biodiversidade mas também políticas ambientais e tratados internacionais, desmatamento, invasão de parques 8 Veja nota 2. 10 protegidos por lei, criação de reservas, usinas elétricas, energias alternativas, estudos de impacto ambiental etc. - Consideramos como “de ciência” também as matérias sobre ciências humanas e sociais, o que significa, muitas vezes, considerar matérias de comportamento ou sobre política que dêem voz a pesquisadores dessas áreas. A economia também é considerada uma das ciências humanas, porém, não incluem-se matérias que apenas expõem dados econômicos (valore da cesta básica deste mês, diminuição da taxa de desemprego etc.), mas apenas aqueles que trazem algum tipo de discussão sobre teorias econômicas, modelos de desenvolvimento, novas pesquisas, globalização etc. De maneira similar, as ciências políticas são consideradas, mas não selecionaremos matérias, por exemplo, que simplesmente forneçam dados sobre as porcentagem de indicação de voto para diferentes candidatos a uma eleição na última enquete eleitoral e, sim, discussões sobre filosofia política, divulgação de pesquisas acadêmicas etc. É importante ressaltar, porém, que, neste trabalho, analisaremos exclusivamente o funcionamento do sistema no que concerne à sua seleção de matérias de ciências naturais e exatas: os dados a seguir (sobre fidedignidade, porcentagem de matérias sobre CT&I etc) são calculados então somente levando em conta temas como ciências exatas, biomedicina, meio ambiente, inovação e políticas tecnológicas etc. Existem motivos para isso. O protocolo de seleção, no caso da ciências humanas e sociais, é bastante mais complexo e a quantidade de matérias para analisar nos jornais muito elevada, levando a uma margem de discordância entre codificadores humanos também alta. Ao mesmo tempo, as análises preliminares indicam que o sistema de filtros por palavras-chaves que desenvolvemos, apesar de serem – também no caso das ciências humanas e sociais – um instrumento útil para fazer uma pré-seleção das matérias, não têm um grau tão elevado de eficácia. Decidimos, então, avaliá-lo e utilizá-lo mais profundamente na próxima etapa do projeto, quando disporemos de instrumentos mais sofisticados de seleção automática, tais como as mencionadas redes bayesianas. Com esta definição ampla em mente, construímos um sistema de seleção automática, que descrevemos a seguir, e compararemos, posteriormente, sua performance com a seleção feita por codificadores treinados. As matérias de cada jornal passam por cinco filtros, ou listas de palavras-chaves. Cada palavra-chave um seu peso numérico: termos técnicos de determinadas disciplinas ou palavras que 11 descrevem a prática científica têm um peso elevado (por exemplo: “Neurônio”=4, “Nanotecnologia”=5 e assim por diante). Essas palavras estão agrupadas em cinco conjuntos (filtros) diferentes. Figura 2: Os cinco filtros usados para seleção das matérias Outras palavras, que costumam comparecer em matérias de caráter científico, mas que também são de uso comum na linguagem geral, têm um peso baixo (“atmosfera”=1; “física”=1 etc.). Figura 3: Exemplos de palavra chaves e sua pontuação Passando pelos filtros, cada matéria adquire uma pontuação (score) dada pela soma dos pesos de cada palavra chave encontrada (calculada uma vez só). As matérias que somam pontuação superior a 16, são selecionadas pela máquina como sendo de CT&I. As que ficam abaixo de 10 são 12 classificadas como “descartadas”. Todas as matérias que ficam na área intermédia (9<score<17), são classificadas como “não revisadas”, precisando, nesta fase de evolução do projeto, do acompanhamento de um codificador para ser confirmadas ou rejeitadas. Como veremos, tais matérias não passam de 4% do total. Figura 4 Exemplos de matérias rejeitadas pelo sistema Porém, esse score tem limitações no que se refere à capacidade de selecionar as matérias. Por isso, além desse tipo de pontuação linear, desenvolvemos, de forma experimental, uma pontuação de tipo fatorial (que chamamos de “score teste”): os pesos de todas as palavras encontradas não são somados e, sim, multiplicados, e o resultado total (que cresce exponencialmente) é dividido pelo número total de palavras contidas na matéria. Esse segundo tipo de pontuação têm duas vantagens: a) Matérias extremamente curtas como notas, legendas de imagens científicas, citações etc, que contêm poucas palavras (ou seja, têm poucas chances de serem selecionadas pela simples soma de pontos), podem ter um “score teste” alto. Isso acontece porque a pontuação computada é dividida pelo número de caracteres contido na respectiva matéria, o que torna o score teste mais comparativo, já que o tamanho da matéria é relativizado. b) Utilizando esse parâmetro como indicador de relevância das matérias, o que importa não é tanto a presença de uma palavra ou outra, mas sim a presença simultânea de palavras com 13 pontoação>1 , o que pode ajudar a selecionar matérias com base em seus campos semânticos, de forma similar (embora mais rudimentar) à feita nas redes de bayesianas ou em instrumentos de Inteligência Artificial. A escolha das palavras-chaves para a seleção de notícias não foi fácil. Inicialmente, experimentamos uma lista bastante extensa de termos, com o objetivo de “capturar” o maior número possível de matérias. No entanto, os arquivos típicos de palavras-chaves utilizadas, por exemplo no âmbito da biblioteconomia, são, por um lado, de grande dimensão (o Vocabulário Controlado USP têm cerca de 25 mil verbetes), por outro lado, quase completamente inúteis: o conjunto de palavras-chaves utilizadas para classificação em arquivos de revistas científicas ou bibliotecas compartilha só em mínima parte a bagagem lexical típica da divulgação na mídia. Termos como “processos estocásticos” ou “geometria algébrica”, que são perfeitamente adequados para identificar e classificar artigos científicos, praticamente nunca são utilizados em matérias jornalísticas, nem quando tratam exatamente dos assuntos identificados por tais termos. Por essas razões, uma abordagem baseada na construção de um vocabulário exaustivo de termos técnicos se mostrou pouco produtiva: muitas matérias eram incorporadas ao sistema, mas não havia sido definido nenhum parâmetro a partir do qual fosse possível identificar quais eram de maior interesse para os objetivos deste projeto. A opção foi, então, delimitar um número muito mais restrito de palavras, facilmente manejável e passível de atualização e aperfeiçoamento dinâmico, atribuindo a essas a pontuação mencionada acima, o que facilita a definição do perfil das matérias que se quer coletar. Vale ressaltar que essa lista não pretende ser exaustiva e nem equanimemente abranger todas as áreas da ciência. Não é importante ter termos técnicos ligados a todas as áreas de conhecimento que um jornal possa tratar, nem ter termos igualmente distribuídos entre várias áreas (medicina, química etc). O importante é ter um conjunto mínimo de termos qualquer que sejam caraterísticos da linguagem de matérias de divulgação ou das que tratam de ciência, política científica, meio ambiente etc, e que sejam, ao mesmo tempo, menos freqüentes em matérias que tratam de outros argumentos. Assim, obviamente, “DNA” ou “transgênicos” podem ser termos importantes, mas “eletrofisiologia” e “antiproton” não necessariamente (pois não são tão caraterísticos ou comuns). Do mesmo modo, podem também não ser tão importantes palavras como “teoria”, “modelo”, “física”, porque, apesar de serem caraterísticas e comuns em descrições científicas, não são específicas ou endêmicas só de matérias que tratam de ciência. 14 3. Confiabilidade do sistema de coleta e seleção 3.1 Confiabilidade do sistema de coleta Para verificar a correspondência entre o material coletado pelo sistema e o que é publicado nos jornais, comparamos matérias contidas no banco de dados em três “semanas construídas” (os sete dias da semana, porém escolhidos casualmente num intervalo de seis meses de disponibilidade do jornal) para os quatro jornais coletados, com o material disponível também na versão impressa dos jornais, para comparação. Após ajustamentos iniciais nos veículos de coleta (alguns jornais mudaram sua produção, introduziram ou eliminaram cadernos etc), conseguimos coletar todos os cadernos de todos os jornais com um excelente nível de correspondência entre o material no banco de dados e o que sai nas bancas. É importante ressaltar, porém, que: a) O sistema somente coleta textos: imagens, charges, tiras, publicidades etc não fazem parte do corpus coletado b) Há algumas diferenças entre a versão impressa do jornal que um assinante recebe em sua casa e a versão que o mesmo assinante pode acessar no site do jornal como sendo a versão “impressa”. Por exemplo, a versão “impressa” disponível online, conterá, em alguns casos, mais cadernos que qualquer versão física comprada nas bancas, pois esta última só tem o caderno local correspondente à cidade de residência (do Rio de Janeiro, Niterói, Campinas, São Paulo etc.), enquanto a versão online pode ter todos. c) Há outra pequenas porém interessantes diferenças entre versão impressa e sua “cópia” online. Algumas matérias da versão impressa disponível no site são extremamente parecidas com o que saiu realmente no papel, porém não idênticas: o título e o primeiro parágrafo podem ser ligeiramente diferentes ou, às vezes, o tamanho ligeiramente ajustado. Isso, provavelmente, deve-se a modificações de última hora ocorridas durante a diagramação e edição final do jornal, devido a exigências de publicidade ou de notícias de última hora, e que foram executadas de forma diferente em diferentes versões impressas do jornal. Feitas tais ressalvas, podemos afirmar que a confiabilidade do sistema de coleta é extremamente alta. Estimamos as divergências entre o corpus coletado e o que sai na versão de papel em menos de 1% do material total, excetuando obviamente os cadernos locais, que não estão todos disponíveis na versão para assinante. A coerência do corpus é garantida, sendo que o sistema envia mensagem de alerta quando não consegue coletar parte ou totalidade de alguns cadernos (devido, por exemplo, à queda do servidor). 15 Resta importante, obviamente, checar periodicamente que cada jornal não eliminou cadernos ou criou novos, mudou a estrutura de arquivação dos velhos etc. Dentro dessas limitações, o sistema demostrou ter um ótimo nível de confiabilidade quanto à coleta integral do corpus textual dos veículos. 3.2 Confiabilidade do sistema de seleção Para analisar a confiabilidade da classificação de matérias “de ciência” do sistema, efetuamos diferentes tipos de análise: a) nível de concordância entre humanos e máquina quanto às matérias descartadas b) nível de concordância entre humanos e máquina quanto as matérias selecionadas c) situação e composição das matérias que o sistema armazena na categoria não revisadas d) intercoder reliability entre máquina e humanos. Essa análise será realizada para garantir que o nível de concordância entre a máquina e humanos sobre quais matérias são “de ciência” não será menor que o nível de concordância entre dois codificadores. a) Porcentagem de acertos do sistema ao descartar matérias não ligadas a ciência Primeiramente, efetuamos vários pré-testes em duplo cego: dois codificadores humanos, separados e sem comunicação mas tendo passado pelo mesmo tipo de treinamento, analisaram a mesma edição de um jornal (em sua versão impressa), escolhendo quais matérias eram relacionadas (de acordo com o protocolo e definição descrita anteriormente) com ciência, tecnologia, meio ambiente, e quais deveriam ser descartadas. O resultado foi que a avaliação de dois operadores humanos diferia em média em 3% das matérias analisadas. Na segunda fase, 1700 matérias, publicadas nos quatro veículos e descartadas pelo sistema foram analisadas pelos mesmos codificadores humanos, em busca de eventuais matérias que se enquadrasse em nosso protocolo. O resultado foi que menos de 0.5% das matérias descartadas pelo sistema eram potencialmente relevantes sob o olhar dos codificadores (Tab. 1). Repetimos os testes com mais 2000 matérias, obtendo o mesmo resultado. Mas, como explicar ser a concordância entre humanos de 97% e, entre estes e a máquina ser maior que 99%? A razão disso é que o sistema não coloca na categoria “descartadas” todas as matérias não ligadas a ciência. Uma pequena parte das matérias que não se enquadra na definição que estabelecemos fica na categoria “não revisadas” (aquela que possui um score intermediário) criando-se, assim, uma zona cinza, o que diminui sensivelmente a margem de erro tanto para categoria “descartadas” quanto para a de “selecionadas”. 16 Dias Veículos analisados 2/1/2006 FSP 26/1/2006 FSP e EST 15/1/2006 FSP e EST 1/9 a 3/9/2005 FSP e JB TOT TOT. Matérias N. Discordâncias % descartadas 100 317 413 870 1700 com codificador humano 0 1 1 4 6 Concordância 100% 99.7% 99.8% 99.5% 99.65% Tabela 1: Matérias descartadas pelo sistema e porcentagem de concordância com a classificação feita por um codificador humano Outra caraterística interessante ressaltar é relativa ao tipo de matérias que causam diferença na seleção feita por dois codificadores humanos ou na diferença de seleção entre um codificador e a máquina. No caso dos humanos, boa parte dos desacordos (matérias que foram descartadas por um e selecionadas por outro) estavam ligados a falhas de leitura: o codificador lia apressadamente matérias vindas de partes do jornal em que ele/a não esperava alto conteúdo científico (esporte, crônica de cidades, cartas de leitores, colunas de política ou economia etc.) e não se dava conta de que uma matéria que, pelo título, parecia tratar de economia, política ou esporte, tocava na verdade em temas ligados à ciência. No caso da máquina, quase todas as matérias tocando temas de ciência eram selecionadas ou pelo menos colocadas em “não revisadas”, enquanto que as poucas matérias erroneamente descartadas (ou seja, que os operadores humanos consideraram ligadas à ciência) eram quase todas de dois tipos: a) matérias com poucos caracteres, como legendas de imagens, listas de notas breves (consideradas, em seu conjunto, como uma matéria, mas sendo apenas umas das notas relativa à ciência) ou frases isoladas. Esse foi um dos fatores que levou à construção do score teste experimental discutido acima. b) matérias ligadas à ciência mas não divulgando conteúdo científico e, sim, discutindo aspectos culturais, filosóficos ou sociais da ciência, contendo, então pouquíssimas palavras-chaves de cunho científico. O sistema é então, em certa medida, mais confiável que os operadores humanos, pois nunca se deixa influenciar pela colocação ou título da matéria a ser analisada, sendo necessário porém refinar sua eficiência nos casos discutidos acima. 17 b) Porcentagem de acertos do sistema ao selecionar matérias de ciência No caso de matérias selecionadas a situação é mais complexa pois, se é bastante fácil treinar codificadores para excluir matérias que claramente não se relacionem com temas científicos, muito mais difícil é definir um protocolo claro que delimite eficientemente quando uma matéria jornalística tem muita relação com ciência e tecnologia. Demonstremos o problema com um exemplo: consideramos, para os veículos Folha de S. Paulo e Jornal do Brasil, os dias entre 1/9/2005 e 14/9/2005, período em que o sistema armazenou como “selecionadas” um total de 145 matérias. Analisadas por um codificador, sete dessas matérias foram julgadas como não sendo sobre ciência, ou contendo termos científicos somente usados como metáforas e não como tema de base. Isso corresponde a uma porcentagem de concordância entre máquina e humano de cerca de 95%. Porém, o mesmo codificador encontrou mais 10 matérias que tratavam, sim, de ciência, mas só marginalmente ou somente em pequena parte de seu texto. Levando em conta estas, a porcentagem de concordância baixa para 88%. Dias analisados 22/1 a 26/1/2006 Semana construída 1/9 a 14/9/2005 TOT TOT. Veículos Mat. N. Discordâncias (e matérias parcialmente ligadas à CT&I) % Concord. Selec. FSP e EST 62 4 (+8) 93.5% (81%) FSP, EST 115 3 97% FSP, JB 145 7 (+10) 95% (88%) 322 14 (+18) 96% (90%) Tab. 2: Matérias selecionadas pelo sistema como sendo de CT&I e porcentagem de concordância com um codificador humano (em parêntese, a mesma quantidade contabilizando como discordâncias as matérias que, de acordo com o codificador, só tratam de ciência marginalmente ou em trechos muito pequenos. Voltaremos, mais tarde, a abordar as implicações disso para o nível de confiabilidade do sistema. Por enquanto, basta ressaltar alguns fatos: 18 – O nível de desacordo entre máquina e humanos é, de qualquer maneira, não superior a 10% das matérias selecionadas. Esse valor corresponde a menos de 1% das matérias totais do jornal, ou seja, poucas unidades por dia. – O fato da máquina selecionar como sendo “de ciência” textos que só em pequenos trechos tratam efetivamente de temas ligados à CT&I não deve necessariamente ser considerado um erro do sistema de seleção, por duas razões: por um lado, a estrutura de editoração da maioria dos diários é feita de tal forma que colunas contendo muitas pequenas notícias (por exemplo: colunas sociais, colunas de eventos da cidade, notícias breves de política ou economia) sejam tratadas como uma única matérias. Se uma única notícia for de ciência, nosso sistema, corretamente, deve selecioná-la mas, infelizmente, não pode fazer isso a não ser pegando o inteiro texto: o erro não deve ser corrigido na seleção e, sim, na fase de coleta, ou seja na subdivisão do texto em mais notícias. Por outro lado, quando há grandes reportagens que só em pequena parte mencionam temas de CT&I, nem sempre é claro, para um codificadore humano, se o sistema “errou” em selecioná-las. Se estamos interessados em medir como e quanto a ciência permeia a cultura, a política, a economia, o fato, por exemplo, de encontrar, dentro de uma matéria que trata de um comício eleitoral, algumas linhas explicitando a posição do candidato sobre transgênicos, protocolo de Kyoto ou fontes de energia, pode ser relevante. È por estas razões que um segundo codificador avaliou de forma bastante diferente as matérias corretamente selecionadas ou erradas, com uma porcentagem de acordo com o primeiro codificador de cerca de 92%: a seleção ou rejeiçãodeste tipo de matérias não é somente um problema para a máquina . c) Matérias que o sistema armazena na categoria “não revisadas” Entram nestas categorias os textos cuja pontuação fica numa “zona cinza” que não permite afirmar, com nível suficiente de confiabilidade, se devem ou não ser selecionados como “de CT&I”. Trata-se, então, de matérias (cerca 5% do total, poucas unidades para cada dia de coleta) para as quais é necessária a supervisão de um codificador humano. Também são matérias que, normalmente, os codificadores humanos têm mais dificuldades em classificar. Uma análise preliminar de tais matérias (Tab. 3) mostra que um codificador humano considera como sendo de CT&I, em média, 45% delas. 19 TOT. Matérias Dias analisados Veículos 04/01/2006 6 e 7/01/2006 JB e FSP JB e FSP FSP e EST 16/1 a 18/1/2006 1/10 a 8/10 2005 10/2 a 17/2 2006 TOT JB, EST JB na cat. “não revisadas” 10 27 N. Matérias consideradas ligadas à % de CT&I CT&I por codificador humano 6 60% 16 59% 42 20 48% 113 47 239 40 26 108 35% 55% 45% Tab. 3: Análise das matérias classificadas como “não revisadas” pelo sistema 3.2 Intercoder reliability Os níveis de acordo percentual medidos acima são bastante notáveis, mostrando que as matérias que a máquina seleciona são consideradas relevantes por codificadores humanos treinados em pelo menos 95% dos casos, enquanto que as matérias descartadas são confirmadas como tais pelos humanos em mais de 99% dos casos. Apesar disso, tais porcentagens não podem ser consideradas um bom indicador do nível de confiabilidade de nosso sistema, não só por causa das matérias contidas na “zona cinza”, que precisam de supervisão humana. Como mostrado por vários autores, uma simples porcentagem de acordo médio não é um indicador confiável do chamado intercoder agreement, ou intercoder reliability, porque não leva em conta os casos nos quais a concordância entre os pesquisadores pode ser simples fruto do acaso: Despite its simplicity and widespread use, there is consensus in the methodological literature that percent agreement is a misleading and inappropriately liberal measure of intercoder agreement (at least for nominal-level variables); if it is reported at all the researcher must justify its value in the context of the attributes of the data and analyses at hand (Lombard et al., 2005) Por exemplo, se o codificador A seleciona suas matérias baseado em lançar uma moeda, descartando todas as que coincidem com cara, enquanto o B descarta todas as matérias que coincidem, em seu lançamento de moeda, com coroa, os dois terão uma porcentagem de acordo, no caso de um número bastante elevado de matérias analisadas, de cerca de 50%. Porém, a fidedignidade dessa concordância é nenhuma, já que todas as decisões foram mero fruto do acaso. Além disso, operadores humanos, em sua primeira fase de treinamento, selecionavam como sendo “de ciência” de 2 a 10 matérias em 100. A porcentagem de acordo total era sempre superior a 90%, 20 ou seja aparentemente satisfatória. Na verdade, quando se examinavam as matérias selecionadas, logo percebia-se que o acordo sobre estas últimas era insignificante: os codificadores não tinham problemas em concordar sobre a grande maioria de matérias a serem descartadas, mas sobre poucas “de ciência”, justamente as relevantes, tinham opiniões tão discordes que, às vezes, pouco mais que a metade das matérias selecionadas coincidia. Assim sendo, há acordo entre pesquisadores de que medir de forma rigorosa esta reliability, ou índice de fidedignidade ou de confiabilidade (Bauer & Gaskell, 2002) é condição absolutamente necessária, embora não suficiente, para conferir validade a pesquisas baseadas em seleção e categorização de textos e que tal quantidade não pode ser medida por meio de porcentagens de acordo. Vários indicadores estatísticos, e talvez umas dúzias de métodos diferentes, foram propostos para avaliar a inter-coder reliability (Popping, 1998). De acordo com a maioria dos estudiosos, indicadores de uso clássico em estatística (tais como o alpha de Cronbach, o r de Pearson, ou o quiquadrado) também não são adequados para avaliar o nível de concordância entre dois ou mais codificadores de um corpus textual. Mais confiáveis e freqüentemente utilizados na área de análise de conteúdo são os chamados Pi de Scott (1955), K de Cohen, alpha de Krippendorf e o método de Holsti (1969). Utilizamos aqui o primeiro, de uso particularmente simples em casos, como o nosso, de dois codificadores utilizando variáveis binárias (Matéria Selecionada/Rejeitada). De acordo com a maioria das pesquisas, valores de Pi acima de 80% são considerados extremamente bons para confiabilidade de uma seleção e classificação de textos. Valores de Pi > 65% são considerados razoaveis, enquanto valores muito abaixo disso indicam duas possíveis tipologias de problema, codificadores mal treinados, ou protocolo de seleção ambíguo ou mal definido: It is widely acknowledged that intercoder reliability is a critical component of content analysis, and that although it does not insure validity, when it is not established properly, the data and interpretations of the data can not be considered valid. As Neuendorf (2002) notes, "given that a goal of content analysis is to identify and record relatively objective (or at least intersubjective) characteristics of messages, reliability is paramount. Without the establishment of reliability, content analysis measures are useless" (p. 141). […] Interjudge reliability is often perceived as the standard measure of research quality. High levels of disagreement among judges suggest weaknesses in research methods, including the possibility of poor operational definitions, categories, and judge training (Lombard et al., 2005). 21 Em nosso caso, vimos que os próprios codificadores dificilmente conseguiam valores bons para Pi. Em suas primeiras fases de treinamento, os codificadores selecionaram, a partir de um estoque de cerca de 1100 textos, matérias de ciência com uma porcentagem de concordância acima de 90%. Porém, quando Pi era calculado, mostrava valores extremamente baixos. Codificadores cuidadosamente treinados - graças a discussões sobre cada caso duvidoso -, nivelados numa definição empírica razoavelmente coerente e estável chegaram a ter valores de Pi satisfatórios Dia analisado 2/07/2006 23/7/2006 23/7/2006 Média Veículos % Concordância PI FSP EST FSP 94% 93% 98% 95% 50% 29.5% 71.5% 50% Tab. 4: % de Concordância e Pi de Scott entre dois codificadores em sua primeira fase de treinamento Dia analisado 7/11/2004 23/7/2006 Prova 18/08/2004 12/03/2006 02/07/2006 TOT e Média TOT. Veículos Matérias % Concordância PI FSP FSP examinadas 137 181 93% 98% 77% 85% EST 156 91% 67% GLO FSP 49 154 96% 95% 84% 58% 677 95% 74% Tab. 5: % de Concordância e Pi de Scott entre dois codificadores que já concluíram treinamento A performance do sistema passou por algo análogo: numa primeira fase de teste, em que as palavras-chaves dos filtros tinham sido ajustadas somente na base de garantir que a maioria das matérias de C,T&I fossem selecionadas, e que ficassem como rejeitadas praticamente só matérias que não tratassem de ciências, a máquina mostrava uma boa porcentagem de concordância com os codificadores, mas péssimos valores de Pi (Tab. 6). 22 Dia analisado 12/03/2006 TOT. Veículos Matérias % Concordância PI JB examinadas 121 96% 43% Tab. 6: % de Concordância entre codificador e sistema e Pi de Scott, antes do refinamento dos filtros Dia analisado 23/07/2006 TOT. Veículos Matérias % Concordância PI FSP examinadas 181 92% 65% Tab. 7: % de Concordância entre codificador e sistema e Pi de Scott, depois do refinamento dos filtros Por um lado, tais valores relativamente baixos para Pi são, obviamente, ligados, como mencionado acima, ao fato que nosso universo de análise (CT&I e cultura científica nos jornais) não é algo identificável de forma rígida, que não se mistura e confunde com a produção cultural geral da mídia. Nossa definição de temas ligados à ciência é razoável, mas com uma margem de ambigüidade intrínseca: trata-se de uma ambigüidade epistemológica, não ligada a definição operativa vaga e confusa. Isso leva a uma margem de erro dos operadores humanos (para matéerias selecionadas) entre 2 e 5%. Por outro lado, é interessante ver como o sistema automático não só é, no mínimo, tão confiável quanto os codificadores humanos, como também não sofre da inconstância e variabilidade ligada ao treinamento de cada indivíduo. Sua seleção não é baseada nos mesmos princípios que a de um codificador humano, porém é pelo menos tão confiável quanto esta e mais constante: uma vez aceita como razoável a performance da máquina em selecionar e quantificar a ciência na mídia, essa se torna universalmente reproduzível. Não é mais necessário transmitir e interpretar protocolos bastante complexos e, em parte, ambíguos sobre como definir o que é ciência na mídia; nem é preciso ensiná-los para pessoas diferentes e que precisam de muitos dias de treinamento. 3.3 Eficiência e eficácia do SAPO Resumindo, o estado atual dos filtros permite uma avaliação excelente da quantidade de matérias relacionadas à ciência. SAPO fornece, com notável eficiência e eficácia, um corpus de textos selecionados automaticamente (pode chegar a baixar e classificar mais de 15000 matérias por 23 dia). SAPO precisa de supervisão humana somente para poucas unidade de texto por dia para cada jornal. Até na ausência de supervisão, os dados quantitativos fornecidos pelo barometro de indicadores de SAPO têm uma margem de erro total não maior que ±3%: a) a máquina é boa quanto codificadores humanos treinados para descartar matérias não consideradas “de ciência” dentro do corpus coletado, sendo sua margem de “erro” na escolha (<0.5%) menor que a discordância entre dois humanos treinados quanto a o que não considerar “de ciência” na mídia b) a margem de incerteza sobre a definição de quais matérias levar em conta como sendo “sobre ou de ciências” é maior, chegando a quase 10% das matérias selecionadas (que são 3-4% do total) e cerca 40-60% das “não revisadas”) (que são 3-5% do total). Isso implica, como mencionado acima, uma margem de erro porcentual total da ordem de 2-3%. Uma parte deste erro é devido ao sistema de seleção extremamente simples utilizado, por palavras-chaves: será então minimizado numa próxima fase do projeto, em que campos semânticos, associações de palavras e redes bayesanas serão implementadas para seleção. Mas uma parte do erro é intrínseca à definição e sentido amplo que decidimos, propositalmente, dar ao tema ciência na mídia. Demos à ciência a dimensão cultural, complexa e profunda que ela tem nas sociedades contemporâneas. Ou seja, estamos utilizando uma definição em que a ciência, como toda atividade cultural, não tem paredes impermeáveis que a possam separar de um jeito simples, mecânico e inevitável, do resto da produção cultural. 4. Aplicações do SAPO 4.1 Barômetro e Índice de CT&I na mídia O primeiro produto alcançado ao longo do desenvolvimento do Projeto SAPO é o Índice de CT&I, com o qual, à semelhança de outros índices nas áreas econômica, social e financeira, se pode avaliar de maneira quantitativa a penetração de tópicos de CT&I nos meios de comunicação e, conseqüentemente, no dia a dia da sociedade. Nesta primeira fase foram desenvolvidos quatro indicadores quantitativos, que futuramente serão integrados num “barômetro” de indicadores e finalmente deverão compor também um Índice de composição complexa e, ao mesmo tempo, simples e compreensível. São calculados e apresentados graficamente de forma automática pelo sistema Os primeiros três são indicadores já afirmados entre os pesquisadores de estudos da mídia, enquanto o quarto foi desenvolvido por nós e sua aplicabilidade e utilidade estão sendo analisadas em um trabalho específico. Chamamos N_Tot o número total de matérias que foram publicadas num determinado dia 24 por um determinado veículo. Por exemplo, para diários de grande porte como Folha de S. Paulo e Estado de S. Paulo, N tende a assumir valores na faixa de 150 a 180. Chamamos P_Tot o número total de palavras contidas num determinado diário num determinado dia. Chamaremos então N_selecionadas o número de matérias selecionadas, para um determinado dia em determinado veículo, e P_selecionadas o número total de palavras nelas contidas. A partir destes valores, que nosso sistema calcula diariamente para cada veículo coletado, definimos os seguintes indicadores numéricos: 1. Indicador de “massa” na mídia, M. Representa simplesmente o número absoluto de matérias de CT&I publicadas em cada veículo analisado, num determinado dia: M = N_selecionadas Sua análise temporal permite evidenciar de forma automática os momentos em que existe uma “epidemia mídiatica” sobre CT&I, permitindo apontar estudos de caso interessantes. Por exemplo, analisando o Indicador de massa diário, ao longo de um intervalo temporal de um mês, não foi difícil identificar a tendência da Folha de S. Paulo e do Estado de S. Paulo em ter um maior número de artigos “de ciência” nos domingos (que correspondem à publicação dos cadernos culturais) e – em menor medida – em dias de semana que correspondem a cadernos de saúde, meio ambiente etc. Além disso, foi fácil identificar, pelos picos do indicador de massa, recorrências, aniversários ou pequenas epidemias mídiaticas (Figura 5a e 5b), tais como o aniversário da descoberta da estrutura do DNA, por Watson & Crick. Figura 5a e 5b Uso do Indicador de Massa na identificação de casos midiáticos 25 O uso do Indicador M, calculado não diariamente e, sim, como média sobre intervalos maiores (por exemplo, mensais) permite, por sua vez, avaliar o espaço dedicado em média pelos jornais à C&T. 2. Indicador de “freqüência”, f. Representa a quantidade relativa, ou seja a porcentagem de matérias de CT&I sobre o total de matérias publicadas no veículo: f = M/ N_Tot Pode ser considerado como um indicador de “atenção” dada por um determinado veículo a questões de CT&I. Permite, de forma melhor que o valor absoluto, “de massa”, uma comparação da atenção dada, no mesmo veículo, a outros tópicos, como esportes, economia, lazer etc. Como veremos, seus valores oscilam normalmente entre 1% e 10%, com picos de em dias específicos caraterizados pela presença de cadernos intensamente “habitados” pela CT&I. Este indicador, tendo valor relativo, é fundamental para uma comparação do comportamento de diferentes jornais. Além disso, também se revela de grande utilidade em sinalizar casos midiáticos: em alguns dias, onde as matérias do jornal aumentam, a freqüência, mais que o número absoluto de matérias, pode alerta para algo que esteja acontecendo (Fig. 6) Figura 6. Exemplo do Indicador de Freqüência 26 3. Indicador de “densidade” na mídia, d. Representa o espaço relativo que as matérias de CT&I ocupam em cada veículo analisado, ou seja a porcentagem de caracteres dedicada à CT&I: d = P_selecionadas /P_Tot Figura 7. Indicador de densidade na mídia (média semanal) 4. Indicador de aprofundamento na mídia, A. Representa o peso relativo que o veículo dá a matérias de CT&I em comparação a matéria “média” do jornal: A = d/f Quando este índice é acima de 1, significa que o veículo está publicando matérias de ciência e tecnologia que são, em média, de tamanho maior que o das matérias em geral. Trata-se, então, de um indicador do tipo de política editorial e cultural do jornal. A<1 tende a significar uma política editorial que vê ciência e tecnologia, de maneira geral, como notícias ou artigos breves. Quando – como por exemplo tende a ser o caso da Folha de S. Paulo – 27 A>1, significa que, em média, o jornal trata ciência e tecnologia freqüentemente na forma de editoriais, colunas ou reportagem de tamanho médio maior que a matéria geral no jornal. Figura 8. Indicador de aprofundamento Tais indicadores, como já mencionado, não somente representam instrumentos fundamentais para estudos de mídia (e podem ser facilmente adaptados para analisar não somente C&T mas qualquer tópico de interesse dentro do banco de dados), como também podem ser transformados em produtos e serviços de uso diário para empresas, instituições, jornais e profissionais interessados em um acompanhamento qualitativo de sua atuação na mídia. 4.2 Outras aplicações Um produto gerado a partir do sistema SAPO é o Índice Fapesp, projetado para permitir avaliar ao longo do tempo como a imagem pública da Fundação evolui. Enriquecendo e complementando o atual clipping organizado pela própria Fapesp, o banco de dados deste projeto permite que correlações de vários tipos sejam feitas, a critério da Fundação. Além desse, diversos outros produtos podem ser obtidos a partir do SAPO e fornecido a variados usuários, de acordo suas demandas. Por exemplo, SAPO pode ajudar em: – Avaliar e medir tendências gerais na cobertura de diferentes temáticas – Fazer análise de cobertura de casos midiáticos novos (como transgênicos, clonagem etc.); estudo da evolução temporal de uma notícia; cobertura longitudinal de temas “clássicos” (câncer, espaço, informática etc); estudo de percepção e reposta do público (por exemplo, as secções de Carta do Leitor); correlação entre tipo de cobertura de um determinado tema e outras variáveis 28 – Medir notícias sobre produtos relativos às inovações tecnológicas na indústria do entretenimento – Notícias sobre saúde e sua repercussão na sociedade – Etc. 5. Conclusões: SAPO como ajuda nos estudos de ciência na mídia Como mencionamos acima, a adaptação e aplicação do sistema para vários veículos, ou para vários idiomas, pode, além de baixar o custo de pesquisas deste tipo, permitir construir estudos transversais e longitudinais confiáveis, não sendo necessário o treinamento de novas pessoas a cada ano e a conseqüente dúvida sobre coerência e estabilidades dos protocolos de pesquisa. Obviamente, podem ser discutidos e criticados os critérios que o sistema usa para selecionar as matérias, como podem ser criticados e discutidos os de qualquer pesquisa deste tipo. Porém, vale a pena ressaltar um fato: uma vez decidido um protocolo de seleção, a vantagem de ele ser único, constante e coerente, independente do treinamento das pessoas, é bastante grande. Uma analogia pode explicar melhor a idéia. Indicadores quantitativos ligados a fenômenos sociais e culturais são sempre, obviamente, fruto de escolhas negociadas, legitimas e arbitrárias. Inventar como medir de 0 a 100 a “qualidade de vida” e comparar o número obtido no Rio de Janeiro, Calcutá, Amsterdã e Cincinnati, é claramente algo arbitrário. Vale mais pontos ter uma escola primária para cada X crianças ou um hospital cada Y habitantes? É mais negativa a poluição sonora e visual em um bairro ou a ausência de um parque público? Obviamente, tais considerações podem variar profundamente de pesquisador a pesquisador, de acordo com a situação social do país em que ele vive, com sua história, como também com suas crenças religiosas, seus valores políticos e inúmeros outros fatores, inclusive o fato de que algumas questões (riscos ambientais, por exemplo) só vem sendo discutidas (e descobertas) recentemente. Porém, a decisão negociada, conjunta, que grupos de pesquisadores podem chegar a tomar para definir indicadores como o Índice de Desenvolvimento Humano (IDH) tem sua utilidade: no momento em que todos usam o mesmo método para medir uma mesma quantidade, por arbitrária que essa seja, isso permite comparação internacional e medição de tendências de algo que, se obviamente não representa “desenvolvimento humano”, é algo que, em seu movimento ao longo de uma escala temporal e espacial, é ligado a avanços ou recuos importantes nas formas de gestão das cidades e nas condições de vida. 29 Da mesma forma, os índices que produzimos não pretendem ser um reflexo exato sobre o quanto de ciência é divulgado na mídia. Representam recorte específico, a partir de critérios discutíveis, porém fixos, que, a partir do momento em que são adotados e mensurados historicamente, adquirem sentido e passam a indicar flutuações e processos interessantes. O SAPO já se mostra um instrumento bastante valioso para a reflexão e pesquisa sobre o quanto e como ciência, tecnologia e inovação aparecem na mídia impressa. Como procuramos mostrar nesse trabalho, contudo, parece claro que alguns ajustes e evoluções possíveis do sistema aqui apontadas poderiam torna-lo um instrumento de referência para a pesquisa desses temas. Nesse sentido, dois caminhos principais podem ser apontados. O primeiro, e mais evidente, é a integração de novos veículos ao sistema, para que a amostra de pesquisa seja mais representativa e diversificada. O segundo é o uso de inteligência artificial para a seleção das matérias consideradas “de ciência”. Nesta primeira fase, optamos por utilizar um conjunto de palavras-chaves que procuramos tornar representativas de quais matérias o protocolo definido pretende selecionar. Essa tarefa foi realizada empiricamente e por aproximação, ou seja, com palavras sendo adicionadas ou retiradas de modo a que a seleção feita pudesse ser bastante próxima da seleção feita por humanos a partir do protocolo definido – o que provamos ter conseguido. Utilizando inteligência artificial, contudo, essa seleção será ainda mais precisa, pois será o padrão de escolha definido pelo protocolo que caberá à maquina repetir em sua seleção. De qualquer forma, porém, o sistema já conta com um desenvolvimento bastante maduro principalmente no que se refere ao armazenamento e qualificação das matérias inseridas (sendo isso feito de maneira automática ou manual). Isso significa um considerável ganho em termos de facilidade, agilidade e precisão para pesquisa. A informatização do corpus de análise torna possível a busca e correlação por palavras e por itens de descrição de cada matéria (como gênero, caderno etc). Além disso, torna possível a mensuração mais precisa de características medidas antes de maneira precária (o tamanho das matérias passa a ser medido por número de caracteres ou palavra e não mais por centímetro-coluna). A criação de índices, derivados de informações coletadas cotidianamente, é outra qualidade que se origina da informatização do corpus. Como mostramos, é possível gerar um conjunto muito interessante de informações estatísticas capazes de identificar “cronicidades” e “epidemias” relativas à frequência do tema CT&I na mídia. 30 6. BIBLIOGRAFIA BARDIN, L. Análise de conteúdo. Lisboa: Edições 70, 1977. BAUER, M.W.; GASKELL, G. Pesquisa qualitativa com texto, imagem e som. Um manual prático. Petrópolis, RJ: Vozes, 2002. BUCCHI, M.; MAZZOLINI, R., “Big science, little news: science coverage in the Italian daily press, 1946–1997”, Public Understanding of Science, 12, 2003; p. 7-24. CASTELFRANCHI, Y. Scientists to the streets: Science, politics and the public moving towards new osmoses. Jcom, Vol. 1, n. 2, Trieste: Junho 2002. DUTT, B.; GARG, K.C., “An overview of science and technology coverage in Indian English-language dailies”, Public Understanding of Science, 9, 2000; p. 123-140. EINSIEDEL, E, “Framing science and technology in the Canadian press”, Public Understanding of Science, 1992; p. 189-101. EISENSTEIN, E. A revolução da cultura impressa: os primórdios da Europa Moderna. São Paulo: Ática, 1998. FLICK, U. An introduction to qualitative research. Londres: SAGE Publications, 1998. GRECO P. Communicating in the post-academic era of science. Jcom, Vol. 1, n. 1, Trieste, Março 2002. Disponível em: <http://jcom.sissa.it/editorial/edit0101.pdf>. GRECO, P. “Il modello Venezia. La comunicazione nell’era post-accademica della scienza”, em: La comunicazione della scienza, Atti del I e II Convegno Nazionale, Roma: ZadigRoma, 2004 GREGORY, J., MILLER, S. Science in public. Communication, culture, and credibility. New York: Plenum Press, 1998. GUIMARÃES, E. (Org). Produção e Circulação do Conhecimento: Política, Ciência, Divulgação. Campinas, Pontes Editores: 2001 GUIMARÃES, E. (Org). Produção e Circulação do Conhecimento: Estado, Mídia e Sociedade. Campinas, Pontes Editores: 2001 HOLSTI, O.R. Content analysis for the social sciences and humanities. Reading, MA: AddisonWesley, 1969. LOMBARD, M.; SNYDER-DUCH, J.; CAMPANELLA, C. “Practical Resources for Assessing and Reporting Intercoder Reliability in Content Analysis Research Projects”, 2005. Em: http://www.temple.edu/mmc/reliability/ NELKIN, D. Selling science: How the press covers science and technology. New York: W.H. Freeman and Company, 1987. NEUENDORF, K. A. The content analysis guidebook. Thousand Oaks, CA: Sage, 2002. 31 ORLANDI, E. Análise do Discurso: princípios e procedimentos. Campinas: Pontes, 1999. POPPING, R. On agreement indices for nominal data. In Willem E. Saris & Irmtraud N. Gallhofer (Eds.). Sociometric research: Volume 1, data collection and scaling (pp. 90-105). New York: St. Martin’s Press, 1998. ROSSI, P. La nascita della scienza moderna in Europa. Roma-Bari: Laterza, 2000. SCOTT, W. Reliability of content analysis: The case of nominal scale coding. Public Opinion Quarterly, 17, 321-325, 1955. VOGT, C.; KNOBEL, M.; EVANGELISTA, R.; PALLONE, S.; CASTELFRANCHI, Y. “Percepção Pública da Ciência e Tecnologia: uma Abordagem Metodológica para São Paulo”. Em: Landi, F. (Org.). Indicadores de Ciência, Tecnologia e Inovação do Estado de São Paulo - 2004. São Paulo, FAPESP: 2005, cap. 12. VOGT, C.; MARQUES DE MELO, J.; et al. “C&T na mídia impressa brasileira: tendências evidenciadas na cobertura nacional dos jornais diários sobre ciência & tecnologia (biênio 20002001)”. Em: Guimaraes, E. (Org). Produção e Circulação do Conhecimento: Política, Ciência, Divulgação. Campinas: Pontes Editores, 2001. VOGT, C.A.: POLINO, C. (Orgs.) Percepção pública da ciência: Resultados da pesquisa na Argentina, Brasil, Espanha e Uruguai. Campinas, SP: Editora da UNICAMP; São Paulo: FAPESP, 2003. ZIMAN, J. Il lavoro dello scienziato, Roma-Bari: Laterza, 1987 (Ed. original: An introduction to science studies; The philosophical and social aspects of science and technology. Cambridge: Cambr. Univ. Press, 1984). ZIMAN, J. Real Science: What it is, and what it means. Cambridge: Cambr. Univ. Press, 2000. 32

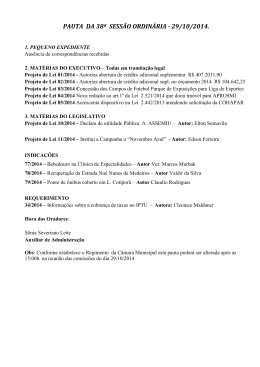

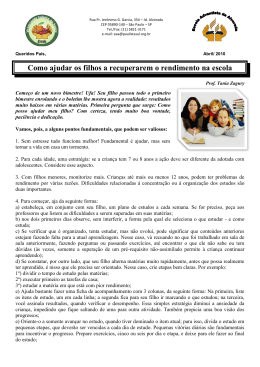

Download