MINISTÉRIO DA DEFESA

EXÉRCITO BRASILEIRO

DEPARTAMENTO DE CIÊNCIA E TECNOLOGIA

INSTITUTO MILITAR DE ENGENHARIA

CURSO DE MESTRADO EM SISTEMAS E COMPUTAÇÃO

DIEGO NASCIMENTO ESTEVES DA SILVA

PREDIÇÃO DE TENDÊNCIA DE ATIVOS EM SÉRIES FINANCEIRAS

UTILIZANDO ALGORITMOS DE APRENDIZADO DE MÁQUINA

Rio de Janeiro

2014

INSTITUTO MILITAR DE ENGENHARIA

DIEGO NASCIMENTO ESTEVES DA SILVA

PREDIÇÃO DE TENDÊNCIA DE ATIVOS EM SÉRIES

FINANCEIRAS UTILIZANDO ALGORITMOS DE

APRENDIZADO DE MÁQUINA

Dissertação de Mestrado apresentada ao Curso de

Mestrado em Sistemas e Computação do Instituto Militar de Engenharia, como requisito parcial para obtenção

do título de Mestre em Sistemas e Computação.

Orientador: Prof. Julio Cesar Duarte - D.Sc.

Rio de Janeiro

2014

c2014

INSTITUTO MILITAR DE ENGENHARIA

Praça General Tibúrcio, 80-Praia Vermelha

Rio de Janeiro-RJ CEP 22290-270

Este exemplar é de propriedade do Instituto Militar de Engenharia, que poderá incluí-lo

em base de dados, armazenar em computador, microlmar ou adotar qualquer forma de

arquivamento.

É permitida a menção, reprodução parcial ou integral e a transmissão entre bibliotecas

deste trabalho, sem modicação de seu texto, em qualquer meio que esteja ou venha a

ser xado, para pesquisa acadêmica, comentários e citações, desde que sem nalidade

comercial e que seja feita a referência bibliográca completa.

Os conceitos expressos neste trabalho são de responsabilidade do autor e do orientador.

005.1

S586p

Silva, Diego Nascimento Esteves da

Predição de tendência de ativos em séries nanceiras utilizando algoritmos de aprendizado de máquina/

Diego Nascimento Esteves da Silva, orientado por Julio

Cesar Duarte. Rio de Janeiro: Instituto Militar de

Engenharia, 2014.

123p.: il.

Dissertação (mestrado) Instituto Militar de

Engenharia Rio de Janeiro, 2014.

1. Curso de Sistemas e computação - teses e dissertações 2. Algoritmos. 3. Mercado nanceiro-Brasil.

I. Duarte, Julio Cesar. II. Título. III. Instituto Militar

de Engenharia.

CDD 005.1

2

INSTITUTO MILITAR DE ENGENHARIA

DIEGO NASCIMENTO ESTEVES DA SILVA

PREDIÇÃO DE TENDÊNCIA DE ATIVOS EM SÉRIES

FINANCEIRAS UTILIZANDO ALGORITMOS DE

APRENDIZADO DE MÁQUINA

Dissertação de Mestrado apresentada ao Curso de Mestrado em Sistemas e Computação do Instituto Militar de Engenharia, como requisito parcial para obtenção do

título de Mestre em Sistemas e Computação.

Orientador: Prof. Julio Cesar Duarte - D.Sc.

Aprovada em 09 de Junho de 2014 pela seguinte Banca Examinadora:

Prof. Julio Cesar Duarte - D.Sc. do IME - Presidente

Prof. Anderson Fernandes Pereira dos Santos - D.Sc. do IME

Prof. Leandro Guimarães Marques Alvim - D.Sc. da UFRRJ

Rio de Janeiro

2014

3

Dedico este trabalho à minha irmã, Luane Nascimento Esteves da Silva (in memorian ).

4

AGRADECIMENTOS

À Deus, por estar comigo em todos os momentos da minha vida.

Ao meu professor e orientador Major Julio Cesar Duarte, por toda a dedicação, sabedoria, motivação e valiosos ensinamentos que me tornaram uma pessoa melhor e contribuíram diretamente no desenvolvimento deste trabalho.

À minha professora Maria Claudia Reis Cavalcanti (Yoko ), pelo apoio, incentivo e

grande oportunidade de prosseguir com a pesquisa.

Ao meus professores do CEFET-RJ, Eduardo Bezerra da Silva e Jorge de Abreu Soares, pelo apoio e incentivo direto, fundamental para que mais esta etapa fosse concluída.

Aos meus pais, Maria de Lourdes N. Esteves da Silva e Nelson Esteves da Silva, por

todo apoio, carinho e amor. À vocês que sempre me estimularam, me inspiraram a novas

conquistas e incentivaram-me a prosseguir sem medo em todas as etapas da vida.

A minha irmã, Luane N. Esteves da Silva, que mudou toda a minha vida e me ensinou

valores que jamais poderei aprender em lugar algum. Sua passagem foi a maior alegria

que nossa família poderia ter. "Você sempre estará comigo".

À Bruno Mesquita Amaral, por ser um verdadeiro irmão de coração.

À Josumar Amaral e Liliane Mesquita, por terem me abraçado como um lho desde

o início, por darem suporte incondicional a mim e minha esposa em todas as situações.

Por fazerem eu sempre me sentir amado como um lho. Serei eternamente grato.

Finalmente à minha eterna esposa, Bianca Mesquita Amaral Esteves, que sempre

esteve ao meu lado durante os últimos 10 anos, por todo amor, carinho, apoio e palavras

de força e por ser, desde o início, a maior incentivadora desta conquista.

Diego Nascimento Esteves da Silva

5

Todas as vitórias ocultam uma abdicação.

Simone de Beauvoir

6

SUMÁRIO

LISTA DE ILUSTRAÇÕES . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9

LISTA DE TABELAS . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

11

LISTA DE ABREVIATURAS . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

14

1

INTRODUÇÃO

..................................................

17

1.1

Motivação . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

17

1.2

Objetivo . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

18

1.3

Justicativa . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

19

1.4

Metodologia . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

19

1.5

Estrutura da Dissertação . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

22

2

APRENDIZADO DE MÁQUINA

................................

23

2.1

Tipos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

24

2.2

O processo de Indução de uma Hipótese . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

26

2.3

Subajuste(Undertting) e Superajuste(Overtting) . . . . . . . . . . . . . . . . . . . . . . .

27

2.4

Métodos de amostragem . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

28

2.4.1 Retenção (Holdout ) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

29

2.4.2 Amostra Aleatória (Random Subsampling ) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

29

2.4.3 K-partições (K-fold ) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

29

2.4.4 Deixando um fora (Leave-One-Out ) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

30

2.4.5 Estraticada (Stratied ) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

30

2.5

Avaliação de Modelos de Classicação . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

30

2.5.1 Matriz de Confusão . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

30

2.5.2 Análise ROC . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

33

2.6

Naive Bayes . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

34

2.7

Regressão Logística . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

36

2.8

Máquinas de Vetores de Suporte (Support Vector Machine ) . . . . . . . . . . . . . . .

37

2.8.1 Teoria do Aprendizado Estatístico . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

38

2.8.2 Limite do Risco Esperado . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

39

2.8.3 Risco Marginal . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

40

7

2.8.4 SVM lineares de margens rígidas (hard margin ) . . . . . . . . . . . . . . . . . . . . . . . . .

41

2.8.5 SVM lineares de margens suaves (soft margin ) . . . . . . . . . . . . . . . . . . . . . . . . . .

42

2.8.6 SVM não-lineares . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

43

3

REVISÃO DA LITERATURA

...................................

45

3.1

Trabalhos na área . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

46

3.2

Trabalhos Relacionados . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

49

3.3

Tendências . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

50

4

MODELAGEM PARA O PROBLEMA DE PREVISÃO DE TENDÊNCIAS EM SÉRIES FINANCEIRAS . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 60

4.1

Arquitetura da Solução . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

60

4.2

Pre-processamento . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

65

4.3

Sistema de Referência (Baseline System ) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

67

4.4

Naive Bayes . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

67

4.5

Regressão Logística . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

70

4.6

Máquina de Vetores de Suporte (Support Vector Machine) . . . . . . . . . . . . . . . .

71

5

EXPERIMENTOS

...............................................

73

5.1

Análise dos resultados . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

73

5.1.1 Exp01 - Parâmetros do modelo . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

73

5.1.2 Exp02 - Período de treinamento . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

81

5.1.3 Exp03 - SVM - implementações . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

87

5.1.4 Exp04 - SVM - kernels . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

90

5.1.5 Exp05 - Validação cruzada deslizante - parâmetro . . . . . . . . . . . . . . . . . . . . . . .

93

5.1.6 Exp06 - Modelos híbridos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

95

6

CONCLUSÕES

7

REFERÊNCIAS BIBLIOGRÁFICAS

8

ANEXOS

8.1

Codigos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 112

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 104

. . . . . . . . . . . . . . . . . . . . . . . . . . . 107

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 111

8

LISTA DE ILUSTRAÇÕES

FIG.1.1

PETR4 - Comparação dos resultados dos modelos de diferentes

algoritmos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 21

FIG.1.2

Validação cruzada deslizante em função do tempo com 24 dias de

treino . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 22

FIG.2.1

Hierarquia do Aprendizado Indutivo . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

24

FIG.2.2

Fluxo Básico do Aprendizado Supervisionado para um Classicador . . . .

26

FIG.2.3

Exemplos de overtting e undertting (Adaptado de SMOLA e

SCHOLKOPF, 2002) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 28

FIG.2.4

Análise ROC . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

34

FIG.2.5

Exemplo de limiar logístico (a) x linear (b) . . . . . . . . . . . . . . . . . . . . . . . . .

36

FIG.2.6

Exemplo de classicação SVM - SV com margens rígidas . . . . . . . . . . . . .

42

FIG.2.7

Exemplo de classicação SVM - SV com margens suaves . . . . . . . . . . . . . .

43

FIG.2.8

Exemplo de dados não lineares . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

44

FIG.4.1

Visão geral da arquitetura proposta . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

60

FIG.4.2

Modelo de dados . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

62

FIG.4.3

Vetor auxiliar de cálculo (média e desvio) . . . . . . . . . . . . . . . . . . . . . . . . . .

68

FIG.5.1

Série histórica nanceira (2006) com valores diários de fechamento

das ações América Latina Logística (ALLL11), Companhia Siderúrgica Nacional (CSNA3), Eletrobras (ELET6) e Petrobras (PETR4)

no período entre 01 de Janeiro a 30 de Setembro de 2006.

. . . . . . . . . . . 74

FIG.5.2

Resultados da América Latina Logística (ALLL11) em G1, G2 e G3 . . . .

FIG.5.3

Resultados da Companhia Siderúrgica Nacional (CSNA3) em G1,

75

G2 e G3 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 76

FIG.5.4

Resultados da Eletrobras (ELET6) em G1, G2 e G3 . . . . . . . . . . . . . . . . .

77

FIG.5.5

Resultados da Petrobras (PETR4) em G1, G2 e G3 . . . . . . . . . . . . . . . . . .

78

FIG.5.6

Melhores e piores (por defasagem) resultados dos algoritmos agrupados em função do grupo de experimento e ações . . . . . . . . . . . . . . . . . . 79

FIG.5.7

Melhores resultados da Petrobras (PETR4) em diferentes tamanhos

de amostras de treinamento . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 83

9

FIG.5.8

Melhores resultados da Petrobras (PETR4) em diferentes tamanhos

de amostras de treinamento . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 84

FIG.5.9

Melhores resultados da Petrobras (PETR4) em diferentes tamanhos

de amostras de treinamento . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 85

FIG.5.10 Melhores resultados da Petrobras (PETR4) em diferentes tamanhos

de amostras de treinamento . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 86

10

LISTA DE TABELAS

TAB.1.1

PETR4 - Exemplo de dataset simples . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

20

TAB.2.1

Descrição da hierarquia do aprendizado indutivo . . . . . . . . . . . . . . . . . . . .

25

TAB.2.2

Matriz de confusão para um problema binário . . . . . . . . . . . . . . . . . . . . . . .

31

TAB.2.3

Principais kernels utilizados . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

44

TAB.3.1

Principais focos de previsão nanceira . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

46

TAB.3.2

Impacto dos parâmetros livres nos problemas de undert e overt

(TAY, 2001a) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

47

TAB.3.3

resumo dos trabalhos relacionados . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

51

TAB.3.4

Parametrização nos trabalhos relacionados . . . . . . . . . . . . . . . . . . . . . . . . . .

54

TAB.4.1

Série histórica nanceira obtida . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

63

TAB.4.2

Estrutura parcial da tabela cotacoes . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

63

TAB.4.3

Estrutura da tabela execution_group_user_description . . . . . . . . . . . . . .

64

TAB.4.4

Estrutura da tabela ibovespa . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

64

TAB.4.5

Estrutura da tabela releases . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

64

TAB.4.6

Estrutura parcial da tabela results . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

65

TAB.4.7

Representação para dados discretizados em 3 dias . . . . . . . . . . . . . . . . . . .

66

TAB.5.1

Totais de melhores resultados dos algoritmos agrupados em função

do grupo de experimento. G1 apresentando melhores resultados. . . . . . .

TAB.5.2

79

Totais de piores resultados dos algoritmos agrupados em função do

grupo de experimento. G1 apresentando melhores resultados. . . . . . . . . .

80

TAB.5.3

Experimentos com diferentes tamanhos de amostras . . . . . . . . . . . . . . . . .

81

TAB.5.4

Períodos com melhores taxas de acertos por ação . . . . . . . . . . . . . . . . . . . .

87

TAB.5.5

Amostras utilizadas para análise das implementações de SVM: CSVC e nu -SVC, considerando melhores períodos por ações . . . . . . . . . . . .

TAB.5.6

Amostras utilizadas para análise das implementações de SVM: CSVC e nu -SVC . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

TAB.5.7

88

89

Amostras utilizadas para análise do kernel Linear. Conforme esperado, resultados abaixo dos melhores cenários obtidos com uso

do kernel RBF . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

11

90

TAB.5.8

Amostras utilizadas para análise do kernel RBF . . . . . . . . . . . . . . . . . . . . .

91

TAB.5.9

Amostras utilizadas para análise do kernel Sigmoid . . . . . . . . . . . . . . . . . .

92

TAB.5.10 Amostras utilizadas para análise do kernel Polinomial . . . . . . . . . . . . . . . .

93

TAB.5.11 Bons resultados para modelos retreinados em função do tempo com

validação cruzada deslizante . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

94

TAB.5.12 Amostras utilizadas para análise do modelo híbrido da ação ALLL11.

96

TAB.5.13 Análise do desempenho do modelo híbrido da ação ALLL11 . . . . . . . . . . .

98

TAB.5.14 Amostras utilizadas para análise do modelo híbrido da ação CSNA3 . . .

98

TAB.5.15 Análise do desempenho do modelo híbrido da ação CSNA3 . . . . . . . . . . . 100

TAB.5.16 Amostras utilizadas para análise do modelo híbrido da ação PETR4 . . . 100

TAB.5.17 Análise do desempenho do modelo híbrido da ação PETR4 . . . . . . . . . . . 101

TAB.5.18 Amostras utilizadas para análise do modelo híbrido da ação ELET6 . . . 101

TAB.5.19 Análise do desempenho do modelo híbrido da ação ELET6 . . . . . . . . . . . 103

12

LISTA DE ALGORITMOS

1

Método do Gradiente Descendente (versão para minimização) . . . . . . . . . . .

37

2

principal . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

61

3

Classicador BLS . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

67

4

Treinador Naive Bayes . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

69

5

Classicador Naive Bayes . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

70

6

Treinador Regressão Logística . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

71

7

Classicador Regressão Logística . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

71

8

Transformação SVM . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

72

9

Classicação SVM . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

72

10

Regra de previsão do modelo híbrido composto por NB, RL e SVM

para ação ALLL11 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

11

Regra de previsão do modelo híbrido composto por NB, RL e SVM

para ação CSNA3 e PETR4. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

12

97

99

Regra de previsão do modelo híbrido composto por NB e SVM para

ação ELET6 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 102

13

LISTA DE ABREVIATURAS

AM

-

Aprendizado de Máquina

BLS

-

Sistema de Referência (Baseline System )

BOVESPA

-

Bolsa de Valores de São Paulo

FAMA

-

Framework de Aprendizado de Máquina

IME

-

Instituto Militar de Engenharia

NB

-

Naive Bayes

RL

-

Regressão Logística

SVM

-

Máquina de Vetores de Suporte (Support Vector Machines)

TAE

-

Teoria do Aprendizado Estatístico

14

RESUMO

Prever o comportamento de ativos nanceiros é um desao que vem sendo estudado

com diversas técnicas nos últimos anos, seja por modelos de regressão ou de classicação.

Apesar da grande quantidade de pesquisas acadêmicas, antecipar o movimento do preço

nal de um ativo ainda é um desao a ser superado. A maior diculdade está no comportamento não-linear e não estacionário das séries temporais nanceiras, assim como toda

incerteza e ruídos encontrados no mercado nanceiro.

Este trabalho foca em encontrar tendências para os preços de ações do mercado

Brasileiro em determinados períodos de tempo e abrange o estudo do comportamento

de três algoritmos de aprendizado de máquina, Naive Bayes (NB), Regressão Logística

(RL) e Support Vector Machines (SVM) aplicados a dados históricos de séries nanceiras.

O comportamento foi comparado com um algoritmo base (Baseline - BLS) criado para

ser o limite inferior de qualidade para os modelos gerados.

Como apresentado em estudos similares da área, o algoritmo SVM apresentou melhores resultados que os algoritmos comparados nesse estudo. Uma análise detalhada mostra

que o ajuste de parâmetros traz benefícios para o resultado dos modelos, com ganhos de

até 32%. A biblioteca LibSVM foi integrada ao framework FAMA, ambos disponíveis

livremente.

A m de obter modelos com maior capacidade de generalização, foi alterado o comportamento do método de validação cruzada padrão para se ajustar as características do

problema, tornando-a deslizante em função do tempo. Observou-se que retreinar o modelo em determinado período de tempo melhora positivamente a taxa de acerto quando

comparado ao modelo de validação cruzada padrão.

15

ABSTRACT

Predict the behavior of nancial assets is a challenge that has been studied with

various techniques in recent years, either regression or classication models . Despite the

large amount of academic research, anticipate the movement of the nal price of an asset

is still a challenge to be overcome . The main diculty is nonlinear and non-stationary

behavior of nancial time series, as well as all uncertainty and noise found in the nancial

market.

This work focuses on nding stock price trends in the Brazilian market in certain

periods of time and covers the study of the behavior of three machine learning algorithms,

Naive Bayes (NB), Logistic Regression (LR) and Support Vector Machines (SVM) applied

to historical data for nancial time series. The behavior was compared with a basic

algorithm (Baseline - BLS) developed as a lower limit of quality for models generated.

As shown in similar studies in the area, the SVM algorithm outperforms the others

algorithms compared in this study. A detailed analysis shows that the parameter setting

has benets for the outcome of the models, overcoming with up to 32% . The LIBSVM library has been integrated into the FAMA framework, both available as opensource

distribution.

In order to obtain models with larger capacity of generalization, the default behavior of the cross-validation method has been changed to adjust the characteristics of the

problem, making it slide on time's period. It was shown that retrain the model in a

given period of time positively improves the hit rate when compared to the standard

cross-validation model.

16

1 INTRODUÇÃO

O mercado nanceiro é composto por diversos tipos de investidores, com diversos

graus de experiência acerca das particularidades de cada ativo nanceiro. Apesar da heterogeneidade, antecipar a direção de ativos nanceiros (tendências de alta no preço de

fechamento do ativo ou tendências de baixa, de curto, médio ou longo prazo) ainda é um

desao a ser superado. Prever esse comportamento é uma tarefa que vem sendo estudada

por meio de diversas técnicas nos últimos anos, sejam elas por meio de análise técnica,

fundamentalistas ou ainda utilizando modelos computacionais (de regressão ou de classicação). Apesar da grande quantidade de pesquisas sobre o assunto (ATSALAKIS, 2009),

ainda não foi possível gerar modelos com uma alta taxa de acertos. A maior diculdade

em realizar essa tarefa está no comportamento não linear e não estacionário das séries

temporais nanceiras assim como toda a incerteza e ruídos encontradas nos dados, dicultando bastante a descoberta de padrões de predição. Essas características sugerem

ainda que não há informação completa que pode ser obtida do passado para capturar

completamente a dependência entre o passado e o futuro (o preço de fechamento do ativo,

por exemplo), divergindo parcialmente da Hipótese do Mercado Eciente (GRANGER,

1992) (ALLAN, 2004) (ALDRIGHI, 2005), que sugere o valor de um ativo é ajustado

sem atraso para reetir toda informação pública disponível, não sendo possível realizar

lucro excessivo. Fatores Econômicos (índices da economia de uma País ou região), Institucionais (informações econômicas de empresas privadas ou públicas) ou ainda Sociais

(determinada sociologia econômica) não são modeladas nesta pesquisa, que tem foco no

comportamento dos algoritmos de Aprendizado de Máquina (AM) aplicados a dados de

séries históricas nanceiras. Neste trabalho foram estudados algoritmos de aprendizado

supervisionado para induzir modelos preditivos que apresentem boa taxa de acurácia em

tarefas de classicação de ativos nanceiros, servindo como base para a tomada de decisão

de investidores.

1.1

MOTIVAÇÃO

Apesar dos bons resultados encontrados em estudos recentes na área (HUANG, 2005),

(PHICHHANG, 2009), (ZHONGYUAN, 2012), (SHEN, 2012), (KARAZMODEH, 2013),

17

(ALVIM, 2013), (WANG, 2013), o desao de encontrar modelos com boa capacidade de

generalização com dados atuais ainda está em aberto, seja para previsão de tendências

para indicadores nanceiros ou ações da bolsa de valores. Principalmente quando são

utilizados modelos gerados com o algoritmo SVM, onde são obtidos excelentes resultados

para a base de treinamento, que não se repetem quando o modelo é aplicado a novos

dados, evidenciando o problema de superajuste comumente encontrado em tarefas de

Aprendizado de Máquina (TAY, 2001b), (TAY, 2001a), (TAY, 2002), (TAY, 2003).

Em pesquisas com foco de maximização do investimento são encontrados bons modelos como ferramentas de apoio a decisão, apesar de pontos importantes ainda estarem em

aberto. (GOMIDE, 2011) propôs uma técnica de seleção de carteira baseada em Pairs

Trading 1 que apresenta bons resultados. (ALVIM, 2013) propôs um modelo baseado na

construção de estratégias multirresolução2 , a partir da resolução do problema de Agendamento de Intervalos Ponderados, alcançando um lucro médio anual de 77%, que representa

um excelente retorno nanceiro. A modelagem proposta é aplicada com valores de investimento superiores a R$ 50.000,00.

Outro foco de previsão no mercado nanceiro se dá para tendências de ações da Bolsa

de Valores. Em (ESTEVES, 2013) foi observado que o ajuste dos parâmetros do algoritmo SVM aplicados a uma tarefa de treinamento deslizante em relação ao tempo gera

melhores resultados na previsão da tendência da ações da Bolsa de Valores de São Paulo

(BOVESPA). O foco da pesquisa também se torna interessante por haver poucos trabalhos publicados nesta área para ativos do mercado nanceiro do Brasil (MARTINEZ,

2009), (ALVIM, 2010), (ALVIM, 2013).

1.2

OBJETIVO

O objetivo do estudo é voltado para análise de comportamento dos algoritmos de aprendizado de máquina aplicados em séries temporais nanceiras. O trabalho será focado

em realizar um estudo comparativo entre os algoritmos e entre trabalhos relacionados,

desenvolvendo um método computacional que possa ser usado como base para predição

1 Basicamente

pode ser denida como uma operação baseada em uma taxa calculada entre duas ações

(spread ), que normalmente reetem o mesmo fundamento econômico. Quando esta taxa oscila em determinado valor, sugere uma boa oportunidade de lucro através de uma operação casada de venda de um

dos ativos e compra de outro.

2 Uma estratégia que opera em diferentes escalas de tempo

18

de tendências de ativos nanceiros (ações), além de desenvolver um modelo público de

tratamento de séries históricas nanceiras e colaborar com futuras pesquisas, integrando

a biblioteca LibSVM (CHANG, 2011) com o framework opensource de aprendizado de

máquina FAMA(FAMA, 2012).

1.3

JUSTIFICATIVA

Para operar no mercado nanceiro com realização de lucro é muito importante obter

subsídios para tomada de decisão. Esses subsídios podem ser traduzidos em informações

provenientes de especialistas de domínio (analistas nanceiros) ou ainda de softwares

com inteligência computacional capaz de antecipar o movimento dos íncides. Dada a

característica do mercado nanceiro, o risco envolvido na tomada de decisão é grande e

pode gerar perdas nanceiras consideráveis. Este trabalho estuda o comportamento de

certos algoritmos de aprendizado de máquina para desenvolver uma metodologia que possa

servir de base para construção de sistemas complexos para a tomada de decisão, usando

como nível inferior o classicador BLS, que simula o comportamento de um investidor

sem conhecimento de mercado nanceiro.

1.4

METODOLOGIA

Este estudo busca desenvolver uma plataforma para a análise do comportamento dos

ativos quando submetidos a dados encontrados nas séries temporais nanceiras, através

da predição da tendência do ativo, que representa a classe alvo do problema. Deni-se

a classe como "positiva" quando a variação do preço é positiva ou nula, ou seja, quando

o preço de fechamento atual é igual ou superior ao preço de fechamento anterior. Na

situação inversa, a classe é denida como "negativa".

Após a extração das informações dos preços dos ativos (obtidas diretamente do site

da Bovespa), é realizado o pré-processamento dos dados. Essa tarefa consiste em algumas

etapas, como a escolha dos atributos de entrada do modelo, na exclusão de outliers,

gerados pelo processo de desdobramento 3 e agrupamento 4 da série e a transformação dos

3 estratégia

de companhias para melhorar a liquidez de um ativo nanceiro. Ocorre quando o valor da

ação está muito acima, dicultando a transação nanceira

4 representa o processo inverso ao desdobramento e é realizado para melhorar a liquidez de um papel.

Quando o preço está muito abaixo, qualquer alteração menor pode signicar uma variação grande.

19

valores para um domínio de valores que não privilegie alguns destes, além de facilitar a

execução de certos cálculos matemáticos. (MANCUSO, 2013)

De acordo com estudos realizados em (ESTEVES, 2013) foi vericado que os algoritmos

geravam modelos com acurácia maior quando submetidos a determinados períodos de

treinamento, que variavam em função do tempo. Apesar da melhora considerável na taxa

de acertos da tendência futura para este método deslizante de validação cruzada (sliding

cross-validation ), serão detalhadas as variações deste parâmetro na tarefa de classicação.

Toda informação foi mantida em banco de dados relacional. Um serviço consulta

essas informações e transforma os parâmetros e entrada escolhidos em determinada série

temporal para o formato de arquivos do FAMA.

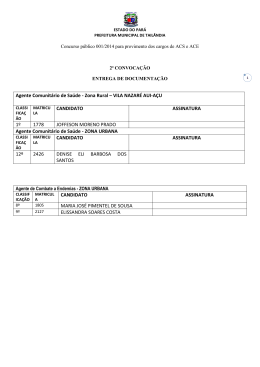

TAB. 1.1: PETR4 - Exemplo de dataset simples

preabe premax premin preult qtd

21,09

21,49

21,26

21,27

21,10

21,40

21,12

21,86

21,49

21,57

21,26

21,52

21,49

21,39

21,49

21,51

21,53

21,88

21,71

21,60

20,90

21,10

21,26

21,03

21,05

21,14

21,03

21,16

21,40

21,32

21,04

21,21

21,34

21,37

21,23

21,28

21,49

21,24

21,58

21,55

15,423,600

19,397,900

12,603,500

14,738,800

23,325,800

17,024,700

21,066,100

30,343,800

31,775,700

17,723,400

d-1

0,00

0,17

0,13

0,03

-0,14

0,05

0,21

-0,25

0,34

-0,03

d-2

0,00

0,00

0,17

0,13

0,03

-0,14

0,05

0,21

-0,25

0,34

d-3

0,00

0,00

0,00

0,17

0,13

0,03

-0,14

0,05

0,21

-0,25

y

+1

-1

+1

-1

+1

-1

+1

-1

+1

+1

Após a extração e transformação dos dados disponíveis, foram realizados estudos com

relação ao impacto dos atributos de entrada do modelo, além de ajustes nos parâmetros

de conguração.

A tabela 1.1 mostra um exemplo simples de dataset do ativo PETR4 como parâmetro

de entrada para o FAMA (preço de abertura, preço máximo no dia, preço mínimo no

dia, preço de fechamento, quantidade de ações negociadas, diferença de 1 dia, diferença

de 2 dias, diferença de 3 dias e classe alvo, respectivamente). Essa estrutura de dados é

utilizada no treinamento de diferentes modelos, utilizando cada um os algoritmos BLS,

Naive Bayes, Regressão Logística e Support Vector Machines.

Como limite inferior da análise foi considerado o algoritmo BLS, que representa uma

20

implementação de lógica simples para prever a tendência de um ativo, considerando apenas o dia anterior como parâmetro. Em sua lógica estima que o preço futuro seguirá a

tendência passada. Em uma série nanceira com informações diárias, isto signica que o

preço de fechamento de amanhã será positivo, se o preço de fechamento atual for positivo

(Cópia Carbono). A este baseline foi comparado o resultado dos outros algoritmos para

tentar encontrar um especialista em cada ativo, ou em grupos de ativos (normalmente

ativos do mesmo setor econômico ou empresas de porte similar).

A gura 1.1 mostra a comparação entre os algoritmos durante a fase de treinamento.

FIG. 1.1: PETR4 - Comparação dos resultados dos modelos de diferentes algoritmos

Melhores resultados foram obtidos com modelos retreinados em função do tempo, evidenciando o peso maior dos dias anteriores mais próximos. Para isso, alteramos o método

leave-one-out (seção 2.4.4) para deslizar em função do tempo e considerar determinada

janela na fase de indução da hipótese.

21

FIG. 1.2: Validação cruzada deslizante em função do tempo com 24 dias de treino

Para a implementação do algoritmo SVM, foi desenvolvida uma interface com a biblioteca LibSVM (CHANG, 2011) para integração ao FAMA (FAMA, 2012).

1.5

ESTRUTURA DA DISSERTAÇÃO

Esta dissertação está organizada da seguinte forma: no capítulo 2 serão apresentados os

principais conceitos a respeito do tema Aprendizado de Máquina, bem como os principais

algoritmos utilizados. No capítulo 3, será discutido o problema de predição de ativos, enfatizando nos trabalho relacionados. No capítulo 4, será discutida a modelagem utilizada

neste trabalho para a resolução do problema proposto. No capítulo 5, serão realizadas

as análises dos experimentos propostos. No capítulo 6, serão realizadas as considerações

nais e apresentadas sugestões de trabalhos futuros. O capítulo 7 contém as referências

bibliográcas utilizadas como base neste trabalho. Por m, o capítulo 8 apresentará nos

anexos os scripts de banco de dados utilizados neste trabalho.

22

2 APRENDIZADO DE MÁQUINA

Inicialmente vista como uma área teórica, o ramo de Inteligência Articial alavancou

pesquisas com bons resultados nas últimas décadas. No início dos anos de 1970, começou a

ser observado o desenvolvimento de programas que buscavam resolver problemas reais por

meio da informação de especialistas, e não somente a resolução de uma cadeia de regras

bem-denidas que buscava seguir o uxo de uma lógica compilada em um algoritmo. Esses

programas eram conhecidos como Sistemas Especialistas e buscavam extrair as regras para

auxiliar à tomada de decisão.

Recentemente, com a crescente complexidade dos problemas a serem solucionados e o

aumento gradativo da quantidade de informação disponível, tornou-se clara a necessidade

de ferramentas mais sosticadas e inteligentes, que fossem adaptáveis à novas situações

e apresentassem menor intervenção humana. Essa técnica deveria ser capaz de extrair

conhecimento da experiência passada para gerar modelos computacionais capazes de lidar

com novas situações de maneira inteligente.

Um entendimento detalhado dos modelos computacionais gerados pelos algoritmos de

aprendizado de máquina poderiam, então, lidar melhor com situações especícas do que

a capacidade humana em resolver determinadas situações.

Aprendizado de Máquina é o ramo da Inteligência Articial que tem como principal

objetivo aprender a reconhecer padrões complexos e tomar decisões baseada em eventos,

dados, históricos. É o processo de indução de uma função ou hipótese a partir de uma

experiência passada (Machine Learning ). Basicamente, permite à máquina a capacidade

de aprender sem ser explicitamente programada para tal tarefa. A ideia básica por trás

disso é baseada pela forma de representar e à capacidade de generalização de um modelo.

De acordo com (MITCHELL, 1997) pode-se denir Aprendizado de Máquina como:

"A capacidade de melhorar o desempenho na realização de alguma tarefa por meio de

experiência.".

Outra denição recente proposta por (FACELI, 2011):

"O processo de indução de uma hipótese, ou aproximação de uma função, a partir da

experiência."

Na tentativa de gerar modelos cada vez mais próximos (ou superiores) a resultados

23

obtidos por especialistas, diversos algoritmos tem sido propostos, assim como suas variações.

2.1

TIPOS

Algoritmos de Aprendizado de Máquina podem ser classicados em grupos, de acordo com

o problema a ser tratado. Conceitualmente são organizados em dois grupos primários:

Tarefas Preditivas, ou Aprendizado Supervisionado (quando se conhece a saída de determinada instância a ser classicada) e Tarefas Descritivas ou Aprendizado não-supervisionado

(quando não se conhece a saída de determinada instância a ser classicada)(FACELI,

2011).

Nas tarefas de previsão, diz-se que o aprendizado é supervisionado porque o algoritmo

conhece a saída de cada exemplo, normalmente denida por um especialista, no conjunto

de dados. Este induz modelos preditivos (ou hipóteses) a m de prever um rótulo ou valor

que caracterize um novo exemplo, baseado em seus atributos de entrada.

Nas tarefas de descrição, a meta é descrever um determinado conjunto de dados.

Nesse cenário não são usados exemplos rotulados (ou seja, não se conhece os valores dos

elementos de saída para cada exemplo no conjunto de dados), seguindo o paradigma de

aprendizado não-supervisionado. Um exemplo simples seria o agrupamento de exemplos

de um conjunto de dados por semelhança ou ainda extrair regras de associação entre

objetos.

A gura 2.1 apresenta a estrutura do aprendizado, proposta por (MONARD, 2003).

FIG. 2.1: Hierarquia do Aprendizado Indutivo

A raiz da árvore representa o aprendizado indutivo, característica padrão em todas as

24

tarefas de aprendizado de máquina, que busca generalizações a partir do conjunto de dados. Abaixo há duas estruturas, uma representando o aprendizado supervisionado e outra

representando o não-supervisionado. As tarefas supervisionadas se concentram em problemas de classicação e de regressão. As tarefas não supervisionadas se concentram em

problemas de agrupamento, de associação ou ainda de sumarização. A tabela 2.1 resume

a hierarquia sugerida, apesar de não separar cada denição deste nos modelos propostos,

uma vez que um modelo descritivo também pode ser usado para realizar previsões.

TAB. 2.1: Descrição da hierarquia do aprendizado indutivo

subtarefa

Classicação

Regressão

Agrupamento

Associação

Sumarização

Por Esforço

característica

Dados discretos (Modelo Preditivo)

Dados contínuos (Modelo Preditivo)

Dados agrupados de acordo com similaridade (Modelo descritivo)

Padrões frequentes de associação

(Modelo descritivo)

Descrição simples para um conjunto de

dados (Modelo descritivo)

Reforçar uma ação positiva e punir uma

ação negativa (Modelo descritivo)

O foco neste trabalho é no aprendizado supervisionado para gerar modelos de previsão

que classicam ativos nanceiros em duas classes: valorização ou desvalorização de um

ativo em um período de tempo.

O aprendizado supervisionado contempla um conjunto de exemplos rotulados (Xi , yi ),

onde Xi representa o conjunto de atributos do exemplo xi e yi representa a saída esperada

para o i-ésimo exemplo x.

Ao processo de induzir um modelo a partir de um conjunto de exemplos rotulados, é

conhecido como treinamento (MONARD, 2003).

Os rótulos são as saídas desejadas (classes) e os valores que eles assumem caracterizam

o tipo de problema, conforme detalhado na tabela 2.1

A arquitetura geral consiste num conjunto de atributos (características do problema),

representado por um vetor de entrada, onde cada atributo expressa um determinado aspecto do modelo de dados. Resumidamente essas características podem ser divididas em

dois tipos básicos de variáveis: quantitativas (discretas ou contínuas) e qualitativas (nom25

inais ou ordinais). Uma característica, representada por uma variável, é dita quantitativa

quando pode ser medida em uma escala innita de valores. Uma característica representada por uma variável é dita qualitativa (ou ainda categórica) quando é denida por

categorias nitas que representam classicações.

A gura 2.2 exemplica o uxo básico do aprendizado supervisionado para um classicador. Os dados coletados (a) são tratados a m de gerar o vetor de entrada para o

algoritmo, contendo as características e a classe associada ao exemplo (b). Nesta etapa,

exemplos que não são comuns ao cenário estudado (outliers ) são retirados da amostra

e as variáveis continuas são ajustadas para otimizar o processo de cálculo, além de não

privilegiar certos valores (scaling ) (c). Na fase de treinamento, é realizada a indução de

uma hipótese (d), gerando um classicador (e). Após essa fase, o classicador é avaliado

(comparando os rótulos conhecidos com os gerados) (f) a m de gerar as métricas do

modelo proposto (g).

FIG. 2.2: Fluxo Básico do Aprendizado Supervisionado para um Classicador

2.2

O PROCESSO DE INDUÇÃO DE UMA HIPÓTESE

O processo de indução de uma hipótese, etapa fundamental para algoritmos de aprendizado de máquina, parte da análise de um conjunto de dados selecionados. Dessa amostra

26

de dados são extraídas informações a partir dos atributos de entrada de cada exemplo.

O objetivo do algoritmo é aprender (desconsiderando corretamente os ruídos presentes)

a partir de um subconjunto de dados, denominado conjunto de treinamento, e gerar um

modelo ou hipótese capaz de associar corretamente os dados contidos no conjunto de

entrada ao valor do seu atributo de saída.

O objetivo é deduzir corretamente o valor da variável de saída para determinado exemplo de um novo conjunto de dados através da indução da hipótese gerada pelo processo

de treinamento do algoritmo. A essa propriedade é dado o nome de capacidade de generalização da hipótese. Espera-se que o algoritmo encontre boa capacidade de generalização,

podendo então tornar-se útil, quando submetido a novas instâncias.

2.3

SUBAJUSTE(UNDERFITTING) E SUPERAJUSTE(OVERFITTING)

Pode-se vericar dois problemas comuns a esta fase, ambos retratando extremos no

processo de geração do modelo, ou seja, modelos super-ajustados (overtting ) ou subajustados (undertting ) ao conjunto de treinamento.

A gura 2.3(a) exemplica o problema de overtting, quando no processo de treinamento, o classicador gerado consegue prever corretamente todos os exemplos da amostra,

inclusive possíveis ruídos. Esse ajuste excessivo que o algoritmo produz ao conjunto de

dados de treinamento acaba gerando um modelo ruim, normalmente com baixa taxa de

acerto quando submetido a novas instâncias.

No caso extremo oposto, conhecido como undertting, o algoritmo apresenta uma baixa

taxa de acertos (gura 2.3(b)), mesmo na fase de treinamento, caracterizando o subajustamento aos dados. Isto comumente ocorre quando os exemplos são pouco representativos

ou o modelo usado é muito simples e não consegue capturar os padrões existentes nos

dados apresentados ou ainda quando o número de exemplos é insuciente (MONARD,

2003).

A situação mais próxima do desejado é representada pela gura 2.3(c), onde tem-se

um classicador que acerta a maior parte das predições, sem se ater a exemplos muito

fora da curva.

27

FIG. 2.3: Exemplos de overtting e undertting (Adaptado de SMOLA e SCHOLKOPF,

2002)

2.4

MÉTODOS DE AMOSTRAGEM

Existem duas formas básicas de avaliar o desempenho do modelo gerado, classicando-o

com os mesmos dados utilizados no treinamento ou submetendo-o a um novo conjunto

de dados. O primeiro método, chamado de Ressubstituição (TOUSSAINT, 1974), fornece

uma medida de desempenho falsa e muito otimista, uma vez que os algoritmos tendem a

gerar um modelo super-ajustado aos dados durante a fase indutiva. Em geral o erro/acerto

obtido nesse tipo de avaliação é denominado aparente.

Para garantir que o algoritmo seja o mais genérico possível, é importante que algum

método de validação seja aplicado utilizando uma nova amostra, exclusiva aos exemplos

utilizados na fase de treinamento (MONARD, 2003). Os exemplos de treinamento são

empregados na indução e no ajuste do modelo, enquanto que os exemplos de teste são

usados como parâmetros de entrada para o modelo gerado na etapa de testes.

Nesse contexto, pode-se empregar a técnica da validação cruzada (cross-validation ),

que é um método de amostragem para avaliar a capacidade de generalização de um modelo

a partir de um conjunto de dados. (KOHAVI, 1995). O objetivo é estimar a taxa de

acerto de um modelo na prática, com um novo conjunto de dados. Apesar das derivações

existentes, o método funciona basicamente na divisão da amostra em conjuntos exclusivos,

utilizando uma determinada quantidade para o treinamento do modelo (estimação dos

parâmetros) e outros para a validação (testes). As subseções a seguir detalharão alguns

dos métodos mais conhecidos.

28

2.4.1

RETENÇÃO (HOLDOUT )

Método bastante comum e simples, a técnica de holdout divide o grupo seguindo uma porcentagem xa p para treinamento e (1−p) para testes, normalmente seguindo a proporção

de 2/3 e 1/3, respectivamente. Essa técnica, possivelmente, pode gerar um preditor superajustado aos dados, uma vez que um produtor produzido sobre todos os objetos, em geral,

apresentará taxa de acerto maior que a gerada a partir de uma parte deles (MONARD,

2003).

Apesar de (MICHIE, 1994) propor que, para um conjunto de dados grande, o superajuste não ocorra, a interpretação do quão grande deve ser o conjunto de dados para que

isto não ocorra deve ser levada em consideração. Outro ponto negativo quanto a este

método é que ele não permite avaliar a variação do desempenho em diferentes amostras

utilizadas para treinamento.

2.4.2

AMOSTRA ALEATÓRIA (RANDOM SUBSAMPLING )

A amostragem aleatória (random subsampling ) ajusta o método holdout, permitindo

avaliar a variação do desempenho em amostras distintas. Divide-se o conjunto em t

diferentes conjuntos aleatórios, aplica-se o método holdout em cada um deles, e ao nal

retira-se a média aritmética dos resultados.

2.4.3

K-PARTIÇÕES (K-FOLD )

Nessa abordagem de validação, assegura-se a representatividade máxima de todas as

classes no processo de treino e testes, repartindo o conjunto de dados em k -partições

exclusivas (folds ) de mesmo tamanho, ou tamanho aproximado, igual a t =

n

k

, onde:

• n = Total de exemplos do conjunto de dados

• t = Tamanho do bloco

• k = Total de blocos

O treinamento é realizado utilizando os exemplos de k−1 blocos e a hipótese é induzida

no bloco (fold ) remanescente. O processo é realizado k vezes e a média da métrica utilizada

é obtida com o resultado das iterações.

29

2.4.4

DEIXANDO UM FORA (LEAVE-ONE-OUT )

Esse método de validação cruzada pode se tornar muito custoso e por isso é normalmente utilizado em amostras pequenas. Para uma amostra de tamanho n, realiza-se o

treinamento utilizando (n − 1) exemplos e a hipótese induzida é testada no único exemplo

remanescente. O processo é repetido n vezes.

2.4.5

ESTRATIFICADA (STRATIFIED )

Método muito similar a validação cruzada, se diferenciando por considerar a distribuição

de classes na amostra. Ou seja, durante a partição dos blocos deve-se levar em consideração a distribuição de classes total. O cenário de 65% de exemplos da classe 0 e 35% de

exemplos da classe 1 num amostra qualquer deve-se repetir em cada bloco (fold ) gerado,

mantendo a proporção de classes.

2.5

AVALIAÇÃO DE MODELOS DE CLASSIFICAÇÃO

A acurácia gerada pelos métodos de amostragem pode ocultar uma boa capacidade de

generalização de um modelo gerado para determinada classe do problema. O algoritmo

pode ser capaz de induzir uma hipótese que tenha boa taxa de acerto para determinada

classe, tornando-o especialista em determinado cenário.

Segundo (MITCHELL, 1997) a avaliação dos algoritmos de aprendizado de máquina é

feita através da análise do desempenho do classicador utilizando dados que não zeram

parte de seu treinamento.

2.5.1

MATRIZ DE CONFUSÃO

A matriz de confusão (MONARD, 2003) realiza papel importante, detalhando o número

de classicações corretas e incorretas de cada classe do problema. A partir da matriz

é possível extrair medidas estatísticas como precisão (precision ), abrangência (recall ) e

acurácia (acuracy ), por exemplo, utilizadas para medir a efetividade do classicador.

(MANNING, RAGHAVAN, SCHUTZE, 2008).

Em um modelo de duas classes, pode-se denir a matriz de confusão da seguinte

maneira (de acordo com a tabela 2.2) :

30

TAB. 2.2: Matriz de confusão para um problema binário

previsto

+1 -1

+1 vp fn

realizado

-1 fp vn

onde:

• vp = verdadeiros positivos (true positive )

total de classes positivas classicadas corretamente.

• vn = verdadeiros negativos (true negative )

total de classes negativas classicadas corretamente.

• f p = falsos positivos (false positive )

total de classes positivas classicadas erradamente.

• f n = falsos negativos (false negative )

total de classes negativas classicadas erradamente.

• tot − prev+ = vp + f p

total de classes previstas como positiva na amostra.

• n = vp + f n + f p + vn total de exemplos na amostra

Existem alguns indicadores de desempenho que podem ser derivados a partir da matriz

de confusão (MONARD, 2003), tais como:

• Taxa de verdadeiro positivo - tvp (true positive rate or recall )

Taxa de acerto na classe positiva

tvp =

vp

(vp + f n)

É uma medida que independe da proporção de exemplos. Equivale à pergunta: "De

todos os exemplos positivos, quantos o modelo acertou?"

• Taxa de verdadeiro negativo - tvn ou especicidade (true negative rate or specicity )

Taxa de acerto na classe negativa

tvn =

vn

(f p + vn)

31

É a medida que independe da proporção de exemplos. Equivale à pergunta: "De

todos os exemplos negativos, quantos o modelo acertou?"

• Taxa de falso positivo - tfp (false positive rate )

Taxa de erro na classe positiva

tf p =

fp

(f p + vn)

É a medida que independe da proporção de exemplos. Equivale à pergunta: "De

todos os exemplos negativos, quantos o modelo errou (previu como positivo)?"

• Taxa de falso negativo - tfn (false negative rate )

Taxa de erro na classe negativa

tf n =

fn

(f n + vp)

É a medida que independe da proporção de exemplos. Equivale à pergunta: "De

todos os exemplos positivos, quantos o modelo errou (previu como negativo)?"

• Acurácia - acc (accuracy )

acc =

(vp + vn)

n

Calcula a taxa total de acertos (em ambas as classes).

• Taxa de previstos positivos - tpp ou precisão - prec (precision )

proporção de exemplos positivos classicados corretamente sobre o conjunto de classicados positivos.

tpp =

vp

(vp + f p)

É a medida dependente da proporção de exemplos, que pode mudar por evento

aleatório. Equivale à pergunta: "Qual o percentual de acerto da classe positiva sob

todos os exemplos classicados como positivos?"

32

• Taxa de previstos negativos - tpn

proporção de exemplos negativos classicados corretamente sobre o conjunto de

classicados negativos.

tpn =

vn

(f n + vn)

É a medida dependente da proporção de exemplos, que pode mudar por evento

aleatório. Equivale à pergunta: "Qual o percentual de acerto da classe negativa sob

todos os exemplos classicados como negativos?"

Para este contexto, o foco será nas seguintes medidas de desempenho: acurácia, taxa

de verdadeiro positivo e taxa de verdadeiro negativo, uma vez que ambas as classes se

tornam relevantes a este cenário de análises (informação de tendência de baixa é tão

importante quanto informação de tendência de alta para o investidor).

2.5.2

ANÁLISE ROC

Análise ROC (Receiver Operating Characteristic ) é um método gráco para a avaliação de

sistemas de predição(FAWCETT, 2005), que ganhou força e começou a ser utilizado em

Aprendizado de Máquina para a avaliação de modelos de classicadores (PRATI, 2008). É

uma ferramenta interessante para domínios onde existe uma grande desproporção entre as

possíveis classes ou ainda quando a relação custo-benefício deve ser levada em consideração

para a predição.

O modelo de classicação é plotado no gráco considerando duas variáveis: no eixo x,

o cálculo da taxa de falsos positivos (false positive rate ) e no eixo y, o cálculo da taxa de

verdadeiros positivos (true positive rate ).

Pode-se observar na gura 2.4 alguns pontos de destaque. O ponto (0,0) representa a

estratégia de nunca classicar um exemplo como positivo (ou seja, o modelo não gera falso

positivo mas também não gera verdadeiro positivo). Inversamente, o ponto (1,1) classica

todos os exemplos como positivos. O ponto (0,1) representa o cenário perfeito, ou seja,

todos os exemplos positivos e negativos são corretamente classicados. Inversamente, o

ponto (1,0) representa o modelo que sempre faz predições erradas.

33

FIG. 2.4: Análise ROC

Quanto mais próximo ao ponto (0,0), mais "conservador" é o modelo. A classicação

positiva depende de grande segurança na classicação (poucos erros de falsos positivos,

mas baixas taxas de verdadeiro positivo).

Quantos mais próximo ao ponto (1,1), mais "liberal" é o modelo. A predição da classe

positiva ocorre mais frequentemente e de maneira correta, mas consequentemente tem

altas taxas de falsos positivos.

A diagonal (0,0)-(1,1) representa o comportamento aleatório e modelos que se encontrem a área de triangulo inferior a esta (área destacada em vermelho) representam

modelos piores que o aleatório.

2.6

NAIVE BAYES

O algoritmo Naive Bayes (Naive Bayes Gaussiano) é a implementação de um modelo

probabilístico baseado na regra de Bayes (BITTENCOURT, 2006). Por sua simplicidade

este algoritmo é largamente utilizado em aprendizado de máquina, seja em variáveis discretas ou contínuas. Sua implementação é considerada ingênua porque considera que todos

os atributos são condicionalmente independentes, ou seja, um dado atributo não possui

relação com nenhum outro. Em outras palavras, todo atributo xi contido no vetor de

34

entrada X é considerado independente dado yi , além de pressupor que os dados apresentam uma distribuição normal simétrica. Apesar da premissa simplista e comportamento

ingênuo, reporta bom desempenho em diversas tarefas de classicação (MCCALLUM,

1998).

A regra básica de Bayes é denida por:

P (h|E) =

P (E|h) ∗ P (h)

P (E)

(2.1)

onde:

P (h) = probabilidade a priori de h (probabilidade do evento h independente de E )

P (E) = probabilidade a priori de E (probabilidade do evento E independente de h)

P (h|E) = probabilidade a posteriori de h (probabilidade do evento após a evidência ser

vista). Probabilidade de E dado h.

P (E|h) = probabilidade a posteriori de E (probabilidade do evento após a evidência ser

vista). Probabilidade de h dado E .

A suposição Naive Bayes implica que a evidência (E ) pode ser dividida em atributos

independentes:

P (h|E) =

P (E 1 |h) ∗ P (E 2 |h)∗, ..., P (E n |h) ∗ P (h)

P (E)

(2.2)

Para atributos numéricos, utiliza-se a função de densidade probabilidade (f (x)), denida

pelos parâmetros de média (µ) (equação 2.3) e desvio-padrão (σ ) (equação 2.4):

n

µ=

1 X

∗

xi

n i=1

(2.3)

n

X

1

σ=

∗

(xi − µ)2

n − 1 i=1

f(x)=

√1

2πσ

∗ e−

(2.4)

(x−µ)2

2σ 2

(2.5)

No processo de treinamento o algoritmo calcula os parâmetros individuais (médias

e desvios-padrão) para cada classe c do problema, de acordo com a equação 2.5. O

processo de classicação, derivado da Teoria de Bayes (BITTENCOURT, 2006), ocorre

comparando o resultado da equação para cada possível classe c do problema. O maior

valor indica a classe alvo prevista.

35

2.7

A

REGRESSÃO LOGÍSTICA

função logística

é derivada da regressão linear multivariada e interpola uma série

de pontos através da melhor curva/hiperplano, gerados a partir de uma função de limiar

(threshold ). O fato, que pode se tornar um problema, de classicadores lineares sempre

apresentarem a predição booleana, mesmo para exemplos que possam estar muito próximos a fronteira, torna o classicador muito rígido, tendendo a um aumento do número

de classicações incorretas.

(2.6)

hx (x) = w1 x + w0

A equação 2.6 representa a função para a regressão linear univariada, onde x é o

parâmetro de entrada e w0 e w1 , os coecientes a serem aprendidos ("pesos"), através de

uma função que minimize o erro empírico, usualmente função de perda (também conhecida

como função de custo).

A equação logística (equação 2.7) é uma função de aproximação na forma f:X → y ou

ainda P (X|y), quando y for uma variável discreta que, dado um conjunto de treinamento

x = x1 ,...,xn , estima yi . Ou seja, calcula a probabilidade da variável alvo ser igual a

1 dado um conjunto de variável discretas ou contínuas como vetor de entrada. Normalmente, considera-se y como uma variável booleana através da implementação de um limiar

(threshold ) que tende a se tornar menos rígido (g(z) ) do que na regressão linear (gura

2.5), ou seja, o problema de classicação como sendo binário apesar da variável resposta

ser categórica.

FIG. 2.5: Exemplo de limiar logístico (a) x linear (b)

36

Quando y é booleano, tem sua formulação básica denida por:

P (y = 1|X) = g(w0 +

n

X

(2.7)

wk x k )

k=1

g(z) =

1

1 + e(−z)

(2.8)

onde:

wk = representa o k -ésimo termo do vetor de pesos w

xk = representa o k -ésimo termo do vetor de entrada X

g(z)= função logística

Para classicar dado exemplo xk busca-se associar o maior valor de yk que maximiza

a expressão P (y = y k |X), ou seja, assume-se que y = 0 se e somente se a condição

1 <

P (y=0|X)

P (y=1|X)

for verdadeira. A saída da função logística pode ser interpretada como a

probabilidade do exemplo pertencer a classe 1.

Usualmente o método

gradiente descendente

é a função de custo para denir os

valores dos pesos de w iterativamente. O processo de busca dos melhores parâmetros w

(pesos) que minimiza a perda no conjunto de dados é chamado de

regressão logística

(algoritmo 1).

Algoritmo 1 Método do Gradiente Descendente (versão para minimização)

procedimento gradiente

Escolher xk=0 como ponto inicial

enquanto k∇f (x(k) )k2 > faça

∆x(k) = −∇f (x(k) )

Utilizar busca linear para encontrar tamanho do passo α

x(k+1) = x(k) + α∆x(k)

m enquanto

m procedimento

2.8

MÁQUINAS DE VETORES DE SUPORTE (SUPPORT VECTOR MACHINE )

As Máquinas de Vetores de Suporte (support vector machine - SVM ) é atualmente uma

das mais populares abordagens para o aprendizado supervisionado. Tem implementação

37

baseada na Teoria do Aprendizado Estatístico (TAE) proposta por (VAPNIK, 1995) e

estabelece uma série de princípios a serem seguidos para obter classicadores com boa

capacidade de generalização. Quando não se tem um conhecimento especializado sobre o

domínio, então a escolha de SVM tende a ser um método excelente para utilizar. (RUSSELL, 2010).

Pode-se denir o problema de maneira similar ao encontrado pelos outros algoritmos

deste trabalho: dada N amostras (ou exemplos) de treinamento {xi , yi }, com i = 1, 2, ..., N

e xi ∈ <m é uma representação vetorial de um conjunto de dados e yi ∈ {−1, +1}

é sua classe associada. Considera-se ainda uma distribuição de probabilidades P (x, y)

desconhecida da qual os dados de treinamento foram retirados. O processo de treinamento

do algoritmo consiste em treinar um classicador que aprenda um mapeamento x → y

por meio de exemplos de treino {x, y}. Desta maneira é esperado que o classicador

atribua uma classe a um novo conjunto de exemplos seguindo a mesma distribuição de

probabilidade P . Na prática o classicador é treinado para aprender um conjunto de

possíveis mapeamentos x → f (x, α).

Seu principal objetivo é determinar fronteiras que produzam uma separação ótima

entre classes por meio de minimização dos erros

2.8.1

TEORIA DO APRENDIZADO ESTATÍSTICO

Sejam h0 um classicador pertencente a um conjunto de todos os classicadores que um

algoritmo de AM pode gerar (H) e X um conjunto de treinamento composto por n pares

(xi , yi ). A Teoria do Aprendizado Estatístico - TAE - estabelece condições matemáticas

que auxiliam na escolha de um classicador particular h0 ∈ H , levando em consideração

sua complexidade.

Tem como premissa a geração dos dados ocorre de forma independente, além de serem

identicamente distribuídos de acordo com uma distribuição de probabilidade P (x, y), que

descreve a relação entre as variáveis (objetos) e suas classes (rótulos). Neste sentido, o

risco esperado (ou ainda erro esperado) de um classicador pode ser denido pela equação

2.10, através de uma função de custo, por exemplo, função de custo 0 − 1 (equação 2.9)

custo(h(x), y) =

1

|y − h(x)|

2

(2.9)

38

Z

R(h) =

(2.10)

(custo(h(x), y)dP (x, y))

O principal dicultador da equação 2.10 é que, em geral, a distribuição de probabilidade é desconhecida, não sendo possível minimizar o risco esperado. Uma saída para

obter o melhor classicador é através do risco empírico (ou ainda erro empírico), denido

na equação 2.11.

n

Remp (h) =

1X

(custo(h(x), y))

n i=1

(2.11)

O risco empírico mede desempenho do classicador nos dados de treinamento, por

meio da taxa de classicações incorretas e constitui o principio de minimização do risco

empírico.

Assintoticamente, com n → ∞, é possível estabelecer condições para o algoritmo de

AM que garantam a obtenção de classicadores que tenham valores de risco empírico

convertendo para o risco esperado. De fato, é importante observar que minimizar o risco

empírico nem sempre leva a um menor risco esperado. Como exemplo pode-se destacar

um determinado classicador superajustados ao conjunto de treinamento (memorizam o

conjunto de treinamento e geram classicações aleatórias para novas amostras): seu risco

empírico é nulo, mas o risco esperado é reduzido pela metade.

Ou seja, é sempre possível encontrar um h0 (dentro de um conjunto de funções do

amplo H ) com menor risco empírico, mas com conjunto de dados onde exemplo são pouco

informativos, pode ocorrer o superajuste. Deve-se então restringir a classe de funções da

qual h0 é extraída. A TAE lida com essa questão considerando a complexidade da classe de

funções que o algoritmo de AM é capaz de induzir, propondo limites

ao risco esperado

de uma função de classicador.

2.8.2

LIMITE DO RISCO ESPERADO

A TAE relaciona o risco esperado de uma função R(h) ao seu risco empírico Remp (h) e a

um termo de capacidade (TC), conforme a inequação 2.12. Esse limite é garantido com

probabilidade 1 − θ, em que θ ∈ [0, 1].

(2.12)

R(h) ≤ Remp (h) + T C

39

onde T C é calculado pela

q

V C(ln(2n/V C)+1)−ln(θ/4)

n

e V C representa a dimensão Vapnik-

Chervonenkis (VAPNIK, 1995), que mede a capacidade do conjunto de funções H . Quando

maior o seu valor, mais complexas são as funções de classicação que podem ser induzidas

a partir de H .

O objetivo principal é minimizar o risco esperado considerando um classicador que

minimize do risco empírico e que pertença a um conjunto de funções H com baixa dimensão V C . Este é o princípio da minimização do risco estrutural (VAPNIK, 1998).

2.8.3

RISCO MARGINAL

Computar a dimensão V C pode ser um problema, uma vez que geralmente não é trivial

e seu valor pode ser desconhecido ou innito. Para funções de decisão lineares do tipo

h(x) = w · x (onde w representa o vetor normal a h) existem resultados alternativos que

relacionam o risco esperado ao conceito de margem.

Esta margem de conança de um exemplo tem relação com sua distância à fronteira

de decisão induzida e é uma medida da conança da previsão do classicador, denida na

equação 2.13

(2.13)

∂(h(xi , yi )) = yi h(xi )

A partir da margem de conança pode-se denir o risco marginal (ou erro marginal)

de uma função h0 conforme equação 2.14

n

Rρ (h) =

1X

I(yi h(xi ) < ρ)

n i=1

(2.14)

onde ρ é uma constante > 0 e I(x) = 1, se verdadeiro.

Ou seja, fornece a proporção do número de exemplos de treinamento cuja margem de

conança é menor que a constante ρ. Alterando a formulação do limite do risco esperado,

propõe-se a formulação de acordo com a equação 2.15, onde tem-se o erro esperado (R(h))

limitado pela soma de uma medida de erro no conjunto de treino (erro marginal: Rρ (h)),

a um termo de capacidade.

s c R2

n

1

2

log

+ log

R(h) ≤ Rρ (h) +

2

n ρ

ρ

θ

40

(2.15)

Pode-se destacar os seguintes pontos da relação:

a) uma maior margem implica em um menor termo de capacidade

b) a maximização da margem pode levar a uma maior taxa de erro marginal

c) baixo valor da margem leva a um erro marginal menor, porém a um termo de

capacidade maior

Ou seja, deve-se buscar a maximização da margem com um menor erro marginal

(hiperplano ótimo).

2.8.4

SVM LINEARES DE MARGENS RÍGIDAS (HARD MARGIN )

As SVMs lineares com margens rígidas geram fronteiras lineares a partir de dados linearmente separáveis. Ou seja, é possível separar os exemplos de treinamento por um

hiperplano de acordo com a equação 2.16, aonde w · x representa o produto escalar entre

os vetores w (vetor normal ao hiperplano) e

b

kwk

representa a distância do hiperplano em

relação a origem (b ∈ <)

(2.16)

h(x) = w · x + b

A partir da equação 2.16 separa-se o espaço de entrada X em duas regiões: w·x+b > 0

(classes +1) e w · x + b < 0 (classes -1). As margens podem ser observadas conforme a

gura 2.6. Os vetores de suporte (support vectors - SVs) são os exemplos que participam

da formação do hiperplano.

41

FIG. 2.6: Exemplo de classicação SVM - SV com margens rígidas

Nesta formulação não devem existir dados de treinamento entre as margens de separação das classes (por isto a formulação é chamada de SVM com margem rígida ).

2.8.5

SVM LINEARES DE MARGENS SUAVES (SOFT MARGIN )

Em cenários reais é difícil encontrar amostras que os dados sejam linearmente separáveis,

tanto pela presença de ruídos ou outliers na série ou até mesmo pela característica da

amostra, que muitas vezes não é linear. Para minimizar este problema é introduzido o

conceito de variáveis de folga ξi (slack variables ) para todo i = 1, · · · , n. A aplicação

deste conceito suaviza as margens do classicador linear, permitindo que alguns exemplos

permanecam entre os hiperplanos, e também que ocorram alguns erros de classicação

(ξi > 1). Logo, a soma dos ξi representa o limite do erro de classicação na fase de

treinamento. Nesta solução é adicionada uma constante de regularização (C ), que controla

a penalidade para imperfeição na fase de treinamento. A principal diferença é a diferença

entre os SVs (gura 2.7):

a) SVs sobre as margens são considerados livres (αi∗ > 0)

b) SVs limitados (αi∗ = C ), podem representar:

• Se ξi∗ > 1: erro na classicação

42

• Se 0 < ξi∗ ≤ 1: acerto na classicação, mas entre as margens

• Se ξi∗ = 0: acerto na classicação, mas sob a margem (raro)

FIG. 2.7: Exemplo de classicação SVM - SV com margens suaves

2.8.6

SVM NÃO-LINEARES

A suavização proposta com a inclusão de variáveis de folga ao classicador linear ajuda

a reduzir erros de classicação por presença de outliers e ruídos, mas na maioria das

vezes não se mostra uma boa solução, uma vez que os casos práticos normalmente não

apresentam uma característica linear em sua distribuição (gura 2.8)

Como não é possível separar dados distribuídos de maneira não linear em um ambiente

bi-dimensional, SVM usa funções de kernel (K )5 para transformar um vetor de entradas

em seu espaço original para um novo espaço de alta dimensão, denominado espaço de características (feature space ), onde é possível aplicar um classicador linear para resolução

do problema, conforme observado na equação 2.17:

(2.17)

K(xi , xj ) = Φ(xi ) · Φ(xj )

5 função

que recebe dois pontos xi e xj no espaço de entradas X e calcula o produto escalar no espaço

de alta dimensão

43

Seja Φ X → = um mapeamento, em que X representa o vetor de entradas e = o

espaço de alta dimensão. A escolha apropriada da função Φ faz com que o conjunto de

treinamento seja separado linearmente em um espaço amostral de alta dimensão.

FIG. 2.8: Exemplo de dados não lineares

Após o mapeamento dos objetos para um espaço de maior dimensão utilizando as

funções de kernel, aplica-se SVM linear com margens suaves sobre esse espaço. As funções

de kernel mais usadas são as polinomiais, os de função base radial (radial base function -

RBF ) e os sigmoidais, conforme tabela 2.3

TAB. 2.3: Principais kernels utilizados

kernel

polinomial

rbf

sigmoidal

função (K(xi , xj ))

d

(δ(xi · xj ) + k)

exp(−σ kxi − xj k2 )

tanh(δ(xi · xj ) + k)

parâmetros

δ, k, d

σ

δ, k

A modelagem do problema com uso de SVM depende então da escolha de uma função

de kernel e da escolha do valor para a constante de regularização C , que impacta diretamente no comportamento do classicador, uma vez que estes afetam a fronteira de decisão

induzida. Em destaque a simplicidade do kernel RBF apresentando apenas 1 parâmetro

em sua formulação.

44

3 REVISÃO DA LITERATURA

O estudo de preços de ativos em séries temporais nanceiras utilizando algoritmos de

aprendizado de máquina se subdivide em dois focos: previsão e classicação. Apesar da

distinção clara entre ambos, a análise de todo o processo de tratamento dos dados e o uso

de variáveis de entrada e congurações da arquitetura utilizada, podem contribuir para o

desenvolvimento de soluções mais robustas que gerem melhores respostas. Recentemente,

diversas técnicas de previsão e classicação vêm sendo exploradas, desde métodos estatísticos clássicos até algoritmos mais complexos de aprendizado de máquina, como

Redes

Neurais Articiais (ABRAHAM, 2001), (CHANG, 2009), (MARTINEZ, 2009), (GOMIDE, 2011), Regressão Logística (DUTTA, 2008), (ARUN, 2012), Partial Least

Squares Regression (ALVIM, 2010) e Support Vectors Machines (TAY, 2001b),

(TAY, 2001a), (TAY, 2002), (TAY, 2003), (KIM, 2003), (CHOUDHRY, 2005), (HUANG,

2005), (SAMSUDIN, 2010), (ZHONGYUAN, 2012), (ROSILLO, 2013), (WANG, 2013).

A diferença principal entre a maioria dos trabalhos relacionados, além dos modelos

gerados, é quanto às variáveis de entrada do modelo e a informação alvo. Enquanto

alguns fornecem a ação que deve ser tomada (abordagem com modelos de classicação),

outros focam em valores previstos de cotação de preço de ativos alcançados durante um

determinado período (abordagem com modelos de regressão), ou ainda a previsão de

algum indicador relacionado ao ativo. Independente da abordagem, ainda encontra-se o

mesmo problema: a perda de acurácia com novos dados e o risco de aplicar o modelo em

um cenário real.

45

TAB. 3.1: Principais focos de previsão nanceira

cenário

modelos

variáveis

entrada

domínio

de

variável

explicativa

classicação, regressão e híbridos

indicadores de análise fundamentalista,

indicadores de análise técnica, indicadores sociais e informação de especialista

valor de fechamento (normalmente

ação ou índice de mercado), valor

mínimo no período, valor máximo no

período, volume, tendência, ...

Neste trabalho o foco é o estudo do comportamento dos algoritmos em função do ajuste

de parâmetros livres (uma vez que não há meio estruturado de escolher estes valores) e em

prever as tendências de mercado para um ativo (de alta e de baixa) baseado em informação

base disponível dos ativos no site da BOVESPA.

3.1

TRABALHOS NA ÁREA

Em (TAY, 2001b), foi apresentado um estudo sobre os parâmetros da formulação SVM