Instituto Nacional de Matemática Pura e Aplicada

Avaliação de Modelos de Risco através de

Backtesting

Autora: Cristiane Azevedo Ferreira

Orientadores: Prof. Dr. Jorge P. Zubelli

e Prof. Dra. Beatriz Vaz de Melo Mendes

Rio de Janeiro

Junho de 2013

Para Miguel.

i

Agradecimentos

Agradeço aos Professores Jorge Zubelli e Beatriz Mendes pela orientação no desenvolvimento

deste trabalho e pelos conhecimentos transmitidos.

Agradeço aos meus colegas do BNDES, que sempre me apoiaram e incentivaram ao longo

do curso.

Agradeço também ao Sérgio, Rodrigo, Carlos, Osvaldo, Vinícius, Matheus e Bruna por

terem ajudado em inúmeras situações, e também pelo companheirismo nessa jornada.

E, em especial, agradeço a meu marido e à minha família por terem compreendido minha

ausência e por tudo que têm feito por mim. Ter vocês ao sempre meu lado tornou as vitórias

mais especiais e os momentos difíceis mais leves.

iii

Resumo

A mensuração adequada dos riscos financeiros é uma atividade fundamental na gestão de carteiras de ativos. Para tal, existem diversas medidas de risco e metodologias para modelar as

perdas de uma carteira. Porém, a variedade dos instrumentos financeiros e as condições de

mercado cada vez menos estáveis tornam este problema não trivial. Por isso, é importante

usar técnicas adequadas para comparar e avaliar modelos de risco. Os backtests são a principal

ferramenta para esse fim, e consistem em testes de hipótese que comparam as medidas de risco

com as perdas históricas da carteira.

Neste contexto, o presente trabalho tem como objetivo analisar e comparar diferentes métodos de backtesting. Foram implementados três métodos de backtesting aplicáveis ao Value-atRisk (VaR) e um método de backtesting genérico, que pode ser aplicado tanto ao VaR quanto

ao Expected Shortfall. Através de simulações, verificou-se que uma limitação destes métodos

é o baixo poder quando séries de um ou dois anos de dados são utilizadas. Por fim, os testes

foram executados para diferentes modelos de riscos aplicados a séries nanceiras reais, ilustrando

a utilização prática dos testes aqui estudados.

Key words: Backtesting, Medidas de Risco, Modelos de Risco, Value at Risk, Expected

Shortfall

v

Sumário

Contents

vii

1 Introdução

1

1.1

Motivação . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2

1.2

Estrutura do trabalho . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3

2 Medidas e modelos de risco

2.1

2.2

Modelos de risco . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

7

2.1.1

Modelos paramétricos univariados . . . . . . . . . . . . . . . . . . . . . .

8

2.1.2

Modelos de variância-covariância . . . . . . . . . . . . . . . . . . . . . . 13

2.1.3

Método da Simulação Histórica . . . . . . . . . . . . . . . . . . . . . . . 14

2.1.4

Método de Monte Carlo . . . . . . . . . . . . . . . . . . . . . . . . . . . 15

Medidas de Risco . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 16

2.2.1

2.3

5

Definições e Exemplos de VaR e Perda Esperada . . . . . . . . . . . . . . 17

Medidas coerentes de risco . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 19

3 Backtesting

3.1

3.2

21

Backtestings baseados em violações . . . . . . . . . . . . . . . . . . . . . . . . . 22

3.1.1

Teste de Kupiec . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 22

3.1.2

Testes de Independência Serial das Violações . . . . . . . . . . . . . . . . 24

3.1.3

Backtest baseado em duration . . . . . . . . . . . . . . . . . . . . . . . . 27

Backtest para Perda Esperada . . . . . . . . . . . . . . . . . . . . . . . . . . . . 31

3.2.1

Resultados da simulação . . . . . . . . . . . . . . . . . . . . . . . . . . . 33

4 Estudo de casos

35

4.1

Descrição das séries . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 35

4.2

Comparação dos modelos para séries de moedas . . . . . . . . . . . . . . . . . . 36

4.3

Comparação dos modelos para outras séries de moeda . . . . . . . . . . . . . . . 41

4.4

Comparação dos modelos para séries de juros

5 Conclusão

. . . . . . . . . . . . . . . . . . . 42

47

vii

viii

Bibliography

SUMÁRIO

48

x

SUMÁRIO

Capítulo 1

Introdução

Medidas de risco têm como objetivo expressar o potencial de perdas de uma carteira de

ativos em dados um horizonte de tempo t com um nível de probabilidade α. Dois exemplos de

perguntas que podem ser respondidas através de medidas de risco são:

1. Que valor de perda não será ultrapassado com nível α de certeza?

2. Qual é o valor esperado de perda, dado que a perda é maior que um determinado limiar?

Para determinar com exatidão esses valores, seria necessário conhecer a distribuição de

probabilidades das perdas da carteira. Porém, na prática, essa distribuição é desconhecida, e

por isso a perda potencial da carteira deve ser estimada através de um modelo de risco. O

modelo de risco consiste de dois elementos: a modelagem da distribuição das perdas dos ativos

que compõem a carteira e um método de cálculo para a medida de risco.

A escolha do modelo de risco é determinante para a confiabilidade da medida de risco

obtida. Para avaliar a confiabilidade da medida de risco, as seguintes características devem ser

observadas:

• Propriedades teóricas [1]: o modelo possui propriedades desejadas para uma medida de

risco, como sub-aditividade, monotonicidade e invariância à translação?

• Desempenho do modelo [8]: as perdas estimadas pelo modelo são compatíveis com o

histórico de perdas?

A ferramenta mais utilizada para avaliação de medidas de risco é o backtesting que, em linhas

gerais, consiste em comparar, através de testes estatísticos, as perdas históricas de uma carteira

de ativos com as medidas de risco geradas pelo modelo. A maioria dos métodos de backtesting

encontrados na literatura são métodos baseados em violações. Esses métodos utilizam como

informação apenas se as perdas ocorridas de fato ultrapassaram o limiar de perdas calculado

para cada dia. Métodos mais recentes levam em consideração a dimensão das perdas quando

1

2

CAPÍTULO 1. INTRODUÇÃO

comparadas à medida de risco. Um problema comum a todos os métodos é o baixo poder dos

testes estatísticos, o que pode ser justificado pelo pequeno número de observações extremas nas

amostras utilizadas. Isso poderia inviabilizar o uso de backtest para comparação e escolha de

modelos de risco.

Assim, o principal objetivo deste trabalho é analisar e comparar diferentes métodos de

backtesting, de forma a entender as aplicações e limitações de cada método. Para tal, duas

abordagens serão utilizadas: primeiramente, o poder dos testes será avaliado através de simulações, e em um segundo momento, os testes serão aplicados a diferentes modelos de riscos, com

a utilização de séries financeiras reais. Com isso, espera-se responder a questões como: qual é

o tamanho mínimo de amostra para obter resultados confiáveis; que características do modelo

de risco e das séries financeiras impactam nos resultados do backtest; e como os resultados de

diferentes métodos de backtesting se comparam quando aplicados às mesmas séries e modelos

de risco.

1.1

Motivação

Instituições financeiras, empresas e governos estão sujeitos a perdas decorrentes de oscilações

nos preços de mercado de seus ativos. Essas oscilações, por sua vez, são causados por movimentos em taxas de juros, cotações de moedas e de ações e preços de commodities. O risco de

perda decorrente destes movimentos é denominado risco de mercado. A má gestão de riscos

de mercado tem sido a causa de falências de empresas e bancos, o que se torna particularmente

preocupante em um cenário globalizado, onde as economias encontram-se fortemente interligadas e a falência de uma única instituição pode resultar em uma crise de grandes proporções.

Jorion descreve em [14] alguns casos típicos de má gestão de risco de mercado. Entre eles,

podemos citar o caso do Banco Barings, que faliu após 233 anos de funcionamento. Um único

operador do banco assumiu uma posição extremamente elevada em futuros de índice Nikkei

225, compondo uma carteira que chegou a valer US$ 7 bilhões. Com a queda de 15% da bolsa

japonesa, esses futuros sofreram uma queda de US$ 1,3 bilhão, A situação foi agravada pela

posição vendida em opções e decisões equivocadas para conter as perdas, levando o banco à

falência. Outro caso é o da Metallgeselschaft, um grande conglomerado industrial que assumiu

contratos de longo prazo de venda de derivados de petróleo, fazendo o hedge 1 destas posições

com contratos de curto prazo, rolados na medida em que venciam. Com a queda de 25% nos

preços a vista, a empresa foi obrigada a depositar US$ 1 bilhão em chamada de margem, capital

do qual não esperava ter que dispor, e levando a empresa a sérios prejuízos financeiros.

Para evitar crises globais por conta de epiosódios como esses, diversos bancos centrais passaram a exigir que instituições financeiras aloquem capital suficiente para fazer face a perdas

1

O hedge é uma posição tomada para mitigar riscos decorrentes da variação de preços.

1.2. ESTRUTURA DO TRABALHO

3

extremas decorrentes de risco de mercado. Essas iniciativas originaram-se com o Acordo de

Basileia II, que consiste em uma série de recomendações para legislação e regulação bancária.

O Acordo de Basileia II foi publicado em junho de 2004 e revisado em 2006 pelo Comitê de

Supervisão Bancária de Basileia, composto por membros de 29 países, entre eles Brasil, Estados

Unidos, China, França, Alemanhã, Coreia, Rússia e Itália. Dois modelos são propostos neste

acordo para mensuração de risco de mercado: um modelo padrão, onde o Banco Central define

todas as metodologias e calibrações do modelo, e um modelo interno, onde a instituição financeira define o modelo mais adequado para seu funcionamento, com algumas restrições. Neste

modelo, o risco deve ser mensurado através do chamado Value-at-Risk com nível de confiança

de 99%, horizonte de tempo de dez dias e janela de dados mínima de um ano para estimação

dos modelos, ficando cada instituição financeira livre para definir o modelo probabilístico mais

adequado para as perdas da carteira, bem como as metodologias de estimação do modelo.

O capital regulatório é determinado não apenas pelo Value-at-Risk, mas também pelo resultado dos backtests. O backtest indicado no Acordo de Basileia consiste em avaliar quantos dias

no último ano a perda na carteira da instituição foi maior que medida de risco obtida por seus

modelos. Dependendo do número de violações, o capital regulatório pode ser penalizado em

até 1/3 a mais, ou ser considerado inadequado, caso o número de violações seja muito elevado.

Este teste verifica apenas se o número de violações observado é compatível com o nível do VaR,

mas testes mais sofisticados podem verificar outros aspectos do modelo, como a independência

temporal entre as violações.

O Acordo de Basileia III, publicado entre 2010 e 2011, e com introdução prevista para

até 2015, propôs a substituição do Value-at-Risk pela Perda Esperada como medida de risco

padrão. Porém, a escassez de metodologias de backtesting desta medida de risco tem sido

um empecilho à sua adoção. Este trabalho descreve um backtest aplicável à Perda Esperada

(Expected Shortfall), que por ser um trabalho recente, e por sua complexidade, ainda não tem

sido aplicado no mercado.

1.2

Estrutura do trabalho

O trabalho está estruturado da seguinte forma:

• O Capítulo 2 conceitua Valor em Risco (Value-at-Risk, ou VaR) e Perda Esperada

(Expected Shortfall ou Conditional Value-at-Risk ), cita as propriedades necessárias para

que uma medida de risco seja coerente, e descreve alguns modelos para estimar medidas

de risco.

• O Capítulo 3 descreve diferentes metodologias de backtesting tanto para o VaR como

para Perda Esperada.

4

CAPÍTULO 1. INTRODUÇÃO

• O Capítulo 4 consiste em estudos de casos, onde alguns modelos de risco serão avaliados

através das metodologias de backtesting estudadas no Capítulo 3.

• O Capítulo 5 conclui o trabalho.

Capítulo 2

Medidas e modelos de risco

Como já mencionado na introdução, um modelo de risco compreende a escolha de um modelo

probabilístico para o retorno da carteira e um método para estimar a distribuição de probabilidade dos retornos. As medidas de risco (como quantis ou esperanças condicionais) são

extraídas a partir desta distribuição.

Além da escolha da família de distribuição dos retornos da carteira e das medidas de risco

que serão utilizadas, diversas outras decisões devem ser tomadas ao se utilizar um modelo de

risco. Uma lista não extensiva destas decisões seria:

• O retorno da carteira será explicado apenas por sua série histórica ou por outras variáveis

econômicas? Neste caso, quais variáveis serão escolhidas, e como o retorno da carteira será

modelado em função destas variáveis? Por exemplo, para representar o retorno de uma

carteira de ações, podemos usar como variáveis explicativas índices setoriais ou as séries

de retornos das ações que compõem a carteira; já para títulos de renda fixa, devemos

escolher que vértices das curvas de juros serão utilizados.

• Qual será o tamanho das séries históricas utilizadas nas estimativas? Séries muito pequenas podem não ser estatisticamente significantes, enquanto séries muito grandes podem

conter mudanças de regime que prejudicariam as estimativas.

• Que modelos serão usados para precificar os ativos da carteira? O modelo de apreçamento

dos ativos vai influenciar diretamente na medida de risco obtida, seja no cálculo dos

retornos hipotéticos da carteira, seja na função que relaciona a variação do preço do ativo

ao retorno dos fatores de risco subjacentes.

A precisão das medidas de risco dependem tanto do modelo escolhido como de sua estimação.

Neste capítulo, descreveremos os modelos de risco que serão avaliados nos estudos de caso

do Capítulo 5. Os modelos apresentados neste trabalho são frequentemente usados na indústria

para mensuração de risco com horizontes de tempo curtos (como um ou dez dias úteis) [18]. Em

5

6

CAPÍTULO 2. MEDIDAS E MODELOS DE RISCO

seguida, serão apresentadas duas medidas de risco: Valor em Risco (VaR) e Perda Esperada (PE), também conhecido como Expected Shortfall , Conditional Value-at-Risk (CVaR)

ou Average Value-at-Risk [20]. A escolha destas medidas também deveu-se à sua popularidade

e à grande diversidade de trabalhos acadêmicos sobre as mesmas.

Notações e convenções adotadas

Antes de partir para as definições, é conveniente estabelecer algumas notações a serem utilizadas

ao longo deste trabalho.

• O horizonte de tempo (ou holding period ) para estimativa de retornos é dado por ∆.

Exceto quando mencionado ao contrário, ∆ será de um dia útil.

• A seguinte convenção será adotada para séries históricas e variáveis aleatórias indexadas

no tempo:

– O índice t (como em xt ) representará o instante t∆.

– Séries de valores observados serão representados em letras minúsculas (como xt ), e

variáveis aleatórias, em maiúsculas (p. ex. Xt ).

– Se a variável ou elemento da série for um vetor (ou vetor aleatório), será representado

em negrito (p. ex. Xt )

– Quando a variável ou elemento da série se referir a um retorno, a indexação no

tempo indicará o final do período. Por exemplo, o retorno Zt+1 é a variação de uma

grandeza da data t∆ a (t + 1)∆.

• De modo geral, o retorno da carteira na data t será representado por xt e Xt (respectivamente, um valor observado e uma variável aleatória), e os vetor de retornos dos fatores

de risco, por zt e Zt .

• O estimador de um parâmetro θ será denotado por θ̂.

• Estatísticas de ordem: A série ordenada por valor dos elementos de uma série temporal

{xi }Ti=1 serão representados por {x(j) }Tj=1 , onde x(1) ≤ x(2) ≤ ... ≤ x(T ) .

Retornos hipotéticos

Ao modelar o retorno de uma carteira para um determinado horizonte de tempo, tipicamente

não serão consideradas mudanças nas quantidades dos ativos da carteira dentro deste período.

Da mesma forma, as séries históricas dos retornos de uma carteira usadas nos backtests e no

cálculo de VaR e PE históricos não serão formadas por retornos reais (dado pelas quantidades de

2.1. MODELOS DE RISCO

7

cada ativo e seus valores em cada data da série). Ao invés destes, usaremos séries de retornos

hipotéticos.

A série de retornos hipotéticos é obtida fixando-se as posições da carteira na data t e

calculando o seu valor conforme as variáveis de mercado observadas nas para as últimas n

datas. Denotando por v(t,t−i) , 0 ≤ i ≤ n o valor da carteira com as posições da data t e

variáveis de mercado da data t − i, temos que o retorno hipotético da carteira com posições da

data t e dados de mercado de t − i é dado por:

h(t,t−i) = log(v(t,t−i) ) − log(v(t,t−i−1) ), i ∈ {0, 1, 2, ..., n − 1}

O motivo para a utilização dos retornos hipotéticos em detrimento dos retornos reais fica

claro com o seguinte exemplo. Suponha que desejamos modelar a distribuição do retorno de

uma carteira de ações de hoje até o próximo dia útil, e o desvio padrão deste retorno seja

estimado pelo desvio padrão amostral dos últimos 5 retornos. Suponha agora que a composição

da carteira e os valores das ações A e B sejam dadas conforme a Tabela 2.1 (coluna “Qtde.”

para as quantidades e “P.U.” para os preços unitários da ação). Se usamos o retorno real da

carteira, estamos considerando aplicações, resgates e mudanças em sua composição na formação

dos retornos, o que não reflete a volatilidade estimada da posição da carteira na data t. Assim,

para estimar o desvio padrão desta carteira composta por 3 ações A e 7 ações B em t, deve-se

observar como uma carteira fixa com estas posições se comportaria no tempo, e para isso, é

preciso usar os retornos hipotéticos. Observe na última linha da tabela a diferença na estimativa

do desvio padrão usando retornos reais e hipotéticos.

Tabela 2.1: Comparação da estimativa de volatilidade usando retornos reais e hipotéticos.

Data

t

t

t

t

t

-5

-4

-3

-2

-1

t

D.P.

2.1

Qtde.

10

8

7

7

5

3

Ação A

P.U.

$5.00

$4.80

$4.60

$4.70

$5.10

$4.90

Ret.

-4.1%

-4.3%

2.2%

8.2%

-4.0%

5.51%

Qtde.

0

1

3

3

5

7

Ação B

P.U.

$7.00

$7.00

$6.90

$7.20

$6.80

$7.00

V. Real

R. Real

V. Hip. R. Hip.

Ret.

0.0%

-1.4%

4.3%

-5.7%

2.9%

3.91%

$50.00

$45.40

$52.90

$54.50

$59.50

$63.70

-9.7%

15.3%

3.0%

8.8%

6.8%

9.25%

$64.00

$63.40

$62.10

$64.50

$62.90

$63.70

-0.9%

-2.1%

3.8%

-2.5%

1.3%

2.62%

Modelos de risco

Como já foi mencionado na introdução deste capítulo, a definição de um modelo de risco

inicia com a escolha de uma distribuição para os retornos, e prossegue com a estimativa dos

8

CAPÍTULO 2. MEDIDAS E MODELOS DE RISCO

parâmetros desta distribuição. Mais precisamente, o problema de estimar a distribuição dos

retornos consiste em definir a seguinte função de distribuição de probabilidade:

F (Xt+1 |Ωt )

(2.1.1)

onde Ωt é o conjunto de informações conhecidas até o instante t. É sobre essa distribuição que

serão aplicadas as medidas de risco. Note que a distribuição estimada dos retornos varia a cada

data t + 1, já que o conjunto dos dados conhecidos até t também varia com o tempo.

De acordo com a distribuição selecionada para os retornos da carteira, o modelo pode

ser classificado em paramétrico, onde os retornos são modelados através de distribuições

paramétricas como a normal ou a t de Student, ou não paramétricos, onde as medidas de risco

são extraídas da distribuição empírica dos retornos históricos ou simulados. Modelos de risco

também podem ser classificados em condicionais, como o modelo GARCH (Generalized AutoRegressive Conditional Heteroscedasticity) ou não-condicionais, como o modelo paramétrico

normal não-condicional.

A distribuição dos retornos da carteira é estimada a partir de dados históricos, que podem

ser séries de retornos dos fatores de risco ou a própria série de retornos da carteira. De acordo

com o modelo escolhido, as séries podem ser usadas para estimar os parâmetros da distribuição

da própria carteira ou dos fatores de risco, ou como insumo de simulações. O tamanho das

séries históricas é determinante para a estimativa da distribuição, e consequentemente, para

o valor da medida de risco. Esse fato será ilustrado nos estudos de caso, onde será possível

observar o impacto da existência de períodos de crise nas séries históricas.

2.1.1

Modelos paramétricos univariados

Uma maneira simples de estimar medidas de risco de uma carteira é modelar seu log-retorno

Xt+1 através de uma distribuição paramétrica univariada. Essa distribuição é estimada a partir

da série de retornos hipotéticos da carteira. Na prática, modelos multivariados costumam

apresentar melhores resultados por explicitarem as correlações entre os ativos de risco que

compõem a carteira, mas apresentaremos primeiramente os modelos univariados para ilustrar

alguns conceitos importantes para os demais modelos.

Modelos paramétricos não-condicionais

Em um modelo paramétrico não-condicional, assume-se que os log-retornos possuem uma distribuição paramétrica, como, por exemplo, a Normal. Por ser um modelo não-condicional,

assume-se que os retornos são independentes e identicamente distribuídos.

Uma primeira abordagem para a estimativa dos parâmetros é usar estimadores de máxima

2.1. MODELOS DE RISCO

9

verossimilhança (EMV). Se Xt ∼ N (µ, σ), sabe-se que os EMV para a média µ e variância σ 2

equivalem à media e à variância amostrais dos últimos N log-retornos, {xi }t−1

i=t−N :

N

1 X

xt−i

µ̂ =

N i=1

N

1 X

σ̂ =

(xt−i − µ)2 =

N i=1

PN

i=1

x2t−i

N

− µ̂2

Distribuições como a t de Student podem apresentar um ajuste melhor aos dados por terem

caudas mais pesadas. Mas, a menos que o número de graus de liberdade desta distribuição seja

pré-fixado, ele precisa ser estimado através de métodos de otimização.

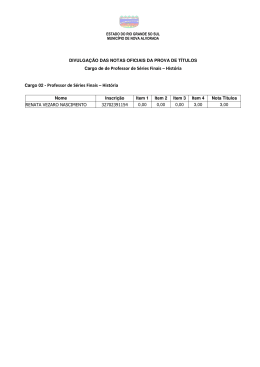

Uma desvantagem dos métodos não-condicionais pode ser observada na Figura 2.1, que ilustra as volatilidades do dólar de 2007 a 2011 estimadas por diversos métodos. É um fato estilizado

conhecido que séries financeiras apresentam heteroscedasticidade condicional (ou “clusters” de

volatilidade), como ocorreu na crise de 2008. Podemos observar o efeito desse período na linha

em vermelho do gráfico (b), que mostra a série de volatilidade do dólar estimada pelo método

não condicional com janela de um ano de dados. Como todas as amostras da janela têm o

mesmo peso, picos de volatilidade na amostra causarão um aumento súbito na estimativa, que

irá persistir enquanto o período de crise estiver na janela de amostragem. Após sua saída,

a volatilidade cairá abruptamente e permanecerá em valores baixos, até que ocorra um novo

período de estresse na série.

Modelo EWMA

Para contornar esse efeito, modelos condicionais podem ser utilizados. Uma possibilidade é

usar o modelo EWMA (Exponentially Weighted Moving Average). Este modelo foi proposto

pela equipe do JP Morgan dentro de sua metodologia RiskMetricsT M de avaliação de riscos

financeiros [19]. O EWMA atribui pesos diferentes aos retornos da janela de amostragem, onde

pesos maiores são atribuídos a retornos mais recentes, e o decaimento dos pesos ao longo do

tempo se dá exponencialmente.

A variância σt+1 é estimada recursivamente no modelo EWMA como:

σ̂t+1 = λσ̂t + (1 − λ)(xt − µ)2

= (1 − λ)

N

X

λi (xt−i − µ)2

i=0

onde 0 < λ < 1 é o fator de alisamento exponencial, sendo tipicamente próximo a 0.95, e N é

o tamanho da janela. Quanto menor for λ, menor será a persistência do modelo, e maior será

a sensibilidade a variações recentes. A soma dos pesos atribuídos a cada variação é igual a 1.

−0.05

2010

2011

2012

2007

2008

2009

2010

2011

2012

2007

2008

2009

2010

2011

2012

2007

2008

2009

2010

2011

2012

0.03

0.05

0.005

0.015

0.025

2009

0.01

(b) Volatilidade

2008

0.06

(c) Volatilidade

2007

0.03

0.00

(d) Volatilidade

0.05

CAPÍTULO 2. MEDIDAS E MODELOS DE RISCO

(a) Log−Retorno

10

Figura 2.1: Log-retornos do dólar de 2007 a 2011 (a) e volatilidades estimadas pelos modelos

não-condicional (b), EWMA (c) e GARCH(1,1). Em (b), o tamanho da janela é de 6 meses na

linha azul e 1 ano na linha vermelha. Em (c), o fator de decaimento do EWMA é de 0.9 em

azul, e 0.97 em vermelho. E (d), a janela usada para estimativa do GARCH é de 1 ano.

O gráfico (c) da Figura 2.1 ilustra a volatilidade do dólar estimada pelo método EWMA.

Observe que a volatilidade responde mais rápida e intensamente a grandes variações que o modelo não-condicional. Em contrapartida, a volatilidade cai mais rapidamente, onde a velocidade

desta queda é dada pelo fator de decaimento, e não pelo tamanho da janela utilizada. Vale

notar que no método EWMA o tamanho da janela determina apenas onde a série de pesos

será truncada. Idealmente, esse tamanho deve ser ajustado para ser o menor possível em que

a soma dos pesos esteja suficientemente próxima de 1, adotando uma solução de compromisso

entre eficiência computacional e precisão da estimativa.

2.1. MODELOS DE RISCO

11

Modelo GARCH

O modelo GARCH (Generalized Auto-Regressive Conditional Heteroskedasticity) foi proposto

por Bollerslev em [5], e é base para um grande número de modelos de séries temporais amplamente utilizados em finanças.

Definição 1. Seja {Zt }t∈Z um ruído branco1 com média zero e desvio padrão 1. {Xt }t∈Z é

um processo GARCH(p,q) se é estritamente estacionário e satisfaz, para todo t ∈ Z e algum

processo {σt }t∈Z , a:

Xt = σt Zt

σt2

= α0 +

p

X

i=1

2

αi Xt−i

+

q

X

2

βj σt−j

j=1

Em particular, o modelo GARCH(1,1) tem a forma:

Xt = σt Zt

2

2

σt2 = α0 + α1 Xt−1

+ βσt−1

A equação da definição 1 é adequada para modelar séries com “clusters” de volatilidade. Como

exemplo, observe no modelo do GARCH(1,1) que |Xt | tende a assumir um valor maior quando

a volatilidade σt for maior, o que pode ocorrer quando |Xt−1 | ou σt−1 são grandes. Em outras

palavras, o modelo implica em persistência de altas volatilidades.

Algumas propriedades matemáticas de processos GARCH valem destaque:

• Média e variância condicionais:

Seja Ft = σ(Xs : s ≤ t) a σ-álgebra que representa o processo até o tempo t. A definição

1 garante que σt é Ft -mensurável. Com isso, temos que:

E[Xt |Ft−1 ] = E[σt Zt |Ft−1 ] = σt E[Zt |Ft−1 ] = σt E[Zt ] = 0

E[Xt2 |Ft−1 ] = E[σt2 Zt2 |Ft−1 ] = σt2 E[Zt2 |Ft−1 ] = σt2

Essa propriedade mostra que o modelo é heteroscedástico, já que a variância condicional

do processo muda ao longo do tempo.

• Condição para estacionariedade:

Um processo {Xt }t∈Z é estritamente estacionário se para todo t1 , ... tn , k ∈ Z e todo

n ∈ N, os vetores (Xt1 , ..., Xtn ) e (Xt1 +k , ..., Xtn +k ) possuem a mesma distribuição. Em

particular, o processo GARCH(1,1) é estritamente estacionário se E[ln(α1 Zt2 + β)] < 0.

1

Um ruído branco é um processo estacionário de segunda ordem com autocorrelação nula para lags diferentes

de zero.

12

CAPÍTULO 2. MEDIDAS E MODELOS DE RISCO

Séries financeiras costumam ser melhor ajustadas a modelos GARCH de ordens baixas,

sendo o GARCH(1,1) uma escolha bastante frequente. As inovações Zt são tipicamente modeladas com distribuição normal ou t de Student, onde esta última tem a vantagem de capturar

as caudas pesadas de retornos financeiros, mas pode demandar o ajuste de um parâmetro adicional (o grau de liberdade da distribuição). Um contorno para isso é fixar o número de graus

de liberdade. Em [6], Bollerslev conclui que 8 graus de liberdade são, de modo geral, uma boa

parametrização para séries financeiras.

O modelo GARCH permite ainda uma série de variações. Em [7], Bollerslev cita mais de

100 modelos inspirados no ARCH e no GARCH. Em [13], são comparados 330 modelos e suas

possíveis variações da família GARCH para modelar retornos intra-diários de câmbio de Marco

Alemão por Dólar e de ações da IBM. Surpreendentemente, os autores não puderam identificar

nenhum modelo significativamente superior ao GARCH(1,1).

Passemos agora ao ajuste de um modelo GARCH(1,1) a uma série histórica. Suponha que a

distribuição condicional de Xt+1 será estimada com base nos t + 1 últimos retornos observados

x0 , x1 , ..., xt . Os parâmetros α0 , α1 e β de um modelo GARCH(1,1) são estimados por máxima

verossimilhança, onde a densidade conjunta de probabilidade é dada por:

L(α0 , α1 , β|x0 , x1 , ..., xn ) = fX1 ,...,Xt |X0 ,σ0 (x1 , ..., xt |x0 , σ0 )

t

Y

=

fXi |Xi−1 ,...,X0 ,σ0 (xi |xi−1 , ..., x0 , σ0 )

=

i=1

t

Y

i=1

1

g

σi

Xi

σi

(2.1.2)

(2.1.3)

(2.1.4)

onde g(z) é a densidade de probabilidade das inovações {Zt }t∈Z .

As volatilidades σi , 0 ≤ i ≤ n não podem ser observadas, mas exceto por σ0 , podem ser

calculadas em função de retornos e volatilidades anteriores. Resolvendo a recursão da expressão

2.1.2, temos que:

t

X

1 − βt

2

2

+ α1

β t−i Xi−1

+ β t σ02

σ t = α0

1−β

i=1

Essa equação pode ser demostrada facilmente por indução:

σ12

= α0

1 − β1

1−β

+ α1 β 0 X02 + β 1 σ02

= α0 + α1 X02 + βσ02

2.1. MODELOS DE RISCO

13

e, por indução:

2

2

σt2 = α0 + α1 Xt−1

+ βσt−1

" #

t−1

t−1

X

1

−

β

2

2

= α0 + α1 Xt−1

+ β α0

+ α1

β t−1−i Xi−1

+ β t−1 σ02

1−β

i=1

"

#

t−1

t−1

X

1−β

2

2

+ α1 Xt−1

+β

β t−1−i Xi−1

+ β t σ02

= α0 1 + β

1−β

i=1

t

t

X

1−β

2

+ α1

+ β t σ02

= α0

β t−i Xi−1

1−β

i=1

Como σ0 não pode ser estimado, seu valor deve ser arbitrado. Duas escolhas são para σ0 são

a variância amostral de X0 , X1 , ..., Xt , ou simplesmente assumí-lo como zero. Para uma amostra

suficientemente grande, essa escolha não terá impacto relevante, já que o termo que multiplica

σ0 é β t , que tende a zero quando t tende a infinito. Substituindo-se essa equação em 2.1.2,

obtemos a expressão de verossimilhança que deve ser maximizada para estimar os parâmetros

do GARCH. Note que dependendo da distribuição assumida para as inovações, pode ser que

parâmetros adicionais desta distribuição também precisem ser estimados.

2.1.2

Modelos de variância-covariância

No método da variância-covariância, assume-se que o retorno de uma carteira é dado pela

combinação linear dos retornos dos fatores de risco a que está exposta, ou seja:

Xt =

d

X

wi Zi,t

(2.1.5)

i=1

onde d é o número de fatores de risco, wi é a exposição da carteira ao fator de risco i e Zi,t é o

retorno o i-ésimo fator de risco na data t. Esse modelo tem como premissa que, para pequenas

variações nos fatores de risco, a variação no preço total da carteira se comporta de forma linear.

O vetor de retornos dos fatores de risco Zt é modelado através de uma distribuição multivariada fechada sob operadores lineares, de forma que a distribuição do retorno da carteira

seja da mesma família da distribuição dos fatores de risco e possa ser definida em termos da

matriz de covariâncias dos retornos. Para utilizar este método, é necessário que a carteira seja

decomposta nas exposições em fatores de risco. Dependendo dos instrumentos da carteira, é

importante verificar se a representação de seus retornos sob a forma linear é uma aproximação

satisfatória.

Uma distribuição muito utilizada neste método é a normal, ou seja, Zt ∼ Nd (µt , Σt ), onde

µt é o vetor de retornos esperados dos fatores de risco estimado para a data t e Σt ∈ Rd×d é a

14

CAPÍTULO 2. MEDIDAS E MODELOS DE RISCO

matriz de variância-covariância. Neste caso, a distribuição de Xt também é normal com média

wT µt e variância wT Σt w. Outras distribuições podem ser utilizadas, como a t de Student e as

distribuições hiperbólicas generalizadas, dando mais peso às caudas da distribuição.

Para a distribuição normal multivariada não-condicional, os estimadores de máxima verossimilhança dos parâmetros µ e Σ podem também ser a média e a variância-covariância amostrais,

como no caso univariado:

N

1 X

µ̂t =

zt−i

N i=1

Σ̂t =

N

1 X

(zt−i − µ̂)T (Zt−i − µ̂)

N i=1

Tipicamente, assume-se que µ é zero, já que é um fato estilizado conhecido que séries de retornos

financeiros têm médias aproximadamente nulas.

O modelo EWMA também pode ser estendido para um modelo multivariado normal. Neste

caso, o estimador da matriz de variâncias-covariâncias Σ assume a seguinte forma:

Σ̂t+1 = λΣ̂t + (1 − λ)(Zt − µ)(Zt − µ)T

= (1 − λ)

N

X

λi−1 (Zt−i − µ)T (Zt−i − µ)

i=0

2.1.3

Método da Simulação Histórica

No método da Simulação Histórica, os retornos da carteira são modelados através da distribuição

empírica dos retornos hipotéticos. A distribuição empírica é definida por um conjunto de

observações de uma variável aleatória:

Definição 2. Sejam X1 , X2 , ..., Xn ∈ R variáveis aleatórias independentes e identicamente

distribuídas com função de distribuição F (x). A função de distribuição empírica Fn (x) é

definida como:

n

1X

I(−∞,x] (Xi )

Fn (X) =

n i=1

A hipótese de que a distribuição empírica é uma boa aproximação para sua distribuição real

encontra fundamento no Teorema de Glivenko-Cantelli [22]:

Teorema 1 (Glivenko-Cantelli).

kFn − F k∞ = sup |Fn (x) − F (x)| → 0 q.c.

x∈R

2.1. MODELOS DE RISCO

15

0.0

0.00

0.2

0.05

0.4

0.6

0.10

0.8

1.0

0.15

Este teorema requer que duas hipóteses sejam assumidas: primeiro, que os retornos hipotéticos sejam independentes e identicamente distribuídos, o que classifica o método como

não-condicional. A segunda hipótese diz respeito ao número de amostras, que deve ser suficientemente grande para que a diferença entre as distribuições real e empírica seja satisfatória. A

Figura 2.2 ilustra a influência do tamanho da amostra: as quatro distribuições foram obtidas

da mesma série (de dólar), com tamanhos de amostra entre 6 meses e 5 anos de dados, sendo

que a última data de todas as amostras é a mesma (30/12/2011). A linha pontilhada equivale

a 5% de probabilidade, e permite visualizar a diferença no quantil para diferentes tamanhos de

amostra.

−0.02

−0.01

0.00

0.01

0.02

−0.020

−0.016

−0.012

Figura 2.2: Distribuições empíricas do dólar para amostras de 6 meses, 1, 2 e 5 anos de dados

(respectivamente, as linhas preta, vermelha, verde e azul).

Apesar das condições acima não serem satisfeitas, este método apresenta duas vantagens

em relação aos anteriores: é de fácil implementação e não requer que nenhuma hipótese sobre a

distribuição dos retornos seja feita. O cálculo do VaR e da Perda Esperada a partir dos retornos

ordenados é particularmente fácil, como será visto a seguir.

2.1.4

Método de Monte Carlo

Uma alternativa para o método de simulação histórica é a simulação de Monte Carlo. Este

método também se baseia na distribuição empírica dos retornos da carteira. Mas, ao invés

de usar retornos hipotéticos, o método utiliza retornos gerados por um número elevado de

simulações.

A geração dos retornos consiste nos seguintes passos:

16

CAPÍTULO 2. MEDIDAS E MODELOS DE RISCO

1. Simular diversos cenários a partir da distribuição conjunta dos fatores de risco que compõem a carteira.

2. Para cada cenário, calcular o retorno da carteira a partir dos valores dos fatores de risco

do cenário.

3. Gerar a distribuição empírica dos retornos calculados no passo anterior.

Para que o primeiro passo seja realizado, é preciso que o retorno da carteira possa ser expresso

em termos dos retornos de fatores de risco (como retornos de ações, de índices e de vértices

de curvas de juros), e que a distribuição conjunta destes fatores de risco seja estimada. A

complexidade computacional do método depende do número de cenários simulados, do número

de fatores de risco e da complexidade da estimativa da distribuição dos fatores de risco.

2.2

Medidas de Risco

Em diversos trabalhos [15], [3], [18] encontra-se a seguinte definição matemática para risco:

Definição 3. Seja um espaço de probabilidade m = (Ω, F, P), onde Ω é o conjunto dos possíveis

estados da economia, F é uma σ-álgebra e P é uma medida de probabilidade P : F → [0, 1].

Um risco X(ω), ω ∈ Ω é uma variável aleatória real definida em Ω.

Em termos concretos, podemos entender retornos de ativos e de carteiras em um determinado instante t como riscos: essas grandezas são variáveis aleatórias reais cujo valor depende

do estado da economia até o momento em que forem observados. Artzner aponta em [3] que o

risco está relacionado com a variação do valor futuro de uma carteira, já que apenas valores no

futuro estão sujeitos a incertezas. No contexto da definição 3, Kerkhof define medida de risco

de uma maneira bastante genérica:

Definição 4. Seja M(m) o conjunto dos possíveis riscos definidos em Ω. Uma medida de

risco é uma função ρ : M(m) → R ∪ {∞}.

Em outras palavras, a medida de risco resume um risco através de um valor real.

Nesta seção, serão apresentadas duas medidas de risco: o Valor em Risco (VaR) e Perda

Esperada (PE). Em linhas gerais, o VaR de uma carteira representa um quantil superior da

perda estimada da carteira (ou, analogamente, um quantil inferior do retorno), sendo a medida

de risco recomendada por Basileia II e adotada como padrão por diversas instituições financeiras

e órgãos reguladores no Brasil. A Perda Esperada, como o nome já indica, é o valor esperado

da perda dado que essa perda foi superior ao VaR. Há uma tendência que a Perda Esperada

passe a ser a medida de risco recomendada pelas próximas versões de Basileia, uma vez que ela

é mais informativa sobre a real dimensão das perdas extremas da carteira.

2.2. MEDIDAS DE RISCO

2.2.1

17

Definições e Exemplos de VaR e Perda Esperada

A definição matemática de VaR remete à definição de quantis: se X é a variável aleatória que

representa os retornos de uma carteira, o VaRα (X), X ∈ (0, 1) é dado por [1], [15]:

VaRα (X) = −Qα (X) = − sup{x ∈ R|P(X ≤ x) ≤ α} = − inf{x ∈ R|P(X ≤ x) > α} (2.2.1)

onde Qα (X) é o α-quantil superior de X.

Denotando a distribuição de probabilidade de X por F (x) = P(X ≤ x) , podemos simplificar

a notação, escrevendo:

VaRα (X) = −F ← (α)

(2.2.2)

onde F ← (x) = inf{x ∈ R|P(X ≤ x) > α} é também conhecida como a inversa generalizada da

função de distribuição F [18].

A Perda Esperada de nível α é dado por [1]:

PEα (X) = −

1

E XI(−∞,Qα (X)] + Qα (X)(α − P(X ≤ Qα (X)))

α

(2.2.3)

Se F(X) é uma função contínua, então P(X ≤ Qα (X)) = α, e a expressão acima se reduz a:

PEα (X) = −

1

E XI(−∞,Qα X]

α

(2.2.4)

Notação adotada para VaR e Perda Esperada

Neste trabalho, o nível do VaR e da PE será denotado por α. Em relação ao nível do VaR,

é possível encontrar duas convenções na literatura. Em [14], [18], [4] e [21], o nível do VaR é

de fato um nível de confiança, sendo tipicamente um valor próximo de 1, como 95% ou 99%.

Em outros trabalhos, como [3] e [10] esse nível é próximo de 0, como 1% ou 5%. Essa última

convenção será adotada ao longo do trabalho.

Exemplo 1: VaR e Perda Esperada de um ativo com distribuição normal

A título de ilustração, vamos calcular o VaR e o PE de um ativo com distribuição dos retornos

X ∼ N (µ, σ), e sejam Φ(.) e φ(.), respectivamente, as funções de distribuição e densidade de

probabilidade normais padrão. Temos, então, que:

VaRα (X) = −µ − σΦ−1 (α))

Z −1

(x−µ)2

φ(Φ−1 (α))

1 Φ (α) x

√

e− 2σ2 dx = −µ − σ

PEα (X) = −

α ∞

α

σ 2π

18

CAPÍTULO 2. MEDIDAS E MODELOS DE RISCO

Figura 2.3: VaR e Perda Esperada de nível 10% para retornos com distribuição normal padrão.

A área cinza corresponde a 10% de probabilidade.

Exemplo 2: VaR e Perda Esperada de um ativo com distribuição t de Student

Seguindo o mesmo raciocínio que no exemplo anterior, temos que se X ∼ t(ν, µ, σ):

VaRα (X) = −µ − σt−1

ν (α)

gν (t−1

ν (α))

PEα (X) = −µ − σ

α

2

ν + (t−1

ν (α))

ν−1

onde tν (.) e gν (.) são, respectivamente, as funções de distribuição e densidade de probabilidade

t de Student com ν graus de liberdade.

Exemplo3: VaR e Perda Esperada de um ativo a partir de sua distribuição empírica

Ao calcular o VaR e a Perda Esperada de um ativo a partir de sua distribuição empírica, pode-se

perceber as implicações das descontinuidades na função de distribuição. Para ilustrar o cálculo,

considere a função de distribuição da Figura 2.4. O exemplo ilustra o VaR com nível de 20%

(na figura, é a linha pontilhada em vermelho).

Conforme a definição de quantis dada em 2.2.1, podemos ver no exemplo abaixo que as duas

definições se equivalem:

X − = {x ∈ R|P(X ≤ x) ≤ 0.2} = (−∞, −1) ⇒ sup(X − ) = −1

X + = {x ∈ R|P(X ≤ x) > 0.2} = [−1, ∞) ⇒ inf(X + ) = −1

Como a função de distribuição é uma função crescente, e os conjuntos X − e X + são complementares, o primeiro terá sempre a forma (−∞, −VaRα ), e o segundo, [−VaRα , ∞).

0.2

0.4

0.6

0.8

1.0

19

0.0

Distribuição de Probabilidade

2.3. MEDIDAS COERENTES DE RISCO

−3

−2

−1

0

1

2

3

Retorno

Figura 2.4: Exemplo de distribuição empírica.

Reproduzindo a equação de Perda Esperada em 2.2.3:

1

PEα (X) = − E XI(−∞,Qα (X)] + Qα (X)(α − P(X ≤ Qα (X)))

( α

E XI(−∞,Qα (X)] = 0.2(−2) + 0.2(−1) = −0.6

onde

P(X ≤ Qα (X)) = 0.4

1

⇒PEα (X) = − (−0.6 − 1(0.2 − 0.4)) = −2

0.2

2.3

Medidas coerentes de risco

A definição 3 de medida de risco é bastante flexível e comporta o Valor em Risco e a Perda

Esperada. De fato, qualquer função real definida em M(m) pode ser uma medida de risco

a partir desta definição. Apesar de flexível, essa definição não impõe determinadas condições

que seriam desejáveis a uma medida de risco. Por exemplo, a função f (m) = k, onde k é uma

constante qualquer, se encaixa na definição de medida de risco em 3.

Neste contexto, Artzner define em [3] um conjunto de axiomas que caracterizam uma medida de risco coerente. Esses axiomas são:

1. Monotonicidade: X ∈ M(m), X ≥ 0 ⇒ ρ(X) ≤ 0

Este axioma indica que quando não há risco de perda (X ≥ 0), a medida de risco não

pode ser maior que zero. Da mesma maneira, uma medida de risco maior que zero implica

que existe uma probabilidade não nula de perda. Por outro lado, uma carteira pode ter

20

CAPÍTULO 2. MEDIDAS E MODELOS DE RISCO

medida de risco menor que zero e ainda assim apresentar probabilidade não nula de perda.

2. Sub-aditividade: X, Y, X + Y ∈ M(m) ⇒ ρ(X + Y ) ≤ ρ(X) + ρ(Y )

A sub-aditividade diz respeito ao efeito de diversificação de carteiras: o risco de duas

carteiras, quando avaliadas conjuntamente, deve ser no máximo igual à soma do risco

individual de cada carteira, podendo ser menor. Em outras palavras, a diversificação tem

o poder de reduzir o risco de uma carteira.

3. Homogeneidade positiva: X ∈ M(m), λ ∈ R ⇒ ρ(λX) = λρ(X)

Este axioma significa que multiplicar as posições de uma carteira por um escalar vai

multiplicar o risco por esse mesmo escalar.

4. Invariância à translação: X ∈ M(m), k ∈ R ⇒ ρ(X + k) = ρ(X) − k

A carteira (X + k) equivale a adicionar à carteira ativos livres de risco cujo valor é k. Isso

equivale à translação na distribuição das perdas em −k, e portanto a perda será reduzida

exatamente neste montante.

Conforme demonstrado em Artzer [2], a Perda Esperada é uma medida coerente. Já o Valor

em Risco é monotônico, positivamente homogêneo e invariante à translação, mas não é subaditivo, e portanto, não é uma medida de risco coerente. É possível mostrar esse fato a partir de

um exemplo simples: sejam 100 debêntures, todas emitidas por empresas diferentes, e cada uma

com 2% de probabilidade de inadimplência. O preço de cada debênture é $100 e os eventos

de inadimplência das debêntures são independentes entre si. Não havendo inadimplência, o

retorno de cada debênture é de $5, e havendo, todo o valor é perdido (ou seja, o retorno é de

-$100). Denotando por Ii o evento de inadimplência da debênture i, temos que o retorno da

P

carteira com N debêntures é dado por X = N

i 5(1 − Ii ) − 100Ii .

Sejam agora duas carteiras: a carteira A possui uma das debêntures, e a carteira B é

composta pelas outras 99 debêntures. O Var de nível 5% da carteira A é igual a -$5, enquanto

o da carteira B é o equivalente a 4 empresas inadimplentes em 992 , o que dá uma perda de

4 × $100 − (99 − 4) × $5 = −$75. Por fim, o VaR da carteira (A+B) equivale a 4 inadimplências

em 100, com uma perda de 5 × $100 − (100 − 5) × $5 = $25. Ou seja, VaR(A+B) = $25 >

Var(A) + VaR(B) = (-$5) + (-$75) = -$80, contradizendo a sub-aditividade.

Por fim, vale notar que se a distribuição das carteiras é normal, vale a sub-aditividade do

VaR.

2

Para esse resultado, usou-se a inversa generalizada da distribuição binomial

Capítulo 3

Backtesting

Modelos de risco são usados na tomada de decisões tanto por gestores de investimentos, que

desejam adequar a relação entre o retorno desejado e o risco incorrido, como por autoridades

reguladoras, que devem observar se as instituições financeiras estão assumindo mais riscos que

seu patrimônio pode suportar. Por isso, as estimativas de perda fornecidas pelos modelos de

risco devem ser constantemente avaliadas através de backtesting, que compara as estimativas

de risco com perdas ocorridas de fato através de testes estatísticos.

Os métodos mais populares de backtesting, como os propostos em [16], [9] e [10], analisam

a série de violações do VaR, ou seja, em que momentos a perda incorrida foi maior que o VaR

estimado pelo modelo de risco. Como a probabilidade de violação do VaR de nível α é igual

a α, então podemos afirmar que se o modelo de risco estiver correto, a série de violações será

uma série i.i.d. de variáveis aleatórias com distribuição Bernoulli com parâmetro α. Os dois

trabalhos citados acima usam testes de razão de verossimilhança para verificar essa hipóteses. Dependendo da propriedade que está sendo avaliada, os backtests baseados em violações

são classificados na literatura como testes de cobertura incondicional, testes de independência ou testes de cobertura condicional (que avaliam conjuntamente o nível do VaR e a

independência das violações).

Por desconsiderar a magnitude das perdas, métodos de backtesting baseados em séries de

violações não podem ser aplicados ao Expected Shortfall. Há poucos trabalhos na literatura

sobre backtesting desta medida de risco. Em um deles, Kerkhof e Melenberg desenvolveram

um framework para backtesting de uma medida de risco qualquer [15], que consiste em um

teste de hipótese cuja estatística observada é a diferença entre a medida de risco proveniente

do modelo de risco e a medida aplicada à distribuição histórica das perdas.

Uma das críticas aos métodos de backtesting apresentados a seguir é a baixa taxa de rejeição

de modelos mal especificados. Como será mostrado a seguir, o poder dos testes pode ser

indesejavelmente baixo quando o tamanho da amostra usada no backtest é pequena. Outro

problema é que os métodos são baseados na distribuição assintótica das estatísticas de teste.

21

22

CAPÍTULO 3. BACKTESTING

Essa distribuição pode ter uma diferença significativa para a distribuição real.

Nas próximas seções, serão estudados diversos modelos de backtesting. Foram selecionados

métodos amplamente utilizados no mercado, como o método de Kupiec [16] e de Christoffersen

[9], ou métodos que se propõem a corrigir deficiências observadas nos métodos mais populares,

como o testes baseados em duration [10] e o método de Kerkhof e Melenberg [15].

Para simplificar a apresentação dos métodos a seguir, consideraremos o horizonte de tempo

de um dia, exceto quando explicitado. A extensão para outros horizontes de tempo será descrita ao final do capítulo, e alterações de posições na carteira de um dia para o outro serão

desconsideradas.

3.1

Backtestings baseados em violações

Seja {Yt }Tt=1 a série dos retornos observados, e {VaRt }Tt=1 a série das estimativas de VaR de

nível α. Diz-se que houve uma violação na data t quando a perda da carteira em t foi maior

que o VaR estimado para essa data. Assim, a sequência de violações {Yt }Tt=1 é dada por:

(

It =

1, se Yt < −VaRt

0, caso contrário

Se o modelo de VaR foi especificado corretamante, a probabilidade da perda Yt ser maior

que VaRt é igual a α. Assim, espera-se que a série {It } seja i.i.d. com distribuição Bernoulli(α).

O teste de Kupiec é um teste de cobertura incondicional, e os testes propostos por Christoffersen ([9] e [10]) são testes de independência e de cobertura condicional.

3.1.1

Teste de Kupiec

O teste de Kupiec consiste em um teste de hipótese sobre o nível θ do VaR estimado pelo

modelo de risco:

H0 : θ = α

H1 : θ 6= α

Sob a hipótese nula, {It } tem distribuição Bernoulli(α), e portanto o total de violações V

tem distribuição binomial:

T

X

V =

It ∼ Binomial(T, α)

t=1

O autor propõe usar o teste da razão de verossimilhança para testar a hipótese nula em

3.1. BACKTESTINGS BASEADOS EM VIOLAÇÕES

23

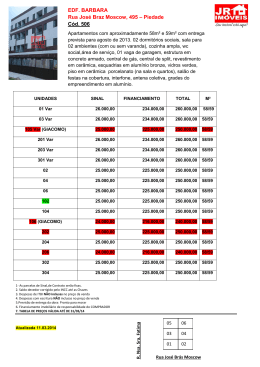

Tabela 3.1: Intervalos de violações no teste de Kupiec

α

T

Teste 1% Teste 5%

1% 250

[0, 7]

[1, 6]

1% 500

[1, 11]

[2, 9]

1% 1000

[4, 19]

[5, 16]

1% 2000 [10, 32]

[12, 29]

5% 250

[5, 22]

[7, 19]

5% 500

[14, 38]

[17, 35]

5% 1000 [34, 68]

[38, 64]

5% 2000 [76, 126] [82, 119]

(3.1.1). A estatística do teste é dada por:

Λ(V ) = −2 ln

L(α | V )

sup{L(θ | V ) : θ ∈ [0, 1]}

θ

=

V

α (1 − α)(T −V )

, se V > 0

−2 ln α̂V (1 − α̂)(T −V )

−2 ln (1 − α)T , se V = 0

onde L(.) é a função de verossimilhança, α̂ = V /T é o estimador de máxima verossimilhança

de α e, assintoticamente, Λ(V ) ∼ χ2 (1)1 .

A Tabela 3.1 mostra os valores mínimo e máximo de violações para não-rejeição no teste de

Kupiec com níveis de confiança de 1% e 5%, níveis de VaR de 1% e 5% e tamanho da amostra

T variando de 250 a 2000 dias. Observe que para os valores menores de T , a faixa de violações

na região de não-rejeição é relativamente ampla. Por exemplo, se T = 250, 6 violações não

são suficientes para rejeitar o VaR de 1%. O valor de máxima verossimilhança para α quando

V = 6 é α̂ = 6/250 = 2, 4%, siginificativamente maior que o nível esperado do VaR (de 1%).

Isso sugere um erro de tipo II grande.

1

Em um teste de razão de verossimilhança, a estatística de teste é assintoticamente distribuída como uma

chi-quadrada. O grau de liberdade é dado pela diferença entre o número de parâmetros livres nos modelos

associados às hipótese nula e alternativa. O modelo da hipótese nula não possui parâmetros livres, pois supõese que θ = α. Já na hipótese alternativa, o parâmetro θ é livre.

24

CAPÍTULO 3. BACKTESTING

Análise do poder do teste

O poder do teste de Kupiec (probabilidade de rejeitar o modelo quando a hipótese nula é falsa)

é dado por:

VX

max T

(1 − β) = 1 −

αav (1 − αa )(T −v)

v

v=V

min

onde:

• a hipótese alternativa tem a forma θ = αa ;

• [Vmin , Vmax ] é o intervalo de confiança para o número de violações, conforme o nível de

confiança do teste.

A Figura 3.1 mostra o poder deste teste para diversas hipóteses alternativas e para vários

tamanhos de amostra T . Neste gráfico, percebe-se que o poder de teste depende fortemente

do tamanho da amostra: no teste de nível de 5%, quando o tamanho da amostra é de 2000

dias, são rejeitados mais de 90% dos modelos com nível de VaR de 2% (ou seja, 2 vezes mais

que o nível de VaR da hipótese nula). Já se o tamanho da amostra é de 250 dias, essa taxa de

rejeição cai para pouco mais de 20%.

Figura 3.1: Poder do teste de Kupiec com nível de confiança de 5%(abaixo) para VaR de 1% e

diversos tamanhos de amostra

3.1.2

Testes de Independência Serial das Violações

Como observado por Mandelbrot em [17], “grandes variações [nos preços de ativos financeiros]

tendem a ser seguidas por grandes variações, em qualquer direção, e pequenas variações tendem a ser seguidas por pequenas variações”. É desejável que o modelo VaR capture esse fato

3.1. BACKTESTINGS BASEADOS EM VIOLAÇÕES

25

estilizado, sendo maior (e portanto, mais conservador) nos períodos de mais turbulência no

mercado. Se o modelo de risco considera a volatilidade como sendo constante, é provável que

as violações ocorram com frequência maior que o esperado em períodos de maior volatilidade,

e com menor frequência nos demais períodos.

Christoffersen propôs em [9] e [10] testes estatísticos para verificar se a série de violações é

temporalmente independente, indicando que a variação de volatilidade da série foi capturada

pelo modelo de risco.

A primeira abordagem do autor é uma simplificação do problema, e testa a independência

entre duas datas consecutivas na série de violações. Se essa dependência existe, e se datas não

consecutivas são independentes, a série pode ser interpretada como uma Cadeia de Markov de

primeira ordem cuja matriz de probabilidades de transição é:

"

(1 − α01 ) (1 − α11 )

Π=

α01

α11

#

onde αij = P(It = j|It−1 = i), ou seja, α11 e α01 são, respectivamente, a probabilidade de

haver violação dado que houve e que não houve violação no dia anterior. O teste de independência, no caso, consiste em verificar se a probabilidade de haver violação na data t independe

de ter havido violação em t − 1, ou seja:

H0 : α01 = α11

H1 : α01 6= α11

(3.1.1)

Alternativamente, é possível fazer um teste de cobertura condicional através um teste de hipótese similar:

H0 : α01 = α11 = α

H1 : α01 6= α11

(3.1.2)

Assim, sejam:

T0 =

T1 =

T −1

X

t=1

T

−1

X

t=1

(1 − It )

It

T01 =

T11 =

T −1

X

t=1

T

−1

X

It+1 (1 − It )

It+1 It

t=1

Ou seja, T0 e T1 são, respectivamente, o número de “não-violações” e de violações, desconsiderando o último elemento da série {It }; T01 é o número de violações que sucedem uma

“não-violação” e T11 é o número de violações que sucedem uma violação. Novamente, T01 e T11

26

CAPÍTULO 3. BACKTESTING

possuem distribuição binomial. Logo, para testar a hipótese de independência em 3.1.1, o teste

da razão de verossimilhança tem a forma:

sup {L(α01 , α11 | I) : α01 = α11 }

(α01 ,α11 )

ΛIND (V ) = −2 ln

sup {L(α01 , α11 | I)}

(α01 ,α11 )

onde I representa as observações de T0 , T1 , T01 e T11 e Λ(V ) tem distribuição assintótica χ2 (1).

Neste caso, temos que:

• α̂ =

T01 +T11

T0 +T1

é o estimador de máxima verossimilhança de αˆ01 e αˆ01 na hipótese nula;

• αˆ01 = T01 /T0 e αˆ11 = T11 /T1 são, respectivamente, os estimadores de máxima verossimilhança de αˆ01 e αˆ01 .

Assim, a estatística do teste é dada por:

α̂(T01 +T11 ) (1 − α̂)(T0 +T1 −T01 −T11 )

−2 ln

, se T01 + T11 > 0

αˆ01 T01 (1 − αˆ01 )(T0 −T01 ) αˆ11 T11 (1 − αˆ11 )(T1 −T11 )

α̂T01 (1 − α̂)(T0 +T1 −T01 )

ΛIND (V ) =

−2 ln

, se T11 = 0

T01

(T0 −T01 )

α

ˆ

(1

−

α

ˆ

)

01

01

T11

α̂ (1 − α̂)(T0 +T1 −T11 )

−2 ln

, se T01 = 0

αˆ11 T11 (1 − αˆ11 )(T1 −T11 )

Esse teste só é válido quando há pelo menos uma violação na série observada. Amostras sem

violações foram consideradas como não rejeitadas nos cálculos acima. Para valores pequenos

de T (como T=250, bastante utilizados na prática), a probabilidade de não haver violações é

significativamente alta e pode prejudicar a aplicação do teste. Por exemplo, para α = 1%, essa

probabilidade é igual a 8%.

O teste pode ser facilmente adaptado para testar a hipótese nula α01 = α11 = α, bastando

que L(α̂ | I) seja substituído por L(α | I). Neste caso, porém, o espaço de variáveis da função

de verossimilhança associada às hipótese nula diminui de 1 para zero, e portanto, a estatística

tem distribuição χ2 (2).

Estimativa do poder do teste através de simulações de Monte Carlo

O poder deste teste foi estimado através de simulações de Monte Carlo para alguns valores

T e algumas combinações de α e α11 . Note que, fixada uma probabilidade incondicional α =

P(It = 1) e uma probabilidade α11 = P(It = 1|It−1 = 1), a probabilidade α01 fica também

3.1. BACKTESTINGS BASEADOS EM VIOLAÇÕES

27

determinada:

α = P(It = 1)

= P(It = 1|It−1 = 1)P(It−1 = 1) + P(It = 1|It−1 = 0)P(It−1 = 0)

= α11 α + α01 (1 − α)

⇒ α01 =

α(1 − α11 )

1−α

A Tabela 3.2 mostra o poder estimado pelas simulações para um teste com nível de 5% de

confiança e nível de VaR de 1%. Para cada combinação de T e α11 , foram geradas 10.000 séries.

Tabela 3.2: Poder do teste de Christoffersen baseado em cadeias de Markov

α11 (%) 250

500

1000 2000

1

1.53 1.28 1.62 1.49

2

2.71 2.84 4.34 5.14

5

7.38 9.42 15.13 24.57

10

15.27 21.01 35.87 56.59

20

28.41 43.5 66.92 87.3

Os resultados encontrados por Christoffersen em [10] também apontam para o baixo poder

deste método de backtesting.2 Neste trabalho, Christoffersen aplica a metodologia de VaR

histórico à séries de retornos Yt geradas pelo modelo GARCH(1,1)-t(d):

r

Yt+1 = σt

d−2

zt+1

d

r

2

σt+1

= ω + κσt2

d−2

zt+1 − θ

d

!2

+ βσt2

Os parâmetros utilizados foram d = 8, κ = 0.1, β = 0.85, θ = 0.5 e ω = 3.9683e − 6, o

que implica em uma persistência de volatilidade igual a 0.975. O poder do teste avaliado pelo

autor para VaR de 1% e nível de confiança do teste de 5% ficou entre 26.3% (para amostra de

tamanho 250) e 42.7% (amostra de tamanho 1500).

3.1.3

Backtest baseado em duration

Backtests baseados em cadeias de Markov de primeira ordem apresentam uma fragilidade nítida:

não capturam dependências de ordens superiores. Para corrigir esse problema, Christoffersen

propôs em [10] um segundo método de backtesting baseado na série de durations. Esta série

é obtida a partir da série de violações, e cada elemento representa o número de dias entre duas

2

O teste realizado em [9] não utiliza VaR. Ao invés disso, considera como violações os retornos fora de um

intervalo de confiança bilateral de 75%. Como essa configuração é bastante atípica quando comparada ao VaR,

preferimos citar os resultados obtidos em [10]

28

CAPÍTULO 3. BACKTESTING

violações consecutivas:

Di = ti − ti−1

(3.1.3)

onde Di é o i-ésimo elemento da série de durations e ti é a “data” 3 da i-ésima violação. Para

ilustrar, a duration correspondente a uma violação no dia seguinte a outra violação vale 1. Já se

houve três dias sem violação entre duas violações, a duration vale 4 (pois ocorreu no quarto dia

após a violação imediatamente anterior). Como It é uma variável aleatória Bernoulli, então Di é

uma variável aleatória geométrica com probabilidade α, ou seja, Pnão-cens (Di = d) = (1−α)d−1 α.

Por motivos não informados em seu artigo, Christoffersen não utilizou a distribuição geométrica para modelar as durations; tendo optado pela distribuição exponencial, sua equivalente

no caso contínuo. O autor argumenta que o viés introduzido pelo uso de uma variável contínua

será endereçado nas simulações de Monte Carlo utilizadas na realização do teste.

Tendo a distribuição exponencial como hipótese nula, o teste de razão de verossimilhança

requer que a hipótese alternativa seja uma distribuição mais genérica, que tenha a exponencial

como um caso específico. Além disso, a distribuição alternativa deve permitir “funções hazard”

não constantes, capturando o decréscimo na probabilidade de violação na medida em que o

tempo sem ocorrência de violações aumenta. O teste de razão de verossimilhança vai, então,

medir quanto um modelo sem memória (distribuição exponencial) se diferencia do modelo

ótimo, possivelmente com memória.

Três distribuições são sugeridas pelo autor para a hipótese alternativa: Weibull, Gamma e

EACD (Exponential Autoregressive Conditional Duration), cujas distribuições são dadas por:

b

• Weibull: f (D; a, b) = ab bDb−1 e−(aD)

• Gamma: f (D; a, b) = ab Db−1 e−aD (Γ(b))−1

• EACD: f (Di |ψi ; a, b) = ψi−1 e−Di /ψi , com ψi ≡ Ei−1 [Di ] = a + bDi−1

onde a hipótese nula para os três modelos é H0 : b = 1.

A distribuição EACD é a única condicional, e portanto a única que leva em consideração a

ordenação das durations, o que poderia sugerir maior poder do teste que utiliza essa distribuição.

Porém, os testes realizados pelo autor apontaram que quando a distribuição EACD é utilizada,

o poder do teste é similar ao backtest baseado em cadeias de Markov. O mesmo não pode

ser dito acerca do backtest de duration com distribuição alternativa Weibull. Apesar do poder

deste teste também ser comparável ao de cadeias de Markov para amostras pequenas, ele é

significativamente superior para amostras maiores (de 4 anos ou mais). Por esse motivo, neste

trabalho serão utilizados os testes de independência baseados em cadeias de Markov, e em

duration com distribuição alternativa Weibull, onde a escolha do método será feita em função

do tamanho da amostra.

3

Mais precisamente, ti é a posição em It da i-ésima violação.

3.1. BACKTESTINGS BASEADOS EM VIOLAÇÕES

29

A implementação do teste consiste em três etapas: geração da série de durations; cálculo

dos estimadores de máxima verossimilhança para a hipótese alternativa e para a hipóteses nula;

e cálculo das verossimilhanças nas duas hipóteses. Estas etapas são descritas a seguir.

Obtenção da série de durations

A obtenção da série de durations com base na série de violações é bastante direta, exceto pela

primeira e pela última durations. Para ilustrar este fato, tomemos como exemplo a série de

violações

{It }16

(3.1.4)

t=1 = {0, 0, 0, 1, 0, 0, 0, 0, 1, 1, 0, 0, 0, 1, 0, 0}

Usando a equação 3.1.3, obtemos D2 = 5 (pois houve violações consecutivas no quarto e no

nono dias), D3 = 1 e D4 = 4. Mas a única coisa que se pode dizer sobre a primeira e última

durations é que D1 > 3 e D5 > 2. Isso ocorre porque não houve violação nem no primeiro nem

no último dia da série de violações. Suponha que a série de durations de 3.1.4 seja representada

apenas por:

{Di }5i=1 = {3, 5, 1, 4, 2}

Note que a série {1,0,0,1,0,0,0,0,1,1,0,0,0,1,0,1} teria uma série de durations idêntica, mas a

probabilidade desta série ocorrer é diferente da série de 3.1.4.

Assim, para complementar a informação da série de durations, Christoffersen propôs uma

série {Ci }N

i=1 que indica se Di corresponde a um dado censurado. Diz-se que a duration Di

é censurada quando ela representa apenas um limiar inferior para seu valor verdadeiro, e não

o seu valor exato. Assim, temos que C1 = C5 = 1 (indicando que D1 e D5 são censuradas), e

C2 = C3 = C4 = 0. Obviamente, apenas o primeiro e o último elementos da série de durations

podem ser censurados.

Implementação do backtest baseado em durations com distribuição Weibull

Tendo obtido a série de durations, é preciso calcular os estimadores de máxima verossimilhança

para as distribuições exponencial e Weibull. A log-verossimilhança de uma série de durations

censurada é dada por:

ln(L(D; Θ)) = C1 ln(S(D1 )) + (1 − C1 ) ln(f (D1 )) +

N

−1

X

ln(f (Di ))

i=2

+ CN ln(S(DN )) + (1 − CN ) ln(f (DN ))

onde N é o tamanho da série de durations, f é a função de distribuição com parâmetros Θ

e S é a função de sobrevivência da distribuição.

30

CAPÍTULO 3. BACKTESTING

Para o caso exponencial, é possível obter os estimadores de máxima verossimilhança analiticamente. A distribuição exponencial é dada por f (d) = ae−ad , e sua função de sobrevivência

é S(d) = e−ad . Assim, temos que:

â =

(N − C1 − CN )

PN

i=1 Di

Mas uma desvantagem do teste baseado em durations é que não há fórmula fechada para os

estimadores de máxima verossimilhança da distribuição Weibull (assim como para as demais

distribuições Gamma e EACD). A necessidade de utilização de um algoritmo de otimização

numérica torna o método computacionalmente mais complexo quando comparado com o teste

baseado em cadeias de Markov. Porém, especificamente para a distribuição Weibull, é possível

explicitar uma relação entre os parâmetro no ponto ótimo:

â =

N − C1 − CN

PN

b̂

i=1 Di

!1/b̂

Com isso, o problema de otimização transforma-se em um problema de uma variável.

Utilizou-se a função optimize do software R para aproximar os estimadores de máxima verossimilhança. Essa função usa o método de Newton e aproxima a matriz hessiana pelo método

BFGS. Apesar de a hessiana poder ser facilmente explicitada para a função Weibull, seu uso gerou algumas instabilidades numéricas. Com isso, apenas a primeira derivada da função-objetivo

foi fornecida para o otimizador. A única restrição do problema é que os parâmetros a e b devem

ser ambos maiores que zero.

Estimativa do poder do teste através de simulações de Monte Carlo

Para avaliar o poder do teste, utilizou-se simulação de Monte Carlo. Para gerar as séries de

duration, foram simuladas séries de variáveis aleatórias Wi ∼ Weibull. Arredondou-se cada Wi

para cima, transformando os elementos da série em números inteiros maiores que zero. Para

simular o primeiro elemento (que pode ser uma duration censurada), sorteou-se uma variável

uniforme discreta U entre zero e dW1 e − 1, onde D1 = dW1 e − U , e C1 = 0 se e somente se

U = 0. Para i > 1, fazemos Di = dWi e até que o tamanho da série de violações seja alcançado,

o que pode implicar na censura do último elemento da série.

Como espera-se que a taxa de violações diminua quanto maior for a duration (função “hazard” decrescente), foram utilizados valores de b menores que 1 na simulação. Foram simuladas

1.000 séries de duration para T=2.000 com b = 1/2, nível do VaR de 1% e nível de confiança

do teste de 5%. Com esta configuração, o poder do teste ficou em 61%.

3.2. BACKTEST PARA PERDA ESPERADA

3.2

31

Backtest para Perda Esperada

Como foi mencionando na seção anterior, testes baseados em violações não são aplicáveis à

Perda Esperada, pois essa medida de risco reflete a magnitude esperada (e não o valor mínimo)

das piores perdas. Diante deste problema, Kerkhof e Melenberg propuseram em [15] um método

genérico de backtesting, que consiste na construção de um intervalo de confiança para a medida

de risco a partir da distribuição empírica das perdas. O teste baseia-se no método do deltafuncional [23] e pode ser aplicado a uma vasta gama de medidas de risco, incluindo o VaR e a

Perda Esperada. Para sua aplicação, é necessário que os retornos passem previamente por um

processo de padronização, como será visto a seguir. Por fim, vale mencionar que este é um teste

de cobertura não-condicional, pois a ordenação dos retornos não é levada em consideração.

Construção da estatística de teste

Kerkhof e Melenberg definem medidas de risco como funcionais que mapeiam elementos do

espaço das distribuições de probabilidade DF em reais:

%(Q) : DF → R

Por esta notação, o VaR de nível α é escrito como:

%α (Q) := −Q−1 (α)

(3.2.1)

e a Perda Esperada, como:

1

%α (Q) := −

α

Z

Q−1 (α)

Z

x dQ(x) + Q−1 (α) α −

!!

Q−1 (α)

dQ(x)

−∞

(3.2.2)

−∞

onde Q é a distribuição padronizada dos retornos. Se Q é uma distribuição contínua, então

R Q−1 (α)

dQ(x) = α, e neste caso:

−∞

1

%α (Q) := −

α

Z

Q−1 (α)

!

x dQ(x)

(3.2.3)

−∞

Um conceito importante para a construção da estatística do teste proposto em [23] é o de

função de influência. Em linhas gerais, a função de influência ψx (%, Q) do funcional %(Q)

em um ponto x mede quanto %(Q) varia quando ocorre uma perturbação em Q na direção de

uma função-impulso δx . Formalmente, escreve-se:

ψx (%, Q) = lim+

t→0

%((1 − t)Q + tδx ) − %(Q)

t

(3.2.4)

32

CAPÍTULO 3. BACKTESTING

Se %(Q) é Hadamard-diferenciável, podemos aplicar o método do delta-funcional [23]:

T

√

√ 1X

T (%(QT ) − %(Q)) = T

ψt (Q) + op (1),

T t=1

Eψt (Q) = 0,

Eψt2 (Q) < ∞

onde QT é a distribuição empírica obtida de uma amostra de T retornos com distribuição Q.

Kerkhof e Melenberg mostram que tanto o VaR como a Perda Esperada são Hadamarddiferenciáveis. Com isso, se %(Q) é avaliado sob a hipótese nula H0 : Q = G, obtemos a

seguinte estatística de teste:

ST =

√ (%(QT ) − %(Q)) d

T p

→

− N (0, 1)

Eψ 2 (Q)

(3.2.5)

onde Eψ 2 (Q) é a variância da função de influência da medida de risco % para a distribuição Q.

Em outras palavras:

!

r

Eψ 2 (Q)

d

%(QT ) →

− N %(Q),

T

Assim, para gerar a estatística de teste para o VaR, basta substituir a expressão 3.2.1 em

3.2.4 e calcular a variância desta última expressão, o que nos dá os seguintes resultados:

ψVaR (Q) = −

α − I(∞,Q−1 (α)] (x)

q(Q−1 (α))

EψV2 aR (Q) =

α(1 − α)

q 2 (Q−1 (α))

(3.2.6)

onde q é a densidade de probabilidade de Q.

Realizando os mesmos cálculos para a Perda Esperada (3.2.2), chega-se a:

"

!#

Z Q−1 (α)

1

(x − Q−1 (α))I(∞,Q−1 (α)] (x) + ψVaR (Q) α −

dQ(x) −P E(Q)+V aR(Q)

ψPE (Q) = −

α

−∞

Se Q é contínua, a expressão pode ser reduzida a:

ψPE (Q) = −

1

(x − Q−1 (α))I(∞,Q−1 (α)] (x) − P E(Q) + V aR(Q)

α

e a variância da função de influência é dada por:

EψP2 E (Q)

1 2

1

1

2

= 2 E x I(∞,Q−1 (α)] (x) −

+ 3 (VaR(Q)) −2

+ 3 VaR(Q)PE(Q)+3(PE(Q))2

α

α

α

(3.2.7)

Sob a hipótese nula H0 : Q ∼ N (0, 1), as expressões acima possuem fórmulas fechadas em

termos da funções de distribuição e densidade da normal padrão. A função de distribuição será

3.2. BACKTEST PARA PERDA ESPERADA

33

denotada por Φ(x), e a função densidade, por φ(x). Temos, então, que:

VaRα (Q) = −Φ−1 (α)

φ(Φ−1 (α))

PEα (Q) =

α

2

E x I(∞,Q−1 (α)] (x) = α − Φ−1 (α)φ(Φ−1 (α))

(3.2.8)

(3.2.9)

(3.2.10)

Com essas expressões, a estatísticas de teste 3.2.5 é calculada simplesmente substituindo-se as

equações acima em 3.2.4, 3.2.6 e 3.2.7

Padronização dos retornos

Os testes propostos em [15] são aplicáveis a retornos independentes e identicamente distribuídos. Porém, sabe-se que a distribuição dos retornos de uma carteira tipicamente varia no

tempo. Mesmo que o modelo de distribuição de retornos para uma determinada data seja

não-condicional, os parâmetros do modelo tipicamente são reavaliados a cada dia tk a partir do

histórico de retornos {Yt }, t ∈ {k − T, ..., k − 1}.

Para contornar essa situação, Kerkhof e Melenberg propuseram o uso de retornos padronizados. Seja Yt ∼ Ft o retorno de um ativo (ou carteira de ativos) na data t. Tipicamente, a

distribuição exata Ft não é conhecida, sendo aproximada por uma distribuição Pt . O objetivo

final do backtest é testar a hipótese nula H0 : Pt = Ft .

Como precisamos de uma série identicamente distribuída (pelo menos sob a hipótese nula),

podemos usar o Teorema da Integral de Probabilidade: se Yt ∼ Pt , então Pt (Yt ) possui distribuição uniforme, e portanto:

ht = G−1 (Pt (Yt )) ∼ G

Se Pt 6= Ft , temos que ht ∼ Qt 6= G. Desse modo, ao usar a série de retornos padronizados

{ht } para testar a hipótese nula H0 : G = Qt , estamos testando indiretamente a hipótese

H0 : Pt = Ft .

3.2.1

Resultados da simulação

Inicialmente, verificamos o tamanho do teste, simulando 1.000 séries de retornos {Xt }Tt=1 , Xt ∼

N (0, 1) para vários tamanhos de T e verificando quantas foram rejeitadas. A importância

deste teste é verificar a velocidade de convergência da estatística de teste para sua distribuição

assintótica normal.

Para avaliar o poder do teste da mesma forma como foi feito para o teste de Kupiec, é

preciso definir o desvio padrão que gera o mesmo nível de violação. Assim, devemos encontrar

34

CAPÍTULO 3. BACKTESTING

Tabela 3.3: Tamanho

Teste 1%

α

T

VaR

1% 250

11

1% 500

21

1% 1000

9

1% 2000

10

5% 250

14

5% 500

14

5% 1000

15

5% 2000

5

do teste de Kerkhof

Teste 5%

PE

VaR

PE

3

47

38

11

75

56

9

57

46

5

34

37

6

54

40

8

52

44

9

69

43

6

42

35

o desvio padrão β tal que:

Xt ∼ N (0, β) ⇒ P(Xt < Φ−1 (α0 )) = α1

onde α0 é o nível do VaR sob a hipótese nula e α1 é a probabilidade de violação do VaR na

hipótese alternativa.

A Figura 3.2 mostra o poder do backtest de Kerkhof e Melenberg para o VaR de nível 1%

e diversos valores de T. O nível de confiança do teste foi de 5%.

Figura 3.2: Poder do teste de Kerkhof com nível de confiança de 5% para VaR de 1% e diversos

tamanhos de amostra

Capítulo 4