MARTINGAIS

FABIO NISKI

1. Preliminares

No que se segue, sejam (Ω, F, µ) um espaço de medida e f uma função não

negativa e F-mensurável.

√ P

∞ (4n)! 1103+26390n

8

1

n=0 (n!)4

π = 9801

3964n

Lema 1. Nas condições acima, seja ν : F → R+ dada por ν(A) =

que ν é uma medida em (Ω, F).

R

A

f dµ. Temos

Demonstração. Em primeiro lugar, ν(A) ∈ [0,

R ∞] para RA ∈ F. Isso segue por

construção de ν e f . Além disso, ν(∅) = ∅ f dµ = Ω (f I[∅] )(ω) µ(dω) = 0,

pois f I[∅] é nula q.s. Finalmente, sejam {Ak } uma sequência disjunta de conPn

S∞

.

.

juntos em F tal que k=1 Ak ∈ F , gn = f I[Snk=1 Ak ] =

k=1 f I[Ak ] e g =

S

. Temos que 0 ≤ gn ↑ g (sempre ou q.s?) e portanto, pelo Teorema

f I[ ∞

k=1 Ak ]

R

R

R

da convergência monótona, lim Ω gn dµ = Ω g dµ, ou seja, lim Ω f I[Snk=1 Ak ] dµ =

R

R Pn

P∞

P∞ R

lim Ω k=1 f I[Ak ] = k=1 Ω f I[Ak ] dµ = k=1 ν(Ak ) = Ω lim f I[Snk=1 Ak ] dµ =

R

S∞

¤

dµ = ν( k=1 Ak ).

f I[S∞

Ω

k=1 Ak ]

Definição 1. Dizemos que a medida ν : F → R+ definida por

Z

ν(A) =

f dµ, A ∈ F

A

tem densidade f com respeito à medida µ.

Definição 2. Sejam µ e ν medidas em (Ω, F). Dizemos que ν é absolutamente

contı́nua com respeito a µ quando para cada A ∈ F, µ(A) = 0 implicar que ν(A) = 0.

Observe que se ν tem densidade f com Rrespeito a Rµ então ν é absolutamente

contı́nua com respeito a µ. De fato, ν(A) = A f dµ = Ω f I[A] dµ = 0 se µ(A) = 0,

pois f I[A] ≡ 0 q.s.

O teorema de Radon-Nikodym é quase uma recı́proca para essa observação.

Antes,

Definição 3. Seja µ uma medida em (Ω, F). Dizemos que:

• µ é finita quando µ(Ω) < ∞.

• µ é σ-finita quando existir

S uma sequência {Ak }, Ak ∈ F finita ou

enumerável tal que Ω = Ak e µ(Ak ) < ∞.

Teorema 1. (Radon-Nikodym) Se µ e ν são medidas σ-finitas e ν é absolutamente

contı́nua

com respeito a µ então existe f não negativa, F-mensurável tal que ν(A) =

R

f

dµ

para

qualquer A ∈ F . Isto é, ν tem densidade f com respeito a µ.

A

Para a demonstração, veja Billinsgley, Teorema 32.2.

1

2

FABIO NISKI

2. Esperança Condicional

Definição 4. Seja X uma variável aleatória definida no espaço de probabilidade

(Ω, F, P), P-integrável e G é uma sub-σ-álgebra em F. Dizemos que a variável

aleatória E[XkG] é uma esperança condicional de X dado G, quando satisfazer as

seguintes propriedades:

(i) E[XkG] é G-mensurável e integrável.

(ii) E[XkG] satisfaz a seguinte equação funcional:

Z

Z

X d P, G ∈ G.

E[XkG] d P =

G

G

Lema 2. Existe uma variável aleatória E[XkG] com as propriedades da definição

anterior.

Demonstração. Inicialmente,

considere X não negativa. Defina uma medida ν em

R

(Ω, G) por ν(G) = G X d P. Como X é integrável, ν é finita e é absolutamente

contı́nua com respeito a P. Pelo

R teorema de Radon-Nikodym, existe uma função f ,

G-mensurável tal que ν(G) = G f d P. Assim, da integrabilidade de X segue a de

f e portanto essa f satisfaz as propriedades (i) e (ii). Se X não for necessáriamente

não negativa, considere a decomposição X = X + − X − e obtenha f + e f − . A

proposicão está provada pois f + − f − satisfaz as condições da definição anterior.

Perceba que aqui nada se afirmou sobre a unicidade da esperança condicional. De

fato, existem várias esperanças condicionais, basta alterar a função em conjuntos

de medida P-nula. As propriedades continuam sendo satisfeitas e chamamos cada

uma das esperanças condicionais de versão da esperança condicional.

¤

Observe que se G = {∅, Ω} então a esperança

condicional, por ser G-mensurável,

R

só

pode

ser

constante.

Disso,

vem

que

E[XkG]

d P = E[XkG] P(Ω) = E[XkG] =

Ω

R

X

d

P

ou

seja,

E[XkG]

=

E[X],

com

probabilidade

1. Observe também que para

Ω

G = F, X satisfaz todas a propriedades donde E[XkF] = X com probabilidade 1.

O próximo teorema lista algumas propriedades da esperança condicional. Todas

as igualdades e desigualdades valem com probabilidade 1. A prova destes resultados

está em Billingsley página 447. Daqui em diante, assume-se tacitamente que X é

uma variável aleatória definida no espaço (Ω, F, P) e G é uma sub-σ-álgebra de F.

Teorema 2. Sejam X, Y e Xn variáveis aleatórias integráveis

(i)

(ii)

(iii)

(iv)

(v)

Se X = a com probabilidade 1, então E[XkG] = a.

Se a e b são constantes, vale que E[aX + bY kG] = a E[XkG] + b E[Y kG].

Se X ≤ Y com probabilidade 1, então E[XkG] ≤ E[Y kG].

| E[XkG]| ≤ E[|X|kG].

Se limn Xn = X com probabilidade 1, |Xn | ≤ Y e se Y for integrável,

então limn E[Xn kG] = E[XkG] com probabilidade 1.

Teorema 3. Suponha que X é G-mensurável e que Y e XY são integráveis então,

com probabilidade 1 vale que

E[XY kG] = X E[Y kG].

Demonstração. Inicialmente, sejam G0 ∈ G e X = I[G0 ] . Temos que I[G0 ] E[Y kG] é

G-mensurável

e integrável

(pois I[G0 ] E[Y kG] R≤ E[Y kG]). Além disso,

R

R

R como vale que

E[Y

kG]

d

P

=

Y

d

P,

vem

que

I

E[Y

kG]

d

P

=

I

Y dP =

[G

]

0

G∩G0

G∩G0

G

G [G0 ]

MARTINGAIS

3

R

E[I[G0 ] Y kG] d P. Resulta portanto que X E[Y kG] é uma versão de E[XY kG]

G

quando X = I[G0 ] .

Pn

Agora para X =

k=1 xk I[Gk ] , com G1 , . . . , Gn ∈ G e x1 , . . . , xn constantes

reais, temos pelo o que acabamos de mostrar e pelo item (ii) do Teorema 2 que:

Z

Z

E[XY kG] d P =

E[x1 I[A1 ] Y + · · · + xn I[An ] Y kG] d P

G

Z

ZG

x1 E[I[A1 ] Y kG] d P + · · · + xn

E[I[An ] Y kG] d P

=

ZG

Z G

=

x1 I[A1 ] E[Y kG] d P + · · · +

xn I[An ] E[Y kG] d P

G

G

Z

X E[Y kG] d P

=

ZG

=

XY d P .

G

Como X E[Y kG] é G-mensurável e integrável, segue que X E[Y kG] é uma versão de

E[XY kG] para X simples.

Finalmente, seja X arbitrária e G-mensurável. Sabemos que existe uma sequência

{Xn } de funções simples, G-mensuráveis tais que |Xn | < |X| e limn Xn = X. Como

|Xn Y | ≤ |XY | e |XY | é integrável por hipótese, pelo item (v) do Teorema 2,

temos que limn E[Xn Y kG] = E[XY kG] com probabilidade 1. Resulta portanto que

X E[Y kG] = limn Xn E[Y kG] = limn E[Xn Y kG] = E[XY kG]. Como X E[Y kG] é Gmensurável (pois é limite de funções G-mensurável) e é integrável (pois, pelos itens

(iii) e (iv) do Teorema 2, |Xn E[Y kG]| = | E[Xn Y kG] ≤ E[|Xn Y |kG] ≤ E[|XY |kG],

que é integrável), resulta que X E[Y kG] é uma versão de E[XY kG], como querı́amos.

¤

Teorema 4. Sejam X uma variável aleatória integrável e G1 ⊂ G2 , sub-σ-álgebras

de F. Então com probabilidade 1 vale que

E[E[XkG2 ]kG1 ] = E[XkG1 ] = E[E[XkG2 ]kG1 ].

Demonstração. Para a primeira igualdade, temos que E[XkG2 ] é integrável portanto, pela definição de esperança condicional, E[E[XkG2 ]kGR1 ] é G1 -mensurável e inRtegrável, assim falta verificar o item (ii) da definição 4 isto é, GR E[E[XkG2 ]kG1 ] d P =

RG X d P para G ∈ GR1 . De fato, se G ∈ G1 então G ∈ G2 donde G E[E[XkG2 ]kG1 ] d P =

E[XkG2 ] d P = G X d P. Para a segunda, observe que E[XkG1 ] por ser G1 G

mensurável é também G2 -mensurável, assim da observação depois da prova da

Proposição 2 segue o que querı́amos.

¤

Teorema 5. Seja X uma variável aleatória integrável e G uma sub-σ-álgebra de

F. Se X for independente de G então, com probabilidade 1, vale que

E[XkG] = E[X].

Demonstração. Lembramos o leitor que dizer que X é independente de G é dizer que

a σ-álgebra gerada por X é independente de G. Note que como E[X] é constante,

4

FABIO NISKI

segue que E[X] ∈ G. Agora seja Λ ∈ G arbitrário. Temos que

Z

E[X] d P = E[X] P(Λ)

Λ

= E[X] E[I[Λ] ]

= E[X · I[Λ] ]

Z

=

X · I[Λ] ] d P

Ω

Z

=

X dP.

Λ

Donde resulta o que querı́amos.

¤

Vamos formalizar o conceito subjetivo de informação amarrando-o com o conceito de sub-σ-álgebra. Com isso, torna-se mais fácil a interpretação de resultados

probabilı́sticos envolvendo esperança condicional.

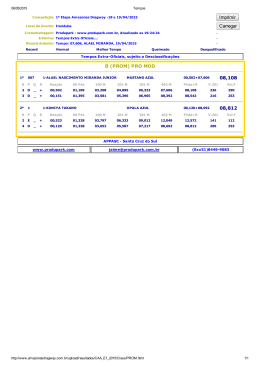

Considere um experimento que consiste no lançamento de 3 moedas nos instantes de tempo t1 , t2 e t3 . Seja Ω o espaço de todos os resultados possı́veis deste

experimento, isto é Ω = {HHH, HHT, HT H, HT T, T HH, T HT, T T H, T T T }. A

figura 1 ilustra as possibilidades deste experimento. Em t0 a única informação que

temos sobre o resultado do experimento (ω) é a trivial, isto é, ω é tal que ω ∈ Ω.

Em t1 temos mais informações sobre o possı́vel ω que irá ocorrer, de fato, agora

sabemos que ω ∈ {HHH, HHT, HT H, HT T } ou ω ∈ {T HH, T HT, T T H, T T T }.

Figura 1. Árvore de estados possı́veis.

Seja F1 a σ-álgebra gerada pela familı́a

{{HHH, HHT, HT H, HT T }, {T HH, T HT, T T H, T T T }}.

Dizer que um observador possui a informação F1 é dizer que para qualquer F ∈ F1

ele sabe se ω ∈ F ou se ω ∈

/ F . No caso do lançamento das moedas, é dizer que o observador conheçe o resultado do primeiro lançamento. Após o segundo lançamento,

obtemos mais informações. Sabemos agora que ω pertencerá a exatamente um dos

MARTINGAIS

5

conjuntos da famı́lia

{{HHH, HHT }, {HT H, HT T }, {T HH, T HT }, {T T H, T T T }},

sendo F2 a σ-álgebra gerada por esta famı́lia, dizer que o observador possui a

informação F2 é , equivalemente ao que escrevemos antes, conhecer o valor da

variável aleatória I[F ] para cada F ∈ F2 . O fato intuitivo de que a cada lançamento

o observador possui mais informações sobre o resultado do experimento, é expresso

pela inclusão F0 ⊂ F1 ⊂ F2 ⊂ F3 onde F0 é a σ-álgebra trivial e F3 é, neste caso,

a σ-álgebra gerada pela famı́lia

{{HHH}, {HHT }, {HT H}, {HT T }, {T HH}, {T HT }, {T T H}, {T T T }}.

Observe que no sentido que demos acima, ter a informação F0 é não saber nada e

ter a informação F3 é saber o resultado do experimento.

3. Martingais

3.1. Definição e exemplos.

Definição 5. Sejam X1 , X2 , . . . uma sequência de variáveis aleatórias definidas no

espaço de probabilidade (Ω, F, P) e F1 , F2 , . . . uma seqûencia de σ-álgebras de F.

Dizemos que a sequência {(Xn , Fn ) : n = 1, 2, . . .} é um martingal (discreto) quando

as quatro condições a seguir forem satisfeitas:

(i)

(ii)

(iii)

(iv)

{Fn } é uma filtração, isto é, Fn ⊂ Fn+1 .

{Xn } é adatpada à filtração, isto é, Xn é Fn -mensurável.

E[|Xn |] < ∞.

E[Xn+1 kFn ] = Xn , com probabilidade 1.

É usual dizer apenas que a sequência {Xn } é um martingal quando a filtração

estiver implı́cita no contexto. Se ao invés de (iv) valer, com probabilidade 1, que

E[Xn+1 kFn ] ≥ Xn ,

então a sequência {Xn } é chamada de submartingal. Se valer que

E[Xn+1 kFn ] ≤ Xn ,

dizemos que sequência é um supermartingal.

Apartir deste ponto, quando não for explicitada nenhuma filtração, subentendese que se trada da filtração natural gerada pela sequência de variáveis aleatórias,

isto é Fn = σ(X1 , . . . , Xn ).

R

R Pela definição de esperança condicional, temos para A ∈ Fn que A E[Xn+1 kFn ] d P =

X

d P. Agora, a condição (iv) da definição anterior diz que Xn é uma versão

A n+1

de E[Xn+1 kFn ] e como Xn é Fn -mensurável, a condição pode ser reescrita como

Z

Z

(1)

Xn+1 d P =

Xn d P, A ∈ Fn .

A

A

Como {Fn } é filtração, podemos,

por indução,

R

R repetir o argumento

R acima e concluir

que para A ∈ Fn vale que A Xn d P = A Xn+1 d P = . . . = A Xn+k d P. Isso

mostra que Xn é uma versão de E[Xn+k kFn ] para k ≥ 1. Vamos agora apresentar

alguns exemplos de martingais.

6

FABIO NISKI

Exemplo 1. Seja {Xn } uma sequência de variáveis aleatórias independentes, identicamente distribuidas e com média

Pn0 (Este processo é conhecido como Passeio

aleatório centrado) e defina Sn = k=1 Xn , n ≥ 0 (Y0 = X0 = 0). Com relação

à filtração Fn = σ(X0 , . . . , Xn ) = σ(S0 , . . . , Sn ), {Xn } e {Sn } são martingais. De

fato

E[Sn+1 kFn ] = E[Sn + Xn+1 kFn ]

= Sn + E[Xn+1 kFn ]

= Sn + 0.

Note que usamos o fato que Xn+1 é independente de Fn (a demonstração disso é

uma aplicação do Teorema 20.2 do Billinsgley) e o Teorema 5.

Exemplo 2. Seja {Fn } uma filtração no espaço de probabilidade (Ω, F, P) e seja

X uma variável aleatória integrável. Para cada n defina Xn = E[XkFn ]. Pela

definição de esperança condicional, Xn é integrável e Fn -mensurável. Temos então

que {Xn } é adaptada à filtração {Fn } e

E[Xn+1 kFn ] = E[E[XkFn+1 ]kFn ]

pela construção de Xn+1

= E[XkFn ]

pelo Teorema 4

= Xn

pela construção de Xn .

Exemplo 3. Sejam {Fn } uma filtração no espaço de probabilidade (Ω, F, P) e ν

uma medida finita em F. Suponha que P seja absolutamente contı́nua com respeito

a ν quando ambas medidas estão restritas a Fn . Pelo teorema de Radon-Nikodym,

existe uma densidade Xn de ν com respeito a P quando ambas estão restritas a Fn .

Então Xn é uma função Fn -mensurável e satisfaz

Z

Xn d P = ν(A), A ∈ Fn .

A

Pelo fato de Xn ser positiva (pois é densidade) e por ν ser finita segue que

Z

Xn d P = ν(Ω) < ∞,

Ω

ou seja, Xn é P-integrável. Pelo mesmo argumento considere

agora a densidade

R

Xn+1 . Como A

∈

F

implica

que

A

∈

F

temos

que

X

d P = ν(A), porn

n+1

n+1

A

R

R

tanto vale que A Xn d P = A Xn+1 d P e por (1) resulta que {Xn } é um martingal.

Exemplo 4. É muito útil enxergar os martingais em termos de jogos (de apostas

com dinheiro). Para isso, denote por ∆Xn = Xn − Xn−1 a variável aleatória que

representa o ganho de um jogador no n-ésimo jogo (vamos assumir que X0 = 0)

que é realizado nos instantes n = 1, 2, . . .. Um bom jogador mantém um registro

do seu capital disponı́vel jogo a jogo para que possa tomar as decisões da melhor

forma possı́vel. Modelamos esse fato dizendo que o jogador no instante k possui

a informação gerada pela filtração natural Fk = σ{Xi : i ≤ k} = σ{∆Xi : i ≤

k}. Assim, em um jogo honesto, imediatamente antes da n-ésima partida o jogador espera que seu ganho incremental seja 0 em média. Expressamos isso como

E[∆Xn kFn−1 ] = 0 mostrando como jogos honestos e martingais estão relacionados.

De forma análoga, os jogos favoráveis ao jogador são modelados como submartingais pois temos que E[∆Xn kFn−1 ] ≥ 0. Os jogos desfavoráveis ao jogador, tı́picos

de cassino, são supermartingais e evidentemente E[∆Xn kFn−1p. ] ≤ 0.

MARTINGAIS

7

O exemplo anterior mostrou como podemos interpretar martingais em termos de

jogos de apostas. Uma pergunta que possa ser natural para jogadores e é certamente

interessante para matemáticos é: Será que podemos transformar um jogo honesto

em um jogo favorável?. Para responder essa pergunta, precisamos antes de uma

Definição 6. Dada uma filtração {Fn }, dizemos que uma sequência de varı́aveis

aleatórias {Cn } é um processo previsı́vel quando, para n ≥ 2, Cn for Fn−1 -mensurável.

Voltando à pergunta, vamos interpretar um processo previsı́vel como uma estratégia de jogo. Cn representa a quantidade que será apostada na n-ésima partida.

É natural supor que Cn ≥ 0 e que exista um limite para as apostas, isto é, para

algum K ∈ [0, ∞) vale que Cn (ω) ≤ K para todo n e ω. O fato de ser um processo

previsı́vel diz intuitivamente que a escolha de Cn só pode depender das informações

que o jogador tem até a jogada n − 1. Nessas condições Ck (ω)∆Xk (ω) representa

Pk

quanto o jogador ganhou na k-ésima jogada e

j=1 Cj (ω)(∆Xk (ω)) representa

quanto o jogador ganhou até a k-ésima jogada. O próximo teorema mostra que a

resposta para a nossa pergunta é negativa.

Teorema 6. Seja (Ω, F, P) um espaço de probabilidade e {Fn } uma filtração. Se

{Xn } é um (sub/super)martingal e {Cn } um processo previsı́vel, positvo e limitado,

então a sequência {In } definida por

n

n

X

X

(2)

In (ω) =

Cj (ω)(∆Xj (ω)) =

Cj (ω)(Xj (ω) − Xj−1 (ω))

j=1

j=1

é um (sub/super)martingal também.

Demonstração. Perceba que In satisfaz os itens (i),(ii) e (iii) da definição 5. Vamos

mostrar que (iv) também vale. De fato,

E[In kFn−1 ] = E[In−1 + Cn ∆Xn kFn−1 ]

pela construção de In

= E[In−1 kFn−1 ] + E[Cn ∆Xn kFn−1 ] pela linearidade da esperança condicional

= In−1 + Cn E[∆Xn kFn−1 ]

pois In−1 ∈ Fn−1 e pelo teorema 3

= In−1 + Cn · 0

por hipótese.

E[In kFn−1 ] = In−1 e o teorema está provado. As afirmações referentes aos (sub/super)martingais

são provadas da mesma forma.

¤

O processo (2) é um exemplo de transformada

martingal de {Xn } por {Cn } e é a

R

versão discreta da integral estocástica C dX que estudaremos depois.

Como observação final, note que {Xn } é submartingal se e somente se {−Xn }

for um supermartingal. Por esta equivalência, para todos os resultados sobre submartingais existem os duais para supermartigais e vice versa. Além disso, {Xn } é

um martingal se e somente for um submartingal e um supermartingal. Disso, todos os resultados que valem para submartingais ou para supermartingais, também

valem para martingais.

3.2. Convergência de martingais. Vamos começar esta seção com um lema:

Lema 3. Seja (Ω, F, P) um espaço de probabilidade e {Fn } uma filtração. Se

(i) {Xn } for um martingal então E[X1 ] = E[X2 ] = . . .

(ii) {Xn } for um submartingal então E[X1 ] ≤ E[X2 ] ≤ . . .

(iii) {Xn } for um supermartingal então E[X1 ] ≥ E[X2 ] ≥ . . .

8

FABIO NISKI

Demonstração. Vamos provar (i). Pela discussão logo após a definição 5 vimos que

para A ∈ F1 e k ≥ 1 vale

Z

Z

X1 d P =

Xk d P

A

A

Tomando A = Ω, segue o resultado. A demonstração dos outros itens é análoga. ¤

Considere a < b dois números reais. Vamos denotar por UN (a, b) a variável

aleatória que indica a quantidade de upcrossings (ou atravessamentos pra cima???)

feitas pela sequência {Xn } até o instante N . Ela é definida como o maior k ∈

{0, 1, 2, . . .} tal que podemos encontrar

0 ≤ s1 < t1 < s2 < t2 < . . . < sk < tk ≤ N

onde

Xsi (ω) ≤ a,

Xti (ω) ≥ b

(1 ≤ i ≥ k).

Nosso objetivo agora será provar o seguinte resultado obtido por J. L. Doob

Teorema 7. Seja {Xn } um supermartingal. Então, UN (a, b), como definido acima,

satisfaz a seguinte desigualdade

E[UN (a, b)] ≤

E[(XN − a)− ]

.

b−a

Para demonstrar este teorema, vamos lançar mão da relação entre jogos e martingais. Considere então dois jogadores P e Q. O jogador P irá jogar N partidas

e seu dinheiro na n-ésima jogada será representado pela variável aleatória Xn . O

jogador Q adotará a seguinte estratégia: Antes do primeiro jogo começar, ele fixa

dois numeros a e b (a < b) e vai iniciar uma série de apostas na rodada que o

dinheiro de P ficar menor ou igual a a e terminará na rodada que o dinheiro de P

ficar maior ou igual a b. Esta estratégia pode ser representada como uma sequência

de variavéis aleatórias {Cn } definidas da seguinte maneira:

C1 = I[X0 ≤a]

e para n ≥ 2,

Cn = I[Cn−1 =1] I[Xn−1 ≤b] + I[Cn−1 =0] I[Xn−1 ≤a] .

Por essa construção, resulta que {Cn } é um processo previsı́vel em relação à σálgebra natural Fk = σ(X1 , . . . , Xk ) (ou seja é Fn−1 -mensurável pois existe uma

função mensurável f tal que para todo ω ∈ Ω, Cn (ω) = f (X1 (ω)), . . . , Xn−1 (ω)).

Assim,Pseja Yn o dinheiro do jogador Q até o instante n. Temos que Y0 = 0 e

n

Yn = j=1 Cj (Xj − Xj−1 ). Observe a cada upcrossings, o valor de o dinheiro do

jogador Q aumenta em pelo menos b − a unidades. Assim, sendo (XN (ω) − a)− a

pior perda possı́vel no ultimo intervalo de jogadas, resulta que

(3)

YN (ω) ≥ (b − a)UN (a, b)(ω) − (XN (ω) − a)− .

Com isso, estamos prontos para provar o teorema.

Demonstração. (do Teorema 7.) Temos que o processo {Cn } é previsı́vel, limitado e

não-negativo. Pelo Teorema 6 resulta que {Yn } é um supermartingal. Agora, como

Y0 = 0, temos pelo item (iii) do Lema 3 que E[YN ] ≤ 0. Finalmente, tomando o

valor esperado dos dois lados da desigualdade (3) temos

E[YN ] ≥ E[(b − a)UN (a, b) − (XN − a)− ]

MARTINGAIS

9

e usando que E[YN ] ≤ 0, resulta

E[UN (a, b)] ≤

E[(XN − a)− ]

.

b−a

Como querı́amos.

¤

Se {Xn } for um supermartingal representando o dinheiro de um jogador em uma

série de jogos, vimos que é razoável esperar que este dinheiro diminua conforme

as partidas são realizadas. Em termos de upcrossings esse fato é justificado pelo

seguinte

Corolário 1. Sejam {Xn } um supermartingal tal que supn E[|Xn |] < ∞ e a < b

.

números reais arbitrarios, então, definindo U∞ (a, b) = limN UN (a, b), temos que

P[U∞ (a, b) = ∞] = 0.

Demonstração. Como (Xn − a)− ≤ |Xn | + |a|, pelo Teorema 7 temos que

|a| + E[|XN |]

b−a

|a| + supn E[|XN |]

≤

.

b−a

E[UN (a, b)] ≤

Pelo teorema da convergência monótona, limN E[UN (a, b)] = E[U∞ (a, b)], donde

|a| + supn E[|XN |]

< ∞.

b−a

.

Agora suponha por absurdo que P[A] > 0 onde A = {ω ∈ Ω : U∞ (a, b)(ω) = ∞}.

Isso implica que

Z

Z

E[U∞ (a, b)] =

U∞ (a, b) d P +

X dP

A

Ω\A

Z

= ∞ · P[A] +

X dP

E[U∞ (a, b)] ≤

Ω\A

= ∞.

Esta contradição completa a demonstração.

¤

Agora estamos com condições para provar um dos principais resultados desta

seção

Teorema 8. (Teorema de convergência de Doob) Seja {Xn } um supermartingal.

Se supn E[|Xn |] < ∞ então, existe uma variável aleatória integrável X∞ tal que

limn Xn = X∞ com probabilidade 1.

Demonstração. Em primeiro lugar, lembramos que escrever b < lim sup Xn (ω) é o

mesmo que dizer que b é menor que o maior ponto de acumulação de {Xn (ω)}, que

é o mesmo que dizer que existe uma subsequência de {Xn (ω)} que converge para

um número maior do que b e isso finalmente implica que existem infinitos indı́ces

n tais que Xn (ω) > b. De forma análoga, a > lim inf Xn (ω) implica na existência

de infinitos indices n tais que Xn (ω) < a. Posto isso,

10

FABIO NISKI

.

Θ = {ω : Xn (ω) não converge em [−∞, ∞]}

= {ω : lim inf Xn (ω) < lim sup Xn (ω)}

[

=

{ω : lim inf Xn (ω) < a < b < lim sup Xn (ω)}.

a,b∈Q:a<b

.

Seja Θa,b = {ω : lim inf Xn (ω) < a < b < lim sup Xn (ω)}. Se ω ∈ Θa,b , então

sendo U∞ (a, b)(ω) como no Corolário anterior, temos, pela discussão inicial, que o

número de upcrossings é infinito. Disso resulta a inclusão

Θa,b ⊆ {ω : U∞ (a, b)(ω) = ∞}.

Agora, pelo Corolário anterior, P[Θa,b ] = 0 e assim,

[

X

Θa,b ≤

P[Θ] = P

a,b∈Q:a<b

P[Θa,b ] = 0.

a,b∈Q:a<b

Portanto está garantida a existência de X∞ = lim Xn com probabilidade 1. Vamos

agora mostrar que X∞ é integrável. De fato, pelo Lema de Fatou,

Z

Z

Z

|X∞ | d P =

lim inf |Xn | d P ≤ lim inf

|Xn | d P < ∞.

Ω

Ω

Ω

E isso termina a demonstração.

¤

3.3. Tempos de parada. Outros dois teoremas centrais da teoria dos Martingais

são Doob’s Optional Sampling e o Doob’s Optional Stopping Theorem. Para tratar

destes resultados, vamos introduzir o conceito de tempo de parada. Com o ferramental que desenvolvemos até agora, é possı́vel provar os teoremas citados acima para

tempos de parada finitos. Veremos que ao indroduzir o conceito de martingal uniformemente contı́nuo será possivel extender esses resultados para tempos de parada

não finitos e uma versão modificada do Teorema de convergência de Doob. De posse

destes resultados vamos, em um próximo capı́tulo, generaliza-los para martingais

continuos o que será crucial para desenvolver a teoria de integração estocástica.

Definição 7. Dizemos que uma variável aleatória T : Ω 7→ {0, 1, . . . ; ∞} é um

tempo de parada (com relação à filtração {Fn } quando

{ω : T (ω) ≤ n} ∈ Fn ,

∀n ≤ ∞.

Perceba que pela definição acima é S

necessário que {T = ∞} ∈ F∞ . Para lidar

.

com essa situação, definimos F∞ = σ( n≥1 Fn ).

Intuitivamente, podemos interpretar o tempo de parada como o instante em

que decidimos parar de jogar um jogo ou o instante em que exercemos uma opção

americana. A mensurabilidade de T diz que a decisão de T ≤ n ou não, é tomada

com base na informação disponı́vel até o instante n. Para modelos em tempo

discreto, é mais fácil verificar que T é um tempo de parada usando a seguinte

equivalência

Lema 4. T : Ω 7→ {0, 1, . . . ; ∞} é um tempo de parada se, e somente se

{ω : T (ω) = n} ∈ Fn ,

∀n ≤ ∞

MARTINGAIS

11

Demonstração. Se valer que {ω : T (ω) ≤ n} ∈ Fn ,

∀n < ∞ , então

{ω : T (ω) = n} = {ω : T (ω) ≤ n} \ {ω : T (ω) ≤ n − 1} ∈ Fn .

e

{ω : T (ω) = ∞} = Ω \ {ω :

[

T (ω) ≤ n} ∈ F∞ .

n≥1

Reciprocamente, se valer que {ω : T (ω) = n} ∈ Fn , ∀n ≤ ∞, então, para k ≤ n,

{ω : T (ω) = k} ∈ Fk ⊆ Fn e portanto, resulta que

[

{ω : T (ω) ≤ n} =

{ω : T (ω) = k} ∈ Fn .

k≤n

e

{ω : T (ω) ≤ ∞} = Ω ∈ F∞ .

¤

Lema 5. Sejam T1 e T2 tempos de parada e K um inteiro positivo. Então

(i) T1 ≡ K é um tempo de parada ;

(ii) T1 ∧ T2 = min{T1 , T2 } é um tempo de parada ;

(iii) TK = T1 ∧ K = min{T1 , K} é um tempo de parada finito.

Demonstração. Temos que {T = n} = Ω, quando n = K e {T = n} = ∅, quando

n 6= K. Isso prova a primeira T

afirmação. Para a segunda, note que para qualquer

n, {T1 ∧ T2 > n} = {T1 > n} {T2 > n} ∈ Fn . A última resulta das anteriores e

do fato que TK ≤ K.

¤

Será que um martingal interrompido continua sendo um martingal? Vamos responder esta pergunta e formalizar esse conceito. Sejam, então, um supermartingal

{Xn } e T um tempo de parada. Considere um jogo de apostas e a seguinte estratégia de um jogador: Sempre apostar uma unidade e parar imediamente depois

do instante T (ou da T -ésima jogada). A estratégia pode ser representada pela

(T )

(T )

sequência de variavéis aletórias {Cn } onde Cn (ω) = I[n≤T ] (ω). Vamos mostrar

(T )

que esta estratégia é um processo previsı́vel. De fato, Cn só pode assumir os

(T )

valores 0 ou 1 e portanto, {ω ∈ Ω : Cn (ω) = 0} = {ω ∈ Ω : T (ω) ≤ n} ∈ Fn−1 .

(T )

(T )

Como {ω ∈ Ω : Cn (ω) = 1} = Ω \ {ω ∈ Ω : Cn (ω) = 0} ∈ Fn−1 , resulta o que

(T )

querı́amos. Por construção, {Cn } é positivo e limitado. O ganho total do jogador

até a k-ésima jogada In , é calculado por

I0 (ω) = 0,

Ik (ω) =

k

X

Cn(T ) (ω)(Xj (ω) − Xj−1 (ω)),

k > 0.

j=1

Para ilustrar, veja que para ω ∈ Ω fixado tal que T (ω) = 4, temos para k = 6 que,

I6 (ω) = X4 (ω) − X0 (ω), e quando k = 3, I3 (ω) = X3 − X0 . De modo geral,

(4)

In (ω) = XT (ω)∧n (ω) − X0 (ω).

Essa discussão nos motiva à seguinte

Definição 8. Sejam {Xn } um supermartingal e T um tempo de parada, todos com

respeito à uma filtração {Fn }. Dizemos que {XT ∧n } é um processo parado em T .

e ao seguinte

12

FABIO NISKI

Teorema 9. (Teorema da parada opcional de Doob I). Sejam (Ω, F, P) um espaço

de probabilidade, {Xn } um supermartingal (martingal) e T um tempo de parada,

ambos com respeito à filtração {Fn }. Então o processo parado em T , {XT ∧n } é um

supermartingal (martingal) e vale que

E[XT ∧n ] ≤ E[X0 ]

(E[XT ∧n ] = E[X0 ]).

Demonstração. Pela discussão anterior, podemos usar In definido em (4) no Teorema 6. Segue portanto que In é um supermartingal (martingal). Assim,

E[In ] ≤ E[I0 ]

E[XT ∧n − X0 ] ≤ 0

E[XT ∧n ] ≤ E[X0 ].

Pelos mesmos argumentos, se {In } for um martingal resulta que

E[XT ∧n ] = E[X0 ].

Como querı́amos.

¤

Um exemplo importante de tempo de parada é o de first hitting time. Para definilo, considere um processo {Xn } adaptado à filtração {Fn } e seja B um boreliano

qualquer. TB : Ω → {0, 1, . . . ; ∞} definido por TB (ω) = inf{n ≥ 1 : Xn (ω) ∈ B} é

um tempo de parada (aqui usamos que inf ∅ = ∞). De fato, para k ≥ 2,

{TB = k} =

k−1

\

{Xj ∈

/ B} ∩ {Xk ∈ B} ∈ Fk

j=1

{TB = ∞} = Ω \

[

{TB ≤ n} ∈ F∞

n≥0

e para k = 1, {TB = 1} = {X1 ∈ B} ∈ F1 .

Considere agora um passeio aleatório centrado como no exemplo 1. Vimos que

{Sn } é um martingal e seja T = inf{n : Sn = 1} um tempo de parada. Sabe-se (ver

Williams pag 102) que P (T < ∞) = 1. Queremos saber se quando n → ∞ temos

E[ST ∧n ] → E[ST ]. Sabemos, pelo último teorema que E[ST ∧n ] = E[S0 ] = 0 mas

ST = 1 com probabilidate 1. Então a resposta à essa pergunta é negativa. Para ser

positiva, devemos acrescentar algumas hipóteses como mostra o próximo teorema.

Teorema 10. (Teorema da parada opcional de Doob II). Sejam (Ω, F, P) um espaço

de probabilidade, {Xn } um supermartingal (martingal) e T um tempo de parada,

ambos com respeito à filtração {Fn }. Então XT é integrável e vale que

E[XT ] ≤ E[X0 ]

(E[XT ] = E[X0 ]).

nas seguintes situações:

(i) Existe N ∈ N tal que T (ω) ≤ N, ∀ω;

(ii) Existe K ∈ R+ tal que |Xn (ω)| ≤ K, ∀(n, ω) ∈ (N × Ω) e T finito com

probabilidade 1.

(iii) E[T ] < ∞ e para algum K ∈ R+ ;

|Xn (ω) − Xn−1 (ω)| ≤ K

∀(n, ω) ∈ (N × Ω).

MARTINGAIS

13

Demonstração. Em primeiro lugar, sabemos do teorema anterior que o processo

{XT ∧n } é integrável e

(5)

E[XT ∧n − X0 ] ≤ 0,

pois {XT ∧n } é supermartingal.

Para o item (i), bastar usar (5) com n = N , assim

E[XT ∧N − X0 ] ≤ 0

E[XT ∧N ] ≤ E[X0 ]

E[XT ] ≤ E[X0 ].

Para o item (ii), temos que P {ω ∈ Ω : lim XT ∧n (ω) = XT (ω)} = 1 pois o limite

converge para XT em {ω ∈ Ω : T (ω) < ∞} que por hipótese tem medida 1. Além

disso |XT | ≤ K < ∞ e portanto E[XT ] < ∞, isto é, XT é integrável. Desses

.

resultados, seja fn = XT ∧n − X0 . fn é uniformemente limitada e converge com

probabilidade 1 para XT − X0 . Pelo teorema da convergência limitada, E[XT −

X0 ] = lim E[XT ∧n − X0 ] ≤ 0. Assim E[XT ] ≤ E[X0 ].

Para o item (iii), note que

|XT ∧n − X0 | = |

T

∧n

X

(Xk − Xk−1 | ≤ KT.

k=1

Agora, da hipótese que E[T ] < ∞, segue que KT é uma função integrável e sendo

fn como na demonstração do item (ii) temos que fn converge com probabilidade

1 para XT − X0 . Estamos nas condições do teorema da convergência dominada

que garante que XT é integrável e E[XT − X0 ] = lim E[XT ∧n − X0 ] ≤ 0. Portanto

E[XT ] ≤ E[X0 ]. Finalmente, perceba que todas os passos acima continuam válidos

se considerarmos o processo {Yn } = {−Xn } que é um submartingal. Disso resulta

que o teorema também vale para o caso de martingais e nesse caso E[XT ] = E[X0 ].

¤

Teorema 11. (Doob’s optional sampling for bounded stopping times). Sejam {Xn }

um supermartingal e T , τ tempos de parada limitados com T ≤ τ com probabilidade

1. Então

E[XT

Download