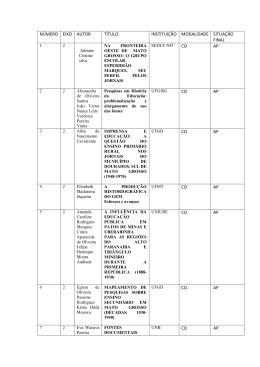

Escola Regional de Informática SBC Mato Grosso Apoio: Parceiro: Realização: Fundação de Amparo à Pesquisa do Estado de Mato Grosso INSTITUTO FEDERAL DE EDUCAÇÃO, CIÊNCIA E TECNOLOGIA MATO GROSSO UFMT PROCEV ORGANIZAÇÃO Comissão Organizadora Cristiano Maciel UFMT – (Coordenador Geral) Alexandre Martins dos Anjos - UFMT Andreia Gentil Bonfante – UFMT Claudia Aparecida Martins - UFMT Clodoaldo Nunes - IFMT Deive de Oliveira Souza - UFMT Eunice Pereira dos Santos Nunes - UFMT Evandro César Freiberger - UFMT Ivairton Monteiro Santos - UFMT-BG João Paulo Delgado Preti - UFMT Luciana Correia L. de Faria Borges - UFMT Mara A. Dota - UFMT-ROO Maurício Lima Pereira - UFMT Nielsen Cassiano Simões – UFMT Patricia Cristiane de Souza - UFMT Raul Teruel dos Santos - UFMT Wilnice Tavares Reis Oliveira - IFMT Alunos do Centro Acadêmico de Computação – UFMT Alunos da Empresa Junior em Computação da UFMT Alunos do Departamento da Área de Informática (DAI) – IFMT Comitê Científico Patricia Cristiane de Souza - UFMT (Coordenadora) Adriana Vivacqua – DCC-IM/UFRJ Andreia Gentil Bonfante - UFMT Ana Claudia Azevedo – IFMT Avanilde Kemczins - UDESC Claudia Aparecida Martins - UFMT Cristiano Maciel – UFMT Ed’ Wilson Ferreira – IFMT Gleber Nelson Marques – UNEMAT Idalmis Milián Sardiña – UFF Jésus Franco Bueno – UFMT José Viterbo - UFF Josiel Maimone de Figueiredo – UFMT Junia Anacleto – UFSCar Karina Valdivia-Delgado – USP Mauricio Fernando Pereira Lima – UFMT Nélson Tenório Junior. – CESUMAR Raul S. Wazlawick - UFSC Ruy de Oliveira – IFMT Ruy Ferreira – UFMT Valtemir do Nascimento – IFMT Vânia Neris - UNICAMP Wilnice Tavares Reis Oliveira - IFMT I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios SUMÁRIO A AVALIAÇÃO DO USO DE APLICATIVOS COMO PROPOSTA DE SUPRIR A CARÊNCIA DE SOFTWARES EDUCATIVOS PARA O ENSINO DE GEOGRAFIA . 8 Carlos José Braga da Silva .................................................................................................................................. 8 Juvenal Silva Neto ............................................................................................................................................... 8 A PARTICIPAÇÃO E A INTERAÇÃO DOS ALUNOS EM AMBIENTES VIRTUAIS DE APRENDIZAGEM: O USO DOS RELATÓRIOS DE ATIVIDADES DO MOODLE10 Danilo Garcia da Silva ....................................................................................................................................... 10 Kátia M. Alonso ................................................................................................................................................ 10 Cristiano Maciel ................................................................................................................................................ 10 ADAPTANDO PADRÕES DE ACESSIBILIDADE PARA GOVERNO ELETRÔNICO USANDO A PLATAFORMA LIFERAY ..................................................................... 12 Marco aurelio Campos ...................................................................................................................................... 12 Rômulo Prandini Lima ...................................................................................................................................... 12 Patricia Cristiane Souza ..................................................................................................................................... 12 Cristiano Maciel ................................................................................................................................................ 12 AMBIENTE WEB SOCIAL DE INFORMAÇÃO POLÍTICA ÚTIL AO CONTROLE E TRANSPARÊNCIA DA VIDA PÚBLICA ........................................................................................................................................ 14 AMBIENTES VIRTUAIS DE APRENDIZAGEM: O USO DOS RELATÓRIOS DE ATIVIDADES DO MOODLE NO CURSO DE PEDAGOGIA DA UFMT, ACORDO BRASIL/JAPÃO ........................................................................................................ 16 Danilo Garcia da Silva ....................................................................................................................................... 16 Kátia M. Alonso ................................................................................................................................................ 16 Cristiano Maciel ................................................................................................................................................ 16 ANÁLISE TÉCNICA DE ARQUITETURAS DE VIRTUALIZAÇÃO .......................... 18 André Valente do Couto .................................................................................................................................... 18 Claudio Toyoshy Onohara ................................................................................................................................. 18 Reginaldo Hugo S. Dos Santos.......................................................................................................................... 18 ARQUITETURA ORIENTADA A SERVIÇOS E COMPONENTES PARA GESTÃO AMBIENTAL ATRAVÉS DE IMAGENS MULTI-ESPECTRAIS................................ 20 Gustavo Liberatti ............................................................................................................................................... 20 Rodicrisller Rodrigues ....................................................................................................................................... 20 Josiel Maimone de Figueiredo ........................................................................................................................... 20 Cláudia Martins ................................................................................................................................................. 20 Andreia Gentil Bonfante .................................................................................................................................... 20 BENEFÍCIOS DE MVC PARA OS PROJETOS DE SOFTWARE ............................ 23 Robison Karls Custódio ..................................................................................................................................... 23 Wagner Santos Lino .......................................................................................................................................... 23 Ghanem Arfox ................................................................................................................................................... 23 CERBEROS: SOFTWARE LIVRE PARA ADMINISTRAÇÃO DO SQUID ............... 25 André L. L. De Oliveira .................................................................................................................................... 25 COMPUTADOR EMBARCADO BASEADO EM MICROCONTROLADORES ARM PARA APLICAÇÃO EM AGRICULTURA DE PRECISÃO ....................................... 28 Maurício Fernando Lima Pereira ....................................................................................................................... 28 Filipe Pereira Ferraz .......................................................................................................................................... 28 Wellington Sales Eugênio Santos ...................................................................................................................... 28 Elmo Batista de Faria ........................................................................................................................................ 28 Josiel Maimone de Figueiredo ........................................................................................................................... 28 Raul Teruel dos Santos ...................................................................................................................................... 28 CONSTRUÇÃO DE UMA BASE DE TREINAMENTO DE IDS UTILIZANDO O PROTOCOLO SNMP PARA CAPTURA DE DADOS EM UMA REDE 802.11 ........ 30 Filipe Araújo Molina ......................................................................................................................................... 30 Nelcileno Virgílio de Souza Araújo .................................................................................................................. 30 Ed’Wilson Tavares Ferreira............................................................................................................................... 30 I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios Ruy de Oliveira ................................................................................................................................................. 30 CONVERSÃO DE DIAGRAMA DE ATIVIDADES UML PARA SAN: GERAÇÃO DE CASOS DE TESTE DE SOFTWARE ........................................................................ 32 Toni Amorim de Oliveira .................................................................................................................................. 32 CRIAÇÃO DE MODELOS DE PRODUTIVIDADE DE SOJA PARA FIDELIZAÇÃO DE ASSOCIADOS EM COOPERATIVAS DE PRODUÇÃO..................................... 34 Gilso César Valiati ............................................................................................................................................ 34 Sandro da Silva Camargo .................................................................................................................................. 34 CRIAÇÃO DE MODELOS PREDITIVOS DE EVASÃO ESCOLAR ......................... 36 Fernanda Milani ................................................................................................................................................ 36 Sandro da Silva Camargo .................................................................................................................................. 36 DATA WEBHOUSE CEB-INEP – UM DATA WEBHOUSE A PARTIR DOS MICRODADOS DO CENSO ESCOLAR BÁSICO INEP/MEC .................................. 38 Fernando Maia da Mota..................................................................................................................................... 38 Leila Lisiane Rossi ............................................................................................................................................ 38 Marcelo Augusto Santos Turine ........................................................................................................................ 38 Alex de Lima Campelo ...................................................................................................................................... 38 DESENVOLVIMENTO DE UM SHELL DE COMANDOS PARA COMUNICAÇÃO COM MICRONTROLADORES ARM COM FREERTOS........................................... 40 Izandro Monteiro Metello .................................................................................................................................. 40 Josiel Maimone de Figueiredo ........................................................................................................................... 40 Maurício Fernando Lima Pereira ....................................................................................................................... 40 DESENVOLVIMENTO DE UM SIMULADOR MULTIMÍDIA PARA O ENSINO DE ESCALONAMENTO DE PACOTES ......................................................................... 42 Gustavo X. Santana ........................................................................................................................................... 42 Tatiana Annoni Pazeto ...................................................................................................................................... 42 ESTIMATIVA DE EVAPOTRANSPIRAÇÃO UTILIZANDO REDES NEURAIS ....... 44 Thiago Meirelles Ventura .................................................................................................................................. 44 ETIQUETAS INTELIGENTES - RFID ....................................................................... 46 Bruno Delanne Porto Dourado .......................................................................................................................... 46 Lidia Martins da Silva ....................................................................................................................................... 46 FORMAÇÃO TECNOLÓGICA CONTINUADA NAS ESCOLAS ESTADUAIS DA REGIÃO NORTE DE CUIABÁ – TRANSPONDO BARREIRAS .............................. 48 Elza Santos Moura de Jesus............................................................................................................................... 48 GCOMPRIS E A INCLUSÃO DIGITAL ..................................................................... 50 Laura M. S. Cunha ............................................................................................................................................ 50 Alex F. de Araújo .............................................................................................................................................. 50 Carlos A. S. J. Gulo ........................................................................................................................................... 50 GERENCIAMENTO E ARMAZENAMENTO DE DADOS MICROMETEOROLÓGICOS .................................................................................... 52 Allan Gonçalves de Oliveira.............................................................................................................................. 52 Thiago Meirelles Ventura .................................................................................................................................. 52 Josiel Maimone de Figueiredo ........................................................................................................................... 52 Claudia Aparecida Martins ................................................................................................................................ 52 Andréia Bonfante Gentil .................................................................................................................................... 52 HOTSPOT COM CAPTIVE PORTAL PARA ACESSO A INTERNET ...................... 54 André Valente do Couto .................................................................................................................................... 54 Wellyngton Rodrigues Siqueira......................................................................................................................... 54 INTEGRAÇÃO DE DADOS: UM ESTUDO DE CASO NA ÁREA EDUCACIONAL . 56 Maicon Ança dos Santos ................................................................................................................................... 56 Sandro da Silva Camargo .................................................................................................................................. 56 INTERFACE EM LINGUAGEM NATURAL USANDO AGENTES INTELIGENTES . 58 Marcos Eduardo Rizzi ....................................................................................................................................... 58 INTERNET NOS LABORATÓRIOS DE INFORMÁTICA DAS ESCOLAS, COMO ADMINISTRAR O USO? – UMA AÇÃO DE EXTENSÃO ........................................ 60 Francisco Sanches Banhos Filho ....................................................................................................................... 60 I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios Ralf Hermes Siebiger ........................................................................................................................................ 60 LINHA DE PRODUTOS DE SOFTWARE NO PROCESSO DE GERAÇÃO DE APLICAÇÕES WEB E-PARTICIPATIVAS ............................................................... 63 Edie Correia Santana ......................................................................................................................................... 63 Marcelo Augusto Santos Turine ........................................................................................................................ 63 Cristiano Maciel ................................................................................................................................................ 63 LINUX EDUCACIONAL: EXPERIÊNCIA DE ENSINO PARA ALUNOS ENTRE 9 E 13 ANOS DE ESCOLA PÚBLICA DE RONDONÓPOLIS-MT.................................. 65 Liana S. L. Mesquita ......................................................................................................................................... 65 Mirian S. Riva ................................................................................................................................................... 65 Luis Fernando Refatti ........................................................................................................................................ 65 Luzane Francisca Gomes ................................................................................................................................... 65 Mara Dota .......................................................................................................................................................... 65 MAPEAMENTO DAS AÇÕES REALIZADAS NO ÂMBITO DE UM CURSO DE LICENCIATURA EM INFORMÁTICA ....................................................................... 67 Leandro Arruda de Rezende .............................................................................................................................. 67 Soraia Silva Prietch ........................................................................................................................................... 67 Tatiana Annoni Pazeto ...................................................................................................................................... 67 MÉTODOS PRÁTICOS DE ESTEGANOGRAFIA DIGITAL ..................................... 69 Patrícia Ladislau Silva ....................................................................................................................................... 69 André Valente do Couto .................................................................................................................................... 69 Lídia Martins Silva ............................................................................................................................................ 69 O PROCESSO DE APRENDIZAGEM DE ESTRUTURA DE DADOS ATRAVÉS DA PRODUÇÃO DE VÍDEOS EDUCATIVOS................................................................. 71 Rodrigo A. Morbach .......................................................................................................................................... 71 Cleverson R. M. Fernandes ............................................................................................................................... 71 Soraia Silva Prietch ........................................................................................................................................... 71 O USO DE REDES SOCIAIS COMO MECANISMO DE INCLUSÃO SOCIAL NA PERIFERIA DE CUIABÁ .......................................................................................... 73 Taciane Garcez Maurício .................................................................................................................................. 73 Tadeusa Margarida de Melo .............................................................................................................................. 73 Cristiano Maciel ................................................................................................................................................ 73 ORGANIZAÇÃO E DISPONIBILIZAÇÃO DE CONTEÚDOS POR MEIO DE TAXONOMIA ............................................................................................................ 75 Aline Wollinger ................................................................................................................................................. 75 Custódio Gastão da Silva Júnior ........................................................................................................................ 75 OS PROFESSORES E A TECNOLOGIA: A QUALIFICAÇÃO TECNOLÓGICA NAS LICENCIATURAS DO CUR-UFMT ........................................................................... 78 Luzane Francisca Gomes ................................................................................................................................... 78 Prof. Dr. Ruy Ferreira ........................................................................................................................................ 78 PERSPECTIVAS SOBRE A INTERAÇÃO ENTRE ONTOLOGIAS E WEB SEMÂNTICA ............................................................................................................. 80 Adriana Cássia da Costa .................................................................................................................................... 80 Custódio Gastão da Silva Júnior ........................................................................................................................ 80 PLANEJAMENTO PARA REDES FWA BASEADO EM ALGORITMOS GENÉTICOS ............................................................................................................. 82 Aline Paulino Domingos de Souza .................................................................................................................... 82 Alexandre Torrezam .......................................................................................................................................... 82 André Valente do Couto .................................................................................................................................... 82 PORTAIS EDUCACIONAIS E CULTURA MIDIÁTICA: ESPECIFICAÇÃO DE REQUISITOS EM CONTEXTOS DE EXTENSÃO À DISTÂNCIA ............................ 84 Juvenal Silva Neto ............................................................................................................................................. 84 Gleber Nelson Marques ..................................................................................................................................... 84 PROCESSAMENTO DE CONSULTAS EM SISTEMA DE GERENCIAMENTO DE BANCO DE DADOS ................................................................................................. 86 Raphael de Souza Rosa Gomes ......................................................................................................................... 86 I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios Josiel Maimone Figueiredo ............................................................................................................................... 86 PRODUÇÃO DE INSTRUMENTO DE AVALIAÇÃO DE CURSOS DE GRADUAÇÃO E PROPOSTA DE APLICAÇÃO ESPECÍFICA EM UM CURSO DE LICENCIATURA EM INFORMÁTICA ................................................................................................... 88 Denise Pires Liceras .......................................................................................................................................... 88 Danilo Escobar .................................................................................................................................................. 88 Soraia Silva Prietch ........................................................................................................................................... 88 Tatiana Annoni Pazeto ...................................................................................................................................... 88 PROJETO DE INTERAÇÃO BASEADO EM CONTROLE 3D ................................. 90 Alexandre Torrezam .......................................................................................................................................... 90 Aline Paulino Domingos de Souza .................................................................................................................... 90 Diego Duarte Almeida ....................................................................................................................................... 90 PROJETO DE UM SISTEMA ONLINE DE AUXÍLIO À FISCALIZAÇÃO DA VIDA PÚBLICA DOS POLÍTICOS ..................................................................................... 92 PROJETO E IMPLEMENTAÇÃO DE UMA PLATAFORMA WEB PARA CONTROLE E GERENCIAMENTO DE REDES DE SENSORES SEM FIO ............ 94 Leonardo de Souza Alves .................................................................................................................................. 94 Otto Julio Ahlert Pinno da Silva ........................................................................................................................ 94 Maxweel Carmo ................................................................................................................................................ 94 PROPOSTA DE SOFTWARE EDUCATIVO PARA AUXILIAR NO PROCESSO DE ENSINO-APRENDIZAGEM DE MÉTODOS CLÁSSICOS........................................ 96 Thaís Santos Santana ......................................................................................................................................... 96 Nair Crisitina dos Santos Ribeiro ...................................................................................................................... 96 Simone Fátima Ferreira ..................................................................................................................................... 96 Soraia Silva Prietch ........................................................................................................................................... 96 PROPOSTA DE UM PROCESSO DE DESENVOLVIMENTO DE SOFTWARE PARA FACILITAR A INTEGRAÇÃO DA EQUIPE DE DESENVOLVIMENTO ........ 98 Maria Cristina Delgado Preti ............................................................................................................................. 98 Cristiano Maciel ................................................................................................................................................ 98 RECONHECIMENTO DE PADRÕES ATRAVÉS DA MODELAGEM E TREINAMENTO DE REDES NEURAIS UTILIZANDO BACKPROPAGATION MULTILAYER PERCEPTION IMPLEMENTADO EM SCILAB .............................. 100 André Valente do Couto .................................................................................................................................. 100 Gérson Kazuyoshi Kida ................................................................................................................................... 100 Marilson Oliveira Corrêa ................................................................................................................................. 100 REDES SOCIAIS E CONTROLE POLÍTICO .......................................................... 102 Ângelo Carlotto ............................................................................................................................................... 102 Frederico Scarcelli ........................................................................................................................................... 102 Gilberto Valandro ............................................................................................................................................ 102 Luís Márcio Resende ....................................................................................................................................... 102 Cristiano Maciel .............................................................................................................................................. 102 SHEEPBOT – UM MOTOR DE BUSCA E FORMADOR DE ONTOLOGIAS POLÍTICAS ............................................................................................................. 104 Suliane de Oliveira Carneiro ........................................................................................................................... 104 Custódio Gastão da Silva Júnior ...................................................................................................................... 104 SIMILARIDADE CONCEITUAL ENTRE DOCUMENTOS DE REQUISITOS USANDO O MODELO VETORIAL DE RECUPERAÇÃO DE INFORMAÇÃO ....... 107 Adriana Cássia da Costa .................................................................................................................................. 107 Custódio Gastão da Silva Júnior ...................................................................................................................... 107 UM ESTUDO COMPARATIVO DAS TÉCNICAS DE ELICITAÇÃO DE REQUISITOS: AMENIZANDO PROBLEMAS NO LEVANTAMENTO DOS REQUISITOS .......................................................................................................... 110 Luã Marcelo Muriana ...................................................................................................................................... 110 Cristiano Maciel .............................................................................................................................................. 110 I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios UM ESTUDO DAS ARQUITETURAS DE ARMAZENAMENTO DE DADOS VOLTADOS À WEB ............................................................................................... 112 Talita Finger .................................................................................................................................................... 112 Cristiano Maciel .............................................................................................................................................. 112 Banco de Dados, Web, Redes Sociais. ............................................................... 113 UM LEVANTAMENTO SOBRE SOFTWARES NO APRENDIZADO DE CRIANÇAS COM DEFICIENCIA NAS ESCOLAS PÚBLICAS DE RONDONÓPOLIS/MT........ 114 Arthur de Lima Lira......................................................................................................................................... 114 UM MODELO DE SISTEMA AUTOMATIZADO DE CLASSIFICAÇÃO DE ABELHAS BASEADO EM RECONHECIMENTO DE PADRÕES .......................... 116 Jésus Franco Bueno ......................................................................................................................................... 116 Bruna Elisa Zanchetta Buani ........................................................................................................................... 116 Antonio Mauro Saraiva ................................................................................................................................... 116 André Riyuiti Hirakawa .................................................................................................................................. 116 Tiago Maurício Francoy .................................................................................................................................. 116 Vera Lúcia Imperatriz-Fonseca ....................................................................................................................... 116 UMA ABORDAGEM DE BANCO DE DADOS ORIENTADO A OBJETOS NO CONTEXTO DE DESENVOLVIMENTO DE SOFTWARE ...................................... 119 Arthur Mendes Molina .................................................................................................................................... 119 Juliana Saragiotto Silva ................................................................................................................................... 119 UMA ABORDAGEM PARA REUTILIZAÇÃO DE MODELOS DE NEGÓCIOS EM LINHAS DE PRODUTO DE SOFTWARE ............................................................... 121 Edie Correia Santana ....................................................................................................................................... 121 Marcelo Augusto Santos Turine ...................................................................................................................... 121 Cristiano Maciel .............................................................................................................................................. 121 UMA ANÁLISE DAS PRÁTICAS DE IHC PARA ADOÇÃO EM PROCESSOS DE ENGENHARIA DE SOFTWARE ............................................................................. 123 Joyce Cristina Souza Bastos ............................................................................................................................ 123 Sandro Ronaldo Bezerra Oliveira .................................................................................................................... 123 UTILIZANDO POLLING COMO MECANISMO DE CONTROLE DE ACESSO AO MEIO EM REDES DE SENSORES PARA O CORPO HUMANO ........................... 125 Luís Fernando Refatti ...................................................................................................................................... 125 Tatiana Annoni Pazeto .................................................................................................................................... 125 WEB WIRELESS SENSOR MANAGER (W²SM) UMA PLATAFORMA PARA GERENCIAMENTO DE REDES DE SENSORES SEM FIO ................................... 127 Itamar Eduardo Gonçalves de Oliveira............................................................................................................ 127 Tatiana Annoni Pazeto .................................................................................................................................... 127 WEBQUEST “GÊNEROS DO DISCURSO”: UM PROCEDIMENTO DE ENSINOAPRENDIZAGEM DE LÍNGUA PORTUGUESA .................................................... 129 Niulian R. Carrijo ............................................................................................................................................ 129 Gleber N. Marques .......................................................................................................................................... 129 Marilena I. de Souza ........................................................................................................................................ 129 I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 8 A AVALIAÇÃO DO USO DE APLICATIVOS COMO PROPOSTA DE SUPRIR A CARÊNCIA DE SOFTWARES EDUCATIVOS PARA O ENSINO DE GEOGRAFIA 1 Carlos José Braga da Silva – [email protected] 1 Juvenal Silva Neto – [email protected] 1 – UNEMAT – Universidade do Estado de Mato Grosso – Alto Araguaia / MT. RESUMO Com o surgimento das novas tecnologias surgiram também novos recursos pedagógicos digitais para auxiliar o processo de ensino/aprendizagem nas escolas. É fato que os recursos tecnológicos contribuem de maneira significativa e atraente no ensino de conteúdos considerados difíceis de serem assimilados. Um dos recursos tecnológicos que corroboram com a educação são os softwares educativos, que constituem-se de ferramentas auxiliadoras do aprendizado de um domínio especifico como matemática, geografia, física, etc., e outros tipos de softwares que por sua vez não são desenvolvidos especificamente para a área educacional, mas que contemplam alguns requisitos básicos, permitindo que sejam utilizados no ensino - estes são apresentados aqui como sendo softwares educacionais. O trabalho a seguir avalia a utilização de quatro softwares aplicativos gratuitos, todos aproveitados na disciplina de geografia, com os alunos da 8ª série do Ensino Fundamental, com o intuito de definir quais seriam os requisitos básicos de um software para ser considerado educacional. Para isto, nos orientamos pela metodologia de avaliação proposta por Thomas Reeves apud Campos (1996), que considera tanto os aspectos pedagógicos quanto os de qualidade de uso da interface do software. Os softwares escolhidos para a avaliação foram o Google Earth, Sun Times, Altas Eletrônico Rodoviário do Estado de Mato Grosso e Atlas de Desenvolvimento Humano no Brasil por serem bastante populares e conhecidos pelo realizador desta pesquisa. Utilizou-se para o levantamento dos requisitos os critérios de Reeves, que se orienta por meio de um checklist gráfico com avaliação por escala em dois sentidos. À direita, o conceito mais positivo e, à esquerda, o conceito mais negativo. Reeves em seu método de avaliação de software educacional define duas abordagens para serem usadas na analise e avaliação de software educacional, sendo que a primeira consiste em fazer a análise de quatorze critérios pedagógicos: epistemologia, filosofia pedagógica, psicologia subjacente, objetividade, seqüencia instrucional, validade experimental, papel do instrutor, valorização do erro, motivação, estruturação, acomodação de diferenças individuais, controle de aluno, atividade do usuário, aprendizado cooperativo. A segunda abordagem refere-se a analise de dez critérios relacionados à interface com o usuário: facilidade de uso, navegação, carga cognitiva, mapeamento, design de tela, compatibilidade do conhecimento, apresentação da informação, integração das mídias, estética, funcionalidade geral. O software Google Earth foi utilizado na tarefa de localizar a BR 364 e ver por quais Estados ele está presente. Quanto ao software Sun Times, os alunos fizeram comparações entre os fusos horários do Brasil. O software Atlas Eletrônico Rodoviário do Estado de Mato Grosso foi utilizado no cálculo das distâncias entre o município de Alto Araguaia-MT e outros municípios. O software Atlas de Desenvolvimento Humano no Brasil utilizado para apresentar a densidade demográfica urbana e rural do município de Alto Araguaia-MT, analisando o crescimento das populações do ano de 1991 a 2000. Após a utilização dos softwares os alunos receberam um questionário contendo I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 9 quatorze perguntas baseadas nos critérios de Reeves, com as respostas em formato de escala iniciando em um (conceito mais negativo) até cinco (conceito mais positivo). O único software avaliado que não atendeu minimamente aos critérios pedagógicos e que também foi reprovado nos critérios relacionados à interface foi o Sun Times. Alguns dos critérios que foram avaliados negativamente pelos alunos no referido software foram: facilidade de leitura da tela, clareza dos comandos, adaptabilidade ao nível do usuário, tempo de resposta, existência de tratamento de erro, adequação ao vocabulário, etc. Nesta pesquisa pode-se descobrir que de quatro softwares aplicativos sugeridos, três foram considerados potenciais para o uso na educação uma vez que receberam mais de 60% (sessenta porcento) de avaliações positivas dos alunos em um processo que visou destacar aspectos pedagógicos e qualidades relacionadas à interface. Uma vez sendo considerados eficientes como ferramenta de auxílio ao processo de ensino/aprendizagem, os softwares aplicativos podem inclusive atender às diversas necessidades pedagógicas de aplicações multimídia, simulações, modelagens, jogos, tutoriais, etc, na disciplina de geografia quanto em outras disciplinas escolares. Da mesma forma que há certa dificuldade em se encontrar softwares educativos variados e suficientes para as diversas áreas da educação, também nos deparamos com vários softwares educativos que não abrangem plenamente os conteúdos vistos em sala de aula. Sugerimos aqui, visando amenizar essa deficiência, a utilização de softwares aplicativos que possam atender às propostas educacionais de forma aderente aos objetivos de ensino/aprendizagem, que, verificados e validados a partir de um processo de avaliação simples e adequado como o método de Reeves, podem se tornar ferramentas muito úteis para professores e alunos. PALAVRAS-CHAVE Avaliação de Software, Ensino de Geografia, Requisitos de Software, Software Educacional. TIPO DE TRABALHO: TRABALHO DE GRADUAÇÃO I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 10 A PARTICIPAÇÃO E A INTERAÇÃO DOS ALUNOS EM AMBIENTES VIRTUAIS DE APRENDIZAGEM: O USO DOS RELATÓRIOS DE ATIVIDADES DO MOODLE 1 Danilo Garcia da Silva – [email protected] 2 Kátia M. Alonso – [email protected] 3 Cristiano Maciel – [email protected] 1 – UFMT – Universidade Federal de Mato Grosso - Cuiabá / MT 2 – UFMT – Universidade Federal de Mato Grosso - Cuiabá / MT 3 – UFMT – Universidade Federal de Mato Grosso - Cuiabá / MT RESUMO Este trabalho apresenta os resultados parciais de uma pesquisa de mestrado que investiga que recursos presentes no Ambiente Virtual de Aprendizagem – AVA Moodle permitem identificar a participação e a interação dos sujeitos da aprendizagem. Objetivamos verificar se é possível mensurar o nível de participação e de interação dos alunos através dos relatórios de atividades do Moodle. As conclusões admitem que os dados armazenados por estes recursos seguem a perspectiva de relatórios computacionais, sendo, portanto, dados quantitativos passíveis de análises qualitativas podendo contribuir no processo de avaliação da aprendizagem, mas que não são usados pelos atores da formação. O curso de Licenciatura em Pedagogia a distância, acordo Brasil/Japão, coordenado pela Universidade Federal de Mato Grosso (UFMT) em parceria com a Universidade de Tokai, é realizado no AVA/Moodle. Entendemos que os AVA podem possibilitar maior dinamicidade e flexibilidade ao processo de ensino e aprendizagem. Frente a essas possibilidades não se pode desconsiderar também as limitações que estes ambientes investem no trabalho cotidiano com eles. Dessa forma, nos questionamos como mensurar a participação e a interação dos alunos nos cursos em AVA? Partimos da compreensão de que a participação pode ser entendida como troca de ações, controle e modificação de conteúdos e relações. Pode ser gerada na interação do indivíduo com o meio físico e social. Abstraindo para o contexto do AVA, a participação seria ações como: o acesso ao ambiente, o envio mensagens, a postagens em fóruns, o envio de arquivos e a visualização de conteúdos, entre outros. A interação, entretanto, refere-se a mecanismos vivos – comportamentos e atitudes - que se transformam de acordo com as ações e operações fomentadas em um determinado espaço (PRIMO, 2000, p. 02)1. No AVA temos a possibilidade do acompanhamento da frequência e da produção de cada aluno, uma vez que possuem uma base de dados que armazena/pode armazenar a frequência e assiduidade (data e hora de acessos ao ambiente, data e hora de acessos a cada um dos recursos disponíveis nestes “espaços”) (BASSANI & BEHAR, 2006, p. 01)2. A interação ocorre na inter-relação dos sujeitos e nas potencialidades, possíveis de serem exploradas, entre o indivíduo e o ambiente (com seus recursos 1 PRIMO, Alex. Interação mútua e reativa: uma proposta de estudo. Revista da Famecos, n. 12, p. 81-92, jun. 2000. 2 BASSANI, Patricia. B. Scherer, BEHAR, P. A. Análise das interações em ambientes virtuais de aprendizagem: uma possibilidade para avaliação da aprendizagem em EAD.RENOTE: V. 4 Nº 1, Julho, 2006. I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 11 tecnológicos), influenciando o próprio pensamento e a tomada de consciência de cada um dos indivíduos participantes de um processo de formação. Em termos metodológicos usamos a abordagem qualitativa3 do tipo estudo de caso4. Coletamos dados através dos relatórios de atividades do Moodle e realizamos entrevistas com seis orientadores acadêmicos e dois professores especialistas. Estes dados comporam o corpus da pesquisa. Investigamos se os sujeitos usavam e qualificavam os dados dos relatórios para se mensurar a participação e a interação dos alunos como subsídios para a avaliação da aprendizagem. Os dados dos relatórios de atividades permitiram identificar quais eram os orientadores e professores que mais participavam no curso. Com as entrevistas constatamos que, ainda que fossem os sujeitos que mais participaram e interagiram no AVA, os professores e os orientadores não consideram as informações de participação e de interação armazenadas pelos relatórios de atividades como elementos para a avaliação dos alunos. A participação e a interação são consideradas ao se avaliar a qualidade da produção e as atividades que os alunos realizavam. Logo, os relatórios do Moodle são colocados em segundo plano ou não são utilizados em suas práticas pedagógicas. Ao invés disso, anotam, em planilhas ou manualmente em agendas, as informações sobre os sujeitos da aprendizagem. A ênfase do processo de aprendizagem se restringe ao resultado, ou seja, as produções entregues e avaliadas pelos professores e orientadores. Mediante o exposto, os dados evidenciaram que os relatórios de atividades do Moodle não são utilizados como complementares a prática docente e que a participação e a interação dos alunos limitam-se à realização das atividades. Os sujeitos não se apóiam nos dados destes relatórios como elementos constituintes da avaliação dos alunos no curso que são substituídos por anotações, das mais variadas possíveis, como: planilha em Excel, tabelas no Word, anotações em agenda, entre outros. Esta pesquisa está ainda em andamento, porém, as análises preliminares apontam a necessidade de maior entendimento, por parte dos atores do processo formativo, sobre os relatórios de atividades do Moodle de forma que estes agreguem novas dinâmicas e possibilidades ao trabalho pedagógico. PALAVRAS-CHAVE Participação. Interação. Ambientes Virtuais de Aprendizagem. Moodle. TIPO DE TRABALHO: Dissertação de Mestrado 3 Caracteriza-se por coletar os dados diretamente do ambiente natural e por coletar dados predominantemente descritivos. LÜDKE, Menga e ANDRÉ, Marli E. D. A. Pesquisa em educação: abordagens qualitativas. São Paulo: EPU, 1986. 4 O estudo de caso serve tanto para coleta de dados numa abordagem qualitativa quanto quantitativa frente aos inúmeros instrumentos e técnicas (amostra por cota, amostra de bola de neve, busca de exceções) e que podem ser empregados tanto para a coleta quanto para a análise dos dados. COHEN, Louis; MANION, Lawrence. Métodos de Investigación Educativa. Traducción: Francisco Agudo López. Editorial La Muralla. S.A. 1990. I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 12 ADAPTANDO PADRÕES DE ACESSIBILIDADE PARA GOVERNO ELETRÔNICO USANDO A PLATAFORMA LIFERAY 1 Marco aurelio Campos - [email protected] 1 Rômulo Prandini Lima – [email protected] 1 Patricia Cristiane Souza - [email protected] 1 Cristiano Maciel - [email protected] 1 – UFMT – Universidade Federal de Mato Grosso - Cuiabá / MT RESUMO A adoção de meios eletrônicos para a prestação dos serviços governamentais exige que sítios e portais desenvolvidos e mantidos pela administração pública sejam fáceis de usar, relevantes e efetivos. O governo definiu então um modelo de acessibilidade (e-MAG, disponível em: http://www.governoeletronico.gov.br/acoes-e-projetos/e-MAG) que contem cartilhas com recomendações sobre usabilidade, redação, codificação, manutenção e arquitetura de informação e desenho que orientam o desenvolvimento de páginas, tornando mais fácil a navegação e a acessibilidade de pessoas com necessidades especiais que procuram os serviços eletrônicos disponíveis nos sítios e portais por outros canais além da Internet. Entretanto, o Censo da Web (http://www.cgi.br/publicacoes/pesquisas/govbr/cgibr-nicbrcensoweb-govbr-2010.pdf e http://www.w3c.br/palestras/2009/projeto-censoweb/slidy/template.html), estudo pioneiro no mundo, realizado pelo Comitê Gestor da Internet, avaliou no mês de agosto de 2010, em uma primeira fase, sites governamentais do domínio “.gov.br”. Entre as constatações apuradas no levantamento está o fato de apenas 2% dos sites pesquisados apresentarem algum tipo de conformidade com resoluções internacionais de acessibilidade para sítios governamentais. O grupo de pesquisa em governo eletrônico do Laboratório de Ambientes Virtuais Interativos (LAVI), da UFMT adotou o ambiente Liferay como framework para desenvolvimento de aplicações e-participativas na web e pretende aplicar as normas do e-MAG, além de algumas das recomendações sobre acesso e navegação das cartilhas disponibilizadas dentro do ambiente (http://www.w3.org/WAI/ e http://www.liferay.com/community/wiki//wiki/Main/Accessibility+Guidelines). O Liferay é um portal web feito com tecnologia Java usado para hospedar aplicações como e-mail, blog ou wiki. Por possibilitar várias páginas hospedadas em um mesmo portal ele se torna uma opção viável para sítios governamentais. Seguindo as recomendações disponibilizadas pelo governo sobre e-MAG esta pesquisa visa estabelecer algumas diretrizes para o desenvolvimento com o uso do Lifeay. Os pontos marcados como mais importantes a serem avaliados são: o uso de arquivos externos para folhas de estilo e scripts, os recursos de impressão e URLs amigáveis, o uso correto dos elementos HTML, o funcionamento sem o “www” e com CSS desabilitado. Munidos do checklist do e-MAG (http://www.governoeletronico.gov.br/biblioteca/arquivos/checklist-manual-deacessibilidade-desenvolvedores) fornecida pelo governo podemos avaliar de forma direta quais pontos estão em conformidade e quais precisam ser modificados. A partir de agora nosso trabalho será focado na analise e adaptação do material gerado com o Liferay as necessidades de um portal governamental, enfocando a acessibilidade oferecida por ele. Com o avanço do projeto pretendemos identificar e corrigir quaisquer falhas na acessibilidade existentes I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 13 dentro da ferramenta utilizada. A priori, pelas pesquisas realizadas, essa ferramenta apresenta o mínimo de conformidade com instruções internacionais sobre acessibilidade definidas pelo comitê gestor de internet, trazendo certas facilidades para as adaptações necessárias. PALAVRAS-CHAVE Governo eletrônico, usabilidade, acessibilidade, portal, Liferay TIPO DE TRABALHO: Iniciação Científica AGENCIA FINANCIADORA CNPq I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 14 AMBIENTE WEB SOCIAL DE INFORMAÇÃO POLÍTICA ÚTIL AO CONTROLE E TRANSPARÊNCIA DA VIDA PÚBLICA Alexandre Bossa Perotto¹ – [email protected] Guilherme Felipe Schultz¹ – [email protected] Gustavo Liberatti¹ – [email protected] Luiz Henrique Padilha Godinho¹ – [email protected] Cristiano Maciel¹ - [email protected] ¹UFMT – Universidade Federal de Mato Grosso – Cuiabá/MT RESUMO A nossa sociedade é carente de informação sobre a política em geral, ou seja, é difícil encontrar noticiários atrativos acerca do tema, pois o foco gira em torno de escândalos e fatos midiáticos. Isto posto um trabalho acadêmico foi iniciado com o intuito de abrir os olhos da sociedade referente à cognição política salvaguardando os limites da matéria proposta (Engenharia de Software no curso de Ciência da Computação). A pesquisa objetivou a criação de uma web page (um sistema propriamente dito) que tem como base centralizar notícias e prover uma interação em forma de softwares sociais, mesclando politização com um “organismo vivo” da rede social. Esta dinâmica prima por dois elementos de software social: relacionamentos e grupos, segundo o contexto de Gene Smith. Com o desenvolvimento do sistema proposto pretende-se atrair o eleitor para imergir ao mundo político agregando a ele possibilidades de pesquisar e obter informação sobre conteúdos de seu interesse, bem como tentar aproximar o cidadão comum ao seu representante político, com o intuito de amenizar a barreira e o preconceito existente na população brasileira referente à temática. Para tanto, o desenvolvimento do sistema organizou-se em: análise, projeto e prototipação, com vista a futura implementação. Para tanto, realizou-se em primeira instância uma análise de mercado a fim de definir o grau de inovação da ideia proposta. Ainda no primeiro momento a parte de gerência de projeto foi realizada, como a criação dos requisitos, marcos, atividades, técnicas de elicitação, análise de riscos, cronogramas, formação de equipes, prototipações, entre outros fatores cruciais para o desenvolvimento de um bom projeto. Em um segundo momento, realizado na disciplina subsequente (Tópicos Especiais em Engenharia de Software), foi aplicado a técnica de elicitação de requisitos “questionário”. Neste, inicialmente foi definido o instrumento, o público alvo, o tipo de amostragem e forma de aplicação. Como amostragem, se optou pelas não probabilísticas acidental/convencional e intencional, pois elas são qualificadas para atender o público alvo do sistema proposto, com isso aplicou-se o questionário de forma presencial (questionários impressos) e não presencial (web page). Ao final, 189 (cento e oitenta e nove) questionários foram respondidos e houve poucas respostas inconsistentes. Diretamente o resultado impactou em um objeto avaliável, ou seja, apresentável, no caso uma prototipação de alto nível, derivada de uma prototipação manual (storyboard). Os protótipos atenderam as expectativas para a primeira versão, pois apresentaram os conceitos esperados, como informações em geral sobre política e elementos de redes sociais, além de atender as propostas criadas na fase de projeto como: requisitos funcionais, planejamento do projeto, especificações de caso de uso, entre outros elementos essenciais para o desenvolvimento do protótipo. Buscando analisar o impacto do I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 15 projeto na comunidade eleitoral e definir um perfil de usuário a pesquisa realizada revelou que a maioria esmagadora utiliza a Internet diariamente e 72% (setenta e dois por cento) gostariam de ter conversas diretas com políticos (em chat, por exemplo). Em geral, os questionados consideram a política brasileira não transparente, o que valoriza a proposta. O perfil traçado irá impactar de forma sucinta no projeto criado, mostrando que os próximos protótipos devem seguir uma linha mais voltada a redes sociais e com conteúdos em foco, para atrair o eleitor, além de disponibilizar informações relevantes por meio de mensagens instantâneas (sms), e-mails, entre outros métodos de disponibilização. Apesar de a comunidade apresentar-se distanciada do monitoramento políticos o eleitor demonstrou grande interesse no projeto, como ferramenta a facilitar sua interação com seus representantes, resultando em uma aceitabilidade teórica de 90% dentro os abordados e 69% do total afirmaram que utilizariam o sistema. Infelizmente o projeto possui uma falha crucial, aqueles que não possuem acesso ao mundo digital ficarão impedidos de usufruir do sistema, porém os governos estaduais do Rio de Janeiro, Espírito Santo e Mato Grosso, na figura dos programas Internet para todos e Internet Comunitária disponibilizam pontos de acesso à rede e inclusão digital para tentar mudar o patamar de inclusão da população brasileira, o que facilita o acesso ao sistema proposto. O povo brasileiro que tem acesso pode ou não estar suficientemente preparado para utilizar um sistema político como esse, porém só o tempo confirmará este conceito. PALAVRAS CHAVE: Fiscalização, política, sociedade, redes sociais, interação. Tipo de Trabalho: Trabalho de disciplina de graduação I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 16 AMBIENTES VIRTUAIS DE APRENDIZAGEM: O USO DOS RELATÓRIOS DE ATIVIDADES DO MOODLE NO CURSO DE PEDAGOGIA DA UFMT, ACORDO BRASIL/JAPÃO 1 Danilo Garcia da Silva – [email protected] 1 Kátia M. Alonso – [email protected] 1 Cristiano Maciel – [email protected] 1 – UFMT – Universidade Federal de Mato Grosso - Cuiabá / MT RESUMO Os Ambientes Virtuais de Aprendizagem (AVA), como espaços educacionais, são possíveis de agregar eficiência ao processo de ensino e aprendizagem, porque, podem permitir novas ações comunicativas que considere as peculiaridades da interação entre os sujeitos da aprendizagem. As relações de aprendizagem decorrem dos processos estabelecidos entre os sujeitos da prática educativa e com o ambiente compartilhado. A expansão dos AVA fortalecida pelo constante desenvolvimento das Tecnologias da Informação e da Comunicação (TIC) tem, nestes espaços, novas promoções de mudanças nos processos educacionais. Novas formas e possibilidades pedagógicas são estimuladas e exigidas, pois AVA são programas computacionais que visam servir de apoio aos processos de ensino e aprendizagem promovendo outras possibilidades de interação. Nesta pesquisa, parte de nosso trabalho de mestrado, indicamos alguns resultados preliminares que nos permitem algumas análises parciais quanto ao uso dos relatórios de atividades do Moodle para o acompanhamento dos alunos no curso. Os avanços tecnológicos têm permitido o estabelecimento de redes mundiais de comunicação, permitindo a produção e trocas de informações em tempos antes imaginados. Nesse contexto, os indivíduos precisam desenvolver capacidades e habilidades de usar e adaptar essas tecnologias às suas próprias necessidades de forma a entender o seu próprio ambiente. Por se tratarem de recursos relativamente novos, vemos como importante a realização de pesquisas e estudos para melhor entender os AVA e as TIC. Assim, com nossa pesquisa de mestrado objetivamos analisar as funcionalidades dos relatórios de atividades do Moodle, na visão dos orientadores acadêmicos5, na perspectiva do acompanhamento dos alunos no curso, de forma que essa compreensão possa dinamizar os processos educacionais em AVA. Realizamos uma pesquisa qualitativa, do tipo estudo de caso, que resulta diretamente das análises dos dados recolhidos (Carmo e Ferreira, 1998). O curso investigado é o de Licenciatura em Pedagogia a distância, acordo Brasil/Japão, criado no AVA Moodle. São 300 alunos inscritos e alocados, no ambiente virtual, organizado em 15 turmas de 20 alunos e cada turma conta 1 professor especialista6 por área de conhecimento, 2 orientadores acadêmicos e 1 coordenador de orientadores acadêmicos. A escolha do Moodle se deve ao fato de ser este o ambiente utilizado no curso investigado e também nos cursos ofertados pela Universidade Aberta do Brasil na Universidade Federal de Mato Grosso. Analisamos os relatórios de atividades porque estes armazenam dados quantitativos de acesso e participação em atividades do curso, passíveis de análises qualitativas. Buscamos identificar se os relatórios de atividades do I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 17 Moodle possibilitam acompanhar os alunos no curso e identificar o percurso trilhado por estes sujeitos. Os instrumentos de coleta de dados foram: observação direta, questionário e entrevista semi-estruturada, aplicados aos dezessete orientadores acadêmicos que participam do curso. Pelo fato de a pesquisa estar em curso, vimos, na leitura preliminar dos dados obtidos, que os orientadores acadêmicos desconhecem as funcionalidades dos relatórios de atividades do Moodle ou, quando as conhecem, não conseguem significar as informações armazenadas de forma a subsidiar o acompanhamento dos alunos. Assim, o acompanhamento dos sujeitos é realizado verificando, em cada uma das atividades, se os alunos as desenvolveram. Mesmo em se tratando de um curso na modalidade EaD, alguns sujeitos informaram que o acompanhamento seria mais efetivo caso houvessem mais encontros presenciais os quais fortaleceriam os processos interacionais e garantiriam um acompanhamento mais efetivo dos alunos. Pelo que vimos discorrendo, precisamos compreender os sujeitos envolvidos nos processos educacionais como construtores de seu próprio conhecimento. Para Moraes (1997, p.23) esta construção se dá não apenas com o uso predominante do raciocínio e da percepção do mundo exterior pelos sentidos, mas também usando as sensações, os sentimentos, as emoções e a intuição para aprender. Nesse sentido, entendemos que o acompanhamento dos alunos pode fortalecer esses laços com vistas à aprendizagem. Evidencia-se que os recursos do AVA não substituem todos os processos educacionais. Logo, o acompanhamento dos alunos se efetiva através da intervenção e mediação dos orientadores acadêmicos, e estes realizam uma verdadeira “garimpagem” para identificar a participação dos alunos em cada uma das atividades. Por outro lado, precisamos considerar o potencial que os relatórios de atividades agregam ao trabalho docente e que podem contribuir com suas práticas pedagógicas em cursos mediados por AVA melhorando, também, as nossas percepções sobre eles. Entretanto, pelo caráter incipiente desta pesquisa, não desconsideramos a possibilidade de, em sua continuidade, novas perspectivas e horizontes se apresentarem permitindo-nos novas leituras e compreensões. PALAVRAS-CHAVE Acompanhamento. Ambientes Virtuais de Aprendizagem. Moodle. Educação superior. TIPO DE TRABALHO: Dissertação de Mestrado I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 18 ANÁLISE TÉCNICA DE ARQUITETURAS DE VIRTUALIZAÇÃO 12 André Valente do Couto – [email protected] 1 Claudio Toyoshy Onohara – [email protected] 12 Reginaldo Hugo S. Dos Santos – [email protected] 1 – UNIRONDON – Centro Universitário Cândido Rondon - Cuiabá / MT 2 – IFMT – Instituto Federal de Mato Grosso - Cuiabá / MT RESUMO Este trabalho, tem como objetivo analisar o funcionamento das tecnologias de Virtualização de Servidor, no que concerne à sua fundamentação teórica, adotada pelos produtos: VMware-ESX, produzido pela empresa VMware líder no mercado de soluções de virtualização, e pelo Xen, um software open-source desenvolvido a partir de um projeto de pesquisa apelidado de XenoServers. Especificamente, a análise é focada, nas formas em que o Xen e o VMware-ESX encontraram, para realizar o compartilhamento de processador, memória e dispositivos de E/S, tornando possível que um mesmo hardware seja utilizado por várias máquinas virtuais. A principal justificativa para realização desse trabalho, é que a tecnologia de Virtualização de Servidores está em crescente utilização há vários anos. Através da análise técnica, será fornecida uma visualização dos ambientes criados pelos dois softwares de virtualização, de maneira que seja possível entender como os recursos são utilizados e fornecidos aos sistemas em execução sobre as plataformas de virtualização, que possuem abordagens técnicas bem diferentes, para construção de seus ambientes virtuais. A realização do trabalho teve como base materiais pesquisados em livros, artigos científicos, além da utilização de softwares de computação. Neste estudo, ficou claro que o Xen e o VMware-ESX adotam abordagens diferentes para a virtualização das instruções da arquitetura X86, utilizam tipos de hypervisors distintos, e realizam o compartilhamento do processador, memória e dispositivos de E/S de forma diferenciada. A virtualização das instruções X86, do Xen, utliza a paravirtualização e a virtulização assistida por hardware. O Vmware-ESX por sua vez, faz uso da virtualização total e para-virtualização. Mesmo as abordagens de paravirtualização adotadas pelas plataformas de virtualização também são diferentes. A para-virtualização, no Xen, exige que o kernel do convidado seja especializado e substitua todas as chamadas de sistema por hypercalls para se comunicar com o hypervisor, sendo necessário então um kernel diferente do usado na execução direta sobre o hardware. Já no VMware-ESX, basta que o kernel do convidado tenha, disponível e habilitada, a API VMI (a qual fornece um conjunto de hypercalls) para se comunicar com o hypervisor. Possibilitando desta forma que um mesmo kernel seja executado sobre um hypervisor ou diretamente sobre uma máquina física. O hypervisor, utilizado pelo Xen, é do tipo microkernelizado. Já, o hypersivor, do VMware-ESX é monolítico. O escalonamento do processador no Xen é feito através da lógica SEDF, ou com o escalonador de crédito. No VMware-ESX o compartilhamento é feito através de quotas proporcionais, associada ao Co-Escalonamento quando as máquinas virtuais possuem mais que um processador virtual. O compartilhamento da memória é feito através de tabelas de paginação sombra no VMware-ESX. Em contraste, as máquinas virtuais do Xen, possuem acesso a tabela de paginação real que lhe pertence. Os dispositivos de E/S são administrados pelo hypersor na arquitetura VMware-ESX, e no Xen o acesso aos dispositivos de E/S é coordenado pelo domínio 0. A única I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 19 semelhança encontrada foi que ambos virtualizadores utilizam VMMs do tipo hypervisor (ou nativos), que são instalados diretamente sobre o hardware, e possuem o nível mais alto de privilégio. O Xen e o VMware-ESX, usam diferentes mecanismos para realizar a Virtualização de Servidor, que implicam em quantidade de sistemas operacionais convidados suportados, eficiência da utilização de recursos, flexibilidade para configuração da alocação de recursos e grau de isolamento entre Vms. A virtualização realiza a consolidação, aumenta a disponibilidade e a flexibilidade do portfólio de aplicações que fornecem serviços que agregam valor ao negócio. Portanto, as necessidades operacionais das aplicações, e o desempenho obtido por elas em cada plataforma de virtualização, podem determinar qual plataforma a ser utilizada. O hardware, capital disponível, equipe técnica e a qualidade de suporte oferecido por cada produto, são outros fatores decisivos na escolha. Como os cenários de utilização da Virtualização de Servidor são os mais variados possíveis, e os virtualizadores possuem mecanismos de funcionamento bem distintos, não há como afirmar que um é melhor do que outro de forma generalizada. PALAVRAS-CHAVE Sistemas Operacionais, Virtualização, Hypervisors, Para-Virtualização. Tipo de Trabalho: Trabalho de Graduação I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 20 ARQUITETURA ORIENTADA A SERVIÇOS E COMPONENTES PARA GESTÃO AMBIENTAL ATRAVÉS DE IMAGENS MULTIESPECTRAIS Gustavo Liberatti ¹ - [email protected] Rodicrisller Rodrigues¹ - [email protected] Josiel Maimone de Figueiredo¹ - [email protected] Cláudia Martins¹ - [email protected] Andreia Gentil Bonfante ¹ - [email protected] 1 – UFMT – Universidade Federal de Mato Grosso - Cuiabá / MT RESUMO Uma das principais formas de modernização do estado está fortemente apoiada no uso das novas tecnologias para prestação de serviços públicos. A comunidade como um todo interage com o governo, consumindo estes serviços e fiscalizando de certa forma os trabalhos realizados, bem como se beneficia dos produtos gerados pelos mesmos. Neste contexto o monitoramento de áreas ambientais em países com grande extensão territorial ocorre primordialmente através de imagens georreferenciadas. O montante de dados gerados pode conter informações e padrões de conhecimento valiosos, que devido à sua complexidade, faz-se necessária a aplicação de abordagens computacionais para que possam ser recuperadas informações úteis, tanto para o governo quanto para a população. No que tange a imagens, Figueiredo (2005) formalizou uma álgebra para um domínio imagem, cuja principal característica é “suportar operações de manipulação e de comparação entre instâncias de imagens em Sistemas Gerenciadores de Banco de Dados (SGBDs) relacionais”. Estas imagens são então tratadas como um novo tipo de dado natural a base relacional. As duas classes de elementos fundamentais que compõe essa álgebra são: o operando imagem e o conjunto de operadores que agem sobre o primeiro. O operando imagem (λ) é formalmente definido como um par λ = (Φ,S) onde Φ é um posto de imagens e S é um conjunto característica. Sendo que Φ é um par Φ = (II, L) onde II é um vetor de imagens sem limite de tamanho e, L é um índice de uma das imagens desse vetor, denominada imagem corrente (lL). E S = {a1,a2,a3,a4,..., an} um vetor de características onde cada característica a é um par composto por: nome característica e valor característica, que descreve propriedades de uma imagem. Os operadores são classificados em operadores de manipulação, de controle e de persistência, sendo os operadores de manipulação aqueles que realizam qualquer alteração no vetor de imagens (II) do posto de imagens (Φ) ou no conjunto característica (S) de um operando imagem (λ); são divididos em: extrator de características, sintetizador de imagens, operadores unários e operadores binários. Encontra-se na segunda classe os operadores de controle, responsáveis por organizar o fluxo de execução dos outros operadores, através da replicação do operando imagem corrente para ser manipulado por um ou mais operadores de imagem. Nesta classe dispomos os operadores: move, swap, fork, I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 21 condicionalIf e condicionalCase. A terceira classe de operadores são os de persistência cujo objetivo é armazenar os dados gerados durante o fluxo de processamento na base de dados, de forma inteligente e automática. Existem três operadores de persistência pré-definidos: StillImage, FeatureVector e o SimilarityCriterion. No desenvolvimento da aplicação, a fim de prover serviços que abstraíssem o processamento de imagens realizado pelos operadores da álgebra, utilizamos o estilo arquitetônico para a construção de soluções empresariais baseadas em serviços denominado SOA (Service-Oriented Architecture). Mais especificamente, a SOA está preocupado com a construção independente de negócios alinhados na forma de serviços que podem ser combinados em uma solução de nível superior, em processos de negócios e soluções no âmbito empresarial. Os serviços são normalmente interfaces de programação de aplicativo (API) acessadas via Hypertext Transfer Protocol (HTTP) e executado em um sistema remoto que hospeda os serviços solicitados. A implementação de um serviço é inerente aos seus utilizadores. Buscando implementar os conceitos envolvidos em SOA a Arquitetura de Componentes e Serviços (SCA) disponibiliza um ou mais serviços associados a uma unidade de implementação chamado componente. Esses componentes podem trabalhar juntos para solucionar um problema de um determinado domínio, através das composições. A criação das composições dá-se mediante um arquivo de configuração descrito em XML (Extensible Markup Language), denominado Service Component Definition Language (SCDL). A arquitetura proposta baseia-se na tecnologia SCA implementada pelo servidor de aplicações apache Tuscany, projeto mantido pela Apache Foundation como projeto open-source. Esta tecnologia permite instanciar serviços e componentes em tempo de execução proporcionando maior versatilidade a aplicação, além de ser possível combinar diversas tecnologias de implementação para solução de um único problema. Foi desenvolvido um Gerente de Domínio responsável por realizar a interação dos objetos Java com o servidor Tuscany em tempo de execução através de um arquivo SCDL, permitindo a aplicação gerar linhas de processamento (sequência de algoritmos de processamento, classificação ou extração de informação) através da combinação de diferentes operadores imagens, viabilizando assim a álgebra definida por Figueiredo (2005). O protótipo de interação foi implementado utilizando a tecnologia JSF (JavaServer Faces) combinado com a biblioteca RichFace, ambas tecnologias livres (código aberto) devido a sua inerente comunicação com a linguagem Java, amplamente utilizada no desenvolvimento dos operadores descritos anteriormente. Este protótipo permite ao usuário manusear os operadores de imagem de forma transparente a arquitetura, além de configurar seus próprios operadores através do agrupamento de funcionalidades primárias disponibilizadas pelo sistema. I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 22 PALAVRAS-CHAVE: Gestão ambiental, Imagens multi-espectrais, Arquitetura orientada componentes, Arquitetura orientada a serviços, Componentes de Software. Tipo de Trabalho: Iniciação Científica I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios a 23 BENEFÍCIOS DE MVC PARA OS PROJETOS DE SOFTWARE 1 Robison Karls Custódio – [email protected] 1 Wagner Santos Lino – [email protected] 1 Ghanem Arfox – [email protected] 1 – UNIRONDON – Centro Universitário Cândido Rondon - Cuiabá / MT RESUMO Atualmente o meio corporativo é muito competitivo, muitas empresas disputando o mercado e na área de Tecnologia da Informação não é diferente. Para uma empresa continuar no mercado é necessário que tenham um diferencial, no segmento da indústria de software, o diferencial está na agilidade de entrega e na qualidade do produto. A rápida evolução tecnológica e o crescimento dos serviços computacionais contribuíram para que a engenharia de software desenvolve-se um meio de agilizar e organizar o processo de fabricação de um Software (Programa), utilizando o Design Patterns (Padrões de Projeto). O Padrão de Projeto estuda a solução para um problema e as consequências desta solução. A engenharia do software tem vários tipos de Padrões, são dezenas de modelos cada um com suas próprias características, por isso é necessário ter cautela na hora de decidir qual utilizar. Recentemente, com a explosão da web 2.0, houve um aumento no interesse por sites e sistemas web. As Software House, empresas que vendem sistemas, tiveram que fazer uma escolha de framework para o trabalho, algo que seja moderno, flexível, reutilizável e de fácil aprendizagem. Através de uma pesquisa exploratória, que visa observação não estruturada, recolhemos registros aleatórios e chegamos à conclusão que os padrões de projeto MVC podem suprir senão todas, a maioria das necessidades que obtemos na fabricação de sites e sistema para web. O MVC (Model, View, Controller) consiste em separar nossa aplicação em camadas. Model gerencia o comportamento dos dados da aplicação que organizam o acesso e a atualização desses dados, View gerencia a saída gráfica e textual da parte da aplicação visível ao usuário e o Controller define o comportamento da aplicação enviando as requisições do usuário para o modelo e selecionando as visões para apresentar os resultados destas requisições. Através do nosso projeto apresentaremos as melhorias e benefícios que o MVC nos proporciona, e a indústria de software que utilizar dos mesmos benefícios conseguirá facilitar a probabilidade de sucesso. A organização que utiliza o MVC e adota como paradigma de programação a Orientação a Objeto, certamente o desenvolvimento dos projetos agregaram a reusabilidade, flexibilidade, extensibilidade aos softwares. A meta do artigo visa difundir o uso de boas praticas de programação junto com a adoção de um framework que utilize de um Padrão de projeto MVC, o ganho de tempo é imenso. Será mais fácil adquirir o conhecimento, os documentos ganho são de grande utilidade e o software terá uma aceitação melhor, pois adotando padrões você não adota apenas um maneira nova de trabalhar, mas sim uma adoção de novas praticas como algumas convenções que deixam o software mais legível e fácil de se adaptar tornando seu produto muito mais comercializável. O projeto e o uso do framework MVC que demonstraremos é uma revista eletrônica que utiliza do framework Symfony, que adota o MVC como padrão de projeto. O Symfony foi utilizado no back-end deste projeto, ou seja, temos MVC bem implementado que utiliza todas as suas vantagens. E relacionado ao mesmo projeto, mas no front-end, optamos por não utilizar o MVC para podermos comparar quais foram os benefícios com a utilização e não I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 24 utilização. O front-end é uma espécie de interface entre o usuário e o back-end, que seria toda a visualização que um usuário tem do sistema ou site. Seguimos um critério de avaliação em nosso projeto, estudamos os seguintes itens: reutilização de códigos, facilidades para manutenção, flexibilidades, portabilidades, documentação e facilidade de aprendizagem. O Symfony por ser um framework muito bem estruturado nos proporcionou uma curva de aprendizagem muito boa, por que temos as classes documentadas e vários artigos e tutoriais de exemplos na internet. A facilidade de adquirir o material de ajuda foi crucial para o sucesso do projeto, percebemos que esta facilidade se deve a comunidade dos usuários do MVC que tem um grupo grande e prestativo possibilitando um aprendizado sem maiores problemas. Já o front-end onde optamos por não utilizar este conceito, houve uma demora maior tempo de desenvolvimento e foi um processo mais trabalhoso, esses contratemos aconteceram por falta de documentação, caso haja contratempos e o projeto pare, ficara difícil dar continuidade ao mesmo posteriormente. PALAVRAS-CHAVE: design patterns, engenharia, software, open source. TIPO DE TRABALHO: Trabalho voluntário de Iniciação Científica com o apoio do Centro Universitário Cândido Rondon. I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 25 CERBEROS: SOFTWARE LIVRE PARA ADMINISTRAÇÃO DO SQUID 2 André L. L. De Oliveira - [email protected] 1 Carlos A. S. J. Gulo - [email protected] 1 – UNEMAT – Universidade do Estado de Mato Grosso – Alto Araguaia / MT 2 – Altatech – Soluções e Serviços em T.I.C. - Londrina / Paraná RESUMO Um dos maiores desafios encontrados por empresas nos dias atuais é o controle de acesso à Internet, além de sua otimização, conseguindo assim economia de recursos e maior desempenho nos acessos. Para esta finalidade, geralmente usase ferramentas com a função de proxy e cache http. No entanto, algumas destas ferramentas possuem custo elevado e outras são de difícil configuração e utilização. O Squid é uma ferramenta que realiza ambas as funções de proxy e cache http, é open source, estável e possui diversas funcionalidades para controle de acesso. Entretanto, ainda é de difícil configuração e administração, visando facilitar a utilização do Squid por usuários com menor nível de conhecimento neste tipo de ferramenta, foi criada uma interface web controlada por Sistema de Banco de Dados, o qual mostrou-se ágil e intuitiva para facilitar as tarefas cotidianas do administrador de proxy, denominada Cerberos. Com o crescimento da rede mundial de computadores, empresas e instituições passaram a ter uma maior preocupação com a disponibilidade e a velocidade de acesso à Internet, além da necessidade de filtrar este acesso de modo a controlar o conteúdo visitado por seus usuários. Para realizar este filtro e melhorar o desempenho de acesso, costuma-se utilizar ferramentas que possuem a função proxy e cache http da rede, como é o caso do Squid. O Squid é um intermediário entre as transações realizadas na web, aceita requisições vindas dos clientes, processa tais requisições e as encaminha para o servidor original. Mesmo possuindo tais funcionalidades, o Squid ainda é uma ferramenta considerada de difícil utilização. Esta dificuldade, em geral, é atribuída à necessidade de uso dos comandos no prompt do sistema operacional, o qual exige maior domínio para manipular suas opções, tornando-se um obstáculo em sua utilização. O objetivo deste trabalho foi desenvolver uma interface web para administração da ferramenta de proxy Squid, visando facilitar a realização de tarefas cotidianas do administrador de sistemas, proporcionando maior produtividade na manipulação de políticas do proxy, bem como a ampliação do número de usuários do software Squid. O desenvolvimento de software pode ser caracterizado como uma busca para a solução de um problema, sendo esta dividida em quatro etapas distintas: estado atual; definição do problema; desenvolvimento técnico; e integração de soluções. Baseado nestas quatro etapas genéricas é possível segmentar cada uma delas em diversos subníveis, gerando assim um maior grau de detalhamento a ser seguido nos projetos de software. Sendo assim, o desenvolvimento do protótipo foi dividido em etapas, utilizando-se o modelo de desenvolvimento evolutivo. Primeiramente, realizou-se um levantamento bibliográfico buscando em trabalhos científicos os conceitos de proxy e cache, além de materiais sobre as ferramentas utilizadas para o desenvolvimento do protótipo, como por exemplo, a linguagem de programação PHP, a ferramenta de proxy Squid, e o sistema de banco de dados MySQL. O desenvolvimento do protótipo da ferramenta de administração do Squid foi dividido em duas fases: a) o desenvolvimento de um protótipo inicial contendo funcionalidades básicas; b) o desenvolvimento do protótipo final contendo todas I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 26 as funcionalidades propostas. O software foi disponibilizado para 15 administradores de sistemas, com o objetivo de identificar suas potencialidades em relação ao propósito de desenvolvimento. Vale ressaltar que a maioria apresentou dificuldades na implementação do serviço de proxy, devido ao nível de conhecimento que estes administradores possuíam sobre o sistema. A avaliação de uso consistiu em implementar um conjunto de políticas de acesso, criando grupos e regras distintas para cada grupo. Ao utilizar o Cerberos, os administradores relataram a facilidade em implementar a avaliação proposta, e demonstraram satisfação com o desempenho e com a interface do software. Não foram adotados parâmetros de avaliação quanto à usabilidade da interface, apenas a verificação quanto ao sucesso ou não na implementação de regras. O armazenamento persistente dos dados, garante segurança para manipulação de regras, políticas de acesso e filtro. O sistema de banco de dados proporciona também agilidade e eficiência na execução das transações. O uso do Cerberos em ambiente de produção apresentou desempenho não apenas satisfatório, mas totalmente viável, pois o software oferece uma interface ágil e intuitiva, facilita a administração de tarefas do proxy Squid e, possibilita a configuração rápida de políticas de acesso à Internet por meio de sua interface, como pode ser visto na Figura 1. O administrador pode utilizar outro importante recurso, a função de importação de listas de acesso, o que facilita a criação de políticas de acesso, demonstrado na Figura 2. Figura 1 – Cadastro de Lista de Acesso Figura 2 – Importar Lista de Acesso Através de todas as etapas que foram vencidas durante o desenvolvimento do sistema, desde o levantamento bibliográfico, passando pela modelagem do sistema e chegando enfim na codificação do protótipo e ao testes das funcionalidades implantadas, pode-se constatar a viabilidade para utilização da aplicação em um ambiente de produção. Com a interface ágil e intuitiva do I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 27 sistema, conseguiu-se facilitar as tarefas de administração do proxy Squid, possibilitando assim que profissionais que não possuem conhecimento técnico do sistema operacional Linux e da ferramenta Squid, sejam capazes de configurar políticas de acesso à Internet por grupos de usuários e listas de acesso. Além disso, possibilitou realizar a configuração de algumas características avançadas de cache, fornecendo ao administrador a função de importação de listas de acesso, o que facilita toda a criação das políticas do sistema. Assim, conseguiuse atingir os principais objetivos propostos para o projeto. PALAVRAS-CHAVE Proxy, Cache, Software Livre, Open Source, HTTP TIPO DE TRABALHO: Trabalho de Graduação I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 28 COMPUTADOR EMBARCADO BASEADO EM MICROCONTROLADORES ARM PARA APLICAÇÃO EM AGRICULTURA DE PRECISÃO 1 Maurício Fernando Lima Pereira – [email protected] 1 Filipe Pereira Ferraz – [email protected] 1 Wellington Sales Eugênio Santos - [email protected] 1 Elmo Batista de Faria – [email protected] 1 Josiel Maimone de Figueiredo – [email protected] 1 Raul Teruel dos Santos – [email protected] 1 – UFMT – Universidade Federal de Mato-Grosso - Cuiabá / MT RESUMO A busca pela conservação dos recursos naturais e maior produtividade impõe à atividade agrícola a procura por novos métodos e técnicas de produção. Neste contexto, o conceito de agricultura de precisão se distingue da agricultura tradicional por seu nível de manejo. Em vez de administrar uma área inteira como uma única unidade, o manejo é adaptado para pequenas áreas dentro de um campo. Recentemente, com a crescente evolução das arquiteturas de computação embarcadas, tornou-se possível uma maior integração de campo e tecnologia aplicados a agricultura de precisão, com custos relativamente mais baixos. Neste contexto, este trabalho apresenta o desenvolvimento de um computador embarcado baseado em microcontrolador da família ARM para aplicação em agricultura de precisão. Entende-se por computação embarcada, um sistema computacional capaz de realizar tarefas de forma autônoma, normalmente com execução em tempo real, e construídos em tamanhos compactos e utilizados para um fim especifico. Neste computador embarcado é possível conectar diferentes dispositivos tais como GPS, sensores digitais e analógicos, bem como realizar comunicação com outros computadores via rede Ethernet ou sem fio. Também pode-se persistir as informações em memórias não voláteis do tipo Flash. O objetivo deste trabalho esta relacionado ao desenvolvimento de hardware e firmware para uso em agricultura de precisão. No que tange a arquitetura de hardware, o objetivo é pesquisar e desenvolver um computador embarcado focando o estudo na família de microcontroladores ARM combinado como a utilização de sistemas operacionais de tempo real (RTOS). No trabalho foram utilizados os microcontroladores LPC2138 e LPC2148 da NXP que pertencem à família ARM7. Esta família apresenta como características principais: um pipeline integrado de três estágios, baixo consumo de energia e boa relação custo desempenho. No que tange ao desenvolvimento do firmware, o objetivo é criar uma arquitetura de sistema que permita desenvolver uma gama de aplicações relacionadas à agricultura de precisão usando uma mesma arquitetura de hardware. Dentre as aplicações possíveis, pode-se destacar a coleta de dados, o controle de equipamentos, o gerenciamento de pessoal em campo dentre outras. Nesta arquitetura de firmware se viabiliza a integração com diferentes aplicações de desktop e bases de dados através do uso de linguagem XML para troca de informações e armazenamento. Desta forma, todas as informações adquiridas em campo são gravadas em formato XML e podem ser integradas em bases de dados permitindo estudos que tornem mais racional o uso de máquinas, de implementos e a aplicação de insumos. Assim neste trabalho se desenvolve um modelo de firmware com 3 camadas, sendo a camada I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 29 base de funções para lidar com os diferentes tipos de portas de entrada e saída do microcontrolador, gravação de dados em memórias e comunicação, semelhante a uma camada de drivers nos softwares tradicionais. Acima desta camada tem-se um RTOS responsável por gerenciar as várias tarefas realizadas pelo microcontrolador durante a execução da aplicação, o que também permite abstrair das peculiaridades relacionadas ao controle de interrupções e temporizadores, que em geral são bastante complexas. Acima da camada de RTOS foram desenvolvidas bibliotecas de manipulação XML e de sistema de arquivos FAT e nessa camada se constrói a aplicação. No trabalho utiliza-se a linguagem C para desenvolvimento das camadas com alguns trechos em linguagem assembler do microcontrolador para iniciar a execução da aplicação. O ambiente de programação utilizado é a IDE Eclipse juntamente com o Yagarto que é um plug-in do Eclipse responsável por gerar o código-objeto .hex o qual é gravado no microcontrolador. Para gravação do .hex utiliza-se o Flash Magic, disponibilizado pela NXP. Para avaliar o sistema desenvolvido, utilizou-se um conjunto de sensores digitais e analógicos, combinados com um real time clock(RTC) e memória SD Card e portas serial. Um dos sensores utilizados no projeto é o sensor LM35 da National Semiconductor, que apresenta uma saída de tensão linear relativa a sua temperatura, tendo em sua saída uma variação de 10mV/°C. Entre os resultados obtidos pode-se destacar o desenvolvimento da camada básica de drivers e a biblioteca de manipulação de arquivos em sistemas FAT e de LCD, dentre outros. Utilizando este modelo em camadas, criou-se uma aplicação no microcontrolador para realização de coleta de dados. Para fins de validação deste firmware desenvolvido utilizando a arquitetura proposta foram realizados testes em laboratório com coleta automática de sensores analógicos e digitais e posterior comparação dos dados gravados com observações visuais. A comparação entre observações e informação persistida automaticamente mostrou uma precisão em 100% dos casos, com destaque para a precisão na coleta de dados analógicos de temperatura realizada pelo microcontrolador. O tempo de coleta foi de uma hora com amostragem a cada trinta segundos. Conclui-se que ainda que seja em ambiente controlado, a aplicação em microcontrolador mostrou-se bastante robusta. O modelo em camadas mostrou-se adequado e uma maior integração com o RTOS está sendo pesquisada. PALAVRAS-CHAVE ARM; Agricultura de precisão; Sistemas embarcados; Microcontroladores. Tipo de Trabalho: Iniciação Científica Agencia financiadora Bolsa PIBIT – CNPq I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 30 CONSTRUÇÃO DE UMA BASE DE TREINAMENTO DE IDS UTILIZANDO O PROTOCOLO SNMP PARA CAPTURA DE DADOS EM UMA REDE 802.11 1 Filipe Araújo Molina – [email protected] 1 Nelcileno Virgílio de Souza Araújo – [email protected] 2 Ed’Wilson Tavares Ferreira – [email protected] 2 Ruy de Oliveira – [email protected] 1 - UFMT – Instituto de Computação - Cuiabá / MT 2 - IFMT – Departamento de Informática – Cuiabá/MT RESUMO A maioria dos sistemas detectores de intrusão (IDSs) concentra sua análise nos dados do pacote, que resulta em detecção tardia e numa carga elevada do sistema para lidar com a alta velocidade do tráfego de rede. Pouca ou nenhuma integração ocorre entre o IDS e o protocolo de gerenciamento de rede SNMP (Simple Network Management Protocol). Apesar dos agentes de SNMP fornecerem um monitoramento intensivo e informação estatística implementados pelos dispositivos de rede. Por exemplo, o SNMP MIB-II (Management Information Base), um padrão do IETF (Internet Engineering Task Force) para o MIB oferece suporte para todos os agentes SNMP, fornecendo uma grande quantidade de informações sobre o desempenho do tráfego sobre diferentes camadas e protocolos. Empregando os dados do MIB, o IDS pode diminuir a sobrecarga de processamento sobre a análise de dados e oferecer uma alta flexibilidade de implementação. O objetivo desta pesquisa é utilizar o protocolo SNMP para captura de dados numa rede sem fio infra-estruturada e gerar uma base de treinamento para IDS. A escolha por esta tecnologia deve-se pela escassez de base de treinamento nela. Além disso, as redes 802.11 são conhecidas pela sua limitação de banda passante onde a necessidade de uma ferramenta de captura de dados que gere baixo nível de tráfego de controle é essencial. A metodologia aplicada consiste numa primeira fase na revisão bibliográfica sobre os seguintes tópicos: uso do protocolo SNMP na captura de dados numa rede de computadores, especificação da camada 2 na rede 802.11 e a caracterização dos ataques de negação de serviço sobre as redes sem fio. A seguir, implanta-se um ambiente de simulação onde existe uma rede sem fio infra-estruturada acadêmica, realizando o monitoramento por meio do protocolo SNMP e ocorrendo em determinados períodos de tempo ataques de negação de serviço (deautenticação, duração e chop chop). Na última fase pretendemos préprocessar a base gerada colocando em cada amostra, além dos atributos capturados durante a segunda fase, um rótulo de classificação (normal, deautenticação, duração e chop chop) para identificar a qual classe de detecção ela pertence. O projeto encontra-se atualmente na segunda fase, ou seja, na instalação e configuração do ambiente de simulação. O local escolhido para realizar o experimento é o Instituto de Computação da Universidade Federal de Mato Grosso, pois a rede sem fio acadêmica implantada possui uma diversidade de usuários o que possibilita uma captura de dados com amostras ricas em informações. Além disso, a tarefa de geração dos ataques torna-se mais fácil de implementar devido a restrição do espaço físico num único edifício de dois pavimentos. As ferramentas empregadas para gerar os ataques na rede são I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 31 aircrack-NG (ataques chop chop e deautenticação) e framespam (ataque de duração). O período de duração da captura de dados está programado para 2 semanas, registrando o tráfego no intervalo das 8:00 ás 22:00 horas e de segunda a sexta. O instante dos ataques deve ocorrer nos seguintes tempos: 13:00-13:50, 15:30-15:50 e 17:30-18:10, privilegiando os momentos de intervalo entre as aulas para não atrapalhar as atividades acadêmicas desenvolvidas no local do experimento. As amostras capturadas serão armazenadas e préprocessadas num banco de dados MySQL para a partir disso termos uma base de treinamento que pode ser empregada no módulo de aprendizagem de um IDS. PALAVRAS-CHAVE Auditoria de dados, SNMP, base de treinamento de IDS, redes sem fio infraestruturada. TIPO DE TRABALHO: Estágio Supervisionado I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 32 CONVERSÃO DE DIAGRAMA DE ATIVIDADES UML PARA SAN: GERAÇÃO DE CASOS DE TESTE DE SOFTWARE Toni Amorim de Oliveira – [email protected] UNEMAT - Universidade do Estado de Mato Grosso RESUMO Pesquisas recentes propõem o uso de formalismos como redes de Petri estocásticas (SPN - Stochastic Petri Nets) cadeias de Markov (MC - Markov Chains) e redes de autômatos estocásticos (SAN - Stochastic Automata Networks) para construção de um modelo comportamental que viabilize a análise e a validação de sistemas durante o processo de desenvolvimento, cujos resultados possibilitam desenvolver um software mais robusto e eficiente. Com o objetivo de se obter um modelo comportamental de sistemas computacionais, demonstra-se neste artigo um método de conversão de diagramas de atividades para SAN, um formalismo que possibilita a modelagem de sistemas, a partir da qual, é possível extrair índices probabilísticos relacionados aos estados do modelo e gerar casos de teste de software. Apresentamos neste trabalho um método de conversão de diagramas de atividades para SAN, fundamentado em um formalismo matemático que possibilita a modelagem de sistemas em geral, a partir do modelo comportamental de sistema construído por diagramas de atividades UML. Com base nos modelos criados, é possível extrair índices probabilísticos relacionados aos estados do modelo SAN gerado, permitindo a geração de casos de testes de software, cujos resultados podem fundamentar decisões de projeto. O desenvolvimento de software envolve tanto a modelagem quanto o uso de linguagens orientadas a objeto, empregando sempre os elementos da Engenharia de Software, dentre eles a UML (Unified Modeling Language), desenvolvida com o objetivo de descrever qualquer tipo de sistema em termos de diagramas orientados a objetos e de padronizar a forma de especificação de sistemas. Testes de software podem ser vistos como o processo de executar ações que visam identificar a presença de erros ou limitações de desempenho do sistema, ou seja, consistem na verificação dinâmica do funcionamento de um determinado programa, baseados em um conjunto finito de casos de testes, intimamente relacionados dentro de um domínio infinito de entradas possíveis contra o funcionamento esperado. Redes de Autômatos Estocásticos é um formalismo proposto por Plateau nos anos 80 para modelagem analítica de sistemas com um grande espaço de estados, representado por meio de subsistemas, equivalente à cadeia de Markov. O método apresentado neste trabalho é uma conversão manual de diagramas de atividades da UML para um modelo SAN que possibilita a realização de análises de comportamento do sistemas, tais como, determinar a funcionalidade do sistema que possui uma maior probabilidade de uso. Posteriormente, com base no modelo SAN obtido, é possível gerar casos de teste de software. O processo de conversão pode ser descrito em sete passos descritos da seguinte forma: Conversão dos elementos estado inicial e estado final, Conversão do elemento atividade, Conversão do elemento transição, Conversão do elemento decisão, Conversão do elemento fork, Conversão do elemento join e Conversão do elemento merge. Os resultados obtidos após a conversão do diagrama de atividades (Figura 1) para o modelo SAN (Figura 2) gerado, demonstram a possibilidade de o modelo I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 33 SAN estar em um determinado estado que representa a execução de uma atividade. A partir desse modelo SAN obtido, foram gerados casos de teste de software em que cada caminho percorrido nos estados existentes representa um caso de teste. Figura 1 – Diagrama de atividades Figura 2 – Modelo SAN obtido Este trabalho teve por objetivo apresentar um método de conversão de diagramas de atividades da UML para SAN e a geração de casos de teste de software. Foram apresentados os principais conceitos sobre UML, a descrição das principais técnicas de teste de software. Foram demonstrados ainda os conceitos sobre o formalismo SAN, um dos focos do trabalho aqui apresentado. Trabalhos futuros deverão abordar a melhoria do método, de modo a reduzir o estado global dos modelos SAN gerados. Ainda como trabalho futuro, espera-se encontrar outras formas de efetuar o tratamento das condições de guarda, visando obter modelos SAN com um tamanho menor, o que possibilitaria analisar sistemas mais complexos. PALAVRAS-CHAVE: Redes de Autômatos Estocásticos, Teste de Software, UML (Unified Modeling Language) I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 34 CRIAÇÃO DE MODELOS DE PRODUTIVIDADE DE SOJA PARA FIDELIZAÇÃO DE ASSOCIADOS EM COOPERATIVAS DE PRODUÇÃO 1 Gilso César Valiati - [email protected] 1 Sandro da Silva Camargo – [email protected] 1 – FATEC – Faculdade SENAC de Tecnologia – Passo Fundo / RS RESUMO Este artigo descreve a aplicação de técnicas de mineração de dados para criação de modelos preditivos de produção de soja aplicável a produtores cooperados da região do Planalto Médio do Rio Grande do Sul. O objetivo é fornecer subsídios que contribuam com o processo de fidelização dos produtores e identificação de possíveis fraudes na entrega de produção dos associados da Cotrijal Cooperativa Agropecuária e Industrial na região de Não-Me-Toque. A fidelidade dos cooperados, no que tange ao seu comprometimento com a cooperativa, é um fator crítico para o sucesso deste tipo de organização. Entre outras coisas, um cooperado faz um compromisso de entrega de toda a sua produção para a cooperativa em função da utilização dos ativos e benefícios que esta lhe proporciona. Ao utilizar os recursos da cooperativa, sem a entrega de toda a sua produção, um cooperado está prejudicando indiretamente os demais. Desta forma, a cooperativa tem a necessidade saber se o cooperado entregou a ela toda sua produção, porém necessita de informações adequadas para avaliar o grau de envolvimento com a organização. Este trabalho tem como objetivo a criação de modelos para predição da quantidade de semente e entrega da produção por produtores de soja na Cooperativa de Produção, Cotrijal Cooperativa Agropecuária e Industrial na região de Não-Me-Toque, no Rio Grande do Sul, considerando os índices pluviométricos. Com o resultado deste trabalho tem-se a intenção de contribuir no processo de fidelização dos produtores e também na identificação de possíveis desvios de entrega de produto não correspondendo, em produtividade, à compra inicial das sementes por parte do produtor. Os dados de produção e compra de semente foram obtidos a partir do banco de dados da cooperativa. Foi realizada uma seleção dos dados disponíveis das safras de 2008, 2009 e 2010, considerando apenas os dados de produtores de soja da região de Não-Me-Toque Os dados pluviométricos mensais referentes às respectivas safras foram obtidos a partir de um banco de dados da cooperativa. Como resultado destes sucessivos processos de seleção, foi gerada uma base de dados com 1228 amostras. Cada uma destas amostras contém dados pluviométricos de 12 meses, compreendidos entre julho do ano anterior à safra a junho do ano da safra, além da quantidade de sacos de semente comprados pelo produtor e a quantidade de sacos de produto entregue à Cooperativa. Para gerar os modelos preditivos, foi realizado um processo de mineração de dados com utilização de algoritmos de regressão implementados no pacote de software livre Weka. Foram utilizados diversos algoritmos de regressão do tipo “caixa-branca”. Dentre os algoritmos aplicados, os resultados obtidos com regressão linear criaram modelos com maior capacidade preditiva. Para avaliar a capacidade preditiva dos modelos foi utilizada a técnica 10-fold cross validation. Modelos de regressão linear atingiram um coeficiente de correlação de 0,74 em relação à produção real dos cooperados. O modelo de regressão gerado foi discutido com o departamento técnico da Cooperativa. Em relação ao processo atualmente utilizado na Cooperativa para predição de produção, o modelo criado I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 35 neste trabalho tem maior capacidade preditiva, provavelmente pelo fato de incluir dados de precipitação mensal. Modelos de regressão linear sem dados de pluviosidade atingem um coeficiente de correlação de 0,72 com a produção real. Dado que a cooperativa recebe anualmente em torno de 6 milhões de sacos de produção, a diferença de correlação de 0,02 entre os modelos representa um incremento de precisão em torno de 120.000 sacos. Outra descoberta interessante é que o modelo de regressão criado demonstra uma correlação positiva entre produtividade e as chuvas nos meses de janeiro e março, e correlação negativa para a pluviosidade nos meses de outubro e dezembro. É possível concluir que o modelo preditivo criado através da aplicação de técnicas de mineração de dados alcançou um índice de correlação de 0.74 dentro de um contexto ideal de 1.0, tendo capacidade preditiva superior aos modelos utilizados atualmente na Cooperativa. Assim, espera-se que o modelo possa contribuir para a melhoria deste processo na Cooperativa. Sugere-se, no entanto, que o próximo passo seja a identificação das maiores discrepâncias em produtividade com base na produção predita pelo modelo. Tais discrepâncias consistem em produtores que devem ter sua situação analisada mais detalhadamente por indícios de não reciprocidade entre cliente, sócio e fornecedor que neste tipo de organização pode ser o mesmo. Isso contribuirá para o sucesso da empresa. Salienta-se ainda que a inclusão de dados sobre qualidade do solo provavelmente aumentaria a exatidão preditiva do modelo porém não foi possível obter estes dados. PALAVRAS-CHAVE Produção de Soja, Mineração de Dados, Modelo de produtividade, Weka Tipo de Trabalho: Trabalho de Conclusão de Curso de Especialização I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 36 CRIAÇÃO DE MODELOS PREDITIVOS DE EVASÃO ESCOLAR 1 Fernanda Milani - [email protected] 2 Sandro da Silva Camargo – [email protected] 1 – FATEC – Facultade SENAC de Tecnologia – Passo Fundo / RS RESUMO Este trabalho descreve a aplicação de técnicas de mineração de dados no banco de dados do Campus de Passo Fundo do Instituto Federal Sul-Rio-Grandense. O objetivo é a identificação de fatores que contribuem para a evasão escolar. Foram identificados alguns fatores que permitem a descoberta de grupos de risco para evasão. A evasão é o desligamento do aluno, por sua própria responsabilidade, da instituição de ensino a qual está matriculado. Nas Instituições Federais de Ensino a evasão é um aspecto crítico, visto que tem influência nos repasses de recursos federais. A predição de quais alunos têm maior propensão à evasão escolar pode permitir um acompanhamento mais direto destes alunos de forma a diminuir a ocorrência deste fenômeno. Além disso, a identificação de quais fatores contribuem para a evasão dos alunos pode fornecer subsídios para a formulação de políticas que permitam atenuá-los, reduzindo assim os níveis de evasão. A análise dos dados dos alunos através de processos baseados em trabalho humano torna-se proibitiva, sendo necessária a aplicação de técnicas automáticas para a análise destes dados. Este trabalho visa identificar os principais fatores que contribuem para evasão dos alunos do Campus de Passo Fundo do Instituto Federal Sul-Rio-Grandense (IFSul). Foi realizada a aplicação de técnicas de mineração de dados sobre dados dos alunos do campus de Passo Fundo do IFSul. Para utilizar as ferramentas, houve a necessidade de consolidar um banco de dados a partir de fontes de dados oriundas de diversos setores do Instituto, visto que não existe um único banco de dados com toda a informação corporativa. Devido à heterogeneidade das fontes de dados, este processo foi realizado de forma manual e foram considerados apenas dados do curso técnico em informática, técnico em mecânica e curso superior de sistemas para internet. Está sendo implementada uma estrutura automática para integração de instâncias destas diversas fontes de dados heterogêneas. Dentro do banco consolidado, 22% das instâncias representam dados de alunos que evadiram e os outros 78% representam dados de alunos que não evadiram. A fim de realizar a mineração de dados, foram utilizados algoritmos de classificação implementados na ferramenta Weka. Foram utilizados diversos algoritmos que geram modelos “caixa-branca” com ênfase em algoritmos de geração de regras e geração de árvores de decisão. Levando-se em conta que a taxa média de evasão no banco de dados considerado é 22%, foram encontradas as seguintes regras relevantes: Em relação aos resultados obtidos que levam em consideração a idade dos alunos, foram obtidas as seguintes regras: 1) Alunos com idade maior que 37 anos têm um percentual crítico de evasão, em um patamar entre 40 e 50%, o que representa em torno do dobro da média de evasão do instituto. 2) Alunos entre Alunos com idade menor que 22 anos têm baixo percentual de evasão, inferior a 10%, o que representa metade da média de evasão do Instituto. 3) Alunos entre 22 e 27 anos tem percentual de evasão acima de 20%, valor que está alinhado com a média de evasão do instituto. Em relação aos resultados obtidos que levam em consideração o curso do aluno, foram obtidas as seguintes regras: 1) Alunos do curso técnico em mecânica têm alta probabilidade de evasão, próxima a 30%. 2) Alunos do curso técnico em informática têm probabilidade de evasão em torno I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 37 de 20%, o que está levemente abaixo da média geral. 3) Alunos do curso superior em tecnologia para internet têm baixa probabilidade de evasão, em torno de 10%. Pode-se concluir que a aplicação de técnicas de mineração de dados é eficiente na identificação de fatores que contribuem para a evasão universitária campus de Passo Fundo do IFSul. A utilização de algoritmos de geração de regras e de geração de árvores de decisão permite identificar alguns dos fatores que contribuem para a evasão universitária, sendo possível reconhecer os grupos de risco para evasão. Tais resultados fornecem subsídios para indicar quais alunos necessitariam de um acompanhamento mais personalizado a fim de tentar diminuir o risco de evasão. PALAVRAS-CHAVE Evasão Escolar, Mineração de Dados, Modelos Preditivos, Weka Tipo de Trabalho: Trabalho de Conclusão de Curso de Especialização I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 38 DATA WEBHOUSE CEB-INEP – UM DATA WEBHOUSE A PARTIR DOS MICRODADOS DO CENSO ESCOLAR BÁSICO INEP/MEC Fernando Maia da Mota – [email protected] Leila Lisiane Rossi – [email protected] Marcelo Augusto Santos Turine – [email protected] Alex de Lima Campelo - [email protected] UFMS - Universidade Federal de Mato Grosso do Sul - Coxim / MS RESUMO Este artigo apresenta o Data Webhouse CEB-INEP, desenvolvido a partir dos microdados do Censo Escolar Básico-INEP/MEC, cujo objetivo é fornecer aos gestores do INEP uma ferramenta que possibilite auxiliá-los na tomada de decisão para a adoção de políticas educacionais, além de oferecer a educadores, pesquisadores e publico em geral uma ferramenta gráfica e com usabilidade para acompanhamento, comparação e previsão do ensino básico no Brasil. Com o crescente volume de informações no nosso dia a dia surge a necessidade de ferramentas automatizadas que auxiliem no processo de armazenamento e recuperação dos dados de forma rápida e prática. Nas instituições de ensino é realizada uma série de provas para avaliar a qualidade e as condições da educação no Brasil, O Instituto Nacional de Estudos e Pesquisas Educacionais Anísio Teixeira – INEP é uma autarquia federal vinculada ao Ministério da Educação – MEC responsável pelas avaliações do Sistema Educacional Brasileiro. Através das pesquisas realizadas pelo INEP é possível obter informações claras e confiáveis aos gestores, pesquisadores, educadores e público em geral. Contudo essas informações nem sempre são de fácil acesso a essas pessoas. Com o objetivo de contribuir e facilitar as consultas sobre os dados do INEP obtidos através das provas e pesquisas promovidas por ele, foi proposto pela Universidade Federal de Mato Grosso do Sul – UFMS em parceria com a Universidade Federal de São Carlos – UFSCar o projeto de pesquisa WebPIDE o qual prevê a criação de uma plataforma de integração dos dados educacionais do INEP. O projeto WebPIDE é composto por vários projetos sendo um deles a avaliação e os testes com as ferramentas a serem usadas para criação dos Data Webhouses(Data Warehouse disponível na web) que irão compor a plataforma proposta. Este trabalho demonstra a criação do Data Webhouse CEB-INEP desenvolvido a partir dos microdados do CEB-INEP. O INEP disponibiliza os dados do censo escolar básico através de download em seu sitio oficial, esses dados são chamados de microdados a equipe do projeto WebPIDE desenvolveu uma ferramenta de extração de dados, intitulada DEAR( Data Extractor ASCII to Relational), esta ferramenta insere em tabelas de banco de dados os dados extraídos dos microdados. Devido ao tamanho da base e falta de padronização ao longo dos anos de pesquisa no que se refere aos questionamentos, decidiu-se fazer o mapeamento dos campos que se faziam presentes em todos os anos da tabela censo_esc, esta é a principal tabela da base, pois armazena os dados principais do censo escolar básico além de estar presente em todos os anos da pesquisa. Só após o mapeamento foi possível definir o modelo estrela a ser utilizado para construção do Data Webhouse. Para carregar os dados no modelo estrela utilizou-se scripts sql. Após pesquisa entre ferramentas de BI open-source disponíveis, a Pentaho se mostrou a melhor e mais usada no mundo, esta disponibiliza ferramentas para fazer consultas OLAP. Também utilizou-se a ferramenta BI-Server que é um portal desenvolvido pela I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 39 Pentaho também open-source, que serve para disponibilizar os cubos na web. Como resultado foi obtido o Data Webhouse do CEB–INEP a partir dos microdados do INEP através do qual é possível realizar consultas OLAP na web facilitando desta maneira os coordenadores e gestores do INEP na tomada de decisão em relação a adoção de políticas educacionais para a melhoria da qualidade do ensino no Brasil. Com base nesse modelo é possível realizar consultas do tipo, “Número de Instituições por Região e Ano”, “Número de Professores em Sala de Aula por Região e Ano ”, “Número de Alunos Aprovados e Reprovados no Ensino Médio por Ano, Região e município”. O trabalho esta disponível para acesso no seguinte endereço http://webpide.ledes.net/pentaho. Através do trabalho realizado é possível concluir que a criação de um Data Webhouse é uma tarefa extremamente complexa considerando principalmente bases com grandes volumes de dados e a necessidade do conhecimento de várias áreas da computação como a Engenharia de Software, Banco de Dados, Análise e Projeto de Software além do domínio de ferramentas e tecnologias para a disponibilização dos resultados na web. Como dificuldades encontradas é necessário citar principalmente a falta de padrão e manutenção entre as questões das avaliações, assim muitos dados não puderam ser utilizados na criação do Data Webhouse. Trabalhos futuros relacionados a este trabalho envolve a avaliação da necessidade da criação de Data Marts considerando as diferenças entre alguns dados da base do CEB e o estudo e a análise das outras bases de dados e das ferramentas as quais já estão sendo avaliadas e desenvolvidas pela equipe do WebPIDE. PALAVRAS-CHAVE Data Webhouse, WebPIDE, CEB, INEP. Tipo de Trabalho: Iniciação Científica I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 40 DESENVOLVIMENTO DE UM SHELL DE COMANDOS PARA COMUNICAÇÃO COM MICRONTROLADORES ARM COM FREERTOS 1 Izandro Monteiro Metello – [email protected] 1 Josiel Maimone de Figueiredo – [email protected] 1 Maurício Fernando Lima Pereira – [email protected] 1 – UFMT – Universidade Federal de Mato-Grosso - Cuiabá / MT RESUMO A agricultura de precisão tem como objetivo melhorar a produtividade utilizando tecnologias como aplicação controlada de insumos e coleta de informações sobre o ambiente da aplicação. Neste contexto, os microcontroladores permitem criar pequenos computadores, que podem ser utilizados em diversas aplicações que exigem características como portabilidade, economia de energia e capacidade de processar informações. Alguns microcontroladores como os de arquitetura ARM, por exemplo, contam com uma boa relação de processamento por quantidade de energia gasta (MIPS/WATTS). No cenário de automação agrícola, estes computadores embarcados podem ser utilizados para fazer a conexão entre um computador e vários sensores ou entre dispositivos de aplicação de insumos em uma plantação. Em ambos, os computadores embarcados devem fazer o gerenciamento da leitura de vários sensores, da exibição de informações numa interface LCD, da leitura de um teclado, da gravação e leitura de memória EEPROM, da comunicação com o mundo externo via USB ou Ethernet ou serial, dentre outras tarefas. Este gerenciamento pode ser algo bastante complexo para o programador, visto que ele tem que projetar um algoritmo que seja capaz realizar as operações descritas anteriormente e também gerenciar interrupções, temporizadores do microcontrolador e preocupar-se com interrupções durante execução de uma determinada tarefa crítica. A utilização de sistemas operacionais ajuda a solucionar esse problema, fornecendo uma camada de máquina virtual na qual o programador não se preocupa com essas questões de gerenciamento de recursos de hardware, dando a ele maior liberdade para criar tarefas que devem ser realizadas de forma aparentemente paralela. Neste contexto apresentado, o objetivo deste trabalho é desenvolver um shell de comandos tendo como base um sistema operacional (SO) de tempo real (RTOS) e microcontroladores ARM7. A partir dessa base, pretende-se criar aplicações que automatizem procedimentos em campo, tornando possível economizar recursos como água, auxiliar no aumento de produtividade pela coleta de informações em campo, reduzir custos e aumentar a eficiência na manutenção do solo. Para atingir esses objetivos, vários módulos estão sendo desenvolvidos pelo grupo de pesquisa para explorar os recursos presentes nos microcontroladores e aplicá-los na área agrícola. Para fazer o gerenciamento desses módulos de forma eficiente está sendo utilizado um RTOS, o qual se caracteriza pelas restrições de tempo no sentido de que os resultados ou as ações devem ser fornecidos dentro de uma janela de tempo específico. Neste trabalho o RTOS utilizado é o FreeRTOS, o qual é de código-aberto, portável e projetado para sistemas embarcados. Ele implementa um kernel de tempo real com sistema operacional preemptivo, que gerencia a comunicação entre as várias tarefas executadas e contribui para reduzir a complexidade na criação de aplicações embarcadas bem como no uso otimizado do microcontrolador. Na personalização do RTOS e no desenvolvimento dos módulos é utilizado a toolchain Yagarto (GNU-ARM) e a IDE I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 41 Eclipse. Um dos módulos que está sendo implementado é um shell de comunicação para o microcontrolador, utilizando uma porta de comunicação serial. A base dessa interface já está implementada e funcional e facilita muito a utilização do microcontrolador. A interface serial é bem flexível, permitindo a comunicação entre um computador e o microcontrolador, um microcontrolador e outro microcontrolador e de um microcontrolador e um dispositivo, como um GPS, o que viabiliza a troca de dados entre diferentes dispositivos. O shell de comunicação é uma das tarefas no RTOS e possibilita o acesso e o controle aos recursos do microcontrolador de forma mais simples. Além disso, ela evita a necessidade de regravação do firmware dado que permite realizar ajustes de configurações durante a execução. Atualmente utilizando o shell é possível obter informações a respeito do Real Time Clock (ajustar e ver as horas) e alterar o estado das GPIOs (ligar ou desligar leds, por exemplo). Futuramente, será implementado no shell mecanismos que permitam organizar quais tarefas devem ser executadas e a sua sequência sem necessidade de recompilação, o que contribui para redução no tempo de desenvolvimento e na complexidade de criação da aplicação. Observa-se a partir dos resultados obtidos, o uso de RTOS tende a agilizar o desenvolvimento de firmware. No desenvolvimento de uma aplicação de coleta de dados, por exemplo, houve uma redução da complexidade de criação da aplicação, visto que apoiando-se em um SO, pode-se trabalhar modelar e implementar a aplicação com o conceito de tarefas e deixar a cargo do RTOS, o gerenciamento das trocas de contexto e do gerenciamento de regiões críticas. PALAVRAS-CHAVE Agricultura de precisão, Microcontroladores, Sistema Operacional de Tempo Real, ARM7. Tipo de Trabalho: Iniciação científica Agencia financiadora: CNPq I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 42 DESENVOLVIMENTO DE UM SIMULADOR MULTIMÍDIA PARA O ENSINO DE ESCALONAMENTO DE PACOTES Gustavo X. Santana - [email protected] Tatiana Annoni Pazeto - [email protected] UFMT- Universidade Federal de Mato Grosso - Rondonópolis/MT RESUMO O presente trabalho é fruto de uma pesquisa que objetiva o desenvolvimento de uma ferramenta de auxílio ao ensino/aprendizagem de escalonamento de pacotes. Através de pesquisas realizadas, dentre as várias ferramentas existentes, não foi encontrada nenhuma que atenda exclusivamente ao objetivo proposto, principalmente com a abordagem VAK (Visual, Auditive and Kinesthetic). Além disso, as ferramentas analisadas não são de fácil utilização, pois a maioria foi desenvolvida com objetivos comerciais. Desta forma, a ferramenta proposta irá preencher uma lacuna existente, sendo desenvolvida exclusivamente com a finalidade acadêmica. Assim, além desta diferença, o estilo de aprendizagem VAK será usado para o desenvolvimento da ferramenta. O assunto escalonamento foi escolhido por ser algo abstrato de ser visualizado e entendido, bem como os algoritmos de escalonamento que permitem aos dispositivos de controle de rede diminuir as desigualdades na distribuição da largura de banda, otimizando a utilização dos recursos da rede e evitando perdas de dados decorrentes de atrasos e/ou congestionamentos (Junior, 2007). Neste contexto, o processo de ensino/aprendizagem desta área do conhecimento é complexo, de forma que criar meios que possam sanar estas deficiências é uma necessidade evidente, fato que motivou esta pesquisa. Esta investigação é uma sequência do trabalho desenvolvido por Silva (2009), no qual foi implementado um simulador de escalonamento FIFO (First-in, First-out) e DRR (Deficit Round Robin) com o intuito de analisar o impacto das fontes de tráfego. Neste sentido, ao simulador desenvolvido por Silva (2009), serão adicionadas características e funções que possibilitem o auxílio ao ensino/aprendizagem de escalonamento de pacotes. Outrossim, como vários conceitos são necessários, para o desenvolvimento da ferramenta foi realizada uma pesquisa bibliográfica sobre simuladores, escalonadores de tráfego e, posteriormente, uma análise sobre softwares utilizados no ensino de redes. Desta forma, inicialmente foi realizado o levantamento dos requisitos com base na interface e funcionalidades do simulador desenvolvido por Silva (2009). Em seguida buscaram-se adicionar, ao simulador, funções e características que possibilitassem a utilização no processo de ensino/aprendizagem de escalonamento de pacotes. Após a análise de requisitos foi realizada a implementação de um pequeno protótipo da interface principal, utilizando a linguagem C/C++ e a biblioteca de programação de jogos Allegro, sendo este trabalho publicado por Santana e Pazeto (2010). Em seguida o protótipo foi analisado por alguns alunos e professores, que identificaram melhorias a serem implementadas, além de sugestões em geral. Estas já foram realizadas na interface do programa. Além disso, buscou-se implementar a interface de acordo com os estilos de aprendizagem VAK (Gallert, 2005; Frei, 2010), com o intuito de atender aos estilos de aprendizagem da maioria dos discentes. Neste sentido, as melhorias implementadas consistem na inclusão de ícones autoexplicativos, legendas ativadas ao passar o mouse pelo parâmetro e redução da quantidade de parâmetros mostrados simultaneamente. O objetivo é facilitar a utilização da ferramenta, contemplando características visuais, visando I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 43 atender aos estudantes que aprendem melhor através da visão. Além disso, os resultados gerados pelo simulador poderão ser visualizados em gráficos, através de um programa editor de planilhas, como o Calc do Broffice ou o Excel do Windows. Também poderão ser visualizadas animações referentes ao escalonamento dos pacotes, atendendo assim aos estudantes visuais e auditivos. Quanto aos sinestésicos, a interatividade fica por conta da alteração nos parâmetros de geração de tráfego, que modifica o resultado das simulações. Assim o aluno poderá perceber o impacto que as fontes exercem no que se refere a performance da rede. Futuramente, após a conclusão do simulador, o mesmo deverá ser avaliado e validado através de critérios baseados em estilos de aprendizagem VAK e também referentes a ergonomia de interfaces, além de questões consoantes ao ensino/aprendizagem. Desta forma, a partir destes critérios pré-definidos, será elaborado um formulário onde uma turma de alunos, após utilizar o programa, irá avaliá-lo baseando-se nesses requisitos. Desse modo, os principais resultados obtidos até agora foram a implementação da interface da ferramenta proposta, de acordo com os estilos de aprendizagem VAK, bem como a geração de fontes on/off fixas através da inserção de diferentes parâmetros. Além disso, também foram definidas as funcionalidades que irão ser implementadas como forma de auxílio à utilização da ferramenta (menus de ajuda, formas de apresentação das informações) no ensino/aprendizagem do que foi proposto. Como trabalhos futuros estão a integração da ferramenta ao simulador para escalonamento FIFO e DRR, além de formas diferenciadas de apresentação dos resultados das simulações e outros modelos de geração de fontes de tráfego. PALAVRAS-CHAVE Redes, Escalonamento, Simulação, Ensino/aprendizagem, Modelos de Tráfego. Tipo de Trabalho: Trabalho de conclusão de curso I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 44 ESTIMATIVA DE EVAPOTRANSPIRAÇÃO UTILIZANDO REDES NEURAIS Thiago Meirelles Ventura, Allan Gonçalves de Oliveira, Claudia Aparecida Martins, Josiel Maimone de Figueiredo, Andréia Gentil Bonfante [email protected], [email protected], {claudia,josiel,andreiab}@ufmt.br UFMT – Universidade Federal de Mato-Grosso - Cuiabá / MT RESUMO Em áreas relacionadas com agricultura é importante saber qual a quantidade de vapor de água está presente na região da plantação. Essa quantidade de água depende da evapotranspiração da cultura presente na região, que é a soma da transpiração das plantas com a evaporação da água no solo. Conhecendo a evapotranspiração da cultura, é possível determinar e aplicar de maneira mais racional a irrigação necessária à mesma, economizando recursos e potencializando o resultado da cultura. A evapotranspiração geralmente é estimada de duas maneiras: por lisímetro e pelo método de razão de Bowen. O lisímetro é um instrumento que necessita de grandes esforços para a sua instalação, impossibilitando de ser aplicado em várias pesquisas. Já o método de razão de Bowen é um conjunto de fórmulas que tem como característica uma medida indireta baseado na energia líquida disponível ao meio, ou seja, o saldo de energia após todas as trocas energéticas. Baseia-se no princípio de conservação de energia, aplicado aos mecanismos físicos envolvidos no fenômeno de evapotranspiração. O método da razão de Bowen tem suas limitações e, às vezes, não consegue estimar com exatidão a evapotranspiração. O problema é que o método não leva em consideração a energia armazenada no sistema, o que pode levar a uma subestimação da evapotranspiração. O objetivo deste trabalho consiste na utilização das técnicas computacionais de aprendizado usando redes neurais para tentar obter uma estimativa da evapotranspiração de maneira mais fácil, do que utilizando um lisímetro, e mais preciso, do que utilizando o método de razão de Bowen, fazendo um comparativo entre os métodos. Assim, para estimar a evapotranspiração, foi definida a arquitetura de redes neurais perceptron multicamadas, usando o algoritmo de retropropagação para seu treinamento. Na implementação e treinamento da rede foi utilizado o software MATLAB, que possui como característica a resolução de cálculos complexos por meio de funções já incorporadas em seu sistema. No conjunto de treinamento, as entradas da rede neural foram os dados de radiação global, calor sensível e calor latente para estimar a evapotranspiração, as mesmas variáveis utilizadas no método de razão de Bowen. As saídas são os valores reais medidos pelo lisímetro, com isso espera-se que a rede alcance valores mais próximos do real. Os resultados alcançados após o treinamento da rede foram semelhantes, não demonstrando muita diferença ao método proposto por Bowen. Entretanto, os resultados podem ser considerados animadores, visto que a rede pode ser ajustada e novamente treinada, com possibilidade de se estimar valores que são difíceis de obter com instrumentos específicos, mas que se baseiam em parâmetros simples. Espera-se que com a inserção de mais um parâmetro que possa representar a energia armazenada pelo sistema (tipo de solo, vegetação, entre outras características do meio) possa alcançar resultados mais I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 45 representativos. Apesar da rede neural ter um treinamento pesado, a vantagem é ajustar seus parâmetros até a possível convergência e, com isso, obter um resultado satisfatório e rápido da rede neural treinada. Com os testes realizados, acredita-se que seja possível chegar a um resultado comparado aos dos lisímetros e, assim, propiciar uma maneira mais simples de estimar a evapotranspiração auxiliando a parcela da sociedade e de órgãos governamentais que atuam no ramo da agricultura, principalmente quando os recursos são limitados. PALAVRAS-CHAVE Redes neurais, matlab, bowen, evapotranspiração. Tipo de Trabalho: Trabalho de Grupo de Pesquisa I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 46 ETIQUETAS INTELIGENTES - RFID Bruno Delanne Porto Dourado – [email protected] Lidia Martins da Silva – [email protected] UNIRONDON – Centro Universitário Cândido Rondon - Cuiabá / MT RESUMO Este trabalho está voltado para o estudo da tecnologia RFID (Identificação por Rádio Frequência), também conhecida como Etiquetas Inteligentes. Tem como objetivo, apresentar a tecnologia RFID, suas vantagens e desvantagens, os desafios e as barreiras existentes para a implantação e realizar um estudo em algumas empresas da cidade de Cuiabá e Várzea Grande quanto ao uso desta tecnologia. Estas etiquetas são dispositivos eletrônicos que são fixadas em objetos, semelhantes às conhecidas etiquetas de código de barras e utilizam ondas de rádio como meio de transporte; permitindo em tempo real a transferência de informações entre um dispositivo portátil e um computador. Sua aplicabilidade nos diversos setores permite diminuir o tempo de espera quanto à detecção, conferência e controle de informações sobre qualquer objeto. As informações como, por exemplo, de identificação ou controle de produção de um objeto são armazenadas em memórias e transmitidas ou recebidas através de um par de antenas, sendo uma delas acoplada ao equipamento transmissor e outra ao receptor, mais especificamente à etiqueta. Quanto ao campo de aplicação, observa-se nos mais variados lugares, nos quais, produtos, objetos e pessoas tenham que ser etiquetadas e identificadas para posterior acompanhamento e/ou processamento. Aqui citamos alguns exemplos, tais como: acompanhamento de estoques, acompanhamento de corredores em uma corrida, Coladas nos produtos em mercados, farmácias, supermercados, dentro de passaportes, para evitar fraudes de documentos, no transporte e logística de produtos e containers, na identificação animal, em implantes humanos, em bibliotecas em livros raros e caros. A vantagem significativa dos sistemas de RFID é a de não exigir contato nem campo visual para fazer a leitura das etiquetas. As etiquetas podem ser lidas através de uma variedade de substâncias como água, névoa, gelo, pintura, sujeira, plásticos, madeira e em condições ambientais que outra tecnologia óptica não tem, também permite a leitura em circunstâncias desafiadoras e em velocidades notáveis – na maioria dos casos, a resposta é de menos que 100 milissegundos. A capacidade de leitura/escrita de um sistema de RFID também é uma vantagem significativa em aplicações interativas, como controle de manutenção, apesar de ser uma tecnologia mais cara se comparada ao código de barras. A RFID se tornou indispensável para uma grande variedade de coleta de dados e aplicações de identificação automatizada que não seriam possíveis com outras tecnologias. A tecnologia de radiofrequência deverá num futuro próximo, atuar paralelamente ao código de barras ou até mesmo substituí-lo, em situações que permitam e justifiquem sua aplicação. Passa a ser analisada como solução de médio e longo prazo para indústrias e comércios, possibilitando a identificação de produtos à distância e a troca de informações por meio de ondas de rádio, com ganhos inquestionáveis em agilidade na transmissão e também na qualidade dos dados que trafegam pelo sistema. As RFIDs serão capazes de reduzir o desperdício, manter os níveis conservados em estoque ao mínimo, encurtar tempos de ligação e permitirão que alguns varejistas obtenham preços mais baixos, eliminando o custo em todos os níveis. Em cartões de identificação para a segurança do empregado, posição dentro dos escritórios, dados da equipe de I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 47 funcionários para programas da fidelidade do cliente, veículos guiados automaticamente em linhas de montagem, sistemas automatizados de bagagem de linhas aéreas, o uso será quase universal através de todas as indústrias. Para realização deste trabalho e atingir o objetivo proposto, utilizou-se de pesquisa bibliográfica através de livros, revistas e artigos para análise do funcionamento geral do sistema de RFID e uma pesquisa de campo, realizada em várias empresas situadas nas cidades de Cuiabá e Várzea Grande, com o intuito de obter respostas quanto ao conhecimento das mesmas sobre a tecnologia RFID, qual empresa estaria utilizando e qual segmento, quais foram as vantagens percebidas na utilização, se obteve ganhos ou perdas, se houveram dificuldades na implantação, onde eram adquiridas a tecnologia e qual a opinião dos proprietários e funcionários quanto ao uso da tecnologia. Das empresas pesquisadas, a grande maioria possui conhecimento sobre a tecnologia, suas vantagens e desvantagens, porém não a implantaram, por considerarem o custo ainda muito elevado. Mesmo sendo uma tecnologia confiável, poucas são as empresas que a utilizam em nossa região. Podemos citar aqui como exemplos, apenas algumas empresas subsidiárias de produção de alimentos frigoríficos, supermercados e empresas de eventos esportivos. PALAVRAS-CHAVE: Rádio frequência. Tecnologias. Etiquetas. Tipo de Trabalho: Trabalho de Graduação I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 48 FORMAÇÃO TECNOLÓGICA CONTINUADA NAS ESCOLAS ESTADUAIS DA REGIÃO NORTE DE CUIABÁ – TRANSPONDO BARREIRAS Elza Santos Moura de Jesus [email protected] RESUMO A concepção deste artigo se baseia na experiência da Introdução à Educação Digital nas escolas estaduais da região norte de Cuiabá no período de 2009 a 2010. Nesse enfoque será trabalhada a importância da busca pela formação continuada dos funcionários e professores. Visto que a sociedade atual, denominada por muitos como sociedade do conhecimento, da informação, do avanço tecnológico entre outros. Com base na rapidez e facilidade com que as informações são disponibilizadas, em função do desenvolvimento dos recursos tecnológicos e meios comunicações, com elevado potencial transformador e integrador das atividades sociais, políticas e econômicas, capazes de promover a integração entre as pessoas, programas e projetos em diversos níveis. A sociedade do conhecimento através das tecnologias da informação e comunicação busca novas formas de produzir, preservar, atualizar e transmitir o conhecimento, à memória coletiva, que possam alterar as práticas educacionais as quais eram direcionadas apenas para a oralidade e a escrita tradicionais, com isso o fluxo de saber, o trabalho do conhecimento, as novas tecnologias da inteligência individual voltada ao coletivo mudam profundamente o enfoque da educação e da capacitação, fazendo com que seja repensada a postura interdisciplinar, transdisciplinar e multidisciplinar, revendo os processos didáticos e inteirando-se das inovações tecnológicas e novas alternativas sejam criadas para se chegar a um resultado prático da reconstrução do ambiente educacional escolar. O grande desafio é sem dúvida capacitar funcionários e professores, fornecendo ferramentas e recursos, ao professor para que possa utilizar novas linguagens para ministrar aulas mais interativas, propiciando aprender a ensinar, aprendendo a aprender e vivendo no coletivo, requisitos básicos para essa nova sociedade do conhecimento. Com este artigo pretendo discutir alguns pontos, de grande relevância, que possam propiciar uma reflexão sobre a importância da introdução à Educação Digital no seu cotidiano e no contexto escolar na sociedade como um todo: os desafios da inclusão digital, a utilização da internet, correio eletrônico, debate em rede, editores de textos, slides, criação de blogs, cooperação e interação em rede e criação de planilhas eletrônicas. As possíveis vantagens e obstáculos do uso da informática na escola. A metodologia utilizada foi pesquisa investigativa quantitativa e qualitativa, através de questionários e avaliação dos cursistas sobre o conhecimento adquirido. Os resultados obtidos contribuíram para se ter uma visão desta transposição de barreiras. Com a finalidade de poder contribuir através da publicação deste artigo com os nobres colegas docentes e discentes para que juntos possamos romper os velhos paradigmas e voltar o nosso olhar ao novo (tecnologia), a fim de construir uma sociedade globalizada mais justa e igualitária na sua diversidade e tempo, tanto no quesito digital quanto social. I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 49 PALAVRAS-CHAVE: Formação continuada, Inclusão social e digital na diversidade - globalização, informática educacional. TIPO DE TRABALHO: Iniciação Científica I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 50 GCOMPRIS E A INCLUSÃO DIGITAL 1 Laura M. S. Cunha - [email protected] 2 Alex F. de Araújo - [email protected] 1 Carlos A. S. J. Gulo - [email protected] 1 – UNEMAT – Universidade do Estado de Mato Grosso – Alto Araguaia / MT 2 – FEUP – Faculdade de Engenharia da Universidade do Porto - Porto / Portugal RESUMO O uso de computadores como ferramenta de apoio no processo ensinoaprendizagem vem acontecendo gradativamente na rede de ensino, e os programas de computador utilizados neste processo merecem atenção especial. Um destes softwares educacionais que merece destaque é o GCompris. Durante este trabalho, este sistema foi aplicado em um ambiente real, para ensino de disciplinas do nível fundamental. Durante os experimentos realizados neste projeto, foi possível verificar as potencialidades e conformidades do GCompris com os PCNs (Parâmetros Curriculares Nacionais). Atualmente, é notável a importância da informática em vários setores da sociedade, sendo não apenas útil, mas também indispensável para a vida do cidadão. Surgem então questionamentos sobre como essas tecnologias têm sido usadas na sociedade, tornando imprescindível a preparação dos indivíduos para enfrentar os desafios apresentados nesse novo contexto. Acreditamos na evidente necessidade da sociedade atual de se apropriar do conhecimento tecnológico até por uma questão de sobrevivência social. No entanto, há muitos indivíduos despreparados que acabam sendo excluídos dessa sociedade, na qual os indivíduos são classificados como: incluídos ou excluídos digitalmente. Neste contexto, há uma emergente demanda no mercado com excelentes salários e condições de trabalho, entretanto, nestes casos a exigência mínima é a qualificação profissional. O conhecimento de uso dos computadores faz parte desta exigência, estando incluído na qualificação profissional. Assim, este trabalho tem como objetivo apresentar as potencialidades de uso do software GCompris, para aplicação em disciplinas do ensino fundamental, tendo como referência os Parâmetros Curriculares Nacionais (PCNs). O GCompris é um software que oferece inúmeras atividades educacionais, disponibilizando atividades educacionais para crianças de 2 a 10 anos de idade. O projeto desenvolvido durante este trabalho, cujo tema foi: “O uso do Software GCompris na escola”, foi oferecido à 50 alunos do ensino fundamental de uma escola pública no interior do Estado de Mato Grosso. As crianças envolvidas tinham entre sete e nove anos de idade, foram levantados dados sobre a utilização do software como ferramenta de apoio ao ensino. Dessa forma, buscou-se a caracterização dos PCNs para os conteúdos que devem ser explicados aos alunos nas séries iniciais do ensino fundamental. As mesmas atividades foram aplicadas em três turmas do primeiro ano do ensino fundamental. Participaram das atividades, 17 crianças de uma turma chamada neste trabalho de X, 18 crianças de uma turma chamada Y, e 15 crianças de uma turma chamada Z. O laboratório de informática utilizado possuía 20 computadores para utilização dos alunos, e 1 computador para uso do professor. Como material referencial para aplicação do curso, foi utilizado o “Manual de utilização do Software GCompris” desenvolvido para realização desta pesquisa, além de planos de aula que foram cuidadosamente elaborados durante a realização do curso. Os planos de aulas contemplaram, em geral, metade da carga horária da disciplina para uso do software GCompris como ferramenta de I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 51 apoio ao conteúdo previsto no ementário. Durante a realização da pesquisa, observou-se que mesmo com a tecnologia presente no cotidiano das pessoas, como o uso de caixa eletrônico, telefone celular, Internet, dentre outras, não é possível garantir a inclusão digital de todos os envolvidos. Utilizando o método de pesquisa não-experimental foi possível verificar a significativa mudança neste cenário, o qual a exploração do ambiente de aprendizagem permitiu o desenvolvimento da autonomia de operacionalização daquele software. Neste ambiente, é extremamente viável tratar sobre diversos assuntos vistos em sala de aula. Estes assuntos apresentados, exercitados e discutidos, permitem ao professor, tornar-se agente socializador de todo o processo. Diante de relatos, observou-se que os alunos avaliaram positivamente a aplicação do software, pois ele encaixa-se com muita propriedade em várias atividades como cálculo, experimentos, raciocínio, leitura e escrita. Acredita-se que o processo de ensino/aprendizagem foi muito facilitado devido ao compartilhamento e aplicação dos conteúdos propostos. Apoiado em um modelo construtivista de base piagetiana, a proposta aqui edificada proporcionou aos alunos visualizar os objetos através de suas próprias imagens, mantendo-os mais tempo presente na mente para reflexão sobre os mesmos. Para validar os resultados de aproveitamento, foram aplicados pré-testes após as aulas sem o software, e póstestes após as aulas com aplicação do software GCompris. Diante da perspectiva de contribuição com o aprendizado que o GCompris demonstrou neste estudo, defendemos que o indivíduo tenha contato, ou saiba como utilizar as TICs desde as séries iniciais do ensino fundamental. Assim sendo, conhecem uma nova forma de “aprender a pensar”, transformando-se em indivíduos críticos, capazes de transformar a realidade no qual estão inseridos. O uso do GCompris mostrouse facilmente aplicável pelos professores, pelo fato de adequar-se aos conteúdos exigidos em diversas disciplinas e no reforço ao conteúdo específico para os alunos. Além disso, oferece uma forma intuitiva no aprendizado de uso do computador. A utilização de software livre, especificamente o GCompris, oferece uma alternativa de promoção da inclusão digital nas escolas, uma vez que o mesmo tem objetivo de tornar o acesso fácil e econômico em razão do não pagamento de licença. A aplicação do GCompris resultou em uma aprendizagem significativa e eficiente, provendo interações entre as pessoas, os meios e os préconhecimentos de cada participante. Além disso, contribuiu também para o crescimento do saber social, maior familiarização no manuseio dos equipamentos, e também o aprendizado sobre conteúdos específicos do ensino formal, e atividades relacionadas. PALAVRAS-CHAVE Informática na Educação, Software Livre, Educação Tecnológica TIPO DE TRABALHO: Trabalho de Graduação I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 52 GERENCIAMENTO E ARMAZENAMENTO DE DADOS MICROMETEOROLÓGICOS 1 Allan Gonçalves de Oliveira – [email protected] 1 Thiago Meirelles Ventura – [email protected] 1 Josiel Maimone de Figueiredo – [email protected] 1 Claudia Aparecida Martins – [email protected] 1 Andréia Bonfante Gentil – [email protected] 1 – UFMT – Universidade Federal de Mato Grosso – Cuiabá / MT RESUMO Variáveis micrometeorológicas são alvos de constante estudo, principalmente no Brasil, onde grande parte do território ainda demanda muitos estudos a respeito disso. Essas variáveis, na maioria das vezes, são estudadas por grupos de pesquisa de instituições de ensino, onde muitas pessoas manipulam as mesmas informações. Com o levantamento de requisitos feito no Programa de PósGraduação em Física Ambiental (PGFA) da Universidade Federal de Mato Grosso (UFMT), percebeu-se que, no processo operacional de manipulação desses dados, geralmente não há uma prática sistemática de organização das informações e cada pesquisador usa planilhas de dados isoladas, com controles e validações próprias. Somado a esse problema, tem-se a complexidade desse tipo de informação, a grande variedade de fontes e o grande volume de dados, por essa razão é necessário existir uma infraestrutura computacional que contemple todos esse requisitos. Nesse contexto, este trabalho envolve a modelagem de um sistema para armazenamento e gerenciamento de dados micrometeorológicos utilizando os conceitos envolvidos nos Enterprise Resource Planning (ERP). Os ERPs são sistemas de informações que integram todos os departamentos e funções de uma organização, tanto sob a perspectiva funcional quanto sistêmica, permitindo total ligação entre toda a organização. Assim, a modelagem objetiva integrar as informações de forma a permitir que a validação dos dados e o processamento sejam flexíveis, eficiente, garantindo confiabilidade e rastreabilidade das informações. O compartilhamento das validações facilita o trabalho colaborativo da equipe permitindo que o conhecimento do especialista que foi embutido nas validações seja difundido e verificado por um maior número de pessoas. O modelo de dados criado, foi dividido em duas partes principais. A primeira parte refere-se a área reservada de perfis e permissões para acesso ao sistema. Isso é necessário porque os dados inseridos nesse banco têm uma grande importância científica, e as pessoas que têm acesso a esse banco devem ser previamente cadastradas e habilitadas em um perfil para controlar que tipo de informação elas podem inserir, alterar, remover ou consultar dentro do sistema. Outro aspecto relevante é que as validações embutidas pelos pesquisadores precisam ser verificadas antes de torná-las públicas. A segunda parte da modelagem detém a gravação dos dados coletados pelos equipamentos em campo. Nesse contexto, existem diversos tipos de equipamentos e sensores que realizam a leitura de variáveis climatológicas, cada um com uma calibração única e capaz de coletar dados referentes a uma ou mais variáveis climatológicas. Todas essas informações devem ser armazenadas de forma integrada uniformizada e transparente no banco de dados. Em paralelo à implementação do banco de dados, foi implementado o módulo de importação dos dados coletados, esse módulo foi escrito utilizando o framework de desenvolvimento web JBoss Seam, que integra a tecnologia Java Server Faces (JSP), Enterprise Java Beans I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 53 (EJB) e Extensible Hypertext Markup Language (XHTML). Nessa camada de apresentação dos dados, o enfoque está também na gestão dos dados ambientais e da infraestrutura de captação dos dados, ou seja, os colaboradores, estações micrometeorológicas e equipamentos. Nos testes de importação dos dados surgiram alguns problemas. Os arquivos gerados pelos equipamentos não seguem um padrão. Dependendo de como o mesmo foi programado, ele pode gerar arquivos diferentes. Essa característica dificulta o trabalho de uma ferramenta automatizada para importar dados. Além disso, podem existir dados falhos e/ou faltantes no conteúdo dos arquivos. Para contornar esses problemas a interface de importação teve de ser modificada algumas vezes buscando maior flexibilidade, pois a uniformização das informações que já estão modeladas no banco de dados precisa ser refletida também na interface com o usuário. Com o sistema finalizado os pesquisadores que trabalham com dados meteorológicos têm uma nova ferramenta para auxiliar em suas pesquisas. O item mais importante em uma pesquisa são os dados, e esta ferramenta fará com que esse item esteja facilmente na posse dos pesquisadores. O mesmo sistema pode ser aplicado na distribuição de informações climáticas para a sociedade e para o governo, já que todos os dados estarão concentrados em um só local e em uma plataforma web. Consequentemente, essa infraestrutura facilita a análise quanto ao comportamento micrometeorológico de uma determinada região estudada, auxiliando na tomada de decisões e inferências comportamentais a respeito do microclima, seja por pesquisadores, órgãos interessados do governo e até para a criação de um veículo informativo para a sociedade. Para trabalhos futuros, será implementado com inteligência artificial uma solução para tratar dos dados ausentes e/ou falhos mencionados neste trabalho. E ainda, um módulo para facilitar a extração de informações do sistema, gerando gráficos e planilhas dependendo do filtro escolhido pelo usuário. PALAVRAS-CHAVE Banco de dados, dados micrometeorológicos, erp. Tipo de Trabalho: Dissertação I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 54 HOTSPOT COM CAPTIVE PORTAL PARA ACESSO A INTERNET 12 André Valente do Couto – [email protected] 1 Wellyngton Rodrigues Siqueira – [email protected] 1 – UNIRONDON – Centro Universitário Cândido Rondon - Cuiabá / MT 2 – IFMT – Instituto Federal de Mato Grosso - Cuiabá / MT RESUMO Este trabalho teve como objetivo principal a conceituação e instalação de um Hotspot de internet sem fio de baixo custo e de alta aplicabilidade, com autenticação centralizada em um servidor LDAP e o intermédio de uma solução de Captive Portal. Pode-se dizer que o Hotspot é uma solução para a maioria das empresas ou universidades que desejam compartilhar internet para seus clientes ou alunos da instituição sem a necessidade de passar senha ou simplesmente deixar liberado sem nenhum tipo de controle de acesso, tornando assim vulnerável para qualquer pessoa não credenciada o seu acesso e o uso impróprio. A solução adotada foi o software livre PFSense, software este que foi desenvolvido baseado na distribuição FreeBSD e que foi adaptado para ser um firewall/roteador. O PFSense possui uma vasta quantidade de funcionalidades que o coincidem a softwares e soluções proprietárias, entre as funcionalidades o Captive Portal. A base LDAP utilizada é o Active Directory da Microsoft, pelo o motivo da grande aceitação desse software nos ambientes de TI do Centro-Oeste e pela a sua facilidade de integração com outras ferramentas é o que torna a solução muito interessante no aspecto tecnológico e viável no aspecto mercadológico. A realização deste trabalho teve como base de pesquisa livros, conteúdo disponível na rede mundial de computadores, além da observação por meio de manipulações de softwares de computação que nos auxiliou através de um ambiente virtualizado e também durante o processo experimental em laboratório que resultou nos resultados finais para os efetivos ajustes da solução. Hotspot é um ponto de acesso WiFi que tipicamente possui acesso a internet. Como toda solução de acesso sem fio, para ter o mínimo de segurança é necessário saber quem está utilizando, por isso é indispensável à autenticação dos usuários. Para isso era necessário um mecanismo que fizesse a autenticação do usuário sem a necessidade de ficar instalado programa ou ficar divulgando a senha para se conectar no Hotspot, foi então que surgiu a solução Captive Portal. Captive Portal é uma ferramenta capaz de tornar o browser do usuário uma ferramenta de autenticação. Nesta arquitetura todas as requisições solicitadas ao Hotspot são automaticamente redirecionadas para o Captive Portal, o qual retorna uma página web para autenticação no browser do usuário solicitante, nesta pagina além de conter a politica de utilização, o solicitante deverá informada as credenciais para que seja liberado tal acesso ou que novas credenciais sejam criadas. Caso as credenciais sejam aceitas, dinamicamente, são realizadas alterações no firewall do PFSense liberando a navegação e os demais recursos disponível no Hotspot para o solicitante. No PFSense que além da ferramenta Captive Portal foram implementados as seguintes funcionalidades para obter um melhor desempenho e garantir as segurança dos usuários: Proxy/Cache; Servidor DNS; Firewall; Estatísticas de utilização da rede; DHCP; SARG; Qualidades de Serviço (QoS). Na base de dados de usuários LDAP, foi implementado o Active Directory intermediado pela solução IAS (Sistema de autenticação da Internet) que atua como um servidor Radius para implementação das propriedades de I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 55 Autenticação, Autorização e Auditoria centralizada de todos os acessos do Hotspot. No caso deste trabalho, tanto o PFSense como o Windows Server 2003 possuem suas implementações de servidores RADIUS: free-radius no PFSense e IAS no Windows Server 2003. A escolha pelo IAS se deu unicamente pela facilidade de implementação e armazenagem dos dados gerados fora do ambiente de exposição que se encontra o servidor Hotspot. Depois de configurados os serviços e integradas as plataformas, foi possível implementar a um custo extremamente baixo uma solução completa e funcional de autenticação sem fio à internet. Pelo fato da implementação ter sido executada em um ambiente virtualizado a disponibilidade de ampliar sua utilização e demonstração da solução se tornou ampliada. Este trabalho originou-se de uma necessidade do mercado e através do estudo utilizando as metodologias científicas das tecnologias abordadas, nos teste realizados obtivemos êxito em seu funcionamento. Além de permitir o aprimoramento técnico decorrido da pesquisa científica, esta é uma solução viável e de baixo custo que possui alta aplicabilidade em todos os ambientes de redes sem fio. PALAVRAS-CHAVE redes sem fio, hotspot, captive portal, segurança de redes, autenticação Tipo de Trabalho: Trabalho de Graduação I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 56 INTEGRAÇÃO DE DADOS: UM ESTUDO DE CASO NA ÁREA EDUCACIONAL 1 Maicon Ança dos Santos – [email protected] 1 Sandro da Silva Camargo – [email protected] 1 – FATEC - Faculdade Senac de Tecnologia – Passo Fundo / RS RESUMO Nos dias atuais, é comum encontrar empresas que utilizem, simultaneamente, diferentes sistemas de informação em seus setores. Neste contexto, o aproveitamento destes dados para o processo de tomada de decisão é dificultado, tornando-se indispensável a realização de um processo de integração de dados. Este artigo apresenta uma proposta de integração para as diferentes fontes de dados de um Instituto Federal de Educação Tecnológica. O objetivo do trabalho é gerar uma base de dados integrada para servir de recurso a um processo de mineração de dados, o qual irá investigar a existência de padrões de evasão escolar. Assim como ocorre nos diversos ramos de atividade, as empresas da área educacional também sofrem com a coexistência de diferentes fontes de informação em seus setores. Dentro deste escopo, o Campus Passo Fundo do Instituto Federal Sul-rio-grandense (IFSul), que está em atividade há poucos anos, já apresenta grandes quantidades de informações sobre seus alunos distribuídas em diversos setores. Concomitantemente a isto, atualmente percebese a existência de um nível representativo de evasão dos alunos. Tal situação despertou a necessidade de descobrir quais seriam os motivos responsáveis pela diminuição considerável no número de alunos da Instituição. A utilização de técnicas de mineração de dados para identificação automática de padrões de evasão demonstrou-se ineficiente através da análise individual das diversas fontes de dados principalmente devido à existência de redundâncias e inconsistências entre as fontes. Assim, a realização de um processo de integração de dados tornou-se indispensável para análise e identificação de padrões de evasão. Dada esta necessidade, este trabalho descreve a realização de um processo de integração das diferentes fontes disponíveis de dados no IFSul, o que permitiu a posterior mineração dos dados de maneira eficiente. Para este trabalho foram utilizados os dados das diversas fontes de interesse. Estes dados estavam disponíveis originariamente na forma de planilhas eletrônicas em formato proprietário MS-Excel com os dados de alunos disponíveis em casa setor do instituto. Para realizar o processo de integração, foi utilizada a ferramenta Kettle, do pacote Pentaho. Para realizar o processo de mineração foram testados diversos algoritmos de classificação, implementados dentro da ferramenta Weka, a fim de identificar padrões dos alunos evadidos. As fontes de dados selecionadas, que estavam na forma de planilhas MS-Excel, foram inseridas na ferramenta Pentaho, que é um pacote de software de código aberto para sistemas de Business Intelligence (BI), do qual foi utilizado o módulo de Extraction Transformation and Loading (ETL), denominado Kettle. À ferramenta Kettle foi adicionado um complemento de software chamado ArffOutput, que é capaz de salvar saídas de dados em arquivos no formato Attribute-Relation File Format (ARFF), a fim de permitir que os dados possam ser interpretados pelo software Weka. O Weka é um pacote de mineração de dados que implementa uma coleção de algoritmos para este fim. A ferramenta Kettle foi capaz de realizar a integração das diferentes fontes em uma única base de informações no padrão ARFF. O arquivo resultante foi minerado com sucesso em busca de padrões de dentre os I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 57 alunos evadidos. Com relação à maneira com que os dados são tratados, atualmente, no campus Passo Fundo, as tarefas de integração contribuíram para uma análise mais detalhada e com a descoberta de padrões de comportamento dos alunos do campus. Neste trabalho foi apresentado um estudo de caso de aplicação de técnicas integração de dados em uma organização da área educacional. O resultado do trabalho foi a geração de uma fonte de dados integrada para servir de subsídio a um processo de mineração de dados para facilitar a tomada de decisão sobre problemas de evasão escolar. Os resultados apresentados demonstraram, com eficiência, que é possível integrar diversas fontes de informação para mineração e, assim, prover a análise de grandes volumes de dados de forma automatizada. Os experimentos realizados no decorrer deste estudo se mostraram muito satisfatórios, inclusive, abrindo portas para sua utilização em estruturas maiores de aplicação prática como, por exemplo, todos os campi que integram o Instituto Federal Sul-rio-grandense, pois as demandas que surgiram no campus Passo Fundo, podem ser objeto de estudo nas demais unidades também. Por fim, a importância do objeto de estudo deste artigo se dá pela grande necessidade de não somente ter dados armazenados, mas sim informação e conhecimento extraídos, facilitando as atividades dos gestores das unidades do Instituto. Em projetos futuros, serão sugeridas propostas de estudos de maior amplitude, a fim de analisar os dados do instituto como um todo e, com base nas informações obtidas, descobrir quais regiões tem maior ou menor propensão à evasão escolar, fato este que colaborará para o desenvolvimento do sucesso do aluno dentro da Instituição. PALAVRAS-CHAVE Integração de Dados, Mineração de Dados, Evasão Escolar, Pentaho. Tipo de Trabalho: Trabalho de Conclusão de Curso de Especialização I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 58 INTERFACE EM LINGUAGEM NATURAL USANDO AGENTES INTELIGENTES 1 Marcos Eduardo Rizzi – [email protected] 1 – UFMT – Universidade Federal de Mato Grosso - Cuiabá / MT RESUMO Muitas pessoas deixam de usar o computador por “medo”, por desconhecerem a linguagem utilizada para comunicar-se com ele ou por não adaptarem-se as diversas formas de interface existentes e, ainda, as pessoas que se adaptam ao uso de interfaces, limitam-se ao uso de apenas um tipo, pela dificuldade em aprender como manipular diversas interfaces. Quando um software possui uma quantidade muito grande de recursos, a utilização de menus ou ícones pode dificultar o acesso a algumas funcionalidades do programa, ou alguns recursos podem ficar ocultos em meio a grande quantidade de opções. Pensando nos problemas de ocultação de recursos e de ambiguidade de ferramentas com formas distintas de manipulação, neste resumo é apresentada uma interface de comunicação em linguagem natural que facilite a utilização do computador. O funcionamento da interface desenvolvida consiste de um protótipo que atua executando comandos no terminal Linux. Assim, ao invés de o usuário decorar inúmeros comandos Shell ou manter sempre a mão um manual, ele pode fazer solicitações em linguagem natural e o protótipo interpreta a solicitação e executa o comando desejado. A metodologia utilizada no trabalho foi dividida em três partes principais: a revisão bibliográfica, o desenvolvimento do protótipo e os testes realizados com o protótipo. O Agente desenvolvido segue o modelo de agente reativo simples com aprendizado proposto por Russel & Norvig(2004). O método de compreensão da linguagem natural foi adaptado do modelo de casamento de palavra chave, abordado por Rich(1988). O aprendizado do agente é baseado em exemplos (experiência) que são fornecidos durante o treinamento. Para responder a uma solicitação em linguagem natural o agente consulta em sua base de dados exemplos que possuam palavras-chave compatíveis com as da solicitação, depois cada exemplo é avaliado e o que possuir maior significância é escolhido como resposta e executado. A importância de um exemplo é calculada por meio da comparação de suas palavras-chave com as da solicitação e pela quantidade de vezes que o exemplo já foi utilizado como resposta. Foi utilizado como sistema operacional base o Linux Ubuntu 9.10, e a linguagem de programação Java, as informações necessárias ao funcionamento do protótipo são armazenadas em uma base de dados Mysql. A escolha destes recursos se deu devido ao bom nível de desempenho apresentados, por possuírem vasto material para consulta e por serem softwares gratuitos. No primeiro teste apenas um voluntário inicia o treinamento do agente, todas as solicitações feitas são relacionadas a apenas um comando Linux, por exemplo o comando ls, que lista os arquivos e subdiretórios do diretório atual. Com apenas quatro exemplos o agente obteve acerto máximo em todas as solicitações, este fato se deve a restrição da aplicação do conhecimento do agente. No segundo teste foi feito treinamento do agente para execução de dez comandos. Neste teste, cinco voluntários iniciam simultaneamente o treinamento do agente, cada um é responsável por dois comandos Linux, eles fazem solicitações e adicionaram novos exemplos até que o agente obtenha o máximo de acerto em todas as respostas. Com o aumento do domínio de conhecimento do agente foram necessários mais exemplos por comando para que o agente alcançasse o I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 59 máximo de acerto em todas as suas respostas. Isto acontece porque alguns exemplos podem possuir palavras chaves em comum dificultando a escolha da resposta. Neste teste foram necessários setenta exemplos para que o agente obtivesse o máximo de acertos. A interface em linguagem natural usando agentes inteligentes que foi desenvolvida atende usuários que possuem pouco conhecimento na utilização do terminal Linux, evitando a necessidade de decorar os comandos ou de manter um manual sempre a mão. Além de utilizado como interface de comunicação, o protótipo desenvolvido pode ser utilizado também como ferramenta de aprendizado, para quem quer adquirir conhecimento sobre os comandos utilizados no terminal Linux, visto que os comandos são exibidos ao usuário antes de serem executados. O uso desse tipo de ferramenta evitaria a necessidade de treinamento para usuários leigos aumentando a acessibilidade para pessoas que possuem “medo” ou dificuldade em aprender sobre o funcionamento do computador e alguns comandos que talvez não sejam amigáveis. PALAVRAS-CHAVE Inteligência artificial, linguagem natural, agente inteligente, sistema operacional. TIPO DE TRABALHO: Trabalho de Graduação I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 60 INTERNET NOS LABORATÓRIOS DE INFORMÁTICA DAS ESCOLAS, COMO ADMINISTRAR O USO? – UMA AÇÃO DE EXTENSÃO 1 Francisco Sanches Banhos Filho – [email protected] 1 Ralf Hermes Siebiger - [email protected] 1 – UNEMAT – Universidade do Estado de Mato Grosso – Campus Universitário do Vale do Teles Pires - Colider / MT RESUMO O projeto compreende duas escolas públicas do município de Colider e a Universidade do Estado de Mato Grosso num esforço conjunto para oferecer, nos laboratórios de informática dessas escolas, acesso a internet de forma segura, filtrando acessos indevidos a sites de cunho erótico, que envolvam pedofilia ou que fujam do objetivo de ensino-aprendizagem. A proposta consiste na implantação de um Servidor GNU Linux para realizar o trabalho de proxy e firewall, ministrando-se treinamentos para que os profissionais que trabalham nos laboratórios de informática das escolas possam gerenciar este computador/servidor. INTRODUÇÃO Com o ingresso dos computadores no meio educacional, é fundamental o investimento na formação continuada dos profissionais da educação, especialmente no que tange à capacitação daqueles que atuam diretamente nos laboratórios de informática das escolas públicas. Atualmente, com o uso crescente da internet como ferramenta para diversos fins – pessoais, profissionais, educacionais, entre outros –, um dos temas que merece atenção diz respeito ao tipo de conteúdo acessado. Na esfera educacional, a preocupação recai sobre o acesso indiscriminado e mesmo ilegal a sites de cunho erótico, material de pedofilia, jogos que não tenham como finalidade as atividades de ensino-aprendizagem, e mesmo a utilização desse recurso apenas como forma de entretenimento. Considerando essa preocupação, a Universidade do Estado de Mato Grosso – Campus Universitário do Vale do Teles Pires, por meio do Projeto de Extensão Administração e filtro de conteúdo na internet - PROACI, propõe, como estratégia, a capacitação dos profissionais que já atuam nos laboratórios de informática e/ou como administradores de redes nas escolas públicas. Através de curso teórico-prático, com duração de 100 horas-aula, esses profissionais vêm sendo capacitados abordando-se conceitos básicos da administração de redes e servidores GNU Linux, objetivando-se também a implantação de servidores GNU Linux nas escolas participantes do projeto. Com a realização desse projeto, intenta-se que diretores, professores bem como os pais de alunos, tenham controle sobre o conteúdo acessado na internet pelos alunos, permitindo que se administre esse acesso por meio de restrições a sites proibidos para menores de 18 anos e, assim possibilitando a prevenção de possíveis crimes cibernéticos como difamação, bullying e cyberbullying. I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 61 METODOLOGIA A estratégia implementada nas duas escolas públicas do município de Colider – Escola Estadual Alzira Maria e Escola Estadual Des. Milton Pompeu de Barros – consiste na implantação de um Servidor que, além de suas funções precípuas, atua como roteador/firewall no compartilhamento da internet. Para tanto, esse Servidor procederá à uma separação entre a rede do laboratório (intranet) e a rede externa (internet) utilizando-se a ferramenta iptables, que possibilita a criação das regras de firewall. Ante esse procedimento, o Servidor passa a trabalhar como roteador do compartilhamento da internet, realizando um mascaramento dos pacotes oriundos da rede, bem como é também responsável pela própria conexão, protegendo assim todos os computadores que, através dele, realizam esse acesso. Juntamente com a implantação do Servidor Proxy, é necessária a implantação de um firewall, que é a base de um sistema de proteção contra ataques. Através dele, o administrador pode especificar que tipo de tráfego é ou não permitido dentro de uma rede, sendo normalmente utilizado para separar a rede pública, normalmente a internet, da rede interna (laboratórios). (NAKAMURA, 20077). RESULTADOS Um dos fatores de sucesso do projeto de extensão tem sido que praticamente todos os profissionais que atuam nos laboratórios de informática possuem bom conhecimento de informática. Com isso a implantação tem ocorrida sem maiores problemas. Assim, primeiramente é feito contato com o diretor da escola e é apresentada a lei, autorizada a implantação, os detalhes são tratados diretamente com o profissional que trabalha no laboratório. Na implantação do servidor é utilizada a técnica de Proxy Transparente, em que o tráfego é direcionado primeiramente à porta 80 do Servidor, e posteriormente redirecionado para a porta 3128 onde está ativo o Squid. Isso pode ser verificado no trecho do arquivo rc.firewall descrito a seguir: iptables -t nat -A PREROUTING -i eth1 -p tcp --dport 80 -j REDIRECT --to-port 3128 Para se obter sucesso no bloqueio ao acesso de conteúdo impróprio, foram utilizadas três listas: de palavras proibidas, de palavras permitidas e de sites que passam pelo squid sem a necessidade de se gravar qualquer informação. Ainda sobre a implantação, foi utilizada a ferramenta Squid Analysis Report Generator8 Sarg para tornar os logs do Squid mais amigáveis, possibilitando assim encontrar e adicionar mais palavras nas listas. CONCLUSÃO A preocupação com o conteúdo acessado via internet por alunos nas escolas públicas têm ganhado, a cada dia, mais relevância. Nesse sentido, a Assembléia Legislativa do Estado de Mato Grosso sancionou, em 2008, a Lei n. 8.821 9, que I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 62 torna obrigatório a todas as escolas das redes pública estadual e privada, a instalação de filtros de conteúdo pornográficos em seus equipamentos de informática. No entanto, até o presente momento ainda não existem diretivas emanadas da esfera governamental sobre a implantação desses filtros nas respectivas escolas. O projeto de Extensão PROACI, vem realizando este trabalho no município de Colider, oferecendo treinamento e implantação de filtros de conteúdo para os laboratórios de informática. O treinamento é realizado utilizando os laboratórios de informática da UNEMAT, Campus Universitário Vale do Teles Pires, nesse treinamento objetiva-se situações reais e práticas, possuindo avaliações e um teste final que consiste na configuração de um servidor proxy, tem duração de 100 horas. Na implantação quando o profissional que atua no laboratório de informática já realizou o treinamento, a implantação ocorre sem muitos problemas. Quando o profissional é alguém que não participou do treinamento, o computador servidor é implantado, disponibiliza-se todo o material que fora utilizado no curso para que caso haja interesse ser um ponto de partida de estudos. Uma das grandes dificuldades que tem-se encontrado é a troca de pessoas que trabalham no laboratório, sendo que a pessoa que começa a trabalhar em substituição, não tem conhecimento de como funciona o filtro. Neste sentido novas turmas para o curso de qualificação deverão ser ofertadas, se preocupando em prestar suporte para as escolas já implantadas. PALAVRAS-CHAVE filtros de conteúdo, escolas públicas, redes de computadores, GNU Linux. Tipo de Trabalho: Projeto de Extensão I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 63 LINHA DE PRODUTOS DE SOFTWARE NO PROCESSO DE GERAÇÃO DE APLICAÇÕES WEB E-PARTICIPATIVAS 1 Edie Correia Santana – [email protected] 1 Marcelo Augusto Santos Turine – [email protected] 2 Cristiano Maciel – [email protected] 1 – UFMS – Universidade Federal de Mato Grosso do Sul – Campo Grande / MS 2 – UFMT – Universidade Federal de Mato Grosso – Cuiabá / MT RESUMO As Tecnologias de Informação e Comunicação (TIC’s) estão trazendo possibilidades de relacionamento entre governo e cidadão. Diversos serviços e informações são disponibilizados via Internet para a população brasileira. Porém, a participação dos cidadãos em processos consultivos e/ou deliberativos é uma lacuna a ser preenchida. Buscando promover a participação popular na web, esta pesquisa visa apresentar uma linha de produtos (LPS) para aplicações de participação eletrônica (e-participação). O domínio de aplicações e-participativas tem se mostrado altamente favorável à aplicação da abordagem de LPS, pois existe uma arquitetura padrão e uma demanda por produtos similares, porém com características diferentes. A revolução da comunicação trazida pela Internet, sem dúvida, foi a principal responsável pelas mudanças que a nossa sociedade viveu na última década. O acesso às informações ficou democrático e rápido. O governo não ficou de fora dessa revolução e hoje, disponibiliza via Internet diversos serviços importantes para a população brasileira. Apesar das iniciativas direcionadas aos cidadãos, há uma falta de soluções no que diz respeito à possibilidade do cidadão poder ser consultado e deliberar sobre opiniões de interesse seu e da sociedade. Existem algumas soluções, no entanto, não há como reutilizar diretamente todas as ferramentas desenvolvidas na construção de novos ambientes de participação. Neste contexto, uma abordagem que pode habilitar reuso na prática é LPS. Essa abordagem propõe a derivação sistemática de produtos de software a partir de um conjunto de componentes e artefatos comuns que pertencem a um mesmo domínio, como, por exemplo, eParticipação. Assim, este trabalho aplica a abordagem LPS na criação de ambientes de participação eletrônica. A metodologia adotada para a pesquisa consta de uma Pesquisa Bibliográfica que visa atualizar constantemente o referencial bibliográfico da pesquisa. Como abordagens teóricas esta pesquisa, de cunho interdisciplinar, abordam-se conceitos de engenharia de software e técnicas de e-participação; Pretende-se aprofundar conceitos com base em pesquisas recentes e dados estatísticos sobre aplicações Web, governo eletrônico e aspectos da Interação Humano-Computador aplicados à Web. Para definir as características da LPS devem ser escolhidos exemplos de aplicações web e-participativas para se extrair funcionalidades similares e variáveis. Com isso os componentes que irão compor a LPS serão definidos e implementados e também serão definidas a arquitetura da LPS e do ambiente de geração de aplicação. Por fim, será elaborado um estudo de caso para o confronto das abordagens teóricas e dos experimentos empíricos a fim de analisar os resultados obtidos na pesquisa e testar as hipóteses de pesquisa. O produto final desenvolvido na pesquisa é a criação de um processo LPS para gerar aplicações Web no domínio de Governo Eletrônico que propiciem a participação do cidadão na vida pública. O uso e benefício desse projeto podem ser destacados em I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 64 qualquer esfera do governo, pois a participação dos cidadãos, em especial, pode tornar real a democracia, uma vez que gera um fluxo contínuo de informações entre o cidadão e o governo, auxiliando ambos na tomada de decisões. A participação do cidadão no que diz respeito à esfera governamental, como foi comentado no início desse trabalho, carece de mais atenção. O Brasil já apresenta algumas soluções em se tratando de informação e comunicação. Entretanto, são escassas as soluções para que o cidadão possa realmente interagir com o governo, sendo consultado e/ou deliberando sobre opiniões de seu interesse. Por isso, esse trabalho trouxe uma proposta com o intuito de preencher essa lacuna. Para que essa proposta fosse implementada, foi utilizada uma LPS para permitir a rápida criação de ambientes virtuais e promover a participação dos cidadãos em processos consultivos e/ou deliberativos de interesse comum a estes e ao governo. PALAVRAS-CHAVE Reuso de software, Linha de Produtos de Software, Governo Eletrônico, Participação Eletrônica. Tipo de Trabalho: Dissertação de Mestrado Agencia financiadora: Capes I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 65 LINUX EDUCACIONAL: EXPERIÊNCIA DE ENSINO PARA ALUNOS ENTRE 9 E 13 ANOS DE ESCOLA PÚBLICA DE RONDONÓPOLIS-MT Liana S. L. Mesquita¹ - [email protected] Mirian S. Riva¹ - [email protected] Luis Fernando Refatti¹ - [email protected] Luzane Francisca Gomes¹ - [email protected] Mara Dota¹ - [email protected] 1 – UFMT – Universidade Federal de Mato Grosso – Rondonópolis/MT RESUMO O curso de Linux Educacional desenvolvido junto a Escola Estadual São José Operário do município de Rondonópolis- MT foi realizado com 19 crianças entre 9 e 13 anos, permitindo capacitar seus participantes em conceitos básicos de Linux, por exemplo, a criação de pastas, excluir e renomeá-las, edição de textos no Br.Office.org 2.0, além de ensinar como navegar na internet através do browser Iceweasel 2.0.0.3., para realizar pesquisar escolares. O Linux é um sistema operacional livre. Foi desenvolvido inicialmente por um estudante filandês Linus Trovalds em 1991, baseado no sistema operacional Unix e hoje é mantido por profissionais na área de informática, comunidades internacionais de programadores, estudantes, etc. Nos últimos anos podemos observar que muitos usuários da plataforma Windows estão migrando para o Linux. Já o Linux Educacional é uma ferramenta compilação do Linux (distribuição debian) com foco em aplicação a laboratório de informática educacional (LIED) e escolas. O governo Brasileiro incentiva o uso do sistema por não ser pago e também por ter várias ferramentas com intuito educacional, sendo implantado em todas as escolas públicas. O objetivo para este curso foi capacitar crianças, para que sejam capazes de utilizar a plataforma Linux Educacional e conseguir ter uma maior familiaridade com a interface, além de saber utilizar de maneira correta, grande parte das ferramentas que é oferecido no sistema como o Br.Office.org 2.0 e outros. Fazendo com tenha uma contribuição para sua vida escolar, por ser o sistema utilizado é preciso que se tenha um conhecimento para poder aproveitar todos os seus benefícios. O curso de extensão através do seu objetivo traçado pretendeu despertar nos seus participantes o interesse e a importância do Linux Educacional, focado nos conceitos básicos do Sistema, onde podemos observar que muitos dos participantes tinham grandes dificuldades por não possuírem computadores nas suas residências ou não terem muito contato com ele na própria escola, fazendo com que tivessem algumas dificuldades de principio, porém podemos observar com o decorrer das aulas que os alunos tinham muitas curiosidades e aprendiam facilmente as explicações, sem terem vergonha de tirarem dúvidas. Este projeto porém teve além da abordagem da plataforma Linux Educacional a intenção de criar um ambiente de maior familiaridade educativa, trazer o aluno com contato no laboratório significa a inclusão digital facilitar o entrosamento com a máquina e favorecer a inclusão das outras disciplinas usando o computador como ferramenta de apoio educacional, assim, o professor terá maior aproveitamento do tempo e de uso desta plataforma. O conteúdo foi trabalhado através de aulas teóricas, exercícios aplicados para uma melhor memorização e um teste avaliativo para podermos mensurar o grau de aprendizagem dos alunos. Com este teste podemos observar que dos 19 alunos, e das cinco questões que foram passadas, 51% dos alunos conseguiram realizar I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 66 as atividades com auxilio, porém quando íamos relembrando eles geralmente conseguiam terminá-las sozinhos, e 49% conseguiram fazer sozinhos. O curso proporcionou a nós discentes do curso de Licenciatura Plena em Informática/ICEN/CUR/UFMT um grande aprendizado, além de podermos repassar nossos conhecimentos, fez com que exercitássemos a prática do ensino em Linux Educacional. Palavras-chave: Linux Educacional, conhecimento, capacitação. Tipo de Trabalho: Curso de extensão I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 67 MAPEAMENTO DAS AÇÕES REALIZADAS NO ÂMBITO DE UM CURSO DE LICENCIATURA EM INFORMÁTICA Leandro Arruda de Rezende - [email protected] Soraia Silva Prietch - [email protected] Tatiana Annoni Pazeto - [email protected] UFMT - Universidade Federal de Mato Grosso – Rondonópolis/MT RESUMO Esta proposta de pesquisa busca realizar o mapeamento das ações de pesquisa e de extensão, bem como de sua relação com o ensino, realizadas por um curso de Licenciatura em Informática. Neste aspecto, as informações relacionadas a tais ações estão sendo coletadas ou atualizadas, a fim de que algumas perguntas sejam respondidas, com a finalidade de apurar as contribuições que vem sendo produzidas em benefício da comunidade local. Como exemplo de trabalhos realizados envolvendo ensino-pesquisa-extensão, pode-se citar o trabalho de Vietro et al (2006), que refere-se apresentação de “Oficinas Geográficas”, desenvolvidas com alunos, cujo objetivo é explorar “a importância da tríade ensino-pesquisa-extensão para a realização dessa atividade”. O trabalho de Avena (2008) “salienta aspectos gerais das formações, da estrutura do ensino, da pesquisa e da extensão no Brasil no campo das viagens e do turismo”. Baseandose nos trabalhos supracitados, o presente trabalho visa verificar a articulação entre o ensino, pesquisa e extensão do curso de Licenciatura Plena em Informática. A partir deste, o qual está atrelado ao projeto de pesquisa intitulado “Levantamento Histórico do Curso de Licenciatura Plena em Informática, nos Planos: Acadêmico, Administrativo e de Vivência”. A realização desta pesquisa justifica-se pela necessidade de manter atualizados os dados referentes aos projetos de pesquisas, bem como as ações de extensão realizadas pelo curso de Licenciatura em Informática, para realizar o mapeamento da integração destas ações com o ensino, da atuação dos professores e alunos em projetos, e, de modo geral, da influência destas participações na melhoria da qualidade do curso. Neste contexto, objetiva-se atualizar os arquivos referentes à realização de projetos de pesquisas e ações de extensão, propostos e executados pelo curso de Licenciatura Plena em Informática, bem como efetuar análise destas ações realizadas a fim de verificar seu enfoque, a relação entre esses dois aspectos com o ensino, dentre outras informações relevantes. Através de Silva (2004) foi possível identificar as seguintes características da metodologia de pesquisa adotada para a realização deste trabalho: (1) quanto à natureza: classifica-se como pesquisa básica; (2) quanto a forma de abordagem: esta agrega conceitos tanto da pesquisa qualitativa quanto da quantitativa; (3) quanto aos objetivos: caracteriza-se como pesquisa descritiva; e, (4) quanto aos procedimentos técnicos: tem-se pesquisa bibliográfica e documental, e estudo de caso. Seguindo as orientações apresentadas sobre a metodologia de pesquisa, pretende-se realizar as atividades abaixo, em etapas, as quais estão dispostas na sequência: a) copiar os dados, sobre pesquisa e extensão do curso do trabalho produzido por Prietch (2008) em arquivo “.doc”, referentes aos anos de 2004 a 2008, para planilha “.xls” e realizar a atualização do arquivo “.xls”; b) verificar se existem dados faltantes a serem pesquisados e buscar documentos originais para preenchimento destas lacunas, buscar dados, referente aos anos de 2001 a 2004 e 2009 a 2010; c) gerar tabelas e gráficos quantitativos e efetuar a análise dos dados. I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 68 Com relação à análise a ser realizada, com os dados que estão sendo coletados e/ou atualizados, pretende-se responder alguns questionamentos, dentre os quais se pode exemplificar com as seguintes perguntas: Quantas ações (programas, projetos, cursos e eventos) de extensão, cadastrados junto a CAMEX (Câmara de Extensão) foram realizados pelo curso? Quantas destas ações de extensão e projetos de pesquisa tiveram apoio financeiro de algum órgão de fomento ou de parcerias? Quantas ações de extensão foram realizadas em parceria com escolas (estaduais ou municipais, públicas ou privadas) do município de Rondonópolis? Quantos projetos de pesquisa foram cadastrados e concluídos, de forma regularizada junto a PROPeq, pelo curso? Quantas monografias de alunos foram produzidas pelo curso e quantas tiveram seus resultados publicados ou apresentados em evento? Quantos resumos e artigos completos foram publicados em eventos pelos docentes e discentes do curso? Existe alguma ação de extensão relacionada a algum projeto de pesquisa ou produção acadêmico-científica? quantas? Os resultados podem cooperar em alto grau para se realizar uma avaliação geral sobre a qualidade do curso, ou seja, é possível saber quantos programas, projetos, cursos e eventos de extensão foram cadastrados juntos a Câmara de Extensão, se os mesmos tiveram apoio financeiro, quantas ações de extensão foram realizadas junto às instituições de ensino, dentre outras. Essa avaliação poderia, por exemplo, ter a finalidade de mostrar ao coordenador, docentes, discentes, técnicos-administrativos e contribuintes, quais atividades o curso necessita conferir mais atenção e, assim, promover projetos direcionados às necessidades locais, sempre buscando elevar o seu nível, com isso tornando-se um curso de destaque dentro de sua área de conhecimento na Região. No momento, está sendo realizada a primeira atividade, onde foi possível apurar que, no período de 2004 a 2008, o curso de Licenciatura Plena em Informática de Rondonópolis, já realizou 7 (sete) eventos, 10 (dez) projetos de pesquisa, foram defendidas e apresentadas mais de 50 (cinquenta) monografias, dentre outras informações. Cabe mencionar que muitas informações, que constam no documento elaborado por Prietch (2008), não estavam completas e necessitam ser complementadas para que se atinjam os objetivos finais deste estudo. Neste aspecto, a Plataforma Lattes do CNPq, o Sistema de Informação e Gestão de Projetos (SIGProj), e o JULIO (Jornal Universitário de Licenciatura em Informática Online) serão de grande utilidade para buscar dados faltantes de ações de pesquisa e de extensão ou efetuar entrevistas junto ao corpo docente. PALAVRAS-CHAVE: Extensão Universitária. Pesquisa. Produção científica. Licenciatura Plena em Informática. Tipo de Trabalho: Voluntário em Projeto de Pesquisa. I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 69 MÉTODOS PRÁTICOS DE ESTEGANOGRAFIA DIGITAL Patrícia Ladislau Silva¹ – [email protected] André Valente do Couto¹ ² – [email protected] Lídia Martins Silva¹ – [email protected] 1 – UNIRONDON – Centro Universitário Cândido Rondon – Cuiabá / MT 2 – IFMT – Instituto Federal de Mato Grosso – Cuiabá / MT RESUMO A Segurança da Informação é composta por ambientes interrelacionados para a garantia das três propriedades básicas: Confidencialidade, Integridade e Disponibilidade. Desse tripé, o domínio que acerca as técnicas e os métodos de ocultação de dados se denomina Criptografia, que se divide ainda em outras áreas como criptografia simétrica e assimétrica, autenticação e chaves públicas. Este artigo tem por objetivo citar, descrever e exemplificar as características e métodos da técnica de esteganografia digital para a garantia da confidencialidade no envio de mensagens entre ativos. Esteganografia é a arte de esconder a existência de uma mensagem. É relacionado, mas difere da criptografia. Como a criptografia, uma finalidade da esteganografia é de proteger o conteúdo de uma mensagem. No entanto, diferentemente da criptografia, o conteúdo da mensagem não é oculto. Em vez disso, a existência da mensagem é escondida em algum outro meio de comunicação. A mensagem pode ser escondida em um arquivo gráfico ou de áudio, em um pequeno espaço da mídia de armazenamento, em um ruído do tráfego de rede, ou em um formato digital imagem. No entanto, pela mensagem em si não estar criptografada, no caso de descoberta da sua existência, seu conteúdo pode ser facilmente comprometido. O trabalho teve como base materiais pesquisados em livros, na rede mundial de computadores e alguns softwares de computação forense e de outros ramos, que auxiliaram o processo de pesquisa e testes. Para iniciantes na área, um pequeno espaço foi reservado para os fundamentos da segurança da informação e uma visão geral sobre criptografia, servindo como base para o entendimento do tema do trabalho. Softwares como o Hide in Picture foram utilizados para produzir os efeitos de processos de esteganografia em imagens, e outro para fins de verificação dos mesmos, como o Adobe Photoshop (para análise do histograma das imagens), tornando prática a aplicação dos conceitos pesquisados, possibilitando a melhor demonstração do processo através de esquemas inclusos no artigo. Portanto, foram analisados os seguintes métodos práticos de esteganografia: Esteganografia baseada em modelo, Esteganografia com Preservação Estatística, e Incorporando Mascaramento como Processo Natural. Quanto aos métodos: a Esteganografia baseada em modelo compreende um modelo como uma estrutura geral para a construção da esteganografia em meios gráficos. A imagem pode ter sua intensidade alterada em no máximo 1%, uma taxa imperceptível ao olho humano. No processo, uma variável aleatória é utilizada no modelo e pode ser dividida em duas partes: uma invariável, que será embutida em seu formato original, e uma variável, ou seja, pode sofrer alterações durante o processo de incorporação da mensagem. Utilizando o método com o LSB (Bit Menos Significativo), o componente constante corresponde aos sete bits mais siginificativos e os valores variáveis podem ser modificados durante a incorporação. As probabilidades condicionais, que representam o modelo escolhido, podem ser calculadas através da constante, de forma que o conteúdo I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 70 do destinatário e remetente sejam os mesmos. Os bits da mensagem devem ser distribuídos de igual forma, onde o valor constante seja igual a variável. O método Esteganografia com Preservação Estatística visa preservar o histograma da imagem de cobertura. O algoritmo Outguess, que utiliza técnicas para preservação estatística, realiza o processo em duas etapas: a primeira, incorporando os bits da mensagem em LSBs aleatórios, alternando coeficientes com magnitude é 0 ou 1, e a segunda etapa, a qual efetuam-se correções das magnitudes para garantir que o histograma da imagem esteganografada seja correspondente ao da imagem original. Antes da incorporação, o algoritmo calcula uma parte de mensagem que pode ser incorporada para garantir que correções de ajuste ao histograma sejam possíveis. Como a maioria das magnitudes são zeros, a introdução de uma mensagem pode gerar uma visível distorção, sendo assim, o Outguess não incorpora em zeros, o que torna fundamental a realização do cálculo de parte da mensagem. O terceiro método, Incorporando Mascaramento como Processo Natural, consiste na tentativa de mascaramento da incorporação com caracteristicas de um processo nartural. Se o processo esteganográfico imita alguma forma de processo natural, torna dificultoso julgar se a mensagem foi incorporada ou processada. Um desses processos, a modulação estocástica baseia-se na existência de fontes de ruído que afetam imagens digitais como propriedades de luz e o sinal produzido pelo sensor quando não é exposto à luz adequada. A ideia é disfarçar as mudanças incorporadas como um ruído do dispositivo, o que pode tornar dificil definir se o ligeiro nível de ruído na cobertura da imagem é uma mensagem, falha de hardware ou fatores ambientais, como temperatura e umidade. O primeiro método torna-se menos aplicável se comparado ao segundo e terceiro métodos citados, pois estes preservam o histograma, e o último preserva as características naturais da imagem, o que torna os métodos aplicáveis a dados que requerem alto nível de segurança e discrição, de modo a dificultar a detecção de mensagens. PALAVRAS-CHAVE Esteganografia, Segurança, Integridade, Criptografia, Dados. Tipo de Trabalho: Iniciação Científica. Trabalho de Graduação. I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 71 O PROCESSO DE APRENDIZAGEM DE ESTRUTURA DE DADOS ATRAVÉS DA PRODUÇÃO DE VÍDEOS EDUCATIVOS Rodrigo A. Morbach - [email protected] Cleverson R. M. Fernandes - [email protected] Soraia Silva Prietch - [email protected] UFMT - Universidade Federal de Mato Grosso – Rondonópolis/MT RESUMO Tendo em vista os meios de ensino que estão disponíveis aos docentes, foi realizada a produção de um vídeo educativo com o intuito de auxiliar na compreensão por parte dos alunos da disciplina de Estrutura de Dados, especificamente em Listas Dinâmicas Simplesmente Encadeadas (LDSE) e Duplamente Encadeadas (LDDE). Foram pesquisadas ementas e metodologia de ensino de planos de ensino de quatro Instituições de Ensino Superior (CEFETMA, UFRPE (EAD), UFPB e UFMT/CUR) que ofertam cursos de Licenciatura em Informática/ Computação em diferentes estados brasileiros. A partir disso, foi possível verificar que os conteúdos de listas, pilhas, filas, árvore e grafos são contemplados em quase todas as ementas apresentadas, bem como em algumas também abordam questões referentes à análise de complexidade, métodos de ordenação e de busca. Além disso, pode-se perceber que a metodologia de ensino também possui características semelhantes entre uma e outra, com aulas expositivas e dialogadas, intercaladas com aulas práticas, podendo ter trabalhos e provas como mecanismos de avaliação dos conteúdos trabalhados. Cabe ainda mencionar que em cursos de Licenciatura em Computação/ Informática se tem como propósito principal formar docentes com competências para ministrar conteúdos específicos da área, e para que isso ocorra de maneira adequada, os estudantes devem ser estimulados a produzir seus próprios materiais didáticos, sejam tradicionais ou alternativos, bem como precisam estar preparados para a sua atuação profissional enquanto educador. Neste contexto, este trabalho relata sobre a produção de um vídeo educativo para o ensino de listas dinâmicas, sendo esta atividade realizada como instrumento de processo avaliativo da disciplina de Estrutura de dados proposta por Prietch (2009). Através da leitura de artigos relacionados sobre vídeos, mídias, softwares, dentre outros meios de auxiliar na educação, podem ser citados trabalhos e experiências de diversos pesquisadores e educadores, que buscam levar esses recursos para as escolas, como uma nova forma de ensino, a saber: Souza (2004); Banhara (2008); Garcia, Rezende e Calheiros (1996); além de considerar importante, também, mencionar que existem algumas páginas na Internet que oferecem simulações, exemplificações e animações bastante interessantes que podem ser utilizadas como material de apoio para o ensino de diversos tipos de estruturas de dados. Assim, foi realizada a produção de um vídeo educativo com o objetivo de auxiliar na aprendizagem de Listas Dinâmicas em disciplinas de Estrutura de dados. Assim, para a produção do vídeo, foi realizada a implementação de desenhos relacionados com a matéria estudada pelos alunos do segundo ano do curso de Licenciatura em Informática, de uma Universidade pública de Mato Grosso, na disciplina de Estrutura de Dados. A escolha do conteúdo sobre listas dinâmicas se justifica pelo seu alto grau de abstração e dificuldade de entendimento por grande maioria dos alunos. Com base nessas informações a intenção desse trabalho é mostrar uma nova forma de ensinar os principais conceitos de LDSE e LDDE, que são a base para as demais formas de implementações de listas existentes. Para a criação dos I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 72 desenhos foi utilizado um programa chamado Macromedia Fireworks MX Trial. Após a criação dos desenhos, foi utilizada uma ferramenta do Windows, para a produção do vídeo, chamado Windows Movie Maker, no qual foram inseridos os desenhos de forma simples e objetiva, e acrescentado um fundo musical para que ficasse mais agradável aos espectadores. Depois de concluído o vídeo, o mesmo foi disponibilizado na Internet através do Youtube, dividido em duas partes. Até a conclusão da primeira versão do vídeo, muitas dificuldades foram encontradas. Desde a escolha de um cenário ou situação em que poderiam ser empregados exemplos de Listas Dinâmicas, até a criação dos desenhos. Como grande maioria da turma era composta por jovens, decidiu-se utilizar situações que acontecem com certa freqüência no dia-a-dia dos estudantes da faculdade como, por exemplo, a falta de entendimento, o receio de reprovação. Após a conclusão do vídeo, teve-se a ideia de realizar um questionário piloto para que se pudesse avaliar como estava o conhecimento com relação à Estrutura de Dados, e o que os estudantes acham da implementação de novas formas de se lecionar com a utilização de softwares educativos, vídeos, dentre outros recursos, porém o mesmo ainda não foi aplicado. É válido destacar que se considera o exercício de planejamento e de produção de materiais didáticos digitais alternativos uma prática muito importante e que esta deveria ser ação constante entre o corpo discente e os já graduados de cursos de Licenciatura em Computação ou em Informática, visto que em seu futuro profissional os mesmos poderão atuar como designer instrucional, cuja carreira é bastante promissora e procurada nos dias atuais, dado a grande quantidade de cursos, de Ensino a Distância, que estão disponíveis e a possibilidade de incluir porcentagem desta modalidade em disciplinas de cursos presenciais. PALAVRAS-CHAVE Vídeos educativos, Estrutura de dados, Informática Educativa, Listas Dinâmicas. Tipo de Trabalho: Pesquisa realizada na disciplina de Estrutura de Dados em 2009 I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 73 O USO DE REDES SOCIAIS COMO MECANISMO DE INCLUSÃO SOCIAL NA PERIFERIA DE CUIABÁ 1 Taciane Garcez Maurício – [email protected] 2 Tadeusa Margarida de Melo – [email protected] 3 Cristiano Maciel – [email protected] 1 – SME – Secretaria Municipal de Cuiabá – Cuiabá / MT 2 – SME – Secretaria Municipal de Cuiabá – Cuiabá / MT 3 – UFMT – Universidade Federal de Mato Grosso – Instituto de Computação - Cuiabá / MT RESUMO Atualmente, as redes sociais estão cada vez mais presentes em diferentes contextos e ambientes. Tais redes são tidas como ferramentas importantes para interação e inclusão social, possibilitando que as pessoas possam se relacionar e interagir virtualmente. Além de aproximarem as pessoas, elas também ampliam os relacionamentos e a distância deixa de ser um grande obstáculo. Essas práticas de sociabilidade contagiam principalmente os jovens, que podem utilizar as redes sociais para se exporem com maior liberdade. O objetivo dessa pesquisa é relatar a experiência de jovens estudantes da periferia de Cuiabá, que utilizam as redes sociais para expor suas ideias e também para se relacionarem, ultrapassando barreiras culturais e fronteiras sociais e econômicas.As relações que se estabelecem em redes sociais são as relações intrínsecas do cotidiano como: relações entre colegas de sala, amigos, familiares, professores, funcionários da escola e outros. A motivação para realização de tal estudo foi a observação, em aulas de laboratório de informática, do uso massivo das redes sociais pelos alunos. Assim, esse artigo analisa as redes sociais e seus reflexos no cotidiano desses jovens da periferia, levantando ainda se tais sujeitos estão ou não incluídos digitalmente. É importante lembrar que, a priori, as condições financeiras desses jovens os deixa relegados a margem da tecnologia. Porém, mesmo com dificuldades financeiras, esses conseguem manter suas redes sociais como ponto importante de relacionamento e contato, o que possibilita saírem de seu mundo real, nem sempre agradável e desejável, e construírem um mundo virtual possível e agradável. Assim, as redes sociais são relações de estrutura de identidade social que propiciam elementos para inclusão social. Os parâmetros de inclusão nas redes sociais associam indivíduos por suas identidades culturais e preferências pessoais. Essa relação que se estabelece entre pessoas tão distantes geograficamente ou não, porém com opiniões e gostos semelhantes, levam ao sucesso das redes sociais. Outro ponto importante analisado neste levantamento foi a ruptura de paradigmas, de que as redes sociais podem ser apenas estabelecidas em grupos mais favorecidos financeiramente, impossibilitando a inclusão social, o que não é o caso. O levantamento de dados ocorreu por meio de questionário aplicado aos estudantes da EMEB. Lenine de Campos Póvoas, situada no bairro Jardim União, periferia de Cuiabá, capital de Mato Grosso, com o objetivo de alçar dados para verificação da presença e participação destes jovens em redes sociais. Foi apresentado um questionário investigando a variação da renda dos familiares, a frequência de uso da internet para acesso as redes sociais, locais de acesso, percepções e vivências influenciadas nestas redes sociais, tipos de relacionamento estabelecidos nestas redes sociais e o que movia a participação destes jovens nestas redes sociais. Foram investigados 180 sujeitos, entre 11 e 17 anos. A I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 74 análise dos dados coletados pelo questionário aplicado possibilitou ainda a compreensão de que não importa a renda, as redes sociais influenciam as relações na periferia de Cuiabá. As redes sociais permitem que essa parte da população possa estar conectada, mesmo que não tenha computador em casa. As lan houses, muito frequentes nos bairros periféricos, possibilitam a inclusão nas redes sociais. A rede social dita como utilizada pelos jovens foi o Orkut. O principal interesse constatado foi a exposição de seus perfis, a troca de recados, a abertura de comunidades para discussão de temas polêmicos e a publicação de fotos, com vistas a compartilhar e fazer amigos. O que move esses estudantes a utilizarem as redes sociais é poder expor suas ideias sem serem reprimidos ou limitados e a possibilidade de encontrar pessoas que pensem como eles, criando suas identidades virtuais. Muitos estudantes também comentaram utilizar de artifícios como raqueamento de senhas para “defender-se” de bullying. Outro aspecto importante é a força da palavra escrita, sendo esse um dos elos que os representa e constrói suas identidades no mundo virtual. Para eles, existe mais possibilidade de relacionarem-se com o mundo virtual do que frequentar shoppings e outros lugares da cidade, devido a fatores financeiros. As redes sociais possibilitam a socialização em espaços virtuais que podem ser frequentados, muitas vezes, sem gastos. Ao iniciar os estudos, a princípio pareceu não ser muito lógico que houvesse redes sociais tão articuladas e vivenciadas pelos jovens da periferia de Cuiabá. Os resultados nos permitiram perceber que, independente do meio social e financeiro, todos querem participar e vivenciar os processos de comunicação e relacionamento que as redes sociais propiciam. É notável o grande interesse, prazer e dedicação dos alunos investigados no que se refere a manutenção de suas redes sociais. Perceber esta relação tão perene e ao mesmo tempo tão tênue dos relacionamentos virtuais em redes sociais na Web levanta questionamentos futuros. Entre eles, cita-se o mau uso das redes sociais e os reflexos disso para a sociedade. Na educação, por exemplo, o uso pedagógico das redes sociais é um tema que requer maiores discussões, de forma a propiciar que a escola também faça uso dos mecanismos utilizados no dia-a-dia dos estudantes. PALAVRAS-CHAVE Redes Sociais, Orkut, Educação. Tipo de Trabalho: Pesquisa I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 75 ORGANIZAÇÃO E DISPONIBILIZAÇÃO DE CONTEÚDOS POR MEIO DE TAXONOMIA Aline Wollinger ¹ - [email protected] Custódio Gastão da Silva Júnior ¹ - [email protected] 1 – IFMT – Instituto Federal de Educação, Ciência e Tecnologia de Mato Grosso – Campus Cuiabá - Cuiabá / MT RESUMO Este trabalho tem enfoque em filtragem e classificação de informações, com foco no domínio “político corrupto”. Com base em um acervo de informações que é alimentado por informações retiradas de jornais eletrônicos e páginas relacionadas ao domínio, o objetivo deste estudo é mostrar relações entre o candidato - nome do candidato, cargo que exerce, tempo de cargo, partido a que pertence e tempo de partido - com o crime - social ou político - praticado e seus respectivos dados: data, local e demais envolvidos. A partir deste estudo pretende-se construir uma interface online que facilite a todo cidadão realizar pesquisas dentro do domínio, referentes a candidatos – a reeleição ou não – a qualquer cargo dentro do país. Esta interface deverá fornecer opções de pesquisa como nome, partido, crime e cargo. O resultado desta aparecerá em forma de grafo mostrando as informações extraídas do banco de dados (Figura 01). Em ano eleitoral não faltam noticias relacionadas aos candidatos. Atualmente existem ferramentas de busca como o Google e sites que referenciam corrupção, os quais se podem tirar diversas conclusões sobre a “ficha” de alguns candidatos. Um político é considerado corrupto quando faz uso ilegal do poder político e financeiro de organizações ou agências governamentais, com o objetivo de transferir renda pública ou privada de maneira criminosa, para indivíduos ou grupos de indivíduos ligados por laços de interesse comum (WIKIPÉDIA, Corrupção Política). Com foco no domínio “político corrupto”, vem sido explorada uma forma de indexar essas informações de modo que elas sejam mais bem interpretadas por quem esta em contato com ela, uma forma encontrada foi utilizar grafos que classificam todas as informações referentes ao tema pesquisado, esse filtro de pesquisa deve estar disponível online, para que todo cidadão possa ter acesso a essa ferramenta, assim facilitando a divulgação dessas informações por esse meio. Para que esses resultados sejam filtrados e essas ligações sejam mostradas, estão sendo estudadas duas tecnologias: o JSON (JavaScript Object Notation) e o framework The JIT (JavaScript InfoVis Toolkit). O JSON faz um intercâmbio entre as informações e o acervo interpretando os possíveis nós do grafo a ser gerado. Já o framework fornece ferramentas para criar visualizações de dados interativos para a web. Essas visualizações partem das pesquisas realizadas pelos usuários, onde a cada pesquisa um grafo é gerado. Conforme a especificação do framework, uma das formas de gerar este grafo é utilizando o RGraph.js, que é uma das ferramentas disponíveis dentro da suíte do framework. Essa ferramenta cria a visualização do grafo de forma radial, concentrando no centro o primeiro tema pesquisado, e realizando novas pesquisas conforme o usuário clica nos nós relacionados ao primeiro tema. Conforme cada pesquisa realizada, as informações deverão passar por um filtro que mostrará os resultados. Uma vez filtrada a informação e os demais dados relacionados ao mesmo assunto, devem estar ligados formando uma estrutura gráfica das relações existentes entre o tema pesquisado e demais informações ligadas a esse tema. Os níveis de relação de I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 76 cada informação serão definidos por cores, conforme o grau de ligação. Esses resultados aparecerão conforme cada pesquisa realizada, como mostra a figura 01. Figura 01 – Demonstração do Protótipo do Sistema. É imprescindível a existência de mecanismos de busca referentes ao contexto “político corrupto”, pois conforme na nota “Para mídia e Justiça Eleitoral, brasileiro não sabe votar” a SASP (Sindicato dos Advogados do estado de São Paulo) diz: “O cientista político Alberto Carlos Almeida, da FGV, demonstra isso em seu livro "Reforma Política: Lições da História Recente". A publicação revela que 71% dos eleitores esqueceram em quem votaram para deputado federal quatro anos antes. É verdade que a chamada "amnésia eleitoral" é maior entre os de menor escolaridade, mas, 53% das pessoas com nível superior também não se lembram de seu voto”. Ou seja, a maioria da população concentra o voto baseando-se em pesquisas de intenção de voto ou até mesmo por falta de opção, e depois sequer lembram-se em quem votaram. Criar um mecanismo de busca que tem como resultado a “ficha” destes candidatos é uma forma de ajudar o cidadão a estar I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 77 mais ciente do voto, conhecendo o passado e presente dos candidatos pretendidos. PALAVRAS-CHAVE Corrupto, Json,The Jit. Tipo de Trabalho: Trabalho de Pós-Graduação I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 78 OS PROFESSORES E A TECNOLOGIA: A QUALIFICAÇÃO TECNOLÓGICA NAS LICENCIATURAS DO CUR-UFMT Luzane Francisca Gomes - [email protected] Prof. Dr. Ruy Ferreira - [email protected] UFMT/CUR - Licenciatura Plena em Informática – Rondonópolis/MT RESUMO As escolas estão se modernizando em termos de instrumentos e meios educativos. Isso implica em preparar os novos professores para o trabalho em ambientes com maior concentração tecnológica, exigindo, assim que os professores tenham uma formação inicial capaz de lidar com os artefatos digitais disponíveis nas instituições de ensino. A necessidade de reforma curricular na formação inicial dos professores é essencial para atender as novas demandas por conhecimentos tecnológicos. A identificação dessas necessidades é o objetivo da pesquisa. Se confirmado será apontado caminhos ou sugestões no sentido de solucionar o impasse entre a demanda da escola e qualificação do egresso das licenciaturas. A pesquisa constitui-se no estudo de múltiplos casos conforme preceitua Robert Yin (1994), tratando os sete cursos de licenciaturas ofertados no campus de Rondonópolis, da UFMT, como um caso múltiplo. O trabalho de coleta de dados deu-se por meio de dois instrumentos: questionário aplicado aos alunos do último ano das licenciaturas e entrevista estruturada com os coordenadores de curso. A proposta de associação de entrevista com a aplicação de questionário se revelou útil na compreensão das características culturais, valores e opiniões do público-alvo: alunos formandos das licenciaturas do CUR-UFMT. Adotou-se como instrumento a Escala de Desempenho em Informática Educacional (EDIE), baseada nos padrões de desempenho definidos pela Sociedade Internacional para Tecnologia em Educação (International Society for Technology in Education ISTE), composto por 40 itens do tipo Likert, originalmente com quatro pontos e ampliado neste trabalho para cinco pontos. A finalidade da EDIE é possibilitar a definição de um perfil do sujeito quanto ao seu padrão de desempenho em informática educacional e na gestão desses recursos. Ao mesmo tempo em que enquadra o professor em um dos três níveis possível de desempenho ou qualificação tecnológica: Básico (relacionado aos padrões de desempenho que implicam em uso pessoal limitado da tecnologia); Intermediário (refere-se aos padrões de desempenho relativos à seleção e ao uso dos recursos tecnológicos, envolvendo o uso produtivo de ferramentas de processamento de palavras e administração de dados em ações pedagógicas); e Avançado (relacionado ao ensino e à avaliação da aprendizagem utilizando recursos tecnológicos, avaliação da própria tecnologia educacional e utilização legal e ética das tecnologias educacionais). Os itens referem-se às atividades de ensino que usam recursos informatizados e as ações gestoras quanto ao uso da informática educativa. Adaptado para a realidade brasileira por Maria Cristina Rodrigues Azevedo Joly. Na análise dos pontos apurados no instrumento, considerou-se enquadrado em um nível de desempenho (qualificação tecnológica) o sujeito que obteve mais da metade de pontos possíveis na categoria. Esta investigação seguiu as recomendações de Joly (2004), analisando uma amostra homogênea de alunos concluintes das sete licenciaturas ofertadas no Campus de Rondonópolis da UFMT, em 2010. Os resultados finais onde o corpo discente será enquadrado nos I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 79 níveis citados acima e serão apresentados em trabalho de conclusão de curso no final deste ano. PALAVRAS-CHAVE Formação de professores, Formação Tecnológica, Tecnologia Educacional, Recursos Tecnológicos na Educação, Inovação Tecnológica na Educação. Tipo de Trabalho: Trabalho de graduação I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 80 PERSPECTIVAS SOBRE A INTERAÇÃO ENTRE ONTOLOGIAS E WEB SEMÂNTICA Adriana Cássia da Costa¹ - [email protected] Custódio Gastão da Silva Júnior² - [email protected] 1-Universidade Federal de Mato Grosso – Cuiabá / MT 2-Instituto Federal de Educação, Ciência e Tecnologia de Mato Grosso – Cuiabá / MT RESUMO A Web Semântica chamada também de Web 3.0 é vista como grande salto em qualidade prevista para os próximos anos que permitirá a conexão de dados e a relação entre eventos. O conteúdo disponível será facilmente interpretado por humanos e por computadores. O funcionamento desse novo mecanismo está profundamente ligado a criação de ontologias que serão fundamentais para estruturação de conteúdo na internet, além da dinamização das atividades de recuperação de informação. Espera-se com este artigo, contribuir com a revisão da literatura apresentando importantes conceitos e projetos envolvendo ontologias no âmbito da web semântica. A expansão da internet aumentou a quantidade de informações e consequentemente à dificuldade em encontrar conteúdos relevantes. A partir desse tipo de problema, Tim Berners Lee propôs a web semântica, onde os documentos são auto descritíveis, permitindo que seu conteúdo possa ser “compreendido” por programas. Os agentes de software poderiam assim, fazer inferências sobre o conteúdo de documentos e inferência de conclusões a partir de informações contextuais. [Marcondes e Campos (2008)]. A web semântica é esperada como grande evolução da criação de conteúdo para a internet, os temas relacionados ao assunto são amplos e podem ser classificados em: ferramentas, agentes, metadados, web services construção de modelos semânticos, linguagens da web semântica e ontologias [Breitman (2005)]. As ontologias são de grande interesse por formar um dos alicerces para a estruturação dos conceitos que serão disponibilizados na “nova web”. Os dados deverão ser estruturados e grande parte será escrita em RDF (Resource Description Framwork) e de acordo com uma ontologia. [Breitman(2005)], afirma que futuramente o resultado dos trabalhos será um grande número de ontologias, construídas e mantidas por pessoas, entidades e instituições independentes que estarão disponíveis na web. As ontologias padronizam significados através de identificadores semânticos, representando o mundo real ou conceitual, são compostas por definições de conceitos, classes, propriedades, relações, restrições e axiomas sobre um determinado conceito [Freitas e Schulz (1999)]. Assim, facilitam o mapeamento de conceitos e já são utilizadas na organização de milhares de dados de estudos sobre doenças devido a grande quantidade de conceitos e termos referentes a Área Médica. Uma característica das ontologias é garantir a comunicação sem ambiguidade, sendo vistas como alicerce para a Web Semântica [Breitman(2005)]. As ontologias são construídas conforme as regras gramaticais de cada língua e este é um dos motivos pelos quais são menores os trabalhos em português em relação ao inglês, onde as pesquisas estão mais avançadas. A construção de ontologias é conhecidamente um processo demorado e difícil, requerendo constante atualização e por isso pesquisadores da área tentam automatizar a tarefa. [Vieira, Ribeiro Junior (2008)]. Na construção de ontologias em português, podemos citar o Projeto SISE (Medida de Similaridade Semântica entre Ontologias em Português) e OntoLP: Construção semiI Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 81 automática de ontologias a partir de textos da língua portuguesa, esta ferramenta utiliza o método estatístico TFIDF e informações linguísticas (sintáticas) em um modelo geral para a criação de ontologias.[Freitas, Vieira (2008)]. A web semântica pretende transformar a web atual em um ambiente colaborativo, tornando tanto os benefícios tecnológicos da web quanto os sociais disponíveis a todos independente de hardware, software, cultura ou idioma. O grande desafio é transformar a internet atual chamada de Web Sintática em Web Semântica, atualmente computadores fazem apenas a apresentação da informação, porém o processo de interpretação é feito pelos humanos [Breitman, 2005]. Alguns problemas da web sintática é a falta de precisão nos resultados dos buscadores atualmente disponíveis, com diversas respostas apresentadas fora do escopo desejado pelo usuário. Muitos resultados são sensíveis ao vocabulário, em alguns casos a ordem em que as palavras são digitadas interfere no resultado [Breitman, 2005]. Na web semântica, a web deixa de ser um repositório de documentos, passando realizar o reuso em sistemas diferentes e no compartilhamento de interpretações organizadas com a integração de recursos. As ontologias pretendem suprir dois aspectos fundamentais para o aprimoramento da internet, o primeiro relacionado ao desempenho dos sistemas de busca para capturar informações relevantes para o usuário, o segundo ponto é fazer com que as páginas possuam uma semântica clara e definida. [Freitas]. A construção de ontologias tem importância ímpar em estudos para a estruturação de informação e isso é justificado pela grande quantidade de projetos nacionais e internacionais nessa área. Em língua portuguesa, os estudos estão caminhando em ritmo mais lento que para outros idiomas, entretanto, é crescente o número de pesquisadores interessados em estudar técnicas para a construção de ontologias, pois podem promover avançados tecnológicos que se estendem a áreas como Medicina e Educação. A implantação da web semântica é prevista para os próximos anos em passos lentos e futuramente é esperado que os interessados, principalmente na área de comércio eletrônico e gestão do conhecimento, possam desenvolver suas ontologias para disponibilizar na internet e dessa maneira facilitar a interconexão dos dados. PALAVRAS-CHAVE: Ontologias, Web Semântica, Informação, Conteúdo. Tipo de Trabalho: Artigo de Revisão I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 82 PLANEJAMENTO PARA REDES FWA BASEADO EM ALGORITMOS GENÉTICOS 1 Aline Paulino Domingos de Souza – [email protected] /[email protected] 1 Alexandre Torrezam – [email protected] 1 André Valente do Couto - [email protected] 1- UNIRONDON – Centro Universitário Candido Rondon - Cuiabá / MT RESUMO As novas tecnologias de transmissão trazem maior flexibilidade e eficiência à redes de acesso, tornando-as capaz de atender o contínuo crescimento de demanda por serviços de telecomunicações, requerendo a adaptação e/ou inovação das empresas operadoras em suas redes afim de prover serviços de banda larga. A reforma do setor de telecomunicações trouxe reduções nos investimentos para infra-estrutura de acesso impedindo a própria inovação e conseqüente melhoria de serviços. Contudo, a preparação da infra-estrutura de redes de transmissão de dados para o fornecimento de serviços de maneira satisfatória reflete diretamente no desempenho dos sistemas de telecomunicações que por sua vez, estão relacionados à capacidade de transmissão na porção denominada rede de acesso. A infra-estrutura, de grande parte dessas redes não suportam as taxas de transmissão exigidas pelos novos serviços, bem mais elevadas que as taxas dispensadas para o serviço de voz. Para contornar essas limitações, alternativas como o sistema de FWA (Fixed Wireless Access - Acesso Sem Fio Fixo), tem sido utilizado e são capazes de fornecer serviços de banda larga a usuários residenciais, agrupamentos (condomínios) e a pequenas e médias empresas. Desta forma, o planejamento da rede de acesso é importante, pois concentra parte dos investimentos em infraestrutura, além de trata de um problema complexo, com várias questões conexas e simultâneas. Trata-se, de uma pesquisa experimental onde foi testado o protótipo e verificou-se a estabilidade e confiabilidade das suas instâncias. para obter os resultados apresentado também realizou-se uma pesquisa bibliográfica como aporte teórico que guiaria a concepção do protótipo, o projeto do aplicativo de testes e os critérios de avaliação do modelo criado. Este trabalho apresenta uma abordagem heurística para o planejamento do sistema FWA. Devido à alta complexidade associada à resolução de problemas deste tipo através de métodos exatos, utilizou-se um tratamento baseado em algoritmos genéticos (GA). A partir de uma formulação exata, mostramos como especificar os componentes principais de uma GA: cromossomo, codificação da solução, avaliação de fitness, estrutura da população, operadores genéticos. No problema tratado, as variáveis de decisão de um modelo de programação linear mista baseado na representação em grafos foram transmitidas por um cromossomo especializado e eficiente. O problema da infactibilidade foi contornado por um método de descarte, A maximização da demanda proporcionou mais rentabilidade. Com a utilização deste método heurístico foram obitidos resultados tão bons quando os encontrados pelos métodos exatos, embora não garantisse a otimalidade. A vantagem do método heurístico é reduzir o tempo computacional e gerar uma população de soluções, enquanto o métodos exatos geram apenas uma solução. A abordagem arco_caminho assegura que as configurações possíveis de equipamentos são representadas por meio de um conjunto pré-definido de caminhos, o que permite descartar a priori configurações infactíveis e dominadas, I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 83 as quais são eliminadas em tempo de pré-processamento, minimizando o custo de investimento total. Um método exato de otimização para resolver este tipo de problema é o Branch-and-Bound encontrado freqüentemente em pacotes computacionais. A principal dificuldade encontrada na resolução de problemas de otimização combinatorial, está no esforço computacional empregado para alcançar a solução ótima. Os problemas de grande porte possuem maior dificuldade na sua resolução quando se utilizam os métodos exatos. Para resolver os problemas de otimização combinatorial de grande porte, os métodos heurísticos ou de aproximação fornecem soluções próximas da ótima com maior rapidez e flexibilidade de implementação. Os métodos heurísticos são constituídos por etapas ou procedimentos decorrentes da observação das características do problema. O processo de encontrar uma boa solução consiste em aplicar à cada passo uma heurística que tenha sido projetada para cada problema particular. O que diferencia os algoritmos genéticos de outras heurísticas é o número de soluções geradas. Enquanto as outras heurísticas geram uma única solução em cada iteração, os algoritmos genéticos produzem um conjunto de soluções. O modelo pode ser estendido para representar outras situações de planejamento desta rede, como por exemplo, a escolha de tecnologia e topologia a utilização na conexão entre os sites e a Estação de Controle. O modelo pode também ser reformulado para tratar de outros tipos de decisão em redes, como, por exemplo, a definição de infra-estrutura. Em qualquer caso, o GA pode ser adaptado. PALAVRAS-CHAVE: Algoritmos genéticos, redes FWA, planejamento TIPO DE TRABALHO: Dissertação de Mestrado I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 84 PORTAIS EDUCACIONAIS E CULTURA MIDIÁTICA: ESPECIFICAÇÃO DE REQUISITOS EM CONTEXTOS DE EXTENSÃO À DISTÂNCIA Juvenal Silva Neto – [email protected] Gleber Nelson Marques – [email protected] UNEMAT – Universidade do Estado de Mato Grosso – Alto Araguaia / MT RESUMO Este trabalho sintetiza o desenvolvimento de um protótipo de Portal Educacional iniciado por meio de pesquisa bibliográfica exploratória impulsionada pela problemática da apropriação tecnológica na prática pedagógica. Acreditamos que um dos principais motivos para o pouco uso dos recursos multimidiáticos da Internet na prática docente é decorrente da dificuldade da apropriação tecnológica do computador e Internet como um recurso didático integrante da cultura midiática educativa contemporânea. Os pressupostos teóricos como os defendidos por CASTELLS (1996) incluem a estreita relação entre a cultura, a sociedade, o ser e a tecnologia que fundamentam a proposta de se considerar as possíveis contribuições destas relações ao processo de especificação de sistemas educacionais. Aqui apresentamos os alcances da primeira fase dessa pesquisa que consistiu no desenvolvimento de uma primeira versão do portal educacional, intitulado Portal GENTE que toma como ponto de partida a extensão à distância dos produtos e serviços desenvolvidos pelo Grupo de pesquisas GENTE (Grupo de Estudos sobre Novas Tecnologias na Educação), composto por computólogos, lingüistas e pedagogos. Em linhas gerais, as metodologias de desenvolvimento dessa pesquisa incluem o estudo e a “modelagem” da prática pedagógica com base em técnicas da Teoria da Atividade voltados à especificação de requisitos de sistemas, em que sejam levadas em conta informações provenientes de pesquisa de campo por meio de uma análise de requisitos centrada no usuário. Para o desenvolvimento da primeira versão do Portal foi utilizada a linguagem UML (Unified Modeling Language) para especificação e documentação dos requisitos por meio dos diagramas de casos de uso e de seqüência, além de storyboards. A partir dos diagramas obtidos durante o levantamento de requisitos com integrantes do grupo de pesquisas GENTE utilizou-se na codificação a linguagem PHP para tornar dinâmico tanto o gerenciamento do Portal quanto a disponibilização de recursos. Foi utilizado o Wordpress como Sistema de Gerenciamento de Conteúdo (Content Management System) – CMS, que possibilita ao administrador do portal um gerenciamento simples e em tempo real, além de ser código aberto, oferecer considerável quantidade de funcionalidades, vasta documentação e atualizações anuais. Para avaliação do protótipo será utilizado o método de inspeção “Avaliação Heurística” tomando como referência os aspectos de usabilidade da interface. A estrutura inicial do Portal identificada na etapa de levantamento de requisitos apontou quatro funcionalidades principais denominadas “Produtos e serviços”, “Fábrica de Mídias”, “Empório de Mídias” e “Oficina Pedagógica”. Em Produtos e Serviços o visitante deverá encontrar um resumo dos links com informações resumidas acerca dos produtos e serviços disponíveis no portal como, por exemplo, para as webquests desenvolvidas. Por este recurso o visitante, ainda não familiarizado com os demais espaços do portal, poderá encontrar o que deseja, ou simplesmente conhecer melhor os produtos e serviços oferecidos/disponibilizados. Em Fábrica de Mídias o visitante terá acesso I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 85 a informações relativas aos projetos em desenvolvimento como tipo de projeto, coordenador, objetivos, necessidade de voluntários e colaboradores, equipe de desenvolvimento, etc. O espaço do Empório de Mídias foi projetado para organizar todos os produtos já desenvolvidos ou pesquisados, e disponibilizá-los via download aos visitantes do portal. Na função Oficina Pedagógica o usuário encontrará um canal de comunicações que oferecerá serviços de assistência online visando dar suporte a incorporação efetiva dos recursos midiáticos educativos à prática pedagógica, disponibilizando ferramentas de comunicação síncronas e assíncronas como chat, fórum e whiteboard. A disponibilização dos espaços projetados para o Portal Educacional, particularmente o Empório de Mídias e a Oficina Pedagógica, permitirá estender às escolas os produtos e serviços oferecidos pela equipe multidisciplinar de pesquisadores do Grupo GENTE, e ao mesmo tempo, possibilitará a realização da segunda fase da pesquisa: a investigação de possíveis contribuições da teoria da atividade e etnografia à especificação e aprimoramento de requisitos centrados no usuário para análise e projeto de espaços em portais educacionais. Assumimos que ao termos os usuários como centro do processo de análise de software é possível reunir informações relevantes para a especificação do sistema, podendo dar origem a espaços e funcionalidades bem definidos e mais compatíveis com as necessidades inerentes às atividades envolvidas na prática pedagógica. PALAVRAS-CHAVE Engenharia de requisitos, Software Educacional, Apropriação Tecnológica, Extensão à distância. I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 86 PROCESSAMENTO DE CONSULTAS EM SISTEMA DE GERENCIAMENTO DE BANCO DE DADOS 1 Raphael de Souza Rosa Gomes – [email protected] 2 Josiel Maimone Figueiredo – [email protected] 1 – UFMT – Universidade Federal de Mato Grosso - Cuiabá / MT 2 – UFMT – Universidade Federal de Mato Grosso - Cuiabá / MT RESUMO Atualmente com a crescente globalização da Internet e dos meios de comunicação, ocorre um crescimento significativo na quantidade de dados a serem armazenadas nos servidores e posteriormente manipuladas. Há então a necessidade de realizar processamentos de dados cada vez mais rápidos e em maiores quantidades. Os servidores estão armazenando milhares de informações, e estas precisam ser atualizadas, pesquisadas, excluídas, etc. Para tanto, se faz necessário a utilização de um SGBD (Sistema Gerenciador de Banco de Dados) com bom desempenho na velocidade de resposta das operações sobre os dados. O desempenho de um SGBD poderá ditar o quanto um programa científico irá demorar para alcançar uma resposta em tempo hábil. Além disso, também pode representar uma economia de tempo para empresas e organizações em geral que desejam manipular seus dados. Assim, este trabalho tem como objetivo apresentar e analisar o funcionamento de um compilador de consultas SQL e do seu otimizador, visualizando entender como os componentes funcionam e suas influências no desempenho do sistema. A metodologia utilizada para este trabalho consistiu em realizar uma abrangente revisão bibliográfica sobre os seguintes temas: estrutura da Álgebra Relacional, plano de consultas, otimização de planos de consultas do banco e compilador de consultas. Para realizar as análises utilizou-se o banco de dados PostgreSQL, juntamente com o software de testes BenchMarkSQL, por serem softwares livres, ou seja, que disponibilizam seus códigos fontes. A realização dos testes foi executada através de variações nas configurações do compilador do PostgreSQL, alterando alguns parâmetros relacionados com o compilador de consultas, como por exemplo o parâmetro geqo que ativa o otimizador. Alterou-se também as configurações do BenchMarkSQL que estão relacionados com a quantidade de dados presente no teste. Para a análise dos testes teve-se como parâmetros, os tempos de respostas das consultas e as quantidades de consultas realizadas pelos testes. Os resultados demonstraram que tanto o compilador quanto o otimizador, influenciam diretamente no tempo de resposta das consultas. O compilador de consultas possui três grandes componentes. O componente Sintático, onde é verificada a sintaxe e a semântica das consultas SQL's; o componente Plano Lógico, onde são construídos vários planos de consulta para fazer uma estimativa de qual poderá ter um melhor desempenho, independente do Sistema Operacional ou do SGBD utilizado; e por último, o componente Plano Físico, onde é feita a conversão do plano lógico, de tal forma que o SO e o SGBD utilizados possam executar as consultas. O programa BenchMarkSQL foi alterado para que suporta-se vários testes automaticamente, analisasse os dados e gerasse os scripts dos gráficos para posterior utilização no GNUPlot, sem precisar alterar suas configurações manualmente para cada execução. No total foram realizados 40 testes sobre o PostgreSQL, tudo automaticamente, sem a necessidade de uma intervenção manual. Após análise dos resultados foi possível verificar um ganho de até 60% no tempo de resposta das consultas, apenas alterando as I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 87 configurações do compilador de consultas. Conclui-se, a partir desta explicação, o quanto é importante conhecer o funcionamento do SGBD para um melhor desempenho das operações e assim diminuir o tempo de resposta. Pode-se concluir também o quanto é importante melhorar a configuração do SGBD de forma constante, pois em banco de dados reais a todo o momento os dados são atualizados, inseridos, deletados ou selecionados. Portanto, é preciso verificar e entender as configurações do compilador de forma contínua, para obter os melhores resultados a maior parte do tempo. PALAVRAS-CHAVE Banco de dados, configuração, SQL TIPO DE TRABALHO: Trabalho de Graduação I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 88 PRODUÇÃO DE INSTRUMENTO DE AVALIAÇÃO DE CURSOS DE GRADUAÇÃO E PROPOSTA DE APLICAÇÃO ESPECÍFICA EM UM CURSO DE LICENCIATURA EM INFORMÁTICA Denise Pires Liceras - [email protected] Danilo Escobar - [email protected] Soraia Silva Prietch - [email protected] Tatiana Annoni Pazeto - [email protected] UFMT - Universidade Federal de Mato Grosso – Rondonópolis/MT RESUMO O processo de Avaliação de Cursos de Graduação deve ser e estar em constante renovação e desenvolvimento para, assim, poder apontar e sanar as necessidades de cada curso. Neste contexto, com o presente artigo pretende-se propor novo instrumento de avaliação para aplicação junto ao Curso de Licenciatura Plena em Informática, para que se torne possível confrontar os dados obtidos e assinalar os acertos e falhas para melhoria da qualidade de ensino do mesmo. Cabe ressaltar que o presente trabalho se insere no contexto de um projeto de pesquisa de maior amplitude, denominado “Levantamento Histórico do Curso de Licenciatura Plena em Informática, nos Planos: Acadêmico, Administrativo e de Vivência”, o qual tem como pretensão abordar uma variedade de temas relacionados ao referido curso de graduação considerando os mais diversos pontos de vista. Neste sentido, acredita-se na importância da observação dos erros e acertos passados para que no presente e no futuro, as atitudes que geraram tais resultados sejam repensadas e planejadas, de forma a evitar os passos inadequados e reafirmar os passos de sucesso, de preferência tendo um grupo conciso de profissionais e de estudantes trabalhando por um objetivo comum. A realização desta pesquisa é justificada pela necessidade de avaliar a qualidade do curso, visando analisar cada categoria (corpo discente, corpo docente, corpo técnico e infra-estrutura) separadamente, sendo que, caso alguma irregularidade for apresentada, esta será apontada de forma objetiva através de questões específicas do instrumento facilitando, assim, a identificação do problema a ser solucionado. Desta forma, acredita-se que a contribuição deste trabalho apóia-se nos fatos de que: (1) os alunos de cursos de Licenciatura em Informática/Computação ainda não participam do ENADE (Exame Nacional de Desempenho de Estudantes); e, (2) o curso, desde 2005, não foi re-avaliado pelo MEC, no sentido de obter sua renovação de reconhecimento. No entanto, é válido mencionar que o curso foi avaliado, no início de 2009, por uma comissão da própria UFMT, mas somente no que diz respeito ao seu ementário, o qual foi alterado com base na Resolução CNE/CP nº 2/2002, e no Decreto nº 5.626, de 22/12/2005. Segue abaixo a lista de atividades a serem desenvolvidas no decorrer do subprojeto: a) Buscar artigos e/ou livros que tratam sobre a avaliação de cursos de graduação, de modo geral, de cursos da área da computação; b) Efetuar a leitura e propor alterações no instrumento, proposto por Prietch (2008), de avaliação do curso, bem como acrescentar questões relativas a infra-estrutura; c) Aplicar instrumento na forma de questionário piloto para a realização de melhorias e ajustes; d) Verificar se na literatura pesquisada existem bons exemplos a serem seguidos que podem ser agregados à proposta; I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 89 e) Realizar a aplicação do instrumento (a princípio, em papel), bem como tabular e analisar os dados coletados. Até o presente momento foi possível efetuar a leitura e propor alterações no instrumento, proposto por Prietch (2008), de avaliação do curso, bem como elaborar a forma de pontuação para as questões do instrumento. Além disso, dentre a relação de atividades a serem cumpridas, citadas anteriormente, já foram realizados parcialmente os itens a, b e c. Sendo que, em relação ao item c, o instrumento foi aplicado, como piloto, para 06 alunos do 3º ano do curso de Licenciatura Plena em Informática, os quais sugeriram uma série de melhorias, a citar: (1) aumento das opções de respostas, visto que são objetivas; (2) questionamentos de como o instrumento chegaria a um resultado concreto final (critérios valorados); (3) sugestão de questões que poderiam ser incluídas; (4) verificação de questões duplicadas; (5) depoimentos da dificuldade em realizar auto-avaliação, que é uma das partes do instrumento; e (6) sugestão de incluir uma introdução textual, anterior ao início dos questionários, para explicação das categorias a serem avaliadas, dos critérios de avaliação, dos responsáveis pela aplicação do instrumento, dos objetivos, dentre outras. O instrumento encontra-se dividido na avaliação de cinco categorias: Coordenador do Curso, Corpo Docente, Corpo Técnico-administrativo, Corpo Discente e Infra-Estrutura, sendo que as perguntas estão distribuídas da seguinte forma: Coordenador do Curso 71, onde 10 são sobre o corpo Docente, 11 são sobre o Corpo Técnico-administrativo, 10 são sobre o Corpo Discente, 29 são de autoavaliação e 11 são sobre Infra-Estrutura; Corpo Docente 92, onde 27 são sobre o Coordenador do Curso, 5 são sobre o Corpo Técnico-administrativo, 10 são sobre o Corpo Discente, 39 são de autoavaliação e 11 são sobre Infra-Estrutura; Corpo Discente 88, onde 27 são sobre o Coordenador do Curso, 24 são sobre o corpo Docente, 4 são sobre o Corpo Técnico-administrativo, 10 são sobre a turma do discente, 12 são de auto-avaliação e 11 são sobre Infra-Estrutura; Corpo Técnico-administrativo 40, onde 27 são sobre o Coordenador do Curso, 1 sobre o corpo Docente, 1 sobre o Corpo Discente, 11 são de auto-avaliação. A aplicação piloto do questionário é considerada muito importante, pois através da mesma é possível ter uma noção do ponto de vista de alguns discentes do curso. Além disso, pode-se constatar que os discentes estão preocupados com a desenvoltura do curso, já que demonstraram interesse, além de fornecerem suas sugestões do que poderia ser feito para melhorar o instrumento. Em relação à aplicação final do instrumento, a ser realizada posteriormente, acredita-se que, mesmo não sendo obrigatório, haveria um grande percentual de participação, já que o desenvolver do curso é de interesse de todos, sendo que os discentes, em especial, são atingidos diretamente por tudo que acontece no curso, sejam estes acontecimentos bons ou ruins. PALAVRAS-CHAVE Curso de graduação, Licenciatura em Informática, Avaliação, UFMT. Tipo de Trabalho: Voluntariado de Projeto de Pesquisa I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 90 PROJETO DE INTERAÇÃO BASEADO EM CONTROLE 3D 1 Alexandre Torrezam – [email protected] 1 Aline Paulino Domingos de Souza – [email protected] 1 Diego Duarte Almeida – [email protected] 1 – UNIRONDON – Centro Universitário Cândido Rondon – Cuiabá / MT RESUMO A tecnologia, como é característica, evolui rapidamente e nesse exercício surge a necessidade de se facilitar ou inovar os meios de interação do homem com os mais diversos dispositivos. Vários segmentos estão sendo influenciados diretamente pela evolução tecnológica: e-books, TV, filmes, celulares e principalmente os jogos baseados em computador, impulsionam a necessidade da evolução da interação. Uma das maiores companhias de jogos do mundo, a Nintendo lançou o WII que elevou a interatividade homem-máquina a um novo nível, nunca antes visto em outro produto comercial. Não se trata mais de setinhas direcionais como as de um teclado de computador e sim de apontar um dispositivo na tela de TV, gesticular e balançar, indicando qual é o elemento a ser selecionado e confirmando pelo pressionar dos botões. Com o esse conceito de interação, novas tecnologias vieram à tona; Johnny Chung Lee foi um dos primeiros a exibir algumas das suas ideias e a adaptar algumas das funcionalidades do WII para o computador. Suas pesquisas foram a inspiração para este trabalho. Elaborando um protótipo e garantindo sua funcionalidade poderemos verificar que novos meios de interação podem facilitar e agilizar o uso de diversos dispositivos, nas mais diversas atividades e ainda, propor aplicabilidades que outrora seriam inviáveis. Desta forma, o objetivo geral deste trabalho é construir um protótipo que se comunique com o computador e realize qualquer tarefa que possa ser orientada pelo mouse, teclado ou movimentos em terceira dimensão. Dessa forma pretende-se mostrar através de experimentos, que novas formas de comunicação elevam o nível de interatividade entre homem e diversos dispositivos. Para isso será necessário: explorar novas tecnologias de interatividade existentes, reproduzir o sistema de interatividade do Nintendo WII em um protótipo personalizado e criar uma aplicação que interaja com usuário através dos meios convencionais e também através do protótipo. Trata-se, portanto de uma pesquisa experimental onde testaremos o protótipo e verificaremos a estabilidade e confiabilidade das suas atividades. Para tal experimento, foi necessária uma pesquisa exploratória que trouxesse o estado da arte de interatividade em terceira dimensão e as suas vertentes. Após a exploração, uma pesquisa bibliográfica foi realizada para que se definisse todo o aporte teórico que guiaria a concepção do protótipo, o projeto do aplicativo de testes e os critérios de avaliação do modelo de interatividade criado. Para reproduzirmos o funcionamento do WII, precisamos que seu controle se conecte com um computador e que este esteja apto a interpretar as informações enviadas por ele. Deste modo, seguimos algumas das orientações do projeto de Chung Lee, que se baseia em capturar uma fonte de luz infravermelha como referência usando o Wii Remote e fazendo uso das propriedades do controle da Nintendo para realizar diversas atividades com o computador. Para obtermos total controle sobre o protótipo, uma SensorBar foi reproduzida, utilizando LED´s infravermelhos, um cabo USB, resistores, fios e uma base para fixar todos os elementos; a alimentação pela USB do computador garante a mobilidade do protótipo. Utilizando os softwares BlueSoleil e GlovePIE, foi possível interagir com I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 91 o computador para diversas atividades como controlar o reprodutor de mídia, slides e até desenhar no computador, sem a necessidade do uso do teclado ou mouse. Ainda visando maior controle dos testes, foi desenvolvido um software no formado de um atirador em 2D, baseado na tecnologia XNA que possui uma vasta biblioteca de controladores de entrada de dados o que facilitou a integração do protótipo com o jogo. O jogo tem suas funções de interação baseadas no uso do teclado e mouse e neste trabalho, também foi utilizado nosso sistema de interação personalizado para avaliação de desempenho do sistema. Os problemas principais para a construção do protótipo foi a aquisição dos materiais básicos que os configuram. A revisão bibliográfica nos colocou em contato com os conhecimentos elementares de cálculo de voltagem, corrente, tensão e resistência para que pudéssemos concluir esta etapa. A configuração do BlueSoleil foi um desafio a parte pois o software não funciona adequadamente em um sistema de 64 bits, nos obrigando a migrar para um sistema de 32 bits para desenvolver as atividades. Por fim, o estudo e elaboração de scripts com o GlovePIE permitiu que os testes com a nova SensorBar fossem iniciados. Concluiu-se que SensorBar requer alguns ajustes pois neste trabalho utilizamos apenas 4 LEDs (o original do console utiliza 10) o que limitou a captação dos movimentos do controle mas não comprometeu os testes iniciais. Mesmo com tais limitações, que podem ser ajustadas num próximo projeto, é possível desenhar, jogar e interagir com o sistema conforme a programação de suas funções no GlovePIE permitir. Desta forma, foi possível experimentar as dificuldades em desenvolver um projeto com novas características de interação, atingindo o objetivo de verificar que um bom design de interação promove uma comunicação mais eficiente entre o dispositivo computacional e o humano que deve controlá-lo. PALAVRAS-CHAVE: IHC, interatividade, design de interface TIPO DE TRABALHO: Trabalho voluntário de Iniciação Científica com o apoio do Centro Universitário Cândido Rondon. I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 92 PROJETO DE UM SISTEMA ONLINE DE AUXÍLIO À FISCALIZAÇÃO DA VIDA PÚBLICA DOS POLÍTICOS Guilherme Wilson dos Santos Lopes¹ – [email protected] Iara Fernandes de Araújo¹ – [email protected] Rafael Lima Franco¹ – [email protected] Rodicrisller Rodrigues¹ – [email protected] Sayuri Arake Joazeiro¹ – [email protected] Cristiano Maciel¹ – [email protected] 1 – UFMT – Universidade Federal de Mato Grosso - Cuiabá / MT RESUMO A necessidade de informação se torna mais evidente a cada dia que passa. No que diz respeito a um melhor controle por parte dos cidadãos da gestão pública realizada por seus representantes no governo do nosso país, essas informações estão dispersas em vários meios de comunicação social. As ferramentas computacionais que estão presentes para o grande público apresentam algumas funcionalidades, como disponibilização de informações atualizadas, fóruns, prestação de contas dos políticos, bem como um perfil com informações escassas destes etc. Contudo, estas se encontram desunidas e isoladas. No domínio de gestão pública tem-se a necessidade de uma ferramenta que agregue essas diversas funções, a fim de condensar em um único meio as informações necessárias para fiscalização eficiente das ações políticas. Nesse contexto, foi realizada a análise e o projeto de um sistema que propõe a solução para o problema citado anteriormente, promovendo por meio de uma série de recursos a interatividade entre os usuários e a divulgação das informações da vida pública dos políticos de forma unificada, denominado Programa de Qualidade de Políticos. Tal sistema se destaca por propor medidas que se baseiam nos princípios de software social, descritos por Gene Smith, especialmente os de reputação e compartilhamento. Na fase de Análise, foi realizada a escolha do modelo cascata de desenvolvimento por estar de acordo com as necessidades da aplicação em questão. Em seguida, foram avaliados os impactos morais, éticos e de privacidade que envolviam a produção de um sistema dessa natureza, chegando às normas e regulamentos propostos para a relação dos usuários com o sistema. Logo após, foi realizada uma análise de mercado, na qual efetuamos uma pesquisa em ferramentas nacionais que abordam a mesma temática do Programa de Qualidade de Políticos, como o domínio Políticos do Brasil pertencente ao portal Uol (http://noticias.uol.com.br/politica/politicos-brasil/), com o intuito de compreender o contexto em que o sistema seria inserido, por meio da qual foi constatado que não existe atualmente disponível no mercado um sistema que integre tanta quantidade e qualidade de informação como a ferramenta proposta possibilitaria. Depois, foi realizada a elicitação de requisitos que comportam as características fundamentais do sistema, descrevendo assim as funcionalidades por ele oferecidas, entre elas: informações dos políticos dispostas em um perfil único, uma lista com os nomes dos políticos que respondem ou responderam processos judiciários, área de compartilhamento de arquivos postados por usuários, além de permitir que a comunidade cadastrada no domínio I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 93 possa avaliar o candidato por meio de notas e “favorite” os políticos a fim de que possam receber informações atualizadas sobre estes. Para tanto foram utilizadas as seguintes técnicas de elicitação: entrevistas, questionários, leitura de documentos e brainstorming. Na fase de projeto, definimos os marcos, produtos, atividades, cronograma, diagrama de alocação de pessoal e análise de risco. Em seguida, foram detalhados os requisitos em formas de casos de uso, definimos a arquitetura do sistema e foram feitas algumas prototipações. Como resultado da fase de análise, examinamos os dados coletados por meio da aplicação do questionário e das propostas do brainstorming, que possibilitaram uma idéia mais concreta do perfil dos nossos futuros usuários, a definição do escopo de aplicação da ferramenta, bem como suas características essenciais e a validação da aceitação do sistema pelo público. No projeto do sistema, por meio dos protótipos, foi elaborado um modelo para a interface do sistema, modelo este feito à mão (storyboard), o qual contribuiu para a montagem de uma apresentação de alta fidelidade, com navegabilidade das funcionalidades para o usuário final. Em seguida, realizamos uma avaliação heurística, proposta por Jakob Nielsen, da prototipação de alta fidelidade, a fim de diagnosticar problemas existentes e elaborar possíveis soluções antes da implementação da versão final. Para a gerência de projeto, temos como resultado uma documentação que garante uma futura implementação do sistema por uma equipe de desenvolvimento concreta. Com base na problemática abordada e necessidade de um sistema como esta ferramenta, utilizando algumas metodologias de desenvolvimento de projeto, foram realizados os objetivos propostos por esse trabalho, visto que as técnicas utilizadas produziram a análise e o projeto de uma ferramenta que viabiliza a interatividade entre os usuários e a divulgação das informações da vida pública dos políticos em um único ambiente. A partir dos resultados obtidos, temos a possibilidade, posteriormente, da implantação de uma ferramenta de assistência à fiscalização da gestão pública dos políticos que poderá ser utilizada pela sociedade. PALAVRAS-CHAVE política, engenharia de software, software social, gestão pública Tipo de Trabalho: Trabalho de disciplina de graduação I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 94 PROJETO E IMPLEMENTAÇÃO DE UMA PLATAFORMA WEB PARA CONTROLE E GERENCIAMENTO DE REDES DE SENSORES SEM FIO Leonardo de Souza Alves – [email protected] Otto Julio Ahlert Pinno da Silva – [email protected] Maxweel Carmo – [email protected] UFMT – Universidade Federal de Mato Grosso – Barra do Garças/MT RESUMO Apesar dos expressivos avanços no campo das redes de sensores sem fio (RSSF), a interação eficiente entre esse tipo de rede e o usuário tem sido ainda um importante desafio. O presente trabalho propõe a especificação e implementação de uma plataforma capaz de intermediar e facilitar esta comunicação, permitindo ao usuário realizar atividades de manutenção e gerenciamento da RSSF, além de possibilitar a obtenção e manipulação de dados coletados pelos dispositivos de sensores. As RSSF caracterizam-se pela presença de dispositivos de baixo custo com pouca capacidade de processamento e sérias limitações de energia e comunicação. Em um ambiente onde a RSSF é compartilhada entre usuários com interesses distintos, torna-se evidente a necessidade de uma plataforma capaz de coordenar eficientemente o acesso aos recursos da rede. Por exemplo, implementar políticas de segurança de forma a evitar o acesso à RSSF por pessoas não autorizadas, definir diferentes privilégios para usuários, negando ou autorizando acesso a determinados nós, fornecer serviço de escalonamento de tarefas como configurar um conjunto de nós para iniciar e parar a medição em um determinado intervalo de tempo futuro e desativar nós ociosos de forma a economizar energia. A plataforma fornecerá suporte a atividades de monitoramento, disponibilizando informações sobre a autonomia dos nós (carga de bateria), histórico de utilização destes sensores para auxiliar em tomadas de decisões como reconfiguração da topologia da rede, informação sobre o tipo de sensor disponível no nó (temperatura, pressão, luminosidade, entre outros), etc. A plataforma será ainda responsável por gerenciar um banco de dados de informações coletadas pelos sensores. Entre outras finalidades, o banco de dados permitirá que medições feitas previamente possam ser recuperadas e devolvidas aos usuários ao invés de se iniciar outro processo de medição, poupando, assim, recursos da RSSF. De acordo com políticas de segurança previamente definidas, o banco de dados, ou parte dele, pode ser compartilhado entre diferentes usuários. A ferramenta está sendo desenvolvida para a plataforma Web, permitindo ao usuário interagir com a RSSF via browser e de forma independe de plataforma. Serão empregadas técnicas de mushup de forma a agregar serviços de terceiros como o de mapas georreferenciados do Google Maps. Através da visualização espacial dos nós da RSSF, será possível a realização de diferentes tarefas como, por exemplo, o gerenciamento da rede por parte do administrador e a seleção de nós para realização de medições dos usuários. É comum em uma aplicação de RSSF a presença de centenas de dispositivos de sensores. Neste sentido, durante as fases de testes da ferramenta, a RSSF será simulada via Network Simulator 3 (NS-3) – um ambiente de simulação discreto de redes de computadores. Os resultados da simulação (dados de sensoriamento) alimentarão o banco de dados da ferramenta Web. A possibilidade de interligar a ferramenta diretamente à rede I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 95 simulada também será estudada, visto que o NS-3 oferece interfaces que facilitam tal procedimento. O TinyDB – um sistema de processamento de consultas SQL adaptadas para interação com redes RSSF – também poderá ser empregado. Uma consulta TinyDB a um grupo de nós para obter, por exemplo, informações de temperatura e índice de luminosidade por um intervalo de 10 segundos poderia ser formulada da seguinte forma: “select light, temp from sensors sample interval 1s for 10s”. Espera-se na fase final de desenvolvimento da plataforma a criação de um protótipo de RSSF contendo algumas unidades de sensores reais e voltado para o contexto de monitoramento ambiental. A ferramenta se encontra atualmente em fase inicial de desenvolvimento. PALAVRAS-CHAVE Rede de sensores sem fio, aplicação web, interface com o usuário. Tipo de Trabalho: Trabalho de Graduação I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 96 PROPOSTA DE SOFTWARE EDUCATIVO PARA AUXILIAR NO PROCESSO DE ENSINO-APRENDIZAGEM DE MÉTODOS CLÁSSICOS Thaís Santos Santana - [email protected] Nair Crisitina dos Santos Ribeiro - [email protected] Simone Fátima Ferreira - [email protected] Soraia Silva Prietch - [email protected] UFMT - Universidade Federal de Mato Grosso – Rondonópolis/MT RESUMO O software educativo proposto aqui deverá incluir características classificadas como tutorial, simulação, exercício-e-prática, e programação, conforme especificado por Valente (1995)10. Essa classificação foi definida com a intenção de auxiliar os alunos de graduação da área de computação no processo de aprendizagem dos conteúdos de Métodos Clássicos, abordados na disciplina de Projeto e Análise de Algoritmos. A concepção pedagógica será híbrida, mesclando as abordagens comportamentalista e construtivista, no que se refere à implementação dos algoritmos indicados nos exercícios. Com relação a isso, Valente (1995) menciona que: “o objetivo desta modalidade [programação] de uso do computador é propiciar um ambiente de aprendizado baseado na resolução de problemas. [...] No entanto, deve ser notado que o objetivo não é ensinar programação de computadores e sim como representar a solução de um problema segundo uma linguagem computacional”. O software educativo contemplará dois métodos clássicos: o Método Guloso (Greedy Method), e o Método Divisão e Conquista (Divide-and-Conquer Method), sendo que para cada um serão explorados as características, o funcionamento, as técnicas de implementação, os exemplos práticos, as aplicações, a simulação e os exercícios de fixação. Para a realização desse projeto foram feitas pesquisas bibliográficas, além da utilização do software Enterprise Architect, para confecção do diagrama de casos de uso em UML e para o desenvolvimento do layout da tela inicial proposta, para o software educativo, a ferramenta Adobe Fireworks. Os envolvidos na proposta de criação do software educativo serão um desenvolvedor e um professor. O desenvolvedor do software precisará ter um bom conhecimento da linguagem de programação Java. O professor deverá ter domínio do conteúdo referente aos Métodos Clássicos abordados no software educativo, além de buscar e produzir um material diferenciado, com vídeo aulas, animações, exemplos e exercícios que estimulem o aluno, para compor o software. É importante destacar que o Licenciado em Informática seria um profissional habilitado a exercer tanto a função de programador do software como a de professor, conforme seus conhecimentos adquiridos ao longo de sua formação. Considera-se que, para utilizar o software, o aluno deverá ter uma base de conhecimento em lógica de programação, estrutura de dados, e da linguagem de programação C, que será a linguagem usada, para a implementação dos exercícios. As suas possíveis ações no sistema serão: estudar o conteúdo teórico disponível no tutorial, visualizar o funcionamento do algoritmo por meio das simulações e programar exercícios. Pretende-se incluir especificações para tratamento de erros, por exemplo, para acessar os módulos, o aluno deverá 10 Valente, José Armando. Diferentes usos do Computador na Educação. Separata nº 1, Capítulo I do livro Computadores e Conhecimento: Repensando a Educação, 1995. I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 97 seguir a ordem do estudo, pois os módulos ainda não estudados (mais avançados) ficarão desabilitados até que o usuário tenha alcançado o rendimento necessário no módulo anterior ao desejado. Além de mensagens de erro em situações corriqueiras, como o não preenchimento de alguma questão dos testes. O professor poderá utilizar o software como uma ferramenta auxiliar em suas aulas, contudo os alunos poderão utilizar o software para entendimento dos conteúdos de forma independente, fora do horário de aula. Planeja-se que o software educativo seja executado em Desktop (executável para instalação), pois se acredita que o grupo a quem o software será inicialmente direcionado (estudantes de disciplinas de Projeto e Análise de Algoritmos), poderá utilizá-lo sem a necessidade da Internet, uma vez que o acesso a esta poderá ainda não estar disponível a todos. Podendo, contudo, ser disponibilizado para download na rede, para alcançar todo o público interessado. Com a pesquisa realizada, preliminarmente ao desenvolvimento da proposta, foi possível perceber a necessidade de se desenvolver meios diferenciados que atuem como ferramentas auxiliadoras no processo de ensino de conteúdos abstratos como é o caso da disciplina de Projeto e Análise de Algoritmos. As principais dificuldades encontradas no decorrer da pesquisa estão relacionadas à falta de disponibilidade de estudos realizados na área de construção de software específicos para o ensino de Métodos Clássicos. Como trabalho futuro pretende-se dar continuidade a pesquisa iniciada e desenvolver efetivamente o software proposto. PALAVRAS-CHAVE Métodos Clássicos, Projeto e Análise de Algoritmos, Método Guloso, Método da Divisão e Conquista. Tipo de Trabalho: Trabalho de Avaliação da disciplina de Projeto e Análise de Algoritmos. I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 98 PROPOSTA DE UM PROCESSO DE DESENVOLVIMENTO DE SOFTWARE PARA FACILITAR A INTEGRAÇÃO DA EQUIPE DE DESENVOLVIMENTO 1 Maria Cristina Delgado Preti – [email protected] 2 Cristiano Maciel – [email protected] 1 IFMT – Instituto Federal de Educação, Ciência e Tecnologia de Mato Grosso – Cuiabá / MT UFMT – Instituto de Computação da Universidade Federal de Mato Grosso – Cuiabá / MT 2 RESUMO A falta de adoção de métodos, de ferramentas e de procedimentos no desenvolvimento de software resulta em números expressivos de projetos não concluídos ou em projetos concluídos que não atendem às necessidades do cliente (PRESSMAN, 2006). Um dos focos da Engenharia de Software é o processo de desenvolvimento de software (PDS) investigado neste estudo. Aproveitando-se da recém estruturação, ocorrida no Instituto Federal de Educação, Ciência e Tecnologia de Mato Grosso (IFMT), este estudo propõe à Diretoria de Tecnologia de Informação (DTI) a implantação de um processo de desenvolvimento de software padrão tendo por finalidade: manter integradas as equipes do IFMT, guiadas por um modelo único, trabalhando de forma mais produtiva, com artefatos úteis e adequados e utilizando a mesma linguagem na codificação, na documentação e na comunicação sistêmica. Para a definição do PDS proposto nesse estudo foi feita uma pesquisa bibliográfica que abrangeu a natureza da Engenharia de Software. Entre os modelos que foram originalmente propostos para colocar ordem no caos do desenvolvimento de software, estão: o modelo em cascata que sugere uma abordagem sistemática e sequencial para o desenvolvimento de software. (PRESSMAN, 2006); no desenvolvimento evolucionário há dois tipos de modelos – o exploratório e prototipagem. O processo de iteração da abordagem evolucionária apóia-se em dois modelos: incremental e espiral. O espiral mantém a abordagem sistemática passo a passo, sugerida pelo modelo cascata, mas o incorpora a um arcabouço iterativo. (SOMMERVILLE, 2003). O desenvolvimento baseado em componentes incorpora muitas das características do modelo espiral e propõe soluções através da combinação de componentes de software previamente preparados. (PRESSMAN, 2006). Considerando que os sistemas implantados no IFMT variam de pequeno a médio porte, é proposto para essa instituição um processo híbrido: desenvolvimento evolucionário do tipo prototipagem com uso do modelo espiral para a iteração das fases do processo e o desenvolvimento baseado em componentes, essencial na agilidade do desenvolvimento. A linguagem de modelagem sugerida para a visualização, a documentação, a especificação e a construção de sistemas orientados a objetos é a UML (Unified Modeling Language – Linguagem de Modelagem Unificada) a qual fornece vocabulário e regras para a representação conceitual e física de um sistema. A equipe de desenvolvimento deverá seguir o arcabouço definido neste estudo para alcançar as metas de desenvolvimento. A estrutura inclui cinco atividades: análise, projeto, implementação, implantação e manutenção evolutiva. A análise ou concepção é a primeira etapa do PDS. Ela enfatiza a investigação do problema, produzindo compreensão ampla, mas pouco profunda do sistema. A fase de análise prevê para cada sistema um conjunto de atividades e/ou artefatos: relatório com uma I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 99 análise da viabilidade; levantamento dos requisitos; organização dos requisitos; análise de componentes; criação do glossário; elaboração de um documento de análise de riscos; elaboração de um documento para o planejamento da comunicação; cronograma de execução e custos. A fase de projeto visa a produzir uma solução para o problema identificado na fase de análise. Nesse momento, resta projetar uma arquitetura de software e de hardware para realizar concretamente o sistema, isto é, apresentar uma solução para o problema enunciado. As atividades concernentes à essa etapa são: termo de abertura; expansão de casos de uso; elaboração de diagrama de sequência; elaboração de modelo conceitual; construção de diagrama de classe; elaboração de projeto da camada de interface; elaboração de projeto da camada de persistência; especificação de framework. Implementação – durante essa fase, o projeto de software é compreendido como um conjunto de programas ou unidades de programa, abrangendo as atividades: codificação; testes; integração. Instalação e implantação – o sistema é implantado no ambiente no qual deverá operar. Para essa etapa duas atividades são necessárias: operação e treinamento. A operação envolve, quando necessário, a migração do banco de dados existente. Por sua vez, o treinamento se comprometerá com a organização de sessões de treinamento para os usuários. Manutenção evolutiva – essa etapa consiste na correção de eventuais erros e/ou na melhoria do sistema, ao longo da vida útil do software. Quando necessário, deve haver correções e atualizações nos artefatos provenientes das fases de análise e de projeto do sistema. Os ciclos de análise, de projeto, de implementação e de testes são repetidos tantas vezes quantas forem necessárias para desenvolver todo o sistema. Em cada ciclo, um conjunto diferente de casos de uso é abordado, segundo as prioridades do momento. Dessa forma, procura-se produzir uma solução completa e funcional para cada um dos processos associados ao ciclo. A proposta de PDS em questão visa à efetividade, à continuidade, à segurança e à transparência. De forma geral, os sistemas devem fornecer a visão do estado do projeto a qualquer instante, servir como meio de comunicação entre os envolvidos, indicar o nível de participação de todos os envolvidos, manter um histórico documental do projeto, sistema ou software e ser a base para a fase e subfases seguintes. O estabelecimento de um PDS é essencial porque permite organizar e guiar a equipe de desenvolvimento de forma ordenada. Cabe destacar que, em meio às dificuldades enfrentadas na elaboração dessa proposta, a recente reestruturação organizacional por que passou o IFMT impactou sobremaneira o PDS devido às constantes modificações exigidas e que representam um risco iminente. PALAVRAS-CHAVE: Processo de desenvolvimento de software, Modelo de processos de software. Tipo de Trabalho: Trabalho de Pós-Graduação Lato Sensu – Especialização em Gestão de Projetos em Engenharia de Software. I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 100 RECONHECIMENTO DE PADRÕES ATRAVÉS DA MODELAGEM E TREINAMENTO DE REDES NEURAIS UTILIZANDO BACKPROPAGATION MULTILAYER PERCEPTION IMPLEMENTADO EM SCILAB 1 André Valente do Couto – [email protected] 1 Gérson Kazuyoshi Kida – [email protected] 1 Marilson Oliveira Corrêa – [email protected] 1 – IFMT – Instituto Federal de Mato Grosso – Cuiabá / MT RESUMO A Inteligência Artificial ou Inteligência Computacional reúne técnicas que buscam integrar aos sistemas de processamento, características típicas do comportamento inteligente. A dificuldade em se encontrar uma definição consensual de IA e definir claramente seus limites reside no problema da definição do próprio conceito de inteligência. Pode-se dizer que a capacidade de solucionar problemas relacionados à percepção, interpretação, inferência e tomada de decisões, com elevado grau de auto-adaptação, define a inteligência no escopo de Inteligência Artificial. Existem diversos algoritmos e técnicas para caracterização do comportamento humano, que é rotulado como inteligência. Desses, escolheu-se o Perception Multicamadas pelo fato deste algoritmo ser uma implementação robusta, com extensas referências bibliográficas para as análises de reconhecimento de padrões através de treinamento supervisionado, exatamente o que se enquadra para a utilização da base de dados escolhida. O escopo deste trabalho está na aplicabilidade do algoritmo Perception Multicamadas com retropropagação, implementado em um ambiente computacional numérico (Scilab), para o reconhecimento de padrões através do treinamento supervisionado da rede neural. Ainda, será analisada a manipulação heurística dos principais parâmetros que determinam a estrutura e o formato de aprendizado da rede neural com base na obtenção de seus resultados (taxas de erros). Para o treinamento supervisionado, foi utilizado a base de dados "PenBased Recognition of Handwritten Digits" gerado pelo Prof. Ethem Alpaydin (http://www.cmpe.boun.edu.tr/~ethem) que se consubstancia no reconhecimento dos 10 números (algarismos hinduarábicos) através dos símbolos gerados em um scanner de escrita. Na confecçao da base de dados, uma população de pessoas escreveram os algarismos em um scanner de escrita que após ser equalizada a escala, rotação e número de pontos, foram dispostas em 16 entradas, que correspondem às coordenadas dos 8 pontos pelos quais passou a caneta na mesa digitalizadora. Foram fornecidos 7.494 exemplos para treinamento da rede (pendigits.tra) e 3.498 exemplos para uso exclusivo de teste (pendigits.tes) da rede treinada. A implementação do algoritmo no ambiente de computação numérica (SCILAB) se tornou um aspecto relevante, no sentido em que permite uma observação e experimentação direta da aplicabilidade dos conceitos fornecidos nas referências bibliográficas, além de prover o entendimento completo do algoritmo e não somente a utilização de aplicativos de simulação ou de aplicativos já implementados, o que permite também, o seu uso no meio acadêmico para fins de ensino. Esta implementação inicial teve como base a capacidade do sistema de: ler a base de dados de aprendizagem; ser capaz de treinar a rede Perception Multicamadas (BackPropagation) com um número I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 101 variável de neurônios na camada escondida; permitir a variação das principais características de treinamento deste algoritmo; testar a saída da rede treinada contra uma base de dados de testes e obter uma análise dos resultados obtidos, verificando a evolução da taxa de erro quadrática (no arquivo de treinamento) e a taxa de erro (no arquivo de teste) com base na alteração heurística dos parâmetros de treinamento. Toda a codificação do algoritmo e tradução das fórmulas para o ambiente de computação numérica foram realizadas com base em pesquisas bibliográficas. O algoritmo Perception Multicamadas, possui alguns parâmetros que são definidos de forma heurística, ou seja, não existe uma forma exata para a definição de seus valores, no que decorre a necessidade de diversos ajustes nesses parâmetros. A cada novo ajuste, se faz necessário um novo treinamento da rede neural e consequentemente uma nova análise dos seus resultados. Com base nesses resultados é possível definir os parâmetros que resultaram em uma maior taxa de acerto no reconhecimento dos padrões desejados e por fim definir a rede neural satisfatória. Os principais parâmetros variáveis desse algoritmo são: quantidade de camadas escondidas; quantidade de neurônios em cada uma dessas camadas; o número de épocas e o passo. De acordo com Hayken S. em Neural Networks a Comprehensive Foundations, a quantidade de camadas escondidas não incrementa a capacidade de generalização da rede neural que compense a quantidade extra de cálculos executados e por consequente o maior tempo para o treinamento da rede, fato este que determinou a limitação da variação da quantidade de camadas escondidas para somente uma, ou seja, este parâmetro não será um elemento variável, mas para garantir a propriedade de generalização, o parâmetro a ser variado é a quantidade de neurônios nesta única camada escondida. No processo de aprendizado outro fator importante para o processo de treinamento é a quantidade de vezes que é apresentado o conjunto de exemplos para a convergência da rede neural, definido como a quantidade de épocas. Outro fator importante é a taxa de aprendizagem que é a definição de quão grande serão os ajustes nos neurônios, sendo esta variável rotulada como passo. Nos testes, aproximadamente 145, variando a quantidade de neurônios na camada escondida, o passo e a quantidade de épocas, a menor taxa de erro encontrada, foi de 4,97% obtido com a configuração dos seguintes parâmetros: 200 neurônios na camada oculta, 0,001 passo de atualização dos pesos e 2000 apresentações dos exemplos, épocas. Foi possível certificar que acima de 200 neurônios na camada escondida, o índice do erro quadrático é inferior a 500, nota-se, também, que com menos de 18 neurônios o índice de erro é sempre superior a 10% e a partir de 150 neurônios o índice de erro é inferior a 10% na maioria dos testes. Este trabalho nos permitiu um profundo conhecimento do algoritmo Backpropagation Perception Multicamadas o entendimento das relações das variáveis heurísticas aplicadas no treinamento desta rede neural em função das taxas de erros oferecidas para o reconhecimento dos padrões “Pen-Digits”, além de se oferecer uma nova abordagem teórica e prática para o ensino deste algoritmo. PALAVRAS-CHAVE Inteligência artificial, Redes Reconhecimento de Padrões. Neurais, Backpropagation, Perception, Tipo de Trabalho: Pesquisa Científica I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 102 REDES SOCIAIS E CONTROLE POLÍTICO Ângelo Carlotto - [email protected] Frederico Scarcelli - [email protected] Gilberto Valandro - [email protected] Luís Márcio Resende - [email protected] Cristiano Maciel – [email protected] UFMT – Universidade Federal de Mato Grosso – Cuiabá/MT RESUMO A partir da compreensão da necessidade de uma ferramenta que integre diversas informações dispostas na Internet que, provendo confiabilidade, recursos e facilidades aos usuários, seja capaz de atrair uma maior atenção por parte dos cidadãos brasileiros para o assunto da política nacional, iniciou-se o projeto de um sistema que se propõe a atender tal necessidade. Tal sistema trata-se de uma aplicação para a Web na qual os cidadãos serão capazes de avaliar os políticos em exercício no Brasil. O mesmo se utiliza de muitos recursos atualmente conhecidos na Web e visa atingir sua meta informacional: prover informação política ao eleitor. Dado o grande uso das redes sociais pelos jovens no Brasil, o sistema é proposto acoplado a uma rede social, neste caso, o Orkut. Assim, objetiva-se fornecer um sistema informativo político que monitore as ações realizadas por parlamentares da atual gestão, e de gestões passadas, por meio de perfis individuais contendo informações relevantes sobre a trajetória política desses, bem como fornecer ferramentas para a interação entre usuários e o sistema, como por exemplo, fóruns de discussão e enquetes. Tal sistema pode ser uma fonte de pesquisa e de interação transparente sobre a vida da política nacional, possibilitando aos cidadãos a escolha mais sensata do voto em futuras eleições. A princípio, como metodologia de desenvolvimento do trabalho foi realizada uma pesquisa de mercado com observação na Web com o intuito de identificar o conteúdo político disponibilizado na internet e, assim, percebeu-se a necessidade do desenvolvimento de um sistema web que fornecesse aos usuários um conteúdo rápido e seguro sobre política e a realidade eleitoral dos políticos. Em seguida, iniciou-se uma pesquisa de público com a aplicação de um questionário via web, sendo o público-alvo cidadãos com idade superior a dezesseis anos e grau de escolaridade e classe social variados. Essas duas últimas características se devem à forma de divulgação da pesquisa, realizada por meio de programas de troca de mensagens instantâneas, como o MSN e de aplicativos presentes em redes sociais, como o Orkut, acabando portanto, por abranger uma amostra aleatória da população. O questionário limitou-se a quantia de dez questões de caráter objetivo, qualitativo e quantitativo, abrindo opção para respostas discursivas em algumas alternativas. Para o projeto do sistema, utilizou-se a metodologia de engenharia de sistemas para Web. Como no ponto central da pesquisa estão as redes sociais, elementos como identidade pessoal e compartilhamento de informações são investigados e discutidos via sistema proposto. Como resultados obtidos, percebemos que esta pesquisa, em desenvolvimento, já nos possibilitou a confirmação da necessidade de implantação do futuro sistema em redes sociais, bem como nos levou a percepção da necessidade do desenvolvimento de um sistema voltado tanto para o público jovem quanto para o adulto. Por meio da pesquisa de mercado, realizada de início, percebeu-se a necessidade da existência de um sistema com I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 103 o conteúdo voltado exclusivamente para a política, com notícias de confiança e não tendenciosas, o que envolve tanto notícias atuais, quanto notícias de fatos antigos extremamente relevantes, porém de difícil localização. Com a pesquisa de público percebeu-se que os brasileiros com idade acima dos trinta anos são os que mais se interessam por política, embora quem mais procure por informações neste sentido são os jovens entre dezesseis e trinta anos, que se encontram em pleno desenvolvimento de um lado critico, político e social, fato que está inteiramente ligado ao maior contato deste público com as tecnologias da informação e da comunicação (TIC). Notou-se também que existe interesse por parte da população em um sistema que facilite a obtenção de informação acerca deste assunto, desde que se possa confiar no mesmo. O brasileiro em geral possui um nível mediano de interesse por política e embora tenha uma grande dificuldade em encontrar informações de confiança e não tendenciosas a respeito, busca, com um relevante dispêndio de tempo, se manter informado. Por isso, a proposta da criação de uma rede social com o foco voltado exclusivamente à política poderia ter uma grande aceitação da população, desde que seja provado que o sistema é seguro e que as informações providas pelo mesmo são de confiança e atualizadas. Com base nos resultados preliminares da pesquisa e nos pressupostos teóricos da área de engenharia Web, uma aplicação para redes sociais foi projetada e implementada, com vistas ao funcionamento de forma integrada ao Orkut. Visando manter a confiabilidade do sistema frente aos usuários, os mesmos se avaliarão por meio de “estrelas de reputação”, sendo que cada usuário poderá avaliar qualquer outro, apenas uma vez, a partir da atribuição de estrelas. Cinco estrelas é a pontuação máxima e zero estrela é a pontuação mínima. Este método permitirá que a própria comunidade determine ou não a confiabilidade de um usuário, observando que quanto menor é a reputação de determinado usuário, menor será a atenção dada as suas informações postadas no sistema, evitando assim, a proliferação de notícias inverídicas e caluniosas. Este método de controle de reputação também proporciona uma autosuficiência à aplicação tendo em vista que o usuário é o único ator necessário para a continuidade do sistema. O desenvolvimento da ferramenta será realizado de maneira mais objetiva possível visando oferecer o máximo de interação entre usuário e sistema, proporcionando uma navegabilidade simples e variada bem como a utilização de imagens que recorram a uma familiarização dos usuários. Na página principal, e inicial, estará disposto um mapa do Brasil podendo-se a partir daí realizar a filtragem e busca de informações de políticos relacionados ao respectivo estado. Por fim, ressalta-se que, atendidas as exigências dos possíveis usuários, o uso das redes sociais voltadas à política facilitaria à população se manter informada, ajudando ainda a estimular o interesse pela política no país. PALAVRAS-CHAVE Política, rede social, identidade, governo eletrônico, informações de políticos Tipo de Trabalho: Trabalho de disciplina de graduação I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 104 SHEEPBOT – UM MOTOR DE BUSCA E FORMADOR DE ONTOLOGIAS POLÍTICAS Suliane de Oliveira Carneiro – [email protected] Custódio Gastão da Silva Júnior – [email protected] IFMT - Instituto Federal de Educação, Ciência e Tecnologia de Mato Grosso – Cuiabá / MT RESUMO Em ano eleitoral, o que não falta são informações sobre a vida dos políticos. A sociedade busca cada vez mais recursos que facilite a garantia de confiabilidade dessas informações. Em meio a vários domínios sobre o assunto, é de praxe, conhecer a “ficha” dos políticos, identificar os tipos de crimes que eles já cometeram e os cargos que os mesmos já ocuparam. Contudo, com o grande volume de informações disponibilizados na Web fica difícil agrupar todos os dados sobre um assunto em um único domínio. A proposta desse estudo é elaborar uma ontologia com domínio focado na política a partir de um conjunto de termos ordenados hierarquicamente, baseados no diagrama de classes (Anexo-Figura 1). A Figura 1 é composta por diagramas de classes que contem as principais informações da estrutura da ontologia. Este modelo conceitual captura e define os tipos de combinações seguindo um ciclo de eventos baseados em um motor de busca, o SheepBOT, um ROBOT que enxergará a web como um grande banco de dados com informações não estruturadas e faça consultas que recuperem os dados da vida política dos candidatos, armazenando algumas informações que serão utilizadas como chaves para encontrar conceitos relacionados aos termos pesquisado (Anexo-Figura 2). Para fundamentar esse domínio e construir tal ontologia, a proposta do desenvolvimento desta pesquisa passa sobre um processo de embasamento teórico, da utilização de uma linguagem que faz consultas nas bases de dados disponíveis na web, o SPARQL (SPARQL Protocol and RDF Query Language), e, o desenvolvimento de um motor de busca, o SheepBOT, que faz a indexação dessas informações consultadas e as armazena em outra base de dados, a partir da ontologia criada. Para que essas informações tenham garantia de serem recentes, precisa-se de uma base de dados, com informações gerais, devidamente agrupadas e com alta chance de estar atualizada, e a principio temos a Wikipedia. Ela fornece uma base de conhecimentos como um banco de dados disponível na Web, o DBpedia. O DBpedia já possui uma estrutura para que sejam feitas consultas com a linguagem SPARQL. Imagine que o usuário faça a busca: “Todos os Políticos do Brasil”, a intenção é que, o SheepBOT se conecte a base de dados, o DBpedia, faça a consulta e recupere as informações de forma que as classifique em sujeito - predicado – objeto. Essa classificação é feita através de um protocolo, que reconhece arquivos em formato RDF (Resource Description Framework), um modelo utilizado para descrever dados na Web Semântica, estruturando as informações em forma de triplas. Todas as informações formadas por uma tripla são identificadas por uma URI (Uniform Resource Identifier) que reconhece ou denomina um recurso na Web. O usuário pode combinar os dados dos arquivos RDF, provenientes de diversas fontes e/ou base de dados disponibilizados na web. Na prática pode-se representar a consulta “Todos os Políticos do Brasil” da seguinte forma: I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 105 SELECT ?property ?isValueOf WHERE { ?isValueOf ?property <http://dbpedia.org/class/yago/BrazilianPoliticians> } Quadro 1 - Consulta: Todos os Políticos do Brasil O Yago11 é composto por entidades e relações, e que atualmente contém mais de 1,7 milhões entidades e 15 milhões de fatos. Possui ainda, inúmeras coleções sobre esses diversos fatos. Esta classe representa os Políticos Brasileiros que estão dentro das entidades do Yago. Tem-se uma cláusula de seleção SPARQL, o SELECT, os atributos ?isValueOf e as propriedades dessa classe ?property. Nesta consulta o resultado apresentado, retorna uma lista de tudo que se tem nessa classe, ou seja, todos os políticos do Brasil. O conceito de web semântica tem ganhado grande aceitação na medida em que novos aplicativos de software têm sido desenvolvidos, não somente em ambiente de pesquisa acadêmica, mas também junto ao governo e à iniciativa privada (BREITMAN, 2005). As tecnologias da web semântica fazem com que a integração de novas fontes de dados se transforme em novas bases de dados e por conseqüente, novas ontologias. O SPARQL permite essa junção de tecnologias e integração das bases de dados a partir de buscas semânticas, facilite a obtenção de dados estruturados e semiestruturados, permitindo explorar dados e descobrir novos tipos de relacionamentos e ainda, reunir diferentes aplicações e formar uma nova, como a proposta desse objeto de estudo. Figura 1 – Estrutura de Classes da Ontologia Política 11 http://dbpedia.org/class/yago/BrazilianPoliticians é uma classe do Yago. I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 106 Figura 2 - Ciclo de eventos do motor de busca - SheepBOT PALAVRAS-CHAVE RDF, SPARQL, DBpedia, Recuperação da Informação, Ontologia, Política. Tipo de Trabalho Trabalho de Pós-Graduação Lato Sensu I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 107 SIMILARIDADE CONCEITUAL ENTRE DOCUMENTOS DE REQUISITOS USANDO O MODELO VETORIAL DE RECUPERAÇÃO DE INFORMAÇÃO Adriana Cássia da Costa¹ - [email protected] Custódio Gastão da Silva Júnior² - [email protected] ¹UFMT – Universidade Federal de Mato Grosso, Cuiabá/ MT ²IFMT – Instituto Federal de Educação, Ciência e Tecnologia de Mato Grosso, Cuiabá/ MT RESUMO A similaridade conceitual em projetos de desenvolvimento de software visa a melhoria da especificação de requisitos, auxiliando na redução de erros relativos a ambiguidade de conceitos. Este estudo apresenta o modelo vetorial de recuperação de informação na busca por termos relevantes que consigam indicar a similaridade entre documentos de especificação de requisitos. Foi realizado um estudo de caso para analisar o comportamento deste modelo, os testes retornaram documentos com considerável similaridade conceitual. A amostra utilizada nos testes é um domínio de um sistema acadêmico e os resultados apontam que o método TF-IDF (Term Frequency- Inverse Document Frequency) juntamente com a seleção linguística de substantivos e verbos melhora substancialmente o processo de busca por similaridade conceitual entre documentos. O Processamento de Linguagem Natural - PLN evoluiu consideravelmente na recuperação de informação e na engenharia de software. As contribuições de [Sayão (2007)] e [Carvalho et al (2007)], estudam a aplicação de PLN na verificação e validação de requisitos buscando melhorar a qualidade da análise de requisitos. Atualmente é comum desenvolver softwares em equipes geograficamente distribuídas, nestes casos, a verificação e validação de requisitos são de alta complexidade, podendo envolver o tratamento de até milhares de requisitos [Sayão(2007)] Técnicas de PLN aplicadas a documentos de requisitos e outros artefatos apóiam a validação e verificação destes. A similaridade entre documentos extrai conceitos importantes, possibilitando a verificação de regras de negócios duplicadas e a manutenção de padrões de especificação de requisitos [Sayão(2007)]. Este estudo apresenta as características do método vetorial de recuperação de informação pelo método TFIDF e a sua utilização na engenharia de software, especificamente na fase de construção dos documentos de especificação de requisitos. O foco deste trabalho está na busca por similaridade conceitual entre esses documentos, acrescentando na metodologia a seleção linguística para auxiliar no processamento dos documentos. O modelo vetorial atribui pesos aos termos e utiliza isso como medida de relevância entre os termos do domínio. Os documentos são representados em uma matriz de termos, onde os documentos e cada termo contido neles é colocado em linhas e colunas. A medida IDF (Inverse Document Frequency) verifica a freqüência de ocorrência do termo em relação a todos os documentos do domínio, essa medida reduz os casos de falsos positivos, caracterizado quando termos menos relevantes são apontados como representativos do I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 108 domínio. O TF (Term Frequency) determina a freqüência simples do termo no documento é também é chamado de peso local, pois resultará no valor do peso para o termo em somente um documento. A junção desses métodos minimiza os pesos dos termos muito freqüentes que geralmente não são representativos semanticamente, nessa categoria estão: às conjunções, artigos e pronomes [Sayão (2007)]. Após a aplicação do método TFIDF, os resultados podem atingir valores infinitos e é indicado normalizá-los, restringindo os valores a determinada faixa. Neste estudo foi utilizada a medida do cosseno da similaridade, restringindo os resultados entre 0 e 1. Os pares de documentos com taxa de similaridade próxima a 1 são muito similares, enquanto as taxas próximas a 0 são pouco similares. A seleção lingüística foi composta pelos verbos e substantivos do fluxo básico e das regras de negócio de 28 documentos de especificação de requisitos divididos em dois conjuntos. O primeiro com 6 documentos com verbos e 6 substantivos do fluxo básico, no segundo com 8 documentos de verbos e 8 de substantivos das regras de negócio. Os documentos foram comparados ao pares entre si e a taxa de similaridade representa sempre o resultado da comparação entre os termos comum em pares de documentos. Foi utilizado na contagem de freqüência simples o contador Lácio Web e considerados os termos com pelo menos uma ocorrência para alcançar o maior número de termos relevantes. No conjunto dos verbos do fluxo básico, as taxas de similaridade acima de 0,2 expressavam documentos com maior similaridade. Nos substantivos do fluxo básico a maioria dos documentos apresentou taxas de similaridade abaixo de 0,1. Neste caso, houve maior quantidade de termos em relação ao conjunto dos verbos, isso pode ter influenciado para apontar similaridade entre documentos com taxas menores. No conjunto dos verbos e substantivos das regras de negócio, as taxas com boa similaridade foram os valores acima de 0,048 para os verbos e 0,188 para os substantivos. A busca por soluções para recuperar informações relevantes estimula estudos de métodos como o TFIDF, que em conjunto com a seleção linguística mostrou-se um recurso interessante na busca por similaridade entre documentos. Os resultados apontam para a viabilização desta técnica na engenharia de software para a descoberta de requisitos duplicados e a padronização da especificação . Diversos estudos propõem o desenvolvimento de ferramentas a partir de técnicas línguísticas, estatísticas e híbridas, como o exatolp e NPS [Vieira el al (2009)]. Entretanto, os melhores resultados apontam para a utilização de abordagens híbridas, tendo no tratamento linguístico um diferencial para alcançar resultados consistentes. Na engenharia de software, técnicas de PLN são aplicadas principalmente na automação dos processos como na elicitação de requisitos como [Silva e Martins], que propõe a utilização de mecanismos automáticos na geração de diagramas de classes. Este trabalho mostrou um modelo reconhecidamente importante, com o diferencial de incluir informações linguísticas no processamento. Ressaltamos que essa junção proporcionou o processamento adequado para buscar similaridade conceitual. Como trabalho futuro, pretende-se utilizar o método híbrido C/Value e NC/Value em conjunto com o processo de stemming (redução do termo a parte fundamental/ radical) e realizar uma comparação com o TFIDF para consolidar os resultados experimentais. PALAVRAS-CHAVE: I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 109 Similaridade, TFIDF, documentos de requisitos, modelo vetorial Tipo de Trabalho: Trabalho de Graduação I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 110 UM ESTUDO COMPARATIVO DAS TÉCNICAS DE ELICITAÇÃO DE REQUISITOS: AMENIZANDO PROBLEMAS NO LEVANTAMENTO DOS REQUISITOS Luã Marcelo Muriana - [email protected] Cristiano Maciel – [email protected] UFMT – Universidade Federal de Mato Grosso – Instituto de Computação - Cuiabá/MT RESUMO A elicitação de requisitos na fase de análise de um sistema consiste no processo de se obter as principais características requeridas para um produto de software e para os usuários de um sistema, face às necessidades levantadas para os clientes. Assim, compreender o que os usuários finais de um sistema desejam não é uma tarefa trivial. Há vários problemas que os engenheiros de requisitos e os clientes encontram durante essa fase que é tida como de extrema importância para o sucesso de um software. Esse processo apresenta falhas e precisa ser bem desenvolvido. Segundo autores da área, os problemas se subdividem em cinco categorias: problemas na comunicação e relacionamento interpessoal, de entendimento, na metodologia, no processo e na organização; sendo de natureza social e técnica. Diversos estudos tem sido realizados a fim de comparar as técnicas de elicitação de requisitos, todavia carecem de uma análise, que além de considerar o contexto do sistema a ser desenvolvido, também analise como a escolha por determinada técnica pode ajudar a amenizar os problemas citados. Esse trabalho tem por finalidade comparar as diversas técnicas utilizadas atualmente, com vistas a facilitar a escolha da(s) técnica(s) de acordo com as características do processo. O levantamento bibliográfico foi realizado por meio de uma busca em referenciais da área a fim de identificar as principais técnicas utilizadas e os desafios encontrados na fase de elicitação de requisitos de um sistema. Segundo autores pesquisados, um conjunto de técnicas de elicitação de requisitos pode ser aplicado com o intuito de se definir os requisitos de um sistema, porém, a seleção dessas técnicas deve levar em consideração as características do sistema e das pessoas envolvidas com a aplicação a ser desenvolvida. Alguns estudos comparam algumas das técnicas de elicitação de requisitos, porém, esse estudo faz uma ligação entre essas técnicas e os problemas que podem ocorrer nessa atividade. Essa ligação tem por objetivo amenizar os problemas que possam vir a surgir nesse processo de desenvolvimento software, levando em consideração o contexto no qual o software será desenvolvido. Como resultado prévio do estudo, uma tabela comparativa entre as técnicas de elicitação de requisitos, baseando-se em referenciais bibliográficos, foi desenvolvida. Como técnicas analisadas há: entrevistas, questionários, leitura de documentos, cenários, brainstorming e JAD. As técnicas de elicitação de requisitos apresentam vantagens e desvantagens, assim, a comparação entre as técnicas deve levar em consideração fatores como, por exemplo, a participação dos indivíduos no processo de elicitação, a colaboração entre os envolvidos na aplicação da técnica, o tempo de execução, o custo do uso da ferramenta, se há conflitos entre os participantes e a possível qualidade dos requisitos levantados. Um dos problemas encontrados nessa atividade são os problemas de comunicação e relacionamentos interpessoais, assim, com o uso dessa tabela pode se perceber que algumas técnicas, como, por exemplo, Questionário e Leitura de Documentos, não oferecem conflitos entre I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 111 os usuários, como o JAD e o Brainstorming. Portanto, a importância de um instrumento que sumarize características de diversas técnicas, como a elaborada neste estudo, não reside no fato de tentar-se definir que técnica é melhor que outra, e sim pelo poder de consulta nesta fonte das características para dado contexto da aplicação. Como trabalho futuro, um foco maior será dado aos sistemas web, os quais, além dos requisitos funcionais e não funcionais, exigem que seja levantado, entre outros, os requisitos de conteúdo e a classe de usuários que utilizará o sistema. Neste tipo de sistemas, a comunicação com os clientes e com os usuários finais é feita por meio de alguns mecanismos diferenciados: grupo focal tradicional, grupo focal eletrônico, levantamentos iterativos e exploratórios e a construção de cenários. Tais técnicas de elicitação serão acrescidas ao estudo em desenvolvimento e suas características melhor investigadas. PALAVRAS-CHAVE: técnicas de elicitação de requisitos, engenharia de software. Tipo de Trabalho: Trabalho de graduação. I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 112 UM ESTUDO DAS ARQUITETURAS DE ARMAZENAMENTO DE DADOS VOLTADOS À WEB Talita Finger – [email protected] Cristiano Maciel – [email protected] UFMT – Universidade Federal de Mato Grosso – Instituto de Computação - Cuiabá / MT RESUMO Os sistemas de armazenamento de dados se tornaram essenciais na sociedade nos dias de hoje. Muitas empresas já informatizaram seu serviço; uma grande parcela da população tem aderido à rede como consumidor, vendedor ou até mesmo transmitindo apenas comentários, ideias, críticas, informações pessoais, entre outros. Toda a informação que trafega pela rede é armazenada em algum lugar, seja ela em um sistema de arquivos, em um sistema gerenciador de banco de dados, ou apenas na memória volátil de um computador. Com o crescimento da Internet muitos problemas surgiram devido à demanda de usuários. Algo muito vivenciado em Web Sites como de Redes Sociais, aonde a falta de disponibilidade e escalabilidade devido à grande quantidade de usuários utilizando os serviços tornam-se comum. O objetivo dessa pesquisa é relatar as soluções encontradas pelas Redes Sociais (Twitter, Facebook, MySpace) para resolver esses problemas, comparando o método de cada uma devido à sua necessidade. A motivação para a realização de tal estudo foi a necessidade presente de tratar problemas que até então são difíceis de prever, como é o caso do Twitter que ficou fora do ar, logo após a derrota do Brasil na Copa do Mundo, devido ao excesso de trafego. Um dos grandes desafios dos engenheiros do Facebook, por exemplo, tem sido em manter o site no ar e funcionando perfeitamente, muitas das abordagens tradicionais para servir o conteúdo web quebram ou simplesmente não são práticas. Serviços como os fornecidos na Web, em que é possível acessar até por aparelhos telefônicos, devem estar sempre um passo a frente, suportando novos usuários e garantindo assim seu desempenho. O levantamento de dados ocorreu por meio de pesquisas bibliográficas em livros, revistas, artigos e na Internet, com o objetivo de alçar as estratégias utilizadas por cada serviço de Rede Social. Esses dados possibilitaram reconhecer quais são os problemas mais comuns encontrados nesses ambientes, como eles os têm encarado e como eles os têm retratado, a fim de manter a confiabilidade com seus usuários. Muitas das abordagens adquiridas são comuns a mais de um Web Site garantindo a eficiência de seu uso ou a inexistência de alternativa. Como é o caso do Memcached que tem como objetivo acelerar processos de aplicativos, na qual utiliza a RAM sobressalente de muitos servidores para guardar informações acessadas com frequencia; ferramenta esta utilizada no Facebook e Twitter. Todo esse estudo se mostra importante para a Internet brasileira, pois situações como as enfrentadas pelo Facebook, Twitter e MySpace, podem se tornar cada vez mais comuns devido à tendência de crescimento do número de internautas em âmbito nacional. Aumento este evidenciado na pesquisa divulgada em 2009 pelo IBGE, na qual o percentual de brasileiros internautas aumentou 75.3% de 2005 para 2008. O que tornará, provavelmente, o funcionamento dos sites inadequado por falta de escalabilidade I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 113 e disponibilidade naqueles que não se mantiverem atentos a esse tipo de demanda. PALAVRAS-CHAVE Banco de Dados, Web, Redes Sociais. I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 114 UM LEVANTAMENTO SOBRE SOFTWARES NO APRENDIZADO DE CRIANÇAS COM DEFICIENCIA NAS ESCOLAS PÚBLICAS DE RONDONÓPOLIS/MT 1 Arthur de Lima Lira - [email protected] 1 Ma. Jacirene Lima Pires (orientadora) - [email protected] 1-UFMT- Universidade Federal do Mato Grosso – Rondonópolis - MT RESUMO Geralmente em uma escola convencional o ensino dedicado aos alunos é muito bem definido, com aulas previamente preparadas de maneira uniforme a todos, mesmo assim é comum que alguns assimilem a matéria com mais facilidades que outros. Alunos que geralmente não assimilam tão facilmente a matéria são classificados como alunos com dificuldades de aprendizagem ou até mesmo “alunos com necessidades especiais”. Percebido a necessidade de um acompanhamento cabe aos responsáveis decidir o que fazer em relação a esse novo impasse, alguns ignoram e fingem não estarem vendo, outros encaminham os mesmos para um acompanhamento profissional, é nessa etapa que se constatada a necessidade a criança é então encaminhada para uma instituição de ensino que suporte atender as suas necessidades educacionais com acompanhamento de pedagogos, psicólogos, fisioterapeutas e professores, dentre outros. A proposta da pesquisa surgiu da necessidade de atender a um público que tem sido deixado em segundo plano nas discussões sobre educação, a pesquisa em questão busca ainda dar suporte à inserção de meios interativos nas salas de aula convencionais e laboratórios de informática, sendo em especial explanada a aplicação do software educacional, ferramenta que existe e que é de fato objeto de aprendizagem. O levantamento realizar-se-á diretamente nas escolas públicas da cidade de Rondonópolis/MT, através de questionários fechados, e a analise dos dados se dará pelo método qualitativo. Cada questionário contém indagações sobre a quantidade de máquinas disponíveis nas escolas, quanto a existência ou não de projetos que envolvam utilização de softwares nas escolas, sobre a existência ou não da aplicação de softwares na educação e a educação especial atualmente, e na existência desta, conhecer se o nível de utilização atinge total ou parcialmente os alunos no ambiente educacional. Concluído a aplicação destes questionários pretende-se confrontar os dados com os resultados de pesquisas teóricas, tabular e gerar gráficos para apresentação e avaliação da comunidade. Espera-se com a conclusão desse trabalho fornecer informações suficientes para que seja possível aos professores da rede pública de ensino receber das escolas e aplicar em seus laboratórios os conteúdos adequados auxiliado por softwares que tenham relevância na vida do aluno que tenha deficiência, pois, mesmo que a quantidade de software seja limitada ou às vezes inacessível a região ou ao aparato técnico, os gráficos obtidos deverão abrir uma nova visão de mercado de softwares o que se espera que eleve a gama de softwares educacionais disponível. Contudo, espera-se auxiliar no desenvolvimento de novas propostas para a implantação de softwares no meio escolar da cidade de Rondonópolis/MT, dando ênfase à educação especial. Os dados serão disponibilizados à Secretaria de Educação localizada nesta mesma cidade, a pesquisa terá inicio na data 22/10/210 e fim previsto para I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 115 o final do ano letivo 22/11/210, para que os dados sejam analisados nas propostas pedagógicas do ano de 2011. PALAVRAS-CHAVE: Educação Especial, Aplicação de Softwares, Escola Pública. TIPO DE TRABALHO: Trabalho de Conclusão de curso I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 116 UM MODELO DE SISTEMA AUTOMATIZADO DE CLASSIFICAÇÃO DE ABELHAS BASEADO EM RECONHECIMENTO DE PADRÕES 1 Jésus Franco Bueno – [email protected] 2 Bruna Elisa Zanchetta Buani – [email protected] 2 Antonio Mauro Saraiva – [email protected] 2 André Riyuiti Hirakawa – [email protected] 2 Tiago Maurício Francoy – [email protected] 2 Vera Lúcia Imperatriz-Fonseca – [email protected] 1 – UFMT – Universidade Federal de Mato Grosso – Cuiabá/MT 2 – USP - Universidade de São Paulo – São Paulo/SP RESUMO A crescente perda mundial de biodiversidade tem sido uma das preocupações da comunidade científica internacional que motivaram a criação em 1992 da Convenção sobre a Diversidade Biológica, tornando-se um tratado de compromisso aceito pelos governantes de 187 países e pela Comunidade Européia. A redução da biodiversidade, devido a vários fatores, como a ação antrópica e o aquecimento global, compromete a capacidade do planeta de sustentação da vida humana em face do esgotamento dos recursos e serviços por ela prestados. A conservação e uso sustentável da biodiversidade passa necessariamente pela aquilatação e conhecimento das espécies. Entre essas espécies as abelhas polinizadoras têm merecido especial atenção, pois a polinização das plantas é um serviço de ecossistema muito importante. Estima-se que as abelhas sejam responsáveis por mais de 70% do serviço global de polinização. Existem quase 20.000 espécies de abelhas descritas no mundo. No Brasil são conhecidas quase 400 espécies de abelhas (cerca de 300 são abelhas sem ferrão). No entanto, este enorme esforço taxonômico a ser realizado pode estar comprometido pelo impedimento taxonômico reconhecido na Declaração de Darwin de 1988 pela ONU. Uma contribuição para minimizar o impedimento taxonômico pode ser dada pelo desenvolvimento de sistemas automatizados de apoio à decisão de classificação. A disponibilidade de dados sobre a Biodiversidade é uma importante ferramenta para a tomada de decisões em diferentes esferas de atuação humana: política, econômica, acadêmica, para citar algumas. As ferramentas disponíveis apresentam limitações em suas implementações em software, e muito embora poderosas conceitualmente têm nicho específico de aplicação. Este é o caso do ABIS - Automatic Bee Identification System que é um sistema de identificação automática para as abelhas, que usa algumas células da venação das asas para extração de dados de identificação da abelha. Entretanto, como as abelhas sem ferrão apresentam redução da venação das asas anteriores, o uso do ABIS fica impossibilitado. Mas a classificação deste grupo de abelhas é prioritária, pois são abelhas de extrema importância ecológica e econômica. O objetivo deste trabalho é a modelagem de um sistema automatizado de apoio a classificação taxonômica de abelhas sem ferrão baseado em reconhecimento de padrões e a implementação de um protótipo para prova de conceito. Este trabalho apresenta um modelo para um sistema automatizado de classificação de abelhas sem ferrão com uma abordagem baseada em reconhecimento de padrões usando as imagens das asas de abelhas para I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 117 extração das características empregadas na classificação. Para identificação de abelhas, os pesquisadores utilizam as imagens das asas de abelhas, pois sua morfologia está correlacionada à variabilidade genética. Os marcos anatômicos são pontos bem definidos na anatomia que podem ser reconhecidos em todos os espécimes. Um marco é um ponto de importância biológica em cada indivíduo que encontra correspondência em outros indivíduos semelhantes e dentro de suas populações. Os marcos anatômicos são usados para extração de atributos de classificação de abelhas. Um sistema integrado constitui uma demanda dos pesquisadores do Laboratório de Abelhas – APILAB, do Departamento de Genética da Faculdade de Medicina da USP – Ribeirão Preto. O sistema denominado ABeeS (Automated Bee Classification System) incorpora o conhecimento especializado para o reconhecimento automatizado de abelhas usando a imagem das asas. Partindo de um framework de construção de software, o ABeeS foi modelado em uma arquitetura modular formada por 6 subsistemas: aquisição da imagem digital, processamento da imagem digital, extração das características da imagem, identificação dos espécimes e atribuição da classificação taxonômica da espécie e interface integradora do usuário. A técnica de prototipação foi usada para verificação de requisitos de usuários e de sistema. Os protótipos foram criados no LabVIEW, um ambiente de programação gráfica, que disponibiliza uma plataforma de visão computacional para aplicações de reconhecimento de padrões usando o método de correspondência de padrões (pattern matching) que envolve duas fases: uma fase de aprendizado na qual a imagem-gabarito é processada e uma fase de comparação com a imagem sob análise. Este processo de software ágil tem por objetivo acelerar a resposta do usuário (feedback) que realiza uma bateria de testes a cada protótipo. Os resultados de extração automática dos marcos anatômicos mostram que a capacidade do ABeeS em localizar automaticamente a imagem-gabarito (template) do marco anatômico na imagem da asa em análise depende do conhecimento especializado transferido para o sistema. O ajuste dos parâmetros de treinamento e a qualidade da imagem da asa de abelha são determinantes para extração das características corretas. O conjunto de características extraídas das imagens e dos gabaritos de espécimes-tipo são aplicados a algoritmos de classificação supervisionados, como o FNN4Bees desenvolvido no Laboratório de Automação Agrícola da POLI-USP. Os resultados são comparados com os métodos tradicionais para verificação da eficiência do processo de classificação. Os resultados obtidos são satisfatórios e em alguns casos chegam a 95% de acerto para algumas espécies. Os resultados estão sendo armazenados no Banco Entomológicos de Espécies de Abelhas – BEE - para treinamento e otimização do sistema ABeeS. A automação das atividades de classificação taxonômica de seres biológicos é uma aspiração de longa data dos taxônomos e sistematas. A construção de sistemas baseados em computador para automatizar o processo de classificação deve ser fundamentada em padrões usados pelos especialistas para obter a identificação de espécimes. Com essa abordagem os sistemas podem contribuir para a descoberta de novos e (potencialmente) mais confiáveis caracteres taxonômicos. No entanto, essa automatização não elimina a participação do especialista, muito pelo contrário, cria a necessidade de definir uma forma padronizada para todo o processo, no qual o envolvimento do pesquisador é essencial em todas as atividades. I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 118 PALAVRAS-CHAVE Classificação Automatizada de Abelhas. Sistema Automatizado. Modelagem. Reconhecimento de Padrões. Tipo de Trabalho: Tese Agencia financiadora: Fapesp I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 119 UMA ABORDAGEM DE BANCO DE DADOS ORIENTADO A OBJETOS NO CONTEXTO DE DESENVOLVIMENTO DE SOFTWARE 1 Arthur Mendes Molina – [email protected] 1 Juliana Saragiotto Silva – [email protected] 1 – IFMT – Instituto Federal de Educação, Ciência e Tecnologia de Mato Grosso - Cuiabá / MT RESUMO A tecnologia de Banco de Dados (BD) proporciona o armazenamento, a disponibilização e o controle de dados abstraídos do mundo real (KORTH, 1999). Dentre as abordagens de BD existentes, pode-se mencionar o Banco de Dados Relacional (BDR) e o Banco de Dados Orientado a Objetos (BDOO) – cada qual com estruturas e formas de acesso específicas. Segundo Navathe (2005), os primeiros BDRs experimentais desenvolveram-se no final dos anos 70, com o objetivo de separar o armazenamento físico dos dados de sua representação conceitual. Já os BDOOs começaram a surgir por volta da década de 80. De acordo com Galante (2009), dentre os fatores que impulsionam o uso dos BDOOs, está a necessidade de se obter tipos de dados mais complexos e de difícil representação no modelo relacional. Assim sendo, este trabalho tem por objetivo, num primeiro momento, apresentar uma visão geral do BDR e do BDOO – com um olhar particular para a modelagem de dados e as linguagens de consulta. Na seqüência, apresentar uma aplicação de persistência de dados, utilizando o DB4O (um framework de código aberto, que utiliza a abordagem de BDOO). Um dos motivos que levaram a escolha deste BD, como objeto de estudo, foi o fato do DB4O integrar-se facilmente a uma aplicação Orientada a Objetos (não havendo necessidade de configuração nem instalação), apresentando compatibilidade com a linguagem comercial Java e a plataforma .Net. Para tanto, a metodologia utilizada para o desenvolvimento deste trabalho compreendeu quatro momentos: (i) uma pesquisa bibliográfica acerca da tecnologia de BD – por meio de consultas a periódicos digitais e acervos existentes na cidade de Cuiabá; (ii) um estudo comparativo entre o BDR e o BDOO – em termos de modelagem de dados (confrontando os elementos presentes na diagramação de cada abordagem escolhida) e de linguagem de consulta (apresentando como, uma mesma consulta, pode ser construída a partir da sintaxe padrão de cada abordagem) ; (iii) uma pesquisa de campo com acadêmicos da área de Tecnologia da Informação, do Campus Cuiabá, do Instituto Federal de Educação, Ciência e Tecnologia de Mato Grosso – na perspectiva de se verificar o nível de conhecimento acerca da tecnologia de BDOO, no contexto de desenvolvimento de software; e (iv) o desenvolvimento de uma aplicação, para o monitoramento de contas pessoais – utilizando-se, na implementação, os recursos herança e polimorfismo da Orientação a Objetos (os quais permitiram a reutilização de códigos já existentes) e, na persistência de dados, o framework DB4O. Vale mencionar, também, que como material de apoio, para o desenvolvimento da aplicação, utilizou-se o software NetBeans 6.5 e a linguagem de programação Java. Dentre os resultados obtidos, merecem menção os seguintes: (i) um maior esclarecimento acerca das principais diferenças entre os modelos de BDRs e BDOOs, em termos de modelagem e linguagem de consulta a dados; (ii) a constatação de que 90% dos acadêmicos I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 120 entrevistados não conhecem um BDOO, embora demonstrem interesse em estudos dessa natureza; e (iii) a experiência prática da utilização de um BDOO, por meio do desenvolvimento de uma aplicação desktop – fato, este, ainda pouco explorado na literatura. Sabe-se que este trabalho é apenas um passo na tentativa de se demonstrar a implementação de um BDOO em uma situação do mundo real, e que outras experiências necessitam ser realizadas, para que se possa testar, por exemplo, questões relacionadas ao desempenho do BD. Como perspectiva futura, espera-se que, a partir deste trabalho, a comunidade acadêmica e os profissionais que já atuam no mercado de software possam se motivar a realizar estudos dessa natureza. PALAVRAS-CHAVE Banco de Dados Orientado a Objetos, DB4O, Desenvolvimento de Software, Software Livre TIPO DE TRABALHO: Trabalho de Conclusão de Curso em andamento (Graduação em Tecnologia em Sistemas para Internet) I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 121 UMA ABORDAGEM PARA REUTILIZAÇÃO DE MODELOS DE NEGÓCIOS EM LINHAS DE PRODUTO DE SOFTWARE 1 Edie Correia Santana – [email protected] 1 Marcelo Augusto Santos Turine – [email protected] 2 Cristiano Maciel – [email protected] 1 – UFMS – Universidade Federal de Mato Grosso do Sul – Campo Grande / MS 2 – UFMT – Universidade Federal de Mato Grosso – Cuiabá / MT RESUMO Uma das formas de atingir alta produtividade e qualidade em engenharia de software é estabelecer reuso de software. Neste contexto, uma abordagem que pode habilitar reuso na prática é Linha de Produto de Software (LPS) - um conjunto de sistemas de software que compartilham um conjunto comum e gerenciado de funcionalidades que satisfazem uma necessidade específica de um domínio, e que são desenvolvidas a partir de um conjunto de artefatos reusáveis. A reutilização pode ser aplicada em diversos níveis de abstração, inclusive no nível de modelos processos de negócios (MPN). Como MPN podem ser considerados artefatos de software e que um domínio de negócios pode apresentar variações em suas atividades, é provável que um MPN seja um importante artefato no desenvolvimento de uma LPS. Um domínio em particular onde a adoção de LPS pode trazer benefícios é o domínio de aplicações de participação eletrônica (e-participação). Dessa forma, este trabalho objetiva definir uma abordagem prática para implementação de modelos de processos de negócios (MPN) reusáveis em uma LPS para o domínio de aplicações eparticipativas. Várias tecnologias têm surgido para solucionar os problemas de reuso de software, porém, muitas dessas tecnologias dão ênfase ao reuso em codificação, sendo que essa atividade representa apenas cerca de 20% do custo total de desenvolvimento de software. O reuso de requisitos e de arquiteturas de software pode trazer mais benefícios que os obtidos apenas com o reuso de componentes individuais de software, um dos objetivos da LPS. Algumas técnicas da engenharia de requisitos têm incorporado MPN com o objetivo de obter requisitos de sistemas que representem melhor os processos das organizações. Assim, essa pesquisa propõe uma abordagem para modelar e gerenciar a variação de processos de negócio e reutilizar esses artefatos nas aplicações alvo de uma LPS. A metodologia adotada para a pesquisa consta de uma Pesquisa Bibliográfica que visa atualizar constantemente o referencial bibliográfico da pesquisa. Como abordagens teóricas esta pesquisa, de cunho interdisciplinar, abordam-se conceitos de engenharia de software e técnicas de e-participação; Pretende-se aprofundar conceitos com base em pesquisas recentes sobre aplicações Web, governo eletrônico, modelagem de processos de negócios, linha de produtos de software. Para estender uma linguagem de modelagem de processos de negócio com o uso de variabilidade para permitir a desenvolvimento de uma abordagem de linha de produto estudos devem conduzidos com o propósito de escolher uma linguagem de modelagem para ser estendida, e identificar quais são os mecanismos de linhas de produtos que são relevantes para serem adicionados à linguagem. Por fim, será construído um meta-modelo para definir precisamente os conceitos da linguagem de modelagem. Além de construir um meta-modelo será realizada a validação do mesmo por meio de um estudo de caso. O produto final desenvolvido na pesquisa é a criação de uma I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 122 abordagem para reutilização de modelos de negócios em linhas de produto de software. O uso e benefício desse projeto podem ser destacados em domínios de negócios com contexto similar, uma vez que as operações realizadas são semelhantes. O reuso de software apresenta-se como um importante aliado para reduzir o esforço necessário para o desenvolvimento e manutenção de novos sistemas. Neste contexto, a abordagem LPS se insere estabelecendo um arcabouço de reuso de software que gera benefícios maiores que os das abordagens de reuso tradicionais, pois permitem não só o reuso de componentes individuais de software, como também o de requisitos e modelos de processos de negócios. PALAVRAS-CHAVE Reuso de software, Linha de Produto de Software, Artefatos Reusáveis, Modelos de processos de negócios. Tipo de Trabalho: Dissertação de Mestrado Agencia financiadora: Capes I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 123 UMA ANÁLISE DAS PRÁTICAS DE IHC PARA ADOÇÃO EM PROCESSOS DE ENGENHARIA DE SOFTWARE 1 Joyce Cristina Souza Bastos – [email protected] 1 Sandro Ronaldo Bezerra Oliveira – [email protected] 1 - UFPA - Universidade Federal do Pará – Instituto de Ciências Exatas e Naturais – Belém / PA RESUMO O desenvolvimento de sistemas interativos de qualidade exige a utilização conjunta de conceitos e práticas tanto de Engenharia de Software quanto de Interação Homem-Computador - IHC. Dificilmente a área de IHC é adotada em um projeto de desenvolvimento de software ou quando adotada, é feita de forma isolada do restante do projeto, ocasionando em sistemas pouco interativos, com manutenção dispendiosa e utilização, por parte do usuário, não satisfatória. Com base neste cenário, o principal objetivo da pesquisa apresentada neste trabalho é proporcionar o uso de IHC sem muito precisar adaptar um processo de desenvolvimento de software adotado por uma organização e/ou alterar a política organizacional de uma empresa. Esta análise é feita sobre a norma ISO/IEC 12207, que define processos de Engenharia de Software de maneira a ser flexível, modular e adaptável às necessidades da organização que for utilizá-la. O foco será no Processo de Usabilidade, incluído na norma ISO/IEC 12207, que tem como propósito garantir a consideração dos interesses e stakeholders necessários para permitir a otimização de suportes e treinamento, aumentar a produtividade e qualidade do trabalho, melhorar as condições de trabalho e reduzir as chances de rejeição do sistema pelo usuário. O estudo apresentado neste trabalho trata-se de um Trabalho de Graduação do Curso de Bacharelado em Ciência da Computação da UFPA, realizado pela aluna Joyce Bastos e orientado pelo Prof. Dr. Sandro Bezerra. Primeiramente, realizou-se uma revisão da literatura especializada a respeito das principais práticas, atividades e ferramentas de IHC. Também, fez-se um estudo com o objetivo de identificar um padrão de processo de desenvolvimento de software para que se pudessem estudar as interseções destas práticas de IHC com as atividades realizadas neste processo. Identificou-se, assim, o Processo de Usabilidade da norma ISO/IEC 12207. Os resultados destas pesquisas foram discutidos em reuniões, juntamente com o orientador. Em seguida, realizou-se um mapeamento entre as práticas de IHC e o Processo de Usabilidade da ISO/IEC 12207, constatando-se a aderência entre ambas. Por fim, identificou-se a necessidade de se analisar a adequabilidade destas práticas de IHC com os demais processos do ciclo de vida do software. Assim, optou-se por utilizar o framework de processo do Rational Unified Process - RUP, levando em consideração que se trata de um processo bem definido e estruturado, porém genérico, fornecendo uma estrutura customizável às necessidades de uma Organização. Como resultados atuais, podem-se listar: Conjunto de Práticas de IHC, com base na literatura especializada; Mapeamento das Práticas de IHC às Tarefas da Norma ISO/IEC 12207, para verificar e validar a aderência das práticas ao Processo de Usabilidade; Levantamento de Perfis (Papéis de Recursos Humanos) e Produtos de Trabalhos (Artefatos de Desenvolvimento de Software e Ferramentas de Apoio) para a área de Usabilidade, a fim de possibilitar uma implementação do processo a partir de um programa de melhoria organizacional; Adequação ao uso dos Perfis e Produtos de Trabalho no processo de Usabilidade da norma ISO/IEC I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 124 12207, a fim de colaborar com sua implantação organizacional; e Mapeamento das Práticas de IHC aos Processos de Engenharia existentes no framework do RUP, a fim de analisar o momento em que tais práticas podem ser incorporadas ao longo do desenvolvimento de um projeto de software. A partir do mapeamento realizado neste trabalho pôde-se verificar que as práticas de IHC são aderentes ao Processo de Usabilidade da norma ISO 12207. Como esta norma serve de base para as organizações desenvolvedoras de software instanciarem seus processos, pretende-se que elas possam inserir algumas destas práticas de IHC, de acordo com a demanda do projeto a ser desenvolvido, de forma a produzir e entregar um sistema mais aderentes aos princípios de IHC. Espera-se que o uso destas recomendações possa melhorar a qualidade do produto final e resultar num produto que melhor atenda os interesses e necessidades dos clientes e/ou usuários, uma vez que o uso de práticas de IHC pode tornar o produto mais competitivo mercadologicamente. Para uma organização de desenvolvimento de software que deseja melhorar a usabilidade de seus sistemas, faz-se necessário incorporar práticas e técnicas de IHC em seu processo. Entretanto, projetos centrados no usuário são mais difíceis de construir, pois requerem mais recursos e mais conhecimentos da equipe participante, além de ir de encontro com a cultura das pessoas envolvidas no projeto, que terão que ter consciência de que as duas áreas devem trabalhar de forma integrada. Segundo revisões da literatura, recomenda-se que a introdução das práticas de IHC em um processo deve ser gradual, começando por projetos pequenos e somente com o aumento das experiências, deve-se implementá-las no desenvolvimento de sistemas interativos maiores. Como trabalho futuro, pretende-se que o mapeamento sugerido entre Engenharia de Software e IHC seja implantado de forma customizável, levando em consideração as necessidades da Organização e do Projeto, em um pequeno projeto, para que se possam gerar resultados e, assim, comparações com outros projetos concluídos, da mesma instituição, sejam realizadas a fim de analisar as dificuldades encontradas em unir as duas áreas e os benefícios trazidos ao Produto e a Organização. PALAVRAS-CHAVE Processo de Usabilidade, RUP, Práticas de IHC, Engenharia de Software. Tipo de Trabalho: Trabalho de Graduação (Conclusão de Curso) I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 125 UTILIZANDO POLLING COMO MECANISMO DE CONTROLE DE ACESSO AO MEIO EM REDES DE SENSORES PARA O CORPO HUMANO Luís Fernando Refatti¹ – [email protected] Tatiana Annoni Pazeto¹ – [email protected] 1 – UFMT – Universidade Federal de Mato Grosso - Rondonópolis/MT RESUMO Redes de Sensores para o Corpo Humano são redes compostas por dispositivos eletrônicos com capacidade de monitorar sinais fisiológicos de pessoas (Barbosa, 2008). Estes dispositivos são alimentados por baterias com pouca capacidade energética, devido ao tamanho dos sensores. Contudo, existem sensores com maior capacidade computacional e energética, chamados sorvedouros, responsáveis por interligar os sensores a redes externas. Um dos problemas destas redes é o consumo de energia, sendo que a troca da bateria muitas vezes é inviabilizada devido a localização do sensor (Loureiro et al, 2003), que pode estar, por exemplo, dentro do corpo de uma pessoa. Assim devem-se desenvolver técnicas para que os sensores economizem energia. Uma das tarefas que mais produzem gastos energéticos é a comunicação (Sichitiu, 2004), que é realizada através de conexão sem fio, usando o ar para a difusão das informações. Sendo assim, pode haver colisões de pacotes acarretando na destruição dos mesmos, caso mais de um sensor esteja transmitindo ao mesmo tempo. Desta forma o sensor terá que retransmitir o pacote, resultando em um consumo extra de energia. Para amenizar este problema, devem-se utilizar mecanismos de Controle de Acesso ao Meio (MAC). Dentre os mecanismos existentes, alguns dividem a capacidade do canal em slots de tempo e distribuem uma parte para cada nó. Em outros, os nós disputam entre si o canal para transmitirem o pacote e ao receberem permissão para a transmissão, tem todo o canal alocado para o envio de informações, como ocorre no mecanismo polling. Este é um dos mecanismos mais simples, sendo que o seu funcionamento é descrito a seguir. Inicialmente define-se um ciclo onde o nó centralizador questiona nó a nó se há pacotes para transmitir. Havendo pacotes, o nó que está na vez inicia a transmissão, e os demais sensores que tiverem pacotes para enviar naquele mesmo tempo, armazenam o pacote em um buffer do próprio sensor, caso exista, ou destroem o pacote. Ao fim da transmissão do pacote, o próximo sensor que tiver pacotes para transmitir inicia o envio. Neste sentido, pode ocorrer uma perda significativa de pacotes, antes dos dados serem processados pelo sorvedouro. Assim, para analisar o impacto causado utilizando o método polling, foi desenvolvido um simulador que contém os nós sensores gerando tráfego, o algoritmo polling e um nó sorvedouro. Para simular o comportamento dos nós utilizaram-se cinco modelos de fontes: Fonte On/Off Fixa (Silva, 2009), Fonte On/Off Moeda, Fonte On/Off Moeda Controle, Fonte On/Off Limiar e Fonte On/Off Limiar Controle (Refatti e Pazeto, 2010), sendo que todas as fontes são baseados no modelo de tráfego On/Off. Este modelo consiste na divisão do tempo em períodos On, quando há atividade no canal de comunicação da rede, e períodos Off, quando os nós estão em silêncio. Este simulador foi desenvolvido utilizando a linguagem C++. Para testar o simulador foram geradas simulações com cinco e quinze sensores, com tamanhos de buffer zero, um e três. Para cada sensor, 10000 pacotes foram gerados. Nas simulações com cinco sensores verificou-se que o I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 126 descarte de pacotes ocorre somente quando o tamanho do buffer é zero, sendo este ínfimo. Já nas simulações com quinze sensores, em todos os casos houve descarte de pacotes, onde os descartes variaram entre 20% e 45%. No que tange aos tempos de fila, em todas as simulações com tamanho de buffer zero, não houve fila de espera em nenhum sensor. Isso ocorre pois se um pacote fosse gerado e não estivesse no seu tempo de transmissão, era descartado. Já nas simulações com cinco sensores e tamanhos de buffer um e três, os tempos de fila em todos os sensores foi o mesmo e não há descarte de pacotes. Desta forma percebe-se que se os sensores tiverem um buffer com uma posição, o problema do descarte de pacotes está solucionado. Já o totalizador dos tempos de fila nas simulações com quinze sensores apresentaram valores um tanto quanto elevados, ultrapassando 50s quando o tamanho do buffer é um e 250s quando o tamanho do buffer é três. Atráves dos resultados das simulações pode-se perceber que o método polling pode ser eficiente em aplicações de redes de sensores para o corpo humano, onde a quantidade de sensores é pequena. Isso ocorre pois o corpo pode ser dividido em regiões, sendo inserido apenas um sensor por região. Nestas situações, tanto o atraso na entrega dos pacotes quanto o descarte é baixo, sendo que pode ser zerado utilizando um buffer com poucas posições. O mesmo não ocorre quando há uma grande quantidade de sensores na rede, e devido as limitações de memória do sensor, pode não ser possível armazenar muitos pacotes para aguardar a vez do sensor transmitir, acarretando assim um descarte de pacotes considerável. Além disso, mesmo que o buffer disponível seja suficiente para que não haja descartes, o atraso na entrega dos pacotes pode ser grande. Desta forma, para redes com muitos sensores, outros mecanismos de controle de acesso ao meio devem ser considerados. PALAVRAS-CHAVE Redes de Sensores para o Corpo Humano, Polling, Fonte On/Off. TIPO DE TRABALHO: Trabalho de Graduação I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 127 WEB WIRELESS SENSOR MANAGER (W²SM) UMA PLATAFORMA PARA GERENCIAMENTO DE REDES DE SENSORES SEM FIO Itamar Eduardo Gonçalves de Oliveira - [email protected] Tatiana Annoni Pazeto - [email protected] UFMT- Universidade Federal de Mato Grosso - Rondonópolis/MT RESUMO Com o avanço tecnológico as redes de sensores sem fio estão sendo utilizadas em diversas áreas, como na área médica, possibilitando o gerenciamento de atividades remotamente. O presente trabalho apresenta a proposta de uma plataforma para o gerenciamento de uma rede de sensores sem fio para monitoramento de sinais fisiológicos do corpo humano: a Web Wireless Sensor Manager (W²SM). De acordo com Oliveira e Pazeto (2010), os sensores sem fio são alimentados por pilhas ou baterias. Seu rádio comunicador possui o alcance de cerca de 20 metros em ambientes fechados (com obstáculos) e de aproximadamente 100 metros em ambientes abertos (onde não existam obstáculos). No que se refere a comunicação, esta pode ser feita utilizando diversas tecnologias, variando de acordo com a aplicação que se pretende desenvolver. Vale ressaltar que a tecnologia utilizada na comunicação vai implicar no consumo de energia, na velocidade de transmissão e na quantidade de dados que podem ser transmitidos em cada iteração. Os nós sensores sem fio podem trocar mensagens entre si, possibilitando a formação de clusters, e/ou podem se comunicar com uma estação base. A estação base pode ser qualquer dispositivo (como um computador ou celular) que possua uma interface de comunicação sem fio compatível com a utilizada nos nós sensores, sendo que esta geralmente possui mais recursos que o nó sensor. Dessa forma é possível realizar o monitoramento remoto, onde os nós sensores fazem a coleta dos dados que se deseja monitorar e os transmitem a estação base. Ao receber as informações, a estação base se conecta a Internet e reporta os dados coletados, identificando o sensor que fez a coleta, para um servidor remoto. No servidor é feito o processamento dos dados, os quais podem ser acessados posteriormente pelo responsável pelo monitoramento através de uma página web. Diversos estudos e projetos estão sendo realizados na área de Rede de Sensores Sem Fio (RSSF), contemplando maneiras de otimizar o hardware, coleta, transmissão dos dados, bem como a segurança com que as informações trafegam. O intuito, da maioria das pesquisas, é prolongar a duração da bateria dos nós sensores, uma vez que o consumo de energia é um ponto fundamental em uma RSSF (Akyildiz, Melodia e Chowdhury, 2007). Deste modo, o monitoramento remoto deve considerar a degradação da bateria, pois em alguns casos não é possível sua troca constante, como em sensores implantados no corpo humano. Assim, existe a necessidade de gerenciar a coleta, transmissão e processamento dos dados que se tem o interesse de monitorar, sendo uma solução o W²SM. O W²SM permite realizar várias atividades, a citar: visualizar os dados coletados pelos nós sensores através de um histórico de cada nó; definir alertas para que o responsável pelo monitoramento seja avisado por Short Message Service (SMS) ou e-mail, quando o valor coletado pelo sensor atender a condição definida para a geração do alarme; visualizar o histórico dos alertas; acessar a thread do que foi feito para solucionar determinado alerta; compartilhar as informações de um nó com outros médicos ou assistentes; enviar comandos de configuração do nó; cadastrar I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 128 usuários e definir se ele é administrador, médico ou assistente. Consoante a validação da ferramenta, esta será realizada por sua demonstração para um médico. No desenvolvimento da ferramenta foram utilizadas as tecnologias HyperText Markup Language (HTML), Hypertext Preprocessor (PHP), JavaScript, Cascading Style Sheets (CSS) e MySQL. Também foi usado o editor de texto SciTE para a edição dos códigos, por este possuir sintaxe highlighted. Para a execução dos scripts PHP foi utilizada a ferramenta XAMPP, que é um aplicativo que permite a execução de um servidor Apache com suporte a PHP, além de um servidor MySQL. Até o presente momento foram realizadas as seguintes etapas: desenvolvimento do módulo para gerenciar os usuários, onde é possível fazer a inserção, edição e desativação do usuário; implementação do módulo para gerenciar os pacientes, possibilitando além da inserção e edição dos dados cadastrais do paciente, a configuração da rede de sensores que o médico está utilizando no paciente, ou seja, visualizar a localização dos nós sensores no paciente, bem como o status de cada um dos sensores; o módulo para o cadastro dos modelos de sensores, o qual permite que o perfil administrador insira e edite os dados referentes as configurações dos modelos de sensores disponíveis para o uso dos médicos; o módulo para o médico gerenciar a rede de sensores dos seus pacientes, permitindo ao médico escolher um modelo de nó existente e configurar qual método de sensoriamento será utilizado, qual o tipo de sensor (alguns modelos de nó sensores podem possuir tipos diferentes de sensores), posicionar o nó no cenário, para facilitar a identificação do nó que está sendo representado na tela. Encontra-se também em fase de implementação o módulo para a geração de alertas, que permite configurar uma condição para a geração de alarmes. Esse módulo se baseia no gerenciador de alertas proposto pela Turon (2005), na ferramenta para gerência de RSSF chamada MOTEVIEW. PALAVRAS-CHAVE Gerenciamento Web, Redes, Sensores Sem Fio TIPO DE TRABALHO: Trabalho de conclusão de curso I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 129 WEBQUEST “GÊNEROS DO DISCURSO”: UM PROCEDIMENTO DE ENSINO-APRENDIZAGEM DE LÍNGUA PORTUGUESA 1 Niulian R. Carrijo – [email protected] 1,2 Gleber N. Marques – [email protected] 1,2 Marilena I. de Souza – [email protected] 1 – GENTE – Grupo de Estudos Sobre Novas Tecnologias em Educação – Alto Araguaia/ MT 2 – UNEMAT – Universidade do Estado de Mato Grosso - Alto Araguaia/ MT RESUMO Este trabalho descreve o desenvolvimento e aplicação de uma WebQuest (WQ) como instrumento mediador e norteador no processo ensino-aprendizagem de gêneros do discurso em Língua Portuguesa (LP) a partir de uma concepção enunciativo-discursiva bakhtiniana, na qual os alunos são levados a interagir não só com o texto, objeto de ensino, e suas condições de produção, mas também com um conjunto de informações necessárias à compreensão da esfera social da qual emana o texto, por meio do acesso a conteúdos multimidiáticos da Internet, privilegiando autonomia na aquisição de informações e a reflexão para construção de conhecimento. Os recursos multimidiáticos disponíveis na Internet têm grande potencial como recursos didáticos, contudo a operacionalização dos mesmos não é uma tarefa fácil para escolares e professores. Assim, o modelo WQ constitui uma alternativa promissora para implementação da abordagem proposta em que se pretende possibilitar aos alunos a compreensão das escolhas lingüísticas, estilísticas e discursivas, para que sejam capazes de adequar a sua linguagem a situação comunicativa em que está inserido. Acreditamos que esta WQ ajudará o aluno a compreender melhor este objeto conceitual, bem como a utilizar a Internet como aliada na construção de seu conhecimento. Em uma perspectiva sóciointeracionista, as atividades em grupo e individuais incluídas no Processo da WQ exercitam as interações aluno-aluno e aluno-professor, e também aluno-objeto conceitual, caso em que a WQ se revela um recurso de mediação. A WQ desenvolvida em HTML propõe o estudo em grupo de quatro tipos de esferas públicas: jurídica, jornalística, escolar e científica, em que se objetivou que alunos compreendessem as relações entre as esferas da atividade humana e os gêneros a elas associados. A WQ desenvolvida é de longa duração para propiciar tempo para reflexão e amadurecimento conceitual. Retomando a taxonomia proposta por Bernie Dodge podemos classificar a WQ desenvolvida como uma WQ de “Reconto”, na qual os alunos devem ler, discutir (em grupos), refletir, produzir um texto e depois repassar para os demais colegas por meio de um painel. Aplicamos a WQ em uma 8ª série de uma escola pública local com 23 alunos ao longo de dez aulas. Elaborou-se um plano de ensino que operacionalizasse a WQ e as funções didáticas dos recursos escolhidos, interconectando-os às explicações teóricas. Por fim, aplicou-se um questionário para averiguar como a abordagem foi recebida e percebida pelos alunos, no qual se incluiu questões objetivas e espaço para justificar a opção escolhida. De acordo com as respostas de cerca de 90 % dos alunos, as atividades e os sites propostos pela WQ foram claros e objetivos. Justificaram que os sites eram de fácil entendimento e direcionavam ao assunto, que as informações contidas nos sites eram suficientes, que o modelo WQ é mais produtivo, e não deixava dúvidas quanto a realização das atividades a partir dos sites indicados. Quando perguntados se o roteiro WQ aplicado facilita a I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios 130 aprendizagem via aquisição de informação na Internet, o mesmo percentual reforçou em suas respostas que a WQ contém a descrição passo-a-passo do que precisa ser feito, facilitando assim a pesquisa na Internet, e que a WQ favorece a aprendizagem dos conteúdos teóricos pelo estímulo áudio-visual dos recursos da rede. Cerca de 70% dos alunos declararam que não estavam motivados no início da experimentação, pois a disciplina de LP é “chata”, porém ao longo do trabalho motivaram-se devido a metodologia de estudo proporcionada pela WQ, na qual os sites para as pesquisas eram pré-selecionados e as atividades bem definidas, tornando mais fácil, produtiva e rápida a realização das tarefas. Outros 19% comentaram que estavam motivados desde o início devido ao fato de usar-se a Internet para estudar LP, e ficaram ainda mais motivados ao conhecer a WQ. A análise dos questionários revela que a grande maioria das respostas foi positiva quanto à adoção da WQ como ferramenta de ensino-aprendizagem para cerca de 90% dos alunos, e também se pôde observar que as respostas negativas estão contidas sempre nos mesmos questionários, o que indica possivelmente que tais percepções negativas estão restritas a um grupo bastante particular de estudantes correspondente a aproximadamente 10% da turma. O trabalho realizado revelou a relevância da WQ desenvolvida como uma ferramenta importante para aquisição de conhecimento via Internet em Língua Portuguesa. A abordagem bakhitiniana proposta aos gêneros propiciou tanto o acesso aos diversos gêneros discursivos e tendências quanto uma forma mais interativa e atualizada de se trabalhá-los, além de valorizar a autonomia na aquisição de leitura, análise e documentação das informações de interesse, habilidades consideradas muito importantes na atual sociedade, ao favorecer a teoria da pedagogia da ação, onde o aluno “aprende fazendo”. Além disso, a utilização da WQ desenvolvida em sala de aula despertou os alunos para o ato da pesquisa na rede, bem como incentivou a socialização dos resultados alcançados individualmente e em grupo, favorecendo diferentes maneiras de se relacionar com os outros. PALAVRAS-CHAVE Informática Educativa, Internet na Educação, WebQuest, Ensino de Língua Portuguesa. TIPO DE TRABALHO: Trabalho de Graduação I Escola Regional de Informática de Mato Grosso - Elos Digitais: cidadãos, governo e negócios