CENTRO FEDERAL DE EDUCAÇÃO

TECNOLÓGICA DE MINAS GERAIS

Diretoria de Pesquisa e Pós-Graduação

Programa de Mestrado em Modelagem

Matemática e Computacional

HEURÍSTICAS PARA O

PROBLEMA DA CADEIA DE

CARACTERES MAIS PRÓXIMA

Dissertação de Mestrado, submetida ao Programa

de Pós-Graduação em Modelagem Matemática e

Computacional, como parte dos requisitos exigidos

para a obtenção do título de Mestre em Modelagem Matemática e Computacional.

Aluno: Marcelo Henrique Ribeiro de Almeida

Orientador: Prof. Dr. Sérgio Ricardo de Souza

Belo Horizonte - MG

Agosto de 2013

Almeida, Marcelo Henrique Ribeiro de

L732c

Heurísticas para o Problema da Cadeia de Caracteres mais

Próxima / Marcelo Henrique Ribeiro de Almeida. - 2013.

60f.

Dissertação de mestrado apresentada ao Programa de PósGraduação em Modelagem Matemática e Computacional.

Orientador: Sérgio Ricardo de Souza

Dissertação (mestrado) - Centro Federal de Educação

Tecnológica de Minas Gerais

1. Cadeia de caracteres - Modelos matemáticos - Teses. 2.

Busca Gulosa Iterada - Teses. 3. Algoritmo Genético Baseado em

Chaves Aleatórias Tendencioso - Teses. 4. Distância de Hamming

- Teses. 5. Heurística - Teses. I. Souza, Sérgio Ricardo de. II.

Centro Federal de Educação Tecnológica de Minas Gerais. III. Título.

CDD: 519.4

Elaboração da Ficha catalográfica pela Biblioteca Campus II / CEFET-MG

Agradecimento

Agradeço ao Pai do céu pelas bênçãos, saúde, alegrias e oportunidades que me

possibilitaram alcançar mais uma das etapas de minha vida. Agradeço a minha

família pelo amor e carinho e principalmente a minha avó Celina (in memóriam)

por todo seu amor. Agradeço também por conhecer pessoas maravilhosas nesta

jornada, que me acrescentaram um crescimento humano e espiritual.

E peço a Deus que abençoe: o professor Dr. Sérgio pela oportunidade concedida,

a qual foi fundamental para concretização desse sonho; o meu amigo Daniel pelo incentivo; aos funcionários e professores do CEFET-MG Campus II pela dedicação em

manter uma ótima estrutura educacional e a minha namorada Kianne pelo companheirismo e compreensão pela minha falta de tempo, que foram dedicadas ao nosso

futuro.

iii

Não venci todas as vezes que lutei. Mas perdi todas as vezes que deixei

de lutar.

Rui Barbosa

iv

Resumo

Esta dissertação de mestrado propõe o desenvolvimento de métodos heurísticos para o Problema da Cadeia de Caracteres mais Próxima (PCCP). O PCCP

tem, como objetivo, encontrar uma sequência t mais próxima possível de todas as

seqüências de um conjunto dado, usando, como métrica, a distância de Hamming.

A distância de Hamming dH (s, t) entre duas seqüências s e t de igual comprimento

é dado pelo número de posições nas quais elas diferem. O PCCP possui várias aplicações, em especial, na área da Bioinformática e na Teoria de Códigos. Classificado

como um problema de complexidade NP-Difícil, vários algoritmos de aproximação

e metaheurísticas têm sido propostas para encontrar soluções ótimas e com tempos

de processamentos aceitáveis. Neste trabalho, um novo algoritmo é proposto, baseado no framework do Algoritmo Genético Biased Random-Key Genetic Algorithm

(BRKGA) e será comparado com o algoritmo Iterated Greedy Search (IGS).

PALAVRAS-CHAVE: Problema da Cadeia de Caracteres mais Próxima, distância de Hamming, Iterated Greedy Search, Biased Random-Key Genetic Algorithm,

Metaheurísticas, Otimização.

v

Abstract

This dissertation proposes the development of heuristic methods for the Closest

String Problem (CSP). The CSP aims to find a string t as close as possible of all

the strings of a given set, using as metrics the Hamming distance. The Hamming

distance dH (s, t) between two strings s and t of equal length is given by the number

of positions in which they differ. The CSP has several applications, in special, in the

area of Bioinformatics and in Coding Theory. Classified as a problem of complexity

NP-Hard, several approximation algorithms and metaheuristics have been proposed

to find optimal solutions with acceptable processing times. In this work, a new

algorithm is proposed, based on the framework of the Biased Random-Key Genetic

Algorithm (BRKGA) and it will be compared with the Iterated Greedy Search

algorithm (IGS).

Keywords: Closest String Problem, Hamming distance, Iterated Greedy Search,

Biased Random-Key Genetic Algorithm, Metaheuristics, Optimization.

vi

Lista de Abreviaturas e Siglas

AG Algoritmo Genético

BI do inglês - Best Improvement

BRKGA do inglês - Biased Random Key Genetic Algorithm

BRP do inglês - Bandwidth Reduction Problem

CSP do inglês - Closest String Problem

DBCGA do inglês - Data-Based Coding Genetic Algorithm

DFA do inglês - Distance First Algorithm

DNA Ácido Desoxirribonucléico

DSSP do inglês - Distinguishing String Selection Problem

DSSS do inglês - Distinguishing Substring Selection

EPTAS do inglês - Efficient Polynomial-Time Approximation Scheme

RNA Ácido Ribonucléico

FFMSP do inglês - Far From Most String Problem

FI do inglês - First Improvement

FSP do inglês - Farthest String Problem

IGS do inglês - Iterated Greedy Search

ILP do inglês - Integer Linear Program

ILS do inglês - Iterated Local Search

IP do inglês - Integer-Programming

GRASP do inglês - Greedy Randomized Adaptative Search Procedure

LCS do inglês - Longest Common Subsequence

LCR Lista de Candidatos Restrita

LDDA do inglês - Largest distance decreasing algorithm

vii

LP do inglês - Linear Programming

PCCP Problema da Cadeia de Caracteres Mais Próxima

PTAS do inglês - Polinomial Time Approximation Schemes

PTGS do inglês - Post-Transcriptional Gene Silencing

RKGA do inglês - Random-Key Genetic Algorithm

SA do inglês - Simulated Annealing

VNS do inglês - Variable Neighborhood Search

viii

Sumário

1 Introdução

1.1 Bioinformática . . . . . . .

1.2 DNA . . . . . . . . . . . .

1.3 RNA e Síntese Protéica . . .

1.4 Organização da Dissertação

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

2

4

6

8

2 Uma Revisão Bibliográfica

9

2.1 Revisão bibliográfica do Problema da Cadeia de Caracteres mais Próxima . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 9

2.2 Análise da Revisão Bibliográfica sobre PCCP . . . . . . . . . . . . . 16

3 Caracterização do Problema

3.1 Alguns problemas de comparação e seleção de cadeias . . .

3.2 Closest String Problem (CSP) . . . . . . . . . . . . . . . .

3.3 Farthest String Problem(FSP) . . . . . . . . . . . . . . . .

3.4 Far From Most String Problem(FFMSP) . . . . . . . . . .

3.5 Outros problemas relacionados . . . . . . . . . . . . . . . .

3.5.1 Closest Substring Problem . . . . . . . . . . . . . .

3.5.2 Farthest Substring Problem . . . . . . . . . . . . .

3.5.3 Close to Most String Problem . . . . . . . . . . . .

3.5.4 Distinguishing String Selection Problem (DSSP) . .

3.6 Problema da Cadeia de Caracteres mais Próxima (PCCP)

4 Metodologia de Pesquisa

4.1 Visão Geral . . . . . . . . . . . . . . . . . . .

4.2 Algoritmo MultiStart . . . . . . . . . . . . . .

4.3 Greedy Randomized Adaptive Search Procedure

4.4 Iterated Local Search – ILS . . . . . . . . . . .

4.5 Iterated Greedy Search . . . . . . . . . . . . .

4.6 Heurística IGS-PCCP . . . . . . . . . . . . .

4.7 Algoritmos Genéticos . . . . . . . . . . . . . .

4.8 Random-Key Genetic Algorithm . . . . . . . .

4.9 Biased Random-Key Genetic Algorithm . . . .

4.10 Heurística BRKGA-PCCP . . . . . . . . . . .

ix

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

18

19

20

21

22

23

23

23

24

24

25

.

.

.

.

.

.

.

.

.

.

28

28

28

30

32

33

34

36

38

40

42

5 Experimentos Computacionais

5.1 Instâncias de Teste . . . . . . . . . . . . . . . . . . . .

5.2 Ajustes para a Perturbação k da Heurística IGS-PCCP

5.3 Ajustes para a População da Heurística BRKGA-PCCP

5.4 Comparação entre as heurísticas . . . . . . . . . . . . .

5.5 Comparação entre as heurísticas BRKGA-PCCP e PI .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

44

44

45

46

46

50

6 Considerações Finais

57

Referências

59

x

Lista de Tabelas

1.1

1.2

Aminoácidos de ocorrência natural em proteínas . . . . . . . . . . . .

O código genético (RNAm) . . . . . . . . . . . . . . . . . . . . . . .

2.1

Resultados da literatura. . . . . . . . . . . . . . . . . . . . . . . . . . 17

5.1

5.2

5.3

5.4

5.5

5.6

5.7

5.8

5.9

5.10

5.11

Resultados da perturbação do IGS-PCCP para k = 3%, 10% e 20% .

Resultados da perturbação do IGS-PCCP para k = 30%, 40% e 50% .

Resultados da perturbação do IGS-PCCP para k = 60% e 70% . . . .

Resultados da perturbação do IGS-PCCP para Ω = {20} . . . . . . .

Resultados da perturbação do IGS-PCCP para Ω = {30} . . . . . . .

Resultados das diferentes populações do BRKGA-PCCP . . . . . . .

Resultados das diferentes populações do BRKGA-PCCP para Ω = {20}

Resultados das diferentes populações do BRKGA-PCCP para Ω = {30}

Comparação entre BRKGA-PCCP e IGS-PCCP . . . . . . . . . . . .

Comparação entre BRKGA-PCCP e IGS-PCCP para Ω = {20, 30} . .

Comparação entre BRKGA-PCCP e PI . . . . . . . . . . . . . . . . .

xi

6

8

47

48

49

50

51

52

52

53

54

55

56

Lista de Figuras

1.1

Modelo de fita e bastão de dupla hélice do DNA . . . . . . . . . . . .

4.1

4.2

4.3

4.4

4.5

4.6

4.7

4.8

4.9

4.10

4.11

4.12

Pseudocódigo MultiStart. . . . . . . . . . .

Pseudocódigo da Fase-Construtiva GRASP.

Pseudocódigo da Busca Local GRASP. . . .

Pseudocódigo do Iterated Local Search (ILS).

Ótimos locais IGS . . . . . . . . . . . . . . .

Pseudocódigo da heurística IGS-PCCP. . . .

Estrutura de geração do RKGA . . . . . . .

Geração do RKGA . . . . . . . . . . . . . .

Fim do processo de geração RKGA . . . . .

Crossover BRKGA . . . . . . . . . . . . . .

Transição entre gerações sucessivas (Noronha

Pseudocódigo BRKGA-PCCP . . . . . . . .

xii

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

. . . . . . . .

et al., 2011).

. . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

5

29

31

31

33

34

35

38

39

39

41

42

43

Capítulo 1

Introdução

Em se tratando de Biologia Molecular, pode-se verificar a presença de vários

problemas de otimização combinatória. Geralmente, estes problemas apresentam a

necessidade de se comparar cadeias de caracteres (ou seqüências) de DNA (Ácido

Desoxirribonucléico), RNA (Ácido Ribonucléico) ou proteínas, a fim de encontrar

determinadas características presentes em cada uma delas. Esses problemas possuem

várias aplicações, como busca de regiões conservadas em seqüências não alinhadas,

identificação de drogas genéticas, formulação de sondas genéticas, dentre outras. Por

exemplo, quando se trabalha com Genoma, ou com outra seqüência de aminoácidos,

um dos aspectos principais é como determinar as similaridades e/ ou as diferenças

que ocorrem entre duas seqüências quaisquer.

Segundo Festa (2007), desde 1986 e do surgimento do Projeto Genoma Humano

tem ocorrido um grande crescimento da investigação científica em atividades dedicadas à Biologia Molecular, como o entendimento das interações entre os diversos

sistemas de uma célula, incluindo as interações de DNA, RNA e sínteses protéicas.

Anteriormente a 1980, havia um limite claro entre competências e aplicações da

Biologia Molecular em disciplinas como genética e bioquímica. Em vez disso, nas

duas últimas décadas, as atividades de investigação em Biologia Molecular começaram a ter uma interação com disciplinas de interesses não biológicos, como a Ciência

da Computação e a Física (Festa, 2007).

Com esse interesse de outras áreas em Biologia Molecular, ocorreu um crescimento do leque de novas possibilidades de aplicações. Na Ciências da Computação,

juntamente com a Matemática, a implementação de métodos eficientes para armazenar uma enorme quantidade de dados coletados em experimentos; na Física, um

melhor estudo das moléculas e suas estruturas tridimensionais.

Pesquisadores em Biologia Molecular desenvolveram uma importante representação do DNA, em que a cadeia tridimensional pode ser escrita na forma de cadeias

de caracteres unidimensionais. Essa representação é feita por vetores, que possuem

os seus caracteres representados pelas bases que formam o DNA. Essa representação

facilitou o desenvolvimento computacional nessa área da Biologia.

Com essa nova representação dos caracteres em forma de vetores, facilitou o

surgimento de recursos computacionais para a identificação dos mesmos e sua busca

em bancos de dados.

Esta dissertação trata de um problema conhecido como Problema da Cadeia de

Caracteres mais Próxima (PCCP) – Closest String Problem, que tem como objetivo

1

1.1

Introdução

2

encontrar uma seqüência de caracteres que se aproxime ao máximo, segundo uma

métrica, de todas as seqüências de um banco de dados, que são formados pelos

mesmo caracteres e possuem a mesma dimensão. Os caracteres que compõem estas

seqüências podem ser formados pelas bases do DNA, RNA ou proteínas. Neste

problema, a idéia principal é encontrar uma seqüência centro t que se assemelhe,

ao máximo, às seqüências de um dado conjunto. Ou seja, o objetivo é minimizar a

distância máxima desta cadeia de caracteres t às demais cadeias do conjunto.

Com o objetivo de solucionar o PCCP, serão realizados testes computacionais

utilizando duas heurísticas, a saber, Iterated Greedy Search e Biased Random-Key

Genetic Algorithm. Com o intuito de ajudar pesquisadores em Biologia Molecular a

encontrarem uma seqüência de caracteres semelhante a um conjunto de seqüências

de um banco de dados, formado por seqüências com os mesmos caracteres e mesma

dimensão.

1.1

Bioinformática

Em 1953, a estrutura clássica do DNA foi desvendada no trabalho de Watson

e Crick (1953). Esse e outros trabalhos levaram pesquisadores da área à conclusão

de que o DNA era a molécula que armazenava a informação genética, respondendo

assim aos questionamentos de geneticistas e químicos a respeito da natureza química

do material genético. Uma conseqüência direta destas pesquisas foi o surgimento

de uma nova ciência, a Bioinformática, cujos estudos estavam baseados, principalmente, nos ácidos nucléicos e nas proteínas. Essa nova ciência é permeada por

diversas áreas do conhecimento, como a Engenharia de Software, a Matemática, a

Estatística, a Ciência da Computação e a Biologia Molecular (Pappalardo, 2012).

Os conhecimentos dessas áreas são combinados para processar dados biológicos ou

biomédicos.

Buscando tratar os dados, foi necessário desenvolver softwares para, por exemplo identificar genes, prever a configuração tridimensional de proteínas, identificar

inibidores de enzimas, organizar e relacionar informação biológica, simular células, agrupar proteínas homólogas, montar árvores filogenéticas, comparar múltiplas

comunidades microbianas por construção de bibliotecas genômicas, analisar experimentos de expressão gênica, dentre outras inúmeras aplicações.

A Bioinformática implica a manipulação, busca e extração de informações dos dados de seqüências do DNA, RNA ou Proteínas. O desenvolvimento de técnicas para

armazenamento e busca por seqüências de DNA gerou avanços no desenvolvimento

de softwares para computadores, com muitas aplicações, especialmente algoritmos

de busca de frases. A busca de frases ou algoritmos de coincidências procura a

ocorrência de uma seqüência de letras (ou caracteres) dentro de uma seqüência de

caracteres maior, e até seqüências que sejam distintas de um determinado grupo, o

qual foi desenvolvido para buscar seqüências específicas de nucleotídeos.

Com o desenvolvimento e as pesquisas em Bioinformática, surgiram métodos

de sequenciamento dos polímeros citados acima, principalmente do DNA. A partir do surgimento desses métodos, bilhões dessas seqüências já foram e têm sido

catalogadas e armazenadas em bancos de dados públicos. O surgimento dos seqüenciadores automáticos de DNA, a partir da segunda metade da década de 1990, elevou

1.1

Introdução

3

abruptamente a quantidade de seqüências a serem armazenadas, surgindo também

a necessidade de análise desses dados. Esse novo panorama trouxe a necessidade da

utilização de plataformas computacionais capazes de interpretar, com eficiência, os

resultados obtidos.

O trabalho de Lesk (2008) destaca os bancos de dados da Biologia Molecular,

os quais contém seqüências de ácidos nucléicos e de proteínas, estruturas e funções de macromoléculas, padrões de expressão, redes de vias metabólicas e cascatas

de regulação. Segundo o autor, o arquivamento mundial de seqüências de ácidos

nucléicos é uma parceria tríplice entre o Genbank, situado no US National Center

for Biotechnology Information (NCBI), em Bethesda, Maryland, Estados Unidos; o

EMBL Nucleotide Sequence Database, localizado no European Bioinformatics Institute (EBI), em Hinxton, no Reino Unido; e o The Center for Information Biology e

DNA Data Bank of Japan, no National Institute of Genetics, em Mishima, Japão.

Há uma troca de informações entre esses grupos diariamente. Como resultado, os

dados brutos são idênticos, embora o formato em que são armazenados e a natureza

da anotação podem variar entre eles. Esses bancos de dados organizam, arquivam

e distribuem seqüências de DNA e RNA coletados de projetos genoma, publicações científicas e depósitos de patentes. Para garantir que esses dados fundamentais

permaneçam disponíveis livremente, as revistas científicas exigem o depósito de novas seqüências de nucleotídeos em um banco de dados como uma condição para a

publicação de artigos científicos.

Já em 2002, três bancos de dados de proteínas:

• Protein Information Resource (PIR), o qual trata-se de um banco de dados

de seqüências de proteínas, que foi iniciado no National Biomedical Research

Foundation (NBRF) no início do ano de 1960, localizado na Georgetown University Medical Center em Washington, DC, Estados Unidos;

• SWISS-PROT e o TrEMBL, o Swiss Institute of Bioinformatics, localizado

em Genebra; e

• European Bioinformatics Institute (EBI)

coordenaram seus esforços para formar o consórcio UniProt. Os parceiros dessa

iniciativa compartilham os bancos de dados, mas continuam a oferecer ferramentas

separadas de acesso à recuperação de informação.

De acordo com Lesk (2008), o PIR originou-se do primeiro banco de dados de

seqüências, desenvolvido por Margaret O. Dayhoff - a pioneira da área de Bioinformática. O SWISS-PROT foi desenvolvido no Swiss Institute of Bioinformatics. O

TrEMBL contém as traduções dos genes identificados nas seqüências de DNA do

EMBL Data Library. Entradas do TrEMBL são consideradas como preliminares, e

são convertidas, após organização e anotações extensas, em entradas completas do

SWISS-PROT.

Muitos projetos de sequenciamento de genomas completos mantém bancos de dados focalizados em espécies individuais. Exemplos notáveis são o ENSEMBL (Sanger

Centre, Hinxton, Reino Unido) e os navegadores da Universidade da Califórnia, em

Santa Cruz, Estados Unidos, para o genoma humano e outras espécies.

Muitos bancos de dados secundários agrupam famílias de proteínas ou subunidades com base nas similaridades entre suas seqüências. Um banco de dados

1.2

Introdução

4

“guarda-chuva”, o Interpro, é um banco de dados de famílias de proteínas, domínios

e sítios funcionais, no qual características identificáveis encontradas em proteínas

conhecidas podem ser aplicadas em seqüências de proteínas desconhecidas. Além

disso, contém conexões para outros bancos, incluindo a classificação funcional do

Gene Ontology Consortium T M .

Considerada uma recente subdivisão da Biotecnologia, a Bioinformática representa o “casamento” da Biotecnologia com a Informática. De modo simples, Bioinformática consiste no depósito e análise de seqüências genéticas em bancos de dados

e conseqüente manipulação e análise destas seqüências com a utilização de software específicos. Portanto, essa nova área surge a partir da necessidade de aplicar

recursos computacionais no armazenamento, manipulação, interpretação e análise

dos resultados obtidos das plataformas computacionais a respeito das seqüências de

polímeros.

Segundo Prosdocimi et al. (2002), a diversidade na formação dos profissionais que

atuam nas pesquisas em Biotecnologia é um fator dificultante na comunicação entre

esses profissionais. Para resolver esta questão, surge o Bioinformata, um profissional

cuja formação permite fazer uma ponte entre a Biologia e a Informática, capaz

de conhecer os problemas biológicos reais, e apto a desenvolver uma abordagem

computacional ajustada e viável para esses problemas. Assim, o Bioinformata, além

de saber utilizar programas produzidos por outros programadores, deve também ser

capaz de produzir seus próprios programas, para lidar com problemas típicos da

Bioinformática.

1.2

DNA

Segundo da Fonseca (2003), no final do Séc. XIX, o monge augustiniano Gregor

Mendel, realizando experimentos com ervilhas, estabeleceu a existência de estruturas

biológicas denominadas genes, que seriam responsáveis pela expressão e transmissão

de características hereditárias nos indivíduos. O trabalho de Mendel deu origem

ao ramo da Biologia atualmente conhecido como Genética. Até 1944, acreditava-se

que o material genético estava contido em proteínas no interior das células, até que

Oswald Avery, Maclyn McCarty e Colin McLeod (Avery et al., 1944) demonstraram

que, na verdade, a molécula de DNA é o principal carregador do código genético dos

organismos vivos.

O ácido desoxiribonucléico, ou DNA, é uma macromolécula constituída a partir de estruturas menores, denominadas nucleotídeos. Cada nucleotídeo, por sua

vez, é formado por uma molécula de açúcar (desoxiribose), um grupo fosfato e uma

base nitrogenada que o identifica. Moléculas de DNA são cadeias longas, contendo

uma mensagem composta por um alfabeto de quatro letras, na forma {A, C, G, T },

representando as quatro bases nitrogenadas desta molécula, denominadas, respectivamente, Adenina (A), Guanina (G), Citosina (C) e Timina (T). Mesmo para

microrganismos, a mensagem é longa, tipicamente com 106 caracteres. Em 1953,

Watson e Crick (1953) deduziram a estrutura tridimensional da molécula do DNA

e, a partir de então, seu processo de replicação.

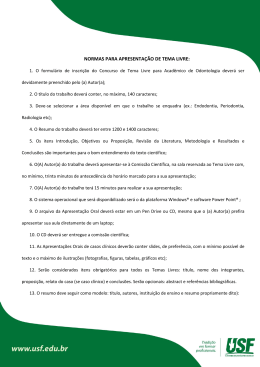

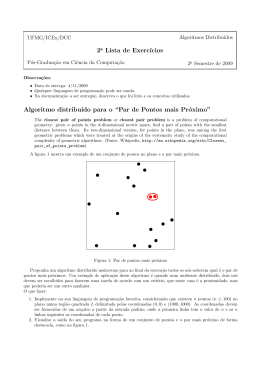

O DNA possui a forma de um helicóide duplo (ver Figura 1.1). Cada uma

das fitas helicoidais representa uma seqüência de nucleotídeos. As duas fitas são

1.3

Introdução

5

mantidas juntas através de ligações químicas conhecidas como pontes de hidrogênio,

sendo que, no caso do DNA, essas ligações obedecem a uma certa regra: as chamadas

bases púricas (A e G) dos nucleotídeos de uma fita são unidas às chamadas bases

pirimídicas (T e C) da outra fita, e vice-versa, formando os chamados pares de base.

Mais precisamente, a Adenina de uma fita sempre se emparelha com uma Timina

da outra fita, e reciprocamente, ao passo que a Guanina de uma fita sempre se

emparelha com uma Citosina da outra, e reciprocamente. Como conseqüência dessa

regra de formação, as fitas na molécula do DNA, embora não sejam idênticas, são

complementares, no sentido que uma determina a outra univocamente. Além disso,

essas fitas possuem uma orientação ditada pelo número do átomo de carbono da

molécula de açúcar na qual um nucleotídeo se liga ao outro. A orientação positiva é,

convencionalmente, denominada orientação 5′ − 3′ , indicando que um nucleotídeo se

liga ao anterior a ele na fita pelo carbono de número 5 e, ao posterior, pelo carbono

de número 3. As orientação das fitas complementares são reversas entre si.

Figura 1.1: Modelo de fita e bastão de dupla hélice do DNA. (Pasternak, 2002).

Um gene pode ser visto como um trecho ou região da molécula de DNA responsável pela codificação e expressão de alguma característica física do indivíduo, o que

corresponde, geralmente, à informação necessária para a síntese de uma determinada

proteína. De acordo com da Fonseca (2003), o DNA não é composto totalmente por

genes, muito pelo contrário, apenas entre 2% e 3% do DNA humano é constituído

por genes. Os restantes, aproximadamente 97% a 98%, do DNA, correspondem a

agrupamentos de proteínas, que não contém nenhuma informação.

As moléculas de DNA, em geral, estão dentro de um cromossomo, que é uma

estrutura que reside no interior das células (especificamente no núcleo, no caso dos

eucariontes). O número de cromossomos varia de espécie para espécie. As informações correspondentes ao DNA, de todos os cromossomos de uma determinada

espécie, compõem aquilo que se denomina o genoma da espécie. O genoma humano,

por exemplo, possui cerca de 3, 3 × 109 pb, ou seja, mais de três bilhões de pares de

base.

1.3

Introdução

1.3

6

RNA e Síntese Protéica

Proteínas são polímeros constituídos de moléculas menores (monômeros), denominadas aminoácidos, unidas entre si através das chamadas ligações peptídicas. A

implementação da informação genética ocorre inicialmente com a síntese de DNA e

proteínas. As proteínas são as moléculas responsáveis pela maior parte da estrutura

e atividade dos organismos, como tecidos, órgãos dos indivíduos e também agem

como hormônios, enzimas digestivas, etc. A principal atividade celular na qual o

DNA está envolvido é justamente a síntese protéica. Além do DNA, o ácido ribonucléico ou RNA, que é um outro tipo de ácido nucléico, também desempenha um

papel fundamental na síntese protéica.

Para que as células possam produzir suas proteínas, elas precisam de aminoácidos, que podem ser obtidos a partir da alimentação ou serem fabricados pelo próprio

organismo. Tipicamente, proteínas são compostas de 200 a 400 aminoácidos de proteínas. A Tabela 1.1 a seguir mostra os aminoácidos de ocorrência natural nas

proteínas.

Tabela 1.1: Aminoácidos de ocorrência natural em proteínas

Item

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

17

19

20

Nome

Glicina ou Glicocola

Alanina

Leucina

Valina

Isoleucina

Prolina

Fenilalanina

Serina

Treonina

Cisteina

Tirosina

Asparagina

Glutamina

Aspartato ou

Ácido aspártico

Glutamato ou

Ácido glutâmico

Arginina

Lisina

Histidina

Triptofano

Metionina

Abreviação

Gly ou Gli

Ala

Leu

Val

Ile

Pro

Phe ou Fen

Ser

Thr ou The

Cys ou Cis

Tyr ou Tir

Asn

Gln

Asp

Símbolo

G

A

L

V

I

P

F

S

T

C

Y

N

Q

D

Glu

E

Arg

Lys ou Lis

His

Trp ou Tri

Met

R

K

H

W

M

De acordo com Lesk (2008), o RNA, assim como o DNA, é constituído de nucleotídeos, sendo a Timina (T) substituída pela Uracila (U). Entretanto, ao contrário

do DNA, o RNA é formado por uma única fita e apresenta uma conformação tridimensional bem mais variada do que a dupla hélice do DNA, podendo se dividir em

três tipos:

• RNA mensageiro (RNAm): responsável por levar a informação do DNA do

núcleo até o citoplasma;

1.3

Introdução

7

• RNA transportador (RNAt): responsável por transportar os aminoácidos que

serão utilizados na formação das proteínas até os ribossomos; e

• RNA ribossômico (RNAr): faz parte da constituição dos ribossomos.

O processo de síntese de proteínas que ocorre no interior das células é formado,

essencialmente, por duas etapas, denominadas transcrição e tradução. Na transcrição, a partir de um gene, a síntese protéica se inicia com a produção de um tipo

de RNA, conhecido como RNA mensageiro ou RNAm. O processo de produção do

RNAm ocorre, a grosso modo, da seguinte forma: o aparato celular reconhece o

início de um gene a partir de alguns sinais, como seqüências específicas de nucleotídeos, que ocorrem nas chamadas regiões promotoras, que se estendem por algumas

dezenas de pares de base antes do início dos genes. Uma enzima, denominada RNA

polimerase, fixa-se ao DNA em pontos específicos da região promotora, conhecidos

como sítios de ligação, provocando uma ruptura localizada entre as suas duas fitas

constituintes. A partir de então, a RNA polimerase desliza sobre uma das fitas do

DNA gênico, no sentido 3′ − 5′ (a cada três ligações), percorrendo cada desoxiribonucleotídeo (C, G, T ou A) e fazendo com que ribonucleotídeos complementares

(respectivamente G, C, A ou U) sejam acrescentados à molécula de RNAm que,

assim, vai se formando ao longo do caminho, no sentido 5′ − 3′ . Ao final do gene,

também reconhecido pela RNA polimerase por um sinal específico, algumas dezenas

de ribonucleotídeos {A} são acrescentados ao RNAm, constituindo a chamada cauda

poli -A, e a RNA polimerase desliga-se do DNA, que é então reconstituído.

Nos seres procariontes, dentre os quais incluem-se formas de vida primitivas como

as bactérias e algas cianofíceas, o RNAm assim produzido já pode ser utilizado para

a síntese de uma determinada proteína. Já nos seres denominados eucariontes, que

são organismos pluricelulares com núcleo celular distinto, dentre os quais incluemse a maioria dos organismos superiores como as plantas e animais, os genes são

extratificados em trechos que contribuem para a síntese protéica, chamados éxons,

intercalados por trechos não codificantes, denominadas íntrons. Portanto, nos eucariontes, o RNAm recém-produzido a partir de um gene da maneira acima descrita

ainda não está completamente maduro, sendo ainda submetido a um processo denominado splicing, no qual, através da ação de um complexo de enzimas, os trechos

correspondentes aos íntrons são removidos da molécula, permanecendo apenas os

trechos codificantes.

Já na tradução, uma vez maduro, o RNAm abandona o núcleo celular, nos eucariontes, e migra para o citoplasma, que é um líquido fora do núcleo, mas no interior da

célula. De acordo com Lesk (2008), a tradução do RNAm em uma proteína é feita,

no interior de organelas celulares denominadas ribossomos, com o auxílio de um

tipo de RNA conhecido como RNA transportador (RNAt), da seguinte forma: cada

tripla ordenada de nucleotídeos consecutivos, como por exmplo {UAC}, ao longo

do RNAm, constitui aquilo que é denominado como códon. Cada códon responde

pela codificação de um determinado aminoácido, no caso do exemplo a Tirosina

(Tyr), conforme disposto na Tabela 1.2. As moléculas de RNAt são, geralmente,

pequenas, tendo cerca de 80 resíduos, e possuem uma região com grande afinidade

a um determinado códon, denominada anti-códon, e uma outra extremidade ligada

a um determinado aminoácido correspondente ao códon afim, de acordo com código

genético da Tabela 1.2. À medida em que o RNAm vai passando pelo ribossomo,

1.4

Introdução

8

um RNAt correspondente a cada um dos sucessivos códons acopla-se ao RNAm,

trazendo consigo o aminoácido equivalente ao códon em questão. Através da ação

de determinadas enzimas, esse aminoácido desprende-se do RNAt e une-se à cadeia

polipeptídica que, assim, vai sendo progressivamente formada. A tradução é finalizada assim que um stop códon é detectado, ou seja, a cada tripla ordenada de

nucleotídeos consecutivos do tipo {UAA, UGA, UAG}. Veja a Tabela 1.2.

Tabela 1.2: O código genético (RNAm)

1a posição

(extr. 5’)

U

C

A

G

2a posição (meio)

U

Phe (F)

Phe (F)

Leu (L)

Leu (L)

Leu (L)

Leu (L)

Leu (L)

Leu (L)

Ile (I)

Ile (I)

Ile (I)

Met (M)

Val (V)

Val (V)

Val (V)

Val (V)

C

Ser (S)

Ser (S)

Ser (S)

Ser (S)

Pro (P)

Pro (P)

Pro (P)

Pro (P)

Thr (T)

Thr (T)

Thr (T)

Thr (T)

Ala (A)

Ala (A)

Ala (A)

Ala (A)

A

Tyr (Y)

Tyr (Y)

STOP

STOP

His (H)

His (H)

Gln (Q)

Gln (Q)

Asn (N)

Asn (N)

Lys (K)

Lys (K)

Asp (D)

Asp (D)

Glu (E)

Glu (E)

3a posição

(extr. 3’)

G

Cys (C)

Cys (C)

STOP

Trp (W)

Arg (R)

Arg (R)

Arg (R)

Arg (R)

Ser (S)

Ser (S)

Arg (R)

Arg (R)

Gly (G)

Gly (G)

Gly (G)

Gly (G)

U

C

A

G

U

C

A

G

U

C

A

G

U

C

A

G

Repare que esse código é degenerado, uma vez que os 64 (43 ) possíveis códons

originam apenas 20 aminoácidos, sendo que cada aminoácido possui um código de

três letras e um outro código de uma letra apenas.

1.4

Organização da Dissertação

Após ter introduzido, no presente capítulo, conceitos básicos relativos as áreas

da Biologia relevantes à presente dissertação, que são de fundamental aplicação

neste trabalho, no Capítulo 2 será feito uma revisão bibliográfica, apresentando as

heurísticas mais utilizadas e problemas relacionados a sequência de caracteres e o

PCCP. No Capítulo 3, são abordados problemas relacionados ao PCCP e suas variações, com suas respectivas formulações, bem como o próprio Problema da Cadeia

de Caracteres mais Próxima, com seu conjunto de formulações e suas aplicações.

O Capítulo 4 mostra métodos heurísticos da literatura utilizados para solucionar

o PCCP e as metaheurísticas Iterated Greedy Search e Biased Random-Key Genetic Algorithm, implementadas nesta dissertação para resolvê-lo. No Capítulo 5, são

apresentadas as instâncias utilizadas para os devidos experimentos computacionais,

bem como os resultados dos testes. Por fim, as conclusões e considerações finais são

apresentadas no Capítulo 6.

Capítulo 2

Uma Revisão Bibliográfica

Neste capítulo serão descritos alguns dos trabalhos extraídos da literatura que

estão relacionados com o Problema da Cadeia de Caracteres mais Próxima (PCCP),

contendo os principais objetivos abordados, aplicações e métodos empregados para

resolver problemas de otimização em sequenciamento de cadeias de caracteres e suas

variações, como encontrar subseqüências de caracteres comuns a uma determinada

seqüência, determinar a presença de motifs em seqüências de DNA, RNA ou em

proteínas.

Para medir as similaridades ou diferenças entre duas seqüências de caracteres,

a maioria dos trabalhos citados abaixo utiliza a distância de Hamming, que é dada

pela soma das diferenças dos caracteres de mesma posição entre duas seqüências.

2.1

Revisão bibliográfica do Problema da Cadeia de

Caracteres mais Próxima

Ben-Dor et al. (1997) utiliza a palavra consenso para definir os caracteres de

uma seqüência. Utiliza Otimização Inteira para modelar o Problema da Cadeia de

Caracteres mais Próxima (PCCP) e usa um algoritmo de aproximação com base em

arredondamento randomizado, com razão de performance próxima do valor ótimo

para d, suficientemente grande, sendo d a maior distância a ser minimizada. Ele

também retrata em seu trabalho o Distinguishing String Selection Problem (DSSP).

Gasieniec et al. (1999) fornece um algoritmo de aproximação de tempo polinomial

para a solução do problema denominado Hamming Center Problem, que possui a

finalidade de encontrar uma cadeia de caracteres, construídas a partir de um alfabeto

binário, que minimize a distância de Hamming entre essa cadeia e as demais do

conjunto dado, as quais são constituídas do mesmo alfabeto e mesma dimensão.

Trabalhando com os problemas Closest String problem e Closest Substring Problem, Li et al. (2002) utiliza algoritmos de aproximação de tempo polinomial para a

solução dos problemas da seqüência mais próxima e da subseqüência mais próxima.

Algumas formulações para o problema foram baseadas no trabalho de Ben-Dor et al.

(1997), e o autor também fez uso do mesmo tipo de algoritmo utilizado no trabalho

de Gasieniec et al. (1999), para resolver o Hamming Center Problem.

Os três problemas estudados no trabalho de Deng et al. (2002) envolvem a busca

de um padrão que, com alguns erros, ocorre em um conjunto de seqüências (o Closest

9

2.1

Revisão bibliográfica do PCCP

10

String Problem), não ocorre em outro conjunto (o Farthest String Problem), ou em

ambos (o Distinguishing String Problem), e faz uso da distância de Hamming para

avaliar a proximidade entre seqüências. Segundo o autor, o seu trabalho tem diferentes tipos de objetivos e encontra aplicações em várias áreas, como a Genética, a

Correspondência de Padrões e a Teoria de Códigos. Neste trabalho é proposta, para

a solução dos problemas citados, uma formulação via algoritmos de aproximação em

tempo polinomial (Polinomial Time Approximation Schemes - PTAS).

Ecker et al. (2002) apresentou um modelo de otimização não-linear para encontrar locais de ligação a proteínas em cadeias de DNA. Foram utilizadas instâncias

de tamanho moderados, formadas pelas cadeias do DNA. Em seu trabalho, usou a

abordagem de probabilidade máxima para encontrar a melhor cadeia que se ajuste

aos dados de seqüência, maximizando a probabilidade das seqüências observadas.

Lanctot et al. (2003), além dos três problemas de seleção de cadeias que Festa

(2007) retrata em seu trabalho, aborda mais quatro problemas. São eles: Closest

Substring Problem, Farthest Substring Problem, Close to Most String Problem, Distinguishing String Selection Problem. A fim de solucionar estes problemas, o autor

propõe técnicas de relaxamento de otimização linear, algoritmos de aproximação e

um algoritmo heurístico. Para o Closest Substring Problem, foi utilizado um algo4

ritmo de aproximação com garantia de desempenho ( + ǫ), com valores pequenos

3

para ǫ > 0, bem como algumas formulações do trabalho de Ben-Dor et al. (1997)

para calcular a distância de Hamming e um método simples de relaxamento linear,

mostrando assim resultados eficientes.

O termo motifs foi relacionado no trabalho de da Fonseca (2003) para identificar

as subseqüências de caracteres, utilizando, como alfabeto, as bases nitrogenadas do

DNA. Em se tratando de Biologia Molecular Computacional, esses motifs representam, em geral, regiões altamente conservadas, isto é, pouco afetadas por mutações,

que desempenham funções biológicas específicas. Esse problema de localização de

motifs limita-se com o Problema do Casamento de Padrões e pode ser abordado

através das mesmas técnicas. O autor faz uso de algoritmos combinatórios exatos e

técnicas para encontrar as similaridades entre as seqüências baseadas na distância

de Hamming e na distância de Levenshtein, a qual é definida como o número mínimo de caracteres para substituir, inserir ou apagar, de modo a transformar uma

seqüência o mais próximo da outra.

Mauch H (2003) fez o uso de Algoritmos Genéticos com modificações, definindo

um novo algoritmo chamado GA Run, com o objetivo de solucionar problemas relacionados ao Problema da Cadeia de Caracteres mais Próxima (PCCP), tendo destaque

os problemas de sequenciamento com Post-Transcriptional Gene Silencing (PTGS)

ou RNA interference (RNAi).

No trabalho de Meneses et al. (2004) foi estudado o Problema da Cadeia de

Caracteres mais Próxima (PCCP). Os autores desenvolveram três formulações de

Otimização Inteira, mostrando que a terceira formulação, baseada nos trabalhos de

Ben-Dor et al. (1997) e Li et al. (2002), é a mais eficiente. Desenvolveram uma

heurística com o objetivo de estabelecer limites superiores para os valores ótimos

do PCCP, tornando mais rápida a aplicação do algoritmo branch-and-bound, que foi

usado com as técnicas de relaxamento da terceira formulação.

São utilizadas, três classes de instâncias, com dimensões variadas, para n =

2.1

Revisão bibliográfica do PCCP

11

{10, 15, 20, 25, 30} e m = {300, 400, 500, 600, 700, 800}, no trabalho de Meneses et al.

(2004). A primeira classe tem como alfabeto o conjunto {0, 1}; a segunda utiliza

um alfabeto de quatro caracteres; a terceira utiliza um alfabeto de 20 caracteres

(representando as seqüências de proteínas). Todas essas instâncias foram geradas

aleatoriamente, exceto 6 conjuntos de instâncias, que foram retiradas do trabalho

de McClure et al. (1994).

Os resultados computacionais se mostraram bastante interessantes, e foram comparados com a mesma formulação de Otimização Inteira, porém utilizando relaxamento linear no lugar do branch-and-bound. Para as instâncias com o alfabeto de 20

caracteres, os resultados foram mais significantes, na maioria dos casos conseguindo

alcançar soluções próximas do ótimo em menos de 1 minuto.

Quatro diferentes algoritmos heurísticos de construção e busca local para o Greedy Randomized Adaptive Search Procedures (GRASP) são apresentados por Pinto

et al. (2006). Além desses procedimentos, foram propostas duas estratégias de busca

intensiva, usando os conceitos de First Improvement (FI) e Best Improvement (BI).

A construção GRASP é a mesma para os quatro algoritmos, que se diferenciam na

busca local, uma determinística e outra aleatória, e nas estratégias de busca. O

número máximo de iterações GRASP foi de {n, 5n, 10n}, em que n é a dimensão de

cada seqüência, e os valores escolhidos para α = {0.1; 0.2; ...; 0.9}. Com o objetivo

de resolver o Problema da Cadeia de Caracteres mais Próxima (PCCP), o alfabeto

utilizado foi de 4 caracteres, com n = {300, 400, 500, 700} e m = {10, 15, 20, 25, 30}

(m é número de seqüências em cada conjunto), sendo que as instâncias testadas

foram retiradas do trabalho de Meneses et al. (2004). Cada instância foi executada cinco vezes. Destas cinco execuções foram calculadas as médias e os mínimos

das soluções xi encontradas. A partir daí, foram calculados os Gaps em relação às

soluções ótimas s∗ da seguinte forma:

P5

1

(

i=1 f (xi ))

Gapmédio = 5

− f (s∗ )

(2.1)

∗

f (s )

Gapmínimo =

min{f (xi ); i = 1, . . . , 5} − f (s∗ )

f (s∗ )

(2.2)

O termo Gap se refere à distância entre o valor procurado e os valores obtidos nos

testes. Os resultados obtidos pelos algoritmos implicaram melhorias na qualidade

das soluções, obtendo valores do Gap inferiores em relação aos encontrados por

Meneses et al. (2004).

Gramm et al. (2006) trata do problema Distinguishing Substring Selection (DSSS),

separando o conjunto de seqüências em duas partes, um conjunto de “boas” seqüências e outro de seqüências “ruins”, respeitando a métrica de Hamming. Foi apresentado um algoritmo exato de parâmetro-fixo para resolver o DSSS de forma eficiente,

baseando em algumas técnicas utilizadas por Lanctot et al. (2003) para resolver

um problema semelhante. O autor adaptou o algoritmo para a seqüência mais próxima ajudar a solucionar o DSSS. Foi mostrado que algoritmos utilizando Efficient

Polynomial-Time Approximation Scheme (EPTAS) não resultam em um boa solução para o DSSS.

Festa (2007) destaca que um dos problemas fundamentais em Biologia Molecular consiste em comparar seqüências genômicas em indivíduos de diferentes espécies,

2.1

Revisão bibliográfica do PCCP

12

determinando sua similaridade ou distância. Neste trabalho foi feita uma descrição

detalhada de problemas biológicos formulados como problemas de otimização combinatória. Uma nova heurística é proposta, com a finalidade de encontrar boas

soluções para uma classe particular desses problemas, conhecida como Far From

Most String Problem (FFMSP), dando uma ênfase especial à formulação matemática e a métodos eficientes de programação matemática, aplicados para resolvê-los.

Em seu trabalho, Festa (2007) ainda descreve outros dois problemas, o Closest String

Problem (CSP) e o Farthest String Problem (FSP).

Para solucionar o FFMSP, a autora implementou a heurística GRASP, escolhendo, de forma aleatória, os dois melhores candidatos para compor a Lista de

Candidatos Restrita (LCR). Para a busca local, o algoritmo 2-exchange, proposto

por Meneses et al. (2004), foi utilizado. As instâncias testadas foram comparadas com os resultados de Meneses et al. (2004), com n = {100, 150, 200} e m =

{300, 400, 500, 600, 800}. Os resultados obtidos com os testes foram as melhorias

das soluções ótimas acima de 10%.

Um algoritmo paralelo Multistart foi proposto por Gomes et al. (2008), para solucionar o Closest String Problem (CSP). O autor faz uso de uma heurística paralela,

combinando um algoritmo de aproximação com estratégias de busca local. O algoritmo 2-approximation, proposto no trabalho de Meneses et al. (2005), foi utilizado,

tendo algumas modificações nas estratégias de busca local, a qual usa vários processadores em uma máquina paralela. O autor ainda destaca o uso de uma matriz

de dimensão n para calcular mais rapidamente a distância de Hamming. Os testes

foram feitos com 20 processadores e comparados com um algoritmo exato, tendo o

objetivo de avaliar apenas as distâncias de Hamming encontradas e não o tempo

gasto no processamento. Algumas instâncias foram retiradas dos experimentos de

McClure et al. (1994) e do banco de dados GenBank. Uma parte das instâncias,

formadas pelo alfabeto Σ = {A, C, G, T }, era composta por 72% de seus caracteres

{C, G}. Foram realizados também testes com o alfabeto de 2, 4 e 20 caracteres.

Construindo um novo método para resolver o PCCP, Chen (2009) aplicou a

técnica Iterative Rounding, que foi empregada com sucesso no trabalho de Jain

(2001), auxiliando um algoritmo de aproximação para solucionar um problema de

redes de Steiner, considerado também um problema NP-Difícil. Utilizando uma

formulação com base em Otimização Inteira e aplicando técnicas de relaxamento

linear, o autor construiu um algoritmo mais ganancioso para solucionar o PCCP.

Os testes foram realizados com o conjunto de instâncias de McClure et al. (1994)

para um alfabeto de 4 caracteres. Os resultados foram comparados com os obtidos

pelo algoritmo Branch-and-Bound de Meneses et al. (2004). O algoritmo testado se

mostrou mais rápido com relação ao Branch-and-Bound, com soluções iguais ou em

alguns casos muito próximas.

Em um trabalho mais recente, Ma e Sun (2009) propuseram um método de

aproximação denominada Polinomial Time Approximation Schemes (PTAS), cuja

−2

complexidade é O(no(ǫ ) ). Este método, segundo os autores, é formulado para os

problemas Closest String Problem (CSP) e Closest Substring Problem, que tratam

da busca de uma seqüência ou subseqüência que seja similar, ao máximo, a uma

seqüência de um conjunto de cadeias dado. Os trabalhos que utilizam algoritmos

baseados em heurísticas, como aqueles encontrados nos estudos de Liu et al. (2005),

Mauch H (2003) e Meneses et al. (2004), não apresentam nenhuma garantia de

2.1

Revisão bibliográfica do PCCP

13

desempenho, mas, em contrapartida, os métodos de aproximação, desenvolvidos até

então, sacrificam a qualidade da solução em função da obtenção de um algoritmo

cujo tempo computacional seja polinomial. O autor desenvolveu também algoritmos

de parâmetros fixos, cuja complexidade é O(n|Σ|o(d) ), em que o raio d é o parâmetro

e Σ é o alfabeto. Como resultado, tem-se um algoritmo de tempo polinomial para

d = O(logn) e Σ de tamanho constante.

Faro e Pappalardo (2010) propuseram um novo algoritmo, chamado Ant-CSP,

com base no algoritmo Colônia de Formigas. Para avaliar o seu efeito e robustez, foi

comparado com dois outros algoritmos para o PCCP, um com base em Simulated

Annealing (SA), chamado de SA-CSP, e o outro em Algoritmo Genético (AG),

denominado GA-CSP, ambos utilizados por Liu et al. (2005) em seu trabalho. As

instâncias para os testes foram geradas aleatoriamente para um alfabeto Σ = 4, com

n = {10, 20, 30, 40, 50} e m = {10, 20, ..., 50} ∪ {100, 200, ..., 1000}. Os resultados

experimentais mostram que o algoritmo Ant-CSP proposto neste trabalho calcula

quase sempre melhores soluções e é muito mais rápido do que os algoritmos SA e

AG, independentemente do número e do comprimento de seqüências de entrada. Em

particular, para instâncias pequenas com 10 ≤ n ≤ 50, o algoritmo Ant-CSP é de 5

a 36 vezes mais rápido em relação ao GA-CSP.

Um novo método de aproximação é apresentado no trabalho de Chen et al.

(2010), denominado 3-string approach. Essa aproximação é utilizada pelos autores

para desenvolver novos algoritmos parametrizados para o PCCP. Os autores ainda

destacam uma vantagem entre esse método e aqueles desenvolvidos em trabalhos

anteriores, que utilizavam a técnica de 2-string approach (Chen (2009)). Segundo

os autores, intuitivamente esse novo método é melhor que os anteriores, pois, selecionando cuidadosamente três strings de entrada, ao invés de duas, o algoritmo

pode visitar uma porção maior da solução de saída. Segundo Chen et al. (2010), há

um ganho na complexidade dos algoritmos desenvolvidos com 3-string approach em

relação àqueles baseados em duas cadeias.

Trabalhando com dois tipos de problemas, Closest String Problem (CSP) e Closest Substring Problem (CSSP), Chimani et al. (2011) apresentou formulações em

otimização linear inteira para solucionar esses dois problemas. Para o CSSP, é

apresentada uma nova formulação, chamada de Polytope-Wise, superior à CSP,

pois evita suas extensões de formulação. Para os testes, foram utilizadas instâncias reais da Biologia e instâncias geradas aleatoriamente. Com dimensões de

K = {10, 20, 30, 40, 50}, que representam o número de seqüências em cada conjunto, n = {250, 500, 750, 1000, 2000, 5000, 10000}, que representam a dimensão de

cada seqüência, e com o alfabeto Σ = {2, 4, 20}. Os resultados foram comparados

com os trabalhos de Faro e Pappalardo (2010), Meneses et al. (2004) e Gomes et al.

(2008). Os experimentos mostraram que, para o problema CSP, seu tempo de execução foi muito satisfatório, e, mesmo para instâncias aleatórias, teve uma solução

perto da ótima.

No trabalho de Liu et al. (2011), foi apresentado um algoritmo exato, chamado

Distance First Algorithm (DFA), para solucionar problemas de CSP. Os autores

fizeram uma análise teórica para demonstrar que DFA consegue encontrar soluções

ótimas para um conjunto de três seqüências com alfabeto de tamanho dois. O mesmo

problema foi relatado também por Gramm et al. (2001), construindo o algoritmo

3-strings para solucionar este caso especial do CSP. Para os casos gerais do CSP, foi

2.1

Revisão bibliográfica do PCCP

14

projetado uma heurística polinomial, chamada LDDA-LSS, que é uma combinação

do algoritmo LDDA, proposto por Liu et al. (2004), com estratégias de busca local.

Essas estratégias são adaptadas dos trabalhos de Meneses et al. (2004) e Gomes

et al. (2008). Diferente destes autores, Liu et al. (2011) descreve como encontrar o

parâmetro N utilizado para definir o número de iterações do algoritmo.

Estas estratégias de busca local funcionam da seguinte forma: seja um conjunto

de seqüências S = {s1 , ..., sn }, com n seqüências de dimensões m. Então, seja t

a solução corrente e sindex uma string em S, tal que dH (si , t) é a maior distância

encontrada no conjunto, em que i = {1, 2, ..., n}. Então, para k = {1, 2, ..., m}, se

sindex

6= tk e substituindo tk por sindex

não faz a solução piorar, a substituição é feita

k

k

e a distância de Hamming entre t e todas as strings em S é computada. Depois de

verificar todas a m posições, uma nova string t é produzida e o processo se repete.

Os autores definem o número de iterações da seguinte forma:

N = m.|A|.b − rep

em que m é a dimensão da string, A é o tamanho do alfabeto e b−rep é pré-definido.

Depois de alguns testes experimentais, Liu et al. (2011) definiu b − rep = 0, 5,

para grandes instâncias com um alfabeto de 20 caracteres, e b − rep = 2, para os

demais casos. Para os devidos testes, os autores utilizaram dados biológicos reais e

simulados, sendo seis instâncias de alfabeto com 20 caracteres do conjunto de dados

do trabalho de McClure et al. (1994). As comparações foram feitas com o algoritmo

Exact, que faz uso de Otimização Inteira, o algoritmo proposto LDDA-LSS e o

Heuris-Seq, que é uma versão seqüencial da heurística proposta por Gomes et al.

(2008). Os resultados mostraram que o algoritmo proposto não é muito eficiente

para resolver instâncias pequenas, mas muito eficiente para instâncias de grandes

dimensões.

O trabalho de Zörnig (2011), por sua vez, apresenta um novo modelo de otimização linear inteira. Este modelo requer, segundo o autor, um número menor de

variáveis e restrições, o que representa uma melhoria no modelo de otimização linear

inteira binária utilizado em outros trabalho da literatura, como em Festa (2007) e

Meneses et al. (2004). Segundo Zörnig (2011), a redução do número de variáveis

e restrições do problema linear inteiro seria possível a partir do reconhecimento da

existência de isomorfismo entre colunas da matriz a ser tratada e a obtenção de

uma matriz denominada pelo autor de matriz normalizada. Essa normalização da

matriz proporciona, segundo o autor, a redução do tamanho do alfabeto. A solução

normalizada terá, então, o número de variáveis menor que a solução original, pois o

alfabeto desta terá no máximo o tamanho igual ao número de linhas da matriz.

Nos testes realizados pelo autor, foram aplicadas as instâncias geradas aleatoriamente a partir de alfabetos de tamanho 4 para cadeias cujo tamanho m pertence ao

intervalo 1000 ≤ m ≤ 2000, e também a partir de um alfabeto de tamanho 5 com

cadeias que possuem dimensão em torno de 3000 caracteres. A aplicação do modelo mostrado por Zörnig (2011) fica restrita a instâncias formadas por um reduzido

número de cadeias de no máximo 20.

Os resultados dos testes mostraram que em 14 das 20 instâncias o valor da função

objetivo da solução de arredondamento é o menor inteiro maior ou igual ao valor ideal

do relaxamento linear, tornando a solução aproximada do CSP, determinada pelo

arredondamento, uma solução ideal. Nos 6 casos restantes, o erro de aproximação

2.1

Revisão bibliográfica do PCCP

15

CSP é no máximo 1. Este trabalho chama a atenção pela técnica de álgebra linear

aplicada.

Usando técnicas de relaxação lagrangeana, Tanaka (2012) propõe um algoritmo

heurístico eficiente na resolução do CSP. A idéia principal é aplicar técnicas de relaxação lagrangeana para a formulação inteira-mista, permitindo obter uma solução

aproximada e, ao mesmo tempo, estreitar o limite inferior. O algoritmo proposto

é composto por duas partes. Na primeira, o algoritmo subgradiente resolve o problema dual lagrangeano (DLR). Segundo o autor, multiplicadores de Lagrange µ são

iterativamente atualizados para maximizar d∗ (µ). Este processo se repete até que

uma condição de término seja satisfeita. Na segunda etapa, é aplicada a metaheurística Busca Tabu para melhorar a solução. No procedimento Busca Tabu, Tanaka

(2012) fez uso de uma função de avaliação V , a qual avalia os melhores caracteres

para substituir por outros na solução inicial s. A seleção destes caracteres é feita

através da string mais distante em relação a s, escolhendo de forma determinística

os caracteres que se diferem entre essas duas seqüências. O critério para troca é

diminuir a distância máxima de Hamming entre s e as demais cadeias do conjunto.

A Busca Tabu é encerrada quando não houver melhora no valor da função objetivo

d, em movimentos sucessivos contabilizados por 4.N, sendo N é o número de strings

do conjunto.

As instâncias utilizadas para os testes foram as mesmas de Gomes et al. (2008),

com alfabeto Σ = {2, 4, 20} e instâncias simulando o genoma da “Actinobacteria”

Streptomyces coelicolor, cuja formação é composta de 72% dos caracteres GC, com

N = {10, 20, ..., 50} e a dimensão das strings dada por L = {1000, 2000, ..., 5000}.

As comparações do algoritmo proposto foram feitas com os seguintes trabalhos:

algoritmo paralelo Multistart de Gomes et al. (2008), comparando as médias do Gap;

o algoritmo CGSA de Liu et al. (2008), que utiliza como base a heurística Simulated

Annealing; o algoritmo GA proposto por Julstrom (2009) com L = 500 e Σ =

{2, 4, 10, 20, 30}; e Faro e Pappalardo (2010), com o algoritmo Ant-CSP, com todas

as strings de dimensão L = 1000 e Σ = 4. Os experimentos computacionais mostram

que o algoritmo proposto pôde encontrar boas soluções, ou soluções aproximadas, em

um tempo computacional muito rápido em relação a todas as heurísticas testadas.

Em um trabalho mais recente, de Souza (2012) implementou dois algoritmos

baseados nas metaheurísticas GRASP (Greedy Randomized Adaptative Search Procedure), ILS (Iterated Local Search) e AG (Algoritmo Genético), aplicando-os à

resolução do Problema da Cadeia de Caracteres mais Próxima (PCCP). Foram implementados quatro versões de algoritmos, a saber, GRASP-AG I e GRASP-AG II,

que se diferenciam na fase de construção GRASP; GRASP-ILS I e GRASP-ILS II,

que se diferenciam na escolha dos elementos a compor a Lista de Candidatos Restrita

(LCR). O algoritmo GRASP é responsável apenas pela fase de construção, sendo

a varredura do espaço de busca realizada pelos algoritmos AG e ILS. O método de

Descida Randômica é responsável pela busca local.

Após testes preliminares, verificou-se que o GRASP-AG I e GRASP-ILS I apresentaram melhores resultados computacionais em relação aos outros dois algoritmos.

As instâncias testadas no trabalho foram construídas a partir do alfabeto de quatro

caracteres do DNA dado por Σ = {A, C, T, G}. Os resultados foram comparados

com outros de Meneses et al. (2004), Gomes et al. (2008) e Mousavi e Esfahani

(2012). Para instâncias moderadas e grandes, os algoritmos apresentados atingiram

2.2

Uma Análise da revisão bibliográfica sobre PCCP

16

valores sub-ótimos razoáveis, porém, pouco competitivos em relação aos resultados

da literatura.

Em outro trabalho encontrado na literatura, que também faz uso da heurística

GRASP para solucionar o CSP, Mousavi e Esfahani (2012) utilizam uma função

heurística (cos(.)) de avaliação inspirada na teoria das probabilidades, a fim de

avaliar e comparar soluções candidatas. A função proposta pelos autores avalia o

beneficio de duas ou mais soluções candidatas diferentes, que possuam a mesma

distância de Hamming, diminuindo assim o custo computacional do algoritmo.

Essa nova função proposta por Mousavi e Esfahani (2012) funciona da seguinte

forma: dadas duas soluções candidatas x1 e x2 , é dada à solução x1 um valor maior

que o de x2 se e somente se ocorrem f (x1 ) < f (x2 ) ou f (x1 ) = f (x2 ) e cos(x1 ) <

cos(x2 ), em que: f (.) é a função da avaliação tradicional e cos(.) é a nova função

heurística desenvolvida pelos autores. Segundo os autores, esse tipo de avaliação

sugere que o número de mínimos locais poderá ser reduzido, quando for utilizada a

função cos(.) no lugar de f (.) para avaliar soluções candidatas.

A fase de construção GRASP é avaliada por essa função heurística, e foi ajustada

para atingir um equilíbrio adequado entre a escolha aleatória e gulosa dos candidatos

para compor a Lista de Candidatos Restrita (LCR). Já a busca local é feita por um

algoritmo de melhoria iterada.

Os resultados experimentais obtidos pelo algoritmo GRASP-CSP de Mousavi

e Esfahani (2012) foram comparados com os resultados das seguintes heurísticas

propostas para o CSP: CGSA por Liu et al. (2008); Ant-CSP por Faro e Pappalardo

(2010); a heurística DBCGA, do trabalho de Julstrom (2009); e o algoritmo exato

Mismatch count, de Hufsky et al. (2010).

Os parâmetros utilizados no GRASP-CSP, implementados no trabalho de Mousavi e Esfahani (2012) foram: Lista de Candidatos Restrita (LCR) com tamanho

2, 10 iterações do algoritmo e número de execuções igual a 20. A fim de demonstrar a ineficiência dos métodos exatos, em especial o Mismatch Count, foram geradas aleatoriamente, segundo os autores, 18 instâncias de tamanho reduzido com

um alfabeto binário (|Σ| = 2), com n = {10, 20, 30} (número de seqüências) e

m = {10, 20, 30, 40, 50, 100} (dimensões das seqüências).

As comparações entre os resultados do algoritmo GRASP-CSP, implementado

no trabalho de Mousavi e Esfahani (2012), e aqueles encontrados pelas heurísticas

dos trabalhos de Liu et al. (2008), Faro e Pappalardo (2010) e Julstrom (2009),

foram feitas com vários grupos de instâncias constituídas por alfabetos pertencentes

ao conjunto Σ = {2, 4, 10, 20, 30}. Para alguns casos com valores de m ≤ 50, as

soluções obtidas pelo algoritmo GRASP-CSP foram iguais, porém com o tempo de

processamento reduzido. Para os demais casos, o algoritmo teve um desempenho

superior e com um tempo bem abaixo das demais comparações.

2.2

Análise da Revisão Bibliográfica sobre PCCP

A seguir, a Tabela 2.1 contém os resultados da literatura referente aos autores

citados anteriormente, com destaque para o tipo de problema tratado e os métodos

utilizados para resolvê-los.

Para encontrar uma solução viável para problemas relacionados ao PCCP, há

2.2

Uma Análise da revisão bibliográfica sobre PCCP

17

Tabela 2.1: Resultados da literatura.

Autor

Ben-Dor (1997)

Gasieniec et al. (1999)

Li et al. (2002)

Deng et al. (2002)

Ecker et al. (2002)

Lanctot et al. (2003)

Mauch (2003)

Fonseca (2003)

Problema

CSP e DSSP

Hamming Center

Problem

Closest String problem e

Closest Substring problem

Closest String problem e

Farthest String Problem e

Distinguishing String Problem

Encontrar locais de

ligação a proteínas em

cadeias de DNA

CSP, FSP, Close to Most

String Problem, Distinguishing

String Selection Problem.

CSP

subseqüência de caracteres

(motifs)

Meneses et al. (2004)

PCCP

Pinto et al. (2006)

Gramm (2006)

PCCP

DSSS

Festa (2007)

CSP, FSP, FFMSP

Jing-Chao (2007)

Gomes et al. (2008)

Ma e Sun (2009)

CSP

PCCP

CSP, CSSP

Faro e Pappalardo (2009)

Chen et al. (2010)

Chimani (2011)

PCCP

Closest String Problem

CSP, CSSP

Liu et al. (2011)

CSP

Zornig (2011)

CSP

Tanaka (2012)

CSP

Mousavi e Esfahani (2012)

Souza (2012)

CSP

PCCP

Metodologia

Algoritmo de aproximação

Algoritmo de aproximação

de tempo polinomial

Algoritmo de aproximação

de tempo polinomial

Polinomial Time

Approximation Schemes

(PTAS)

Nonlinear Programming

(NLP)

Técnicas de Relaxamento de

Programação linear, Algoritmos de

Aproximação e Algoritmo heurístico

GA Run

Algoritmos Força-bruta,

Knuth-Morris-Pratt (KMP)

e Boyer-Moore (BM)

Otimização Inteira, uma

heurística e um Algoritmo

branch-and-bound

Algoritmos heurísticos GRASP

Algoritmo exato

de parâmetro-fixo

Otimização Combinatória,

heurísticas GRASP

Iterative Rounding

Algoritmo Paralelo Multistart

Polinomial Time Approximation

Schemes (PTAS)

Algoritmo Ant-CSP

Algoritmo 3-string approach

formulações do tipo Integer

Linear Program (ILP)

algoritmo exato Distance

First Algorithm (DFA)

Programação Linear Inteira

Relaxamento LP

Técnicas de Relaxação Lagrangeana,

Algoritmo Heurístico e a

Meta-heurística Busca Tabu

GRASP

GRASP, ILS e AG

o uso freqüente de metaheurísticas híbridas, algoritmos de aproximação de tempo

polinomial, heurística de busca local e o uso de Otimização Inteira. Estes métodos

são os mais utilizados para se obter uma solução rápida e de boa qualidade, otimizando, assim, os problemas relacionados a seqüências de caracteres, seja o objetivo

encontrar a cadeia mais próxima ou a mais distante.

Capítulo 3

Caracterização do Problema

Esse capítulo irá abordar o Problema da Cadeia de Caracteres mais Próxima

(PCCP) que, segundo a literatura, está entre os mais importantes problemas estudados pelos pesquisadores da Biologia Computacional. Em muitos problemas que

ocorrem nessa área, existe uma necessidade de comparar e encontrar características

comuns em seqüências de DNA, RNA e proteínas. Em se tratando de otimização

combinatória, o PCCP é considerado um problema NP-difícil.

Segundo a literatura, o Problema da Cadeia de Caracteres mais Próxima é um

dos vários problemas constituintes da classe de problemas da Biologia Computacional e da Teoria dos Códigos. Em destaque, tem-se a descoberta de alvos potenciais

para medicamentos, criação de testes diagnósticos e identificação de padrões em

seqüências de proteínas. Um dos principais objetivos deste trabalho é encontrar

uma seqüência (string) ou subseqüência (substring) de caracteres, que se aproxime

ao máximo da estrutura de um determinado conjunto de seqüências, formadas pelos mesmos grupos de caracteres, como as bases nitrogenadas do DNA, RNA ou

seqüências de proteínas. Para medir estas semelhanças, é utilizado como métrica a

distância de Hamming. A distância de Hamming entre duas seqüências de caracteres de mesma dimensão corresponde ao número de posições nas quais as seqüências

diferem.

A escolha da utilização da distância de Hamming se deve ao fato de ser a mais

utilizada em toda a literatura, empregada também no trabalho de Meneses et al.

(2004), e por ser a mais simples e objetiva forma de determinar as similaridades ou

diferenças entre duas seqüências.

O presente Capítulo está organizado como segue: a próxima seção introduz os

problemas mais importantes em Biologia Computacional, abordados no trabalho

de Festa (2007). A Seção 3.2 apresenta o Closest String Problem. A Seção 3.3

apresenta o Problema da Cadeia de Caracteres mais Distante ou Farthest String

Problem(FSP); a Seção 3.4 mostra o Far From Most String Problem (FFMSP);

a Seção 3.5 apresenta outros tipos de problemas relacionados com seqüências de

caracteres, estudados por Lanctot et al. (2003) e outros autores e, por fim, na Seção

3.6 será apresentada uma formulação proposta por Meneses et al. (2004) para a

solução do PCCP, tema desta dissertação, com algumas definições e exemplos.

18

3.1

Caracterização do Problema

3.1

19

Alguns problemas de comparação e seleção de

cadeias

Segundo Festa (2007), problemas de comparação e seleção de cadeias pertencem

a uma classe da Biologia Molecular mais conhecida como seqüências de consenso,

em que um conjunto finito de seqüências é dado, e o objetivo é encontrar o seu

consenso, ou seja, uma nova seqüência que concorde, tanto quanto possível, com

todos elementos de uma seqüência dada.

Alguns destes problemas são apresentados por Li et al. (1999). Dentre eles, estão:

(i) Consensus Patterns: dado um conjunto de seqüências S = {s1 , s2 , ..., sn }, com

|si | = m, e um número inteiro L, encontrar a string mediana s e uma substring

ti (Consensus Patterns), ambas com dimensão L, de cada si , minimizando

n

X

dH (s, ti ); e

i=1

(ii) Star Alignment: dado um conjunto de seqüências S = {s1 , s2 , ..., sn }, com

n

X

|si | = m, encontrar a seqüência mediana s minimizando

dE (si , s), em que

i=1

dE denota a distância edit.

De acordo com Festa (2007), os seguintes problemas abordados em seu trabalho

também estão relacionados com seqüências de consenso:

(i) o consenso é uma nova seqüência, cuja distância total, a partir de todas as

seqüências de um dado conjunto, é a menor possível (Closest String Problem);

(ii) o consenso é uma nova seqüência, cuja distância total a partir de todas as

seqüências de um dado conjunto é a maior possível (Farthest String Problem);

(iii) o consenso é uma nova seqüência, e este problema consiste em determinar

uma seqüência que seja a mais distante possível de um conjunto de seqüências

dadas (Far From Most String Problem).

As formulações matemáticas referentes aos três problemas citados são apresentados a seguir. As seguintes notações são utilizadas nestes três problemas:

• um alfabeto Ω = {c1 , c2 , · · · , ck } é um conjunto finito de elementos chamados

caracteres;

• uma seqüência s = {s1 , s2 , · · · , sm }, em que |s| = m, sendo m a dimensão

da seqüência s, ou seja, o número de cadeias que s possui, formadas pelo

alfabeto Ω, de modo que os caracteres si que compõem a cadeia pertencem a

Ω, i = 1, 2, · · · , m;

• Dadas duas seqüências s e t em Ω, tais que |s| = |t|, a distância de Hamming

entre s e t, denotada por dH(s,t) , é calculada pela expressão:

dH(s,t) =

|s|

X

i=1

φ(si , ti ),

(3.1)

3.2

Caracterização do Problema

20

em que a função φ(·) é tal que:

φ : Ω × Ω → {0, 1}

(3.2)

sendo:

φ(a, b) =

0, se a = b;

1, caso contrário.

(3.3)

Deve ser observado que a distância de Hamming entre duas cadeias a e b pode

ser calculada desde que as duas cadeias tenham o mesmo número de caracteres.

Essa distância é dada pela soma de uma unidade ao valor atual da distância para as

posições em que os caracteres são diferentes. Caso esses mesmos caracteres sejam

iguais, somaremos zero ao valor da distância atual. Esse procedimento do somatório

se repete para cada cadeia de uma instância. A seguir, um exemplo de como encontrar a distância de Hamming entre uma seqüência dada e as demais cadeias de um

conjunto.

Exemplo 3.1 Seja o alfabeto Ω = {A, C, G, T } e um conjunto de cadeias de caracteres S = {s1 , s2 , s3 }, formadas pelo alfabeto Ω, em que s1 = (GAT T G), s2 =

(GAT CA), s3 = (CT CGA). Se t = (GAT T C), determine a distância de Hamming

entre t e as demais cadeias do conjunto S.

• No conjunto S, tem-se: número de cadeias de caracteres em S é m = 3 e

|s1 | = |s2 | = |s3 | = 5 (dimensão de cada cadeia em S);

• Sendo |t| = 5, segue que |s1 | = |s2 | = |s3 | = |t|;

• Então, a distância de Hamming entre t e s1 , s2 , s3 é dada por: dH (s1 , t) = 1;

dH (s2 , t) = 2; dH (s3 , t) = 5

Todas essas seqüências possuem a mesma dimensão e são construídas a partir

de um único alfabeto, que é utilizado para definir as cadeias de caracteres. Estas

cadeias são utilizadas para representar as bases nitrogenadas do DNA, na forma do

alfabeto Ω = {A, C, G, T }.

3.2

Closest String Problem (CSP)

Dado um conjunto finito de n seqüências Σ = {s1 , s2 , . . . , sn } em Ω, cada um

de comprimento m, ou seja, de modo que si ∈ Ωm , i = 1, 2, . . . , n, o Problema da

Cadeia de Caracteres mais Próxima, ou (CSP), é encontrar uma seqüência central

t ∈ Ωm , ou seja, uma seqüência t de comprimento m, tal que a distância de Hamming

entre t e todas as outras seqüências em Σ seja mínima, ou seja:

dH (t, si ) ≤ d, ∀si ∈ Σ

(3.4)

O presente problema pode ser formulado como um problema de Otimização Inteira. Seja vk um conjunto de caracteres que aparecem na posição k no conjunto de

3.3

Caracterização do Problema

21

seqüências em Σ. Para cada k = 1, 2, . . . , m e j ∈ vk , define-se a variável de decisão

binária:

1, se o j-ésimo caractere em vk for utilizado na posição k;

xjk =

(3.5)

0, caso contrário.

De acordo com Festa (2007), o CSP admite a seguinte formulação matemática:

(CSP )

(3.6)

min d

sujeito a: