CENTRO FEDERAL DE EDUCAÇÃO TECNOLÓGICA DE MINAS GERAIS

PROGRAMA DE PÓS-GRADUAÇÃO EM MODELAGEM MATEMÁTICA E

COMPUTACIONAL

Vitor Tavares Gontijo

Técnica de Engenharia de Software para

desenvolvimento de aplicativos paralelos e

distribuídos

Belo Horizonte

2013

Vitor Tavares Gontijo

Técnica de Engenharia de Software para

desenvolvimento de aplicativos paralelos e

distribuídos

Dissertação apresentada ao Curso de

Mestrado em Modelagem Matemática e

Computacional do Centro Federal de

Educação Tecnológica de Minas Gerais,

como requisito parcial à obtenção do título

de Mestre em Modelagem Matemática e

Computacional.

Orientador:

Prof. Dr. Gray Farias Moita

Belo Horizonte

CEFET/MG

2013

DEDICATÓRIA

Dedico este trabalho aos meus pais

pelo apoio aos estudos sempre e a

minha

esposa

pelo

amor

e

companheirismo.

AGRADECIMENTOS

Aos professores do Programa de Pós-graduação em Modelagem Computacional, em

especial aos que estiveram mais próximo neste projeto, Bruno Santos, Paulo

Almeida e Henrique Borges.

A todos os colegas de mestrado.

Aos colegas de trabalho do CEFET-MG.

Ao meu professor e orientador Gray Farias Moita.

À minha querida esposa que tanto me apoiou e tolerou momentos difíceis nesta

fase. “Se tudo passa, como se explica o amor que fica?” (Zeca Baleiro)

Aos meus pais que sempre me deram plenas condições e incentivo aos estudos.

Aos amigos e todos aqueles que contribuíram de alguma forma com este trabalho

meus sinceros agradecimentos.

“Alguns homens veem as coisas como são, e

dizem 'Por quê?' Eu sonho com as coisas que

nunca foram e digo 'Por que não ?'” (George

Bernard Shaw)

RESUMO

Recentemente, computação paralela e distribuída tem se mostrado tema

amplamente estudado. Também, arquiteturas de hardware de múltiplos núcleos

(multicore) já estão bem consolidadas e são largamente utilizadas em diferentes

campos de aplicações. No entanto, ainda não existe um consenso a respeito das

melhores práticas ou da maneira de utilização da Engenharia de Software no

desenvolvimento específico de softwares para tais arquiteturas e uma avaliação

cuidadosa do atual estado da arte no assunto pode ser uma interessante maneira de

seguir adiante neste campo de pesquisa. No presente trabalho de pesquisa, buscase promover a concepção de softwares eficientes para aproveitar ao máximo o

potencial do hardware multicore ou distribuído disponível usando para isto técnicas

de Engenharia de Software como ponto de partida. Existem várias soluções para

processamento de aplicações paralelas e distribuídas, porém, para obter uso

satisfatório do potencial oferecido por cada solução, o software deve ser concebido

em arquitetura paralela. Portanto, para se desenvolver softwares paralelos de alta

qualidade, que tornem a programação paralela mais compreensível e mais fácil de

desenvolver e manter, são necessárias pesquisas em análise e projeto de software

paralelo. Este trabalho propõe técnicas específicas de Engenharia de Software a

serem utilizadas no desenvolvimento de aplicações para computadores multicores e

de processamento distribuído, e, em especial, para softwares científicos, devido às

suas características intrínsecas, como, por exemplo, a habitual necessidade de alto

desempenho computacional e a frequente inexperiência com programação dos

desenvolvedores dos projetos. Nesta pesquisa são aplicadas as técnicas propostas

em diferentes arquiteturas paralelas como Multicores, Clouds, Grids e Clusters, e

uma abordagem otimizada, controlada e sistemática da Engenharia de Software

para aplicativos paralelos e distribuídos é investigada. No final, uma nova técnica

para desenvolvimento deste tipo de software é proposta.

PALAVRAS-CHAVE: Computação Paralela e Distribuída, Engenharia de Software,

Arquitetura Multicore, Software Científico, Computação de Alto Desempenho.

ABSTRACT

Parallel and distributed computing has been a topic largely studied in the last few

years. Also, multicore architectures can be easily found and are widely used in

different fields of application. However, best practices and the “correct” use of

software engineering to develop such applications are not yet common place and a

careful evaluation of the current state-of-the-art in the subject can be a useful way

forward. In the present work, the main idea is to conceive efficient software to make

the best of the multicore or distributed hardware available; software engineering

techniques can be a good starting point. There exist several solutions for parallel and

distributed processing applications, but to obtain satisfactory use of the potential

offered by each solution, the actual software must be parallel designed. Therefore, to

attain higher quality “products”, parallel software design patterns, that make the

parallel programming more understandable and easier to develop and maintain, are

necessary and should be considered. This work proposes specific techniques of

software engineering to be applied in the development of distributed and concurrent

computer processing, especially for scientific software, due to their inherent

characteristics and the usual need for higher performance in their applications. In this

study the techniques proposed are implemented in different parallel architectures

such as multicore, cloud computing, grid computing and cluster, and an optimized,

controlled and systematic approach is sought. At the end, a new model for

management of this kind of software is proposed.

Keywords: Parallel and Distributed Computing, Software Engineering, Multicore

Architecture, Scientific Software, High Performance Computing.

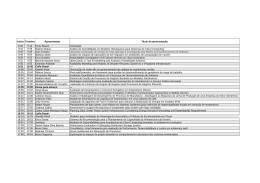

LISTA DE FIGURAS

Figura 1: Gráfico de desempenho com utilização de Multicores e Multiprocessadores. ...................... 12

Figura 2: Gráfico comparativo de desempenho e eficiência de CPU´s Multicores ............................... 14

Figura 3: Apresentação gráfica da organização da dissertação em capítulos. .................................... 16

Figura 4: Configurações de sistemas .................................................................................................... 24

Figura 5: Diferenças entre as configurações de Cluster e Grid. ........................................................... 28

Figura 6: Cloud Computing. .................................................................................................................. 29

Figura 7: Etapa de identificação do aplicativo. ...................................................................................... 43

Figura 8: Etapa de identificação do ambiente. ...................................................................................... 44

Figura 9: Definição do modelo de controle. .......................................................................................... 46

Figura 10: Níveis de granularidade. ...................................................................................................... 47

Figura 11: Métodos de comunicação. ................................................................................................... 49

Figura 12: Sincronia e plano de testes. ................................................................................................. 50

Figura 13: Visão geral da técnica proposta. .......................................................................................... 53

Figura 14: Estrutura do Grid JPPF ........................................................................................................ 62

Figura 15: Gráfico comparativo de performance – Arquitetura Multicore. ............................................ 78

Figura 16: Gráfico comparativo de Speed-up – Arquitetura Multicore. ................................................. 79

Figura 17: Gráfico comparativo de performance – Arquitetura Grid Computing. .................................. 81

Figura 18: Gráfico comparativo de Speed-up – Arquitetura Grid Computing. ...................................... 81

Figura 19: Gráfico comparativo de performance – Arquitetura Cluster................................................. 84

Figura 20: Gráfico comparativo de Speed-up – Arquitetura Cluster. .................................................... 84

Figura 21: Gráfico comparativo de variação de granularidade - Arquitetura Cloud Computing. .......... 86

Figura 22: Gráfico comparativo de performance – Arquitetura Cloud Computing. ............................... 87

Figura 23: Comparativo entre o tempo de execução em diferentes arquiteturas ................................. 88

LISTA DE TABELAS

Tabela 1: Comparativo entre interfaces de programação paralela ....................................................... 17

Tabela 2: Tempo de execução sem paralelismo – Arquitetura Multicore. ............................................. 77

Tabela 3: Tempo de execução com paralelismo sem técnica – Arquitetura Multicore. ......................... 77

Tabela 4: Tempo de execução com aplicação da técnica proposta – Arquitetura Multicore................. 78

Tabela 5: Comparativo de valores de tempo de execução – Arquitetura Multicore. ............................. 78

Tabela 6: Resultados da execução cálculo de PI em arquitetura Grid Computing. .............................. 80

Tabela 7: Comparativo de valores de tempo de execução – Arquitetura Grid Computing. .................. 80

Tabela 8: Comparativo de valores de tempo de execução detalhado – Arquitetura Cluster. ............... 82

Tabela 9: Comparativo de valores de tempo de execução – Arquitetura Cluster. ................................ 83

Tabela 10: Resultados da execução cálculo de PI em arquitetura Cloud Computing. ......................... 85

Tabela 11: Comparativo de valores de tempo de execução – Arquitetura Cloud Computing. .............. 85

SUMÁRIO

1 – INTRODUÇÃO ................................................................................................................................. 11

1.1 – Caracterização do Problema / Motivação ................................................................................. 11

1.2 – Objetivos: Geral e Específico ................................................................................................... 14

1.3 – Estrutura do trabalho ................................................................................................................ 15

2 – FUNDAMENTAÇÃO TEÓRICA ....................................................................................................... 17

2.1 – Programação paralela .............................................................................................................. 17

2.2 – Softwares científicos ................................................................................................................. 20

2.3 – Arquiteturas paralelas ............................................................................................................... 22

2.3.1 – Multicore ........................................................................................................................... 23

2.3.2 – Cluster .............................................................................................................................. 25

2.3.3 – Grid Computing ................................................................................................................ 27

2.3.4 – Cloud Computing ............................................................................................................. 29

2.4 – Visão geral da Engenharia de Software ................................................................................... 31

3 – PRINCIPAIS PROBLEMAS RELACIONADOS AO PARALELISMO .............................................. 34

3.1 – Levantamento bibliográfico ...................................................................................................... 34

3.1.1 – Bloqueios em Programas de memória compartilhada ..................................................... 36

3.1.2 – Escalonamento de tarefas ............................................................................................... 38

3.1.3 – Escalabilidade .................................................................................................................. 39

4 – TÉCNICA PROPOSTA .................................................................................................................... 41

4.1 – Considerações Iniciais.............................................................................................................. 41

4.2 – Proposta para uma Engenharia de Software paralelo ............................................................. 42

4.2.1 – Etapa de identificação ...................................................................................................... 42

4.2.2 – Etapa de definição ........................................................................................................... 46

4.2.3 – Documento de identificação de paralelismo .................................................................... 51

4.3 – Visão geral da técnica proposta ............................................................................................... 52

5 – DESENVOLVIMENTO ..................................................................................................................... 54

5.1 – Aplicação escolhida .................................................................................................................. 54

5.2 – Implementação ......................................................................................................................... 55

5.3 – Métricas de software ................................................................................................................ 56

5.4 – Implantação em Multicore ........................................................................................................ 57

5.4.1 - Documento de Identificação de Paralelismo .................................................................... 58

5.4.2 – Implementação................................................................................................................. 60

5.5 – Implantação em Grid Computing .............................................................................................. 61

5.5.1 – Grid Computing com JPPF Grid. ..................................................................................... 61

5.5.2 - Documento de Identificação de Paralelismo .................................................................... 62

5.5.3 – Implementação................................................................................................................. 65

5.6 – Implantação em Cluster............................................................................................................ 67

5.6.1 – Cluster com Rocks ........................................................................................................... 67

5.6.2 - Documento de Identificação de Paralelismo .................................................................... 68

5.6.3 – Implementação................................................................................................................. 70

5.7 – Implantação em Cloud Computing ........................................................................................... 73

5.7.1 - Cloud Computing com Jelastic.com ................................................................................. 73

5.7.2 - Documento de Identificação de Paralelismo .................................................................... 74

5.7.3 – Implementação................................................................................................................. 76

6 – RESULTADOS OBTIDOS ............................................................................................................... 77

6.1 – Multicore ................................................................................................................................... 77

6.2 – Grid Computing ........................................................................................................................ 79

6.3 – Cluster de Computadores......................................................................................................... 82

6.4 – Cloud Computing ...................................................................................................................... 85

6.5 – Observações gerais .................................................................................................................. 87

7 – CONCLUSÕES E CONSIDERAÇÕES FINAIS .............................................................................. 89

7.1 – Conclusões, limitações e contribuições ................................................................................... 89

7.2 - Trabalhos Futuros ..................................................................................................................... 91

8 – REFERÊNCIAS BIBLIOGRÁFICAS ................................................................................................ 92

11

1 – INTRODUÇÃO

Atualmente, a tendência dos hardwares dos computadores serem mais

simples, com frequência de operação mais baixa e integração em um mesmo chip

de dois ou mais núcleos de processamento – arquiteturas conhecidas como de

múltiplos núcleos (multicore) – já está consolidada e é utilizada amplamente nos

mais diversos campos de aplicações (RIGO et al., 2007). Com isso, a computação

paralela e distribuída tem se mostrado tema amplamente estudado. Entretanto,

somente com estas arquiteturas, sem softwares eficientes e adequados, o potencial

de hardware disponível poderá ser subutilizado. Assim, é real a necessidade de

adequação dos modelos tradicionais de desenvolvimento de softwares sequenciais

para um modelo paralelo.

O grande desafio atual, então, é descobrir como tornar a programação paralela

mais simples e acessível para a grande maioria dos programadores, principalmente

pesquisadores, uma vez que este trabalho tem como principal abordagem o

desenvolvimento de software científico. Desta maneira, o enfoque principal deste

trabalho foram os softwares científicos. Entretanto, em princípio, nada impede que a

técnica seja usada para desenvolvimento de aplicativos paralelos e distribuídos em

geral.

Ao final deste trabalho é disponibilizado para a comunidade acadêmica um

conjunto de técnicas de Engenharia de Software voltadas ao desenvolvimento de

aplicações paralelas, incentivando, facilitando e proporcionando esta evolução na

qualidade dos softwares produzidos principalmente por cientistas.

1.1 – Caracterização do Problema / Motivação

Não é possível notar um volume significativo de produções acadêmicas (ou

comerciais) que envolvam a Engenharia de Software aplicada ao desenvolvimento

de software paralelo. Neste sentido, busca-se, a partir da presente pesquisa, estudar

e propor novas estratégias para a melhoria da qualidade no desenvolvimento desse

tipo de software. Assim, além de melhorar o desenvolvimento de novas aplicações e

proporcionar melhorias também nos aplicativos já desenvolvidos, este estudo

procura incentivar a identificação de padrões de projeto que tornem a programação

paralela mais compreensível e, principalmente, mais fácil de desenvolver e manter.

12

Em complementação, não se percebe um consenso a respeito das melhores práticas

ou da maneira de utilização da Engenharia de Software no desenvolvimento

específico para arquiteturas paralelas e distribuídas. Portanto, o trabalho realiza,

também, uma avaliação cuidadosa do atual estado da arte no assunto, avaliando as

técnicas a serem utilizadas em projetos de engenharia de desenvolvimento de

software especificamente paralelos, e principalmente software científico, devido às

suas características peculiares e necessidade de alto desempenho, e, então, seguir

adiante neste campo de pesquisa.

Segundo Lee et al. (2010), de acordo com a Lei de Amdahl, o desempenho do

código é limitado por sua parte serial. Neste sentido, é algo interessante, quando se

tem um hardware com processamento paralelo, o projeto de sistema possuir um

núcleo para acelerar regiões de códigos não seriais através da utilização de threads,

que seria a paralelização do código. Isto já vem sendo pesquisado, conforme se vê

abaixo no gráfico apresentado por Jason (2012), o qual apresenta os ganhos de

desempenho conquistados através da utilização de uma arquitetura multicore e

multiprocessada (Figura 1).

Figura 1: Gráfico de desempenho com utilização de Multicores e Multiprocessadores.

Fonte: Adaptado de Jason (2012).

O problema da dificuldade de desenvolver software paralelo não é novo e

através do aproveitamento das pesquisas e descobertas já realizadas até hoje,

pode-se partir para a busca de novas descobertas, já considerando que a

13

automatização do paralelismo não é muito interessante e a criação de uma nova

linguagem de programação é inviável. Assim, acredita-se que uma maneira de

resolver este problema é primeiramente entender como arquitetar o software

paralelo da melhor maneira (KEUTZER E MATTSON, 2010). Isto pode ser verificado

quando Rigo et al. (2007) dizem que para fazer uso do potencial oferecido pelo

hardware atual, o software deve ser paralelizado, e confirmado também por

Pankratius (2010), quando diz que todas as aplicações de alto desempenho, não

apenas as aplicações de supercomputadores, devem ser paralelas para explorar

melhor o potencial do hardware. Dessa forma, o modelo sequencial de programação

deve ser alterado para um modelo paralelo.

Segundo Keutzer e Mattson (2010), a chave para escrever software paralelo de

alta qualidade é desenvolver uma análise robusta para este software: o sucesso de

qualquer produto de software de qualidade está na base em que ele foi desenvolvido

- sua arquitetura, análise e desenho – que, consequentemente, irá influenciar

diretamente o bom desenvolvimento e implantação.

A evolução das arquiteturas de hardware já trouxe avanços significativos para o

desempenho, por exemplo, o speed-up dos aplicativos, que é entendido como o

ganho em velocidade de processamento através da adição de núcleos de

processamento. O gráfico da Figura 2, apresentado por Geonumerics (2012) indica a

possibilidade de avanços na utilização dos recursos de hardware disponíveis. Ele

ilustra a perda de eficiência na atual utilização dos computadores multicores,

comparando o speed-up alcançado com diferentes tecnologias de implementação de

paralelismo, como o algoritmo de gerenciamento de tarefas H-Dispatch, o modelo de

endereçamento de memória Scatter-Gather e a interface de comunicação MPI, com

o que denotaria o speed-up ideal.

14

Figura 2: Gráfico comparativo de desempenho e eficiência de CPU´s Multicores

Fonte: Adaptado de Geonumerics (2012)

Uma vez que seja perceptível uma melhoria na qualidade, reusabilidade e

eficiência dos softwares produzidos, acredita-se que o presente projeto se tornará

um multiplicador para uma melhor utilização dos ambientes multiprocessados e de

processamentos distribuídos disponíveis para pesquisas, ampliando assim o

conhecimento e evoluindo os estudos na área de Engenharia de Software voltada

para a computação paralela.

Assim, ao final desta pesquisa, fazendo-se uso do suporte de uma abordagem

otimizada, controlada e sistemática da Engenharia de Software para sistemas

paralelos

e

distribuídos,

pretende-se

apresentar

uma

nova

técnica

para

desenvolvimento deste tipo de sistema.

1.2 – Objetivos: Geral e Específico

O objetivo geral da presente investigação é propor um modelo baseado em técnicas

específicas de Engenharia de Software a serem utilizadas no desenvolvimento de

softwares,

especialmente

científicos,

para

computadores

multicores

e

de

processamento distribuído.

Para que seja possível alcançar o objetivo geral acima descrito, os seguintes

objetivos específicos podem ser elencados:

15

- Levantamento detalhado do estado da arte em computação e técnicas de

programação paralela, arquiteturas paralelas e desenvolvimento de softwares

científicos, com foco principal nos problemas enfrentados durante o desenvolvimento

de software paralelo.

- Estudo da Engenharia de Software aplicada ao desenvolvimento de software

paralelo.

- Proposta de um conjunto de técnicas de Engenharia de Software a serem utilizadas

neste tipo específico de arquitetura, proporcionando opções simples e eficazes de

documentação para os pesquisadores utilizarem o modelo de programação paralela

em seus aplicativos.

- Estabelecimento de um modelo com técnicas e formalização de uma proposta de

abordagem sistematizada da Engenharia de Software para aplicativos a serem

implementados em arquiteturas paralelas e distribuídas.

- Escolha de uma aplicação paralelizável, no caso, o cálculo da constante PI, para

verificação e validação das técnicas propostas no presente estudo.

- Implementação e execução de aplicativos específicos, de cálculo de PI,

desenvolvidos com base nas técnicas propostas, para arquiteturas de Multicores,

Cloud Computing, Grid Computing e Cluster.

- Avaliação, sistematização e conclusão dos resultados obtidos.

1.3 – Estrutura do trabalho

O presente trabalho foi distribuído em sete capítulos. Após o capítulo

introdutório, segue o Capítulo 2 com a fundamentação teórica relevante para o

desenvolvimento da dissertação. No Capítulo 3 é apresentado um levantamento

bibliográfico a respeito dos principais problemas relacionados à programação

paralela. No Capítulo 4, as técnicas desenvolvidas são apresentadas juntamente

com o modo de utilização. Nos Capítulos 5 e 6 são propostas a implementação de

16

um aplicativo de testes e a aplicação da técnica em seu desenvolvimento para

implantação em diferentes arquiteturas paralelas, ao final são apresentados os

resultados obtidos e uma análise a respeito deles. Finalmente, no sétimo e último

capítulo são apresentadas as conclusões a respeito do trabalho desenvolvido. Ao

final, são apresentadas as referências utilizadas e os anexos. A organização dessa

dissertação é apresentada graficamente pela Figura 3:

Figura 3: Apresentação gráfica da organização da dissertação em capítulos.

17

2 – FUNDAMENTAÇÃO TEÓRICA

2.1 – Programação paralela

Pode-se dizer que a programação paralela é, hoje em dia, desenvolvida e

estudada de maneira independente da Engenharia de Software, ou melhor,

utilizando basicamente a Engenharia de Software tradicional. Ritter e Bordin (2009),

em seu trabalho de pesquisa bibliográfica e laboratorial, identificaram e avaliaram

algumas bibliotecas e linguagens utilizadas na programação, chegando ao seguinte

quadro comparativo de interfaces (Tabela 1).

Tabela 1: Comparativo entre interfaces de programação paralela

Fonte: Ritter e Bordin (2009)

POSIX threads (PThreads) é uma interface de programação em linguagem C

padronizada que foi especificada pelo IEEE POSIX. Define uma API padrão para

criar e manipular threads. As bibliotecas que implementam a POSIX threads são

chamadas Pthreads, sendo muito difundidas no universo Unix e outros sistemas

operacionais semelhantes como Linux e Solaris (BARNEY, 2012).

Cilk Plus é um produto da Intel, de código aberto. Essencialmente, o projeto

está trabalhando em extensões para as linguagens C e C++, tornando a

programação paralela eficiente mais fácil. O produto inclui três simples palavras

chave e notações de array que permitem aos desenvolvedores C e C++ fazerem uso

produtivo de processadores modernos que contém tanto múltiplos núcleos quanto

unidades vetoriais (CAMPOS, 2011).

18

Intel® Threading Building Blocks (Intel ® TBB) oferece uma abordagem rica e

completa para expressar paralelismo em um programa C++. É uma biblioteca que

ajuda o desenvolvedor a tirar proveito do desempenho dos processadores multicore

sem ter que ser um especialista em paralelismo. Intel TBB não é apenas uma

biblioteca para substituição de threads. Ela representa um nível mais alto; é

paralelismo baseado em tarefas que abstrai detalhes da plataforma e mecanismos

de segmentação para escalabilidade e desempenho. (INTEL, 2012)

Em relação à autoparalelização, estudos já demonstraram não ser uma boa

opção, pois os compiladores podem especular, ordenar dados e reordenar

instruções para equilibrar a carga entre os componentes de um sistema, mas eles

não conseguem reescrever um algoritmo serial criando um algoritmo diferente mais

adequado para execução paralela. (KEUTZER E MATTSON, 2010)

OpenMP (Open Multi-Processing) é uma interface de programação de

aplicativo para a programação paralela de memória compartilhada em múltiplas

plataformas. Permite acrescentar aos programas escritos em C, C++ e Fortran um

método de paralelização no qual o "master thread", parte serial do código, bifurca

(forks) um específico número de threads escravos e uma tarefa é dividida entre eles.

As threads são então executadas simultaneamente. Esta interface está disponível

em muitas arquiteturas, incluindo as plataformas Unix e Microsoft Windows.

High Performance Fortran (HPF) é uma extensão do Fortran 90 com

construções que suportam a computação paralela, publicada pelo High Performance

Fortran Fórum (HPFF) em seu primeiro fórum em 1993. Com base na matriz de

sintaxe introduzido em Fortran 90, HPF usa um modelo de dados de computação

paralela para apoiar a distribuição da execução de uma matriz de trabalhos em

múltiplos processadores. Isso permite uma execução eficiente em arquiteturas SIMD

e MIMD, que serão abordadas mais a frente. (RICE UNIVERSITY, 2006)

CUDA™ é uma plataforma de computação paralela e um modelo de

programação desenvolvido pela NVIDIA. Ela permite aumentos significativos de

desempenho computacional ao aproveitar a potência da unidade de processamento

gráfico (GPU). Com a CUDA, você pode enviar código em C, C++ e Fortran

diretamente à GPU, sem precisar usar uma linguagem de compilação. (NVIDIA,

2012)

Ao final de seu trabalho, Ritter e Bordin (2009) chegaram à conclusão de que

em seus experimentos, CUDA se apresentou como melhor opção em fase de testes,

19

devido à memória compartilhada rápida, porém o modelo sofre alguns gargalos em

relação à comunicação e é utilizada somente em Unidades de Processamento

Gráfico de Propósito Geral ou GPGPU. HPF e OpenMP continuam sendo as

principais alternativa para aplicações paralelas devido à relativa simplicidade de

implementação. Por sua vez, TBB surgiu com enfoque principal em multicore. Assim,

não existe uma única interface melhor para todos os casos, sendo que uma

avaliação específica da aplicação ainda é necessária e indispensável para definir

bem a ferramenta que será melhor aproveitada.

Outras interfaces de desenvolvimento paralelo poderiam ser abordadas, como,

por exemplo, o MPI, Message Passing Interface, que é um padrão para

comunicação de dados em computação paralela. O MPI tem por objetivo prover um

padrão para escrever programas paralelos com comunicação através de troca de

mensagens de forma prática, portátil, eficiente e flexível. Existem diversas

implementações de MPI, sendo o Open MPI a maior e mais ampla delas. O Open

MPI é um projeto open source mantido por um conjunto de universidades e

entidades de pesquisa, que proporciona a fácil utilização do MPI. (OPEN MPI

PROJECT, 2013)

Além das tecnologias abordadas por Ritter e Bordin (2009), a programação

paralela em Java, hoje em dia, vem se desenvolvendo através da biblioteca Java

Threads, nativa. A implementação de códigos paralelos é realizada através da

Classe Thread (java.lang.Thread). O uso desta classe permite definir algumas

configurações, como, por exemplo, de prioridade de execução das Threads, início e

parada de processamento e tipos de Thread. (JEVEAUX, 2012)

A partir da versão 1.5 do Java, ele passou a fornecer um melhor suporte para o

paralelismo de processamento através do pacote java.util.concurrent. Este novo

pacote fornece ferramentas mais simples para implementação de aplicativos

concorrentes, como, por exemplo, o bloqueio para proteger certas partes do código a

serem executadas por vários segmentos, ao mesmo tempo. (VOGEL, 2012)

Viry (2010) aborda a utilização do Java em computação de alta performance

(HPC - High-Performance Computing) e cita como vantagens da utilização do Java o

desenvolvimento mais ágil, maior confiabilidade do código, portabilidade e a

possibilidade de otimizações em tempo de execução.

Na mesma linha da linguagem Java, de linguagens de programação

gerenciadas,

a

Microsoft

vem

trabalhando

em

seu

principal

produto

de

20

desenvolvimento de softwares, o framework .NET, com o objetivo de melhorar e

facilitar as implementações paralelas através da biblioteca “Task Parallel Library”.

Segundo Macoratti (2011), a partir da versão 4.0 do .NET framework, um novo

modelo de programação paralela foi introduzido, permitindo ao programador focar

principalmente nas tarefas do softwares, e a criação e gerenciamento das Threads

fica sob a responsabilidade do runtime. A principal desvantagem é que ao usar este

recurso, o programador abre mão do controle direto do comportamento da sua

aplicação e isso pode não ser o cenário ideal para aplicações que requeiram um

controle e gestão mais refinado.

Há quem possa questionar o valor de um subsistema avançado em

linguagem gerenciada para escrever código paralelo. Afinal de contas,

paralelismo e simultaneidade dizem respeito a desempenho, e

desenvolvedores interessados em desempenho procuram por linguagens

nativas que ofereçam acesso extremamente rápido ao hardware e controle

total sobre cada manipulação de bit, de linha de cache e cada operação

sincronizada...certo? Eu temo pela situação de nossa indústria se esse for

realmente o caso. Linguagens gerenciadas, como C#, Visual Basic e F#

existem para oferecer a todos os desenvolvedores — tanto os meros

mortais como os super-heróis — um ambiente seguro e produtivo no qual se

possa desenvolver rapidamente código poderoso e eficiente. (TOUB, 2011)

Toub (2011) faz uma análise a respeito da evolução apresentada pelo .NET

Framework 4.0 para desenvolvimento paralelo, onde defende a simplificação e a

utilização de linguagens gerenciadas no desenvolvimento de softwares de alto

desempenho, principalmente paralelos.

Assim, analisando comparativamente, no momento atual o .NET se encontra

mais avançado no sentido de proporcionar facilidade de programação paralela aos

programadores do que o Java, porém este possui um maior controle dos processos

paralelos desenvolvidos, gerando talvez uma maior dificuldade no desenvolvimento

dos códigos fontes, mas o Java possui uma comunidade bastante sólida de

programadores, que se ajudam através da internet a fim de solucionarem os

problemas apresentados pelos colegas.

2.2 – Softwares científicos

O desenvolvimento de software científico, segundo Mohammad (2010), é um

processo pelo qual o software é criado para auxiliar cientistas e pesquisadores na

21

procura de solução para a sua meta. Mohammad (2010) acrescenta ainda que o

estudo de uma melhor abordagem de desenvolvimento de software científico está

em um estágio prematuro, devido ao fato de não existir uma definição formal de

levantamento de requisitos na investigação científica, dada a sua natureza muitas

vezes complexa.

Segundo Pressman (2006), software científico e de engenharia são

principalmente algoritmos de processamento de números. Mas as aplicações de

software científico e de engenharia vão muito além, da astronomia à vulcanologia,

da análise automotiva de tensões à dinâmica orbital do ônibus espacial, e da

biologia molecular à manufatura automatizada.

Assim, softwares científicos são considerados por Pankratius (2010) como mais

comuns na área da programação paralela por não necessitarem tanta robustez como

os softwares comerciais ou industriais, uma vez que a maioria das simulações pode

ser reiniciada, caso haja alguma falha. Contudo, os resultados dos softwares

científicos precisam ser confiáveis, o que é favorecido através de uma boa

engenharia software.

Segundo Pereira Junior (2007), as particularidades que os softwares científicos

apresentam em relação ao software comercial são principalmente: o papel do

cliente, a identificação dos requisitos e a alta rotatividade dos pesquisadores. No

desenvolvimento de um software científico não existe o papel do cliente. Este tipo de

software geralmente é construído por um pesquisador, com a finalidade de validar ou

apoiar sua própria pesquisa. Sendo assim, os pontos de validação existentes no

desenvolvimento de um software comercial inexistem no desenvolvimento de um

software científico. Além disso, na maioria das vezes, os pesquisadores não

possuem muita experiência com desenvolvimento de software, necessitando

aprender como se desenvolve em determinadas tecnologias para implementar seus

aplicativos.

A identificação dos requisitos ao longo do seu desenvolvimento pode mudar,

por exemplo, pela evolução da pesquisa. Sendo assim, o pesquisador e

desenvolvedor não tem o conhecimento dos detalhes do software científico como um

todo, diferentemente do software comercial em sua maioria.

E, por fim, há alta rotatividade dos pesquisadores em uma pesquisa.

Geralmente, um software científico é desenvolvido para validar uma determinada

22

parte de uma pesquisa e, ao término da pesquisa, o desenvolvedor se desvincula da

pesquisa, como acontece com os alunos de mestrado e doutorado, por exemplo. No

entanto, os próximos alunos frequentemente continuam o desenvolvimento do

software. Já no caso de softwares comerciais, frequentemente existe uma equipe de

desenvolvimento pré-definida e não se altera, ou se altera minimamente, até o

término do projeto. Além disso, no desenvolvimento de um software comercial

existem

pessoas

com

funções

distintas,

como

analistas

de

sistemas,

administradores da base de dados, engenheiros de testes, e programadores. No

desenvolvimento de um software científico, o pesquisador tende a desempenhar

todas estas atividades, e muitas das vezes apenas com o mínimo de conhecimento

em cada um dos papeis citados acima.

2.3 – Arquiteturas paralelas

Uma arquitetura paralela de computador pode ser definida como aquela que

permite a computação ou execução de vários cálculos simultaneamente. Isto se

torna possível devido à presença de várias unidades de processamento dedicadas

ao ambiente de execução. Segundo Rose (2010), as arquiteturas paralelas

contribuem para o ganho de desempenho em relação às arquiteturas convencionais,

sendo alternativa quando os limites físicos são alcançados. Hoje, já existe demanda

de aplicações de alto desempenho como simulações de previsão de tempo, modelos

físicos ou biológicos, computação gráfica, entre outros.

As arquiteturas de computadores são classificadas segundo o modelo, pelo

fluxo de instruções e pelos dados que se apresentam. Essa classificação é definida

como taxonomia de Flynn e fica divida em quatro categorias, conforme listadas

abaixo: (FLYNN, 1966, apud COSTA, 2006).

• SISD (Single Instruction stream and Single Data stream): Arquitetura onde

uma unidade de processamento pode executar uma única instrução em um único

conjunto de dados, não há paralelismo. Corresponde a arquitetura de Von Neumann.

Há aproximadamente uma década, essa arquitetura tem deixado de ser o padrão na

construção de computadores, sendo substituída por computadores com arquitetura

do tipo SIMD e MIMD.

• SIMD (Single Instruction stream and Multiple Data stream): Arquitetura onde

uma unidade de processamento pode executar uma mesma instrução e operar em

23

múltiplos conjuntos de dados. Aplicações que precisam executar a mesma operação

em grandes vetores ou matrizes podem tirar vantagem desse tipo de arquitetura.

• MISD (Multiple Instruction stream and Single Data stream): Arquitetura onde

múltiplas

unidades

de

processamento

executam

diferentes

instruções

simultaneamente em um mesmo conjunto de dados.

• MIMD (Multiple Instruction stream and Multiple Data stream): Arquitetura onde

múltiplas

unidades

de

processamento

executam

diferentes

instruções

simultaneamente em diversos conjuntos de dados diferentes.

Estas

arquiteturas

ainda

podem

ser

classificas

também

segundo

o

compartilhamento de memória como multiprocessadores ou multicomputadores. Os

computadores multiprocessados compartilham uma memória central, com um único

espaço de memória que é utilizado por todos os núcleos de processamento. Neste

tipo de arquitetura, normalmente a comunicação e a sincronização entre os

processos é feita através de variáveis compartilhadas. (ROSE, 2010)

Já no caso dos multicomputadores, a memória não é compartilhada, ou seja,

cada elemento de processamento possui seu próprio espaço de memória, e a

comunicação e a sincronização normalmente é realizada através da troca de

mensagens.

2.3.1 – Multicore

Atualmente, os hardwares paralelos mais comuns são as arquiteturas

multicores, ou seja, arquiteturas com múltiplos núcleos de processamento. Esta

tecnologia implica em introduzir vários núcleos de processamento dentro de um

mesmo encapsulamento físico, permitindo a execução de diversas instruções

simultaneamente. Segundo Domeika (2008), multicore é um processador composto

por réplicas idênticas e funcionais de um processador ou várias unidades funcionais

distintas, agregando muita flexibilidade em termos da distribuição da aplicação.

Há alguns anos, a comparação entre processadores era bem mais simples,

bastando analisar a frequência de operação entre eles. No entanto, este paradigma

tornou-se insustentável a partir do momento em que altas frequências geravam uma

quantidade muito grande de calor que provocava limitações nos sistemas, além de

acarretar alto consumo energético. Assim, surgia a nova era dos processadores

multicores, que utiliza diversos núcleos com frequências de processamento mais

24

baixas dentro de um mesmo chip. (SULEMAN, 2011)

Ainda segundo Suleman (2011), núcleos com frequências mais baixas tendem

a ser mais eficientes devido a três razões: primeiramente, devido à economia de

energia proporcionada pela diminuição da dissipação de calor; pela diminuição da

especulação, pois núcleos mais rápidos tendem a ser mais especulativos confiando

mais em valores previstos, sem esperar a confirmação do resultado final, mas isso

pode gerar erros; e, por fim, pela diminuição da potência dos flip-flops, pois núcleos

mais rápidos tendem a possuir pipelines mais profundos na busca por alto

desempenho, e quanto mais estágios de pipelines, maior será o numero de flip-flops,

gerando maior gasto de energia.

Os multicores representam o caminho da evolução dos processadores, pois

representam a replicação real dos recursos de vários processadores dentro de um

único chip, sendo que cada núcleo possui sua própria memória cache e todos eles

ainda compartilham uma memória cache geral do chip. (MIDORIKAWA, 2010)

É importante definir a diferença entre processadores multicores e sistemas

multiprocessados, sendo que um sistema multiprocessado consiste em múltiplos

processadores interconectados em um único sistema ou um único computador,

sendo que cada um destes processadores ainda podem ser core simples ou

multicore (Figura 4). Já os processadores multicores possuem vários núcleos de

processamento dentro de cada processador. Então, pode-se entender que um

computador pode ser multiprocessado e multicore ao mesmo tempo, uma vez que

são conceitos distintos.

Figura 4: Configurações de sistemas

Fonte: Domeika (2008)

25

Atualmente no mercado já estão disponíveis processadores para uso

doméstico de 6 (seis) núcleos, como o caso do Intel i7 980X, com tecnologia HyperThreading, capaz de emular o dobro de núcleos, resultando teoricamente em 12

(doze) núcleos de processamento. Este tipo de processador atualmente atende

perfeitamente a demanda de performance dos usuários domésticos e a maioria dos

usuários profissionais, sendo perceptível a melhora de performance em relação a

modelos anteriores como o Intel i5 somente em trabalhos gráficos como

renderização de vídeos ou cálculos matemáticos pesados. (JORDÃO, 2010)

2.3.2 – Cluster

Existem, além das arquiteturas paralelas citadas acima, alguns tipos de

hardwares que são paralelos, como, por exemplo, os Clusters. Um Cluster pode ser

definido como um sistema constituído de vários processadores, na maioria dos

casos através de uma rede de alta velocidade, onde trabalham de maneira conjunta

para realizar um processamento pesado, dividindo as tarefas de processamento e

trabalhando como se fosse um único computador.

Na década de 1960, a IBM começou a desenvolver uma forma de interligar

grandes mainframes, visando obter uma solução comercialmente viável de

paralelismo, sinalizando o que viria a ser definido como Cluster de Computadores.

A IBM desenvolveu o Cluster de mainframes através do Parallel Sysplex

System, um sistema que permitia ao hardware, ao sistema operacional, ao

middleware e ao software de gerenciamento do sistema prover uma grande melhora

na performance e diminuição dos custos. Este modelo de Cluster ganhou força até

que três tendências se consolidaram nos anos 1980: microprocessadores de alta

performance, redes de alta velocidade e ferramentas padronizadas para computação

distribuída de alto desempenho. Mas, uma quarta tendência, a crescente

necessidade de poder de processamento para aplicações científicas e comerciais,

com um alto custo e baixa acessibilidade dos tradicionais supercomputadores,

enfraqueceu o modelo de Cluster da IBM.

No final de 1993, Donald Becker e Thomas Sterling iniciaram um esboço de um

sistema de processamento distribuído construído a partir de hardware convencional

como uma medida de combate aos altos custos dos supercomputadores. No início

26

de 1994 criaram o primeiro cluster com estas característica, o projeto Beowulf. O

protótipo inicial era um cluster de 16 processadores ligados por dois canais Ethernet

acoplados. A máquina foi um sucesso instantâneo e esta idéia rapidamente se

espalhou pelos meios acadêmicos, pela NASA e por outras comunidades de

pesquisa. (JORGE NETO, 2012)

Pitanga (2004) diz que as características fundamentais para a construção de

Clusters são principalmente a confiança, a distribuição de carga e o desempenho.

Ainda segundo Pitanga (2004), os Clusters são classificados como:

• Cluster de Alta Disponibilidade (High Availability (HA) and Failover): Estes

modelos de clusters são construídos para prover uma disponibilidade de serviços e

recursos de forma ininterrupta através do uso da redundância implícita ao sistema.

• Cluster de Balanceamento de carga (Load Balancing): Este modelo distribui o

tráfego entrante ou requisições de recursos provenientes dos nós que executam os

mesmos programas entre as máquinas que compõem o Cluster.

• Combinação HA & Load Balancing: Como o próprio nome diz, combina as

características dos dois tipos de Cluster, aumentando assim a disponibilidade e

escalabilidade de serviços e recursos.

Cluster de Processamento Distribuído ou Processamento Paralelo: Este

modelo de Cluster aumenta a disponibilidade e desempenho para as aplicações,

particularmente para as grandes tarefas computacionais. Uma grande tarefa

computacional pode ser dividida em pequenas tarefas que são distribuídas ao redor

das estações (nós), como se fosse um supercomputador massivamente paralelo.

Em um ambiente de cluster de computadores, conforme o texto de Appel et al.

(2012), a alocação de recursos é efetuada por domínio administrativo centralizado,

tornando o processo de utilização e o recurso mais seguros, uma vez que a rede de

interconexão esteja desconectada da rede de acesso externo. Além disso, este tipo

de ambiente pode se beneficiar de protocolos de comunicação mais eficientes entre

suas unidades de processamento, pois como a rede de interconexão pertence ao

mesmo domínio administrativo, o recurso é controlado.

Nos dias atuais, as maiores arquiteturas de processamento de alto

desempenho são montadas em Clusters de computadores e classificados

mundialmente conforme o desempenho pelo site http://top500.org. As listas são

atualizadas semestralmente, nos meses de junho e novembro. Segundo a última

27

lista disponibilizada, de novembro de 2012, o primeiro Cluster do ranking é o Titan Cray XK7 , Opteron 6274 16C 2.200GHz da Cray Gemini interconnect, com 560.640

núcleos de processamento, localizado nos Estados Unidos. Na segunda posição do

ranking está o projeto Sequoia da IBM. No Brasil, segundo o mesmo ranking, o

maior Cluster é o Grifo04, um Itautec Cluster, Xeon X5670 6C 2.930GHz Infiniband

QDR, NVIDIA 2050, da Petrobras, classificado na 98º posição no mundo.

2.3.3 – Grid Computing

Segundo Poderoso (2004), Grid Computing pode ser entendido como

computação

por

demanda

ou

computação

em

grade.

Os

recursos

são

dinamicamente alocados para atender as necessidades do sistema na hora em que

eles realmente precisam. É possível entender este conceito como sendo um grupo

de equipamentos compartilhando seus recursos através de redes de altíssima

velocidade. Estas redes seriam capazes de atender às demandas pelas requisições

e os recursos deveriam estar sob o controle de algo que pudesse, dinamicamente,

distribuir o serviço de modo a equilibrar esta equação.

Em um ambiente de Grid, a alocação de recursos normalmente é realizada por

administração descentralizada, ou seja, cada organização, ou nó de processamento,

controla seus próprios recursos, aplicando políticas conforme sua demanda de

utilização. Existe, ainda, a possibilidade de heterogeneidade das arquiteturas e

sistemas operacionais empregados, característica típica de um Grid. Assim, um

grande desafio é obter uma forma de encapsular estas diferenças sem comprometer

a performance do Grid como um todo. A infraestrutura deste ambiente deve permitir

o acesso consistente aos recursos através de serviços padronizados, com interfaces

e parâmetros muito bem definidos. Sem estas normas, os serviços prestados podem

ser ineficazes. (APPEL et al., 2012)

Os Grids são comumente utilizados em projetos de organizações, que podem

ser empresas comerciais ou não, universidades, dentre outras, que necessitam de

longas horas de processamento mas não possuem esta capacidade disponível.

Assim são criadas comunidades em que usuários comuns da Internet oferecem

períodos ociosos de seus computadores para ajudar nestes processamentos. Um

exemplo deste tipo de organização é o Boinc (BOINC, 2012), onde cada nó de

processamento é cadastrado como voluntário no site e fica disponível para ser

utilizado em seus momentos ociosos de processamento, assim como os nós de

28

processamento. Organizações interessadas nestes nós disponíveis podem cadastrar

seus projetos e utilizar todo este potencial disponibilizado através da rede.

Mas os Grids podem ser utilizados também através de redes privadas de

dados, onde todos os nós de processamento utilizados pertencem a uma mesma

rede. Isto proporciona maior potencial de utilização, devido às pequenas distâncias

entre os computadores, e garante também mais segurança nos dados processados.

Um exemplo de aplicativo utilizado para o gerenciamento de Grid Computing é

o JPPF Grid. O JPPF Grid permite a configuração e disponibilização de vários nós

de processamento em uma rede, além do gerenciamento completo do Grid através

de um aplicativo em Java. Por ser desenvolvido em Java, o JPPF ainda possui a

característica de ser multiplataforma e não necessitar de instalação para o seu

funcionamento. (JPPF, 2012)

Cluster e Grid são arquiteturas semelhantes, sendo a principal diferença entre

eles é que um cluster possui um controlador central, ou seja, um único ponto de

onde é possível utilizar todo o poder de processamento do cluster; os demais nós

são apenas escravos que servem a este nó central. Já o Grid pode ser definido

como uma arquitetura mais "democrática" onde, embora possa existir algum tipo de

controle central, se tem um ambiente fundamentalmente cooperativo. Os nós de

processamento ou computadores compartilham os seus ciclos ociosos de

processamento em seus sistemas, e em troca podem utilizar parte do tempo de

processamento do Grid. (MORIMOTO, 2005)

Appel et.al (2012) faz uma comparação interessante entre as características

das arquiteturas de Cluster e Grid Computing, resumida na Figura 5 mostrada

abaixo. Apenas o item que trata a segurança do processamento e do recurso é

questionável, uma vez que, de acordo com a informação tratada pelos

computadores, a segurança pode se tornar um fator muito importante.

Figura 5: Diferenças entre as configurações de Cluster e Grid.

Fonte: APPEL et al. (2012)

29

2.3.4 – Cloud Computing

Também conhecido no Brasil como computação nas nuvens ou computação

em nuvem, Cloud Computing se refere, essencialmente, à idéia de se utilizar, em

qualquer lugar e independente de plataforma, as mais variadas aplicações por meio

da internet com a mesma facilidade de tê-las instaladas em computadores próprios,

como apresentado na Figura 6. Intimamente ligado ao Cloud Computing está o

conceito de Software as a Service (SaaS), ou Software como Serviço. Em sua

essência, trata-se de uma forma de trabalho onde o software é oferecido como

serviço, assim, o usuário não precisa adquirir licenças de uso para instalação ou

mesmo comprar computadores ou servidores para executá-lo. Nesta modalidade, no

máximo, paga-se um valor periódico, como se fosse uma assinatura, somente pelos

recursos utilizados e/ou pelo tempo de uso. Surgem ainda, neste mesmo sentido, a

Platform as a Service (PaaS) ou Plataforma como Serviço, Database as a Service

(DaaS) ou Banco de Dados com Serviço, Infrastructure as a Service (IaaS) ou

Infraestrutura como Serviço, e Testing as a Service (TaaS) ou Testes como Serviço

(ALECRIM, 2011).

Figura 6: Cloud Computing.

Fonte: Adaptado de Nacionalhost (2011)

O Cloud Computing é um modelo que provê um melhor aproveitamento dos

investimentos em hardware. Nesse ambiente, não se tem a garantia de que os

processos serão todos alocados numa mesma máquina, caracterizando assim o

30

processamento distribuído, porém sem a necessidade de linguagens paralelas ou

extensões de programação. Um dos pilares do Cloud Computing é a consolidação

dos recursos de hardware para que eles possam ser aproveitados ao máximo e

gerenciados de forma inteligente, proporcionando economia de custos (NACIONAL

HOST, 2011). Porém, esta proposta de transparência pode limitar o aproveitamento

do hardware, pois limita o controle dos aplicativos, confiando apenas no potencial do

software gerencial do sistema de Cloud Computing para a distribuição das tarefas a

serem processadas.

Conforme Armbrust et al. (2010), as empresas com grandes lotes tarefas

podem obter resultados tão rapidamente quanto seus programas puderam escalar,

isto porque podem usar 1.000 servidores para uma hora de processamento

custando não mais do que usando um único servidor para 1.000 horas de

processamento. Essa elasticidade de recursos, sem pagar um alto valor pela alta

escalabilidade, é sem precedentes na história da TI.

De um provisionamento de hardware e do ponto de vista de custos,

três aspectos são novos na computação em nuvem.

•

A aparência de infinitos recursos computacionais disponíveis

sob demanda, com rapidez suficiente para acompanhar picos de carga,

elimina a necessidade de planejamento a longo prazo dos recursos

computacionais pelos usuários.

•

A eliminação de um compromisso antecipado pelos usuários

na nuvem permite que as empresas comecem utilizando poucos recursos

de hardware e aumentem seus recursos apenas quando há necessidade.

•

A possibilidade de pagar pelo uso de recursos de computação

em uma base de curto prazo, conforme a necessidade (por exemplo, os

processadores por hora e armazenagem por dia) e liberá-los, se necessário,

permitindo que máquinas e armazenamento fiquem disponíveis quando não

estão mais em uso. (ARMBRUST et al., 2010)

Ainda segundo Armbrust et al. (2010), a construção e operação em larga

escala de data centers locáveis com baixo custo foram a chave para o sucesso do

Cloud Computing, que proporcionou ainda a queda dos custos com energia elétrica,

bandas de rede, licenças de softwares e investimentos em hardware. Estes fatores

combinados com análises estatísticas de utilização proporcionaram ainda mais a

diminuição dos custos com serviços de TI através do Cloud.

Assim, diante dos conceitos e diversas arquiteturas apresentados, e pelo fato

de que se deve conseguir o melhor aproveitamento do potencial oferecido por cada

solução, propõe-se que o software deve ser concebido em arquitetura paralela,

31

desenvolvendo-se softwares paralelos de alta qualidade. Por conseguinte, o foco

deste trabalho se volta à Engenharia de Software paralelo.

2.4 – Visão geral da Engenharia de Software

Provavelmente a primeira vez em que se utilizou o termo “Engenharia de

Software” foi em uma conferência com esse nome, realizada em 1968, na Alemanha.

O termo “Engenharia de Software” foi escolhido para destacar o quanto era

necessário que a produção de software fosse baseada nos fundamentos teóricos e

nas disciplinas práticas conhecidas nos diversos ramos da engenharia. E o seu

surgimento se deu principalmente devido à crise do software que aconteceu naquela

época, conforme descrito por Dijkstra (1972):

A maior causa da crise do software é que as máquinas

tornaram se várias ordens de magnitude mais potentes! Em termos

diretos, enquanto não havia máquinas, programar não era um

problema; quando tivemos computadores fracos, isso se tornou um

problema pequeno e agora que temos computadores gigantescos,

programar tornou-se um problema gigantesco. (DIJKSTRA, 1972)

E hoje, com o continuo desenvolvimento dos computadores, principalmente

com tecnologias de processamento paralelo e distribuído, a necessidade de

constante evolução da produção de software é mais que presente.

Em 1969, Fritz Bauer definiu Engenharia de Software como, “o estabelecimento

e uso de sólidos princípios de engenharia para obter software confiável e que

trabalhe de forma eficiente em máquinas reais.” (BAUER,1969).

Segundo Sommerville (2007), a Engenharia de Software é uma disciplina da

Engenharia que se preocupa com todos os aspectos necessários para a produção

de um software de qualidade, e cujos princípios contribuem para a construção de

sistemas computacionais complexos. Pressman (2006) faz uma abordagem ainda

mais ampla em relação à Engenharia de Software, considerando como uma

tecnologia em camadas que integra processo, métodos e ferramentas para o

desenvolvimento de softwares de computador e deve se apoiar em um compromisso

organizacional com a qualidade.

Assim, entende-se que a Engenharia de Software tem como foco o

desenvolvimento de software dentro dos custos adequados e com alta qualidade.

Pressman (2006) aborda o Processo de Software, como parte da Engenharia de

32

Software, onde quando se elabora um produto ou sistema é importante percorrer

uma série de passos previsíveis, sendo como um roteiro que ajuda a criar um

resultado de alta qualidade, dentro de um prazo razoável. Ainda segundo Pressman,

para todo desenvolvimento de software é recomendada a utilização de um processo

adequado para se garantir o controle e organização das atividades a serem

executadas, seja um processo específico para o tipo de software a ser desenvolvido

ou ainda que seja um processo adaptado para a realidade do projeto em

desenvolvimento.

Além do processo de software, a qualidade do software também é um ponto

fundamental, conforme citado acima por Pressman(2006) e Sommerville (2007),

estando ligada diretamente aos requisitos. Um software de qualidade é aquele que

realiza corretamente todas as funções, ou requisitos, a que se foi proposto executar,

com eficiência e eficácia. Geralmente, a qualidade do produto é decorrente do

processo utilizado em sua elaboração, e pode ser detectada de diversas formas,

como, por exemplo, no caso de funções que não são executadas como deveriam, ou

quando se trata de programas difíceis de serem utilizados ou que não atendem aos

seus requisitos funcionais (PAULA, 2001).

Requisitos funcionais podem ser conceituados como o comportamento que se

espera que o software apresente diante de determinada ação realizada pelo usuário.

Já os requisitos não funcionais estão ligados a outros aspectos não relacionados

diretamente com a função específica do software, como por exemplo: usabilidade,

que define o grau de facilidade de uso do software; portabilidade, que mede o

esforço necessário para transferir um programa para outro ambiente; facilidade de

manutenção, ou seja, o nível de esforço necessário para se localizar os problemas e

realizar a manutenção em um programa (PAULA, 2001).

Em resumo, Almeida Filho (2011) apresenta exatamente o conceito de

Engenharia de Software e a sua ligação ao trabalho proposto, dizendo que ela está

preocupada em estruturar todo o processo de produção do software, desde o

primeiro contato com o cliente até a manutenção exigida após o software estar em

funcionamento, sempre tentando agregar técnicas, métodos, processos e outros

procedimentos e mecanismos para tornar o processo de desenvolvimento mais

racional, científico, repetível, de forma a se aproximar das engenharias tradicionais.

Pankratius (2010) vem trabalhando e pesquisando a fim de avançar os

conceitos, métodos e ferramentas de desenvolvimento de software paralelo, com

33

foco principal na Engenharia de Software totalmente interligada com as linguagens

de programação, compiladores, bibliotecas, middlewares e sistemas operacionais.

Ele acredita ser esta a base para tornar o desenvolvimento de software paralelo

mais fácil. Também, segundo Keutzer e Mattson (2010), a indústria de

desenvolvimento de softwares ainda não conseguiu uma solução efetiva para os

problemas da programação paralela, sendo a análise robusta dos softwares a chave

para o desenvolvimento de software paralelo de boa qualidade.

Assim, dentro destes conceitos sobre a Engenharia de Software propõem-se

algumas técnicas, que unidas ao processo de desenvolvimento de software,

possuem o objetivo de facilitar a utilização das arquiteturas paralelas em projeto de

softwares científicos e proporcionar a construção de softwares paralelos de

qualidade.

34

3 – PRINCIPAIS PROBLEMAS RELACIONADOS AO

PARALELISMO

Para o desenvolvimento de uma técnica de Engenharia de Software para

auxiliar, facilitar e incentivar o uso da programação paralela em projetos de software

científicos, foi realizado um levantamento bibliográfico a respeito dos principais

problemas relacionados à programação paralela, além da revisão bibliográfica, como

visto anteriormente, a respeito das arquiteturas paralelas ou de processamento

distribuído, das técnicas e linguagens de programação paralela e da Engenharia de

Software.

Através destes levantamentos bibliográficos, vislumbrou-se a possibilidade de

desenvolver e sistematizar um conjunto de técnicas com o objetivo que tornar a

programação paralela mais acessível através do desenvolvimento da Engenharia de

Software. Durante esta revisão, atentou-se para importantes pontos da programação

paralela como a granularidade, o controle do sincronismo e da comunicação entre as

tarefas a serem executadas em paralelo, e a escalabilidade. Percebe-se que todos

estes fatores podem ser analisados e planejados de forma inteligente, a fim de

minimizar problemas decorrentes de implementações de paralelismo de baixa

qualidade, ou simplesmente feitos com pouca precaução.

Um aplicativo desenvolvido com níveis de granularidade de paralelismo

inadequados para o ambiente, por exemplo, pode significar grandes perdas de

desempenho, que pode tornar a aplicação do paralelismo prejudicial ao aplicativo.

Assim como um controle ineficaz de sincronismo ou de comunicação pode significar

o

comprometimento dos resultados gerados pelo aplicativo,

ou ainda o

comprometimento de todo aplicativo, tornando-o inutilizável.

Assim, chegou-se à conclusão de que quanto melhor for a compreensão do

problema a ser solucionado e quanto melhor for o conhecimento do aplicativo a ser

desenvolvido, além da arquitetura de hardware que será utilizada para executá-lo,

menor será o custo de desenvolvimento e maior será a qualidade do produto final

desenvolvido.

3.1 – Levantamento bibliográfico

Através de uma revisão bibliográfica, abrangendo artigos publicados entre os

anos de 2009 e 2012, foram levantados e documentados alguns dos principais

35

problemas relacionados à programação paralela que são apresentados a seguir.

Abordado por Lee et al. (2010), Afek et al. (2012) e Allen et. al (2009), o

problema dos bloqueios (locks) em programas de memória compartilhada, assim

como o problema de escalonamento de tarefas ou alocação de recursos em

ambiente de processamento paralelo heterogêneo, citado nos artigos de Netto et al.

(2011), Pascual et al. (2011), Jeannot et al. (2012) e Casanova et al. (2010), são os

problemas que se apresentaram mais frequentes atualmente no desenvolvimento de

aplicações paralelas. Além dos problemas mencionados, conforme citado por Afek et

al. (2012) e Chen e Poirier (2010), a escalabilidade em arquiteturas paralelas

normalmente é comprometida devido ao desenvolvimento das aplicações paralelas

de forma ineficiente. Mais adiante, estes problemas serão abordados de forma mais

específica e detalhada.

Além dos problemas citados, que apareceram com mais frequência no

levantamento bibliográfico realizado e por isso serão abordados com mais

profundidade nos tópicos a seguir, outros problemas encontrados na literatura e

considerados pertinentes podem ser citados, como, por exemplo, a necessidade da

paralelização automatizada de aplicações seriais. No caso, Silva et al. (2009)

propôs, em seu artigo, “Mercury: A reflective middleware for automatic parallelization

of Bags of Tasks.”, o desenvolvimento de um middleware, o Mercury, que lê um

arquivo de configuração que contem informações de quais os métodos e classes

devem ser paralelizados, carrega o aplicativo e, em tempo de execução, o

transforma

de

modo

que

os

métodos

especificados

sejam

executados

paralelamente. A solução proposta utiliza meta-classes, permitindo que a

modificação do código possa ser feita em tempo de execução, sem necessidade de

transformar e recompilar o código fonte. Em seus experimentos, Silva et al. (2009)

concluiu que o Mercury pode lidar com a maioria das aplicações Bag-of-Tasks, que

são aplicações com um conjunto de tarefas independentes a serem executadas, e

até mesmo algumas aplicações com um fluxo de trabalho mais complexos. O

overhead provocado pelo Mercury foi baixo e facilmente vencido pelos ganhos na

facilidade de programação e melhorias de speed-up, mas ainda pode ser utilizado

somente em aplicações bem específicas.

Outro tema abordado é a melhoria de códigos paralelos em linguagens

orientadas a objetos. Noll e Gross (2012) propõem em seu artigo uma extensão para

códigos fonte escritos em Java e C# objetivando a sua melhoria sem a necessidade

36

do uso de bibliotecas específicas da linguagem, o que acontece na maioria das

implementações paralelas em tais linguagens. Em suas observações, eles

conseguiram um ganho de desempenho de 15% em comparação com uma versão

padrão de um mesmo aplicativo.

A limitação do paralelismo é um tema abordado por Allen et al. (2009) em seu

artigo “Serialization Sets: A Dynamic Dependence-Based Parallel Execution Model”,

em que os autores propõem um novo modelo de execução paralela onde os

programadores aprimoram um programa sequencial com pedaços de código

chamados “serializers”, que dinamicamente mapeiam operações computacionais em

conjuntos serializados de operações dependentes. Com este modelo, os conjuntos

de operações serializadas estabelecem uma ordenação lógica em todas as

operações, resultando em uma execução paralela previsível, que pode ser realizada

dinamicamente. Com o novo modelo, eles propõem que não codificando

estaticamente as partes paralelas, ou independentes, do código nos programas

pode se explorar melhor a concorrência.

3.1.1 – Bloqueios em Programas de memória compartilhada

Um problema relatado frequentemente na literatura atual são os bloqueios

(locks)

em

programas

paralelos

de

memória

compartilhada.

Isto

ocorre

principalmente por falhas no sincronismo das tarefas executadas paralelamente, pois

várias tarefas podem necessitar de um dado no mesmo instante, causando conflitos

e bloqueios.

O problema de locks em programas paralelos é abordado por Stivala et al.

(2010), em seu artigo ”Lock-free parallel dynamic programming”, através da

utilização de uma hashtable que armazena todos os resultados compartilhados, que

são computados por cada thread. Antes de executar um novo processo, a thread faz

uma busca na hashtable para saber se aquele processo já foi executado. Quando a

primeira thread verifica que todos os resultados já foram processados, a execução é

finalizada. Stivala et al. (2010) obteve ganho de speedup em diversos aplicativos

dinâmicos, como, por exemplo, o problema da mochila, que trata a otimização de

carga por peso e critério de benefício dos objetos a serem carregados.

Lee et al. (2010) aborda o problema como interferências e conflitos entre as

threads, em seu artigo “Adaptive execution techniques of parallel programs for

37

multiprocessors”, quando executam loops paralelos em arquiteturas de SMT

(Multiprocessadores multithreads), propondo uma técnica padrão onde os processos

paralelos são customizados em tempo de execução de acordo com parâmetros de

performance dinâmicos lidos do hardware. Segundo Lee et al. (2010), foram

alcançadas melhorias de desempenho de execução em 8 contextos de hardware

diferentes, executando aplicações numéricas.

O bloqueio de concorrência é abordado também por Afek et al. (2012) em seu

artigo,

“Interrupting

snapshots

and

the

JavaTM

size

method”,

que

trata

principalmente o paralelismo em um método nativo da linguagem Java TM, o método

size(), que apresenta perda de desempenho por apresentar bloqueios de

concorrência. Para a melhoria de performance do método é proposto um novo

algoritmo livre de bloqueios baseado em snapshot (estado de um sistema em um

determinado ponto no tempo). Segundo Afek et al. (2012), o grande progresso e

coerência das propriedades combinado com a alta escalabilidade do novo algoritmo

leva a crer que este é um bom candidato para a substituição da atual implementação

do método size() no pacote JavaTM para programação paralela.

Allen et al. (2009) também comenta em seu artigo sobre a necessidade de

controle nos processos de sincronização durante a programação paralela, propondo

que o seu modelo de execução visa aprimorar e facilitar o desenvolvimento de

aplicativos paralelos, evitando erros de sincronização, deadlock, livelock e inversão

de prioridades, problemas inerentes aos bloqueios. Allen et al. (2009) utilizou uma

biblioteca do C++, chamada Prometheus, nos testes realizados. Segundo Allen et al.

(2009), Prometheus alcançou bons resultados de desempenho, e em alguns casos

chegou a ter melhor desempenho que programas desenvolvidos exclusivamente

paralelo (que possuem um grau de dificuldade de implementação bem maior), com a

codificação significativamente menor e depuração menos complexa.

Enquanto isso, as práticas de programação modernas, incluindo o

uso de linguagens orientadas a objetos, bibliotecas dinâmicas, e sistemas

gerenciados em tempo de execução, permitiram o rápido crescimento da

indústria da tecnologia da informação. A vasta complexidade das

abordagens atuais para escrever e depurar programas paralelos ameaça

descarrilar este sucesso. Para evitar uma grande ruptura, devemos

identificar soluções que permitam a execução paralela de software sem

comprometer a produtividade do programador. (ALLEN et al., 2009)

38

3.1.2 – Escalonamento de tarefas

Especialmente em arquiteturas de processamento heterogêneas, um problema

que é ressaltado é o escalonamento de tarefas a ser realizado de forma a se

conseguir o processamento de todas as tarefas no menor tempo possível. Neste

sentido, alguns autores propõem algumas soluções a serem avaliadas.

Netto et al. (2011) propõe, em seu artigo “Use of run time predictions for

automatic co-allocation of multi-cluster resources for iterative parallel applications”,

uma técnica de co-alocação de recursos com reescalonamento iterativo de tarefas

com base em previsões de desempenho para multicluster de aplicações paralelas.

Esta técnica é direcionada somente para aplicações com etapas de execução

regular, ou seja, aquelas com carga de trabalho de computação uniforme em cada

iteração, pois podem ser realizadas previsões de tempo observando seu

comportamento em uma execução parcial curta. Segundo Netto et al. (2011),

utilizando a técnica de co-alocação dinâmica, os meta escalonadores ficam

responsáveis por tarefas de previsão de tempo de execução, mapeamento de

processos e reescalonamento de aplicações, tarefas antes atribuídas aos usuários.

Na aplicação dos estudos em 7 (sete) casos diferentes, as previsões de tempo de

execução tiveram um erro médio de apenas 7% e superestimativas de 35% e 57%

para reescalonamento de modelos síncronos e assíncronos, respectivamente. Por

conseguinte, os resultados encontrados permitem encorajar o desenvolvimento do

escalonamento dinâmico de tarefas de processamento paralelo utilizando a previsão

de tempo de execução.

Com uma idéia semelhante à de Netto et al. (2011), Pascual et al. (2011), em

seu artigo “Optimization-based mapping framework for parallel applications”, também

se utiliza de uma matriz de custos de processamento das tarefas e propõe um novo