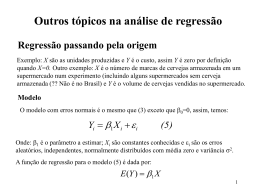

Universidade Federal de Alagoas Centro de Tecnologia Estatística Aula 25 Prof. Marllus Gustavo Ferreira Passos das Neves Adaptado do material elaborado pelo Prof. Christiano Cantarelli Rodrigues Aula 25 Análise de Regressão Correlação Introdução Existe relação entre o tempo em sala de aula e o salário? Existe relação entre a temperatura e o nível de oxigênio dissolvido em um rio? Existe relação entre a fração de área impermeável em um lote e a vazão gerada após uma chuva? Existe relação entre o nível de fibra de carbono em um material em que é fabricada uma estrutura e a resistência desta ao impacto? Existe relação entre as vazões médias mensais de 2 postos de monitoramento próximos? Existe relação entre o no de motos vendidas e o no de acidentes de trânsito? Análise de Regressão Técnica estatística usada para modelar e investigar a relação entre 2 ou mais variáveis a partir de dados amostrais 1) Pode ser usada para construir um modelo para prever um fenômeno exemplo: ano que vem, se forem vendidas x motos, teremos y acidentes ... 2) Pode ser usado também para otimizar um processo, determinar as variáveis que melhoram resposta de um processo ou para controlar um processo exemplo: modificar a temperatura num experimento não modifica em nada os resultados, mas se for modificado tal composto, o efeito é o desejado Análise de Regressão Suponha que um engenheiro esteja interessado em saber se a porcentagem de hidrocarbonetos presente em um condensador principal de uma unidade de destilação tem relação com a pureza do oxigênio produzido em um processo químico Chamando de x a pureza (%) e y a quantidade de hidrocarboneto (reagente, também em %) traçarse primeiramente um diagrama de dispersão A seguir os dados e o gráfico Análise de Regressão Pureza X(%) Y(%) 1 0,99 90,01 2 1,02 89,05 3 1,15 91,43 4 1,29 93,74 5 1,46 96,73 6 1,36 94,45 7 0,87 87,59 8 1,23 91,77 9 1,55 99,42 10 1,40 93,65 11 1,19 93,54 12 1,15 92,52 13 0,98 90,56 14 1,01 89,54 15 1,11 89,85 16 1,20 90,39 17 1,26 93,25 18 1,30 93,41 19 1,43 94,98 20 0,95 87,33 Diagrama de dispersão 100 Pureza (%) Reagente Observação 95 90 85 0,80 1,00 1,20 1,40 1,60 Reagente (%) Embora não vejamos uma curva, mas sim pontos dispersos, há forte indicação de que eles repousam aleatoriamente em torno de uma reta Análise de Regressão Tomando x = 1,2, esperaríamos que seu valor de y caísse na reta Análise de Regressão esperaríamos que y(1,2) caísse aqui Mas caiu aqui Isto ocorre porque Y é uma v.a. Análise de Regressão Se Y é uma v.a. possui uma distribuição de probabilidade possui valor esperado e possui variância Para um dado valor de x (tal como x = 1,2), Y possui valor esperado ou média que é aquele que esperaríamos que caísse bem na reta Então a média da v.a. Y está relacionada com x pela relação linear seguinte: E(Y | x) Y x 0 1x Análise de Regressão E(Y | x) Y x 0 1x Análise de Regressão Coeficientes de Regressão Y x 0 1x Interseção da reta Inclinação da reta A média de Y é uma função linear de x Mas um valor real qualquer observado y não cai exatamente na reta Análise de Regressão y y = (Y|x) + (Y|x) = 0 + 1x x Modelo Linear Probabilístico maneira mais apropriada para generalizar Y 0 1 x Erro aleatório Modelo de Regressão Linear Simples Análise de Regressão Y 0 1 x Modelo de regressão linear simples possui apenas uma variável independente x regressor v. a. Y: Valor esperado E(Y | x) Y x E(0 1x) E( ) Variância Var(Y | x) Var(0 1 x) Var( ) Análise de Regressão Supondo que a v.a. tenha valor esperado (média) 0 e variância s2 E(Y | x) 0 1x Var(Y | x) s 2 1) o modelo verdadeiro de regressão é uma linha de valores médios 2) 1 é a mudança média de Y para uma mudança unítária de x Análise de Regressão Supondo que a v.a. tenha valor esperado (média) 0 e variância s2 E(Y | x) 0 1x Var(Y | x) s 2 3) A variabilidade de Y, em um valor particular de x, é determinada pela variância do erro s2 4) Essa variância é a mesma para cada x distribuição de valores ao redor da média (Y|x) Regressão Linear Simples Possui apenas uma variável independente x regressor Possui apenas uma variável dependente aleatória Y variável de resposta Nosso objetivo é estimar os parâmetros populacionais 0 e 1, ou seja, teremos estimativas pontuais, vindas de amostras retirada de 2 populações E(Y | x) 0 1x Que populações? Estimar Regressão Linear Simples As populações são de X e Y A regressão linear simples supõe ser possível uma relação linear entre as 2 populações X Y 0 e 1 Amostra Amostra x , x , ..., x 1 2 n y , y , ..., y 1 2 n ˆ0 e ˆ1 Estimativas pontuais de 0 e 1 A estimativa dos parâmetros do modelo pode ser feita pela estimativa 1 n y yi dos mínimos quadrados: n 1 n x xi n i 1 i 1 ˆ1 Sxy Sxx ˆ0 y ˆ1 x Regressão Linear Simples x i n xi2 i 1 n i 1 n Fórmulas n n S xx (xi x ) S xy yi (xi x ) 2 i 1 n n xi yi n yi xi i 1 i 1 n i 1 2 i 1 ˆ0 y ˆ1 x ˆ1 S xy S xx Yˆ ˆ0 ˆ1 x Reta que melhor se ajusta aos pontos 2 Regressão Linear Simples Modelo de Regressão Linear Simples Y 0 1 x Resíduo do Modelo de Regressão Linear Simples i yi yˆi Yˆ ˆ0 ˆ1 x Amostras x,y Regressão Linear Simples Como se obtiveram estas fórmulas? yi 0 1 xi i Para cada ponto xi, yi Logo, isolando o resíduo i i yi 0 1 xi Criando a função abaixo, derivando em relação aos estimadores de 0 e 1 e igualando a zero chagamos nas fórmulas n n n ( L ( yi yˆ i ) yi ˆ0 ˆ1 xi i 1 L 0 2 i ˆ0 , ˆ1 2 i 1 L 0e 1 i 1 0 ˆ0 , ˆ1 ) 2 método dos mínimos quadrados Aplicações Exemplo da relação entre a porcentagem de hidrocarbonetos e a pureza do oxigênio produzido em um processo químico Reagente Pureza X(%) Y(%) 1 0,99 90,01 2 1,02 89,05 3 1,15 91,43 4 1,29 93,74 5 1,46 96,73 6 1,36 94,45 7 0,87 87,59 8 1,23 91,77 9 1,55 99,42 10 1,40 93,65 11 1,19 93,54 12 1,15 92,52 13 0,98 90,56 14 1,01 89,54 15 1,11 89,85 16 1,20 90,39 17 1,26 93,25 18 1,30 93,41 19 1,43 94,98 20 0,95 87,33 Observação Aplicações Exemplo: n 20 20 20 2 x i 29,29 xi 23,92 x 1,20 1 20 y i 1 1843,21 y 92,16 1 2 20 20 x y i i 2214,66 1 2 y i 170044,53 1 x i 2 n n ( ) 23 , 92 2 S xx (xi x ) xi2 i 1 29,29 0,68 n 20 i 1 i 1 n n xi yi n n (23,92)(1843,21) 10,18 2 S xy yi (xi x ) yi xi i 1 i 1 2214,66 n 20 i 1 i 1 S xy 10,18 ˆ 1 14,97 S xx 0,68 n Yˆ ˆ0 ˆ1x 74,20 14,97x ˆ0 y ˆ1x 92,16 (14,97)1,20 74,20 Aplicações Experimento Modelo Linear (Modelo) Pureza (%) 100 95 90 85 0,80 1,00 1,20 Reagente (%) 1,40 1,60 Aplicações Reagente Pureza X(%) Y(%) 1 0,99 2 Resíduo do Modelo de Regressão Linear Simples Modelo Resíduo 90,01 89,02 0,99 1,02 89,05 89,47 -0,42 3 1,15 91,43 91,42 0,01 4 1,29 93,74 93,51 0,23 5 1,46 96,73 96,06 0,67 6 1,36 94,45 94,56 -0,11 7 0,87 87,59 87,22 0,37 8 1,23 91,77 92,61 -0,84 9 1,55 99,42 97,40 2,02 10 1,40 93,65 95,16 -1,51 11 1,19 93,54 92,01 1,53 12 1,15 92,52 91,42 1,10 13 0,98 90,56 88,87 1,69 -1,50 14 1,01 89,54 89,32 0,22 -2,00 15 1,11 89,85 90,82 -0,97 16 1,20 90,39 92,16 -1,77 17 1,26 93,25 93,06 0,19 18 1,30 93,41 93,66 -0,25 19 1,43 94,98 95,61 -0,63 20 0,95 87,33 88,42 -1,09 i yi yˆi 2,50 2,00 1,50 Resíduo Observação 1,00 0,50 0,00 -0,50 -1,00 Propriedades dos estimadores Já vimos que Y e são variáveis aleatórias Vimos também que Var(Y) = Var() = s2, mas E(Y) = Y/x (reta de regressão) e E() = 0 Propriedades dos estimadores Os estimadores ˆ e ˆ também são variáveis 0 aleatórias 1 2 1 x 2 ˆ ˆ E( 0 ) 0 e Var( 0 ) s n S xx 2 s E(ˆ1 ) 1 e Var(ˆ1 ) S xx Pode-se mostrar que SQ E sˆ Estimador não tendencioso de s2 n2 2 n n i 1 i 1 onde: SQE i2 ( yi yˆi ) 2 SQT ˆ1S xy n n i 1 i 1 SQT ( yi y ) 2 yi2 ny 2 SQ soma dos quadrados, dos erros (SQE) e total (SQT) Testes de hipóteses na regressão linear O primeiro teste que veremos é para a significância da regressão, ou seja, responder a pergunta: existe evidência suficiente para afirmarmos que há uma relação linear entre x e y? Isto pode ser feito de 2 formas Teste t Tabela ANOVA teste F Suposições: 1) A componente do erro no modelo é uma v.a. que segue uma distribuição normal com média 0 e variância s2 ~ N(0, s2); 2) Quanto as demais v.a. Y ~ N(o+1x, s2), ˆ1 ~ N(β1,s 2/Sxx ) e ˆ0 ~ N( β0,s 2 (1/n x 2/Sxx ) ) Testes de hipóteses na regressão linear Usando o teste t para 1 : H0: 1 = 1,0 a inclinação da reta é igual a um valor constante 1,0 H1: 1 ≠ 1,0 ˆ1 1, 0 t Estatística de teste: sˆ 2 Sxx Se as suposições estiverem certas esta estatística segue a distribuição t com gl = n-2, sujeito a H0 acima. Rejeitamos H0 se |t| > tc, onde tc = ta,n-2 Testes de hipóteses na regressão linear Usando o teste t para 0 : H0: 0 = 0,0 a inclinação da reta é igual a um valor constante 0,0 H1: 0 ≠ 0,0 ˆ0 0,0 t Estatística de teste: 2 1 x 2 sˆ n Sxx Se as suposições estiverem certas esta estatística segue a distribuição t com gl = n-2, sujeito a H0 acima. Rejeitamos H0 se |t| > tc, onde tc = ta,n-2 Testes de hipóteses na regressão linear Usaremos o teste t para 1 para 1,0 = 0, ou seja: H0: 1 = 0 a inclinação da reta é nula não há relação linear entre x e Y ˆ1 H1: 1 ≠ 0 t sˆ 2 Estatística de teste: Sxx Verificaremos a significância da regressão Casos onde H0: 1 = 0 não é rejeitada Testes de hipóteses na regressão linear Verificaremos a significância da regressão Casos onde H0: 1 = 0 é rejeitada Aplicações Continuação do exemplo Reagente Pureza X(%) Y(%) 1 0,99 90,01 2 1,02 89,05 3 1,15 91,43 4 1,29 93,74 ˆ1 5 1,46 96,73 6 1,36 94,45 sˆ 2 7 0,87 87,59 8 1,23 91,77 9 1,55 99,42 10 1,40 93,65 11 1,19 93,54 12 1,15 92,52 13 0,98 90,56 14 1,01 89,54 15 1,11 89,85 16 1,20 90,39 17 1,26 93,25 18 1,30 93,41 19 1,43 94,98 20 0,95 87,33 Observação H0: 1 = 0 H1: 1 ≠ 0 t Sxx Calculados antes ˆ1 14,97 S xx 0,68 SQ E 2 Precisamos agora sˆ n2 n 2 2 ˆ SQE SQT 1S xy SQT yi ny i 1 Aplicações Continuação do exemplo n SQT yi2 ny 2 170.044,5 20 (92,16) 173,38 2 i1 SQE SQT ˆ1Sxy 173,38 14,97 10,18 20,985 Onde Sxy = 10,18 (calculado antes) SQE 20,985 2 sˆ 1,17 n 2 20 2 14,97 t 11,41 1,17 0,68 adotando a = 0,05 (2 caudas), com gl = n-2 = 18: tc = 2,101 rejeita H0 há evidências suficiente para a afirmação da relação linear entre x e y ANOVA: testar a significância da regressão Outra forma de fazer o mesmo teste é através da tabela ANOVA Col 1 Col 2 Col 3 Col 4 Col 5 Fonte de variação Soma dos Quadrados (SQ) Graus de liberdade Média Quadrática (MQ) Estatística de teste F Regressão SQR ˆ1Sxy 1 Num = Col 2/Col 3 Den = Col 2/Col 3 Erro SQE =SQT-SQR n–2 Total SQT n–1 Num / Den Aplicações Continuação do exemplo Col 1 Col 2 Col 3 Col 4 Col 5 Fonte de variação Soma dos Quadrados (SQ) Graus de liberdade Média Quadrática (MQ) Estatística de teste F Regressão 152,395 1 152,395 Erro 20,985 18 1,17 Total 173,38 19 Fc = F0,05;1;18 = 4,4139 rejeita H0 130,25 ANOVA: testar a significância da regressão Qual o significado de cada soma SQ da ANOVA? n 2 ( ) SQT yi y Soma Quadrática Total variabilidade total i 1 n 2 SQR ( yˆ i y ) Soma Quadrática da Regressão variabilidade devido à linha de regressão i 1 n SQE ( yi yˆ i ) i 1 2 Soma Quadrática dos Erros variabilidade residual sem explicação pela linha de regressão SQT SQR SQE ANOVA: testar a significância da regressão Qual o significado de cada soma SQ da ANOVA? n SQT ( yi y ) 2 i 1 n SQE ( yi yˆ i ) 2 i 1 n 2 ˆ SQR ( yi y ) i 1 SQT SQR SQE Desvio ou variação explicada é melhor a estimativa 13 do que simplesmente a média 9 para o valor real 19 IC para a resposta média Para um valor especificado de x, tal como x0, pode ser construído um IC para a resposta média E(Y| x0 ) Y x0 IC em torno da linha de regressão No ponto x0, o valor esperado é E(Y| x0 ) Y x0 0 1x0 Já a estimativa do valor esperado é ˆ Y x ˆ0 ˆ1x0 0 IC para a resposta média Nível de confiança x0 ˆY |x- Ex0 ˆY |x 0 x 0 ˆY |x + Ex0 0 ˆY |x Estimador não tendencioso de Y |x 0 0 IC para a resposta média Como temos ˆ ˆ normalmente distribuídos: e 0 1 ˆ Y|x 0 2 ( x0 x ) 2 1 ~ N Y|x0 , s Sxx n Var(ˆ Y|x0 ) Usando sˆ 2 como estimativa de s 2 E tc 2 ( x0 x ) Margem de erro da 2 1 sˆ predição em x0 Sxx n tc = ta,n-2 (2 caudas) Aplicações Continuação do exemplo Construir o intervalo de confiança para a resposta média, adotando NC = 95% Estimativa pontual para qualquer x0 ˆ Y x 74,2 14,97x0 0 Margem de erro para qualquer x0 tc = 2,101 2 1 (x0 1,20) 2 E 2,101 (1,17) 0,68 20 Aplicações Calculando a resposta média e a margem de erro para vários valores de x0, surge o gráfico abaixo Adequação do modelo de regressão Ajustar um modelo de regressão requer várias suposições • A estimação dos parâmetros 0 e 1 requer que os erros sejam v.a. não correlacionadas com média zero e variância s2 constante • Testes de hipótese e construção de IC requerem que os erros tenham distribuição normal A análise dos resíduos ou análise residual e o coeficiente de determinação R2 nos ajudam a verificar se o modelo é realmente adequado Adequação análise dos resíduos A análise dos resíduos é útil para verificar se eles seguem a distribuição normal Histograma de frequência dos resíduos Pode-se construir Gráfico de probabilidade normal dos resíduos Gráficos dos resíduos contra valores de y ou x Vamos ver nas aplicações Aplicações Continuação do exemplo Reagente Pureza Pureza prevista X(%) Y(%) (%) 1 0,99 90,01 87,22 2,786 2 1,02 89,05 88,42 0,628 3 1,15 91,43 88,87 2,559 4 1,29 93,74 89,02 4,720 5 1,46 96,73 89,32 7,410 6 1,36 94,45 89,47 4,981 7 0,87 87,59 90,82 -3,227 8 1,23 91,77 91,42 0,354 9 1,55 99,42 91,42 8,004 10 1,40 93,65 92,01 1,636 11 1,19 93,54 92,16 1,376 12 1,15 92,52 92,61 -0,093 13 0,98 90,56 93,06 -2,502 14 1,01 89,54 93,51 -3,971 15 1,11 89,85 93,66 -3,811 16 1,20 90,39 94,56 -4,169 17 1,26 93,25 95,16 -1,908 18 1,30 93,41 95,61 -2,197 19 1,43 94,98 96,06 -1,076 20 0,95 87,33 97,40 -10,074 Observação Erro Aplicações Continuação do exemplo Gráficos dos resíduos contra valores de y ou x Adequação análise dos resíduos Que tipos de gráficos podem aparecer? Crescendo com o tempo ou com a magnitude de y ou x Situação ideal Variância crescendo Testar outros modelos (parabólico, por exemplo) Variâncias desiguais Modelo linear inadequado Adequação coeficiente R2 Lembrando ... n 2 ( ) SQT yi y Soma Quadrática Total variabilidade total i 1 n 2 SQR ( yˆ i y ) Soma Quadrática da Regressão variabilidade devido à linha de regressão i 1 n SQE ( yi yˆ i ) i 1 2 Soma Quadrática dos Erros variabilidade residual sem explicação pela linha de regressão SQT SQR SQE Adequação coeficiente R2 Dividindo a equação SQT SQR SQE por SQT SQT SQR SQE SQT SQT SQT SQE SQR 1 SQT SQT SQE SQR Coeficiente de determinação R 1 SQT SQT 2 Frequentemente usado para julgar a adequação do modelo quantidade de variabilidade nos dados explicada ou considerada pelo modelo de regressão 0 ≤ R2 ≤ 1 Adequação coeficiente R2 O coeficiente de determinação deve ser utilizado com cuidado 1) R2 sempre aumentará se adicionarmos uma variável ao modelo, porém isso não significa necessariamente que o modelo novo é melhor que o antigo 2) Mesmo se x e y estiverem relacionados de maneira não linear, R2 será frequentemente grande 3) Mesmo com R2 grande, isto não implica que o modelo de regressão forneça previsões exatas para observações futuras Adequação coeficiente R2 Os 2 casos abaixo podem ter R2 grande, mas o caso 2 não é um caso de linearidade Aplicações n Nosso exemplo SQT ( yi y ) 173,37 2 i 1 n 2 ˆ SQR ( yi y ) 152,39 i 1 n SQE ( yi yˆ i ) 20,98 i 1 SQR SQE R 1 0,8790 SQT SQT 2 2 Correlação Vimos que o engenheiro extrai dados para seus estudos de duas maneiras: experimental x1, x2, ..., xn Sistema estudado Entrada controlada y1, y2, ..., yn saída não controlada observacional x1, x2, ..., xn Sistema estudado Entrada não controlada y1, y2, ..., yn saída não controlada Correlação Vimos que o engenheiro extrai dados para seus estudos de duas maneiras: experimental Exemplo da Eng. Civil: de forma controlada e cuidadosa, altero a forma como as formas são assentadas na construção observo se a velocidade no cronograma é alterada observacional Exemplo da Eng. Ambiental: realizo o monitoramento da quantidade de enxofre lançado na atmosfera por indústrias meço o pH da chuva na mesma região Correlação Fazemos uma análise de regressão quando supomos que a variável x seja uma variável matemática, medida com erro desprezível e a variável Y seja aleatória caso típico de experimentos Usamos o termo correlação quando as 2 variáveis x e Y são aleatórias. Neste caso, elas são distribuídas conjuntamente caso típico de observações Pode-se mostrar que o modelo matemático de regressão com as variáveis X e Y aleatórias é equivalente aquele mesmo modelo, considerando X controlada ou matemática Correlação Mas isto somente ocorre se X e Y forem distribuídas normal e conjuntamente Para o caso linear, surge então o chamado coeficiente de correlação R Pode-se mostrar que ele é a raiz quadrada do coeficiente de determinação que vimos antes SQE SQR R 1 SQT SQT 2 Coef. de determinação R R2 Coef. de correlação linear amostral O coeficiente R é, na verdade o estimador do coeficiente de correlação populacional r existe teste de hipótese para verificar se r = 0 ou r ≠ 0 Casos não lineares redutíveis ao linear Casos não lineares redutíveis ao linear Erros comuns envolvendo regressão 1) Concluir que a correlação implica em causalidade: podemos encontrar correlação entre o aumento de mortes de motociclistas e a venda de motos, mas não significa que mais motos vendidas causem mais mortes; 2) Outro erro surge de dados que se baseiam em médias: médias suprimem a variação individual e podem aumentar o R; 3) Outro erro envolve a propriedade de linearidade: pode existir uma relação entre x e y mesmo quando não há correlação linear significativa Resumo Tudo que foi visto pode ser resumido nos passos: 1) Traçar diagrama de dispersão verificar se o modelo linear é o que deve ser buscado 2) se for modelo linear passo 3, senão linearizar a equação passos adiante com x e y linearizados 3) Determinar a reta com o método dos mínimos quadrados 4) Fazer o teste para o estimador do coeficiente angular 5) Fazer o teste com a tabela ANOVA 6) Construir o intervalo de confiança 7) Verificar a adequação do modelo Aplicações Temos abaixo uma tabela com dados de densidade habitacional e fração de área impermeável, acompanhada do diagrama de dispersão. Podemos concluir que existe alguma relação entre as variáveis? Se positivo, seria linear ou não linear? Faça o estudo. Densidade Habitacional (hab/ha) 25 40 60 80 100 120 140 160 180 200 Fração da área impermeável (%) 11,3 26,7 36,7 46,6 49 53,4 57,2 60,4 63,2 65,8 Universidade Federal de Alagoas Centro de Tecnologia Estatística Aula 25 Prof. Marllus Gustavo Ferreira Passos das Neves Adaptado do material elaborado pelo Prof. Christiano Cantarelli Rodrigues

Download