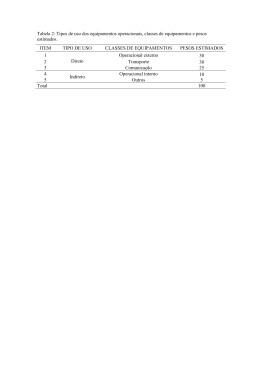

Utilização de Rede Neural Artificial na Obtenção dos Acréscimos de Tensão no Solo Devido a Carregamento Circular Marcos Antonio da Silva, Luiz Biondi Neto e Denise M. S. Gerscovich Programa de Pós-Graduação em Engenharia Civil - PGECIV, Faculdade de Engenharia, Universidade do Estado do Rio de Janeiro - UERJ, Rio de Janeiro RESUMO: Este artigo mostra a aplicação de uma ferramenta pouco utilizada na resolução de problemas geotécnicos, porém muito utilizada em outras áreas da ciência e tecnologia, e neste caso específico facilitará a obtenção de acréscimos de tensão no solo. Esta ferramenta foi criada devido contraste entre o processamento do cérebro humano e os computadores e chama-se Rede Neural Artificial (RNA). Será mostrada uma aplicação da utilização da RNA para facilitar a obtenção de valores acréscimos de tensão vertical contidos no ábaco de acréscimos de tensão devido a um carregamento circular. Esta facilidade se dá especialmente quando se tem um número grande de valores a serem retirados do ábaco. PALAVRAS-CHAVE: Rede Neural Artificial, Tensões Induzidas, Acréscimos de Tensão, Carregamento Circular. 1 INTRODUÇÃO Devido ao contraste na habilidade de processamento entre o cérebro e os computadores, surgiu a idéia de criar um paradigma para tentar imitar o modo de processamento do cérebro “Copiando a sua Estrutura” (Neto, 2006). Esta possui aproximadamente 1011 neurônios, com cerca de 104 a 105 sinapses por neurônio e corresponde a cerca de 2% do peso de um indivíduo adulto. Sabe-se que o cérebro tem a capacidade de processar dados em ciclos de 2ms (0,5KHz) e atualmente os computadores processam dados em ciclos de 0,25ns (4 GHz), isso nos leva a crer que o computador consegue processar dados 8.000.000 de vezes mais rápido, porém o cérebro, devido ao processamento altamente paralelo, reage a um estímulo mais rapidamente (Neto, 2006). Devido a similaridade com a estrutura do cérebro, as RNAs exibem características semelhantes ao do comportamento biológico humano, tais como: procura paralela e endereçamento pelo conteúdo, aprendizado, associação, generalização, abstração, robustez e degradação gradual. As Redes Neurais Artificiais podem ser utilizadas, em geral, em qualquer área que possua problemas de solução não algorítmica. Na área da medicina, podem ser utilizadas para diagnósticos em geral. Na área comercial e financeira são utilizadas para inúmeros tipos de avaliação e previsão de índices, taxas, etc. Na área da engenharia podem ser utilizadas para resolução de problemas de computação paralela, aproximação de funções, controle, reconhecimento de padrões, etc. (Osório, 2005) Neste trabalho o enfoque foi a utilização da Rede Neural Artificial para aproximação de funções com suas curvas representadas no ábaco de acréscimos de tensão devido a um carregamento circular, sendo apresentados os resultados de seu uso para a geração de acréscimos de tensão vertical no solo devido a um carregamento uniforme, circular e perfeitamente flexível e demonstrando a agilidade e a precisão quando é utilizado o processamento em lote disponibilizado pela RNA, quando se deseja obter os acréscimos de tensão em vários pontos. 2 REDE NEURAL ARTIFICIAL (RNA) A estrutura fundamental do sistema nervoso é o neurônio, este possui um corpo celular, um axônio e diversas ramificações (os dendritos). Os dendritos são dispositivos de entrada, que conduzem os sinais das extremidades para o corpo celular e o axônio é o dispositivo de saída, que transmite o sinal do corpo celular para suas extremidades (Juan e Dorado, 2005). As extremidades do axônio de um neurônio são conectadas com os dendritos de outros neurônios através das sinapses. A Figura 1 esquematiza a Rede Neural Biológica e a Figura 2 mostra esquema da Rede Artificial. Figura 1. Esquema da Rede Neural Biológica (http://www.sciam.ru/2005/5/neyrobiology.shtml). E. Transferência E. Processadores E N T R A D A S A Í D A Pesos ou seja, após concluído o treinamento a RNA gera resultados de saída de acordo com os padrões de entrada fornecidos ao executar a rede. Sem treinamento os valores dos pesos sinápticos são estabelecidos explicitamente (a priori). Os pesos não são obtidos através do processo de aprendizado, são simplesmente ajustados em um único passo. No treinamento supervisionado a Rede Neural é treinada através do fornecimento dos valores de entrada e seus respectivos alvos , isto é, valores de saída desejados (Pares de Treinamento). A Rede é treinada através de algoritmos de aprendizado como por exemplo: Perceptron e Backpropagation. O Perceptron é mais utilizado em problemas onde é possível uma separação Linear (ex.: classificação de vetores) e o Backpropagation é utilizado em problemas onde não há possibilidade de separação linear, casos tipicamente encontrados na engenharia (ex.: aproximação de função) (Fahlman, 1988). X1 X2 Função de Ativação W1 Σ W2 b -1 NET η (Tj- OUTj)X Figura 2. Exemplo de Rede Neural Artificial. As Redes Neurais Artificiais foram concebidas para serem estruturas altamente paralelas, baseadas em Processadores bem simples (modelo artificial do neurônio), e densamente interconectados (Braga et al., 2000). O processamento de uma Rede Neural Artificial pode ser dividido em duas fases: a primeira fase que é o treinamento, é onde acontece o processo de atualização dos pesos sinápticos e a segunda fase que é a execução, é onde ocorre o processo de cálculo da saída da Rede Neural dado um certo padrão [X] de entrada. O objetivo do treinamento é adquirir a informação e expressá-la sob a forma de uma matriz de pesos W (Zurada, 1992). Já o objetivo da execução é o de “recuperar” a informação, OUTj 1 NETj Tj- OUTj X η Tj Figura 3. Arquitetura do Perceptron. No algoritmo de aprendizado supervisionado, mostrado na Figura 3, os pesos sinápticos (W) são inicializados com valores randômicos, é aplicado um padrão de entrada e calculada a saída, fazendo uso da função de ativação. Se a saída estiver correta (OUTj = Tj) então aplicar novo padrão de entrada e calcular nova saída. Caso a saída esteja incorreta, calcula-se a variação dos pesos pela Equação 1, atualizam-se os pesos sinápticos e inicia-se novamente o processo aplicando novo padrão de entrada e calculando nova saída. Cada iteração deste processo é chamada de ano ou época. ΔWij = η (Tj - OUTj) X (1) onde: ΔWij = Variação dos Pesos Sinápticos, η = Taxa de Aprendizado, Tj = Alvo e OUTj = Saída Existem vários tipos de função de ativação, OUT=F(NET), e esta pode ser variada para cada tipo de problema, por exemplo, a função de ativação da Figura 3 é do tipo Degrau Simétrico, onde OUT=1 para NET>0 e OUT=-1 para NET<0. A Figura 4 mostra outros tipos de funções de ativação. Linear σ v = γ z cos(i ) (2) onde γ = peso específico do solo, i = ângulo de inclinação da superfície, z = profundidade e σv = tensão atuante na base do elemento de solo. b i Ed γ Ee Z σv Pseudo-Linear b . cos i b b NET NET Sigmóide Tansigmóide 1 1 NET -1 NET Figura 4. Funções de Ativação. No treinamento não supervisionado, a Rede Neural é treinada sem a exigência de uma matriz com os valores de saída desejados (alvo). 3 TENSÕES EM SOLOS 3.1 Tensões Iniciais As tensões iniciais são aquelas originadas pelo peso próprio do maciço. O cálculo deste estado de tensões pode ser bastante complexo em situações de grande heterogeneidade e topografia irregular (Bastos, 2002). No caso mostrado na Figura 5, a superfície do terreno é inclinada, o elemento de solo tem uma espessura unitária, o semi-espaço é infinito, o solo é homogêneo e situa-se acima do nível d’água. A partir do equilíbrio de esforços nas direções vertical e horizontal e assumindo que as resultantes Ed e Ee têm a mesma magnitude, chega-se a expressão para estimativa da tensão vertical; isto é: Figura 5. Caso Geral – Superfície Inclinada. Existem situações, entretanto, freqüentemente encontradas na geotecnia, em que o peso do solo resulta em um padrão de distribuição de tensões bastante simplificado. Esta situação, denominada geostática, corresponde a superfície do terreno horizontal, subcamadas horizontais e pouca variação das propriedades do solo na direção horizontal (Gerscovich, 2006). Nessa situação particular, representada na Figura 6, as tensões cisalhantes nos planos horizontal e vertical são nulas e a tensão vertical atuante na base do elemento é: σv = γ z (3) γ z σv b Figura 6. Caso Particular – Superfície Horizontal. 3.2 Tensões Induzidas Além do peso próprio da massa de solo, as tensões no solo podem variar devido a carregamentos externos, dando origem às tensões induzidas. A determinação da magnitude e distribuição dessas tensões no subsolo é muito importante na avaliação da estabilidade das obras de engenharia. É pratica corrente o uso da teoria da elasticidade para determinação das variações nos estado de tensão. Nestes casos assume-se o solo como um semiespaço homogêneo, linear e elástico (Lambe, 1979). Apesar de não descrever corretamente o comportamento tensão-deformação dos solos, a Teoria da Elasticidade fornece resultados satisfatórios no que diz respeito ao calculo das tensões (Gerscovich, 2006). Neste caso há que se utilizar parâmetros elásticos compatíveis com os níveis de tensão do projeto. Love, a partir da integração da solução de Boussinesq obteve soluções para carregamentos circulares uniformes, e perfeitamente flexíveis, Figura 7 (Bastos, 2002). As soluções analíticas para o calculo de tensões e deformações podem ser representadas graficamente. A Figura 8 mostra as isóbaras correspondentes ao acréscimo da tensão principal maior (Δσ1) tendo como parâmetros de entrada X/R e Z/R e a tensão aplicada na superfície (Δq) a z Figura 7. Carregamento Circular Figura 8. Ábaco para carregamento circular – Tensão vertical σ1 = σv. (Bastos, 2002) 4 MODELAGEM DO PROBLEMA UTILIZANDO A RNA Para a modelagem do problema utilizando RNA o ábaco da Figura 8 foi mapeado gerando os dados de entrada e saída, resumidos na Tabela 1. Tabela 1. Resumo dos dados de Entrada e Saída X/R Z/R Δσ1/Δq 0,000 0,000 0,000 .. . 0,730 0,800 0,400 0,400 0,500 0,880 .. . 0,200 0,000 0,000 0,950 0,900 0,700 .. . 0,950 1,000 1,000 Com esses dados a Rede Neural Artificial foi treinada utilizando o algoritmo “Backpropagation” para seu aprendizado e possuindo uma estrutura onde as duas primeiras colunas da Tabela 1 são os vetores de entrada e a última coluna é o vetor Alvo. Foram utilizadas três camadas escondidas de elementos processadores mais a camada de saída. A função de ativação dos elementos processadores pertencentes à primeira camada escondida foi definida como sendo sigmóide, da segunda camada do tipo linear, da terceira camada foi definida como sendo do tipo tangente hiperbólica e na camada de saída foi usada a função linear. Durante a modelagem foram feitas variações dos seguintes parâmetros: no de camadas escondidas, no de elementos processadores por camada, taxa de aprendizado, erro máximo permitido e forma de apresentação dos dados. Para modelagem, treinamento e posterior execução da Rede Neural, foi empregado o toolbox de Redes Neurais do software MATLAB® versão 7, desenvolvido pela empresa MATHWORKS®. sinal do gradiente em duas iterações sucessivas indica que a última atualização do peso foi excessiva, levando o sistema a saltar sobre um mínimo e sugerindo uma diminuição de Δij proporcional a η-. Em nosso caso quando o erro convergiu para um valor considerado satisfatório, o processo de treinamento foi finalizado e o conhecimento obtido foi armazenado em um arquivo sob forma numérica. 4.1 Treinamento da Rede A primeira fase de processamento, chamada de treinamento, foi caracterizada pela apresentação de padrões de entrada visando mapear o alvo que é o conhecimento que a Rede deve aprender. Nesta fase, os padrões são apresentados separadamente à RNA e o erro entre a saída obtida pelo processo iterativo do treinamento e o alvo, é medido. Em nossa Rede Neural, o treinamento foi feito com o algoritmo “Resilient Backpropagation” que, faz parte de uma classe de estratégias rápidas de adaptação local para treinamento de RNAs e seu algoritmo foi desenvolvido por Riedmiller e Braun (Riedmiller e Braun 1993). Este é um método independente da magnitude do gradiente do erro sobre o peso, no qual a atualização dos pesos depende, simplesmente, do sinal dos termos do gradiente e o aprendizado é feito por épocas. O ajuste dos pesos é realizado depois da apresentação completa de todo o padrão de treinamento à RNA. No método Resiliente, a variação dos pesos é feita de forma separada. Assim, os pesos Wij possuem uma taxa de variação própria Δij, com o tempo. O fato do gradiente do erro sobre o peso não mudar de sinal em duas iterações sucessivas indica que o sistema está se movendo na mesma direção, sugerindo um aumento de Δij proporcional a η+, visando acelerar a convergência. A mudança do Figura 9. Gráfico do Erro do Treinamento (MATLAB) A curva do erro medido pelo processo iterativo do aprendizado está representada na Figura 9, onde a convergência se deu após 3929 iterações ou “épocas”. Depois de treinada, a Rede está pronta para a segunda fase, que é a fase de execução. 4.2 Execução e Resultados Após a conclusão do treinamento foram apresentados à RNA vetores de entrada, também sob forma numérica, e que, não fizeram parte do treinamento, porém, são vetores que os seus respectivos vetores alvo foram retirados do ábaco e portanto também conhecidos. Ao executar a RNA, verificou-se que a mesma possui uma boa capacidade de generalização e foram apresentados resultados próximos aos dos vetores alvo. A comparação dos resultados da RNA com os vetores alvo obtidos pela solução gráfica (ábaco), geraram um erro máximo de 4,44%. Tabela 2 – Tabela Comparativa dos Resultados Vetores Vetores Vetores de Entrada ALVO de Saída X/R Z/R (Ábaco) (RNA) 7 Erro (%) 0,200 1,220 0,530 0,553 4,32 1,200 0,400 0,430 0,411 4,44 0,400 0,100 0,970 0,996 2,71 1,400 1,600 0,235 0,235 0,13 0,800 3,200 0,125 0,126 0,80 0,800 1,200 0,450 0,439 2,40 0,400 1,400 0,450 0,450 0,00 0,800 0,400 0,800 0,793 0,84 0,200 1,000 0,650 0,648 0,38 0,800 0,800 0,600 0,585 2,45 0,800 0,200 0,925 0,907 1,99 1,000 0,400 0,650 0,650 0,05 0,600 1,600 0,360 0,355 1,44 CONCLUSÕES Os resultados obtidos neste trabalho mostram que as Redes Neurais Artificiais conseguem resultados satisfatórios para esta aplicação na Geotecnia. Esta técnica se mostrou bastante eficaz, confiável e ágil, pois após a execução do treinamento da RNA, seu uso torna-se vantajoso quando comparado ao uso dos ábacos, devido à agilidade na obtenção dos resultados e a confiabilidade dos mesmos devido aos baixos erros obtidos pela rede. Outra vantagem da utilização da Rede Neural Artificial quando comparada aos métodos tradicionais acontece principalmente quando se tem diversos pontos do solo onde se deseja saber os acréscimos de tensão vertical, pois para tal é utilizado o processamento em lote, que executa a Rede com todos os pontos que se deseja obter os dados em um único passo, tornando rápida a obtenção desses acréscimos . REFERÊNCIAS Bastos, Cezar Augusto Burket. (2002). Tensões nos Solos, DMC/FURG, Rio Grande do Sul. Disponível em: <http://civmec.dmc.furg.br/~disp04084/>. Braga, Antônio; Ludermir, Teresa; Carvalho, André. (2000). Redes Neurais Artificiais: Teoria e Aplicações, editora LTC. Fahlman, Scott E. (1988). Computer Science Technical Report CMU-CS-88-162: An Empirical Study of Learning Speed in Back-Propagation Networks, Carnegie Mellon University-CMU. Disponível em: <http://www.cs.cmu.edu/Reports/index.html>. Gerscovich, Denise M. S. (2006). Apostila do Curso de Fundamentos Geotécnicos, Universidade do Estado do Rio de Janeiro - UERJ. Rio de Janeiro. Disponível em:<http://paginas.terra.com.br/educacao/deniseg/fun damentos/fundamentos.htm>. Haykin, Simon. (1999). Neural Networks: a Comprehensive Foundation, 2ed. Prentice-Hall. Juan, R. Rabunal e Dorado, Julian. (2005). Artificial Neural Networks in Real-Life Applications, Idea Group Publishing, Hershey-PA, USA. Lambe, T.W. and Whitman, R.V. (1979). Soil Mechanics - SI Version, John Willey & Sons. Neto, Luiz Biondi. (2006). Apostila do Curso de Inteligência Computacional, Universidade do Estado do Rio de Janeiro – UERJ, Rio de Janeiro. Osório, Fernando Santos. (2006). Redes Neurais Artificiais: Histórico, Modelos e Aprendizado, Universidade do Vale do Rio dos Sinos. Rio Grande do Sul. Disponível em: <http://www.inf.unisinos.br/~ osorio/neural.html>. Riedmiller, M., AND H. Braun. (1993). A Direct Adaptive Method For Faster Backpropagation Learning: The RPROP algorithm In Proceedings of the IEEE International Conference on Neural Networks, San Francisco. Zurada, J. M. (1992). Introduction to Artificial Neural Systems. West Publishing Company.

Download