CS276A

Text Retrieval and Mining

Lecture 10

Recapitulando a última aula

Melhorando os resultados das buscas

Especialmente para alto recall. Ex.: buscar por

aeronave para que corresponda a avião;

termodinâmica a calor

Opções para melhoria dos resultados…

Métodos Globais

Expansão da consulta

Tesauros

Geração automática de tesauro

Relevance Feedback global indireto

Métodos locais

Relevance feedback

Pseudo relevance feedback

Relevance feedback probabilístico

Ao invés de recalcular o peso em um vetor

espaço…

Se o usuário nos indicou alguns documentos

relevantes e alguns irrelevantes, então podemos

proceder à montagem de um classificador

probabilístico, tal como o modelo Naïve Bayes:

P(tk|R) = |Drk| / |Dr|

P(tk|NR) = |Dnrk| / |Dnr|

Tk é um termo; Dr é o conjunto de documentos

sabidamente relavantes; Drk é o subconjunto que contém

tk; Dnr é o conjunto de documentos sabidamente

irrelevantes; Dnrk é o subconjunto que contém tk.

Por quê utilizar probabilidades em RI?

Necessidade de

Informação do

usuário

Representação

da Consulta

Compreensão

da necessidade do

Usuário é incerta

Como determinar

equivalência?

Suposição incerta

Representação

sobre a relevância

Documentos

do documento

do

conteúdo do

documento

Em sistemas de RI tradicionais, a equivalência entre cada documento e a

consulta é testada em um espaço semanticamente impreciso de termos de

índice.

Probabilidades fornecem uma base de princípios para decisão incerta.

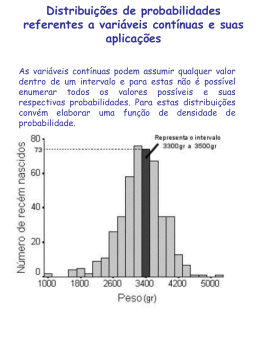

Tópicos de Probabilidade em RI

Modelo clássico de recuperação probabilística

Categoriazação de Texto (Naïve) Bayesiano

Redes Bayesianas para recuperação de texto

Abordagem de modelos de linguagem à IR

Princípio do ranking probabilístico, etc.

Uma ênfase importante em trabalhos recentes

Métodos probabilísticos são um dos tópicos mais

antigos mas também um dos mais discutidos em

RI.

Tradicionalmente: boas ideias, mas nunca

ganharam em performance. Pode ser diferente

agora.

O problema de ordem de documentos

Temos uma coleção de documentos

Usuário envia uma consulta

Uma lista de documentos precisa ser retornada

O método de ordenação é a essência de um

sistema de RI:

Em que ordem apresentamos os documentos ao

usuário?

Queremos o “melhor” documento primeiro, o segundo

melhor em segundo, etc…

Ideia: Ordenar pela probabilidade da relevância

do documento em relação à informação requerida

P(relevante|documentoi, consulta)

Relembrando o básico de

probabilidade

Para eventos a e b:

Regra de Bayes

p (a, b) p (a b) p (a | b) p (b) p (b | a ) p (a )

p (a | b) p (b) p (b | a ) p (a )

Anterio

p (b | a ) p (a )

p (b | a ) p (a )

p ( a | b)

p (b)

xa,a p(b | x) p( x)

Posterior

Probabilidade:

p(a)

p(a)

O( a )

p(a ) 1 p(a)

O Princípio da Ordenação por

Probabilidade

“Se a resposta de um sistema de recuperação de

referências a cada solicitação é subconjunto de

documentos de uma coleção em ordenação decrescente

da probabilidade de relevância ao usuário que enviou a

requisição, em que as probabilidades são estimadas com

o máximo de precisão, com base em qualquer dado que

tenha sido disponibilizado ao sistema com esse propósito,

então a eficácia geral do sistema ao seu usuário será o

melhor que se pode obter com bases nesses dados.”

[1960s/1970s] S. Robertson, W.S. Cooper, M.E. Maron;

van Rijsbergen (1979:113); Manning & Schütze (1999:538)

Princípio da Ordenação Probabilística

Seja x um documento em uma coleção.

Seja R a representação da relevância de um documento em relação a uma

dada (fixa) consulta e seja NR a representação da não-relevância.

R={0,1} vs. NR/R

Precisamos encontrar p(R|x) – a probabilidade de que o documento x seja

relevante.

p( x | R) p( R)

p( R | x)

p( x)

p( x | NR) p( NR)

p( NR | x)

p( x)

p(R),p(NR) – probabilidade

anterior de recuperar um

documento (não) relevante

p( R | x) p( NR | x) 1

p(x|R), p(x|NR) - probabilidade de que se um documento

relevante (não-relevante) for recuperado, ele seja x.

Princípio da Ordenação Probabilística

(PRP)

Caso simples: sem preocupação com custo de

seleção ou outros utilidades que mensurem erros

diferencialmente

Regra Ótima de descisão de Bayes

x é relevante se e somente se p(R|x) > p(NR|x)

PRP em ação: Ordene todos os documentos por

p(R|x)

Teorema:

O uso do PRP é ótimo, pois minimiza a perda (risco

Bayes) sob a perda 1/0

Demonstrável se todas as probabilidades forem

corretas, etc. [e.g., Ripley 1996]

Princípio da Ordenação Probabilística

Caso mais complexo: custos de recuperação.

Seja d um documento

C - custo de recuperação de um documento relevante

C’ – custo de recuperação de documento nãorelevante

Princípio da Ordenação Probabilística: se

C p( R | d ) C (1 p( R | d )) C p( R | d ) C (1 p( R | d ))

para todo d’ ainda não recuperado, então d é o

próximo documento a ser recuperado

Não iremos mais considerar perda/utilidade a

partir de agora

Princípio da Ordenação Probabilística

Como computamos todas essas probabilidades?

Não sabemos as probabilidades exatas, temos que

usar estimativas

Recuperação Binária Independente (BIR) – será

discutida posteriormente –é o modelo mais simples

Suposições questionáveis

“Relevância” de cada documento é independente da

relevância de outros documentos.

Na verdade, é ruim retornar duplicatas

É o mesmo que modelo Booleano de relevância

A informação necessária pode ser alcançada em um

único passo

Visualizar um intervalo de resultados poderia permitir ao

usuário refinar a consulta

Estratégia de Recuperação

Probabilística

Estimar como os termos contribuem para a relevância

Como coisas tal como tf, df e tamanho influenciam

seus julgamentos sobre a relevância de um

documento?

Uma resposta são as fórmulas Okapi (S. Robertson)

Combinar para encontrar a probabilidade de

relavância de um documento

Ordenar os documentos por probabilidade

decrescente

Ordenação Probabilística

Conceito básico:

“Para uma dada consulta, se sabemos que alguns

documentos são relevantes, termos que ocorrem nesses

documentos devem receber maior peso na busca por

outros documentos relevantes.

Ao fazer suposições sobre a distribuição dos termos e

aplicar o Teorema Bayes, teoricamente é possível derivar

pesos."

Van Rijsbergen

Modelo Binário Independente

Tradicionalmente usado em conjunção com PRP

“Binário” = Booleano: documentos são representados

como vetores de termos de incidência binária (aula 1):

x ( x1 ,, xn )

xi 1 se e somente se

o termo i está presente no

documento x.

“Independente”: os termos ocorrem nos documentos

independentemente

Diferentes documentos podem ser modelados como o

mesmo vetor

Modelo Bernoulli Naive Bayes (cf. categoriazão de texto!)

Modelo Binário Independente

Consultas: vetores de termos de incidência binária

Dada a consulta q,

para cada documento d computar p(R|q,d).

substitua com a computação de p(R|q,x) em que

x é um vetor de termos de incidência binária

representando d com interesse apenas na

ordenação

Usaremos probabilidades e a regra de Bayes:

p ( R | q ) p ( x | R, q )

p ( R | q, x )

p( x | q)

O ( R | q, x )

p ( NR | q ) p ( x | NR , q )

p ( NR | q, x )

p( x | q)

Modelo Binário Independente

p ( R | q, x )

p ( R | q ) p ( x | R, q )

O ( R | q, x )

p( NR | q, x ) p( NR | q) p( x | NR, q)

Constante para uma

dade consulta

Requer estimativa

• Usando suposição Independente:

n

p( xi | R, q)

p( x | R, q)

p( x | NR, q) i 1 p( xi | NR, q)

n

•Então : O( R | q, d ) O( R | q)

i 1

p( xi | R, q)

p( xi | NR, q)

Modelo Binário Independente

n

O( R | q, d ) O( R | q)

i 1

p( xi | R, q)

p( xi | NR, q)

• Uma vez que xi é 0 ou 1:

p( xi 1 | R, q)

p( xi 0 | R, q)

O( R | q, d ) O( R | q)

xi 1 p( xi 1 | NR, q) xi 0 p( xi 0 | NR, q)

• Seja pi p( xi 1 | R, q); ri p( xi 1 | NR, q);

• Suponha que, para todos os termos que não ocorem na consulta (q =0)

pi ri

i

Então...

Isso pode ser

alterado (ex: no

relevance feedback)

Modelo Binário Independente

O ( R | q, x ) O ( R | q )

xi qi 1

Termos coincidentes

pi

1 pi

ri xi 0 1 ri

qi 1

Termos não

coincidentes na

consulta

pi (1 ri )

1 pi

O( R | q )

xi qi 1 ri (1 pi ) qi 1 1 ri

Termos coincidentes

Termos da Consulta

Modelo Binário Independente

O( R | q, x ) O( R | q)

pi (1 ri )

1 pi

xi qi 1 ri (1 pi ) qi 1 1 ri

Constante para

cada consulta

•Valor do Status de Recuperação RSV:

Quantificado apenas para

estimativa para ordenação

pi (1 ri )

pi (1 ri )

RSV log

log

ri (1 pi )

xi qi 1

xi qi 1 ri (1 pi )

Modelo Binário Independente

• Tudo se resume a calcular o RSV.

pi (1 ri )

pi (1 ri )

RSV log

log

ri (1 pi )

xi qi 1

xi qi 1 ri (1 pi )

pi (1 ri )

RSV ci ; ci log

ri (1 pi )

xi qi 1

Então, como calcular os ci’s dos nossos dados ?

Modelo Binário Independente

• Estimando os coeficientes RSV.

• Para cada termo i verificar nesta tabela de contagem de

documento:

Document Relevante Não-Relevante Total

os

s

n-s

n

Xi=1

S-s

N-n-S+s

N-n

Xi=0

Total

s

• Estimativa: pi

S

S

N-S

(n s)

ri

(N S)

s ( S s)

ci K ( N , n, S , s) log

(n s ) ( N n S s )

N

Por enquanto,

considere não

haver termos

zerados.Mais

na próxima aula.

Estimar – principal desafio

Se documentos não-relevantes são aproximados pela

coleção inteira, então ri (prob. de ocorrência em

documentos não relevantes para a consulta) é n/N e

log (1– ri)/ri = log (N– n)/n ≈ log N/n = IDF!

pi (probabilidade de ocorrência em documentos

relevantes) pode ser estimada de diversas formas:

de documentos relevantes se alguns forem conhecidos

Peso da Relevância pode ser usado em laço de feedback

constante (Croft e Harper combinação de coincidências)

– então apenas obter peso idf dos termos

proporcional à probabilidade de ocorrência na coleção

mais precisamente, ao log dela (Greiff, SIGIR 1998)

Estimando pi iterativamente

1.

Considere pi é constante para todo xi na consulta

2.

Determinar um conjunto estimado de documentos

relevante:

3.

pi = 0.5 (probabilidades iguais) para qualquer

documento dado

V é um conjunto de tamanho fixo de documentos de

alta ordem nesse modelo (nota: similar a tf.idf!)

Precisamos melhorar nossas estimativas para pi e

ri, logo

Use a distribuição de xi nos documentos em V. Seja

Vi o conjunto de documentos que contém xi

Considere que se não recuperado então não é

relevante

4.

pi = |Vi| / |V|

ri = (ni – |Vi|) / (N – |V|)

Vá para 2. até que converja então retorne o ranking

24

Relevance Feedback Probabilístico

1.

2.

3.

Suponha uma descrição probabilística preliminar

de R e utilize-a para recuperar o primeiro

conjunto de documento V, como acima.

Interaja com o usuário para refinar a descrição:

conheça membros definitivos de R e NR

Reestime pi e ri com base nestes

Ou pode-se combinar a nova informação com a

(1)

suposição original

|

V

|

p

( 2)

i

i

κ éo

p

i

(use anterior Bayesiano):

| V |

peso do

Repita, logo gerando uma sucessão de

anterior

4.

aproximações a R.

PRP e BIR

É possível obter aproximações razoáveis das

probabilidades.

Requer suposições restritivas:

Independência de termos

termos não presentes na consulta não afetam o

resultado

representação booleana de

documentos/consulta/relevância

valores de relevância dos documentos são

independentes

Algumas dessas suposições podem ser removidas

Problema: ou requer informação parcial sobre relevância

ou apenas pode derivar peso de termos, de certa forma,

inferiores

Removendo a Independência de

termo

Em geral, termos do índice

não são independentes

Dependências podem ser

complexas

van Rijsbergen (1979) propôs

um modelo de dependência de

árvore simples

A árvore de Friedman e

Goldszmidt’s ampliaram a

Naive Bayes (AAAI 13, 1996)

Cada termo dependia de um

outro

Na década de 70, problemas

de estimativa retiveram o

sucesso desse modelo

Alimento para o pensamento

Pense a respeito das diferenças entre o tf.idf

padr’ao e o modelo de recuperação

probabilístico na primeira iteração

Pense a respeito das diferenças entre o (pseudo)

relevance feedback do espaço vetorial e o

(pseudo) relevance feedback probabilístico

Notícias boas e ruins

Modelo de Espaço de Vetores Padrão

Vantagens do Modelo Probabilístico

Empírico em sua maior parte; sucesso medido pelos

resultados

Poucas propriedades demonstráveis

Baseado em um embasamento teórico firme

Justificativa teória de um esquema de ordenação ótimo

Desvantagens

Fazer a suposição inicial para obter V

Pesos binários da palavra-no-documento (sem usar

frequência de termos)

Independência de termos (pode ser aliviada)

Quantidade de cálculo

Nunca funcionou convincentemente melhor na prática

Redes Bayesianas para Recuperação

de Texto (Turtle and Croft 1990)

Modelo probabilístico padrão supõe que você não

pode estimar P(R|D,Q)

Ao invés disso supõe independência e usa P(D|R)

Mas talvez você possa com uma rede Bayesiana*

O que é uma rede Bayesiana?

Um grafo direcionado acíclico

Vértices

Eventos ou Variáveis

Supõe valores

Para todos os propósitos, todos Booleanos

Arestas

modelam dependências diretas entre os vértices

Redes Bayesianas

a,b,c - proposições (eventos). • Redes Bayesianas modelam relações

causais entre os eventos

a

b

p(a)

c

p(c|ab) para todos os

valores para a,b,c

p(b)

•Inferências Redes Bayesianas:

Dependência

Condicional

• Dadas a distribuições de

probabilidade para raízes e

probabilidades condicionais

pode-se calcular a probabilidade

apriori de qualquer instância

• Fixar suposições (ex.: b

foi observado) causará recálculo

de probabilidades

Para mais informações:

R.G. Cowell, A.P. Dawid, S.L. Lauritzen, and D.J. Spiegelhalter.

1999. Probabilistic Networks and Expert Systems. Springer Verlag.

J. Pearl. 1988. Probabilistic Reasoning in Intelligent Systems:

Networks of Plausible Inference. Morgan-Kaufman.

Exemplo do Brinquedo

f

0.3

f

0.7

f f

n 0.9 0.3

n 0.1 0.7

t

t

d

d

Finais

(f)

Entrega do Projeto

(d)

Sem dormir

(n)

fd fd

Desânimo g 0.99 0.9

(g)

g 0.01 0.1

g

0.99

0.01

g

0.1

0.9

Café com Leite Triplo

(t)

0.4

0.6

f d f d

0.8

0.3

0.2

0.7

Suposições de Independência

Entrega do Projeto

(d)

Finais

(f)

Sem dormir

(n)

Desânimo

(g)

• Suposição de

Independência:

P(t|g, f)=P(t|g)

• Probabilidade conjunta

P(f d n g t)

=P(f) P(d) P(n|f) P(g|f d) P(t|g)

Café com leite Triplo

(t)

Inferência encadeada

Evidência – um vértice assume um valor

Inferência

Calcular a crença (probabilidade) de outros vértices

condicionado a uma evidência conhecida

Dois tipos de inferência: Diagnóstica e Preditiva

Complexidade computacional

General network: NP-hard

Rede similares a árvore são facilmente tratáveis

Muitos outros trabalhos sobre inferência eficiente em redes

Bayesianas exatas e aproximadas

Programação dinâmica inteligente

Inferência aproximada (“propagação da crença em laço”)

Modelo p/ Recuperação de Texto

Objetivo

Dada a necessidade de informação do usuário

(evidência), encontrar a probabilidade de que um

documento satisfaça a necessidade

Modelo de recuperação

Modelar documentos em uma rede de

documentos

Modelar a necessidade de informação em uma

rede de consulta

Redes Bayesianas para RI: Ideia

Rede de Documento

di -documentos

d1

d2

tiGrande,

– representações

de documento

mas

t1

t2

ricalcular

- “conceitos”

uma vez para

cada coleção de documentos rk

r1

r2

r3

c1

c2

q1

ci – conceitos de consulta cm

Pequeno, calcular uma vez

para cada

qi - conceitos

de consulta

alto-nível

q2

Rede de Consulta

I

I - vértice objetivo

dn

tn

Redes Bayesianas para RI

Construa Rede de Documento (uma vez!)

Para cada consulta

Construa a melhor Rede de Consulta

Anexe-a à Rede de Documentos

Encontre o subconjunto de di’s que maximiza o

valor da probabilidade do vértice I (melhor

subconjunto)

Recupere esses di’s como a resposta à consulta

Redes Bayesianas para recuperação

de texto

Documentos

d1

r1

d2

r2

c1

r3

c2

c3

q1

q2

i

Rede de

Documentos

Termos/Conceitos

Conceitos

Rede de

Consulta

Operadores de Consulta

(AND/OR/NOT)

Necessidade de Informação

Ligando matrizes e probabilidades

Probabilidade anterior do

documento P(d) = 1/n

P(r|d)

frequência do termo no

documento

baseado em tf idf

P(c|r)

1-a-1

thesaurus

P(q|c): forma canônica dos

operadores da consulta

Sempre use coisas como

AND e NOT – nunca

armazene a CPT*

completa

*tabela de probabilidade condicional

Exemplo: “reason trouble –two”

Macbeth

Hamlet

Rede de

Documentos

reason

reason

trouble

trouble

OR

double

two

NOT

Consulta do Usuário

Rede de

Consulta

Extensões

Probabilidades anteriores não têm que ser 1/n

“Necessidade de informação do usuário” não

precisa ser uma consulta - podem ser palavras

digitadas, documentos lidos, qualquer

combinação …

Frases, vínculos intra-documentos

Matrizes de vínculos podem ser modificadas ao

passar do tempo

Feedback do usuário

Promessa de “personalização”

Detalhes computacionais

Rede de documento construída em tempo de

indexação

Rede de consulta construída/pontuada em tempo de

consulta

Representação:

Matrizes de vínculos de documentos para qualquer

termo individual são como entradas de endereçamento

para aquele termo

Matrízes de vínculos são eficientes para armazenar e

calcular

Anexar evidências apenas às raízes da rede

Pode ser construído em única passagem das raízes

para as folhas

Redes Bayesianas em RI

Formas flexíveis de combinar peso dos termos, que pode

generalizar abordagem anteriores

Modelo Booleano

Modelo binário de independência

Modelos probabilísticos com suposições mais fracas

Implementação eficiente de larga-escala

Sistema de recuperação de texto InQuery da Universidade de

Massachusetts

Turtle e Croft (1990) [Defunto de versão comercial?]

São precisas aproximações para evitar inferências intratáveis

É necessário estimar todas as probabilidades de algum modo

(ainda que mais ou menos ad hoc)

Muita nova tecnologia de Redes Bayesianas a ser aplicada?

Resources

S. E. Robertson and K. Spärck Jones. 1976. Relevance Weighting of

Search Terms. Journal of the American Society for Information

Sciences 27(3): 129–146.

C. J. van Rijsbergen. 1979. Information Retrieval. 2nd ed. London:

Butterworths, chapter 6. [Most details of math]

http://www.dcs.gla.ac.uk/Keith/Preface.html

N. Fuhr. 1992. Probabilistic Models in Information Retrieval. The

Computer Journal, 35(3),243–255. [Easiest read, with BNs]

F. Crestani, M. Lalmas, C. J. van Rijsbergen, and I. Campbell. 1998.

Is This Document Relevant? ... Probably: A Survey of

Probabilistic Models in Information Retrieval. ACM Computing

Surveys 30(4): 528–552.

http://www.acm.org/pubs/citations/journals/surveys/1998-30-4/p528-crestani/

[Adds very little material that isn’t in van Rijsbergen or Fuhr ]

Resources

H.R. Turtle and W.B. Croft. 1990. Inference Networks for Document

Retrieval. Proc. ACM SIGIR: 1-24.

E. Charniak. Bayesian nets without tears. AI Magazine 12(4): 50-63

(1991). http://www.aaai.org/Library/Magazine/Vol12/12-04/vol12-04.html

D. Heckerman. 1995. A Tutorial on Learning with Bayesian Networks.

Microsoft Technical Report MSR-TR-95-06

http://www.research.microsoft.com/~heckerman/

N. Fuhr. 2000. Probabilistic Datalog: Implementing Logical Information

Retrieval for Advanced Applications. Journal of the American Society

for Information Science 51(2): 95–110.

R. K. Belew. 2001. Finding Out About: A Cognitive Perspective on Search

Engine Technology and the WWW. Cambridge UP 2001.

MIR 2.5.4, 2.8

Download